Introducción a la mecánica cuántica

| Parte de una serie de artículos sobre |

| Mecánica cuántica |

|---|

La mecánica cuántica es el estudio de la materia y sus interacciones con la energía en la escala de partículas atómicas y subatómicas . Por el contrario, la física clásica explica la materia y la energía solo en una escala familiar para la experiencia humana, incluido el comportamiento de cuerpos astronómicos como la luna. La física clásica todavía se utiliza en gran parte de la ciencia y la tecnología modernas. Sin embargo, hacia fines del siglo XIX, los científicos descubrieron fenómenos tanto en el mundo grande ( macro ) como en el pequeño ( micro ) que la física clásica no podía explicar. [1] El deseo de resolver inconsistencias entre los fenómenos observados y la teoría clásica condujo a una revolución en la física, un cambio en el paradigma científico original : [2] el desarrollo de la mecánica cuántica .

Muchos aspectos de la mecánica cuántica son contraintuitivos [3] y pueden parecer paradójicos porque describen un comportamiento bastante diferente del que se observa a escalas mayores. En palabras del físico cuántico Richard Feynman , la mecánica cuántica trata con "la naturaleza tal como es: absurdo". [4] Las características de la mecánica cuántica a menudo desafían las explicaciones simples en el lenguaje cotidiano. Un ejemplo de esto es el principio de incertidumbre : las mediciones precisas de la posición no se pueden combinar con mediciones precisas de la velocidad. Otro ejemplo es el entrelazamiento : una medición realizada en una partícula (como un electrón que se mide con espín "arriba") se correlacionará con una medición en una segunda partícula (se encontrará que un electrón tiene espín "abajo") si las dos partículas tienen una historia compartida. Esto se aplicará incluso si es imposible que el resultado de la primera medición se haya transmitido a la segunda partícula antes de que tenga lugar la segunda medición.

La mecánica cuántica nos ayuda a entender la química , porque explica cómo los átomos interactúan entre sí y forman moléculas . Muchos fenómenos notables pueden explicarse utilizando la mecánica cuántica, como la superfluidez . Por ejemplo, si se coloca helio líquido enfriado a una temperatura cercana al cero absoluto en un recipiente, fluye espontáneamente hacia arriba y sobrepasa el borde del recipiente; este es un efecto que no puede explicarse mediante la física clásica.

Historia

La unificación de las ecuaciones que rigen la electricidad, el magnetismo y la luz por parte de James C. Maxwell a finales del siglo XIX dio lugar a experimentos sobre la interacción de la luz y la materia. Algunos de estos experimentos tenían aspectos que no pudieron explicarse hasta que surgió la mecánica cuántica a principios del siglo XX. [5]

Evidencia de cuantos a partir del efecto fotoeléctrico

Las semillas de la revolución cuántica aparecen en el descubrimiento de J. J. Thomson en 1897 de que los rayos catódicos no eran continuos sino "corpúsculos" ( electrones ). Los electrones habían sido nombrados apenas seis años antes como parte de la emergente teoría de los átomos . En 1900, Max Planck , poco convencido por la teoría atómica , descubrió que necesitaba entidades discretas como átomos o electrones para explicar la radiación del cuerpo negro . [6]

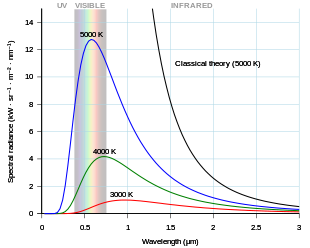

Los objetos muy calientes (al rojo vivo o al blanco vivo) parecen similares cuando se calientan a la misma temperatura. Este aspecto es el resultado de una curva común de intensidad de la luz a diferentes frecuencias (colores), que se denomina radiación de cuerpo negro. Los objetos al blanco vivo tienen intensidad en muchos colores del rango visible. Las frecuencias más bajas por encima de los colores visibles son la luz infrarroja , que también emite calor. Las teorías de onda continua de la luz y la materia no pueden explicar la curva de radiación de cuerpo negro. Planck distribuyó la energía térmica entre "osciladores" individuales de carácter indefinido pero con capacidad energética discreta; este modelo explicaba la radiación de cuerpo negro.

En aquella época, los electrones, los átomos y los osciladores discretos eran ideas exóticas para explicar fenómenos exóticos. Pero en 1905, Albert Einstein propuso que la luz también era corpuscular y que estaba formada por "cuantos de energía", en contradicción con la ciencia establecida de la luz como una onda continua, que se remonta cien años atrás, al trabajo de Thomas Young sobre la difracción .

La propuesta revolucionaria de Einstein comenzó con un nuevo análisis de la teoría del cuerpo negro de Planck, llegando a las mismas conclusiones utilizando los nuevos "cuantos de energía". Einstein luego mostró cómo los cuantos de energía se conectaban con el electrón de Thomson. En 1902, Philipp Lenard dirigió la luz de una lámpara de arco sobre placas de metal recién limpiadas alojadas en un tubo de vidrio al vacío. Midió la corriente eléctrica que salía de la placa de metal, a intensidades de luz más altas y más bajas y para diferentes metales. Lenard demostró que la cantidad de corriente -el número de electrones- dependía de la intensidad de la luz, pero que la velocidad de estos electrones no dependía de la intensidad. Este es el efecto fotoeléctrico . Las teorías de onda continua de la época predecían que una mayor intensidad de luz aceleraría la misma cantidad de corriente a una velocidad mayor, al contrario de este experimento. Los cuantos de energía de Einstein explicaron el aumento de volumen: se expulsa un electrón por cada cuanto: más cuantos significan más electrones. [6] : 23

Einstein predijo entonces que la velocidad del electrón aumentaría en proporción directa a la frecuencia de la luz por encima de un valor fijo que dependía del metal. Aquí la idea es que la energía en cuantos de energía depende de la frecuencia de la luz; la energía transferida al electrón es proporcional a la frecuencia de la luz. El tipo de metal proporciona una barrera , el valor fijo, que los electrones deben superar para salir de sus átomos, para ser emitidos desde la superficie del metal y ser medidos.

Pasaron diez años hasta que el experimento definitivo de Millikan [7] confirmó la predicción de Einstein. Durante ese tiempo, muchos científicos rechazaron la idea revolucionaria de los cuantos. [8] Pero el concepto de Planck y Einstein estaba en el aire y pronto comenzó a afectar a otras teorías de la física y de los cuánticos.

Cuantificación de electrones ligados en átomos

Los experimentos con luz y materia realizados a finales del siglo XIX revelaron una regularidad reproducible pero desconcertante. Cuando se hacía pasar la luz a través de gases purificados, ciertas frecuencias (colores) no pasaban. Estas "líneas" oscuras de absorción seguían un patrón distintivo: los espacios entre las líneas disminuían de forma constante. En 1889, la fórmula de Rydberg predijo las líneas del gas hidrógeno utilizando únicamente un número constante y los números enteros para indexar las líneas. [5] : v1:376 El origen de esta regularidad era desconocido. Resolver este misterio acabaría convirtiéndose en el primer gran paso hacia la mecánica cuántica.

A lo largo del siglo XIX, se fueron acumulando pruebas de la naturaleza atómica de la materia. Con el descubrimiento del electrón por parte de Thomson en 1897, los científicos comenzaron a buscar un modelo del interior del átomo. Thomson propuso que los electrones negativos nadaran en un charco de carga positiva . Entre 1908 y 1911, Rutherford demostró que la parte positiva era sólo 1/3000 del diámetro del átomo. [6] : 26

Se propusieron modelos de electrones "planetarios" que orbitaban alrededor de un "Sol" nuclear, pero no pueden explicar por qué el electrón no cae simplemente en la carga positiva. En 1913, Niels Bohr y Ernest Rutherford relacionaron los nuevos modelos atómicos con el misterio de la fórmula de Rydberg: el radio orbital de los electrones estaba limitado y las diferencias de energía resultantes coincidían con las diferencias de energía en las líneas de absorción. Esto significaba que la absorción y emisión de luz de los átomos estaba cuantificada energéticamente: solo se emitirían o absorberían energías específicas que coincidieran con la diferencia en la energía orbital. [6] : 31

Cambiar un misterio (el patrón regular de la fórmula de Rydberg) por otro (las restricciones a las órbitas de los electrones) puede no parecer un gran avance, pero el nuevo modelo atómico resumía muchos otros hallazgos experimentales. La cuantificación del efecto fotoeléctrico y ahora la cuantificación de las órbitas de los electrones prepararon el terreno para la revolución final.

A lo largo de la primera y la era moderna de la mecánica cuántica, el concepto de que la mecánica clásica debe ser válida macroscópicamente restringió los posibles modelos cuánticos. Este concepto fue formalizado por Bohr en 1923 como el principio de correspondencia . Requiere que la teoría cuántica converja a los límites clásicos. [9] : 29 Un concepto relacionado es el teorema de Ehrenfest , que muestra que los valores promedio obtenidos a partir de la mecánica cuántica (por ejemplo, posición y momento) obedecen a las leyes clásicas. [10]

Cuantización del espín

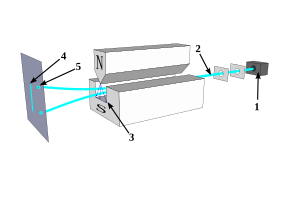

En 1922, Otto Stern y Walther Gerlach demostraron que las propiedades magnéticas de los átomos de plata desafían la explicación clásica, trabajo que contribuyó al Premio Nobel de Física de 1943 para Stern . Dispararon un haz de átomos de plata a través de un campo magnético. Según la física clásica, los átomos deberían haber surgido en una pulverización, con un rango continuo de direcciones. En cambio, el haz se separó en dos, y solo dos, corrientes divergentes de átomos. [11] A diferencia de los otros efectos cuánticos conocidos en ese momento, este sorprendente resultado involucra el estado de un solo átomo. [5] : v2:130 En 1927, TE Phipps y JB Taylor obtuvieron un efecto similar, pero menos pronunciado, utilizando átomos de hidrógeno en su estado fundamental , eliminando así cualquier duda que pudiera haber sido causada por el uso de átomos de plata . [12]

En 1924, Wolfgang Pauli lo llamó "doble valor no descriptible clásicamente" y lo asoció con los electrones en la capa más externa. [13] Los experimentos llevaron a la formulación de su teoría descrita como surgida del espín del electrón en 1925, por Samuel Goudsmit y George Uhlenbeck , bajo el asesoramiento de Paul Ehrenfest . [14]

Cuantización de la materia

En 1924 Louis de Broglie propuso [15] que los electrones de un átomo no están limitados por "órbitas", sino por ondas estacionarias. En detalle, su solución no funcionó, pero su hipótesis –que el "corpúsculo" electrónico se mueve en el átomo como una onda– impulsó a Erwin Schrödinger a desarrollar una ecuación de onda para los electrones; cuando se aplicó al hidrógeno, la fórmula de Rydberg se reprodujo con precisión. [6] : 65

El artículo de Max Born de 1924 "Zur Quantenmechanik" fue el primer uso de las palabras "mecánica cuántica" en forma impresa. [16] [17] Su trabajo posterior incluyó el desarrollo de modelos de colisión cuántica; en una nota a pie de página de un artículo de 1926 propuso la regla de Born que conecta los modelos teóricos con los experimentos. [18]

En 1927 en Bell Labs, Clinton Davisson y Lester Germer dispararon electrones de movimiento lento a un blanco de níquel cristalino que mostró un patrón de difracción [19] [20] [21] [22] que indicaba la naturaleza ondulatoria del electrón cuya teoría fue explicada completamente por Hans Bethe . [23] Un experimento similar realizado por George Paget Thomson y Alexander Reid, disparando electrones a láminas delgadas de celuloide y más tarde películas de metal, observando anillos, descubrió de forma independiente la naturaleza ondulatoria de la materia de los electrones. [24]

Desarrollos futuros

En 1928, Paul Dirac publicó su ecuación de onda relativista que incorporaba simultáneamente la relatividad , predecía la antimateria y proporcionaba una teoría completa para el resultado de Stern-Gerlach. [6] : 131 Estos éxitos lanzaron una nueva comprensión fundamental de nuestro mundo a pequeña escala: la mecánica cuántica.

Planck y Einstein iniciaron la revolución con los cuantos que rompieron con los modelos continuos de la materia y la luz. Veinte años después, los "corpúsculos" como los electrones pasaron a ser modelados como ondas continuas. Este resultado pasó a llamarse dualidad onda-partícula, una idea emblemática junto con el principio de incertidumbre que distingue a la mecánica cuántica de los modelos más antiguos de la física.

Radiación cuántica, campos cuánticos

En 1923 Compton demostró que los cuantos de energía de Planck-Einstein de la luz también tenían momento; tres años más tarde los "cuantos de energía" recibieron un nuevo nombre: " fotón " [25]. A pesar de su papel en casi todas las etapas de la revolución cuántica, no existió ningún modelo explícito para los cuantos de luz hasta 1927, cuando Paul Dirac comenzó a trabajar en una teoría cuántica de la radiación [26] que se convirtió en la electrodinámica cuántica . Durante las décadas siguientes, este trabajo evolucionó hacia la teoría cuántica de campos , la base de la óptica cuántica moderna y la física de partículas .

Dualidad onda-partícula

El concepto de dualidad onda-partícula dice que ni el concepto clásico de "partícula" ni el de "onda" pueden describir completamente el comportamiento de los objetos a escala cuántica, ya sean fotones o materia. La dualidad onda-partícula es un ejemplo del principio de complementariedad en física cuántica. [27] [28] [29] [30] [31] Un ejemplo elegante de dualidad onda-partícula es el experimento de la doble rendija.

En el experimento de la doble rendija, realizado originalmente por Thomas Young en 1803 [32] y luego por Augustin Fresnel una década después [32] , se dirige un haz de luz a través de dos rendijas estrechas y muy próximas entre sí, lo que produce un patrón de interferencia de bandas claras y oscuras en una pantalla. El mismo comportamiento se puede demostrar en las ondas de agua: el experimento de la doble rendija se consideró una demostración de la naturaleza ondulatoria de la luz.

Se han realizado variaciones del experimento de la doble rendija utilizando electrones, átomos e incluso moléculas grandes, [33] [34] y se observa el mismo tipo de patrón de interferencia. Así se ha demostrado que toda la materia posee características ondulatorias.

Si se reduce la intensidad de la fuente, el mismo patrón de interferencia se irá acumulando lentamente, un "recuento" o partícula (por ejemplo, un fotón o un electrón) a la vez. El sistema cuántico actúa como una onda cuando pasa por las rendijas dobles, pero como una partícula cuando se detecta. Esta es una característica típica de la complementariedad cuántica: un sistema cuántico actúa como una onda en un experimento para medir sus propiedades ondulatorias, y como una partícula en un experimento para medir sus propiedades particuladas. El punto en la pantalla del detector donde aparece cualquier partícula individual es el resultado de un proceso aleatorio. Sin embargo, el patrón de distribución de muchas partículas individuales imita el patrón de difracción producido por las ondas.

Principio de incertidumbre

Supongamos que se desea medir la posición y la velocidad de un objeto (por ejemplo, un coche que pasa por un radar). Se puede suponer que el coche tiene una posición y una velocidad definidas en un momento determinado. La precisión con la que se pueden medir estos valores depende de la calidad del equipo de medición. Si se mejora la precisión del equipo de medición, se obtiene un resultado más cercano al valor real. Se podría suponer que la velocidad del coche y su posición se podrían definir y medir operativamente de forma simultánea, con la precisión que se desee.

En 1927, Heisenberg demostró que esta última suposición no es correcta. [36] La mecánica cuántica muestra que ciertos pares de propiedades físicas, por ejemplo, la posición y la velocidad, no pueden medirse simultáneamente, ni definirse en términos operativos, con una precisión arbitraria: cuanto más precisamente se mide una propiedad, o se define en términos operativos, menos precisamente puede tratarse la otra. Esta afirmación se conoce como el principio de incertidumbre . El principio de incertidumbre no es sólo una afirmación sobre la precisión de nuestro equipo de medición, sino que, más profundamente, se refiere a la naturaleza conceptual de las cantidades medidas: la suposición de que el coche tenía posición y velocidad definidas simultáneamente no funciona en la mecánica cuántica. En una escala de coches y personas, estas incertidumbres son insignificantes, pero cuando se trata de átomos y electrones se vuelven críticas. [37]

Heisenberg presentó, como ejemplo, la medición de la posición y el momento de un electrón utilizando un fotón de luz. Al medir la posición del electrón, cuanto mayor sea la frecuencia del fotón, más precisa será la medición de la posición del impacto del fotón con el electrón, pero mayor será la perturbación del electrón. Esto se debe a que, a partir del impacto con el fotón, el electrón absorbe una cantidad aleatoria de energía, lo que hace que la medición obtenida de su momento sea cada vez más incierta, ya que uno necesariamente está midiendo su momento perturbado posterior al impacto a partir de los productos de la colisión y no su momento original (momento que debería medirse simultáneamente con la posición). Con un fotón de menor frecuencia, la perturbación (y, por lo tanto, la incertidumbre) en el momento es menor, pero también lo es la precisión de la medición de la posición del impacto. [38]

En el centro del principio de incertidumbre está el hecho de que, para cualquier análisis matemático en los dominios de la posición y la velocidad, lograr una curva más nítida (más precisa) en el dominio de la posición solo se puede hacer a expensas de una curva más gradual (menos precisa) en el dominio de la velocidad, y viceversa. Una mayor nitidez en el dominio de la posición requiere contribuciones de más frecuencias en el dominio de la velocidad para crear la curva más estrecha, y viceversa. Es una disyuntiva fundamental inherente a cualquier medición relacionada o complementaria de este tipo , pero solo es realmente perceptible en la escala más pequeña (de Planck), cerca del tamaño de las partículas elementales .

El principio de incertidumbre muestra matemáticamente que el producto de la incertidumbre en la posición y el momento de una partícula (el momento es la velocidad multiplicada por la masa) nunca podría ser menor que un cierto valor, y que este valor está relacionado con la constante de Planck .

Colapso de la función de onda

El colapso de la función de onda significa que una medición ha forzado o convertido un estado cuántico (probabilístico o potencial) en un valor medido definido. Este fenómeno solo se observa en la mecánica cuántica, no en la mecánica clásica.

Por ejemplo, antes de que un fotón "aparezca" en una pantalla de detección, sólo se puede describir con un conjunto de probabilidades de dónde podría aparecer. Cuando aparece, por ejemplo en el CCD de una cámara electrónica, el tiempo y el espacio en los que interactuó con el dispositivo se conocen dentro de límites muy estrictos. Sin embargo, el fotón ha desaparecido en el proceso de ser capturado (medido), y su función de onda cuántica ha desaparecido con él. En su lugar, ha aparecido algún cambio físico macroscópico en la pantalla de detección, por ejemplo, un punto expuesto en una hoja de película fotográfica, o un cambio en el potencial eléctrico en alguna celda de un CCD.

Estados propios y valores propios

Debido al principio de incertidumbre, las afirmaciones sobre la posición y el momento de las partículas solo pueden asignar una probabilidad de que la posición o el momento tengan algún valor numérico. Por lo tanto, es necesario formular claramente la diferencia entre el estado de algo indeterminado, como un electrón en una nube de probabilidad, y el estado de algo que tiene un valor definido. Cuando un objeto puede ser "precisamente" determinado en algún aspecto, se dice que posee un estado propio .

En el experimento de Stern-Gerlach mencionado anteriormente, el modelo cuántico predice dos posibles valores de espín para el átomo en comparación con el eje magnético. Estos dos estados propios se denominan arbitrariamente "arriba" y "abajo". El modelo cuántico predice que estos estados se medirán con la misma probabilidad, pero no se observarán valores intermedios. Esto es lo que muestra el experimento de Stern-Gerlach.

Los estados propios de espín sobre el eje vertical no son simultáneamente estados propios de espín sobre el eje horizontal, por lo que este átomo tiene la misma probabilidad de tener cualquiera de los dos valores de espín sobre el eje horizontal. Como se describe en la sección anterior, medir el espín sobre el eje horizontal puede permitir que un átomo que ha girado hacia arriba gire hacia abajo: medir su espín sobre el eje horizontal colapsa su función de onda en uno de los estados propios de esta medición, lo que significa que ya no está en un estado propio de espín sobre el eje vertical, por lo que puede tomar cualquiera de los valores.

El principio de exclusión de Pauli

En 1924, Wolfgang Pauli propuso un nuevo grado de libertad cuántico (o número cuántico ), con dos valores posibles, para resolver las inconsistencias entre los espectros moleculares observados y las predicciones de la mecánica cuántica. En particular, el espectro del hidrógeno atómico tenía un doblete , o par de líneas que diferían en una pequeña cantidad, cuando se esperaba solo una línea. Pauli formuló su principio de exclusión , afirmando: "No puede existir un átomo en un estado cuántico tal que dos electrones dentro de él tengan el mismo conjunto de números cuánticos". [39]

Un año después, Uhlenbeck y Goudsmit identificaron el nuevo grado de libertad de Pauli con la propiedad llamada espín , cuyos efectos se observaron en el experimento de Stern-Gerlach .

Ecuación de onda de Dirac

En 1928, Paul Dirac amplió la ecuación de Pauli , que describía el giro de los electrones, para explicar la relatividad especial . El resultado fue una teoría que abordaba adecuadamente los eventos, como la velocidad a la que un electrón orbita el núcleo, que ocurren a una fracción sustancial de la velocidad de la luz . Al utilizar la interacción electromagnética más simple , Dirac pudo predecir el valor del momento magnético asociado con el giro del electrón y encontró el valor observado experimentalmente, que era demasiado grande para ser el de una esfera cargada giratoria regida por la física clásica . Pudo resolver las líneas espectrales del átomo de hidrógeno y reproducir a partir de los primeros principios físicos la exitosa fórmula de Sommerfeld para la estructura fina del espectro del hidrógeno.

Las ecuaciones de Dirac a veces arrojaban un valor negativo para la energía, para lo cual propuso una solución novedosa: postuló la existencia de un antielectrón y un vacío dinámico. Esto condujo a la teoría cuántica de campos de múltiples partículas .

Entrelazamiento cuántico

En física cuántica, un grupo de partículas puede interactuar o crearse en conjunto de tal manera que el estado cuántico de cada partícula del grupo no puede describirse independientemente del estado de las demás, incluso cuando las partículas están separadas por una gran distancia. Esto se conoce como entrelazamiento cuántico .

Un hito temprano en el estudio del entrelazamiento fue la paradoja de Einstein-Podolsky-Rosen (EPR) , un experimento mental propuesto por Albert Einstein, Boris Podolsky y Nathan Rosen que sostiene que la descripción de la realidad física proporcionada por la mecánica cuántica es incompleta. [40] En un artículo de 1935 titulado "¿Puede considerarse completa la descripción mecánico-cuántica de la realidad física?", argumentaron a favor de la existencia de "elementos de la realidad" que no formaban parte de la teoría cuántica y especularon que debería ser posible construir una teoría que contuviera estas variables ocultas .

El experimento mental implica un par de partículas preparadas en lo que más tarde se conocería como un estado entrelazado. Einstein, Podolsky y Rosen señalaron que, en este estado, si se medía la posición de la primera partícula, se podía predecir el resultado de medir la posición de la segunda partícula. Si, en cambio, se medía el momento de la primera partícula, se podía predecir el resultado de medir el momento de la segunda partícula. Argumentaron que ninguna acción realizada sobre la primera partícula podría afectar instantáneamente a la otra, ya que esto implicaría que la información se transmitiera más rápido que la luz, lo que está prohibido por la teoría de la relatividad . Invocaron un principio, más tarde conocido como el "criterio EPR de realidad", que postula que: "Si, sin perturbar de ninguna manera un sistema, podemos predecir con certeza (es decir, con probabilidad igual a la unidad) el valor de una cantidad física, entonces existe un elemento de realidad correspondiente a esa cantidad". A partir de esto, dedujeron que la segunda partícula debe tener un valor definido tanto de posición como de momento antes de que se mida cualquiera de las cantidades. Pero la mecánica cuántica considera que estos dos observables son incompatibles y, por lo tanto, no asocia valores simultáneos para ambos a ningún sistema. Por ello, Einstein, Podolsky y Rosen concluyeron que la teoría cuántica no proporciona una descripción completa de la realidad. [41] Ese mismo año, Erwin Schrödinger utilizó la palabra "entrelazamiento" y declaró: "Yo no lo llamaría así , sino más bien el rasgo característico de la mecánica cuántica". [42]

El físico irlandés John Stewart Bell llevó el análisis del entrelazamiento cuántico mucho más allá. Dedujo que si las mediciones se realizan independientemente en las dos partículas separadas de un par entrelazado, entonces la suposición de que los resultados dependen de variables ocultas dentro de cada mitad implica una restricción matemática sobre cómo se correlacionan los resultados de las dos mediciones. Esta restricción más tarde se llamaría desigualdad de Bell . Bell luego demostró que la física cuántica predice correlaciones que violan esta desigualdad. En consecuencia, la única forma en que las variables ocultas podrían explicar las predicciones de la física cuántica es si son "no locales", lo que quiere decir que de alguna manera las dos partículas son capaces de interactuar instantáneamente sin importar cuán ampliamente se separen. [43] [44] Realizando experimentos como los que Bell sugirió, los físicos han descubierto que la naturaleza obedece a la mecánica cuántica y viola las desigualdades de Bell. En otras palabras, los resultados de estos experimentos son incompatibles con cualquier teoría de variable oculta local. [45] [46]

Teoría cuántica de campos

La idea de la teoría cuántica de campos surgió a finales de los años 1920 con el físico británico Paul Dirac, cuando intentó cuantificar la energía del campo electromagnético , de la misma manera que en la mecánica cuántica se cuantificaba la energía de un electrón en el átomo de hidrógeno. La cuantificación es un procedimiento para construir una teoría cuántica a partir de una teoría clásica.

Merriam-Webster define un campo en física como "una región o espacio en el que existe un efecto determinado (como el magnetismo )". [47] Otros efectos que se manifiestan como campos son la gravitación y la electricidad estática . [48] En 2008, el físico Richard Hammond escribió:

A veces distinguimos entre mecánica cuántica (MC) y teoría cuántica de campos (TCC). La MCC se refiere a un sistema en el que el número de partículas es fijo y los campos (como el campo electromecánico) son entidades clásicas continuas. La TCC... va un paso más allá y permite la creación y aniquilación de partículas...

Añadió, sin embargo, que la mecánica cuántica se utiliza a menudo para referirse a "toda la noción de la visión cuántica". [49] : 108

En 1931, Dirac propuso la existencia de partículas que más tarde se conocerían como antimateria . [50] Dirac compartió el Premio Nobel de Física de 1933 con Schrödinger "por el descubrimiento de nuevas formas productivas de teoría atómica". [51]

Electrodinámica cuántica

La electrodinámica cuántica (EDQ) es el nombre de la teoría cuántica de la fuerza electromagnética . Para entender la EQQ es necesario empezar por entender el electromagnetismo . El electromagnetismo puede denominarse "electrodinámica" porque es una interacción dinámica entre fuerzas eléctricas y magnéticas . El electromagnetismo comienza con la carga eléctrica .

Las cargas eléctricas son las fuentes y las que crean los campos eléctricos . Un campo eléctrico es un campo que ejerce una fuerza sobre cualquier partícula que lleve cargas eléctricas, en cualquier punto del espacio. Esto incluye el electrón, el protón e incluso los quarks , entre otros. A medida que se ejerce una fuerza, las cargas eléctricas se mueven, fluye una corriente y se produce un campo magnético. El campo magnético cambiante, a su vez, provoca una corriente eléctrica (a menudo electrones en movimiento). La descripción física de las partículas cargadas en interacción , las corrientes eléctricas, los campos eléctricos y los campos magnéticos se llama electromagnetismo.

En 1928, Paul Dirac elaboró una teoría cuántica relativista del electromagnetismo. Esta teoría fue la precursora de la electrodinámica cuántica moderna, ya que tenía ingredientes esenciales de la teoría moderna. Sin embargo, el problema de los infinitos irresolubles se desarrolló en esta teoría cuántica relativista . Años más tarde, la renormalización resolvió en gran medida este problema. Inicialmente vista como un procedimiento provisional y sospechoso por algunos de sus creadores, la renormalización finalmente fue adoptada como una herramienta importante y autoconsistente en la QED y otros campos de la física. Además, a fines de la década de 1940, los diagramas de Feynman proporcionaron una forma de hacer predicciones con QED al encontrar una amplitud de probabilidad para cada forma posible en que podría ocurrir una interacción. Los diagramas mostraron en particular que la fuerza electromagnética es el intercambio de fotones entre partículas que interactúan. [52]

El desplazamiento de Lamb es un ejemplo de predicción de la electrodinámica cuántica que se ha verificado experimentalmente. Se trata de un efecto por el cual la naturaleza cuántica del campo electromagnético hace que los niveles de energía de un átomo o ion se desvíen ligeramente de lo que serían de otro modo. Como resultado, las líneas espectrales pueden desplazarse o dividirse.

De manera similar, dentro de una onda electromagnética que se propaga libremente, la corriente también puede ser simplemente una corriente de desplazamiento abstracta , en lugar de involucrar portadores de carga. En la QED, su descripción completa hace uso esencial de partículas virtuales de vida corta . Allí, la QED nuevamente valida un concepto anterior, bastante misterioso.

Modelo estándar

El Modelo Estándar de la física de partículas es la teoría cuántica de campos que describe tres de las cuatro fuerzas fundamentales conocidas ( interacciones electromagnéticas , débiles y fuertes , excluyendo la gravedad ) en el universo y clasifica todas las partículas elementales conocidas . Se desarrolló en etapas a lo largo de la segunda mitad del siglo XX, a través del trabajo de muchos científicos de todo el mundo, y la formulación actual se finalizó a mediados de la década de 1970 tras la confirmación experimental de la existencia de los quarks . Desde entonces, la prueba del quark top (1995), el neutrino tau (2000) y el bosón de Higgs (2012) han agregado más credibilidad al Modelo Estándar. Además, el Modelo Estándar ha predicho varias propiedades de las corrientes neutras débiles y los bosones W y Z con gran precisión.

Aunque se cree que el Modelo Estándar es teóricamente autoconsistente y ha demostrado éxito en proporcionar predicciones experimentales , deja algunos fenómenos físicos sin explicar y, por lo tanto, no llega a ser una teoría completa de las interacciones fundamentales . Por ejemplo, no explica completamente la asimetría bariónica , no incorpora la teoría completa de la gravitación como se describe en la relatividad general ni explica la expansión acelerada del universo como posiblemente se describe mediante la energía oscura . El modelo no contiene ninguna partícula de materia oscura viable que posea todas las propiedades requeridas deducidas de la cosmología observacional . Tampoco incorpora oscilaciones de neutrinos y sus masas distintas de cero. En consecuencia, se utiliza como base para construir modelos más exóticos que incorporan partículas hipotéticas , dimensiones adicionales y simetrías elaboradas (como la supersimetría ) para explicar resultados experimentales que difieren del Modelo Estándar, como la existencia de materia oscura y oscilaciones de neutrinos.

Interpretaciones

Las mediciones físicas, ecuaciones y predicciones pertinentes a la mecánica cuántica son todas coherentes y tienen un nivel muy alto de confirmación. Sin embargo, la pregunta de qué dicen estos modelos abstractos sobre la naturaleza subyacente del mundo real ha recibido respuestas contradictorias. Estas interpretaciones son muy variadas y a veces algo abstractas. Por ejemplo, la interpretación de Copenhague afirma que antes de una medición, las afirmaciones sobre las propiedades de una partícula carecen completamente de sentido, mientras que la interpretación de los múltiples mundos describe la existencia de un multiverso formado por todos los universos posibles. [53]

La luz se comporta en algunos aspectos como partículas y en otros como ondas. La materia —la "materia" del universo que consiste en partículas como electrones y átomos— también exhibe un comportamiento ondulatorio . Algunas fuentes de luz, como las luces de neón , emiten solo ciertas frecuencias específicas de luz, un pequeño conjunto de colores puros distintos determinados por la estructura atómica del neón. La mecánica cuántica muestra que la luz, junto con todas las demás formas de radiación electromagnética , viene en unidades discretas, llamadas fotones , y predice sus energías espectrales (que corresponden a colores puros) y las intensidades de sus rayos de luz. Un solo fotón es un cuanto , o la partícula observable más pequeña, del campo electromagnético. Un fotón parcial nunca se observa experimentalmente. En términos más generales, la mecánica cuántica muestra que muchas propiedades de los objetos, como la posición, la velocidad y el momento angular , que parecían continuas en la vista ampliada de la mecánica clásica, resultan estar (en la escala diminuta y ampliada de la mecánica cuántica) cuantizadas . Se requiere que tales propiedades de las partículas elementales adopten uno de un conjunto de valores pequeños y discretos permitidos y, dado que la brecha entre estos valores también es pequeña, las discontinuidades solo son evidentes en escalas muy pequeñas (atómicas).

Aplicaciones

Aplicaciones cotidianas

La relación entre la frecuencia de la radiación electromagnética y la energía de cada fotón es la razón por la que la luz ultravioleta puede causar quemaduras solares , pero la luz visible o infrarroja no. Un fotón de luz ultravioleta proporciona una gran cantidad de energía , suficiente para contribuir al daño celular, como ocurre en una quemadura solar. Un fotón de luz infrarroja proporciona menos energía, solo la suficiente para calentar la piel. Por lo tanto, una lámpara infrarroja puede calentar una superficie grande, tal vez lo suficientemente grande como para mantener a las personas cómodas en una habitación fría, pero no puede provocar quemaduras solares a nadie. [54]

Aplicaciones tecnológicas

Las aplicaciones de la mecánica cuántica incluyen el láser , el transistor , el microscopio electrónico y la resonancia magnética . Una clase especial de aplicaciones de la mecánica cuántica está relacionada con los fenómenos cuánticos macroscópicos, como el helio superfluido y los superconductores. El estudio de los semiconductores condujo a la invención del diodo y el transistor , que son indispensables para la electrónica moderna .

Incluso en un interruptor de luz sencillo , el efecto túnel cuántico es absolutamente vital, ya que de lo contrario los electrones de la corriente eléctrica no podrían atravesar la barrera de potencial formada por una capa de óxido. Los chips de memoria flash que se encuentran en las unidades USB también utilizan el efecto túnel cuántico para borrar sus celdas de memoria. [55]

Véase también

- Los experimentos mentales de Einstein

- Fenómenos cuánticos macroscópicos

- Filosofía de la física

- Computación cuántica

- Partícula virtual

- Enseñanza de la mecánica cuántica

- Lista de libros de texto sobre mecánica clásica y cuántica

Notas

Las notas están en el guión principal.

Referencias

- ^ "Mecánica cuántica". National Public Radio . Consultado el 22 de junio de 2016 .

- ^ Kuhn, Thomas S. La estructura de las revoluciones científicas . Cuarta edición. Chicago; Londres: The University of Chicago Press, 2012. Impreso.

- ^ "Introducción a la mecánica cuántica". Socratease . Archivado desde el original el 15 de septiembre de 2017.

- ^ Feynman, Richard P. (1988). QED: la extraña teoría de la luz y la materia (1.ª edición de Princeton, séptima edición con correcciones). Princeton, NJ: Princeton University Press. pp. 10. ISBN. 978-0691024172.

- ^ abc Whittaker, Edmund T. (1989). Una historia de las teorías del éter y la electricidad. 2: Las teorías modernas, 1900 – 1926 (edición repetida). Nueva York: Dover Publ. ISBN 978-0-486-26126-3.

- ^ abcdef Baggott, JE (2013). La historia cuántica: una historia en 40 momentos (Impresión: 3.ª ed.). Oxford: Oxford Univ. Press. ISBN 978-0-19-965597-7.

- ^ Millikan, RA (1 de marzo de 1916). "Una determinación fotoeléctrica directa de la "h" de Planck". Physical Review . 7 (3): 355–388. Bibcode :1916PhRv....7..355M. doi :10.1103/PhysRev.7.355. ISSN 0031-899X.

- ^ Pais, A. (1 de octubre de 1979). "Einstein y la teoría cuántica". Reseñas de Física Moderna . 51 (4): 863–914. Bibcode :1979RvMP...51..863P. doi :10.1103/RevModPhys.51.863. ISSN 0034-6861.

- ^ Messiah, Albert (1966). Mecánica cuántica . North Holland, John Wiley & Sons. ISBN 0486409244.

- ^ "Observaciones sobre el estado y algunas ramificaciones del TEOREMA DE EHRENFEST" (PDF) . Archivado desde el original (PDF) el 10 de julio de 2021.

- ^ Friedrich, Bretislav; Herschbach, Dudley (diciembre de 2003). "Stern y Gerlach: cómo un cigarro malo ayudó a reorientar la física atómica". Física hoy . 56 (12): 53–59. Bibcode :2003PhT....56l..53F. doi : 10.1063/1.1650229 . ISSN 0031-9228.

- ^ Phipps, TE; Taylor, JB (1927). "El momento magnético del átomo de hidrógeno". Physical Review . 29 (2): 309–320. Código Bibliográfico :1927PhRv...29..309P. doi :10.1103/PhysRev.29.309.

- ^ Wolfgang Pauli (13 de diciembre de 1946). "Principio de exclusión y mecánica cuántica". Conferencia Nobel . Premio Nobel .

- ^ Ehrenfest, P. (noviembre de 1925). "Ersetzung der Hypothese vom unmechanischen Zwang durch eine Forderung bezüglich des internalen Verhaltens jedes einzelnen Elektrons". Die Naturwissenschaften (en alemán). 13 (47): 953–954. doi :10.1007/bf01558878. ISSN 0028-1042. S2CID 32211960.

- ^ de Broglie, Louis Victor. "Sobre la teoría de los cuantos" (PDF) . Fundación de Louis de Broglie (traducción al inglés de AF Kracklauer, 2004. ed.) . Consultado el 25 de febrero de 2023 .

- ^ Max Born, Mi vida: Recuerdos de un premio Nobel , Taylor & Francis, Londres, 1978. ("Nos convencimos cada vez más de que era necesario un cambio radical de los fundamentos de la física, es decir, un nuevo tipo de mecánica para el que utilizamos el término mecánica cuántica. Esta palabra aparece por primera vez en la literatura física en un artículo mío...")

- ^ Fedak, William A.; Prentis, Jeffrey J. (1 de febrero de 2009). "El artículo de Born y Jordan de 1925 "Sobre la mecánica cuántica"" (PDF) . American Journal of Physics . 77 (2): 128–139. Bibcode :2009AmJPh..77..128F. doi :10.1119/1.3009634. ISSN 0002-9505.

- ^ Nacido, Max (1926). "Zur Quantenmechanik der Stoßvorgänge" [Sobre la mecánica cuántica de las colisiones]. Zeitschrift für Physik . 37 (12): 863–867. Código bibliográfico : 1926ZPhy...37..863B. doi :10.1007/BF01397477.Reimpreso como Born, Max (1983). "Sobre la mecánica cuántica de las colisiones". En Wheeler, JA ; Zurek, WH (eds.). Teoría y medición cuánticas . Princeton University Press. págs. 52–55. ISBN 978-0-691-08316-2.

- ^ Davisson, C.; Germer, LH (1927). "Difracción de electrones por un cristal de níquel". Physical Review . 30 (6): 705–740. Bibcode :1927PhRv...30..705D. doi : 10.1103/physrev.30.705 . ISSN 0031-899X.

- ^ Davisson, CJ; Germer, LH (1928). "Reflexión de electrones por un cristal de níquel". Actas de la Academia Nacional de Ciencias . 14 (4): 317–322. Bibcode :1928PNAS...14..317D. doi : 10.1073/pnas.14.4.317 . ISSN 0027-8424. PMC 1085484 . PMID 16587341.

- ^ Davisson, C.; Germer, LH (1927). "La dispersión de electrones por un cristal único de níquel". Nature . 119 (2998): 558–560. doi :10.1038/119558a0. ISSN 0028-0836.

- ^ Davisson, CJ; Germer, LH (1928). "Reflexión y refracción de electrones por un cristal de níquel". Actas de la Academia Nacional de Ciencias . 14 (8): 619–627. Bibcode :1928PNAS...14..619D. doi : 10.1073/pnas.14.8.619 . ISSN 0027-8424. PMC 1085652 . PMID 16587378.

- ^ Bethe, H. (1928). "Theorie der Beugung von Elektronen an Kristallen". Annalen der Physik (en alemán). 392 (17): 55-129. Código bibliográfico : 1928AnP...392...55B. doi : 10.1002/andp.19283921704.

- ^ Thomson, GP; Reid, A. (1927). "Difracción de rayos catódicos por una película delgada". Nature . 119 (3007): 890. Bibcode :1927Natur.119Q.890T. doi : 10.1038/119890a0 . ISSN 0028-0836. S2CID 4122313.

- ^ . «18 de diciembre de 1926: Gilbert Lewis acuña el término «fotón» en una carta a Nature». www.aps.org . Consultado el 9 de marzo de 2019 .

- ^ Dirac, PAM (1 de marzo de 1927). "La teoría cuántica de la emisión y absorción de la radiación". Actas de la Royal Society de Londres. Serie A, que contiene artículos de carácter matemático y físico . 114 (767): 243–265. Bibcode :1927RSPSA.114..243D. doi : 10.1098/rspa.1927.0039 . ISSN 0950-1207.

- ^ Zettili, Nouredine (2009). Mecánica cuántica: conceptos y aplicaciones. John Wiley and Sons. págs. 26-27. ISBN 978-0470026786.

- ^ Selleri, Franco (2012). Dualidad onda-partícula. Springer Science and Business Media. pág. 41. ISBN 978-1461533320.

- ^ Podgorsak, Ervin B. (2013). Compendio de física de la radiación para físicos médicos. Springer Science and Business Media. pág. 88. ISBN 978-3642201868.

- ^ Halliday, David; Resnick, Robert (2013). Fundamentos de física, 10.ª edición. John Wiley and Sons. pág. 1272. ISBN 978-1118230619.[ enlace muerto permanente ]

- ^ Myers, Rusty L. (2006). Los fundamentos de la física . Greenwood Publishing Group. pp. 172. ISBN 0313328579.

principio de complementariedad dualidad onda-partícula.

- ^ ab Shamos, Morris H (1 de enero de 1987). Grandes experimentos en física: relatos de primera mano desde Galileo hasta Einstein . Courier Corporation. pág. 108.

- ^ Merali, Zeeya (21 de mayo de 2015). «Física cuántica: ¿qué es realmente real?». Nature . 521 (7552): 278–80. Bibcode :2015Natur.521..278M. doi : 10.1038/521278a . PMID 25993941. S2CID 4452144.

- ^ Eibenberger, Sandra (2013). "Interferencia de ondas de materia de partículas seleccionadas de una biblioteca molecular con masas superiores a 10 000 uma". Química física Física química . 15 (35): 14696–700. arXiv : 1310.8343 . Bibcode :2013PCCP...1514696E. doi :10.1039/C3CP51500A. PMID 23900710. S2CID 3944699.

[E]n un interferómetro de tres rejillas... Observamos patrones de franjas cuánticas de alto contraste de moléculas... que tienen 810 átomos en una sola partícula.

- ^ "El Premio Nobel de Física de 1932". NobelPrize.org .

- ^ Heisenberg publicó por primera vez su trabajo sobre el principio de incertidumbre en la importante revista alemana de física Zeitschrift für Physik : Heisenberg, W. (1927). "Über den anschaulichen Inhalt der quantentheoretischen Kinematik und Mechanik". Z. Física . 43 (3–4): 172–98. Código Bib : 1927ZPhy...43..172H. doi :10.1007/BF01397280. S2CID 122763326.

- ^ "El Premio Nobel de Física de 1932". NobelPrize.org .

- ^ "Principio de incertidumbre", Encyclopædia Britannica

- ^ Pauling, Linus (1960). La naturaleza del enlace químico (3.ª ed.). Itahca, NY: Cornell University Press. pág. 47. ISBN 0801403332. Recuperado el 1 de marzo de 2016 .

- ^ Einstein, A; B Podolsky; N Rosen (15 de mayo de 1935). "¿Puede considerarse completa la descripción mecánico-cuántica de la realidad física?" (PDF) . Physical Review . 47 (10): 777–780. Bibcode :1935PhRv...47..777E. doi : 10.1103/PhysRev.47.777 .

- ^ Peres, Asher (2002). Teoría cuántica: conceptos y métodos . Kluwer. pág. 149.

- ^ Schrödinger, E. (1935). "Discusión de las relaciones de probabilidad entre sistemas separados". Actas de la Sociedad Filosófica de Cambridge . 31 (4): 555. doi :10.1017/S0305004100013554.

Cuando dos sistemas, cuyos estados conocemos por su respectiva representación, entran en una interacción física temporal debido a fuerzas conocidas entre ellos y cuando después de un tiempo de influencia mutua los sistemas se separan de nuevo, entonces ya no pueden describirse como antes, es decir, dotando a cada uno de ellos de un representante propio. Yo no llamaría a eso

un

rasgo característico de la mecánica cuántica, sino más bien

el

rasgo característico de la mecánica cuántica, el que impone su total desviación de las líneas clásicas de pensamiento.

- ^ Parker, Sybil B. (1994). Enciclopedia McGraw-Hill de Física (2.ª ed.). McGraw-Hill. pág. 542. ISBN 978-0-07-051400-3.

- ^ Mermin, N. David (julio de 1993). "Variables ocultas y los dos teoremas de John Bell" (PDF) . Reseñas de física moderna . 65 (3): 803–15. arXiv : 1802.10119 . Código Bibliográfico :1993RvMP...65..803M. doi :10.1103/RevModPhys.65.803. S2CID 119546199.

- ^ The BIG Bell Test Collaboration (9 de mayo de 2018). «Desafiando el realismo local con elecciones humanas». Nature . 557 (7704): 212–216. arXiv : 1805.04431 . Bibcode :2018Natur.557..212B. doi :10.1038/s41586-018-0085-3. PMID 29743691. S2CID 13665914.

- ^ Wolchover, Natalie (7 de febrero de 2017). «Experimento reafirma rareza cuántica». Quanta Magazine . Consultado el 8 de febrero de 2020 .

- ^ "Mecánica", Diccionario en línea Merriam-Webster

- ^ "Campo", Enciclopedia Británica

- ^ Richard Hammond, El universo desconocido , New Page Books, 2008. ISBN 978-1601630032

- ^ "Físicos destacados: Paul Dirac 1902–1984". www.physicalworld.org . Archivado desde el original el 4 de marzo de 2016 . Consultado el 1 de diciembre de 2011 .

- ^ "El Premio Nobel de Física 1933". Fundación Nobel . Consultado el 24 de noviembre de 2007 .

- ^ "Partículas de intercambio". hyperphysics.phy-astr.gsu.edu . Consultado el 16 de octubre de 2018 .

- ^ "Interpretación de Copenhague". abyss.uoregon.edu . Archivado desde el original el 27 de febrero de 2020 . Consultado el 16 de octubre de 2018 .

- ^ Jim Lucas: '¿Qué es la luz ultravioleta?', 15 de septiembre de 2017, en livescience.com. Consultado el 27 de diciembre de 2017.

- ^ Durrani, ZAK; Ahmed, H. (2008). Vijay Kumar (ed.). Nanosilicon . Elsevier. pág. 345. ISBN 978-0080445281.

Bibliografía

- Bernstein, Jeremy (2005). "Max Born y la teoría cuántica". American Journal of Physics . 73 (11): 999–1008. Bibcode :2005AmJPh..73..999B. doi : 10.1119/1.2060717 .

- Beller, Mara (2001). Diálogo cuántico: la creación de una revolución . University of Chicago Press.

- Bohr, Niels (1958). Física atómica y conocimiento humano . John Wiley & Sons]. ISBN 0486479285.OCLC 530611 .

- de Broglie, Louis (1953). La revolución en la física . Noonday Press. LCCN 53010401.

- Bronner, Patrick; Strunz, Andreas; Silberhorn, Christine; Meyn, Jan-Peter (2009). "Demostración de aleatoriedad cuántica con fotones individuales". Revista Europea de Física . 30 (5): 1189–1200. Bibcode :2009EJPh...30.1189B. doi :10.1088/0143-0807/30/5/026. S2CID 7903179.

- Einstein, Albert (1934). Ensayos sobre ciencia . Biblioteca filosófica . ISBN 0486470113. Número de LCCN 55003947.

- Feigl, Herbert ; Brodbeck, May (1953). Lecturas sobre la filosofía de la ciencia . Appleton-Century-Crofts. ISBN 0390304883. Número de serie LCCN 53006438.

- Feynman, Richard P. (1949). "Enfoque espacio-temporal de la electrodinámica cuántica". Physical Review . 76 (6): 769–89. Bibcode :1949PhRv...76..769F. doi : 10.1103/PhysRev.76.769 .

- Feynman, Richard P. (1990). QED, La extraña teoría de la luz y la materia . Penguin Books. ISBN 978-0140125054.

- Fowler, Michael (1999). El átomo de Bohr. Universidad de Virginia.[ Falta ISBN ]

- Heisenberg, Werner (1958). Física y filosofía. Harper and Brothers. ISBN 0061305499. Código LCCN 99010404.

- Lakshmibala, S. (2004). "Heisenberg, mecánica matricial y el principio de incertidumbre". Resonancia: Revista de educación científica . 9 (8): 46–56. doi :10.1007/bf02837577. S2CID 29893512.

- Liboff, Richard L. (1992). Introducción a la mecánica cuántica (2.ª edición). Addison-Wesley Pub. Co. ISBN 9780201547153.[ Falta ISBN ]

- Lindsay, Robert Bruce; Margenau, Henry (1957). Fundamentos de la física . Dover. ISBN 0918024188. Número de serie LCCN 57014416.

- McEvoy, JP; Zarate, Oscar (2004). Introducción a la teoría cuántica. Icon Books. ISBN 1874166374.

- Nave, Carl Rod (2005). "Física cuántica". HyperPhysics . Universidad Estatal de Georgia.

- Peat, F. David (2002). De la certeza a la incertidumbre: la historia de la ciencia y las ideas en el siglo XXI . Joseph Henry Press .

- Reichenbach, Hans (1944). Fundamentos filosóficos de la mecánica cuántica. University of California Press. ISBN 0486404595.Código de artículo LCCN a44004471.

- Schilpp, Paul Arthur (1949). Albert Einstein: filósofo-científico . Tudor Publishing Company. LCCN 50005340.

- Revista Scientific American , 1953.

- Sears, Francis Weston (1949). Óptica (3.ª ed.). Addison-Wesley. ISBN 0195046013. Código LCCN 51001018.

- Shimony, A. (1983). "(título no indicado en la cita). Fundamentos de la mecánica cuántica a la luz de las nuevas tecnologías (S. Kamefuchi et al., eds.) . Tokio: Sociedad Japonesa de Física. pág. 225.; citado en: Popescu, Sandu; Daniel Rohrlich (1996). "Acción y pasión a distancia: un ensayo en honor del profesor Abner Shimony". arXiv : quant-ph/9605004 .

- Tavel, Morton; Tavel, Judith (ilustraciones) (2002). Física contemporánea y los límites del conocimiento. Rutgers University Press. ISBN 978-0813530772.

- Van Vleck, JH, 1928, "El principio de correspondencia en la interpretación estadística de la mecánica cuántica", Proc. Natl. Acad. Sci. 14: 179.

- Westmoreland; Benjamin Schumacher (1998). "Entrelazamiento cuántico y la inexistencia de señales superlumínicas". arXiv : quant-ph/9801014 .

- Wheeler, John Archibald ; Feynman, Richard P. (1949). "Electrodinámica clásica en términos de acción directa entre partículas" (PDF) . Reseñas de física moderna . 21 (3): 425–33. Bibcode :1949RvMP...21..425W. doi : 10.1103/RevModPhys.21.425 .

- Wieman, Carl; Perkins, Katherine (2005). "Transformando la educación en física". Physics Today . 58 (11): 36. Bibcode :2005PhT....58k..36W. doi :10.1063/1.2155756.

Lectura adicional

This section needs to be updated. (September 2021) |

Los siguientes títulos, todos ellos escritos por físicos en activo, intentan comunicar la teoría cuántica a la gente común, utilizando un mínimo de aparatos técnicos.

- Jim Al-Khalili (2003). Quantum: una guía para los perplejos . Weidenfeld & Nicolson. ISBN 978-1780225340 .

- Chester, Marvin (1987). Introducción a la mecánica cuántica . John Wiley. ISBN 0486428788 .

- Brian Cox y Jeff Forshaw (2011) El universo cuántico . Allen Lane. ISBN 978-1846144325 .

- Richard Feynman (1985). QED: La extraña teoría de la luz y la materia . Princeton University Press. ISBN 0691083886 .

- Ford, Kenneth (2005). El mundo cuántico . Harvard Univ. Press. Incluye física de partículas elementales.

- Ghirardi, GianCarlo (2004). Una mirada furtiva a las cartas de Dios , Gerald Malsbary, trad. Princeton Univ. Press. La obra más técnica de las citadas aquí. Los pasajes que utilizan álgebra , trigonometría y notación de bra-ket pueden pasarse por alto en una primera lectura.

- Tony Hey y Walters, Patrick (2003). El nuevo universo cuántico . Cambridge Univ. Press. Incluye gran cantidad de información sobre las tecnologías que la teoría cuántica ha hecho posibles. ISBN 978-0521564571 .

- Vladimir G. Ivancevic, Tijana T. Ivancevic (2008). Salto cuántico: desde Dirac y Feynman, a través del universo, hasta el cuerpo y la mente humanos . World Scientific Publishing Company. Proporciona una introducción intuitiva en términos no matemáticos y una introducción en términos matemáticos comparativamente básicos. ISBN 978-9812819277 .

- JP McEvoy y Oscar Zarate (2004). Introducción a la teoría cuántica . Totem Books. ISBN 1840465778

- N. David Mermin (1990). "Acciones fantasmales a distancia: misterios de la teoría cuántica" en su Boojums all the way through . Cambridge Univ. Press: 110–76. El autor es un físico poco común que intenta comunicarse con filósofos y humanistas. ISBN 978-0521388801 .

- Roland Omnès (1999). Entendiendo la mecánica cuántica . Princeton Univ. Press. ISBN 978-0691004358 .

- Victor Stenger (2000). Realidad atemporal: simetría, simplicidad y universos múltiples . Buffalo, NY: Prometheus Books. Cap. 5-8. ISBN 978-1573928595 .

- Martinus Veltman (2003). Hechos y misterios en la física de partículas elementales . World Scientific Publishing Company. ISBN 978-9812381491 .

Enlaces externos

- "El mundo microscópico: introducción a la mecánica cuántica", por Takada, Kenjiro, profesor emérito de la Universidad de Kyushu

- The Quantum Exchange (tutoriales y software de aprendizaje de código abierto).

- Los átomos y la tabla periódica

- Interferencia de rendija simple y doble

- Evolución temporal de un paquete de ondas en un pozo cuadrado Una demostración animada de la dispersión de un paquete de ondas a lo largo del tiempo.

- Carroll, Sean M. "Mecánica cuántica (una vergüenza)". Sesenta símbolos . Brady Haran para la Universidad de Nottingham.