Renormalización

| Renormalización y regularización |

|---|

| Teoría cuántica de campos |

|---|

|

| Historia |

La renormalización es un conjunto de técnicas de la teoría cuántica de campos , la teoría estadística de campos y la teoría de estructuras geométricas autosimilares que se utilizan para tratar los infinitos que surgen en cantidades calculadas alterando los valores de estas cantidades para compensar los efectos de sus autointeracciones . Pero incluso si no surgieran infinitos en los diagramas de bucles de la teoría cuántica de campos, se podría demostrar que sería necesario renormalizar la masa y los campos que aparecen en el lagrangiano original . [1]

Por ejemplo, una teoría de electrones puede comenzar postulando un electrón con una masa y carga iniciales. En la teoría cuántica de campos , una nube de partículas virtuales , como fotones , positrones y otras, rodea e interactúa con el electrón inicial. Tener en cuenta las interacciones de las partículas circundantes (por ejemplo, colisiones a diferentes energías) muestra que el sistema electrónico se comporta como si tuviera una masa y una carga diferentes a las postuladas inicialmente. La renormalización, en este ejemplo, reemplaza matemáticamente la masa y la carga postuladas inicialmente de un electrón con la masa y la carga observadas experimentalmente. Las matemáticas y los experimentos demuestran que los positrones y las partículas más masivas, como los protones, exhiben exactamente la misma carga observada que el electrón, incluso en presencia de interacciones mucho más fuertes y nubes más intensas de partículas virtuales.

La renormalización especifica las relaciones entre los parámetros de la teoría cuando los parámetros que describen escalas de distancias grandes difieren de los parámetros que describen escalas de distancias pequeñas. Físicamente, la acumulación de contribuciones de una infinidad de escalas involucradas en un problema puede dar lugar a más infinitos. Al describir el espacio-tiempo como un continuo, ciertas construcciones estadísticas y mecánicas cuánticas no están bien definidas . Para definirlas, o hacerlas inequívocas, un límite continuo debe eliminar cuidadosamente el "andamio de construcción" de redes a varias escalas. Los procedimientos de renormalización se basan en el requisito de que ciertas cantidades físicas (como la masa y la carga de un electrón) sean iguales a los valores observados (experimentales). Es decir, el valor experimental de la cantidad física produce aplicaciones prácticas, pero debido a su naturaleza empírica, la medición observada representa áreas de la teoría cuántica de campos que requieren una derivación más profunda a partir de bases teóricas.

La renormalización se desarrolló por primera vez en la electrodinámica cuántica (EDQ) para dar sentido a las integrales infinitas en la teoría de perturbaciones . Inicialmente considerada como un procedimiento provisional sospechoso incluso por algunos de sus creadores, la renormalización finalmente fue aceptada como un mecanismo real importante y autoconsistente de física de escala en varios campos de la física y las matemáticas . A pesar de su escepticismo posterior, fue Paul Dirac quien fue pionero en la renormalización. [2] [3]

Hoy en día, el punto de vista ha cambiado: sobre la base de los innovadores conocimientos del grupo de renormalización de Nikolay Bogolyubov y Kenneth Wilson , el enfoque se centra en la variación de las cantidades físicas en escalas contiguas, mientras que las escalas distantes se relacionan entre sí mediante descripciones "efectivas". Todas las escalas están vinculadas de una manera ampliamente sistemática, y la física real pertinente a cada una se extrae con las técnicas computacionales específicas adecuadas para cada una. Wilson aclaró qué variables de un sistema son cruciales y cuáles son redundantes.

La renormalización es distinta de la regularización , otra técnica para controlar los infinitos asumiendo la existencia de nueva física desconocida en nuevas escalas.

Interacciones internas en la física clásica

El problema de los infinitos surgió por primera vez en la electrodinámica clásica de partículas puntuales en el siglo XIX y principios del XX.

La masa de una partícula cargada debe incluir la masa-energía en su campo electrostático ( masa electromagnética ). Suponga que la partícula es una capa esférica cargada de radio r e . La masa-energía en el campo es

que se vuelve infinita cuando r e → 0 . Esto implica que la partícula puntual tendría una inercia infinita y, por lo tanto, no se la puede acelerar. Por cierto, el valor de r e que hace que sea igual a la masa del electrón se llama radio clásico del electrón , que ( factores de ajuste y restauración de c y ) resulta ser

donde es la constante de estructura fina , y es la longitud de onda Compton reducida del electrón.

Renormalización: La masa efectiva total de una partícula esférica cargada incluye la masa desnuda real de la capa esférica (además de la masa mencionada anteriormente asociada con su campo eléctrico). Si se permite que la masa desnuda de la capa sea negativa, podría ser posible tomar un límite puntual consistente. [ cita requerida ] Esto se llamó renormalización , y Lorentz y Abraham intentaron desarrollar una teoría clásica del electrón de esta manera. Este trabajo temprano fue la inspiración para los intentos posteriores de regularización y renormalización en la teoría cuántica de campos.

(Véase también regularización (física) para una forma alternativa de eliminar los infinitos de este problema clásico, suponiendo que existe nueva física en escalas pequeñas).

Al calcular las interacciones electromagnéticas de partículas cargadas , es tentador ignorar la reacción inversa del campo de una partícula sobre sí misma (de manera análoga a la fuerza contraelectromotriz del análisis de circuitos), pero esta reacción inversa es necesaria para explicar la fricción sobre las partículas cargadas cuando emiten radiación. Si se supone que el electrón es un punto, el valor de la reacción inversa diverge, por la misma razón que diverge la masa, porque el campo es inverso del cuadrado .

La teoría de Abraham-Lorentz tenía una "aceleración previa" no causal. A veces, un electrón comenzaba a moverse antes de que se aplicara la fuerza. Esto es una señal de que el límite puntual es inconsistente.

El problema era peor en la teoría clásica de campos que en la teoría cuántica de campos, porque en esta última una partícula cargada experimenta un Zitterbewegung debido a la interferencia con pares virtuales partícula-antipartícula, con lo que la carga se dispersa en una región comparable a la longitud de onda Compton. En la electrodinámica cuántica, con un acoplamiento pequeño, la masa electromagnética solo diverge como el logaritmo del radio de la partícula.

Divergencias en la electrodinámica cuántica

Al desarrollar la electrodinámica cuántica en la década de 1930, Max Born , Werner Heisenberg , Pascual Jordan y Paul Dirac descubrieron que en las correcciones perturbativas muchas integrales eran divergentes (véase El problema de los infinitos ).

Una forma de describir las divergencias de las correcciones de la teoría de perturbaciones fue descubierta en 1947-49 por Hans Kramers , [4] Hans Bethe , [5] Julian Schwinger , [6] [7] [8] [9] Richard Feynman , [10] [11] [12] y Shin'ichiro Tomonaga , [13] [14] [15] [16] [17] [18] [19] y sistematizada por Freeman Dyson en 1949. [20] Las divergencias aparecen en correcciones radiativas que involucran diagramas de Feynman con bucles cerrados de partículas virtuales en ellos.

Si bien las partículas virtuales obedecen a la conservación de la energía y el momento , pueden tener cualquier energía y momento, incluso uno que no esté permitido por la relación energía-momento relativista para la masa observada de esa partícula (es decir, no es necesariamente el cuadrado de la masa de la partícula en ese proceso, por ejemplo, para un fotón podría ser distinto de cero). Una partícula de este tipo se llama fuera de capa . Cuando hay un bucle, el momento de las partículas involucradas en el bucle no está determinado únicamente por las energías y los momentos de las partículas entrantes y salientes. Una variación en la energía de una partícula en el bucle puede equilibrarse con un cambio igual y opuesto en la energía de otra partícula en el bucle, sin afectar a las partículas entrantes y salientes. Por lo tanto, son posibles muchas variaciones. Entonces, para encontrar la amplitud para el proceso de bucle, uno debe integrar sobre todas las combinaciones posibles de energía y momento que podrían viajar alrededor del bucle.

Estas integrales suelen ser divergentes , es decir, dan infinitas respuestas. Las divergencias que son significativas son las " ultravioletas " (UV). Una divergencia ultravioleta puede describirse como aquella que proviene de

- la región en la integral donde todas las partículas en el bucle tienen grandes energías y momentos,

- longitudes de onda muy cortas y fluctuaciones de alta frecuencia de los campos, en la integral de trayectoria del campo,

- tiempo propio muy corto entre la emisión y la absorción de partículas, si se piensa en el bucle como una suma de trayectorias de partículas.

Por lo tanto, estas divergencias son fenómenos de corta distancia y de corto tiempo.

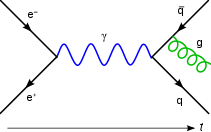

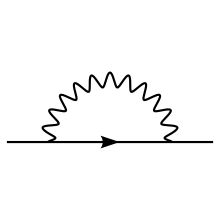

En las imágenes del margen derecho se muestran exactamente tres diagramas de bucle divergente de un bucle en la electrodinámica cuántica: [21]

- (a) Un fotón crea un par virtual electrón -positrón , que luego se aniquila. Este es un diagrama de polarización del vacío .

- (b) Un electrón emite y reabsorbe rápidamente un fotón virtual, llamado autoenergía .

- (c) Un electrón emite un fotón, emite un segundo fotón y reabsorbe el primero. Este proceso se muestra en la sección siguiente de la figura 2 y se denomina renormalización de vértices . El diagrama de Feynman para esto también se denomina " diagrama de pingüino " debido a que su forma se asemeja remotamente a la de un pingüino.

Las tres divergencias corresponden a los tres parámetros de la teoría considerada:

- La normalización de campo Z.

- La masa del electrón.

- La carga del electrón.

La segunda clase de divergencia, llamada divergencia infrarroja , se debe a partículas sin masa, como el fotón. Todo proceso que involucra partículas cargadas emite una cantidad infinita de fotones coherentes de longitud de onda infinita, y la amplitud para emitir cualquier número finito de fotones es cero. Para los fotones, estas divergencias se entienden bien. Por ejemplo, en el orden de 1 bucle, la función de vértice tiene divergencias tanto ultravioleta como infrarrojas . A diferencia de la divergencia ultravioleta, la divergencia infrarroja no requiere la renormalización de un parámetro en la teoría involucrada. La divergencia infrarroja del diagrama de vértice se elimina al incluir un diagrama similar al diagrama de vértice con la siguiente diferencia importante: el fotón que conecta las dos patas del electrón se corta y se reemplaza por dos fotones en la capa (es decir, reales) cuyas longitudes de onda tienden al infinito; este diagrama es equivalente al proceso de bremsstrahlung . Este diagrama adicional debe incluirse porque no hay forma física de distinguir un fotón de energía cero que fluye a través de un bucle como en el diagrama de vértices y los fotones de energía cero emitidos a través de la radiación de frenado . Desde un punto de vista matemático, las divergencias IR se pueden regularizar suponiendo una diferenciación fraccionaria con respecto a un parámetro, por ejemplo:

está bien definida en p = a pero es divergente UV; si tomamos la derivada fraccionaria 3 ⁄ 2 con respecto a − a 2 , obtenemos la divergencia IR

Así que podemos curar las divergencias IR convirtiéndolas en divergencias UV. [ aclaración necesaria ]

Una divergencia de bucle

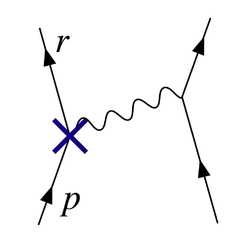

El diagrama de la Figura 2 muestra una de las diversas contribuciones de un bucle a la dispersión electrón-electrón en la electrodinámica cuántica. El electrón del lado izquierdo del diagrama, representado por la línea continua, comienza con un momento 4- p μ y termina con un momento 4- r μ . Emite un fotón virtual que lleva r μ − p μ para transferir energía y momento al otro electrón. Pero en este diagrama, antes de que eso suceda, emite otro fotón virtual que lleva un momento 4- q μ , y reabsorbe este después de emitir el otro fotón virtual. La conservación de la energía y el momento no determinan el momento 4- q μ de manera única, por lo que todas las posibilidades contribuyen por igual y debemos integrar.

La amplitud de este diagrama termina con, entre otras cosas, un factor del bucle de

Los diversos factores γ μ en esta expresión son matrices gamma como en la formulación covariante de la ecuación de Dirac ; tienen que ver con el espín del electrón. Los factores de e son la constante de acoplamiento eléctrico, mientras que proporcionan una definición heurística del contorno de integración alrededor de los polos en el espacio de momentos. La parte importante para nuestros propósitos es la dependencia de q μ de los tres grandes factores en el integrando, que son de los propagadores de las dos líneas de electrones y la línea de fotones en el bucle.

Esto tiene una pieza con dos potencias de q μ en la parte superior que domina en valores grandes de q μ (Pokorski 1987, p. 122):

Esta integral es divergente e infinita, a menos que la cortemos en energía y momento finitos de alguna manera.

Divergencias de bucles similares ocurren en otras teorías cuánticas de campos.

Cantidades renormalizadas y desnudas

La solución fue darse cuenta de que las cantidades que aparecían inicialmente en las fórmulas de la teoría (como la fórmula para el lagrangiano ), que representaban cosas como la carga eléctrica y la masa del electrón , así como las normalizaciones de los propios campos cuánticos, en realidad no se correspondían con las constantes físicas medidas en el laboratorio. Tal como estaban escritas, eran cantidades simples que no tenían en cuenta la contribución de los efectos de bucle de partículas virtuales a las propias constantes físicas . Entre otras cosas, estos efectos incluirían la contraparte cuántica de la reacción inversa electromagnética que tanto desconcertó a los teóricos clásicos del electromagnetismo. En general, estos efectos serían tan divergentes como las amplitudes consideradas en primer lugar; por lo que las cantidades medidas finitas implicarían, en general, cantidades simples divergentes.

Para hacer contacto con la realidad, entonces, las fórmulas tendrían que ser reescritas en términos de cantidades mensurables, renormalizadas . La carga del electrón, por ejemplo, se definiría en términos de una cantidad medida en un punto de renormalización cinemática o punto de sustracción específico (que generalmente tendrá una energía característica, llamada escala de renormalización o simplemente escala de energía ). Las partes del lagrangiano que queden, que involucran las porciones restantes de las cantidades desnudas, podrían entonces ser reinterpretadas como contratérminos , involucrados en diagramas divergentes que cancelen exactamente las divergencias problemáticas para otros diagramas.

Renormalización en QED

Por ejemplo, en el Lagrangiano de QED

Los campos y la constante de acoplamiento son realmente cantidades simples , de ahí el subíndice B anterior. Convencionalmente, las cantidades simples se escriben de modo que los términos lagrangianos correspondientes sean múltiplos de los renormalizados:

La invariancia de calibre , a través de una identidad de Ward-Takahashi , implica que podemos renormalizar los dos términos de la pieza derivada covariante

juntos (Pokorski 1987, p. 115), que es lo que le pasó a Z 2 ; es lo mismo que Z 1 .

Un término en este Lagrangiano, por ejemplo, la interacción electrón-fotón ilustrada en la Figura 1, puede entonces escribirse

La constante física e , la carga del electrón, puede entonces definirse en términos de algún experimento específico: fijamos la escala de renormalización igual a la característica de energía de este experimento, y el primer término da la interacción que vemos en el laboratorio (hasta correcciones pequeñas y finitas de los diagramas de bucles, que proporcionan elementos exóticos como las correcciones de alto orden al momento magnético ). El resto es el contratérmino. Si la teoría es renormalizable (ver más abajo para más información sobre esto), como lo es en QED, las partes divergentes de los diagramas de bucles pueden descomponerse en piezas con tres o menos patas, con una forma algebraica que puede ser cancelada por el segundo término (o por los contratérminos similares que provienen de Z 0 y Z 3 ).

El diagrama con el vértice de interacción del contratérmino Z 1 colocado como en la Figura 3 cancela la divergencia del bucle en la Figura 2.

Históricamente, la división de los "términos desnudos" en términos originales y contratérminos se produjo antes de la idea del grupo de renormalización debido a Kenneth Wilson . [22] Según estas ideas del grupo de renormalización , detalladas en la siguiente sección, esta división no es natural y, en realidad, no es física, ya que todas las escalas del problema entran en formas sistemáticas continuas.

Acoplamientos de funcionamiento

Para minimizar la contribución de los diagramas de bucles a un cálculo dado (y por lo tanto facilitar la extracción de resultados), se elige un punto de renormalización cercano a las energías y momentos intercambiados en la interacción. Sin embargo, el punto de renormalización no es en sí mismo una cantidad física: las predicciones físicas de la teoría, calculadas para todos los órdenes, deberían en principio ser independientes de la elección del punto de renormalización, siempre que esté dentro del dominio de aplicación de la teoría. Los cambios en la escala de renormalización simplemente afectarán qué parte de un resultado proviene de los diagramas de Feynman sin bucles y qué parte proviene de las partes finitas restantes de los diagramas de bucles. Se puede explotar este hecho para calcular la variación efectiva de las constantes físicas con los cambios en la escala. Esta variación está codificada por funciones beta , y la teoría general de este tipo de dependencia de la escala se conoce como el grupo de renormalización .

En términos coloquiales, los físicos de partículas suelen hablar de ciertas "constantes" físicas que varían con la energía de la interacción, aunque, de hecho, la escala de renormalización es la cantidad independiente. Sin embargo, este funcionamiento proporciona un medio conveniente para describir los cambios en el comportamiento de una teoría de campo bajo cambios en las energías involucradas en una interacción. Por ejemplo, dado que el acoplamiento en cromodinámica cuántica se vuelve pequeño a grandes escalas de energía, la teoría se comporta más como una teoría libre a medida que la energía intercambiada en una interacción se vuelve grande, un fenómeno conocido como libertad asintótica . La elección de una escala de energía creciente y el uso del grupo de renormalización lo deja claro a partir de diagramas de Feynman simples; si no se hiciera esto, la predicción sería la misma, pero surgiría de cancelaciones complicadas de alto orden.

Por ejemplo,

Está mal definido.

Para eliminar la divergencia, simplemente cambie el límite inferior de la integral en ε a y ε b :

Asegurándose de εb/es una → 1 , entonces I = ln a/b .

Regularización

Dado que la cantidad ∞ − ∞ está mal definida, para hacer precisa esta noción de cancelación de divergencias, las divergencias primero deben ser controladas matemáticamente usando la teoría de límites , en un proceso conocido como regularización (Weinberg, 1995).

Una modificación esencialmente arbitraria de los integrandos del bucle, o regulador , puede hacer que desaparezcan más rápidamente a energías y momentos altos, de tal manera que las integrales converjan. Un regulador tiene una escala de energía característica conocida como el valor de corte ; al llevar este valor de corte al infinito (o, equivalentemente, la escala de longitud/tiempo correspondiente a cero) se recuperan las integrales originales.

Con el regulador en su lugar y un valor finito para el límite de corte, los términos divergentes en las integrales se convierten en términos finitos pero dependientes del límite de corte. Después de cancelar estos términos con las contribuciones de los contratérminos dependientes del límite de corte, el límite de corte se lleva al infinito y se recuperan resultados físicos finitos. Si la física en escalas que podemos medir es independiente de lo que sucede en las escalas de distancia y tiempo más cortas, entonces debería ser posible obtener resultados independientes del límite de corte para los cálculos.

En los cálculos de la teoría cuántica de campos se utilizan muchos tipos diferentes de reguladores, cada uno con sus ventajas y desventajas. Uno de los más populares en el uso moderno es la regularización dimensional , inventada por Gerardus 't Hooft y Martinus JG Veltman , [23] que domestica las integrales llevándolas a un espacio con un número fraccionario ficticio de dimensiones. Otra es la regularización de Pauli-Villars , que agrega partículas ficticias a la teoría con masas muy grandes, de modo que los integrandos de bucle que involucran a las partículas masivas cancelan los bucles existentes en momentos grandes.

Otro esquema de regularización es la regularización reticular , introducida por Kenneth Wilson , que pretende que la red hipercúbica construye nuestro espacio-tiempo con un tamaño de cuadrícula fijo. Este tamaño es un límite natural para el momento máximo que una partícula podría poseer al propagarse en la red. Y después de hacer un cálculo en varias redes con diferentes tamaños de cuadrícula, el resultado físico se extrapola al tamaño de cuadrícula 0, o nuestro universo natural. Esto presupone la existencia de un límite de escala .

Un enfoque matemático riguroso para la teoría de la renormalización es la llamada teoría de perturbación causal , en la que las divergencias ultravioleta se evitan desde el principio en los cálculos mediante la realización de operaciones matemáticas bien definidas solo en el marco de la teoría de la distribución . En este enfoque, las divergencias se reemplazan por ambigüedad: a un diagrama divergente corresponde un término que ahora tiene un coeficiente finito, pero indeterminado. Luego deben usarse otros principios, como la simetría de calibre, para reducir o eliminar la ambigüedad.

Actitudes e interpretación

Los primeros formuladores de la QED y otras teorías cuánticas de campos, por regla general, no estaban satisfechos con esta situación. Les parecía ilegítimo hacer algo equivalente a restar infinitos de infinitos para obtener respuestas finitas.

Freeman Dyson argumentó que estos infinitos son de naturaleza básica y no pueden eliminarse mediante ningún procedimiento matemático formal, como el método de renormalización. [24] [25]

La crítica de Dirac fue la más persistente. [26] Incluso en 1975, decía: [27]

- La mayoría de los físicos están muy satisfechos con la situación. Dicen: "La electrodinámica cuántica es una buena teoría y ya no tenemos que preocuparnos por ella". Debo decir que estoy muy insatisfecho con la situación porque esta supuesta "buena teoría" implica descuidar los infinitos que aparecen en sus ecuaciones, ignorándolos de manera arbitraria. Esto simplemente no es matemática sensata. La matemática sensata implica ignorar una cantidad cuando es pequeña, ¡no ignorarla solo porque es infinitamente grande y no la queremos!

Otro crítico importante fue Feynman . A pesar de su papel crucial en el desarrollo de la electrodinámica cuántica, escribió lo siguiente en 1985: [28]

- El juego de trileros que utilizamos para encontrar n y j se llama técnicamente "renormalización". Pero, por muy ingeniosa que sea la palabra, ¡sigue siendo lo que yo llamaría un proceso tonto! El hecho de tener que recurrir a semejantes artimañas nos ha impedido demostrar que la teoría de la electrodinámica cuántica es matemáticamente autoconsistente. Es sorprendente que todavía no se haya demostrado que la teoría sea autoconsistente en un sentido u otro; sospecho que la renormalización no es matemáticamente legítima.

Feynman estaba preocupado por el hecho de que todas las teorías de campos conocidas en la década de 1960 tenían la propiedad de que las interacciones se volvían infinitamente fuertes en escalas de distancia suficientemente cortas. Esta propiedad, llamada polo de Landau , hacía plausible que todas las teorías cuánticas de campos fueran inconsistentes. En 1974, Gross , Politzer y Wilczek demostraron que otra teoría cuántica de campos, la cromodinámica cuántica , no tenía un polo de Landau. Feynman, junto con la mayoría de los demás, aceptó que la QCD era una teoría completamente consistente. [ cita requerida ]

El malestar general era casi universal en los textos hasta los años 1970 y 1980. Sin embargo, a partir de los años 1970, inspirados por el trabajo sobre el grupo de renormalización y la teoría de campos efectivos , y a pesar del hecho de que Dirac y varios otros, todos ellos pertenecientes a la generación anterior, nunca retiraron sus críticas, las actitudes comenzaron a cambiar, especialmente entre los teóricos más jóvenes. Kenneth G. Wilson y otros demostraron que el grupo de renormalización es útil en la teoría estadística de campos aplicada a la física de la materia condensada , donde proporciona importantes conocimientos sobre el comportamiento de las transiciones de fase . En la física de la materia condensada, existe un regulador físico de corta distancia: la materia deja de ser continua en la escala de los átomos . Las divergencias de corta distancia en la física de la materia condensada no presentan un problema filosófico ya que la teoría de campos es solo una representación efectiva y suavizada del comportamiento de la materia de todos modos; no hay infinitos ya que el límite es siempre finito, y tiene todo el sentido que las cantidades básicas dependan del límite.

Si la teoría cuántica de campos se mantiene más allá de la longitud de Planck (donde podría dar lugar a la teoría de cuerdas , la teoría de conjuntos causales o algo diferente), entonces puede que tampoco haya un problema real con las divergencias de corta distancia en la física de partículas ; todas las teorías de campo podrían ser simplemente teorías de campo efectivas. En cierto sentido, este enfoque se hace eco de la actitud más antigua de que las divergencias en la teoría cuántica de campos hablan de la ignorancia humana sobre el funcionamiento de la naturaleza, pero también reconoce que esta ignorancia se puede cuantificar y que las teorías efectivas resultantes siguen siendo útiles.

Sea como fuere, la observación de Salam [29] en 1972 parece todavía relevante.

- Los infinitos de la teoría de campos –que se encontraron por primera vez en el cálculo de la masa propia del electrón por parte de Lorentz– han persistido en la electrodinámica clásica durante setenta años y en la electrodinámica cuántica durante unos treinta y cinco. Estos largos años de frustración han dejado en el sujeto un curioso afecto por los infinitos y una creencia apasionada de que son una parte inevitable de la naturaleza; tanto es así que incluso la sugerencia de una esperanza de que, después de todo, puedan ser eludidos –y se puedan calcular valores finitos para las constantes de renormalización– se considera irracional. Compárese la posdata de Russell al tercer volumen de su autobiografía The Final Years, 1944–1969 (George Allen and Unwin, Ltd., Londres 1969), [30] p. 221:

- En el mundo moderno, si las comunidades son infelices, es a menudo porque tienen ignorancias, hábitos, creencias y pasiones que les resultan más caras que la felicidad o incluso la vida. En nuestra peligrosa época, encuentro a muchos hombres que parecen estar enamorados de la miseria y la muerte, y que se enfadan cuando se les insinúa esperanzas. Piensan que la esperanza es irracional y que, al sentarse a la perezosa desesperación, simplemente están enfrentándose a los hechos.

En la teoría cuántica de campos, el valor de una constante física, en general, depende de la escala que se elija como punto de renormalización, y resulta muy interesante examinar el funcionamiento del grupo de renormalización de las constantes físicas bajo cambios en la escala de energía. Las constantes de acoplamiento en el Modelo Estándar de la física de partículas varían de diferentes maneras con el aumento de la escala de energía: el acoplamiento de la cromodinámica cuántica y el acoplamiento débil de isospín de la fuerza electrodébil tienden a disminuir, y el acoplamiento débil de hipercarga de la fuerza electrodébil tiende a aumentar. En la colosal escala de energía de 10 15 GeV (mucho más allá del alcance de nuestros aceleradores de partículas actuales ), todas se vuelven aproximadamente del mismo tamaño (Grotz y Klapdor 1990, p. 254), una motivación importante para las especulaciones sobre la gran teoría unificada . En lugar de ser solo un problema preocupante, la renormalización se ha convertido en una herramienta teórica importante para estudiar el comportamiento de las teorías de campo en diferentes regímenes.

Si una teoría que presenta renormalización (por ejemplo, la QED) sólo puede interpretarse sensatamente como una teoría de campo eficaz, es decir, como una aproximación que refleja la ignorancia humana sobre el funcionamiento de la naturaleza, entonces sigue existiendo el problema de descubrir una teoría más precisa que no presente estos problemas de renormalización. Como ha dicho Lewis Ryder : "En la teoría cuántica, estas divergencias [clásicas] no desaparecen; por el contrario, parecen empeorar. Y a pesar del éxito relativo de la teoría de la renormalización, sigue existiendo la sensación de que debería haber una forma más satisfactoria de hacer las cosas". [31]

Renormalizabilidad

De esta reevaluación filosófica se desprende naturalmente un nuevo concepto: la noción de renormalizabilidad. No todas las teorías se prestan a la renormalización de la manera descrita anteriormente, con un suministro finito de contratérminos y todas las cantidades que se vuelven independientes del punto de corte al final del cálculo. Si el lagrangiano contiene combinaciones de operadores de campo de dimensión suficientemente alta en unidades de energía, los contratérminos necesarios para cancelar todas las divergencias proliferan hasta un número infinito y, a primera vista, la teoría parecería ganar un número infinito de parámetros libres y, por lo tanto, perder todo poder predictivo, volviéndose científicamente inútil. Tales teorías se denominan no renormalizables .

El modelo estándar de física de partículas contiene sólo operadores renormalizables, pero las interacciones de la relatividad general se convierten en operadores no renormalizables si uno intenta construir una teoría de campo de la gravedad cuántica de la manera más directa (tratando la métrica en el lagrangiano de Einstein-Hilbert como una perturbación sobre la métrica de Minkowski ), lo que sugiere que la teoría de perturbaciones no es satisfactoria en su aplicación a la gravedad cuántica.

Sin embargo, en una teoría de campos efectiva , la "renormalizabilidad" es, estrictamente hablando, un nombre inapropiado . En la teoría de campos efectiva no renormalizable, los términos en el lagrangiano se multiplican hasta el infinito, pero tienen coeficientes suprimidos por potencias inversas cada vez más extremas del límite de energía. Si el límite es una cantidad física real, es decir, si la teoría es solo una descripción efectiva de la física hasta cierta escala de energía máxima o distancia mínima, entonces estos términos adicionales podrían representar interacciones físicas reales. Suponiendo que las constantes adimensionales en la teoría no se vuelven demasiado grandes, uno puede agrupar los cálculos por potencias inversas del límite y extraer predicciones aproximadas de orden finito en el límite que aún tienen un número finito de parámetros libres. Incluso puede ser útil renormalizar estas interacciones "no renormalizables".

Las interacciones no renormalizables en las teorías de campos efectivos se debilitan rápidamente a medida que la escala de energía se vuelve mucho más pequeña que el límite. El ejemplo clásico es la teoría de Fermi de la fuerza nuclear débil , una teoría efectiva no renormalizable cuyo límite es comparable a la masa de la partícula W. Este hecho también puede proporcionar una posible explicación de por qué casi todas las interacciones de partículas que vemos son descriptibles por teorías renormalizables. Puede ser que cualquier otra que pueda existir en la escala GUT o de Planck simplemente se vuelva demasiado débil para detectarla en el ámbito que podemos observar, con una excepción: la gravedad , cuya interacción extremadamente débil se magnifica por la presencia de las enormes masas de estrellas y planetas . [ cita requerida ]

Esquemas de renormalización

This section may be confusing or unclear to readers. (January 2022) |

En los cálculos reales, los contratérminos introducidos para cancelar las divergencias en los cálculos del diagrama de Feynman más allá del nivel de árbol deben corregirse mediante un conjunto de condiciones de renormalización . Los esquemas de renormalización comunes en uso incluyen:

- Esquema de sustracción mínima (MS) y esquema de sustracción mínima modificada (MS-bar) relacionado

- Esquema sobre el caparazón

Además, existe una definición "natural" del acoplamiento renormalizado (combinado con el propagador de fotones) como un propagador de bosones libres duales, que no requiere explícitamente la introducción de los contratérminos. [32]

En física estadística

Historia

Una comprensión más profunda del significado físico y la generalización del proceso de renormalización, que va más allá del grupo de dilatación de las teorías renormalizables convencionales , provino de la física de la materia condensada. El artículo de Leo P. Kadanoff en 1966 propuso el grupo de renormalización de "bloqueo-espín". [33] La idea del bloqueo es una forma de definir los componentes de la teoría a grandes distancias como agregados de componentes a distancias más cortas.

Este enfoque cubrió el punto conceptual y recibió plena sustancia computacional [22] en las extensas e importantes contribuciones de Kenneth Wilson . El poder de las ideas de Wilson quedó demostrado por una solución iterativa de renormalización constructiva de un problema de larga data, el problema de Kondo , en 1974, así como por los desarrollos seminales previos de su nuevo método en la teoría de transiciones de fase de segundo orden y fenómenos críticos en 1971. Recibió el premio Nobel por estas contribuciones decisivas en 1982.

Principios

En términos más técnicos, supongamos que tenemos una teoría descrita por una determinada función de las variables de estado y un determinado conjunto de constantes de acoplamiento . Esta función puede ser una función de partición , una función de acción , un hamiltoniano , etc. Debe contener la descripción completa de la física del sistema.

Ahora consideramos una cierta transformación de bloqueo de las variables de estado , el número de debe ser menor que el número de . Ahora intentemos reescribir la función solo en términos de . Si esto se puede lograr mediante un cierto cambio en los parámetros, , entonces se dice que la teoría es renormalizable .

Los posibles estados macroscópicos del sistema, a gran escala, vienen dados por este conjunto de puntos fijos.

Puntos fijos del grupo de renormalización

La información más importante en el flujo RG son sus puntos fijos . Un punto fijo se define por la desaparición de la función beta asociada al flujo. Entonces, los puntos fijos del grupo de renormalización son, por definición, invariantes de escala. En muchos casos de interés físico, la invariancia de escala se amplía hasta convertirse en invariancia conforme. Entonces, se tiene una teoría de campo conforme en el punto fijo.

La capacidad de varias teorías de confluir en el mismo punto fijo conduce a la universalidad .

Si estos puntos fijos corresponden a la teoría de campo libre, se dice que la teoría exhibe trivialidad cuántica . Numerosos puntos fijos aparecen en el estudio de las teorías de Higgs en red , pero la naturaleza de las teorías de campo cuántico asociadas con ellas sigue siendo una cuestión abierta. [34]

Véase también

- Historia de la teoría cuántica de campos

- Trivialidad cuántica

- Las paradojas de Zenón

- Corrección no oblicua

Referencias

- ^ Véase, por ejemplo, Weinberg vol. I, capítulo 10.

- ^ Sanyuk, Valerii I.; Sukhanov, Alexander D. (1 de septiembre de 2003). "Dirac en la física del siglo XX: una evaluación del centenario". Física-Uspekhi . 46 (9): 937–956. doi :10.1070/PU2003v046n09ABEH001165. ISSN 1063-7869.

- ^ Kar, Arnab (2014). Renormalización de la física clásica a la cuántica (tesis). Universidad de Rochester.

- ↑ Kramers presentó su trabajo en la Conferencia de Shelter Island de 1947 , que se repitió en 1948 en la Conferencia Solvay . Esta última no apareció impresa hasta las Actas de la Conferencia Solvay, publicadas en 1950 (véase Laurie M. Brown (ed.), Renormalization: From Lorentz to Landau (and Beyond) , Springer, 2012, p. 53). El enfoque de Kramers no era relativista (véase Jagdish Mehra , Helmut Rechenberg , The Conceptual Completion and Extensions of Quantum Mechanics 1932–1941. Epilogue: Aspects of the Further Development of Quantum Theory 1942–1999: Volumes 6, Part 2 , Springer, 2001, p. 1050).

- ^ H. Bethe (1947). "El cambio electromagnético de los niveles de energía". Physical Review . 72 (4): 339–341. Bibcode :1947PhRv...72..339B. doi :10.1103/PhysRev.72.339. S2CID 120434909.

- ^ Schwinger, J. (1948). "Sobre la electrodinámica cuántica y el momento magnético del electrón". Physical Review . 73 (4): 416–417. Bibcode :1948PhRv...73..416S. doi : 10.1103/PhysRev.73.416 .

- ^ Schwinger, J. (1948). "I. Una formulación covariante". Physical Review . Electrodinámica cuántica. 74 (10): 1439–1461. Bibcode :1948PhRv...74.1439S. doi :10.1103/PhysRev.74.1439.

- ^ Schwinger, J. (1949). "II. Polarización del vacío y autoenergía". Physical Review . Electrodinámica cuántica. 75 (4): 651–679. Bibcode :1949PhRv...75..651S. doi :10.1103/PhysRev.75.651.

- ^ Schwinger, J. (1949). "III. Las propiedades electromagnéticas de las correcciones radiativas de los electrones a la dispersión". Physical Review . Electrodinámica cuántica. 76 (6): 790–817. Bibcode :1949PhRv...76..790S. doi :10.1103/PhysRev.76.790.

- ^ Feynman, Richard P. (1948). "Aproximación espacio-temporal a la mecánica cuántica no relativista" (PDF) . Reseñas de Física Moderna . 20 (2): 367–387. Bibcode :1948RvMP...20..367F. doi :10.1103/RevModPhys.20.367.

- ^ Feynman, Richard P. (1948). "Un límite relativista para la electrodinámica clásica" (PDF) . Physical Review . 74 (8): 939–946. Bibcode :1948PhRv...74..939F. doi :10.1103/PhysRev.74.939.

- ^ Feynman, Richard P. (1948). "Un límite relativista para la electrodinámica cuántica" (PDF) . Physical Review . 74 (10): 1430–1438. Bibcode :1948PhRv...74.1430F. doi :10.1103/PhysRev.74.1430.

- ^ Tomonaga, S. (1 de agosto de 1946). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas". Progreso de la física teórica . 1 (2). Oxford University Press (OUP): 27–42. Bibcode :1946PThPh...1...27T. doi : 10.1143/ptp.1.27 . ISSN 1347-4081.

- ^ Koba, Z.; Tati, T.; Tomonaga, S.-i. (1 de octubre de 1947). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas. II: caso de campos electromagnéticos y electrónicos en interacción". Progreso de la física teórica . 2 (3). Oxford University Press (OUP): 101–116. Bibcode :1947PThPh...2..101K. doi : 10.1143/ptp/2.3.101 . ISSN 0033-068X.

- ^ Koba, Z.; Tati, T.; Tomonaga, S.-i. (1 de diciembre de 1947). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas. III: Caso de campos electromagnéticos y electrónicos en interacción". Progreso de la física teórica . 2 (4). Oxford University Press (OUP): 198–208. Bibcode :1947PThPh...2..198K. doi : 10.1143/ptp/2.4.198 . ISSN 0033-068X.

- ^ Kanesawa, S.; Tomonaga, S.-i. (1 de marzo de 1948). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas. [IV]: Caso de campos electromagnéticos y mesónicos en interacción". Progreso de la física teórica . 3 (1). Oxford University Press (OUP): 1–13. doi : 10.1143/ptp/3.1.1 . ISSN 0033-068X.

- ^ Kanesawa, S.; Tomonaga, S.-i. (1 de junio de 1948). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas V: caso de campos electromagnéticos y mesónicos en interacción". Progreso de la física teórica . 3 (2). Oxford University Press (OUP): 101–113. Bibcode :1948PThPh...3..101K. doi : 10.1143/ptp/3.2.101 . ISSN 0033-068X.

- ^ Koba, Z.; Tomonaga, S.-i. (1 de septiembre de 1948). "Sobre las reacciones de radiación en los procesos de colisión. I: Aplicación del método de sustracción "autoconsistente" a la dispersión elástica de un electrón". Progreso de la física teórica . 3 (3). Oxford University Press (OUP): 290–303. Bibcode :1948PThPh...3..290K. doi :10.1143/ptp/3.3.290. ISSN 0033-068X.

- ^ Tomonaga, Sin-Itiro; Oppenheimer, JR (15 de julio de 1948). "Sobre reacciones de campo infinito en la teoría cuántica de campos". Physical Review . 74 (2). American Physical Society (APS): 224–225. Bibcode :1948PhRv...74..224T. doi :10.1103/physrev.74.224. ISSN 0031-899X.

- ^ Dyson, FJ (1949). "Las teorías de la radiación de Tomonaga, Schwinger y Feynman". Phys. Rev . 75 (3): 486–502. Bibcode :1949PhRv...75..486D. doi : 10.1103/PhysRev.75.486 .

- ^ Peskin, Michael E .; Schroeder, Daniel V. (1995). Introducción a la teoría cuántica de campos . Lectura: Addison-Wesley. Capítulo 10. ISBN 9780201503975.

- ^ ab Wilson, Kenneth G. (1 de octubre de 1975). "El grupo de renormalización: fenómenos críticos y el problema de Kondo". Reseñas de física moderna . 47 (4). Sociedad Estadounidense de Física (APS): 773–840. Código Bibliográfico :1975RvMP...47..773W. doi :10.1103/revmodphys.47.773. ISSN 0034-6861.

- ^ 't Hooft, G.; Veltman, M. (1972). "Regularización y renormalización de campos de calibración". Física nuclear B . 44 (1): 189–213. Código Bibliográfico :1972NuPhB..44..189T. doi :10.1016/0550-3213(72)90279-9. hdl : 1874/4845 .

- ^ Dyson, FJ (15 de febrero de 1952). "Divergencia de la teoría de perturbaciones en la electrodinámica cuántica". Physical Review . 85 (4). American Physical Society (APS): 631–632. Bibcode :1952PhRv...85..631D. doi :10.1103/physrev.85.631. ISSN 0031-899X.

- ^ Stern, AW (7 de noviembre de 1952). "Espacio, campo y éter en la física contemporánea". Science . 116 (3019). Asociación Estadounidense para el Avance de la Ciencia (AAAS): 493–496. Bibcode :1952Sci...116..493S. doi :10.1126/science.116.3019.493. ISSN 0036-8075. PMID 17801299.

- ^ PAM Dirac, "La evolución de la imagen que los físicos tienen de la naturaleza", en Scientific American, mayo de 1963, pág. 53.

- ^ Kragh, Helge; Dirac: Una biografía científica , CUP 1990, p. 184

- ^ Feynman, Richard P. QED: The Strange Theory of Light and Matter . Princeton: Princeton University Press, 1985, p. 128. El pasaje citado está disponible aquí a través de Google Books (versión electrónica de 2014 de la reimpresión de 2006 de la primera impresión de 1985).

- ^ Isham, CJ; Salam, Abdus; Strathdee, J. (15 de mayo de 1972). "Supresión del infinito en la electrodinámica modificada por la gravedad. II". Physical Review D . 5 (10). American Physical Society (APS): 2548–2565. Bibcode :1972PhRvD...5.2548I. doi :10.1103/physrevd.5.2548. ISSN 0556-2821.

- ^ Russell, Bertrand. La autobiografía de Bertrand Russell: Los últimos años, 1944-1969 (Bantam Books, 1970)

- ^ Ryder, Lewis. Teoría cuántica de campos , página 390 (Cambridge University Press 1996).

- ^ Makogon, D.; Morais Smith, C. (2022). "Aproximación del punto medio y su aplicación para el estudio de sistemas fermiónicos". Phys. Rev. B . 105 (17): 174505. arXiv : 1909.12553 . Código Bibliográfico :2022PhRvB.105q4505M. doi :10.1103/PhysRevB.105.174505. S2CID 203591796.

- ^ LP Kadanoff (1966): "Leyes de escala para modelos de Ising cerca de ", Física (Long Island City, NY) 2 , 263.

- ^ DJE Callaway (1988). "Búsqueda de trivialidades: ¿pueden existir partículas escalares elementales?". Physics Reports . 167 (5): 241–320. Bibcode :1988PhR...167..241C. doi :10.1016/0370-1573(88)90008-7.

Lectura adicional

Introducción general

- DeDeo, Simon; Introducción a la renormalización (2017). Curso en línea masivo y abierto sobre complejidad del Instituto Santa Fe . Renormalización desde el punto de vista de los sistemas complejos, incluidas las cadenas de Markov, los autómatas celulares, el modelo de Ising del espacio real, el teorema de Krohn-Rhodes, la electrodinámica cuántica y la teoría de la distorsión de la velocidad.

- Delamotte, Bertrand (2004). "Un indicio de renormalización". American Journal of Physics . 72 (2): 170–184. arXiv : hep-th/0212049 . Código Bibliográfico :2004AmJPh..72..170D. doi :10.1119/1.1624112. S2CID 2506712.

- Baez, John; Renormalization Made Easy, (2005). Una introducción cualitativa al tema.

- Blechman, Andrew E.; Renormalization: Our Greatly Misunderstood Friend (Renormalización: nuestra amiga muy incomprendida), (2002). Resumen de una conferencia; contiene más información sobre esquemas específicos de regularización y divergencia-sustracción.

- Cao, Tian Yu; Schweber, Silvan S. (1993). "Los fundamentos conceptuales y los aspectos filosóficos de la teoría de la renormalización". Synthese . 97 : 33–108. doi :10.1007/BF01255832. S2CID 46968305.

- Shirkov, Dmitry ; Fifty Years of the Renormalization Group , CERN Courrier 41(7) (2001). Texto completo disponible en : IOP Magazines.

- E. Elizalde; Técnicas de regularización zeta con aplicaciones .

Principalmente: teoría cuántica de campos

- NN Bogoliubov , DV Shirkov (1959): La teoría de los campos cuantizados . Nueva York, Interscience. El primer libro de texto sobre la teoría de grupos de renormalización .

- Ryder, Lewis H.; Teoría cuántica de campos (Cambridge University Press, 1985), ISBN 0-521-33859-X Libro de texto de fácil lectura, sin duda la mejor introducción a la QFT relativista para la física de partículas.

- Zee, Anthony; Quantum Field Theory in a Nutshell , Princeton University Press (2003) ISBN 0-691-01019-6 . Otro excelente libro de texto sobre QFT

- Weinberg, Steven; La teoría cuántica de campos (3 volúmenes) Cambridge University Press (1995). Un tratado monumental sobre la teoría cuántica de campos escrito por un experto destacado, premio Nobel en 1979.

- Pokorski, Stefan; Teorías de campos de calibre , Cambridge University Press (1987) ISBN 0-521-47816-2 .

- 't Hooft, Gerard; The Glorious Days of Physics – Renormalization of Gauge theory (Los gloriosos días de la física: renormalización de las teorías de calibre ), conferencia pronunciada en Erice (agosto/septiembre de 1998) por el premio Nobel de 1999. Texto completo disponible en: hep-th/9812203.

- Rivasseau, Vincent; Introducción a la renormalización , Poincaré Seminar (París, 12 de octubre de 2002), publicado en: Duplantier, Bertrand; Rivasseau, Vincent (Eds.); Poincaré Seminar 2002 , Progress in Mathematical Physics 30, Birkhäuser (2003) ISBN 3-7643-0579-7 . Texto completo disponible en PostScript.

- Rivasseau, Vincent; De la renormalización perturbativa a la renormalización constructiva , Princeton University Press (1991) ISBN 0-691-08530-7 . Texto completo disponible en PostScript [ enlace muerto permanente ] y en PDF (versión borrador).

- Iagolnitzer, Daniel y Magnen, J.; Análisis de grupos de renormalización , Encyclopaedia of Mathematics, Kluwer Academic Publisher (1996). Texto completo disponible en formato PostScript y PDF aquí.

- Scharf, Günter; Electrodinámica cuántica finita: el enfoque causal , Springer Verlag Berlin Heidelberg Nueva York (1995) ISBN 3-540-60142-2 .

- AS Švarc ( Albert Schwarz ), Математические основы квантовой теории поля, (Aspectos matemáticos de la teoría cuántica de campos), Atomizdat, Moscú, 1975. 368 págs.

Principalmente: física estadística

- AN Vasil'ev; El grupo de renormalización teórica de campo en la teoría crítica del comportamiento y la dinámica estocástica (Routledge Chapman & Hall 2004); ISBN 978-0-415-31002-4

- Nigel Goldenfeld ; Lectures on Phase Transitions and the Renormalization Group , Frontiers in Physics 85, Westview Press (junio de 1992) ISBN 0-201-55409-7 . Este popular libro, que cubre los aspectos elementales de la física de las transiciones de fase y el grupo de renormalización, pone énfasis en la comprensión y la claridad en lugar de en las manipulaciones técnicas.

- Zinn-Justin, Jean; Teoría cuántica de campos y fenómenos críticos , Oxford University Press (4.ª edición, 2002), ISBN 0-19-850923-5 . Una obra maestra sobre las aplicaciones de los métodos de renormalización al cálculo de exponentes críticos en mecánica estadística, siguiendo las ideas de Wilson (Kenneth Wilson fue premio Nobel en 1982).

- Zinn-Justin, Jean; Phase Transitions & Renormalization Group: from Theory to Numbers , Poincaré Seminar (París, 12 de octubre de 2002), publicado en: Duplantier, Bertrand; Rivasseau, Vincent (Eds.); Poincaré Seminar 2002 , Progress in Mathematical Physics 30, Birkhäuser (2003) ISBN 3-7643-0579-7 . Texto completo disponible en PostScript. Archivado el 15 de octubre de 2005 en Wayback Machine .

- Domb, Cyril; El punto crítico: una introducción histórica a la teoría moderna de los fenómenos críticos , CRC Press (marzo de 1996) ISBN 0-7484-0435-X .

- Brown, Laurie M. (Ed.); Renormalización: de Lorentz a Landau (y más allá) , Springer-Verlag (Nueva York-1993) ISBN 0-387-97933-6 .

- Cardy, John ; Escalamiento y renormalización en física estadística , Cambridge University Press (1996) ISBN 0-521-49959-3 .

Misceláneas

- Shirkov, Dmitry ; The Bogoliubov Renormalization Group , JINR Communication E2-96-15 (1996). Texto completo disponible en: hep-th/9602024

- Zinn-Justin, Jean; Renormalización y grupo de renormalización: desde el descubrimiento de las divergencias UV hasta el concepto de teorías de campos efectivas , en: de Witt-Morette C., Zuber J.-B. (eds), Actas de la NATO ASI sobre teoría cuántica de campos: perspectiva y prospectiva , 15-26 de junio de 1998, Les Houches, Francia, Kluwer Academic Publishers, NATO ASI Series C 530, 375-388 (1999). Texto completo disponible en PostScript.

- Connes, Alain; Symétries Galoisiennes & Renormalisation , Poincaré Seminar (París, 12 de octubre de 2002), publicado en : Duplantier, Bertrand; Rivasseau, Vincent (Eds.); Poincaré Seminar 2002 , Progress in Mathematical Physics 30, Birkhäuser (2003) ISBN 3-7643-0579-7 . El matemático francés Alain Connes (medalla Fields 1982) describe la estructura matemática subyacente (el álgebra de Hopf ) de la renormalización y su vínculo con el problema de Riemann-Hilbert. El texto completo (en francés) está disponible en arXiv :math/0211199.

![{\displaystyle {\mathcal {L}}={\bar {\psi }}_{B}\left[i\gamma _{\mu }\left(\partial ^{\mu }+ie_{B}A_{B}^{\mu }\right)-m_{B}\right]\psi _{B}-{\frac {1}{4}}F_{B\mu \nu }F_{B}^{\mu \nu }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/380fd2c0d942ca26fb6e07d41132bd041f98c187)