Distribución beta

Función de densidad de probabilidad  | |||

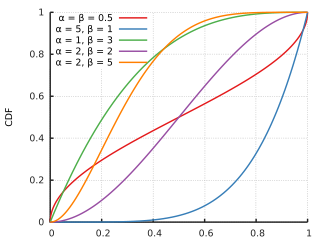

Función de distribución acumulativa  | |||

| Notación | Beta( α , β ) | ||

|---|---|---|---|

| Parámetros | α > 0 forma ( real ) β > 0 forma ( real ) | ||

| Apoyo | o | ||

donde y es la función Gamma . | |||

| CDF | (la función beta incompleta regularizada ) | ||

| Significar |

| ||

| Mediana | |||

| Modo | para α , β > 1 cualquier valor en para α , β = 1 {0, 1} (bimodal) para α , β < 1 0 para α ≤ 1, β ≥ 1, α ≠ β 1 para α ≥ 1, β ≤ 1, α ≠ β | ||

| Diferencia | (ver función trigamma y ver sección: Varianza geométrica) | ||

| Oblicuidad | |||

| Exceso de curtosis | |||

| Entropía | |||

| MGF | |||

| CF | (ver Función hipergeométrica confluente ) | ||

| Información de Fisher | Ver sección: Matriz de información de Fisher | ||

| Método de momentos | |||

En teoría de probabilidad y estadística , la distribución beta es una familia de distribuciones de probabilidad continuas definidas en el intervalo [0, 1] o (0, 1) en términos de dos parámetros positivos , denotados por alfa ( α ) y beta ( β ), que aparecen como exponentes de la variable y su complemento a 1, respectivamente, y controlan la forma de la distribución.

La distribución beta se ha aplicado para modelar el comportamiento de variables aleatorias limitadas a intervalos de longitud finita en una amplia variedad de disciplinas. La distribución beta es un modelo adecuado para el comportamiento aleatorio de porcentajes y proporciones.

En la inferencia bayesiana , la distribución beta es la distribución de probabilidad previa conjugada para las distribuciones de Bernoulli , binomial , binomial negativa y geométrica .

La formulación de la distribución beta que se analiza aquí también se conoce como distribución beta de primer tipo , mientras que la distribución beta de segundo tipo es un nombre alternativo para la distribución beta prima . La generalización a múltiples variables se denomina distribución de Dirichlet .

Definiciones

Función de densidad de probabilidad

La función de densidad de probabilidad (PDF) de la distribución beta, para o , y parámetros de forma , , es una función de potencia de la variable y de su reflejo como sigue:

donde es la función gamma . La función beta , , es una constante de normalización para garantizar que la probabilidad total sea 1. En las ecuaciones anteriores hay una realización —un valor observado que realmente ocurrió— de una variable aleatoria .

Varios autores, incluidos NL Johnson y S. Kotz , [1] utilizan los símbolos y (en lugar de y ) para los parámetros de forma de la distribución beta, que recuerdan a los símbolos utilizados tradicionalmente para los parámetros de la distribución de Bernoulli , porque la distribución beta se aproxima a la distribución de Bernoulli en el límite cuando ambos parámetros de forma y se aproximan al valor de cero.

A continuación, se presenta una variable aleatoria con distribución beta y parámetros y que se denotará por: [2] [3]

Otras notaciones para variables aleatorias distribuidas en beta utilizadas en la literatura estadística son [4] y [5] .

Función de distribución acumulativa

La función de distribución acumulativa es

donde es la función beta incompleta y es la función beta incompleta regularizada .

Parametrizaciones alternativas

Dos parámetros

Media y tamaño de la muestra

La distribución beta también puede ser reparametrizada en términos de su media μ (0 < μ < 1) y la suma de los dos parámetros de forma ν = α + β > 0 ( [3] p. 83). Denotando por αPosterior y βPosterior los parámetros de forma de la distribución beta posterior resultante de aplicar el teorema de Bayes a una función de verosimilitud binomial y una probabilidad previa, la interpretación de la suma de ambos parámetros de forma como tamaño de muestra = ν = α ·Posterior + β ·Posterior solo es correcta para la probabilidad previa de Haldane Beta(0,0). Específicamente, para la previa de Bayes (uniforme) Beta(1,1) la interpretación correcta sería tamaño de muestra = α ·Posterior + β Posterior − 2, o ν = (tamaño de muestra) + 2. Para un tamaño de muestra mucho mayor que 2, la diferencia entre estas dos previas se vuelve insignificante. (Ver la sección Inferencia bayesiana para más detalles.) ν = α + β se conoce como el "tamaño de muestra" de una distribución beta, pero uno debe recordar que es, estrictamente hablando, el "tamaño de muestra" de una función de verosimilitud binomial solo cuando se utiliza una distribución previa Haldane Beta(0,0) en el teorema de Bayes.

Esta parametrización puede ser útil en la estimación de parámetros bayesianos. Por ejemplo, se puede administrar una prueba a un número de individuos. Si se supone que la puntuación de cada persona (0 ≤ θ ≤ 1) se extrae de una distribución beta a nivel de población, entonces una estadística importante es la media de esta distribución a nivel de población. Los parámetros de media y tamaño de muestra están relacionados con los parámetros de forma α y β a través de [3].

- α = μν , β = (1 − μ ) ν

Bajo esta parametrización , se puede colocar una probabilidad previa no informativa sobre la media y una probabilidad previa vaga (como una distribución exponencial o gamma ) sobre los reales positivos para el tamaño de la muestra, si son independientes y los datos y/o creencias previos lo justifican.

Modo y concentración

Las distribuciones beta cóncavas , que tienen , se pueden parametrizar en términos de moda y "concentración". La moda, , y la concentración, , se pueden utilizar para definir los parámetros de forma habituales de la siguiente manera: [6]

Para que la moda, , esté bien definida, necesitamos , o equivalentemente . Si en cambio definimos la concentración como , la condición se simplifica a y la densidad beta en y puede escribirse como:

donde escala directamente las estadísticas suficientes , y . Nótese también que en el límite, , la distribución se vuelve plana.

Media y varianza

Resolviendo el sistema de ecuaciones (acopladas) dado en las secciones anteriores como las ecuaciones para la media y la varianza de la distribución beta en términos de los parámetros originales α y β , se pueden expresar los parámetros α y β en términos de la media ( μ ) y la varianza (var):

Esta parametrización de la distribución beta puede llevar a una comprensión más intuitiva que la basada en los parámetros originales α y β . Por ejemplo, expresando la moda, la asimetría, el exceso de curtosis y la entropía diferencial en términos de la media y la varianza:

Cuatro parámetros

Una distribución beta con los dos parámetros de forma α y β se admite en el rango [0,1] o (0,1). Es posible alterar la ubicación y la escala de la distribución introduciendo dos parámetros adicionales que representan los valores mínimos, a , y máximos c ( c > a ), de la distribución, [1] mediante una transformación lineal que sustituye la variable adimensional x en términos de la nueva variable y (con soporte [ a , c ] o ( a , c )) y los parámetros a y c :

La función de densidad de probabilidad de la distribución beta de cuatro parámetros es igual a la distribución de dos parámetros, escalada por el rango ( c − a ), (de modo que el área total bajo la curva de densidad es igual a una probabilidad de uno), y con la variable "y" desplazada y escalada de la siguiente manera:

Que una variable aleatoria Y tenga una distribución beta con cuatro parámetros α, β, a y c se denotará por:

Algunas medidas de ubicación central se escalan (por ( c − a )) y se desplazan (por a ), de la siguiente manera:

Nota: la media geométrica y la media armónica no se pueden transformar mediante una transformación lineal como sí lo hacen la media, la mediana y la moda.

Los parámetros de forma de Y se pueden escribir en términos de su media y varianza como

Las medidas de dispersión estadística se escalan (no es necesario desplazarlas porque ya están centradas en la media) por el rango ( c − a ), linealmente para la desviación media y no linealmente para la varianza:

Dado que la asimetría y el exceso de curtosis son cantidades adimensionales (como momentos centrados en la media y normalizados por la desviación estándar ), son independientes de los parámetros a y c , y por lo tanto iguales a las expresiones dadas anteriormente en términos de X (con soporte [0,1] o (0,1)):

Propiedades

Medidas de tendencia central

Modo

La moda de una variable aleatoria distribuida beta X con α , β > 1 es el valor más probable de la distribución (correspondiente al pico en la PDF), y se da mediante la siguiente expresión: [1]

Cuando ambos parámetros son menores que uno ( α , β < 1), este es el antimodo: el punto más bajo de la curva de densidad de probabilidad. [7]

Si α = β , la expresión para la moda se simplifica a 1/2, lo que demuestra que para α = β > 1 la moda (o antimoda cuando α , β < 1 ), está en el centro de la distribución: es simétrica en esos casos. Consulte la sección Formas de este artículo para obtener una lista completa de casos de moda, para valores arbitrarios de α y β . Para varios de estos casos, el valor máximo de la función de densidad ocurre en uno o ambos extremos. En algunos casos, el valor (máximo) de la función de densidad que ocurre en el extremo es finito. Por ejemplo, en el caso de α = 2, β = 1 (o α = 1, β = 2), la función de densidad se convierte en una distribución de triángulo rectángulo que es finita en ambos extremos. En varios otros casos, hay una singularidad en un extremo, donde el valor de la función de densidad se acerca al infinito. Por ejemplo, en el caso α = β = 1/2, la distribución beta se simplifica para convertirse en la distribución arcoseno . Existe un debate entre los matemáticos sobre algunos de estos casos y sobre si los extremos ( x = 0 y x = 1) pueden llamarse modos o no. [8] [2]

- Si los extremos son parte del dominio de la función de densidad

- Si una singularidad puede alguna vez ser llamada un modo

- ¿Los casos con dos máximos deben llamarse bimodales?

Mediana

_for_Beta_distribution_versus_alpha_and_beta_from_0_to_2_-_J._Rodal.jpg/440px-(Mean_-_Median)_for_Beta_distribution_versus_alpha_and_beta_from_0_to_2_-_J._Rodal.jpg)

La mediana de la distribución beta es el único número real para el cual se obtiene la función beta incompleta regularizada . No existe una expresión general en forma cerrada para la mediana de la distribución beta para valores arbitrarios de α y β . A continuación se presentan expresiones en forma cerrada para valores particulares de los parámetros α y β : [ cita requerida ]

- Para casos simétricos α = β , mediana = 1/2.

- Para α = 1 y β > 0, mediana (este caso es la imagen especular de la distribución de la función de potencia [0,1])

- Para α > 0 y β = 1, mediana = (en este caso se trata de la distribución de la función de potencia [0,1] [8] )

- Para α = 3 y β = 2, la mediana = 0,6142724318676105..., la solución real de la ecuación cuártica 1 − 8 x 3 + 6 x 4 = 0, que se encuentra en [0,1].

- Para α = 2 y β = 3, mediana = 0,38572756813238945... = 1−mediana(Beta(3, 2))

Los siguientes son los límites con un parámetro finito (distinto de cero) y el otro que se aproxima a estos límites: [ cita requerida ]

Una aproximación razonable del valor de la mediana de la distribución beta, tanto para α como para β mayores o iguales a uno, viene dada por la fórmula [9]

Cuando α, β ≥ 1, el error relativo (el error absoluto dividido por la mediana) en esta aproximación es menor que 4% y tanto para α ≥ 2 como para β ≥ 2 es menor que 1%. El error absoluto dividido por la diferencia entre la media y la moda es igualmente pequeño:

Significar

El valor esperado (media) ( μ ) de una variable aleatoria de distribución beta X con dos parámetros α y β es una función únicamente de la relación β / α de estos parámetros: [1]

Si en la expresión anterior se toma α = β , se obtiene μ = 1/2 , lo que demuestra que para α = β la media está en el centro de la distribución: es simétrica. Además, se pueden obtener los siguientes límites a partir de la expresión anterior:

Por lo tanto, para β / α → 0, o para α / β → ∞, la media se encuentra en el extremo derecho, x = 1. Para estas razones límite, la distribución beta se convierte en una distribución degenerada de un punto con un pico de función delta de Dirac en el extremo derecho, x = 1 , con probabilidad 1 y probabilidad cero en el resto. Hay una probabilidad del 100 % (certeza absoluta) concentrada en el extremo derecho, x = 1 .

De manera similar, para β / α → ∞, o para α / β → 0, la media se ubica en el extremo izquierdo, x = 0. La distribución beta se convierte en una distribución degenerada de 1 punto con un pico de función delta de Dirac en el extremo izquierdo, x = 0, con probabilidad 1 y probabilidad cero en todos los demás lugares. Hay una probabilidad del 100 % (certeza absoluta) concentrada en el extremo izquierdo, x = 0. A continuación se muestran los límites con un parámetro finito (distinto de cero) y el otro que se acerca a estos límites:

Mientras que para distribuciones unimodales típicas (con modas ubicadas centralmente, puntos de inflexión a ambos lados de la moda y colas más largas) (con Beta( α , β ) tal que α , β > 2 ) se sabe que la media de la muestra (como una estimación de la ubicación) no es tan robusta como la mediana de la muestra, lo opuesto es el caso de distribuciones bimodales uniformes o "en forma de U" (con Beta( α , β ) tal que α , β ≤ 1 ), con las modas ubicadas en los extremos de la distribución. Como señalan Mosteller y Tukey ( [10] p. 207) "el promedio de las dos observaciones extremas utiliza toda la información de la muestra. Esto ilustra cómo, para distribuciones de cola corta, las observaciones extremas deberían tener más peso". Por el contrario, se deduce que la mediana de las distribuciones bimodales "en forma de U" con modas en el borde de la distribución (con Beta( α , β ) tal que α , β ≤ 1 ) no es robusta, ya que la mediana de la muestra excluye las observaciones de muestra extremas de la consideración. Una aplicación práctica de esto ocurre, por ejemplo, para los paseos aleatorios , ya que la probabilidad para el momento de la última visita al origen en un paseo aleatorio se distribuye como la distribución de arcoseno Beta(1/2, 1/2): [5] [11] la media de un número de realizaciones de un paseo aleatorio es un estimador mucho más robusto que la mediana (que es una estimación de medida de muestra inapropiada en este caso).

Media geométrica

_for_Beta_Distribution_versus_alpha_and_beta_from_0_to_2_-_J._Rodal.jpg/440px-(Mean_-_GeometricMean)_for_Beta_Distribution_versus_alpha_and_beta_from_0_to_2_-_J._Rodal.jpg)

,_Yellow=G(1-X),_smaller_values_alpha_and_beta_in_front_-_J._Rodal.jpg/440px-Geometric_Means_for_Beta_distribution_Purple=G(X),_Yellow=G(1-X),_smaller_values_alpha_and_beta_in_front_-_J._Rodal.jpg)

,_Yellow=G(1-X),_larger_values_alpha_and_beta_in_front_-_J._Rodal.jpg/440px-Geometric_Means_for_Beta_distribution_Purple=G(X),_Yellow=G(1-X),_larger_values_alpha_and_beta_in_front_-_J._Rodal.jpg)

El logaritmo de la media geométrica G X de una distribución con variable aleatoria X es la media aritmética de ln( X ), o, equivalentemente, su valor esperado:

Para una distribución beta, la integral del valor esperado da:

donde ψ es la función digamma .

Por lo tanto, la media geométrica de una distribución beta con parámetros de forma α y β es la exponencial de las funciones digamma de α y β como sigue:

Mientras que para una distribución beta con parámetros de forma iguales α = β, se deduce que asimetría = 0 y moda = media = mediana = 1/2, la media geométrica es menor que 1/2: 0 < G X < 1/2 . La razón de esto es que la transformación logarítmica pondera fuertemente los valores de X cercanos a cero, ya que ln( X ) tiende fuertemente hacia el infinito negativo a medida que X se acerca a cero, mientras que ln( X ) se aplana hacia cero a medida que X → 1 .

A lo largo de una línea α = β , se aplican los siguientes límites:

A continuación se presentan los límites con un parámetro finito (distinto de cero) y el otro que se aproxima a estos límites:

El gráfico adjunto muestra la diferencia entre la media y la media geométrica para los parámetros de forma α y β desde cero hasta 2. Además del hecho de que la diferencia entre ellos se acerca a cero a medida que α y β se acercan al infinito y que la diferencia se hace grande para los valores de α y β que se acercan a cero, se puede observar una evidente asimetría de la media geométrica con respecto a los parámetros de forma α y β. La diferencia entre la media geométrica y la media es mayor para valores pequeños de α en relación con β que cuando se intercambian las magnitudes de β y α.

NLJohnson y S. Kotz [1] sugieren la aproximación logarítmica a la función digamma ψ ( α ) ≈ ln( α − 1/2) que da como resultado la siguiente aproximación a la media geométrica:

Los valores numéricos para el error relativo en esta aproximación son los siguientes: [ ( α = β = 1): 9,39 % ]; [ ( α = β =2): 1,29% ]; [ ( α = 2, β = 3): 1,51% ]; [ ( α = 3, β = 2): 0,44% ]; [ ( α = β = 3): 0,51% ]; [ ( α = β = 4): 0,26% ]; [ ( α = 3, β = 4): 0,55% ]; [ ( α = 4, β = 3): 0,24% ].

De manera similar, se puede calcular el valor de los parámetros de forma necesarios para que la media geométrica sea igual a 1/2. Dado el valor del parámetro β , ¿cuál sería el valor del otro parámetro, α , necesario para que la media geométrica sea igual a 1/2?. La respuesta es que (para β > 1 ), el valor de α necesario tiende hacia β + 1/2 cuando β → ∞ . Por ejemplo, todas estas parejas tienen la misma media geométrica de 1/2: [ β = 1, α = 1.4427 ], [ β = 2, α = 2.46958 ], [ β = 3, α = 3.47943 ], [ β = 4, α = 4.48449 ], [ β = 5, α = 5.48756 ], [ β = 10, α = 10,4938 ], [ β = 100, α = 100,499 ].

La propiedad fundamental de la media geométrica, que puede demostrarse falsa para cualquier otra media, es

Esto hace que la media geométrica sea la única media correcta cuando se promedian resultados normalizados , es decir, resultados que se presentan como proporciones de valores de referencia. [12] Esto es relevante porque la distribución beta es un modelo adecuado para el comportamiento aleatorio de los porcentajes y es particularmente adecuada para el modelado estadístico de proporciones. La media geométrica juega un papel central en la estimación de máxima verosimilitud, véase la sección "Estimación de parámetros, máxima verosimilitud". En realidad, cuando se realiza la estimación de máxima verosimilitud, además de la media geométrica G X basada en la variable aleatoria X, también aparece naturalmente otra media geométrica: la media geométrica basada en la transformación lineal –– (1 − X ) , la imagen especular de X , denotada por G (1− X ) :

A lo largo de una línea α = β , se aplican los siguientes límites:

A continuación se presentan los límites con un parámetro finito (distinto de cero) y el otro que se aproxima a estos límites:

Tiene el siguiente valor aproximado:

Aunque tanto G X como G (1− X ) son asimétricas, en el caso de que ambos parámetros de forma sean iguales α = β , las medias geométricas son iguales: G X = G (1− X ) . Esta igualdad se desprende de la siguiente simetría que se muestra entre ambas medias geométricas:

Media armónica

_for_Beta_distribution_versus_alpha_and_beta_from_0_to_2_-_J._Rodal.jpg/440px-(Mean_-_HarmonicMean)_for_Beta_distribution_versus_alpha_and_beta_from_0_to_2_-_J._Rodal.jpg)

,_Yellow=H(1-X),_smaller_values_alpha_and_beta_in_front_-_J._Rodal.jpg/440px-Harmonic_Means_for_Beta_distribution_Purple=H(X),_Yellow=H(1-X),_smaller_values_alpha_and_beta_in_front_-_J._Rodal.jpg)

,_Yellow=H(1-X),_larger_values_alpha_and_beta_in_front_-_J._Rodal.jpg/440px-Harmonic_Means_for_Beta_distribution_Purple=H(X),_Yellow=H(1-X),_larger_values_alpha_and_beta_in_front_-_J._Rodal.jpg)

La inversa de la media armónica ( H X ) de una distribución con variable aleatoria X es la media aritmética de 1/ X o, equivalentemente, su valor esperado. Por lo tanto, la media armónica ( H X ) de una distribución beta con parámetros de forma α y β es:

La media armónica ( H X ) de una distribución beta con α < 1 no está definida, porque su expresión definitoria no está acotada en [0, 1] para un parámetro de forma α menor que la unidad.

Dejando α = β en la expresión anterior se obtiene

mostrando que para α = β la media armónica varía de 0, para α = β = 1, a 1/2, para α = β → ∞.

A continuación se presentan los límites con un parámetro finito (distinto de cero) y el otro que se aproxima a estos límites:

La media armónica desempeña un papel en la estimación de máxima verosimilitud para el caso de cuatro parámetros, además de la media geométrica. En realidad, al realizar la estimación de máxima verosimilitud para el caso de cuatro parámetros, además de la media armónica H X basada en la variable aleatoria X , también aparece naturalmente otra media armónica: la media armónica basada en la transformación lineal (1 − X ), la imagen especular de X , denotada por H 1 − X :

La media armónica ( H (1 − X ) ) de una distribución beta con β < 1 no está definida, porque su expresión definitoria no está acotada en [0, 1] para un parámetro de forma β menor que la unidad.

Dejando α = β en la expresión anterior se obtiene

mostrando que para α = β la media armónica varía de 0, para α = β = 1, a 1/2, para α = β → ∞.

A continuación se presentan los límites con un parámetro finito (distinto de cero) y el otro que se aproxima a estos límites:

Aunque tanto H X como H 1− X son asimétricas, en el caso de que ambos parámetros de forma sean iguales α = β , las medias armónicas son iguales: H X = H 1− X . Esta igualdad se desprende de la siguiente simetría que se muestra entre ambas medias armónicas:

Medidas de dispersión estadística

Diferencia

La varianza (el segundo momento centrado en la media) de una variable aleatoria de distribución beta X con parámetros α y β es: [1] [13]

Dejando α = β en la expresión anterior se obtiene

mostrando que para α = β la varianza disminuye monótonamente a medida que α = β aumenta. Fijando α = β = 0 en esta expresión, se encuentra la varianza máxima var( X ) = 1/4 [1] que solo ocurre al acercarse al límite, en α = β = 0 .

La distribución beta también puede parametrizarse en términos de su media μ (0 < μ < 1) y tamaño de muestra ν = α + β ( ν > 0 ) (ver subsección Media y tamaño de muestra):

Utilizando esta parametrización , se puede expresar la varianza en términos de la media μ y el tamaño de la muestra ν de la siguiente manera:

Dado que ν = α + β > 0 , se deduce que var( X ) < μ (1 − μ ) .

Para una distribución simétrica, la media está en el medio de la distribución, μ = 1/2 , y por lo tanto:

Además, los siguientes límites (con sólo la variable indicada acercándose al límite) se pueden obtener a partir de las expresiones anteriores:

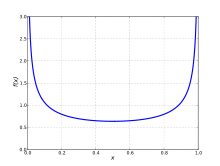

Varianza y covarianza geométrica

El logaritmo de la varianza geométrica, ln(var GX ), de una distribución con variable aleatoria X es el segundo momento del logaritmo de X centrado en la media geométrica de X , ln( G X ):

y por lo tanto, la varianza geométrica es:

En la matriz de información de Fisher , y la curvatura de la función de verosimilitud logarítmica , aparecen el logaritmo de la varianza geométrica de la variable reflejada 1 − X y el logaritmo de la covarianza geométrica entre X y 1 − X :

Para una distribución beta, se pueden derivar momentos logarítmicos de orden superior utilizando la representación de una distribución beta como proporción de dos distribuciones gamma y diferenciando a través de la integral. Se pueden expresar en términos de funciones poligamma de orden superior. Véase la sección § Momentos de variables aleatorias transformadas logarítmicamente. La varianza de las variables logarítmicas y la covarianza de ln X y ln(1− X ) son:

donde la función trigamma , denotada ψ 1 (α), es la segunda de las funciones poligamma , y se define como la derivada de la función digamma :

Por lo tanto,

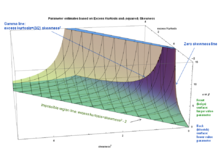

Los gráficos adjuntos muestran las varianzas geométricas logarítmicas y la covarianza geométrica logarítmica en función de los parámetros de forma α y β . Los gráficos muestran que las varianzas geométricas logarítmicas y la covarianza geométrica logarítmica son cercanas a cero para los parámetros de forma α y β mayores que 2, y que las varianzas geométricas logarítmicas aumentan rápidamente de valor para los valores de los parámetros de forma α y β menores que la unidad. Las varianzas geométricas logarítmicas son positivas para todos los valores de los parámetros de forma. La covarianza geométrica logarítmica es negativa para todos los valores de los parámetros de forma, y alcanza grandes valores negativos para α y β menores que la unidad.

A continuación se presentan los límites con un parámetro finito (distinto de cero) y el otro que se aproxima a estos límites:

Límites con dos parámetros variables:

Aunque tanto ln(var GX ) como ln(var G (1 − X ) ) son asimétricas, cuando los parámetros de forma son iguales, α = β, se tiene: ln(var GX ) = ln(var G(1−X) ). Esta igualdad se desprende de la siguiente simetría que se muestra entre ambas varianzas geométricas logarítmicas:

La covarianza geométrica logarítmica es simétrica:

Desviación absoluta media alrededor de la media

La desviación absoluta media alrededor de la media para la distribución beta con parámetros de forma α y β es: [8]

La desviación absoluta media alrededor de la media es un estimador más robusto de la dispersión estadística que la desviación estándar para distribuciones beta con colas y puntos de inflexión a cada lado de la moda, distribuciones Beta( α , β ) con α , β > 2, ya que depende de las desviaciones lineales (absolutas) en lugar de las desviaciones cuadradas de la media. Por lo tanto, el efecto de desviaciones muy grandes de la media no está tan ponderado.

Utilizando la aproximación de Stirling a la función Gamma , NLJohnson y S.Kotz [1] derivaron la siguiente aproximación para valores de los parámetros de forma mayores que la unidad (el error relativo para esta aproximación es solo −3,5% para α = β = 1, y disminuye a cero cuando α → ∞, β → ∞):

En el límite α → ∞, β → ∞, la razón entre la desviación absoluta media y la desviación estándar (para la distribución beta) se vuelve igual a la razón de las mismas medidas para la distribución normal: . Para α = β = 1 esta razón es igual a , de modo que de α = β = 1 a α, β → ∞ la razón disminuye en un 8,5%. Para α = β = 0 la desviación estándar es exactamente igual a la desviación absoluta media alrededor de la media. Por lo tanto, esta razón disminuye en un 15% de α = β = 0 a α = β = 1, y en un 25% de α = β = 0 a α, β → ∞ . Sin embargo, para distribuciones beta sesgadas tales que α → 0 o β → 0, la relación entre la desviación estándar y la desviación absoluta media se acerca al infinito (aunque cada una de ellas, individualmente, se acerca a cero) porque la desviación absoluta media se acerca a cero más rápido que la desviación estándar.

Utilizando la parametrización en términos de media μ y tamaño de muestra ν = α + β > 0:

- α = μν, β = (1−μ)ν

La desviación absoluta media alrededor de la media se puede expresar en términos de la media μ y el tamaño de la muestra ν de la siguiente manera:

Para una distribución simétrica, la media está en el medio de la distribución, μ = 1/2, y por lo tanto:

Además, los siguientes límites (con sólo la variable indicada acercándose al límite) se pueden obtener a partir de las expresiones anteriores:

Diferencia absoluta media

La diferencia absoluta media para la distribución beta es:

El coeficiente de Gini para la distribución beta es la mitad de la diferencia absoluta media relativa:

Oblicuidad

La asimetría (el tercer momento centrado en la media, normalizado por la potencia 3/2 de la varianza) de la distribución beta es [1]

Si en la expresión anterior se toma α = β, se obtiene γ 1 = 0, lo que demuestra una vez más que para α = β la distribución es simétrica y, por lo tanto, la asimetría es cero. La asimetría es positiva (de cola derecha) para α < β, y negativa (de cola izquierda) para α > β.

Utilizando la parametrización en términos de media μ y tamaño de muestra ν = α + β:

La asimetría se puede expresar en términos de la media μ y el tamaño de la muestra ν de la siguiente manera:

La asimetría también se puede expresar solo en términos de la varianza var y la media μ de la siguiente manera:

El gráfico adjunto de asimetría en función de la varianza y la media muestra que la varianza máxima (1/4) está acoplada con una asimetría cero y la condición de simetría (μ = 1/2), y que la asimetría máxima (infinito positivo o negativo) ocurre cuando la media se ubica en un extremo o en el otro, de modo que la "masa" de la distribución de probabilidad se concentra en los extremos (varianza mínima).

La siguiente expresión para el cuadrado de la asimetría, en términos del tamaño de la muestra ν = α + β y la varianza var , es útil para el método de estimación de momentos de cuatro parámetros:

Esta expresión da correctamente una asimetría de cero para α = β, ya que en ese caso (ver § Varianza): .

Para el caso simétrico (α = β), la asimetría = 0 en todo el rango y se aplican los siguientes límites:

Para los casos asimétricos (α ≠ β) los siguientes límites (con sólo la variable indicada acercándose al límite) se pueden obtener a partir de las expresiones anteriores:

Curtosis

La distribución beta se ha aplicado en el análisis acústico para evaluar el daño a los engranajes, ya que se ha informado que la curtosis de la distribución beta es un buen indicador de la condición de un engranaje. [14] La curtosis también se ha utilizado para distinguir la señal sísmica generada por los pasos de una persona de otras señales. Como las personas u otros objetivos que se mueven en el suelo generan señales continuas en forma de ondas sísmicas, se pueden separar diferentes objetivos en función de las ondas sísmicas que generan. La curtosis es sensible a las señales impulsivas, por lo que es mucho más sensible a la señal generada por los pasos humanos que a otras señales generadas por vehículos, vientos, ruido, etc. [15] Desafortunadamente, la notación para la curtosis no se ha estandarizado. Kenney y Keeping [16] usan el símbolo γ 2 para el exceso de curtosis , pero Abramowitz y Stegun [17] usan una terminología diferente. Para evitar confusiones [18] entre curtosis (el cuarto momento centrado en la media, normalizado por el cuadrado de la varianza) y exceso de curtosis, al utilizar símbolos, se escribirán de la siguiente manera: [8] [19]

Dejando α = β en la expresión anterior se obtiene

- .

Por lo tanto, para distribuciones beta simétricas, el exceso de curtosis es negativo, aumentando desde un valor mínimo de −2 en el límite cuando {α = β} → 0, y acercándose a un valor máximo de cero cuando {α = β} → ∞. El valor de −2 es el valor mínimo de exceso de curtosis que cualquier distribución (no solo las distribuciones beta, sino cualquier distribución de cualquier tipo posible) puede alcanzar. Este valor mínimo se alcanza cuando toda la densidad de probabilidad está completamente concentrada en cada extremo x = 0 y x = 1, sin nada en el medio: una distribución de Bernoulli de 2 puntos con igual probabilidad 1/2 en cada extremo (un lanzamiento de moneda: vea la sección a continuación "Curtosis limitada por el cuadrado de la asimetría" para una discusión más detallada). La descripción de la curtosis como una medida de los "valores atípicos potenciales" (o "valores extremos raros potenciales") de la distribución de probabilidad, es correcta para todas las distribuciones, incluida la distribución beta. Cuando se dan valores extremos poco frecuentes en la distribución beta, mayor es su curtosis; de lo contrario, la curtosis es menor. Para distribuciones beta sesgadas α ≠ β, el exceso de curtosis puede alcanzar valores positivos ilimitados (particularmente para α → 0 para β finito, o para β → 0 para α finito) porque el lado que se aleja de la moda producirá valores extremos ocasionales. La curtosis mínima se produce cuando la densidad de masa se concentra de manera uniforme en cada extremo (y, por lo tanto, la media está en el centro) y no hay densidad de masa de probabilidad entre los extremos.

Utilizando la parametrización en términos de media μ y tamaño de muestra ν = α + β:

Se puede expresar el exceso de curtosis en términos de la media μ y el tamaño de la muestra ν de la siguiente manera:

El exceso de curtosis también se puede expresar en términos de sólo los dos parámetros siguientes: la varianza var y el tamaño de la muestra ν de la siguiente manera:

y, en términos de la varianza var y la media μ como sigue:

El gráfico de exceso de curtosis en función de la varianza y la media muestra que el valor mínimo de exceso de curtosis (−2, que es el valor mínimo posible de exceso de curtosis para cualquier distribución) está íntimamente relacionado con el valor máximo de la varianza (1/4) y la condición de simetría: la media se encuentra en el punto medio (μ = 1/2). Esto ocurre para el caso simétrico de α = β = 0, con asimetría cero. En el límite, esta es la distribución de Bernoulli de 2 puntos con igual probabilidad 1/2 en cada extremo de la función delta de Dirac x = 0 y x = 1 y probabilidad cero en todos los demás lugares. (Un lanzamiento de moneda: una cara de la moneda es x = 0 y la otra cara es x = 1). La varianza es máxima porque la distribución es bimodal sin nada entre los dos modos (picos) en cada extremo. El exceso de curtosis es mínimo: la "masa" de densidad de probabilidad es cero en la media y se concentra en los dos picos de cada extremo. El exceso de curtosis alcanza el valor mínimo posible (para cualquier distribución) cuando la función de densidad de probabilidad tiene dos picos en cada extremo: es bi-"pico" sin nada entre ellos.

Por otra parte, el gráfico muestra que para los casos extremadamente sesgados, donde la media se ubica cerca de uno u otro extremo (μ = 0 o μ = 1), la varianza es cercana a cero y el exceso de curtosis se acerca rápidamente al infinito cuando la media de la distribución se acerca a cualquiera de los extremos.

Alternativamente, el exceso de curtosis también se puede expresar en términos de sólo los dos parámetros siguientes: el cuadrado de la asimetría y el tamaño de la muestra ν de la siguiente manera:

A partir de esta última expresión, se pueden obtener los mismos límites publicados hace más de un siglo por Karl Pearson [20] para la distribución beta (véase la sección siguiente titulada "Curtosis limitada por el cuadrado de la asimetría"). Si se establece α + β = ν = 0 en la expresión anterior, se obtiene el límite inferior de Pearson (los valores de asimetría y exceso de curtosis por debajo del límite (exceso de curtosis + 2 − asimetría 2 = 0) no pueden darse para ninguna distribución, y por lo tanto Karl Pearson llamó apropiadamente a la región por debajo de este límite la "región imposible"). El límite de α + β = ν → ∞ determina el límite superior de Pearson.

por lo tanto:

Los valores de ν = α + β tales que ν varía de cero a infinito, 0 < ν < ∞, abarcan toda la región de la distribución beta en el plano de exceso de curtosis versus asimetría al cuadrado.

Para el caso simétrico ( α = β ), se aplican los siguientes límites:

Para los casos asimétricos ( α ≠ β ) los siguientes límites (con sólo la variable indicada acercándose al límite) se pueden obtener a partir de las expresiones anteriores:

Función característica

_Beta_Distr_alpha=beta_from_0_to_25_Back_-_J._Rodal.jpg/440px-Re(CharacteristicFunction)_Beta_Distr_alpha=beta_from_0_to_25_Back_-_J._Rodal.jpg)

_Beta_Distr_alpha=beta_from_0_to_25_Front-_J._Rodal.jpg/440px-Re(CharacteristicFunc)_Beta_Distr_alpha=beta_from_0_to_25_Front-_J._Rodal.jpg)

_Beta_Distr_alpha_from_0_to_25_and_beta=alpha+0.5_Back_-_J._Rodal.jpg/440px-Re(CharacteristFunc)_Beta_Distr_alpha_from_0_to_25_and_beta=alpha+0.5_Back_-_J._Rodal.jpg)

_Beta_Distrib._beta_from_0_to_25,_alpha=beta+0.5_Back_-_J._Rodal.jpg/440px-Re(CharacterFunc)_Beta_Distrib._beta_from_0_to_25,_alpha=beta+0.5_Back_-_J._Rodal.jpg)

_Beta_Distr._beta_from_0_to_25,_alpha=beta+0.5_Front_-_J._Rodal.jpg/440px-Re(CharacterFunc)_Beta_Distr._beta_from_0_to_25,_alpha=beta+0.5_Front_-_J._Rodal.jpg)

La función característica es la transformada de Fourier de la función de densidad de probabilidad. La función característica de la distribución beta es la función hipergeométrica confluente de Kummer (de primera especie): [1] [17] [21]

dónde

es el factorial ascendente , también llamado "símbolo de Pochhammer". El valor de la función característica para t = 0, es uno:

Además, las partes reales e imaginarias de la función característica disfrutan de las siguientes simetrías con respecto al origen de la variable t :

El caso simétrico α = β simplifica la función característica de la distribución beta a una función de Bessel , ya que en el caso especial α + β = 2α la función hipergeométrica confluente (de primer tipo) se reduce a una función de Bessel (la función de Bessel modificada de primer tipo ) utilizando la segunda transformación de Kummer de la siguiente manera:

En los gráficos adjuntos, se muestra la parte real (Re) de la función característica de la distribución beta para casos simétricos (α = β) y sesgados (α ≠ β).

Otros momentos

Función generadora de momentos

También se deduce [1] [8] que la función generadora de momentos es

En particular MX ( α ; β ; 0) = 1.

Momentos más elevados

Utilizando la función generadora de momentos , el k -ésimo momento bruto se da por [1] el factor

multiplicando el término (serie exponencial) en la serie de la función generadora de momentos

donde ( x ) ( k ) es un símbolo de Pochhammer que representa un factorial ascendente. También se puede escribir en forma recursiva como

Dado que la función generadora de momentos tiene un radio de convergencia positivo, la distribución beta está determinada por sus momentos . [22]

Momentos de variables aleatorias transformadas

Momentos de variables aleatorias transformadas linealmente, producto e invertidas

También se pueden mostrar las siguientes expectativas para una variable aleatoria transformada, [1] donde la variable aleatoria X tiene una distribución Beta con parámetros α y β : X ~ Beta( α , β ). El valor esperado de la variable 1 − X es la simetría especular del valor esperado basado en X :

Debido a la simetría especular de la función de densidad de probabilidad de la distribución beta, las varianzas basadas en las variables X y 1 − X son idénticas, y la covarianza en X (1 − X es el negativo de la varianza:

Estos son los valores esperados para las variables invertidas (están relacionadas con las medias armónicas, ver § Media armónica):

La siguiente transformación, que consiste en dividir la variable X por su imagen especular X /(1 − X ), da como resultado el valor esperado de la "distribución beta invertida" o distribución beta prima (también conocida como distribución beta de segundo tipo o distribución beta tipo VI de Pearson ): [1]

Las varianzas de estas variables transformadas se pueden obtener mediante integración, como los valores esperados de los segundos momentos centrados en las variables correspondientes:

La siguiente varianza de la variable X dividida por su imagen especular ( X /(1− X ) da como resultado la varianza de la "distribución beta invertida" o distribución beta prima (también conocida como distribución beta de segundo tipo o tipo VI de Pearson ): [1]

Las covarianzas son:

Estas expectativas y variaciones aparecen en la matriz de información de Fisher de cuatro parámetros (§ Información de Fisher).

Momentos de variables aleatorias transformadas logarítmicamente

En esta sección se analizan los valores esperados para las transformaciones logarítmicas (útiles para las estimaciones de máxima verosimilitud , véase § Estimación de parámetros, Máxima verosimilitud). Las siguientes transformaciones lineales logarítmicas están relacionadas con las medias geométricas G X y G (1− X ) (véase § Media geométrica):

Donde la función digamma ψ(α) se define como la derivada logarítmica de la función gamma : [17]

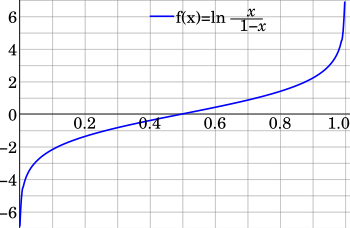

Las transformaciones logit son interesantes, [23] ya que generalmente transforman varias formas (incluidas las formas J) en densidades en forma de campana (generalmente sesgadas) sobre la variable logit, y pueden eliminar las singularidades finales sobre la variable original:

Johnson [24] consideró la distribución de la variable transformada logit ln( X /1 − X ), incluyendo su función generadora de momentos y aproximaciones para valores grandes de los parámetros de forma. Esta transformación extiende el soporte finito [0, 1] basado en la variable original X a un soporte infinito en ambas direcciones de la línea real (−∞, +∞). El logit de una variable beta tiene la distribución logística-beta .

Los momentos logarítmicos de orden superior se pueden derivar utilizando la representación de una distribución beta como proporción de dos distribuciones gamma y diferenciándolas mediante la integral. Se pueden expresar en términos de funciones poligamma de orden superior de la siguiente manera:

Por lo tanto, la varianza de las variables logarítmicas y la covarianza de ln( X ) y ln(1− X ) son:

donde la función trigamma , denotada ψ 1 ( α ), es la segunda de las funciones poligamma , y se define como la derivada de la función digamma :

Las varianzas y covarianzas de las variables transformadas logarítmicamente X y (1 − X ) son diferentes, en general, porque la transformación logarítmica destruye la simetría especular de las variables originales X y (1 − X ), a medida que el logaritmo se acerca al infinito negativo para la variable que se acerca a cero.

Estas varianzas y covarianzas logarítmicas son los elementos de la matriz de información de Fisher para la distribución beta. También son una medida de la curvatura de la función de verosimilitud logarítmica (véase la sección sobre Estimación de máxima verosimilitud).

Las varianzas de las variables inversas logarítmicas son idénticas a las varianzas de las variables logarítmicas:

También se deduce que las varianzas de las variables transformadas logit son

Cantidades de información (entropía)

Dada una variable aleatoria distribuida beta, X ~ Beta( α , β ), la entropía diferencial de X es (medida en nats ), [25] el valor esperado del negativo del logaritmo de la función de densidad de probabilidad :

donde f ( x ; α , β ) es la función de densidad de probabilidad de la distribución beta:

La función digamma ψ aparece en la fórmula de la entropía diferencial como consecuencia de la fórmula integral de Euler para los números armónicos que se desprende de la integral:

La entropía diferencial de la distribución beta es negativa para todos los valores de α y β mayores que cero, excepto en α = β = 1 (para cuyos valores la distribución beta es la misma que la distribución uniforme ), donde la entropía diferencial alcanza su valor máximo de cero. Es de esperar que la entropía máxima se produzca cuando la distribución beta se vuelve igual a la distribución uniforme, ya que la incertidumbre es máxima cuando todos los eventos posibles son equiprobables.

Para α o β que se acercan a cero, la entropía diferencial se acerca a su valor mínimo de infinito negativo. Para (cualquiera o ambos) α o β que se acercan a cero, hay una cantidad máxima de orden: toda la densidad de probabilidad se concentra en los extremos, y hay densidad de probabilidad cero en los puntos ubicados entre los extremos. De manera similar, para (cualquiera o ambos) α o β que se acercan al infinito, la entropía diferencial se acerca a su valor mínimo de infinito negativo y una cantidad máxima de orden. Si α o β se acercan al infinito (y el otro es finito) toda la densidad de probabilidad se concentra en un extremo, y la densidad de probabilidad es cero en todos los demás lugares. Si ambos parámetros de forma son iguales (el caso simétrico), α = β , y se acercan al infinito simultáneamente, la densidad de probabilidad se convierte en un pico ( función delta de Dirac ) concentrado en el medio x = 1/2, y por lo tanto hay 100% de probabilidad en el medio x = 1/2 y probabilidad cero en todos los demás lugares.

La entropía diferencial (del caso continuo) fue introducida por Shannon en su artículo original (donde la llamó la "entropía de una distribución continua"), como la parte final del mismo artículo donde definió la entropía discreta . [26] Desde entonces se sabe que la entropía diferencial puede diferir del límite infinitesimal de la entropía discreta por un desplazamiento infinito, por lo tanto, la entropía diferencial puede ser negativa (como lo es para la distribución beta). Lo que realmente importa es el valor relativo de la entropía.

Dadas dos variables aleatorias distribuidas beta, X 1 ~ Beta( α , β ) y X 2 ~ Beta( α ′ , β ′ ), la entropía cruzada es (medida en nats) [27]

La entropía cruzada se ha utilizado como métrica de error para medir la distancia entre dos hipótesis. [28] [29] Su valor absoluto es mínimo cuando las dos distribuciones son idénticas. Es la medida de información más estrechamente relacionada con el logaritmo de máxima verosimilitud [27] (ver apartado sobre "Estimación de parámetros. Estimación de máxima verosimilitud").

La entropía relativa, o divergencia de Kullback–Leibler D KL ( X 1 || X 2 ), es una medida de la ineficiencia de suponer que la distribución es X 2 ~ Beta( α ′ , β ′ ) cuando la distribución es realmente X 1 ~ Beta( α , β ). Se define de la siguiente manera (medida en nats).

La entropía relativa, o divergencia de Kullback–Leibler , siempre es no negativa. A continuación se presentan algunos ejemplos numéricos:

- X 1 ~ Beta(1, 1) y X 2 ~ Beta(3, 3); D KL ( X 1 || X 2 ) = 0,598803; D KL ( X 2 || X 1 ) = 0,267864; h ( X 1 ) = 0; h ( X 2 ) = −0,267864

- X 1 ~ Beta(3, 0,5) y X 2 ~ Beta(0,5, 3); D KL ( X 1 || X 2 ) = 7,21574; D KL ( X 2 || X 1 ) = 7,21574; h ( X 1 ) = −1,10805; h ( X 2 ) = −1,10805.

La divergencia de Kullback–Leibler no es simétrica D KL ( X 1 || X 2 ) ≠ D KL ( X 2 || X 1 ) para el caso en el que las distribuciones beta individuales Beta(1, 1) y Beta(3, 3) son simétricas, pero tienen diferentes entropías h ( X 1 ) ≠ h ( X 2 ). El valor de la divergencia de Kullback depende de la dirección recorrida: si se va de una entropía (diferencial) más alta a una entropía (diferencial) más baja o al revés. En el ejemplo numérico anterior, la divergencia de Kullback mide la ineficiencia de suponer que la distribución es (en forma de campana) Beta(3, 3), en lugar de (uniforme) Beta(1, 1). La entropía "h" de Beta(1, 1) es mayor que la entropía "h" de Beta(3, 3) porque la distribución uniforme Beta(1, 1) tiene una cantidad máxima de desorden. La divergencia de Kullback es más de dos veces mayor (0,598803 en lugar de 0,267864) cuando se mide en la dirección de la entropía decreciente: la dirección que supone que la distribución (uniforme) Beta(1, 1) es (en forma de campana) Beta(3, 3) en lugar de lo contrario. En este sentido restringido, la divergencia de Kullback es consistente con la segunda ley de la termodinámica .

La divergencia de Kullback-Leibler es simétrica D KL ( X 1 || X 2 ) = D KL ( X 2 || X 1 ) para los casos sesgados Beta(3, 0.5) y Beta(0.5, 3) que tienen igual entropía diferencial h ( X 1 ) = h ( X 2 ).

La condición de simetría:

se desprende de las definiciones anteriores y de la simetría especular f ( x ; α , β ) = f (1 − x ; α , β ) de la que disfruta la distribución beta.

Relaciones entre medidas estadísticas

Relación entre media, moda y mediana

Si 1 < α < β entonces moda ≤ mediana ≤ media. [9] Expresando la moda (sólo para α, β > 1), y la media en términos de α y β:

Si 1 < β < α entonces el orden de las desigualdades se invierte. Para α, β > 1 la distancia absoluta entre la media y la mediana es menor que el 5% de la distancia entre los valores máximo y mínimo de x . Por otra parte, la distancia absoluta entre la media y la moda puede alcanzar el 50% de la distancia entre los valores máximo y mínimo de x , para el caso ( patológico ) de α = 1 y β = 1, para cuyos valores la distribución beta se aproxima a la distribución uniforme y la entropía diferencial se aproxima a su valor máximo , y por tanto al máximo "desorden".

Por ejemplo, para α = 1,0001 y β = 1,00000001:

- modo = 0,9999; PDF(modo) = 1,00010

- media = 0,500025; PDF(media) = 1,00003

- mediana = 0,500035; PDF(mediana) = 1,00003

- media − moda = −0,499875

- media − mediana = −9,65538 × 10 −6

donde PDF representa el valor de la función de densidad de probabilidad .

Relación entre media, media geométrica y media armónica

De la desigualdad de las medias aritmética y geométrica se sabe que la media geométrica es menor que la media. De manera similar, la media armónica es menor que la media geométrica. El gráfico adjunto muestra que para α = β, tanto la media como la mediana son exactamente iguales a 1/2, independientemente del valor de α = β, y la moda también es igual a 1/2 para α = β > 1, sin embargo, las medias geométrica y armónica son menores que 1/2 y solo se aproximan a este valor asintóticamente cuando α = β → ∞.

Curtosis limitada por el cuadrado de la asimetría

Como señaló Feller , [5] en el sistema de Pearson la densidad de probabilidad beta aparece como tipo I (cualquier diferencia entre la distribución beta y la distribución tipo I de Pearson es solo superficial y no hace ninguna diferencia para la siguiente discusión sobre la relación entre curtosis y asimetría). Karl Pearson mostró, en la Placa 1 de su artículo [20] publicado en 1916, un gráfico con la curtosis como eje vertical ( ordenada ) y el cuadrado de la asimetría como eje horizontal ( abscisa ), en el que se mostraban varias distribuciones. [30] La región ocupada por la distribución beta está limitada por las siguientes dos líneas en el plano (asimetría 2 ,curtosis) o el plano (asimetría 2 ,exceso de curtosis) :

o, equivalentemente,

En una época en la que no existían ordenadores digitales potentes, Karl Pearson calculó con precisión otros límites, [31] [20] por ejemplo, separando las distribuciones "en forma de U" de las "en forma de J". La línea límite inferior (exceso de curtosis + 2 − asimetría 2 = 0) se produce por distribuciones beta sesgadas "en forma de U" con valores de los parámetros de forma α y β cercanos a cero. La línea límite superior (exceso de curtosis − (3/2) asimetría 2 = 0) se produce por distribuciones extremadamente sesgadas con valores muy grandes de uno de los parámetros y valores muy pequeños del otro parámetro. Karl Pearson demostró [20] que esta línea límite superior (exceso de curtosis − (3/2) asimetría 2 = 0) es también la intersección con la distribución III de Pearson, que tiene soporte ilimitado en una dirección (hacia el infinito positivo), y puede tener forma de campana o de J. Su hijo, Egon Pearson , demostró [30] que la región (en el plano de curtosis/asimetría al cuadrado) ocupada por la distribución beta (equivalentemente, la distribución I de Pearson) a medida que se aproxima a este límite (exceso de curtosis − (3/2) asimetría 2 = 0) se comparte con la distribución chi-cuadrado no central . Karl Pearson [32] (Pearson 1895, pp. 357, 360, 373–376) también demostró que la distribución gamma es una distribución tipo III de Pearson. Por lo tanto, esta línea límite para la distribución tipo III de Pearson se conoce como la línea gamma. (Esto se puede demostrar a partir del hecho de que el exceso de curtosis de la distribución gamma es 6/ k y el cuadrado de la asimetría es 4/ k , por lo tanto (exceso de curtosis − (3/2) asimetría 2 = 0) se satisface de forma idéntica por la distribución gamma independientemente del valor del parámetro "k"). Pearson señaló posteriormente que la distribución chi-cuadrado es un caso especial del tipo III de Pearson y también comparte esta línea límite (como es evidente a partir del hecho de que para la distribución chi-cuadrado el exceso de curtosis es 12/ k y el cuadrado de la asimetría es 8/ k , por lo tanto (exceso de curtosis − (3/2) asimetría 2 = 0) se satisface de forma idéntica independientemente del valor del parámetro "k"). Esto es de esperarse, ya que la distribución chi-cuadrado X ~ χ 2 ( k ) es un caso especial de la distribución gamma, con parametrización X ~ Γ(k/2, 1/2) donde k es un entero positivo que especifica el "número de grados de libertad" de la distribución chi-cuadrado.

Un ejemplo de una distribución beta cerca del límite superior (exceso de curtosis − (3/2) asimetría 2 = 0) viene dado por α = 0,1, β = 1000, para el que la relación (exceso de curtosis)/(asimetría 2 ) = 1,49835 se acerca al límite superior de 1,5 desde abajo. Un ejemplo de una distribución beta cerca del límite inferior (exceso de curtosis + 2 − asimetría 2 = 0) viene dado por α = 0,0001, β = 0,1, para cuyos valores la expresión (exceso de curtosis + 2)/(asimetría 2 ) = 1,01621 se acerca al límite inferior de 1 desde arriba. En el límite infinitesimal para α y β que se acerca a cero simétricamente, el exceso de curtosis alcanza su valor mínimo en −2. Este valor mínimo se produce en el punto en el que la línea límite inferior interseca el eje vertical ( ordenada ). (Sin embargo, en el gráfico original de Pearson, la ordenada es la curtosis, en lugar del exceso de curtosis, y aumenta hacia abajo en lugar de hacia arriba).

Los valores de asimetría y exceso de curtosis por debajo del límite inferior (exceso de curtosis + 2 − asimetría 2 = 0) no pueden ocurrir para ninguna distribución, y por lo tanto Karl Pearson apropiadamente llamó a la región por debajo de este límite la "región imposible". El límite para esta "región imposible" está determinado por distribuciones bimodales en forma de U (simétricas o sesgadas) para las cuales los parámetros α y β tienden a cero y por lo tanto toda la densidad de probabilidad se concentra en los extremos: x = 0, 1 con prácticamente nada entre ellos. Dado que para α ≈ β ≈ 0 la densidad de probabilidad se concentra en los dos extremos x = 0 y x = 1, este "límite imposible" está determinado por una distribución de Bernoulli , donde los dos únicos resultados posibles ocurren con probabilidades respectivas p y q = 1− p . Para los casos que se aproximan a este límite con simetría α = β, asimetría ≈ 0, exceso de curtosis ≈ −2 (este es el exceso de curtosis más bajo posible para cualquier distribución), y las probabilidades son p ≈ q ≈ 1/2. Para los casos que se aproximan a este límite con asimetría, exceso de curtosis ≈ −2 + asimetría 2 , y la densidad de probabilidad se concentra más en un extremo que en el otro (prácticamente sin nada en el medio), con probabilidades en el extremo izquierdo x = 0 y en el extremo derecho x = 1.

Simetría

Todas las afirmaciones están condicionadas a que α , β > 0:

- Función de densidad de probabilidad reflexión simetría

- Función de distribución acumulativa simetría de reflexión más traslación unitaria

- Simetría de reflexión modal más traslación unitaria

- Simetría de reflexión media más traslación unitaria

- Simetría de reflexión media más traslación unitaria

- Las medias geométricas son individualmente asimétricas, la siguiente simetría se aplica entre la media geométrica basada en X y la media geométrica basada en su reflexión (1-X)

- Armónico significa que cada uno es individualmente asimétrico, la siguiente simetría se aplica entre la media armónica basada en X y la media armónica basada en su reflexión (1-X)

- .

- Simetría de varianza

- Cada variación geométrica es individualmente asimétrica, la siguiente simetría se aplica entre la varianza geométrica logarítmica basada en X y la varianza geométrica logarítmica basada en su reflexión (1-X)

- Simetría de covarianza geométrica

- Desviación absoluta media alrededor de la simetría media

- Asimetría asimétrica

- Simetría de curtosis excesiva

- Simetría de la función característica de la parte real (con respecto al origen de la variable "t")

- Función característica de simetría oblicua de la parte imaginaria (con respecto al origen de la variable "t")

- Simetría de la función característica del valor absoluto (con respecto al origen de la variable "t")

- Simetría de entropía diferencial

- Simetría de entropía relativa (también llamada divergencia de Kullback-Leibler )

- Simetría de la matriz de información de Fisher

Geometría de la función de densidad de probabilidad

Puntos de inflexión

Para ciertos valores de los parámetros de forma α y β, la función de densidad de probabilidad tiene puntos de inflexión en los que la curvatura cambia de signo. La posición de estos puntos de inflexión puede ser útil como medida de la dispersión o extensión de la distribución.

Definiendo la siguiente cantidad:

Los puntos de inflexión ocurren, [1] [7] [8] [19] dependiendo del valor de los parámetros de forma α y β, de la siguiente manera:

- (α > 2, β > 2) La distribución tiene forma de campana (simétrica para α = β y sesgada en caso contrario), con dos puntos de inflexión , equidistantes de la moda:

- (α = 2, β > 2) La distribución es unimodal, sesgada positivamente, de cola derecha, con un punto de inflexión , ubicado a la derecha de la moda:

- (α > 2, β = 2) La distribución es unimodal, sesgada negativamente, de cola izquierda, con un punto de inflexión , ubicado a la izquierda de la moda:

- (1 < α < 2, β > 2, α+β>2) La distribución es unimodal, sesgada positivamente, de cola derecha, con un punto de inflexión , ubicado a la derecha de la moda:

- (0 < α < 1, 1 < β < 2) La distribución tiene una moda en el extremo izquierdo x = 0 y está sesgada positivamente, con cola derecha. Hay un punto de inflexión , ubicado a la derecha de la moda:

- (α > 2, 1 < β < 2) La distribución es unimodal sesgada negativamente, de cola izquierda, con un punto de inflexión , ubicado a la izquierda de la moda:

- (1 < α < 2, 0 < β < 1) La distribución tiene una moda en el extremo derecho x = 1 y está sesgada negativamente, con cola izquierda. Hay un punto de inflexión , ubicado a la izquierda de la moda:

No hay puntos de inflexión en las regiones restantes (simétricas y sesgadas): en forma de U: (α, β < 1), en forma de U invertida: (1 < α < 2, 1 < β < 2), en forma de J invertida (α < 1, β > 2) o en forma de J: (α > 2, β < 1)

Los gráficos adjuntos muestran las ubicaciones de los puntos de inflexión (mostrados verticalmente, que van de 0 a 1) en comparación con α y β (los ejes horizontales que van de 0 a 5). Hay grandes cortes en las superficies que intersecan las líneas α = 1, β = 1, α = 2 y β = 2 porque en estos valores la distribución beta cambia de 2 modos a 1 modo y a ningún modo.

Formas

La función de densidad beta puede adoptar una amplia variedad de formas diferentes según los valores de los dos parámetros α y β . La capacidad de la distribución beta de adoptar esta gran diversidad de formas (utilizando solo dos parámetros) es en parte responsable de que se le haya encontrado una amplia aplicación para modelar mediciones reales:

Simétrico (alfa=β)

- La función de densidad es simétrica alrededor de 1/2 (gráficos azul y verde azulado).

- mediana = media = 1/2.

- asimetría = 0.

- varianza = 1/(4(2α + 1))

- α = β < 1

- En forma de U (gráfico azul).

- bimodal: modo izquierdo = 0, modo derecho = 1, antimodo = 1/2

- 1/12 < var( X ) < 1/4 [1]

- −2 < exceso de curtosis( X ) < −6/5

- α = β = 1/2 es la distribución del arcoseno

- var( X ) = 1/8

- exceso de curtosis( X ) = −3/2

- CF = Rinc (t) [33]

- α = β → 0 es una distribución de Bernoulli de 2 puntos con probabilidad igual 1/2 en cada extremo de la función delta de Dirac x = 0 y x = 1 y probabilidad cero en todos los demás extremos. Lanzamiento de una moneda: una cara de la moneda es x = 0 y la otra cara es x = 1.

- Un valor inferior a éste es imposible de alcanzar para cualquier distribución.

- La entropía diferencial se acerca a un valor mínimo de −∞

- α = β = 1

- la distribución uniforme [0, 1]

- Sin modo

- var( X ) = 1/12

- exceso de curtosis( X ) = −6/5

- La entropía diferencial (negativa en cualquier otro lugar) alcanza su valor máximo de cero.

- CF = Sinc (t)

- α = β > 1

- unimodal simétrico

- moda = 1/2.

- 0 < var( X ) < 1/12 [1]

- −6/5 < exceso de curtosis( X ) < 0

- α = β = 3/2 es una distribución semielíptica [0, 1], véase: Distribución de semicírculo de Wigner [34]

- var( X ) = 1/16.

- exceso de curtosis( X ) = −1

- CF = 2 Jinc (t)

- α = β = 2 es la distribución parabólica [0, 1]

- var( X ) = 1/20

- exceso de curtosis( X ) = −6/7

- CF = 3 Tinc (t) [35]

- α = β > 2 tiene forma de campana, con puntos de inflexión ubicados a cada lado del modo.

- 0 < var( X ) < 1/20

- −6/7 < exceso de curtosis( X ) < 0

- α = β → ∞ es una distribución degenerada de 1 punto con un pico de la función delta de Dirac en el punto medio x = 1/2 con probabilidad 1 y probabilidad cero en el resto de los puntos. Hay una probabilidad del 100 % (certeza absoluta) concentrada en el único punto x = 1/2.

- La entropía diferencial se acerca a un valor mínimo de −∞

Sesgado (alfa≠β)

La función de densidad está sesgada . Un intercambio de valores de parámetros produce la imagen especular (el reverso) de la curva inicial. Algunos casos más específicos:

- α < 1, β < 1

- En forma de U

- Sesgo positivo para α < β, sesgo negativo para α > β.

- bimodal: modo izquierdo = 0, modo derecho = 1, antimodo =

- 0 < mediana < 1.

- 0 < var( X ) < 1/4

- α > 1, β > 1

- Unimodal (gráficos magenta y cian),

- Sesgo positivo para α < β, sesgo negativo para α > β.

- 0 < mediana < 1

- 0 < var( X ) < 1/12

- α < 1, β ≥ 1

- en forma de J invertida con cola derecha,

- sesgado positivamente,

- estrictamente decreciente, convexo

- modo = 0

- 0 < mediana < 1/2.

- (la varianza máxima ocurre para , o α = Φ el conjugado de la proporción áurea )

- α ≥ 1, β < 1

- En forma de J con cola izquierda,

- sesgado negativamente,

- estrictamente creciente, convexo

- modo = 1

- 1/2 < mediana < 1

- (la varianza máxima ocurre para , o β = Φ el conjugado de la proporción áurea )

- α = 1, β > 1

- sesgado positivamente,

- estrictamente decreciente (gráfico rojo),

- una distribución de función de potencia invertida (imagen especular) [0,1]

- media = 1 / (β + 1)

- mediana = 1 - 1/2 1/β

- modo = 0

- α = 1, 1 < β < 2

- cóncavo

- 1/18 < var( X ) < 1/12.

- α = 1, β = 2

- una línea recta con pendiente −2, la distribución triangular recta con ángulo recto en el extremo izquierdo, en x = 0

- var( X ) = 1/18

- α = 1, β > 2

- en forma de J invertida con cola derecha,

- convexo

- 0 < var( X ) < 1/18

- α > 1, β = 1

- sesgado negativamente,

- estrictamente creciente (gráfico verde),

- La distribución de la función de potencia [0, 1] [8]

- media = α / (α + 1)

- mediana = 1/2 1/α

- modo = 1

- 2 > α > 1, β = 1

- cóncavo

- 1/18 < var( X ) < 1/12

- α = 2, β = 1

- una línea recta con pendiente +2, la distribución triangular recta con ángulo recto en el extremo derecho, en x = 1

- var( X ) = 1/18

- α > 2, β = 1

- En forma de J con cola izquierda, convexa.

- 0 < var( X ) < 1/18

Distribuciones relacionadas

Transformaciones

- Si X ~ Beta( α , β ) entonces 1 − X ~ Beta( β , α ) simetría de imagen especular

- Si X ~ Beta( α , β ) entonces . La distribución beta prima , también llamada "distribución beta de segundo tipo".

- Si , entonces tiene una distribución logística generalizada , con densidad , donde es la sigmoide logística .

- Si X ~ Beta( α , β ) entonces .

- Si X ~ Beta( n /2, m /2) entonces (asumiendo que n > 0 y m > 0), la distribución F de Fisher–Snedecor .

- Si entonces min + X (max − min) ~ PERT(min, max, m , λ ) donde PERT denota una distribución PERT utilizada en el análisis PERT , y m = valor más probable. [36] Tradicionalmente [37] λ = 4 en el análisis PERT.

- Si X ~ Beta(1, β ) entonces X ~ Distribución de Kumaraswamy con parámetros (1, β )

- Si X ~ Beta( α , 1) entonces X ~ Distribución de Kumaraswamy con parámetros ( α , 1)

- Si X ~ Beta( α , 1) entonces −ln( X ) ~ Exponencial( α )

Casos especiales y limitantes

- Beta(1, 1) ~ U(0, 1) con densidad 1 en ese intervalo.

- Beta(n, 1) ~ Máximo de n variables aleatorias independientes con U(0, 1) , a veces llamada distribución de función de potencia estándar con densidad n x n –1 en ese intervalo.

- Beta(1, n) ~ Mínimo de n variables aleatorias independientes con U(0, 1) con densidad n (1 − x ) n −1 en ese intervalo.

- Si X ~ Beta(3/2, 3/2) y r > 0 entonces 2 rX − r ~ distribución de semicírculo de Wigner .

- Beta(1/2, 1/2) es equivalente a la distribución de arcoseno . Esta distribución es también la probabilidad previa de Jeffreys para las distribuciones de Bernoulli y binomial . La densidad de probabilidad de arcoseno es una distribución que aparece en varios teoremas fundamentales de caminata aleatoria. En una caminata aleatoria de lanzamiento de moneda justo , la probabilidad para el momento de la última visita al origen se distribuye como una distribución de arcoseno (en forma de U) . [5] [11] En un juego de lanzamiento de moneda justo de dos jugadores, se dice que un jugador está a la cabeza si la caminata aleatoria (que comenzó en el origen) está por encima del origen. El número más probable de veces que un jugador dado estará a la cabeza, en un juego de longitud 2 N , no es N. Por el contrario, N es el número menos probable de veces que el jugador estará a la cabeza. El número más probable de veces a la cabeza es 0 o 2 N (siguiendo la distribución de arcoseno ).

- La distribución exponencial .

- La distribución gamma .

- Para valores grandes , la distribución normal . Más precisamente, si entonces converge en distribución a una distribución normal con media 0 y varianza a medida que n aumenta.

Derivado de otras distribuciones

- La estadística de orden k de una muestra de tamaño n de la distribución uniforme es una variable aleatoria beta, U ( k ) ~ Beta( k , n +1− k ). [38]

- Si X ~ Gamma(α, θ) e Y ~ Gamma(β, θ) son independientes, entonces .

- Si y son independientes, entonces .

- Si X ~ U(0, 1) y α > 0 entonces X 1/ α ~ Beta( α , 1). Distribución de la función potencia.

- Si [ aclaración necesaria ] , entonces [ aclaración necesaria ] para valores discretos de n y k donde y . [39]

- Si X ~ Cauchy(0, 1) entonces

Combinación con otras distribuciones

- X ~ Beta( α , β ) y Y ~ F(2 β ,2 α ) entonces para todo x > 0.

Composición con otras distribuciones

- Si p ~ Beta(α, β) y X ~ Bin( k , p ) entonces X ~ distribución beta-binomial

- Si p ~ Beta(α, β) y X ~ NB( r , p ) entonces X ~ distribución binomial negativa beta

Generalizaciones

- La generalización a múltiples variables, es decir, una distribución Beta multivariante , se denomina distribución de Dirichlet . Las marginales univariadas de la distribución de Dirichlet tienen una distribución Beta. La distribución Beta es conjugada con las distribuciones binomial y de Bernoulli exactamente de la misma manera que la distribución de Dirichlet es conjugada con la distribución multinomial y la distribución categórica .

- La distribución tipo I de Pearson es idéntica a la distribución beta (excepto por el desplazamiento arbitrario y el reescalamiento que también se pueden lograr con la parametrización de cuatro parámetros de la distribución beta).

- La distribución beta es el caso especial de la distribución beta no central donde : .

- La distribución beta generalizada es una familia de distribuciones de cinco parámetros que tiene la distribución beta como un caso especial.

- La distribución beta de matriz variable es una distribución para matrices definidas positivas .

Inferencia estadística

Estimación de parámetros

Método de momentos

Dos parámetros desconocidos

Se pueden estimar dos parámetros desconocidos ( de una distribución beta admitida en el intervalo [0,1]), utilizando el método de momentos, con los dos primeros momentos (media de la muestra y varianza de la muestra) de la siguiente manera. Sea:

sea la estimación de la media muestral y

sea la estimación de la varianza de la muestra . Las estimaciones de los parámetros mediante el método de momentos son

- si

- si

Cuando se requiere la distribución sobre un intervalo conocido distinto de [0, 1] con la variable aleatoria X , digamos [ a , c ] con la variable aleatoria Y , entonces reemplace con y con en el par de ecuaciones anteriores para los parámetros de forma (vea la sección "Cuatro parámetros desconocidos" a continuación), [40] donde:

Cuatro parámetros desconocidos

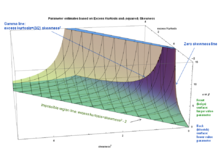

Los cuatro parámetros ( de una distribución beta soportada en el intervalo [ a , c ], ver sección "Parametrizaciones alternativas, Cuatro parámetros") pueden estimarse, utilizando el método de momentos desarrollado por Karl Pearson , igualando los valores de la muestra y la población de los primeros cuatro momentos centrales (media, varianza, asimetría y exceso de curtosis). [1] [41] [42] El exceso de curtosis se expresó en términos del cuadrado de la asimetría y el tamaño de la muestra ν = α + β, (ver sección anterior "Curtosis") de la siguiente manera:

Se puede utilizar esta ecuación para resolver el tamaño de la muestra ν = α + β en términos del cuadrado de la asimetría y el exceso de curtosis de la siguiente manera: [41]

Esta es la relación (multiplicada por un factor de 3) entre los límites previamente derivados para la distribución beta en un espacio (como lo hizo originalmente Karl Pearson [20] ) definido con las coordenadas del cuadrado de la asimetría en un eje y el exceso de curtosis en el otro eje (ver § Curtosis limitada por el cuadrado de la asimetría):

El caso de asimetría cero, se puede resolver inmediatamente porque para asimetría cero, α = β y por lo tanto ν = 2α = 2β, por lo tanto α = β = ν/2

(El exceso de curtosis es negativo para la distribución beta con asimetría cero, que va de -2 a 0, de modo que -y por lo tanto los parámetros de forma de la muestra- es positivo, y va de cero cuando los parámetros de forma se aproximan a cero y el exceso de curtosis se aproxima a -2, hasta infinito cuando los parámetros de forma se aproximan a infinito y el exceso de curtosis se aproxima a cero).

Para una asimetría de muestra distinta de cero, es necesario resolver un sistema de dos ecuaciones acopladas. Dado que la asimetría y el exceso de curtosis son independientes de los parámetros , estos pueden determinarse de forma única a partir de la asimetría de muestra y el exceso de curtosis de muestra, resolviendo las ecuaciones acopladas con dos variables conocidas (asimetría de muestra y exceso de curtosis de muestra) y dos incógnitas (los parámetros de forma):

resultando en la siguiente solución: [41]

Donde se deben tomar las soluciones como sigue: para asimetría de muestra (negativa) < 0, y para asimetría de muestra (positiva) > 0.

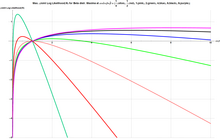

El gráfico adjunto muestra estas dos soluciones como superficies en un espacio con ejes horizontales de (exceso de curtosis de la muestra) y (asimetría al cuadrado de la muestra) y los parámetros de forma como el eje vertical. Las superficies están restringidas por la condición de que el exceso de curtosis de la muestra debe estar limitado por la asimetría al cuadrado de la muestra como se estipula en la ecuación anterior. Las dos superficies se encuentran en el borde derecho definido por la asimetría cero. A lo largo de este borde derecho, ambos parámetros son iguales y la distribución es simétrica en forma de U para α = β < 1, uniforme para α = β = 1, en forma de U invertida para 1 < α = β < 2 y en forma de campana para α = β > 2. Las superficies también se encuentran en el borde frontal (inferior) definido por la línea del "límite imposible" (exceso de curtosis + 2 - asimetría 2 = 0). A lo largo de este límite frontal (inferior), ambos parámetros de forma se aproximan a cero, y la densidad de probabilidad se concentra más en un extremo que en el otro (prácticamente sin nada en el medio), con probabilidades en el extremo izquierdo x = 0 y en el extremo derecho x = 1. Las dos superficies se separan aún más hacia el borde posterior. En este borde posterior, los parámetros de superficie son bastante diferentes entre sí. Como observaron, por ejemplo, Bowman y Shenton, [43] el muestreo en la vecindad de la línea (exceso de curtosis de la muestra - (3/2)(asimetría de la muestra) 2 = 0) (la porción en forma de J del borde posterior donde el azul se encuentra con el beige), "está peligrosamente cerca del caos", porque en esa línea el denominador de la expresión anterior para la estimación ν = α + β se vuelve cero y, por lo tanto, ν se acerca al infinito a medida que se aproxima a esa línea. Bowman y Shenton [43] escriben que "los parámetros de momento más altos (curtosis y asimetría) son extremadamente frágiles (cerca de esa línea). Sin embargo, la media y la desviación estándar son bastante fiables". Por lo tanto, el problema es para el caso de estimación de cuatro parámetros para distribuciones muy asimétricas tales que el exceso de curtosis se acerca a (3/2) veces el cuadrado de la asimetría. Esta línea límite se produce por distribuciones extremadamente asimétricas con valores muy grandes de uno de los parámetros y valores muy pequeños del otro parámetro. Véase § Curtosis limitada por el cuadrado de la asimetría para un ejemplo numérico y más comentarios sobre esta línea límite del borde posterior (exceso de curtosis de la muestra - (3/2)(asimetría de la muestra) 2 = 0). Como señaló el propio Karl Pearson [44], este problema puede no tener mucha importancia práctica ya que este problema surge solo para distribuciones en forma de J muy asimétricas (o en forma de J imagen especular) con valores muy diferentes de parámetros de forma que es poco probable que ocurran mucho en la práctica). Las distribuciones habituales en forma de campana sesgada que ocurren en la práctica no tienen este problema de estimación de parámetros.

Los dos parámetros restantes se pueden determinar utilizando la media de la muestra y la varianza de la muestra utilizando una variedad de ecuaciones. [1] [41] Una alternativa es calcular el rango del intervalo de soporte en función de la varianza de la muestra y la curtosis de la muestra. Para este propósito se puede resolver, en términos del rango , la ecuación que expresa el exceso de curtosis en términos de la varianza de la muestra y el tamaño de la muestra ν (ver § Curtosis y § Parametrizaciones alternativas, cuatro parámetros):

Para obtener:

Otra alternativa es calcular el rango del intervalo de soporte en función de la varianza de la muestra y la asimetría de la muestra. [41] Para este propósito se puede resolver, en términos del rango , la ecuación que expresa la asimetría al cuadrado en términos de la varianza de la muestra y el tamaño de la muestra ν (ver la sección titulada "Asimetría" y "Parametrizaciones alternativas, cuatro parámetros"):

para obtener: [41]

El parámetro restante se puede determinar a partir de la media de la muestra y los parámetros obtenidos previamente :

y por último, .

En las fórmulas anteriores se pueden tomar, por ejemplo, como estimaciones de los momentos muestrales:

Los estimadores G 1 para asimetría de la muestra y G 2 para curtosis de la muestra son utilizados por DAP / SAS , PSPP / SPSS y Excel . Sin embargo, no son utilizados por BMDP y (según [45] ) no fueron utilizados por MINITAB en 1998. En realidad, Joanes y Gill en su estudio de 1998 [45] concluyeron que los estimadores de asimetría y curtosis utilizados en BMDP y en MINITAB (en ese momento) tenían menor varianza y error cuadrático medio en muestras normales, pero los estimadores de asimetría y curtosis utilizados en DAP / SAS , PSPP / SPSS , a saber, G 1 y G 2 , tenían menor error cuadrático medio en muestras de una distribución muy sesgada. Es por esta razón que hemos explicado "asimetría de la muestra", etc., en las fórmulas anteriores, para dejar explícito que el usuario debe elegir el mejor estimador según el problema en cuestión, ya que el mejor estimador para asimetría y curtosis depende de la cantidad de asimetría (como lo muestran Joanes y Gill [45] ).

Máxima verosimilitud

Dos parámetros desconocidos

Como también es el caso de las estimaciones de máxima verosimilitud para la distribución gamma , las estimaciones de máxima verosimilitud para la distribución beta no tienen una solución general de forma cerrada para valores arbitrarios de los parámetros de forma. Si X 1 , ..., X N son variables aleatorias independientes que tienen cada una una distribución beta, la función de verosimilitud conjunta para N observaciones iid es:

Para encontrar el máximo con respecto a un parámetro de forma es necesario tomar la derivada parcial con respecto al parámetro de forma y establecer la expresión igual a cero, obteniendo así el estimador de máxima verosimilitud de los parámetros de forma:

dónde:

ya que la función digamma denotada ψ(α) se define como la derivada logarítmica de la función gamma : [17]

Para garantizar que los valores con pendiente tangente cero sean de hecho un máximo (en lugar de un punto de silla o un mínimo), también hay que satisfacer la condición de que la curvatura sea negativa. Esto equivale a satisfacer que la segunda derivada parcial con respecto a los parámetros de forma sea negativa.

Usando las ecuaciones anteriores, esto es equivalente a:

donde la función trigamma , denotada ψ 1 ( α ), es la segunda de las funciones poligamma , y se define como la derivada de la función digamma :

Estas condiciones equivalen a afirmar que las varianzas de las variables transformadas logarítmicamente son positivas, ya que:

Por lo tanto, la condición de curvatura negativa en un máximo es equivalente a las afirmaciones: