Función característica (teoría de la probabilidad)

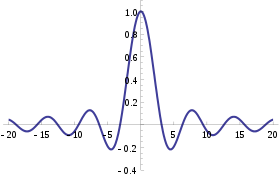

En teoría de probabilidad y estadística , la función característica de cualquier variable aleatoria de valor real define completamente su distribución de probabilidad . Si una variable aleatoria admite una función de densidad de probabilidad , entonces la función característica es la transformada de Fourier (con inversión de signo) de la función de densidad de probabilidad. Por lo tanto, proporciona una ruta alternativa para obtener resultados analíticos en comparación con el trabajo directo con funciones de densidad de probabilidad o funciones de distribución acumulativa . Hay resultados particularmente simples para las funciones características de distribuciones definidas por las sumas ponderadas de variables aleatorias.

Además de las distribuciones univariadas , se pueden definir funciones características para variables aleatorias con valores vectoriales o matriciales, y también se pueden extender a casos más genéricos.

La función característica siempre existe cuando se la trata como una función de un argumento de valor real, a diferencia de la función generadora de momentos . Existen relaciones entre el comportamiento de la función característica de una distribución y las propiedades de la distribución, como la existencia de momentos y la existencia de una función de densidad.

Introducción

La función característica es una forma de describir una variable aleatoria . La función característica ,

Una función de t determina el comportamiento y las propiedades de la distribución de probabilidad de la variable aleatoria X. Equivale a una función de densidad de probabilidad o a una función de distribución acumulativa en el sentido de que conociendo una de las funciones siempre es posible encontrar las otras, aunque proporcionan diferentes perspectivas para comprender las características de la variable aleatoria. Además, en casos particulares, puede haber diferencias en cuanto a si estas funciones se pueden representar como expresiones que involucren funciones estándar simples.

Si una variable aleatoria admite una función de densidad , entonces la función característica es su dual de Fourier , en el sentido de que cada una de ellas es una transformada de Fourier de la otra. Si una variable aleatoria tiene una función generadora de momentos , entonces el dominio de la función característica puede extenderse al plano complejo, y

- [1]

Obsérvese, sin embargo, que la función característica de una distribución está bien definida para todos los valores reales de t , incluso cuando la función generadora de momentos no está bien definida para todos los valores reales de t .

El enfoque de la función característica es particularmente útil en el análisis de combinaciones lineales de variables aleatorias independientes: una prueba clásica del Teorema del Límite Central utiliza funciones características y el Teorema de continuidad de Lévy . Otra aplicación importante es la teoría de la descomponibilidad de variables aleatorias.

Definición

Para una variable aleatoria escalar X, la función característica se define como el valor esperado de e itX , donde i es la unidad imaginaria y t ∈ R es el argumento de la función característica:

Aquí F X es la función de distribución acumulativa de X , f X es la función de densidad de probabilidad correspondiente , Q X ( p ) es la función de distribución acumulativa inversa correspondiente también llamada función cuantil , [2] y las integrales son del tipo Riemann–Stieltjes . Si una variable aleatoria X tiene una función de densidad de probabilidad entonces la función característica es su transformada de Fourier con inversión de signo en la exponencial compleja [3] [ página necesaria ] . [4] Esta convención para las constantes que aparecen en la definición de la función característica difiere de la convención habitual para la transformada de Fourier. [5] Por ejemplo, algunos autores [6] definen φ X ( t ) = E[ e −2 πitX ] , que es esencialmente un cambio de parámetro. Se pueden encontrar otras notaciones en la literatura: como la función característica para una medida de probabilidad p , o como la función característica correspondiente a una densidad f .

Generalizaciones

La noción de funciones características se generaliza a variables aleatorias multivariadas y elementos aleatorios más complejos . El argumento de la función característica siempre pertenecerá al dual continuo del espacio donde la variable aleatoria X toma sus valores. Para los casos comunes, dichas definiciones se enumeran a continuación:

- Si X es un vector aleatorio de dimensión k , entonces para t ∈ R k donde es la transpuesta del vector ,

- Si X es una matriz aleatoria de dimensión k × p , entonces para t ∈ R k × p donde es el operador de traza ,

- Si X es una variable aleatoria compleja , entonces para t ∈ C [7] donde es el conjugado complejo de y es la parte real del número complejo ,

- Si X es un vector aleatorio complejo de dimensión k , entonces para t ∈ C k [8] donde es la transpuesta conjugada del vector ,

- Si X ( s ) es un proceso estocástico , entonces para todas las funciones t ( s ) tales que la integral converge para casi todas las realizaciones de X [9]

Ejemplos

| Distribución | Función característica |

|---|---|

| δ a degenerado | |

| Bernoulli Berna( p ) | |

| Binomio B( n, p ) | |

| Binomio negativo NB( r, p ) | |

| Poisson Pois( λ ) | |

| Uniforme (continua) U( a, b ) | |

| DU uniforme (discreta) ( a, b ) | |

| Laplace L( μ , b ) | |

| Logística Logística ( μ , s ) | |

| Normal N ( μ , σ 2 ) | |

| Chi-cuadrado χ 2 k | |

| Chi-cuadrado no central | |

| Chi-cuadrado generalizado | |

| C de Cauchy ( μ , θ ) | |

| Gamma Γ( k , θ ) | |

| Exp exponencial Exp( λ ) | |

| Gf geométrica ( p ) (número de fallos) | |

| Gt geométrico ( p ) (número de ensayos) | |

| Normal multivariada N ( μ , Σ ) | |

| Cauchy multivariado MultiCauchy( μ , Σ ) [10] |

Oberhettinger (1973) proporciona tablas extensas de funciones características.

Propiedades

- La función característica de una variable aleatoria de valor real siempre existe, ya que es una integral de una función continua acotada en un espacio cuya medida es finita.

- Una función característica es uniformemente continua en todo el espacio.

- No desaparece en una región alrededor del cero: φ (0) = 1 .

- Está acotado: | φ ( t ) | ≤ 1 .

- Es hermítica : φ (− t ) = φ ( t ) . En particular, la función característica de una variable aleatoria simétrica (alrededor del origen) es de valor real e incluso .

- Existe una biyección entre las distribuciones de probabilidad y las funciones características. Es decir, para dos variables aleatorias cualesquiera X 1 , X 2 , ambas tienen la misma distribución de probabilidad si y solo si . [ cita requerida ]

- Si una variable aleatoria X tiene momentos de hasta k -ésimo orden, entonces la función característica φ X es k veces continuamente diferenciable en toda la recta real. En este caso

- Si una función característica φ X tiene una derivada k -ésima en cero, entonces la variable aleatoria X tiene todos los momentos hasta k si k es par, pero sólo hasta k – 1 si k es impar. [11]

- Si X 1 , ..., X n son variables aleatorias independientes, y a 1 , ..., a n son algunas constantes, entonces la función característica de la combinación lineal de las variables Xi es Un caso específico es la suma de dos variables aleatorias independientes X 1 y X 2 en cuyo caso se tiene

- Sean y dos variables aleatorias con funciones características y . y son independientes si y sólo si .

- El comportamiento de la cola de la función característica determina la suavidad de la función de densidad correspondiente.

- Sea la variable aleatoria la transformación lineal de una variable aleatoria . La función característica de es . Para vectores aleatorios y (donde A es una matriz constante y B un vector constante), tenemos . [12]

Continuidad

La biyección enunciada anteriormente entre distribuciones de probabilidad y funciones características es secuencialmente continua . Es decir, siempre que una secuencia de funciones de distribución F j ( x ) converge (débilmente) a alguna distribución F ( x ) , la secuencia correspondiente de funciones características φ j ( t ) también convergerá, y el límite φ ( t ) corresponderá a la función característica de la ley F . Más formalmente, esto se enuncia como

- Teorema de continuidad de Lévy : Una secuencia X j devariables aleatorias de n variables converge en distribución a la variable aleatoria X si y solo si la secuencia φ X j converge puntualmente a una función φ que es continua en el origen. Dondeφ es la función característica de X. [13]

Este teorema se puede utilizar para demostrar la ley de los grandes números y el teorema del límite central .

Fórmula de inversión

Existe una correspondencia biunívoca entre las funciones de distribución acumulativa y las funciones características, por lo que es posible hallar una de estas funciones si conocemos la otra. La fórmula de la definición de función característica nos permite calcular φ cuando conocemos la función de distribución F (o densidad f ). Si, por otro lado, conocemos la función característica φ y queremos hallar la función de distribución correspondiente, entonces se puede utilizar uno de los siguientes teoremas de inversión .

Teorema . Si la función característica φ X de una variable aleatoria X es integrable , entonces F X es absolutamente continua y, por lo tanto, X tiene una función de densidad de probabilidad . En el caso univariado (es decir, cuando X tiene un valor escalar), la función de densidad está dada por

En el caso multivariado es

¿Dónde está el producto escalar ?

La función de densidad es la derivada de Radon-Nikodym de la distribución μ X con respecto a la medida de Lebesgue λ :

Teorema (Lévy) . [nota 1] Si φ X es función característica de la función de distribución F X , dos puntos a < b son tales que { x | a < x < b } es un conjunto de continuidad de μ X (en el caso univariado esta condición es equivalente a la continuidad de F X en los puntos a y b ), entonces

- Si X es escalar: Esta fórmula se puede reformular en una forma más conveniente para el cálculo numérico como [14] Para una variable aleatoria acotada desde abajo, se puede obtener tomando tal que De lo contrario, si una variable aleatoria no está acotada desde abajo, el límite para da , pero es numéricamente impráctico. [14]

- Si X es una variable aleatoria vectorial:

Teorema . Si a es (posiblemente) un átomo de X (en el caso univariado esto significa un punto de discontinuidad de F X ) entonces

- Si X es escalar:

- Si X es una variable aleatoria vectorial: [15]

Teorema (Gil-Pelaez) . [16] Para una variable aleatoria univariante X , si x es un punto de continuidad de F X entonces

donde la parte imaginaria de un número complejo está dada por .

Y su función de densidad es:

La integral puede no ser integrable según el método de Lebesgue ; por ejemplo, cuando X es la variable aleatoria discreta que siempre es 0, se convierte en la integral de Dirichlet .

Existen fórmulas de inversión para distribuciones multivariadas. [14] [17]

Criterios para funciones características

El conjunto de todas las funciones características se cierra bajo ciertas operaciones:

- Una combinación lineal convexa (con ) de un número finito o contable de funciones características también es una función característica.

- El producto de un número finito de funciones características es también una función característica. Lo mismo vale para un producto infinito siempre que converja a una función continua en el origen.

- Si φ es una función característica y α es un número real, entonces , Re( φ ), | φ | 2 , y φ ( αt ) también son funciones características.

Es bien sabido que cualquier función càdlàg no decreciente F con límites F (−∞) = 0 , F (+∞) = 1 corresponde a una función de distribución acumulativa de alguna variable aleatoria. También existe interés en encontrar criterios simples similares para cuando una función dada φ podría ser la función característica de alguna variable aleatoria. El resultado central aquí es el teorema de Bochner , aunque su utilidad es limitada porque la condición principal del teorema, la definitividad no negativa , es muy difícil de verificar. También existen otros teoremas, como el de Khinchine, el de Mathias o el de Cramér, aunque su aplicación es igualmente difícil. El teorema de Pólya , por otro lado, proporciona una condición de convexidad muy simple que es suficiente pero no necesaria. Las funciones características que satisfacen esta condición se denominan de tipo Pólya. [18]

Teorema de Bochner . Una función arbitraria φ : R n → C es la función característica de alguna variable aleatoria si y solo si φ es definida positiva , continua en el origen y si φ (0) = 1 .

Criterio de Khinchine . Una función compleja, absolutamente continua φ , con φ (0) = 1 , es una función característica si y sólo si admite la representación

Teorema de Mathias . Una función φ real, par, continua y absolutamente integrable , con φ (0) = 1 , es una función característica si y solo si

para n = 0,1,2,... , y todos los p > 0 . Aquí H 2 n denota el polinomio de Hermite de grado 2 n .

Teorema de Pólya . Si es una función continua, par y de valores reales que satisface las condiciones

- ,

- es convexo para ,

- ,

entonces φ ( t ) es la función característica de una distribución absolutamente continua simétrica respecto de 0.

Usos

Debido al teorema de continuidad , las funciones características se utilizan en la demostración más frecuente del teorema del límite central . La técnica principal que se utiliza para realizar cálculos con una función característica es reconocer la función como la función característica de una distribución particular.

Manipulaciones básicas de distribuciones

Las funciones características son particularmente útiles para trabajar con funciones lineales de variables aleatorias independientes . Por ejemplo, si X 1 , X 2 , ..., X n es una secuencia de variables aleatorias independientes (y no necesariamente idénticamente distribuidas), y

donde a i son constantes, entonces la función característica para S n está dada por

En particular, φ X+Y ( t ) = φ X ( t ) φ Y ( t ) . Para comprobarlo, escriba la definición de función característica:

Se requiere la independencia de X e Y para establecer la igualdad de las expresiones tercera y cuarta.

Otro caso especial de interés para las variables aleatorias distribuidas de manera idéntica es cuando a i = 1 / n y entonces S n es la media de la muestra. En este caso, escribiendo X para la media,

Momentos

Las funciones características también se pueden utilizar para hallar momentos de una variable aleatoria. Siempre que exista el momento n - ésimo , la función característica se puede derivar n veces:

Esto se puede escribir formalmente utilizando las derivadas de la función delta de Dirac : que permite una solución formal al problema del momento . Por ejemplo, supongamos que X tiene una distribución de Cauchy estándar . Entonces φ X ( t ) = e −| t | . Esto no es diferenciable en t = 0 , lo que demuestra que la distribución de Cauchy no tiene esperanza . Además, la función característica de la media muestral X de n observaciones independientes tiene función característica φ X ( t ) = ( e −| t |/ n ) n = e −| t | , utilizando el resultado de la sección anterior. Esta es la función característica de la distribución de Cauchy estándar: por tanto, la media muestral tiene la misma distribución que la propia población.

Como ejemplo adicional, supongamos que X sigue una distribución gaussiana , es decir , . Entonces y

Un cálculo similar muestra y es más fácil de realizar que aplicar la definición de expectativa y utilizar la integración por partes para evaluar .

El logaritmo de una función característica es una función generadora de cumulantes , que es útil para encontrar cumulantes ; algunos, en cambio, definen la función generadora de cumulantes como el logaritmo de la función generadora de momentos , y llaman al logaritmo de la función característica la segunda función generadora de cumulantes.

Análisis de datos

Las funciones características se pueden utilizar como parte de los procedimientos para ajustar distribuciones de probabilidad a muestras de datos. Los casos en los que esto proporciona una opción practicable en comparación con otras posibilidades incluyen el ajuste de la distribución estable , ya que no se encuentran disponibles expresiones de forma cerrada para la densidad, lo que dificulta la implementación de la estimación de máxima verosimilitud . Hay procedimientos de estimación disponibles que hacen coincidir la función característica teórica con la función característica empírica , calculada a partir de los datos. Paulson et al. (1975) [19] y Heathcote (1977) [20] proporcionan algunos antecedentes teóricos para dicho procedimiento de estimación. Además, Yu (2004) [21] describe aplicaciones de funciones características empíricas para ajustar modelos de series temporales donde los procedimientos de verosimilitud son poco prácticos. Ansari et al. (2020) [22] y Li et al. (2020) [23] también han utilizado funciones características empíricas para entrenar redes generativas adversarias .

Ejemplo

La distribución gamma con parámetro de escala θ y un parámetro de forma k tiene la función característica

Ahora supongamos que tenemos

con X e Y independientes entre sí, y deseamos saber cuál es la distribución de X + Y. Las funciones características son

lo cual por independencia y las propiedades básicas de la función característica conduce a

Esta es la función característica del parámetro de escala de distribución gamma θ y del parámetro de forma k 1 + k 2 , y por lo tanto concluimos

El resultado se puede ampliar a n variables aleatorias distribuidas gamma independientes con el mismo parámetro de escala y obtenemos

Funciones características completas

![[icon]](http://upload.wikimedia.org/wikipedia/commons/thumb/1/1c/Wiki_letter_w_cropped.svg/20px-Wiki_letter_w_cropped.svg.png) | This section needs expansion. You can help by adding to it. (December 2009) |

Como se definió anteriormente, el argumento de la función característica se trata como un número real; sin embargo, ciertos aspectos de la teoría de funciones características se avanzan extendiendo la definición al plano complejo mediante continuación analítica , en los casos en que esto es posible. [24]

Conceptos relacionados

Los conceptos relacionados incluyen la función generadora de momentos y la función generadora de probabilidad . La función característica existe para todas las distribuciones de probabilidad. Este no es el caso de la función generadora de momentos.

La función característica está estrechamente relacionada con la transformada de Fourier : la función característica de una función de densidad de probabilidad p ( x ) es el conjugado complejo de la transformada de Fourier continua de p ( x ) (según la convención habitual; ver transformada de Fourier continua – otras convenciones ).

donde P ( t ) denota la transformada de Fourier continua de la función de densidad de probabilidad p ( x ) . Asimismo, p ( x ) puede recuperarse a partir de φ X ( t ) mediante la transformada de Fourier inversa:

De hecho, incluso cuando la variable aleatoria no tiene densidad, la función característica puede verse como la transformada de Fourier de la medida correspondiente a la variable aleatoria.

Otro concepto relacionado es la representación de distribuciones de probabilidad como elementos de un espacio de Hilbert de núcleo reproductor mediante la incrustación de distribuciones en el núcleo . Este marco puede considerarse como una generalización de la función característica bajo elecciones específicas de la función de núcleo .

Véase también

- Subindependencia , condición más débil que la independencia, que se define en términos de funciones características.

- Cumulante , término de las funciones generadoras de cumulantes , que son logaritmos de las funciones características.

Notas

- ^ llamado así en honor al matemático francés Paul Lévy

Referencias

Citas

- ^ Lukács (1970), pág. 196.

- ^ Shaw, WT; McCabe, J. (2009). "Muestreo de Monte Carlo dada una función característica: mecánica cuantil en el espacio de momento". arXiv : 0903.1592 [q-fin.CP].

- ^ Procesamiento estadístico y adaptativo de señales (2005)

- ^ Billingsley (1995).

- ^ Pinsky (2002).

- ^ Bochner (1955).

- ^ Andersen y col. (1995), Definición 1.10.

- ^ Andersen y col. (1995), Definición 1.20.

- ^ Sobczyk (2001), pág. 20.

- ^ Kotz y Nadarajah (2004), pág. 37 utilizando 1 como el número de grados de libertad para recuperar la distribución de Cauchy

- ^ Lukacs (1970), Corolario 1 del Teorema 2.3.1.

- ^ "Función característica conjunta". www.statlect.com . Consultado el 7 de abril de 2018 .

- ^ Cuppens (1975), Teorema 2.6.9.

- ^ abc Shephard (1991a).

- ^ Cuppens (1975), Teorema 2.3.2.

- ^ Villanueva (1961).

- ^ Shephard (1991b).

- ^ Lukács (1970), pág. 84.

- ^ Paulson, Holcomb y Leitch (1975).

- ^ Heathcote (1977).

- ^ Yu (2004).

- ^ Ansari, Scarlett y Soh (2020).

- ^ Li y otros (2020).

- ^ Lukacs (1970), Capítulo 7.

Fuentes

- Andersen, HH; Højbjerre, M.; Sorensen, D.; Eriksen, PS (1995). Modelos lineales y gráficos para la distribución normal compleja multivariada . Apuntes de conferencias sobre estadística 101. Nueva York: Springer-Verlag. ISBN 978-0-387-94521-7.

- Billingsley, Patrick (1995). Probabilidad y medida (3.ª ed.). John Wiley & Sons. ISBN 978-0-471-00710-4.

- Bisgaard, TM; Sasvári, Z. (2000). Funciones características y secuencias de momentos . Nova Science.

- Bochner, Salomon (1955). Análisis armónico y teoría de la probabilidad . University of California Press.

- Cuppens, R. (1975). Descomposición de probabilidades multivariadas . Academic Press. ISBN 9780121994501.

- Heathcote, CR (1977). "La estimación del error cuadrático integrado de parámetros". Biometrika . 64 (2): 255–264. doi :10.1093/biomet/64.2.255.

- Lukacs, E. (1970). Funciones características . Londres: Griffin.

- Kotz, Samuel; Nadarajah, Saralees (2004). Distribuciones T multivariadas y sus aplicaciones . Cambridge University Press.

- Manolakis, Dimitris G.; Ingle, Vinay K.; Kogon, Stephen M. (2005). Procesamiento estadístico y adaptativo de señales: estimación espectral, modelado de señales, filtrado adaptativo y procesamiento de matrices. Artech House. ISBN 978-1-58053-610-3.

- Oberhettinger, Fritz (1973). Transformadas de Fourier de distribuciones y sus inversas; una colección de tablas . Nueva York: Academic Press. ISBN 9780125236508.

- Paulson, AS; Holcomb, EW; Leitch, RA (1975). "La estimación de los parámetros de las leyes estables". Biometrika . 62 (1): 163–170. doi :10.1093/biomet/62.1.163.

- Pinsky, Mark (2002). Introducción al análisis de Fourier y wavelets . Brooks/Cole. ISBN 978-0-534-37660-4.

- Sobczyk, Kazimierz (2001). Ecuaciones diferenciales estocásticas . Editores académicos de Kluwer . ISBN 978-1-4020-0345-5.

- Wendel, JG (1961). "La convergencia no absoluta de la integral de inversión de Gil-Pelaez". Anales de estadística matemática . 32 (1): 338–339. doi : 10.1214/aoms/1177705164 .

- Yu, J. (2004). "Estimación de funciones características empíricas y sus aplicaciones" (PDF) . Econometric Reviews . 23 (2): 93–1223. doi :10.1081/ETC-120039605. S2CID 9076760.

- Shephard, NG (1991a). "De la función característica a la función de distribución: un marco simple para la teoría". Teoría econométrica . 7 (4): 519–529. doi :10.1017/s0266466600004746. S2CID 14668369.

- Shephard, NG (1991b). "Reglas de integración numérica para inversiones multivariadas". Revista de computación estadística y simulación . 39 (1–2): 37–46. doi :10.1080/00949659108811337.

- Ansari, Abdul Fatir; Scarlett, Jonathan; Soh, Harold (2020). "Un enfoque de función característica para el modelado generativo implícito profundo". Actas de la Conferencia IEEE/CVF sobre visión artificial y reconocimiento de patrones (CVPR), 2020. págs. 7478–7487.

- Li, Shengxi; Yu, Zeyang; Xiang, Min; Mandic, Danilo (2020). "Aprendizaje adversario recíproco a través de funciones características". Avances en sistemas de procesamiento de información neuronal 33 (NeurIPS 2020) .

Enlaces externos

- "Función característica", Enciclopedia de Matemáticas , EMS Press , 2001 [1994]

![{\displaystyle \varphi _{X}(t)=\nombre del operador {E} \left[e^{itX}\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/220ee899de62e4b930fbe4ac3a92c2e9544b2b8d)

![{\displaystyle {\begin{cases}\displaystyle \varphi _{X}\!:\mathbb {R} \to \mathbb {C} \\\displaystyle \varphi _{X}(t)=\operatorname {E} \left[e^{itX}\right]=\int _{\mathbb {R} }e^{itx}\,dF_{X}(x)=\int _{\mathbb {R} }e^{itx}f_{X}(x)\,dx=\int _{0}^{1}e^{itQ_{X}(p)}\,dp\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/326c33a2ba687a8901958c089ac9d3f8ac8945ff)

![{\displaystyle \varphi _{X}(t)=\operatorname {E} \left[\exp(it^{T}\!X)\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/84eb637716a5c31276fa219f1ac8ddd362f1ed8c)

![{\displaystyle \varphi _{X}(t)=\nombredeloperador {E} \left[\exp \left(i\nombredeloperador {tr} (t^{T}\!X)\right)\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1dcc3bfc72bffab503642e3de0a980d1bdcf0ef5)

![{\displaystyle \varphi _{X}(t)=\nombredeloperador {E} \left[\exp \left(i\nombredeloperador {Re} \left({\overline {t}}X\right)\right)\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/eeb9e95c9a7bc00d9a83d8435ef43e7155226eb1)

![{\displaystyle \varphi _{X}(t)=\nombredeloperador {E} \left[\exp(i\nombredeloperador {Re} (t^{*}\!X))\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8131988c72ceebb2b013cf2ef6132f49bf77b3f0)

![{\displaystyle \varphi _{X}(t)=\operatorname {E} \left[\exp \left(i\int _{\mathbf {R} }t(s)X(s)\,ds\right)\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e0c2b2b074883ab9f3a62c39b9bafa0f5c5fe690)

![{\displaystyle {\frac {\exp \left[it\left(m+\sum _{j}{\frac {w_{j}\lambda _{j}}{1-2iw_{j}t}}\right)-{\frac {s^{2}t^{2}}{2}}\right]}{\prod _{j}\left(1-2iw_{j}t\right)^{k_{j}/2}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bbbd466cede81b45a6bef47b62314f2d973f0393)

![{\displaystyle \operatorname {E}[X^{k}]=i^{-k}\varphi _{X}^{(k)}(0).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8b4d9670c5a208c90e576d3dd9e2a67d9f62b3ec)

![{\displaystyle \varphi _{X}^{(k)}(0)=i^{k}\nombre del operador {E} [X^{k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/278511590ecd7122a91abb28362f99a9783231c7)

![{\displaystyle \mu _{X}(\{a\})=\lim _{T_{1}\to \infty }\cdots \lim _{T_{n}\to \infty }\left(\prod _{k=1}^{n}{\frac {1}{2T_{k}}}\right)\int \limits _{[-T_{1},T_{1}]\times \dots \times [-T_{n},T_{n}]}e^{-i(t\cdot a)}\varphi _{X}(t)\lambda (dt)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a6091d2bd8a86072cd6e9c4eba20d2d26588d6a9)

![{\displaystyle F_{X}(x)={\frac {1}{2}}-{\frac {1}{\pi }}\int _{0}^{\infty }{\frac {\operatorname {Im} [e^{-itx}\varphi _{X}(t)]}{t}}\,dt}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cdb024609abbc854a4a74dfaaaaafbe19bf76879)

![{\displaystyle f_{X}(x)={\frac {1}{\pi }}\int _{0}^{\infty }\operatorname {Re} [e^{-itx}\varphi _{X}(t)]\,dt}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2f64a523e775dc962adb40df5614c84ee2d58856)

![{\displaystyle \varphi _{X+Y}(t)=\nombredeloperador {E} \left[e^{it(X+Y)}\right]=\nombredeloperador {E} \left[e^{itX}e^{itY}\right]=\nombredeloperador {E} \left[e^{itX}\right]\nombredeloperador {E} \left[e^{itY}\right]=\varphi _{X}(t)\varphi _{Y}(t)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3a2f8a4335407b6acbee44bfd54d8c5c2e59b1d5)

![{\displaystyle \operatorname {E} \left[X^{n}\right]=i^{-n}\left[{\frac {d^{n}}{dt^{n}}}\varphi _{X}(t)\right]_{t=0}=i^{-n}\varphi _{X}^{(n)}(0),\!}](https://wikimedia.org/api/rest_v1/media/math/render/svg/94b7e821b95332b9aa377186801428897738295f)

![{\displaystyle f_{X}(x)=\sum _{n=0}^{\infty }{\frac {(-1)^{n}}{n!}}\delta ^{(n)}(x)\operatorname {E} [X^{n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/845901835ce231814bc4613de68f01c1499f85eb)

![{\displaystyle \operatorname {E} \left[X\right]=i^{-1}\left[{\frac {d}{dt}}\varphi _{X}(t)\right]_{t=0}=i^{-1}\left[(i\mu -\sigma ^{2}t)\varphi _{X}(t)\right]_{t=0}=\mu }](https://wikimedia.org/api/rest_v1/media/math/render/svg/41462bb40acf2fc9e7a4fd41a5c6fd84b369be1c)

![{\displaystyle \operatorname {E} \left[X^{2}\right]=\mu ^{2}+\sigma ^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e724a4d6ebe2c549c0d8e15be5e90b516736db3d)

![{\displaystyle \operatorname {E} \izquierda[X^{2}\derecha]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c1870531fc3ee86b5deedeaedf9363b5cdd419b0)