Distribución binomial

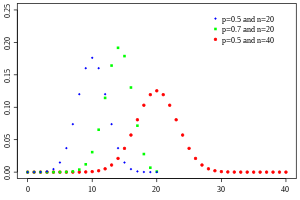

Función de masa de probabilidad  | |||

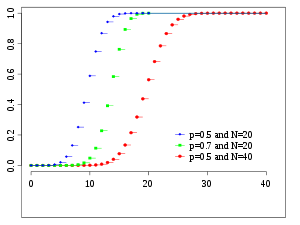

Función de distribución acumulativa  | |||

| Notación | |||

|---|---|---|---|

| Parámetros | – número de ensayos – probabilidad de éxito para cada ensayo | ||

| Apoyo | – número de éxitos | ||

| FMP | |||

| CDF | (la función beta incompleta regularizada ) | ||

| Significar | |||

| Mediana | o | ||

| Modo | o | ||

| Diferencia | |||

| Oblicuidad | |||

| Exceso de curtosis | |||

| Entropía | En Shannons . Para NAT , utilice el logaritmo natural en el logaritmo. | ||

| MGF | |||

| CF | |||

| PGF | |||

| Información de Fisher | (para fijo ) | ||

| Parte de una serie sobre estadísticas |

| Teoría de la probabilidad |

|---|

|

con n y k como en el triángulo de Pascal

La probabilidad de que una bola en una caja de Galton con 8 capas ( n = 8 termine en el contenedor central ( k = 4 es 70/256 .

En teoría de probabilidad y estadística , la distribución binomial con parámetros n y p es la distribución de probabilidad discreta del número de éxitos en una secuencia de n experimentos independientes , cada uno de los cuales plantea una pregunta de sí o no , y cada uno con su propio resultado de valor booleano : éxito (con probabilidad p ) o fracaso (con probabilidad q = 1- p ). Un único experimento de éxito/fracaso también se denomina ensayo de Bernoulli o experimento de Bernoulli, y una secuencia de resultados se denomina proceso de Bernoulli ; para un único ensayo, es decir, n = 1 , la distribución binomial es una distribución de Bernoulli . La distribución binomial es la base de la popular prueba binomial de significación estadística . [1]

La distribución binomial se utiliza con frecuencia para modelar el número de éxitos en una muestra de tamaño n extraída con reemplazo de una población de tamaño N . Si el muestreo se lleva a cabo sin reemplazo, las extracciones no son independientes y, por lo tanto, la distribución resultante es una distribución hipergeométrica , no binomial. Sin embargo, para N mucho mayores que n , la distribución binomial sigue siendo una buena aproximación y se utiliza ampliamente.

Definiciones

Función de masa de probabilidad

En general, si la variable aleatoria X sigue la distribución binomial con parámetros n ∈ y p ∈ [0, 1] , escribimos X ~ B ( n , p ) . La probabilidad de obtener exactamente k éxitos en n ensayos de Bernoulli independientes (con la misma tasa p ) está dada por la función de masa de probabilidad :

para k = 0, 1, 2, ..., n , donde

es el coeficiente binomial , de ahí el nombre de la distribución. La fórmula se puede entender de la siguiente manera: p k q n - k es la probabilidad de obtener la secuencia de n ensayos de Bernoulli independientes en la que k ensayos son "éxitos" y los n - k ensayos restantes resultan en "fracaso". Dado que los ensayos son independientes y las probabilidades permanecen constantes entre ellos, cualquier secuencia de n ensayos con k éxitos (y n - k fracasos) tiene la misma probabilidad de lograrse (independientemente de las posiciones de los éxitos dentro de la secuencia). Existen tales secuencias, ya que el coeficiente binomial cuenta el número de formas de elegir las posiciones de los k éxitos entre los n ensayos. La distribución binomial se ocupa de la probabilidad de obtener cualquiera de estas secuencias, lo que significa que la probabilidad de obtener una de ellas ( p k q n - k ) debe sumarse veces, por lo tanto .

Al crear tablas de referencia para la probabilidad de distribución binomial, por lo general, la tabla se completa con hasta n /2 valores. Esto se debe a que para k > n /2 , la probabilidad se puede calcular por su complemento como

Si consideramos la expresión f ( k , n , p ) como función de k , hay un valor k que la maximiza. Este valor k se puede encontrar calculando

y comparándolo con 1. Siempre hay un entero M que satisface [2]

f ( k , n , p ) es monótona creciente para k < M y monótona decreciente para k > M , con la excepción del caso donde ( n + 1) p es un entero. En este caso, hay dos valores para los cuales f es máxima: ( n + 1) p y ( n + 1) p - 1 . M es el resultado más probable (es decir, el más probable, aunque todavía puede ser improbable en general) de los ensayos de Bernoulli y se llama moda .

De manera equivalente, . Tomando la función de piso , obtenemos M = piso( np ) . [nota 1]

Ejemplo

Supongamos que una moneda sesgada sale cara con una probabilidad de 0,3 al lanzarla. La probabilidad de ver exactamente 4 caras en 6 lanzamientos es

Función de distribución acumulativa

La función de distribución acumulativa se puede expresar como:

donde es el "piso" debajo de k , es decir, el mayor entero menor o igual a k .

También se puede representar en términos de la función beta incompleta regularizada , de la siguiente manera: [3]

que es equivalente a la función de distribución acumulativa de la distribución F : [4]

A continuación se dan algunos límites de forma cerrada para la función de distribución acumulativa.

Propiedades

Valor esperado y varianza

Si X ~ B ( n , p ) , es decir, X es una variable aleatoria distribuida binomialmente, donde n es el número total de experimentos y p la probabilidad de que cada experimento arroje un resultado exitoso, entonces el valor esperado de X es: [5]

Esto se desprende de la linealidad del valor esperado junto con el hecho de que X es la suma de n variables aleatorias de Bernoulli idénticas, cada una con valor esperado p . En otras palabras, si son variables aleatorias de Bernoulli idénticas (e independientes) con parámetro p , entonces y

La varianza es:

Esto también se desprende del hecho de que la varianza de una suma de variables aleatorias independientes es la suma de las varianzas.

Momentos más elevados

Los primeros 6 momentos centrales , definidos como , están dados por

Los momentos no centrales satisfacen

y en general [6] [7]

donde son los números de Stirling de segundo tipo , y es la potencia descendente de . Se obtiene un límite simple [8] al limitar los momentos binomiales a través de los momentos de Poisson superiores :

Esto demuestra que si , entonces es como máximo un factor constante alejado de

Modo

Por lo general, la moda de una distribución binomial B ( n , p ) es igual a , donde es la función base . Sin embargo, cuando ( n + 1) p es un entero y p no es ni 0 ni 1, entonces la distribución tiene dos modas: ( n + 1) p y ( n + 1) p − 1. Cuando p es igual a 0 o 1, la moda será 0 y n correspondientemente. Estos casos se pueden resumir de la siguiente manera:

Prueba: Sea

Para solo tiene un valor distinto de cero con . Para encontramos y para . Esto demuestra que la moda es 0 para y para .

Sea . Encontramos

- .

De esto se desprende

Por lo tanto, cuando es un entero, entonces y es una moda. En el caso de que , entonces sólo es una moda. [9]

Mediana

En general, no existe una fórmula única para hallar la mediana de una distribución binomial, e incluso puede que no sea única. Sin embargo, se han establecido varios resultados especiales:

- Si es un número entero, entonces la media, la mediana y la moda coinciden y son iguales . [10] [11]

- Cualquier mediana m debe estar dentro del intervalo . [12]

- Una mediana m no puede estar demasiado alejada de la media: . [13]

- La mediana es única e igual a m = redondo ( np ) cuando (excepto en el caso en que y n es impar). [12]

- Cuando p es un número racional (con excepción de n impar ) la mediana es única. [14]

- Cuando y n es impar, cualquier número m en el intervalo es una mediana de la distribución binomial. Si y n es par, entonces es la única mediana.

Límites de cola

Para k ≤ np , se pueden derivar límites superiores para la cola inferior de la función de distribución acumulativa , la probabilidad de que haya como máximo k éxitos. Dado que , estos límites también se pueden ver como límites para la cola superior de la función de distribución acumulativa para k ≥ np .

La desigualdad de Hoeffding produce el límite simple

que, sin embargo, no es muy estricta. En particular, para p = 1, tenemos que F ( k ; n , p ) = 0 (para k , n fijos con k < n ), pero el límite de Hoeffding se evalúa como una constante positiva.

Se puede obtener un límite más preciso a partir del límite de Chernoff : [15]

donde D ( a || p ) es la entropía relativa (o divergencia de Kullback-Leibler) entre una moneda a y una moneda p (es decir, entre la distribución de Bernoulli( a ) y Bernoulli( p )):

Asintóticamente, este límite es razonablemente estrecho; véase [15] para más detalles.

También se pueden obtener límites inferiores en la cola , conocidos como límites de anticoncentración. Al aproximar el coeficiente binomial con la fórmula de Stirling se puede demostrar que [16]

lo que implica el límite más simple pero más flexible

Para p = 1/2 y k ≥ 3 n /8 para n par , es posible hacer constante el denominador: [17]

Inferencia estadística

Estimación de parámetros

Cuando se conoce n , el parámetro p se puede estimar utilizando la proporción de éxitos:

Este estimador se obtiene utilizando el estimador de máxima verosimilitud y también el método de momentos . Este estimador es insesgado y uniforme con mínima varianza , lo que se demuestra utilizando el teorema de Lehmann-Scheffé , ya que se basa en un estadístico mínimo suficiente y completo (es decir: x ). También es consistente tanto en probabilidad como en MSE .

También existe un estimador bayesiano de forma cerrada para p cuando se utiliza la distribución Beta como distribución previa conjugada . Cuando se utiliza una distribución general como previa, el estimador de media posterior es:

El estimador de Bayes es asintóticamente eficiente y, a medida que el tamaño de la muestra se acerca al infinito ( n → ∞), se aproxima a la solución MLE . [18] El estimador de Bayes es sesgado (cuánto depende de los valores anteriores), admisible y consistente en probabilidad.

Para el caso especial de utilizar la distribución uniforme estándar como una distribución previa no informativa , el estimador de media posterior se convierte en:

(Un modo posterior debería conducir simplemente al estimador estándar). Este método se llama regla de sucesión , que fue introducida en el siglo XVIII por Pierre-Simon Laplace .

Al confiar en el prior de Jeffreys , el prior es , [19] lo que conduce al estimador:

Al estimar p con eventos muy raros y una n pequeña (por ejemplo, si x = 0), entonces el uso del estimador estándar conduce a lo que a veces es poco realista y no deseable. En tales casos, existen varios estimadores alternativos. [20] Una forma es usar el estimador de Bayes , que conduce a:

Otro método es utilizar el límite superior del intervalo de confianza obtenido mediante la regla de tres :

Intervalos de confianza

Incluso para valores bastante grandes de n , la distribución real de la media es significativamente no normal. [21] Debido a este problema, se han propuesto varios métodos para estimar intervalos de confianza.

En las ecuaciones para intervalos de confianza que aparecen a continuación, las variables tienen el siguiente significado:

- n 1 es el número de éxitos de n , el número total de ensayos

- es la proporción de éxitos

- es el cuantil de una distribución normal estándar (es decir, probit ) correspondiente a la tasa de error objetivo . Por ejemplo, para un nivel de confianza del 95%, el error = 0,05, por lo tanto = 0,975 y = 1,96.

Método Wald

Se puede añadir una corrección de continuidad de 0,5/ n . [ aclaración necesaria ]

Método de Agresti-Coull

[22]

Aquí la estimación de p se modifica a

Este método funciona bien para y . [23] Consulte aquí para . [24] Para utilizar el método Wilson (puntuación) a continuación.

Método del arcoseno

[25]

Método de Wilson (puntuación)

La notación en la fórmula siguiente difiere de las fórmulas anteriores en dos aspectos: [26]

- En primer lugar, z x tiene una interpretación ligeramente diferente en la fórmula siguiente: tiene su significado ordinario de 'el x -ésimo cuantil de la distribución normal estándar', en lugar de ser una abreviatura de 'el (1 − x )-ésimo cuantil'.

- En segundo lugar, esta fórmula no utiliza un signo más-menos para definir los dos límites. En su lugar, se puede utilizar para obtener el límite inferior o para obtener el límite superior. Por ejemplo: para un nivel de confianza del 95 %, el error = 0,05, por lo que se obtiene el límite inferior utilizando y el límite superior utilizando .

- [27]

Comparación

El método llamado "exacto" ( Clopper-Pearson ) es el más conservador. [21] ( Exacto no significa perfectamente preciso; más bien, indica que las estimaciones no serán menos conservadoras que el valor real).

El método Wald, aunque se recomienda comúnmente en los libros de texto, es el más sesgado. [ aclaración necesaria ]

Distribuciones relacionadas

Sumas de binomios

Si X ~ B( n , p ) e Y ~ B( m , p ) son variables binomiales independientes con la misma probabilidad p , entonces X + Y es nuevamente una variable binomial; su distribución es Z=X+Y ~ B( n+m , p ): [28]

Una variable aleatoria distribuida binomialmente X ~ B( n , p ) puede considerarse como la suma de n variables aleatorias distribuidas según Bernoulli. Por lo tanto, la suma de dos variables aleatorias distribuidas binomialmente X ~ B( n , p ) e Y ~ B( m , p ) es equivalente a la suma de n + m variables aleatorias distribuidas según Bernoulli, lo que significa Z=X+Y ~ B( n+m , p ). Esto también puede demostrarse directamente utilizando la regla de la adición.

Sin embargo, si X e Y no tienen la misma probabilidad p , entonces la varianza de la suma será menor que la varianza de una variable binomial distribuida como

Distribución binomial de Poisson

La distribución binomial es un caso especial de la distribución binomial de Poisson , que es la distribución de una suma de n ensayos de Bernoulli independientes no idénticos B( p i ). [29]

Relación de dos distribuciones binomiales

Este resultado fue obtenido por primera vez por Katz y coautores en 1978. [30]

Sean X ~ B( n , p 1 ) e Y ~ B( m , p 2 ) independientes. Sea T = ( X / n ) / ( Y / m ) .

Entonces log( T ) se distribuye aproximadamente de manera normal con media log( p 1 / p 2 ) y varianza ((1/ p 1 ) − 1)/ n + ((1/ p 2 ) − 1)/ m .

Binomios condicionales

Si X ~ B( n , p ) e Y | X ~ B( X , q ) (la distribución condicional de Y , dado X ), entonces Y es una variable aleatoria binomial simple con distribución Y ~ B( n , pq ).

Por ejemplo, imagina lanzar n pelotas a una canasta U X y tomar las pelotas que golpean y lanzarlas a otra canasta U Y . Si p es la probabilidad de golpear U X entonces X ~ B( n , p ) es el número de pelotas que golpean U X . Si q es la probabilidad de golpear U Y entonces el número de pelotas que golpean U Y es Y ~ B( X , q ) y por lo tanto Y ~ B( n , pq ).

Dado que y , por la ley de probabilidad total ,

Dado que la ecuación anterior se puede expresar como

Al factorizar y extraer de la suma todos los términos que no dependen de ahora obtenemos

Después de sustituir en la expresión anterior, obtenemos

Observe que la suma (entre paréntesis) anterior es igual a , según el teorema del binomio . Sustituyendo esto en finalmente se obtiene

y así según lo deseado.

Distribución de Bernoulli

La distribución de Bernoulli es un caso especial de la distribución binomial, donde n = 1. Simbólicamente, X ~ B(1, p ) tiene el mismo significado que X ~ Bernoulli( p ). Por el contrario, cualquier distribución binomial, B( n , p ), es la distribución de la suma de n ensayos de Bernoulli independientes , Bernoulli( p ), cada uno con la misma probabilidad p . [31]

Aproximación normal

Si n es suficientemente grande, entonces la asimetría de la distribución no es demasiado grande. En este caso, una aproximación razonable a B( n , p ) la proporciona la distribución normal

y esta aproximación básica se puede mejorar de una manera sencilla utilizando una corrección de continuidad adecuada . La aproximación básica generalmente mejora a medida que n aumenta (al menos 20) y es mejor cuando p no está cerca de 0 o 1. [32] Se pueden utilizar varias reglas generales para decidir si n es lo suficientemente grande y p está lo suficientemente lejos de los extremos de cero o uno:

- Una regla [32] es que para n > 5 la aproximación normal es adecuada si el valor absoluto de la asimetría es estrictamente menor que 0,3; es decir, si

Esto se puede precisar utilizando el teorema de Berry-Esseen .

- Una regla más fuerte establece que la aproximación normal es apropiada solo si todo dentro de 3 desviaciones estándar de su media está dentro del rango de valores posibles; es decir, solo si

- Esta regla de 3 desviaciones estándar es equivalente a las siguientes condiciones, que también implican la primera regla anterior.

La regla es totalmente equivalente a solicitar que

Mover los términos produce:

Como , podemos aplicar la potencia al cuadrado y dividir por los respectivos factores y , para obtener las condiciones deseadas:

Tenga en cuenta que estas condiciones implican automáticamente que . Por otro lado, aplique nuevamente la raíz cuadrada y divida por 3,

Restando el segundo conjunto de desigualdades del primero obtenemos:

y así, se satisface la primera regla deseada,

- Otra regla que se utiliza con frecuencia es que ambos valores deben ser mayores que [33] [34] o iguales a 5. Sin embargo, el número específico varía de una fuente a otra y depende de la precisión de la aproximación que se desee. En particular, si se utiliza 9 en lugar de 5, la regla implica los resultados indicados en los párrafos anteriores.

Supongamos que ambos valores y son mayores que 9. Como , tenemos fácilmente que

Ahora sólo nos queda dividir por los respectivos factores y , para deducir la forma alternativa de la regla de las 3 desviaciones estándar:

El siguiente es un ejemplo de aplicación de una corrección de continuidad . Supongamos que se desea calcular Pr( X ≤ 8) para una variable aleatoria binomial X . Si Y tiene una distribución dada por la aproximación normal, entonces Pr( X ≤ 8) se aproxima por Pr( Y ≤ 8,5). La adición de 0,5 es la corrección de continuidad; la aproximación normal sin corregir da resultados considerablemente menos precisos.

Esta aproximación, conocida como teorema de De Moivre-Laplace , es un gran ahorro de tiempo cuando se realizan cálculos a mano (los cálculos exactos con n grandes son muy onerosos); históricamente, fue el primer uso de la distribución normal, introducida en el libro de Abraham de Moivre La doctrina de las probabilidades en 1738. Hoy en día, puede verse como una consecuencia del teorema del límite central ya que B( n , p ) es una suma de n variables de Bernoulli independientes, idénticamente distribuidas con parámetro p . Este hecho es la base de una prueba de hipótesis , una "prueba z de proporción", para el valor de p utilizando x/n , la proporción de la muestra y el estimador de p , en una estadística de prueba común . [35]

Por ejemplo, supongamos que se toma una muestra aleatoria de n personas de una población grande y se les pregunta si están de acuerdo con una determinada afirmación. La proporción de personas que estén de acuerdo dependerá, por supuesto, de la muestra. Si se tomaran muestras de grupos de n personas de forma repetida y verdaderamente aleatoria, las proporciones seguirían una distribución normal aproximada con una media igual a la verdadera proporción p de acuerdo en la población y con una desviación estándar

Aproximación de Poisson

La distribución binomial converge hacia la distribución de Poisson a medida que el número de ensayos tiende al infinito, mientras que el producto np converge a un límite finito. Por lo tanto, la distribución de Poisson con parámetro λ = np se puede utilizar como una aproximación a B( n , p ) de la distribución binomial si n es suficientemente grande y p es suficientemente pequeño. Según las reglas generales, esta aproximación es buena si n ≥ 20 y p ≤ 0,05 [36] de modo que np ≤ 1, o si n > 50 y p < 0,1 de modo que np < 5, [37] o si n ≥ 100 y np ≤ 10. [38] [39]

Respecto de la precisión de la aproximación de Poisson, véase Novak, [40] cap. 4 y referencias allí citadas.

Distribuciones limitantes

- Teorema del límite de Poisson : cuando n se acerca a ∞ y p se acerca a 0 con el producto np mantenido fijo, la distribución Binomial( n , p ) se acerca a la distribución de Poisson con valor esperado λ = np . [38]

- Teorema de De Moivre-Laplace : A medida que n se acerca a ∞ mientras p permanece fijo, la distribución de

- se aproxima a la distribución normal con valor esperado 0 y varianza 1. Este resultado a veces se enuncia vagamente diciendo que la distribución de X es asintóticamente normal con valor esperado 0 y varianza 1. Este resultado es un caso específico del teorema del límite central .

Distribución beta

La distribución binomial y la distribución beta son diferentes visiones del mismo modelo de ensayos repetidos de Bernoulli. La distribución binomial es la función de probabilidad de éxito de k éxitos dados n eventos independientes, cada uno con una probabilidad p de éxito. Matemáticamente, cuando α = k + 1 y β = n − k + 1 , la distribución beta y la distribución binomial están relacionadas por [ aclaración necesaria ] un factor de n + 1 :

Las distribuciones beta también proporcionan una familia de distribuciones de probabilidad previa para distribuciones binomiales en inferencia bayesiana : [41]

Dado un previo uniforme, la distribución posterior para la probabilidad de éxito p dados n eventos independientes con k éxitos observados es una distribución beta. [42]

Métodos computacionales

Generación de números aleatorios

Los métodos para la generación de números aleatorios donde la distribución marginal es una distribución binomial están bien establecidos. [43] [44] Una forma de generar muestras de variables aleatorias a partir de una distribución binomial es utilizar un algoritmo de inversión. Para ello, se debe calcular la probabilidad de que Pr( X = k ) para todos los valores k desde 0 hasta n . (Estas probabilidades deben sumar un valor cercano a uno, para abarcar todo el espacio muestral). Luego, al utilizar un generador de números pseudoaleatorios para generar muestras uniformemente entre 0 y 1, se pueden transformar las muestras calculadas en números discretos utilizando las probabilidades calculadas en el primer paso.

Historia

Esta distribución fue derivada por Jacob Bernoulli . Consideró el caso donde p = r /( r + s ), donde p es la probabilidad de éxito y r y s son números enteros positivos. Blaise Pascal había considerado anteriormente el caso donde p = 1/2, tabulando los coeficientes binomiales correspondientes en lo que ahora se reconoce como el triángulo de Pascal . [45]

Véase también

- Regresión logística

- Distribución multinomial

- Distribución binomial negativa

- Distribución beta-binomial

- Medida binomial, un ejemplo de medida multifractal . [46]

- Mecánica estadística

- Lema de acumulación , la probabilidad resultante al aplicar la operación XOR a variables booleanas independientes

Referencias

- ^ Westland, J. Christopher (2020). Análisis de auditoría: ciencia de datos para la profesión contable . Chicago, IL, EE. UU.: Springer. pág. 53. ISBN 978-3-030-49091-1.

- ^ Feller, W. (1968). Introducción a la teoría de la probabilidad y sus aplicaciones (tercera edición). Nueva York: Wiley. pág. 151 (teorema en la sección VI.3).

- ^ Wadsworth, GP (1960). Introducción a la probabilidad y las variables aleatorias . Nueva York: McGraw-Hill. pág. 52.

- ^ Jowett, GH (1963). "La relación entre las distribuciones binomial y F". Revista de la Royal Statistical Society, Serie D . 13 (1): 55–57. doi :10.2307/2986663. JSTOR 2986663.

- ^ Ver Wiki de prueba

- ^ Knoblauch, Andreas (2008), "Expresiones de forma cerrada para los momentos de la distribución de probabilidad binomial", SIAM Journal on Applied Mathematics , 69 (1): 197–204, doi :10.1137/070700024, JSTOR 40233780

- ^ Nguyen, Duy (2021), "Un enfoque probabilístico de los momentos de las variables aleatorias binomiales y su aplicación", The American Statistician , 75 (1): 101–103, doi :10.1080/00031305.2019.1679257, S2CID 209923008

- ^ D. Ahle, Thomas (2022), "Límites claros y simples para los momentos brutos de las distribuciones binomial y de Poisson", Statistics & Probability Letters , 182 : 109306, arXiv : 2103.17027 , doi : 10.1016/j.spl.2021.109306

- ^ Véase también Nicolas, André (7 de enero de 2019). "Encontrar el modo en la distribución binomial". Stack Exchange .

- ^ Neumann, P. (1966). "Über den Median der Binomial- and Poissonverteilung". Wissenschaftliche Zeitschrift der Technischen Universität Dresden (en alemán). 19 : 29–33.

- ^ Lord, Nick. (Julio de 2010). "Promedios binomiales cuando la media es un número entero", The Mathematical Gazette 94, 331-332.

- ^ ab Kaas, R.; Buhrman, JM (1980). "Media, mediana y moda en distribuciones binomiales". Statistica Neerlandica . 34 (1): 13–18. doi :10.1111/j.1467-9574.1980.tb00681.x.

- ^ Hamza, K. (1995). "El límite superior uniforme más pequeño de la distancia entre la media y la mediana de las distribuciones binomial y de Poisson". Statistics & Probability Letters . 23 : 21–25. doi :10.1016/0167-7152(94)00090-U.

- ^ Nowakowski, Sz. (2021). "Singularidad de una mediana de una distribución binomial con probabilidad racional". Avances en Matemáticas: Revista científica . 10 (4): 1951–1958. arXiv : 2004.03280 . doi :10.37418/amsj.10.4.9. ISSN 1857-8365. S2CID 215238991.

- ^ ab Arratia, R.; Gordon, L. (1989). "Tutorial sobre grandes desviaciones para la distribución binomial". Boletín de biología matemática . 51 (1): 125–131. doi :10.1007/BF02458840. PMID 2706397. S2CID 189884382.

- ^ Robert B. Ash (1990). Teoría de la información . Dover Publications. pág. 115. ISBN. 9780486665214.

- ^ Matoušek, J.; Vondrak, J. "El método probabilístico" (PDF) . notas de clase . Archivado (PDF) desde el original el 2022-10-09.

- ^ Wilcox, Rand R. (1979). "Estimación de los parámetros de la distribución beta-binomial". Medición educativa y psicológica . 39 (3): 527–535. doi :10.1177/001316447903900302. ISSN 0013-1644. S2CID 121331083.

- ^ Marko Lalovic (https://stats.stackexchange.com/users/105848/marko-lalovic), Prior de Jeffreys para verosimilitud binomial, URL (versión: 2019-03-04): https://stats.stackexchange.com/q/275608

- ^ Razzaghi, Mehdi (2002). "Sobre la estimación de la probabilidad de éxito binomial con cero ocurrencia en la muestra". Journal of Modern Applied Statistical Methods . 1 (2): 326–332. doi : 10.22237/jmasm/1036110000 .

- ^ ab Brown, Lawrence D.; Cai, T. Tony; DasGupta, Anirban (2001), "Estimación de intervalo para una proporción binomial", Statistical Science , 16 (2): 101–133, CiteSeerX 10.1.1.323.7752 , doi :10.1214/ss/1009213286 , consultado el 5 de enero de 2015

- ^ Agresti, Alan; Coull, Brent A. (mayo de 1998), "Aproximadamente es mejor que 'exacto' para la estimación de intervalos de proporciones binomiales" (PDF) , The American Statistician , 52 (2): 119–126, doi :10.2307/2685469, JSTOR 2685469 , consultado el 5 de enero de 2015

- ^ Gulotta, Joseph. "Método de intervalos de Agresti-Coull". pellucid.atlassian.net . Consultado el 18 de mayo de 2021 .

- ^ "Intervalos de confianza". itl.nist.gov . Consultado el 18 de mayo de 2021 .

- ^ Pires, MA (2002). "Intervalos de confianza para una proporción binomial: comparación de métodos y evaluación de software" (PDF) . En Klinke, S.; Ahrend, P.; Richter, L. (eds.). Actas de la Conferencia CompStat 2002 . Comunicaciones breves y pósters. Archivado (PDF) desde el original el 2022-10-09.

- ^ Wilson, Edwin B. (junio de 1927), "Inferencia probable, la ley de sucesión e inferencia estadística" (PDF) , Journal of the American Statistical Association , 22 (158): 209–212, doi :10.2307/2276774, JSTOR 2276774, archivado desde el original (PDF) el 13 de enero de 2015 , consultado el 5 de enero de 2015

- ^ "Intervalos de confianza". Manual de estadística de ingeniería . NIST/Sematech. 2012. Consultado el 23 de julio de 2017 .

- ^ Dekking, FM; Kraaikamp, C.; Lopohaa, HP; Meester, LE (2005). Una introducción moderna a la probabilidad y la estadística (1 ed.). Springer-Verlag Londres. ISBN 978-1-84628-168-6.

- ^ Wang, YH (1993). "Sobre el número de éxitos en ensayos independientes" (PDF) . Statistica Sinica . 3 (2): 295–312. Archivado desde el original (PDF) el 2016-03-03.

- ^ Katz, D.; et al. (1978). "Obtención de intervalos de confianza para la razón de riesgos en estudios de cohorte". Biometrics . 34 (3): 469–474. doi :10.2307/2530610. JSTOR 2530610.

- ^ Taboga, Marco. "Conferencias sobre teoría de la probabilidad y estadística matemática". statlect.com . Consultado el 18 de diciembre de 2017 .

- ^ ab Box, Hunter y Hunter (1978). Estadísticas para experimentadores . Wiley. pág. 130. ISBN 9780471093152.

- ^ Chen, Zac (2011). Manual de matemáticas H2 (1.ª edición). Singapur: Educational Publishing House. pág. 350. ISBN 9789814288484.

- ^ "6.4: Aproximación normal a la distribución binomial - Statistics LibreTexts". 2023-05-29. Archivado desde el original el 2023-05-29 . Consultado el 2023-10-07 .

{{cite web}}: CS1 maint: bot: original URL status unknown (link) - ^ NIST / SEMATECH , "7.2.4. ¿La proporción de defectuosos cumple con los requisitos?" Manual electrónico de métodos estadísticos.

- ^ "12.4 - Aproximación de la distribución binomial | STAT 414". 28 de marzo de 2023. Archivado desde el original el 28 de marzo de 2023. Consultado el 8 de octubre de 2023 .

{{cite web}}: CS1 maint: bot: original URL status unknown (link) - ^ Chen, Zac (2011). Manual de matemáticas H2 (1.ª ed.). Singapur: Editorial educativa. pág. 348. ISBN 9789814288484.

- ^ ab NIST / SEMATECH , "6.3.3.1. Gráficos de control de recuentos", Manual electrónico de métodos estadísticos.

- ^ "La conexión entre las distribuciones de Poisson y binomial". 13 de marzo de 2023. Archivado desde el original el 13 de marzo de 2023. Consultado el 8 de octubre de 2023 .

{{cite web}}: CS1 maint: bot: original URL status unknown (link) - ^ Novak SY (2011) Métodos de valor extremo con aplicaciones a las finanzas. Londres: CRC/ Chapman & Hall/Taylor & Francis. ISBN 9781-43983-5746 .

- ^ MacKay, David (2003). Teoría de la información, inferencia y algoritmos de aprendizaje . Cambridge University Press; Primera edición. ISBN 978-0521642989.

- ^ "Distribución beta".

- ^ Devroye, Luc (1986) Generación de variables aleatorias no uniformes , Nueva York: Springer-Verlag. (Véase especialmente el capítulo X, Distribuciones univariadas discretas)

- ^ Kachitvichyanukul, V.; Schmeiser, BW (1988). "Generación de variables aleatorias binomiales". Comunicaciones de la ACM . 31 (2): 216–222. doi :10.1145/42372.42381. S2CID 18698828.

- ^ Katz, Victor (2009). "14.3: Probabilidad elemental". Una historia de las matemáticas: una introducción . Addison-Wesley. pág. 491. ISBN 978-0-321-38700-4.

- ^ Mandelbrot, BB, Fisher, AJ, y Calvet, LE (1997). Un modelo multifractal de rendimientos de activos. 3.2 La medida binomial es el ejemplo más simple de un modelo multifractal .

- ^ Excepto el caso trivial p = 0 , que debe comprobarse por separado.

Lectura adicional

- Hirsch, Werner Z. (1957). "Distribución binomial: ¿éxito o fracaso? ¿Qué probabilidades hay de que ocurran?". Introducción a la estadística moderna . Nueva York: MacMillan. págs. 140-153.

- Neter, Juan; Wasserman, William; Whitmore, GA (1988). Estadística Aplicada (Tercera ed.). Boston: Allyn y Bacon. págs. 185-192. ISBN 0-205-10328-6.

Enlaces externos

- Gráfico interactivo: Relaciones de distribución univariadas

- Calculadora de la fórmula de distribución binomial

- Diferencia de dos variables binomiales: XY o |XY|

- Consulta de la distribución de probabilidad binomial en WolframAlpha

- Intervalos de confianza (credibilidad) para probabilidad binomial, p: calculadora en línea disponible en causaScientia.org

![{\displaystyle p\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/33c3a52aa7b2d00227e85c641cca67e85583c43c)

![{\displaystyle G(z)=[q+pz]^{n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/40494c697ce2f88ebb396ac0191946285cadcbdd)

![{\displaystyle \operatorname {E}[X]=np.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3f16b365410a1b23b5592c53d3ae6354f1a79aff)

![{\displaystyle \operatorname {E} [X]=\operatorname {E} [X_{1}+\cdots +X_{n}]=\operatorname {E} [X_{1}]+\cdots +\operatorname {E} [X_{n}]=p+\cdots +p=np.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f238d520c68a1d1b9b318492ddda39f4cc45bb8)

![{\displaystyle \mu _{c}=\nombredeloperador {E} \left[(X-\nombredeloperador {E} [X])^{c}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1c5ea3e05b674668550675c3c4593c725a1ec86b)

![{\displaystyle {\begin{aligned}\nombre del operador {E} [X]&=np,\\\nombre del operador {E} [X^{2}]&=np(1-p)+n^{2}p^{2},\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b3f2b3a9af52fc1ea633476400290069fc3ae7b4)

![{\displaystyle \operatorname {E} [X^{c}]=\sum _{k=0}^{c}\left\{{c \atop k}\right\}n^{\underline {k}}p^{k},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/db435ced7af59fa481fe26a023a1429d18a6a83a)

![{\displaystyle \operatorname {E} [X^{c}]\leq \left({\frac {c}{\log(c/(np)+1)}}\right)^{c}\leq (np)^{c}\exp \left({\frac {c^{2}}{2np}}\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6b86926254189719acfa57fcc1650caf698c292)

![{\displaystyle \nombre del operador {E} [X^{c}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5989f9c9f5202059ad1c0a4026d267ee2a975761)

![{\displaystyle \nombre del operador {E} [X]^{c}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/74d46bd564a6f77db38e12b156443bdbc3262cfb)

![{\displaystyle {\begin{aligned}\operatorname {P} (Z=k)&=\sum _{i=0}^{k}\left[{\binom {n}{i}}p^{i}(1-p)^{ni}\right]\left[{\binom {m}{ki}}p^{ki}(1-p)^{m-k+i}\right]\\&={\binom {n+m}{k}}p^{k}(1-p)^{n+mk}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/38fc38e9a5e2c49743f45b4dab5dae6230ab2ad5)

![{\displaystyle {\begin{aligned}\Pr[Y=m]&=\sum _{k=m}^{n}\Pr[Y=m\mid X=k]\Pr[X=k]\\[2pt]&=\sum _{k=m}^{n}{\binom {n}{k}}{\binom {k}{m}}p^{k}q^{m}(1-p)^{nk}(1-q)^{km}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e8f896e04f3bc2c13d2eed61e48bd43e63f6406)

![{\displaystyle \Pr[Y=m]=\sum _{k=m}^{n}{\binom {n}{m}}{\binom {nm}{km}}p^{k}q^ {m}(1-p)^{nk}(1-q)^{km}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8369ef846ffda72900efc67b334923f70ce48ca5)

![{\displaystyle {\begin{aligned}\Pr[Y=m]&={\binom {n}{m}}p^{m}q^{m}\left(\sum _{k=m}^{n}{\binom {nm}{km}}p^{km}(1-p)^{nk}(1-q)^{km}\right)\\[2pt]&={\binom {n}{m}}(pq)^{m}\left(\sum _{k=m}^{n}{\binom {nm}{km}}\left(p(1-q)\right)^{km}(1-p)^{nk}\right)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/caaa36dbcb3b4c43d7d5310533ef9d4809ba9db8)

![{\displaystyle \Pr[Y=m]={\binom {n}{m}}(pq)^{m}\left(\sum _{i=0}^{nm}{\binom {nm}{i}}(p-pq)^{i}(1-p)^{nmi}\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/54401b2dd0936ca0904832912df2fe9b2c3d5153)

![{\displaystyle {\begin{aligned}\Pr[Y=m]&={\binom {n}{m}}(pq)^{m}(p-pq+1-p)^{nm}\\[4pt]&={\binom {n}{m}}(pq)^{m}(1-pq)^{nm}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/324b106ed5f362da979eebfc0feaa94b44b713b2)