Distribución de Bernoulli

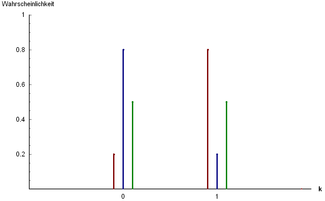

Función de masa de probabilidad  Tres ejemplos de distribución de Bernoulli: y y y | |||

| Parámetros | |||

|---|---|---|---|

| Apoyo | |||

| FMP | |||

| CDF | |||

| Significar | |||

| Mediana | |||

| Modo | |||

| Diferencia | |||

| ENOJADO | |||

| Oblicuidad | |||

| Exceso de curtosis | |||

| Entropía | |||

| MGF | |||

| CF | |||

| PGF | |||

| Información de Fisher | |||

| Parte de una serie sobre estadísticas |

| Teoría de la probabilidad |

|---|

|

En teoría de probabilidad y estadística , la distribución de Bernoulli , llamada así por el matemático suizo Jacob Bernoulli , [1] es la distribución de probabilidad discreta de una variable aleatoria que toma el valor 1 con probabilidad y el valor 0 con probabilidad . De manera menos formal, se puede considerar como un modelo para el conjunto de resultados posibles de cualquier experimento individual que haga una pregunta de sí o no . Tales preguntas conducen a resultados que tienen un valor booleano : un solo bit cuyo valor es éxito/ sí / verdadero / uno con probabilidad p y fracaso/no/ falso / cero con probabilidad q . Se puede utilizar para representar un lanzamiento de moneda (posiblemente sesgado) donde 1 y 0 representarían "cara" y "cruz", respectivamente, y p sería la probabilidad de que la moneda caiga en cara (o viceversa, donde 1 representaría cruz y p sería la probabilidad de cruz). En particular, las monedas injustas tendrían

La distribución de Bernoulli es un caso especial de la distribución binomial en el que se realiza un único ensayo (por lo que n sería 1 para dicha distribución binomial). También es un caso especial de la distribución de dos puntos , para la que los resultados posibles no necesitan ser 0 y 1. [2]

Propiedades

Si es una variable aleatoria con distribución de Bernoulli, entonces:

La función de masa de probabilidad de esta distribución, sobre posibles resultados k , es

- [3]

Esto también se puede expresar como

o como

La distribución de Bernoulli es un caso especial de la distribución binomial con [4]

La curtosis tiende al infinito para valores altos y bajos de pero las distribuciones de dos puntos, incluida la distribución de Bernoulli, tienen un exceso de curtosis menor , es decir, −2, que cualquier otra distribución de probabilidad.

Las distribuciones de Bernoulli forman una familia exponencial .

El estimador de máxima verosimilitud de basado en una muestra aleatoria es la media de la muestra .

Significar

El valor esperado de una variable aleatoria de Bernoulli es

Esto se debe al hecho de que para una variable aleatoria distribuida según Bernoulli con y encontramos

- [3]

Diferencia

La varianza de una distribución de Bernoulli es

Primero encontramos

De esto se desprende

- [3]

Con este resultado es fácil demostrar que, para cualquier distribución de Bernoulli, su varianza tendrá un valor dentro de .

Oblicuidad

La asimetría es . Cuando tomamos la variable aleatoria distribuida Bernoulli estandarizada, encontramos que esta variable aleatoria alcanza con probabilidad y alcanza con probabilidad . Por lo tanto, obtenemos

Momentos superiores y cumulantes

Los momentos crudos son todos iguales debido al hecho de que y .

El momento central del orden viene dado por

Los primeros seis momentos centrales son

Los momentos centrales superiores se pueden expresar de forma más compacta en términos de y

Los primeros seis cumulantes son

Entropía e información de Fisher

Entropía

La entropía es una medida de incertidumbre o aleatoriedad en una distribución de probabilidad. Para una variable aleatoria de Bernoulli con probabilidad de éxito y probabilidad de fracaso , la entropía se define como:

La entropía se maximiza cuando , lo que indica el nivel más alto de incertidumbre cuando ambos resultados son igualmente probables. La entropía es cero cuando o , donde un resultado es seguro.

Información de Fisher

La información de Fisher mide la cantidad de información que una variable aleatoria observable contiene sobre un parámetro desconocido del que depende la probabilidad de que ocurra. Para la distribución de Bernoulli, la información de Fisher con respecto al parámetro viene dada por:

Prueba:

- La función de verosimilitud para una variable aleatoria de Bernoulli es:

Esto representa la probabilidad de observar dado el parámetro .

- La función de log-verosimilitud es:

- La función de puntuación (la primera derivada de la verosimilitud logarítmica con respecto a es:

- La segunda derivada de la función de log-verosimilitud es:

- La información de Fisher se calcula como el valor esperado negativo de la segunda derivada de la verosimilitud logarítmica:

Se maximiza cuando , reflejando la máxima incertidumbre y por tanto la máxima información sobre el parámetro .

Distribuciones relacionadas

- Si son variables aleatorias independientes, idénticamente distribuidas ( iid ), todas ellas ensayos de Bernoulli con probabilidad de éxito p , entonces su suma se distribuye según una distribución binomial con parámetros n y p :

- ( distribución binomial ). [3]

- La distribución de Bernoulli es simplemente , también escrita como

- La distribución categórica es la generalización de la distribución de Bernoulli para variables con cualquier número constante de valores discretos.

- La distribución Beta es la distribución conjugada anterior de la distribución de Bernoulli. [5]

- Los modelos de distribución geométrica modelan el número de ensayos de Bernoulli independientes e idénticos necesarios para obtener un éxito.

- Si , entonces tiene una distribución de Rademacher .

Véase también

- Proceso de Bernoulli , un proceso aleatorio que consiste en una secuencia de ensayos de Bernoulli independientes

- Muestreo de Bernoulli

- Función de entropía binaria

- Diagrama de decisión binaria

Referencias

- ^ Uspensky, James Victor (1937). Introducción a la probabilidad matemática . Nueva York: McGraw-Hill. pág. 45. OCLC 996937.

- ^ Dekking, Frederik; Kraaikamp, Cornelis; Lopuhaä, Hendrik; Meester, Ludolf (9 de octubre de 2010). Una introducción moderna a la probabilidad y la estadística (1 ed.). Springer Londres. págs. 43–48. ISBN 9781849969529.

- ^ abcd Bertsekas, Dimitri P. (2002). Introducción a la probabilidad . Tsitsiklis, John N. , Τσιτσικλής, Γιάννης Ν. Belmont, Massachusetts: Athena Scientific. ISBN 188652940X.OCLC 51441829 .

- ^ McCullagh, Peter ; Nelder, John (1989). Modelos lineales generalizados, segunda edición . Boca Raton: Chapman and Hall/CRC. Sección 4.2.2. ISBN 0-412-31760-5.

- ^ Orloff, Jeremy; Bloom, Jonathan. "Prioridades conjugadas: beta y normal" (PDF) . math.mit.edu . Consultado el 20 de octubre de 2023 .

Lectura adicional

- Johnson, NL; Kotz, S.; Kemp, A. (1993). Distribuciones discretas univariadas (2.ª ed.). Wiley. ISBN 0-471-54897-9.

- Peatman, John G. (1963). Introducción a la estadística aplicada . Nueva York: Harper & Row. pp. 162–171.

Enlaces externos

- "Distribución binomial", Enciclopedia de Matemáticas , EMS Press , 2001 [1994].

- Weisstein, Eric W. "Distribución de Bernoulli". MathWorld .

- Gráfico interactivo: Relaciones de distribución univariadas.

![{\displaystyle {\begin{cases}0&{\text{si }}p<1/2\\\left[0,1\right]&{\text{si }}p=1/2\\1&{\text{si }}p>1/2\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/482cc0f5f8c739e3fe2462d72ee5b9f1f7b5d5a4)

![{\displaystyle \nombre del operador {E} [X]=p}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0eb41a45634ab84b13b83cb1488b626aa2129285)

![{\displaystyle \operatorname {E} [X]=\Pr(X=1)\cdot 1+\Pr(X=0)\cdot 0=p\cdot 1+q\cdot 0=p.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5011326253761bfe33bc3d51773a83268b8a56b7)

![{\displaystyle \operatorname {Var} [X]=pq=p(1-p)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2d4e26d8a1fdfb90e91a2fafd5fb3841de88f1fb)

![{\displaystyle \operatorname {E} [X^{2}]=\Pr(X=1)\cdot 1^{2}+\Pr(X=0)\cdot 0^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/789d8c642c8c2a4da18ebe6833b6fdc7b97ce8ab)

![{\displaystyle =p\cdot 1^{2}+q\cdot 0^{2}=p=\nombre del operador {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/22df95375a51f3068718cc64b926e4c8a517dabd)

![{\displaystyle \operatorname {Var} [X]=\operatorname {E} [X^{2}]-\operatorname {E} [X]^{2}=\operatorname {E} [X]-\operatorname { E} [X]^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/78fc67baff72478c2f83e3ce1630b2b9769fc0cc)

![{\estilo de visualización [0,1/4]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/604604d2122dc1c25141a841483b889d6832f261)

![{\displaystyle {\frac {X-\nombre del operador {E} [X]}{\sqrt {\nombre del operador {Var} [X]}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3bdd3a134128b0517590174937df60485f0828d0)

![{\displaystyle {\begin{aligned}\gamma _{1}&=\operadornombre {E} \left[\left({\frac {X-\operadornombre {E} [X]}{\sqrt {\operadornombre {Var} [X]}}}\right)^{3}\right]\\&=p\cdot \left({\frac {q}{\sqrt {pq}}}\right)^{3}+q\cdot \left(-{\frac {p}{\sqrt {pq}}}\right)^{3}\\&={\frac {1}{{\sqrt {pq}}^{3}}}\left(pq^{3}-qp^{3}\right)\\&={\frac {pq}{{\sqrt {pq}}^{3}}}(q^{2}-p^{2})\\&={\frac {(1-p)^{2}-p^{2}}{\sqrt {pq}}}\\&={\frac {1-2p}{\sqrt {pq}}}={\frac {qp}{\sqrt {pq}}}.\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3ad7bf226e1980a4b3ed35773624b3e968d61933)

![{\displaystyle \nombredeloperador {E} [X^{k}]=\Pr(X=1)\cdot 1^{k}+\Pr(X=0)\cdot 0^{k}=p\cdot 1+q\cdot 0=p=\nombredeloperador {E} [X].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cbafd464e73d482dc6c32d1c4f3eaedd5539952)

![{\displaystyle {\begin{aligned}H(X)&=\mathbb {E} _{p}\ln({\frac {1}{P(X)}})=-[P(X=0)\ln P(X=0)+P(X=1)\ln P(X=1)]\\H(X)&=-(q\ln q+p\ln p),\quad q=P(X=0),p=P(X=1)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5639ed087a5db66ec3f0d967cb414d1a7caaa32d)

![{\displaystyle {\begin{aligned}I(p)=-E\left[{\frac {\partial ^{2}}{\partial p^{2}}}\ln L(p;X)\right]=-\left(-{\frac {p}{p^{2}}}-{\frac {1-p}{(1-p)^{2}}}\right)={\frac {1}{p(1-p)}}={\frac {1}{pq}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/930c79a1f00b168593deb05fe32af5d9dcaed143)