Curtosis

En teoría de probabilidad y estadística , la curtosis (del griego κυρτός , kyrtos o kurtos , que significa "curvo, arqueado") se refiere al grado de "cola" en la distribución de probabilidad de una variable aleatoria de valor real . De manera similar a la asimetría , la curtosis proporciona información sobre las características específicas de una distribución. Existen varios métodos para cuantificar la curtosis en distribuciones teóricas, y las técnicas correspondientes permiten la estimación basada en datos de muestra de una población. Es importante señalar que diferentes medidas de curtosis pueden producir diferentes interpretaciones.

La medida estándar de la curtosis de una distribución, que se originó con Karl Pearson , [1] es una versión escalada del cuarto momento de la distribución. Este número está relacionado con las colas de la distribución, no con su pico; [2] por lo tanto, la caracterización que a veces se ve de la curtosis como " pico " es incorrecta. Para esta medida, una curtosis más alta corresponde a una mayor extremidad de las desviaciones (o valores atípicos ), y no a la configuración de los datos cerca de la media .

El exceso de curtosis, que se suele comparar con un valor de 0, caracteriza la "cola" de una distribución. Una distribución normal univariante tiene un exceso de curtosis de 0. Un exceso de curtosis negativo indica una distribución platicúrtica, que no tiene necesariamente una parte superior plana, pero produce menos valores atípicos o valores menos extremos que la distribución normal. Por ejemplo, la distribución uniforme (es decir, una que es uniformemente finita sobre algún límite y cero en el resto) es platicúrtica. Por otro lado, un exceso de curtosis positivo significa una distribución leptocúrtica. La distribución de Laplace , por ejemplo, tiene colas que decaen más lentamente que una gaussiana, lo que da como resultado más valores atípicos. Para simplificar la comparación con la distribución normal, el exceso de curtosis se calcula como la curtosis de Pearson menos 3. Algunos autores y paquetes de software utilizan "curtosis" para referirse específicamente al exceso de curtosis, pero este artículo distingue entre los dos para mayor claridad.

Las medidas alternativas de curtosis son: la L-curtosis , que es una versión escalada del cuarto momento L ; medidas basadas en cuatro cuantiles de población o muestra . [3] Estas son análogas a las medidas alternativas de asimetría que no se basan en momentos ordinarios. [3]

Momentos Pearson

La curtosis es el cuarto momento estandarizado , definido como donde μ 4 es el cuarto momento central y σ es la desviación estándar . En la literatura se utilizan varias letras para denotar la curtosis. Una opción muy común es κ , que está bien siempre que esté claro que no se refiere a un cumulante . Otras opciones incluyen γ 2 , para ser similar a la notación de asimetría, aunque a veces esto se reserva para el exceso de curtosis.

La curtosis está limitada por debajo por la asimetría al cuadrado más 1: [4] : 432 donde μ 3 es el tercer momento central . El límite inferior se realiza mediante la distribución de Bernoulli . No existe un límite superior para la curtosis de una distribución de probabilidad general, y puede ser infinita.

Una razón por la que algunos autores favorecen la curtosis en exceso es que los cumulantes son extensivos . Las fórmulas relacionadas con la propiedad extensiva se expresan de forma más natural en términos de la curtosis en exceso. Por ejemplo, sean X 1 , ..., X n variables aleatorias independientes para las que existe el cuarto momento, y sea Y la variable aleatoria definida por la suma de las X i . La curtosis en exceso de Y es donde es la desviación estándar de . En particular, si todas las X i tienen la misma varianza, entonces esto se simplifica a

La razón para no restar 3 es que el momento desnudo se generaliza mejor a distribuciones multivariadas , especialmente cuando no se supone independencia. La cocurtosis entre pares de variables es un tensor de orden cuatro . Para una distribución normal bivariada, el tensor de cocurtosis tiene términos fuera de la diagonal que no son ni 0 ni 3 en general, por lo que intentar "corregir" un exceso se vuelve confuso. Es cierto, sin embargo, que los cumulantes conjuntos de grado mayor que dos para cualquier distribución normal multivariada son cero.

Para dos variables aleatorias, X e Y , no necesariamente independientes, la curtosis de la suma, X + Y , es Nótese que los coeficientes binomiales de cuarta potencia (1, 4, 6, 4, 1) aparecen en la ecuación anterior.

Interpretación

La interpretación de la medida de Pearson de la curtosis (o exceso de curtosis) alguna vez fue debatida, pero ahora está bien establecida. Como señaló Westfall en 2014 [2] , "... su interpretación inequívoca se relaciona con la extremidad de la cola. Específicamente, refleja la presencia de valores atípicos existentes (para la curtosis de la muestra) o la tendencia a producir valores atípicos (para la curtosis de una distribución de probabilidad). La lógica subyacente es sencilla: la curtosis representa el promedio (o valor esperado ) de datos estandarizados elevado a la cuarta potencia. Los valores estandarizados menores a 1, correspondientes a datos dentro de una desviación estándar de la media (donde ocurre el "pico"), contribuyen mínimamente a la curtosis. Esto se debe a que elevar un número menor a 1 a la cuarta potencia lo acerca a cero. Los contribuyentes significativos a la curtosis son los valores de datos fuera de la región del pico, es decir, los valores atípicos. Por lo tanto, la curtosis mide principalmente los valores atípicos y no proporciona información sobre el "pico" central.

Numerosos conceptos erróneos sobre la curtosis se relacionan con nociones de agudeza. Uno de esos conceptos erróneos es que la curtosis mide tanto la “agudeza” de una distribución como la pesadez de su cola . [5] Otras interpretaciones incorrectas incluyen nociones como “falta de hombros” (donde “hombro” se refiere vagamente al área entre el pico y la cola, o más específicamente, la región alrededor de una desviación estándar de la media) o “bimodalidad”. [6] Balanda y MacGillivray argumentan que la definición estándar de curtosis “capta pobremente la curtosis, la agudeza o el peso de la cola de una distribución”. En cambio, proponen una definición vaga de curtosis como el movimiento libre de ubicación y escala de la masa de probabilidad desde los hombros de la distribución hacia su centro y colas. [5]

La interpretación de los moros

En 1986, Moors dio una interpretación de la curtosis. [7] Sea donde X es una variable aleatoria, μ es la media y σ es la desviación estándar.

Ahora bien, por definición de la curtosis y por la conocida identidad

La curtosis puede verse ahora como una medida de la dispersión de Z 2 alrededor de su expectativa. Alternativamente, puede verse como una medida de la dispersión de Z alrededor de +1 y −1. κ alcanza su valor mínimo en una distribución simétrica de dos puntos. En términos de la variable original X , la curtosis es una medida de la dispersión de X alrededor de los dos valores μ ± σ .

Los valores altos de κ surgen en dos circunstancias:

- donde la masa de probabilidad se concentra alrededor de la media y el proceso de generación de datos produce valores ocasionales alejados de la media

- donde la masa de probabilidad se concentra en las colas de la distribución.

Entropía máxima

La entropía de una distribución es .

Para cualquier distribución de probabilidad con definida positiva, entre todas las distribuciones de probabilidad con media y covarianza , la distribución normal tiene la mayor entropía.

Como la media y la covarianza son los dos primeros momentos, es natural considerar la extensión a momentos superiores. De hecho, mediante el método del multiplicador de Lagrange , para cualesquiera primeros n momentos prescritos, si existe alguna distribución de probabilidad de la forma que tenga los momentos prescritos (si es factible), entonces es la distribución de entropía máxima bajo las restricciones dadas. [8] [9]

Por expansión serial, entonces si una variable aleatoria tiene distribución de probabilidad , donde es una constante de normalización, entonces su curtosis es . [10]

Exceso de curtosis

El exceso de curtosis se define como curtosis menos 3. Hay 3 regímenes distintos, como se describe a continuación.

Mesocúrtico

Las distribuciones con exceso de curtosis cero se denominan mesocúrticas o mesocurtóticas . El ejemplo más destacado de una distribución mesocúrtica es la familia de distribuciones normales, independientemente de los valores de sus parámetros . Algunas otras distribuciones conocidas pueden ser mesocúrticas, dependiendo de los valores de los parámetros: por ejemplo, la distribución binomial es mesocúrtica para .

Leptocúrtico

Una distribución con exceso de curtosis positivo se denomina leptocúrtica o leptocurtósica . "Lepto-" significa "delgada". [11] En términos de forma, una distribución leptocúrtica tiene colas más gruesas . Algunos ejemplos de distribuciones leptocúrticas son la distribución t de Student , la distribución de Rayleigh , la distribución de Laplace , la distribución exponencial , la distribución de Poisson y la distribución logística . A estas distribuciones a veces se las denomina supergaussianas . [12]

Platicúrtico

Una distribución con exceso de curtosis negativo se llama platicúrtica o platicúrtica . "Plati-" significa "ancha". [13] En términos de forma, una distribución platicúrtica tiene colas más delgadas . Ejemplos de distribuciones platicúrticas incluyen las distribuciones uniformes continuas y discretas y la distribución de coseno elevado . La distribución más platicúrtica de todas es la distribución de Bernoulli con p = 1/2 (por ejemplo, el número de veces que se obtiene "cara" al lanzar una moneda una vez, un lanzamiento de moneda ), para la cual el exceso de curtosis es −2.

Ejemplos gráficos

La familia Pearson tipo VII

Los efectos de la curtosis se ilustran utilizando una familia paramétrica de distribuciones cuya curtosis se puede ajustar mientras sus momentos y cumulantes de orden inferior permanecen constantes. Considere la familia Pearson tipo VII , que es un caso especial de la familia Pearson tipo IV restringida a densidades simétricas. La función de densidad de probabilidad está dada por donde a es un parámetro de escala y m es un parámetro de forma .

Todas las densidades de esta familia son simétricas. El k- ésimo momento existe siempre que m > ( k + 1)/2. Para que exista la curtosis, requerimos que m > 5/2. Entonces, la media y la asimetría existen y ambas son idénticamente cero. Al establecer a 2 = 2 m − 3, la varianza es igual a la unidad. Entonces, el único parámetro libre es m , que controla el cuarto momento (y cumulante) y, por lo tanto, la curtosis. Se puede repararmetrizar con , donde es el exceso de curtosis como se definió anteriormente. Esto produce una familia leptocúrtica de un parámetro con media cero, varianza unitaria, asimetría cero y exceso de curtosis arbitrario no negativo. La densidad reparametrizada es

En el límite se obtiene la densidad que se muestra como la curva roja en las imágenes de la derecha.

En la otra dirección se obtiene la densidad normal estándar como distribución límite, que se muestra como la curva negra.

En las imágenes de la derecha, la curva azul representa la densidad con exceso de curtosis de 2. La imagen superior muestra que las densidades leptocúrticas en esta familia tienen un pico más alto que la densidad normal mesocúrtica, aunque esta conclusión solo es válida para esta familia seleccionada de distribuciones. Las colas comparativamente más gruesas de las densidades leptocúrticas se ilustran en la segunda imagen, que traza el logaritmo natural de las densidades de tipo VII de Pearson: la curva negra es el logaritmo de la densidad normal estándar, que es una parábola . Se puede ver que la densidad normal asigna poca masa de probabilidad a las regiones alejadas de la media ("tiene colas delgadas"), en comparación con la curva azul de la densidad leptocúrtica de tipo VII de Pearson con exceso de curtosis de 2. Entre la curva azul y la negra hay otras densidades de tipo VII de Pearson con γ 2 = 1, 1/2, 1/4, 1/8 y 1/16. La curva roja muestra nuevamente el límite superior de la familia de Pearson tipo VII, con (lo que, estrictamente hablando, significa que el cuarto momento no existe). La curva roja disminuye más lentamente a medida que uno se aleja del origen ("tiene colas gruesas").

Otras distribuciones conocidas

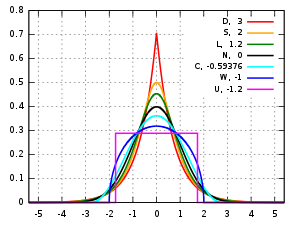

En este artículo se comparan varias distribuciones unimodales y simétricas conocidas de diferentes familias paramétricas. Cada una de ellas tiene una media y una asimetría de cero. Los parámetros se han elegido para que resulten en una varianza igual a 1 en cada caso. Las imágenes de la derecha muestran curvas para las siguientes siete densidades, en una escala lineal y una escala logarítmica :

- D: Distribución de Laplace , también conocida como distribución exponencial doble, curva roja (dos líneas rectas en el gráfico de escala logarítmica), exceso de curtosis = 3

- S: distribución secante hiperbólica , curva naranja, exceso de curtosis = 2

- L: distribución logística , curva verde, exceso de curtosis = 1,2

- N: distribución normal , curva negra (parábola invertida en el gráfico de escala logarítmica), exceso de curtosis = 0

- C: distribución de coseno elevado , curva cian, exceso de curtosis = −0,593762...

- W: distribución de semicírculo de Wigner , curva azul, exceso de curtosis = −1

- U: distribución uniforme , curva magenta (mostrada para mayor claridad como un rectángulo en ambas imágenes), exceso de curtosis = −1,2.

Nótese que en estos casos las densidades platicúrticas tienen soporte acotado , mientras que las densidades con exceso de curtosis positivo o cero están soportadas en toda la línea real .

No se puede inferir que las distribuciones de curtosis alta o baja tengan las características indicadas por estos ejemplos. Existen densidades platicúrticas con soporte infinito,

- p. ej., distribuciones de potencia exponencial con un parámetro de forma b suficientemente grande

y existen densidades leptocúrticas con soporte finito.

- p. ej., una distribución que es uniforme entre −3 y −0,3, entre −0,3 y 0,3, y entre 0,3 y 3, con la misma densidad en los intervalos (−3, −0,3) y (0,3, 3), pero con 20 veces más densidad en el intervalo (−0,3, 0,3)

Además, existen densidades platicúrticas con picos infinitos,

- por ejemplo, una mezcla igual de la distribución beta con parámetros 0,5 y 1 con su reflexión alrededor de 0,0

y existen densidades leptocúrticas que aparecen con la parte superior plana,

- por ejemplo, una mezcla de distribución que es uniforme entre −1 y 1 con una distribución t de Student T(4.0000001) , con probabilidades de mezcla de 0,999 y 0,001.

Curtosis de muestra

Definiciones

Un estimador natural pero sesgado

Para una muestra de n valores, un estimador del método de momentos de la curtosis en exceso de población se puede definir como donde m 4 es el cuarto momento muestral respecto a la media , m 2 es el segundo momento muestral respecto a la media (es decir, la varianza muestral ), x i es el i ésimo valor y es la media muestral .

Esta fórmula tiene una representación más simple, donde los valores son los valores de datos estandarizados que utilizan la desviación estándar definida usando n en lugar de n − 1 en el denominador.

Por ejemplo, supongamos que los valores de los datos son 0, 3, 4, 1, 2, 3, 0, 2, 1, 3, 2, 0, 2, 2, 3, 2, 5, 2, 3, 999.

Entonces los valores son −0,239, −0,225, −0,221, −0,234, −0,230, −0,225, −0,239, −0,230, −0,234, −0,225, −0,230, −0,239, −0,230, −0,230, −0,225, −0,230, −0,216, −0,230, −0,225, 4,359

y los valores son 0,003, 0,003, 0,002, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,002, 0,003, 0,003, 360,976.

El promedio de estos valores es 18,05 y, por lo tanto, el exceso de curtosis es 18,05 − 3 = 15,05. Este ejemplo deja en claro que los datos cerca del "centro" o "pico" de la distribución no contribuyen a la estadística de curtosis, por lo tanto, la curtosis no mide el "pico". Es simplemente una medida del valor atípico, 999 en este ejemplo.

Estimador estándar imparcial

Dado un subconjunto de muestras de una población, el exceso de curtosis de la muestra anterior es un estimador sesgado del exceso de curtosis de la población. Un estimador alternativo del exceso de curtosis de la población, que es insesgado en muestras aleatorias de una distribución normal, se define de la siguiente manera: [3] donde k 4 es el único estimador insesgado simétrico del cuarto cumulante , k 2 es la estimación insesgada del segundo cumulante (idéntica a la estimación insesgada de la varianza de la muestra), m 4 es el cuarto momento de la muestra sobre la media, m 2 es el segundo momento de la muestra sobre la media, x i es el i ésimo valor y es la media de la muestra. Este coeficiente de momento estandarizado de Fisher-Pearson ajustado es la versión que se encuentra en Excel y varios paquetes estadísticos, incluidos Minitab , SAS y SPSS . [14]

Desafortunadamente, en muestras no normales, generalmente está sesgado.

Límite superior

Un límite superior para la curtosis de la muestra de n ( n > 2) números reales es [15] donde es la asimetría de la muestra correspondiente.

Varianza bajo normalidad

La varianza de la curtosis muestral de una muestra de tamaño n de la distribución normal es [16]

Dicho de otra manera, bajo el supuesto de que la variable aleatoria subyacente se distribuye normalmente, se puede demostrar que . [17] : Número de página necesario

Aplicaciones

La curtosis de la muestra es una medida útil para determinar si existe un problema con valores atípicos en un conjunto de datos. Una curtosis mayor indica un problema de valores atípicos más grave y puede llevar al investigador a elegir métodos estadísticos alternativos.

La prueba K-cuadrado de D'Agostino es una prueba de normalidad de bondad de ajuste basada en una combinación de la asimetría y la curtosis de la muestra, al igual que la prueba de Jarque-Bera para la normalidad.

Para las muestras no normales, la varianza de la muestra depende de la curtosis; para obtener más detalles, consulte varianza .

La definición de curtosis de Pearson se utiliza como indicador de intermitencia en la turbulencia . [18] También se utiliza en imágenes por resonancia magnética para cuantificar la difusión no gaussiana. [19]

Un ejemplo concreto es el siguiente lema de He, Zhang y Zhang: [20] Supongamos que una variable aleatoria tiene expectativa , varianza y curtosis. Supongamos que tomamos muestras de muchas copias independientes. Entonces

Esto demuestra que, con muchas muestras, veremos una que esté por encima de lo esperado con una probabilidad de al menos . En otras palabras: si la curtosis es grande, podríamos ver muchos valores, ya sea por debajo o por encima de la media.

Convergencia de curtosis

Al aplicar filtros de paso de banda a imágenes digitales , los valores de curtosis tienden a ser uniformes, independientemente del rango del filtro. Este comportamiento, denominado convergencia de curtosis , se puede utilizar para detectar empalmes de imágenes en análisis forenses . [21]

Análisis de señales sísmicas

La curtosis se puede utilizar en geofísica para distinguir diferentes tipos de señales sísmicas . Es particularmente eficaz para diferenciar las señales sísmicas generadas por pisadas humanas de otras señales. [22] Esto es útil en sistemas de seguridad y vigilancia que dependen de la detección sísmica.

Predicción del tiempo

En meteorología , la curtosis se utiliza para analizar distribuciones de datos meteorológicos. Ayuda a predecir fenómenos meteorológicos extremos evaluando la probabilidad de valores atípicos en datos históricos, [23] lo que resulta valioso para estudios climáticos a largo plazo y pronósticos meteorológicos a corto plazo.

Otras medidas

Se proporciona una medida diferente de "curtosis" utilizando momentos L en lugar de los momentos ordinarios. [24] [25]

Véase también

Referencias

- ^ Pearson, Karl (1905), "Das Fehlergesetz und seine Verallgemeinerungen durch Fechner und Pearson. Una réplica" [La ley del error y sus generalizaciones de Fechner y Pearson. Una réplica], Biometrika , 4 (1–2): 169–212, doi :10.1093/biomet/4.1-2.169, JSTOR 2331536

- ^ ab Westfall, Peter H. (2014), "La curtosis como pico, 1905 - 2014. Descanse en paz ", The American Statistician , 68 (3): 191–195, doi :10.1080/00031305.2014.917055, PMC 4321753 , PMID 25678714

- ^ abc Joanes, Derrick N.; Gill, Christine A. (1998), "Comparación de medidas de asimetría y curtosis de la muestra", Journal of the Royal Statistical Society, Serie D , 47 (1): 183–189, doi :10.1111/1467-9884.00122, JSTOR 2988433

- ^ Pearson, Karl (1916), "Contribuciones matemáticas a la teoría de la evolución. — XIX. Segundo suplemento a una memoria sobre variación sesgada.", Philosophical Transactions of the Royal Society of London A , 216 (546): 429–457, Bibcode :1916RSPTA.216..429P, doi : 10.1098/rsta.1916.0009 , JSTOR 91092

- ^ ab Balanda, Kevin P.; MacGillivray, Helen L. (1988), "Curtosis: una revisión crítica", The American Statistician , 42 (2): 111–119, doi :10.2307/2684482, JSTOR 2684482

- ^ Darlington, Richard B. (1970), "¿Es la curtosis realmente un 'pico'?", The American Statistician , 24 (2): 19-22, doi :10.1080/00031305.1970.10478885, JSTOR 2681925

- ^ Moors, JJA (1986), "El significado de la curtosis: Darlington reexaminado", The American Statistician , 40 (4): 283–284, doi :10.1080/00031305.1986.10475415, JSTOR 2684603

- ^ Tagliani, A. (1990-12-01). "Sobre la existencia de distribuciones de máxima entropía con cuatro o más momentos asignados". Mecánica de ingeniería probabilística . 5 (4): 167–170. Bibcode :1990PEngM...5..167T. doi :10.1016/0266-8920(90)90017-E. ISSN 0266-8920.

- ^ Rockinger, Michael; Jondeau, Eric (1 de enero de 2002). "Densidades de entropía con una aplicación a la asimetría condicional autorregresiva y la curtosis". Journal of Econometrics . 106 (1): 119–142. doi :10.1016/S0304-4076(01)00092-6. ISSN 0304-4076.

- ^ Bradde, Serena; Bialek, William (1 de mayo de 2017). "PCA se encuentra con RG". Revista de Física Estadística . 167 (3): 462–475. arXiv : 1610.09733 . Código Bib : 2017JSP...167..462B. doi :10.1007/s10955-017-1770-6. ISSN 1572-9613. PMC 6054449 . PMID 30034029.

- ^ "Lepto-".

- ^ Benveniste, Albert; Goursat, Maurice; Ruget, Gabriel (1980), "Identificación robusta de un sistema de fase no mínima: ajuste ciego de un ecualizador lineal en comunicaciones de datos", IEEE Transactions on Automatic Control , 25 (3): 385–399, doi :10.1109/tac.1980.1102343

- ^ "platy-: definición, uso y pronunciación - YourDictionary.com". Archivado desde el original el 20 de octubre de 2007.

- ^ Doane DP, Seward LE (2011) J Stat Educ 19 (2)

- ^ Sharma, Rajesh; Bhandari, Rajeev K. (2015), "Asimetría, curtosis y desigualdad de Newton", Rocky Mountain Journal of Mathematics , 45 (5): 1639–1643, arXiv : 1309.2896 , doi :10.1216/RMJ-2015-45-5-1639, S2CID 88513237

- ^ Fisher, Ronald A. (1930), "Los momentos de la distribución para muestras normales de medidas de desviación de la normalidad", Actas de la Royal Society A , 130 (812): 16–28, Bibcode :1930RSPSA.130...16F, doi :10.1098/rspa.1930.0185, hdl : 2440/15205 , JSTOR 95586, S2CID 121520301

- ^ Kendall, Maurice G.; Stuart, Alan (1969), La teoría avanzada de la estadística, volumen 1: teoría de la distribución (3.ª ed.), Londres, Reino Unido: Charles Griffin & Company Limited, ISBN 978-0-822-2-4 0-85264-141-9

- ^ Sandborn, Virgil A. (1959), "Medidas de intermitencia del movimiento turbulento en una capa límite", Journal of Fluid Mechanics , 6 (2): 221–240, Bibcode :1959JFM.....6..221S, doi :10.1017/S0022112059000581, S2CID 121838685

- ^ Jensen, J.; Helpern, J.; Ramani, A.; Lu, H.; Kaczynski, K. (19 de mayo de 2005). "Imágenes de curtosis difusional: la cuantificación de la difusión de agua no gaussiana mediante imágenes por resonancia magnética". Magn Reson Med . 53 (6): 1432–1440. doi :10.1002/mrm.20508. PMID 15906300. S2CID 11865594.

- ^ He, Simai; Zhang, Jiawei; Zhang, Shuzhong (2010). "Probabilidad de limitación de desviación pequeña: un enfoque de cuarto momento". Matemáticas de la investigación de operaciones . 35 (1): 208–232. doi :10.1287/moor.1090.0438. S2CID 11298475.

- ^ Pan, Xunyu; Zhang, Xing; Lyu, Siwei (2012), "Exposición de empalmes de imágenes con variaciones de ruido local inconsistentes", 2012 IEEE International Conference on Computational Photography (ICCP) , 28-29 de abril de 2012; Seattle, WA, EE. UU.: IEEE, págs. 1–10, doi :10.1109/ICCPhot.2012.6215223, ISBN 978-1-4673-1662-0, Número de identificación del sujeto 14386924

{{citation}}: CS1 maint: location (link) - ^ Liang, Zhiqiang; Wei, Jianming; Zhao, Junyu; Liu, Haitao; Li, Baoqing; Shen, Jie; Zheng, Chunlei (2008-08-27). "El significado estadístico de la curtosis y su nueva aplicación a la identificación de personas basada en señales sísmicas". Sensores . 8 (8): 5106–5119. Bibcode :2008Senso...8.5106L. doi : 10.3390/s8085106 . ISSN 1424-8220. PMC 3705491 . PMID 27873804.

- ^ Supraja (27 de mayo de 2024). "La curtosis en la práctica: aplicaciones e interpretaciones en el mundo real". Analytics Insight . Consultado el 11 de noviembre de 2024 .

- ^ Hosking, Jonathan RM (1992), "¿Momentos o momentos L ? Un ejemplo que compara dos medidas de forma distributiva", The American Statistician , 46 (3): 186–189, doi :10.1080/00031305.1992.10475880, JSTOR 2685210

- ^ Hosking, Jonathan RM (2006), "Sobre la caracterización de distribuciones por sus momentos L ", Journal of Statistical Planning and Inference , 136 (1): 193–198, doi :10.1016/j.jspi.2004.06.004

Lectura adicional

- Kim, Tae-Hwan; White, Halbert (2003). "Sobre una estimación más robusta de asimetría y curtosis: simulación y aplicación al índice S&P500". Finance Research Letters . 1 : 56–70. doi :10.1016/S1544-6123(03)00003-5. S2CID 16913409.Fuente alternativa (Comparación de estimadores de curtosis)

- Seier, E.; Bonett, DG (2003). "Dos familias de medidas de curtosis". Métrica . 58 : 59–70. doi :10.1007/s001840200223. S2CID 115990880.

Enlaces externos

- "Coeficiente de exceso", Enciclopedia de Matemáticas , EMS Press , 2001 [1994]

- Calculadora de curtosis

- El software gratuito en línea (calculadora) calcula varios tipos de estadísticas de asimetría y curtosis para cualquier conjunto de datos (incluye pruebas de muestras pequeñas y grandes).

- Curtosis sobre los usos más antiguos conocidos de algunas palabras de las matemáticas

- Celebrando 100 años de Kurtosis una historia del tema, con diferentes medidas de curtosis.

![{\displaystyle \operatorname {Kurt} [X]=\operatorname {E} \left[\left({\frac {X-\mu }{\sigma }}\right)^{4}\right]={\frac {\operatorname {E} \left[(X-\mu )^{4}\right]}{\left(\operatorname {E} \left[(X-\mu )^{2}\right]\right)^{2}}}={\frac {\mu _{4}}{\sigma ^{4}}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/abb6badbf13364972b05d9249962f5ff87aba236)

![{\displaystyle \operatorname {Kurt} [Y]-3={\frac {1}{\left(\sum _{j=1}^{n}\sigma _{j}^{\,2}\right)^{2}}}\sum _{i=1}^{n}\sigma _{i}^{\,4}\cdot \left(\operatorname {Kurt} \left[X_{i}\right]-3\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8f295e334581a6f264d3ca40bf75df3293fb0f3e)

![{\displaystyle \operatorname {Kurt} [Y]-3={1 \sobre n^{2}}\sum _{i=1}^{n}\left(\operatorname {Kurt} \left[X_{i}\right]-3\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6c397ae36f0e23dd0fff0c1137e5dcddc2e9217b)

![{\displaystyle {\begin{aligned}\operatorname {Kurt} [X+Y]={1 \over \sigma _{X+Y}^{4}}{\big (}&\sigma _{X}^{4}\operatorname {Kurt} [X]+4\sigma _{X}^{3}\sigma _{Y}\operatorname {Cokurt} [X,X,X,Y]\\&{}+6\sigma _{X}^{2}\sigma _{Y}^{2}\operatorname {Cokurt} [X,X,Y,Y]\\[6pt]&{}+4\sigma _{X}\sigma _{Y}^{3}\operatorname {Cokurt} [X,Y,Y,Y]+\sigma _{Y}^{4}\operatorname {Kurt} [Y]{\big )}.\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca0a7f4889310fb96ed071c23a6d6af959ef500d)

![{\displaystyle E\left[V^{2}\right]=\operatorname {var} [V]+[E[V]]^{2},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6782f578cb9d22c509a08ab7d43a21735eba1cde)

![{\displaystyle \kappa =E\left[Z^{4}\right]=\operatorname {var} \left[Z^{2}\right]+\left[E\left[Z^{2}\right]\right]^{2}=\operatorname {var} \left[Z^{2}\right]+[\operatorname {var} [Z]]^{2}=\operatorname {var} \left[Z^{2}\right]+1.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c14062cd540b9bba4aa7aac49d5e5a5eccf1718e)

![{\displaystyle {\begin{aligned}&\int {\frac {1}{\sqrt {2\pi }}}e^{-{\frac {1}{2}}x^{2}-{\frac {1}{4}}gx^{4}}x^{2n}\,dx\\[6pt]={}&{\frac {1}{\sqrt {2\pi }}}\int e^{-{\frac {1}{2}}x^{2}-{\frac {1}{4}}gx^{4}}x^{2n}\,dx\\[6pt]={}&\sum _{k}{\frac {1}{k!}}(-g/4)^{k}(2n+4k-1)!!\\[6pt]={}&(2n-1)!!-{\frac {1}{4}}g(2n+3)!!+O(g^{2})\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f7c48b4902dc57596c5d3d22c5642c9b6a7b8847)

![{\displaystyle f(x;a,m)={\frac {\Gamma (m)}{a\,{\sqrt {\pi }}\,\Gamma (m-1/2)}}[1+({\frac {x}{a}})^{2}]^{-m},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/faa28a12d8d7612d4c54447dfabdde07ab6c0c53)

![{\displaystyle g_{2}={\frac {m_{4}}{m_{2}^{2}}}-3={\frac {{\tfrac {1}{n}}\sum _{i=1}^{n}(x_{i}-{\overline {x}})^{4}}{\left[{\tfrac {1}{n}}\sum _{i=1}^{n}(x_{i}-{\overline {x}})^{2}\right]^{2}}}-3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e30ed8db4466ff3e448b71e729464506ddce7770)

![{\displaystyle {\begin{aligned}G_{2}&={\frac {k_{4}}{k_{2}^{2}}}\\[6pt]&={\frac {n^{2}\,[(n+1)\,m_{4}-3\,(n-1)\,m_{2}^{2}]}{(n-1)\,(n-2)\,(n-3)}}\;{\frac {(n-1)^{2}}{n^{2}\,m_{2}^{2}}}\\[6pt]&={\frac {n-1}{(n-2)\,(n-3)}}\left[(n+1)\,{\frac {m_{4}}{m_{2}^{2}}}-3\,(n-1)\right]\\[6pt]&={\frac {n-1}{(n-2)\,(n-3)}}\left[(n+1)\,g_{2}+6\right]\\[6pt]&={\frac {(n+1)\,n\,(n-1)}{(n-2)\,(n-3)}}\;{\frac {\sum _{i=1}^{n}(x_{i}-{\bar {x}})^{4}}{\left(\sum _{i=1}^{n}(x_{i}-{\bar {x}})^{2}\right)^{2}}}-3\,{\frac {(n-1)^{2}}{(n-2)\,(n-3)}}\\[6pt]&={\frac {(n+1)\,n}{(n-1)\,(n-2)\,(n-3)}}\;{\frac {\sum _{i=1}^{n}(x_{i}-{\bar {x}})^{4}}{k_{2}^{2}}}-3\,{\frac {(n-1)^{2}}{(n-2)(n-3)}}\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/51b0b3b5d766ffd8f2c3be0fbe899873b41bb961)

![{\displaystyle E[X]=\mu}](https://wikimedia.org/api/rest_v1/media/math/render/svg/51ed977b56d8e513d9eb92193de5454ac545231e)

![{\displaystyle E\left[(X-\mu )^{2}\right]=\sigma ^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cedd17629b1a84a72ee82ac046028e7628811148)

![{\displaystyle \kappa ={\tfrac {1}{\sigma ^{4}}}E\left[(X-\mu )^{4}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ba57733216b88c28481cf490a6e2f90d0ab83d84)

![{\displaystyle \Pr \left[\max _{i=1}^{n}X_{i}\leq \mu \right]\leq \delta \quad {\text{y}}\quad \Pr \left[\min _{i=1}^{n}X_{i}\geq \mu \right]\leq \delta .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/193e367b4d43bcc0eaae3de498bd2970fd38b98b)