Distribución uniforme continua

Función de densidad de probabilidad  Utilizando la convención máxima | |||

Función de distribución acumulativa  | |||

| Notación | |||

|---|---|---|---|

| Parámetros | |||

| Apoyo | |||

| CDF | |||

| Significar | |||

| Mediana | |||

| Modo | |||

| Diferencia | |||

| ENOJADO | |||

| Oblicuidad | |||

| Exceso de curtosis | |||

| Entropía | |||

| MGF | |||

| CF | |||

En teoría de probabilidad y estadística , las distribuciones uniformes continuas o distribuciones rectangulares son una familia de distribuciones de probabilidad simétricas . Dicha distribución describe un experimento en el que hay un resultado arbitrario que se encuentra entre ciertos límites. [1] Los límites están definidos por los parámetros y que son los valores mínimo y máximo. El intervalo puede ser cerrado (es decir, ) o abierto (es decir, ). [2] Por lo tanto, la distribución a menudo se abrevia donde significa distribución uniforme. [1] La diferencia entre los límites define la longitud del intervalo; todos los intervalos de la misma longitud en el soporte de la distribución son igualmente probables. Es la distribución de probabilidad de entropía máxima para una variable aleatoria sin otra restricción que la de que está contenida en el soporte de la distribución. [3]

Definiciones

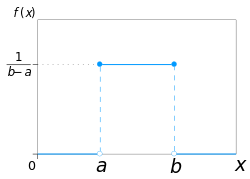

Función de densidad de probabilidad

La función de densidad de probabilidad de la distribución uniforme continua es

Los valores de en los dos límites y normalmente no son importantes, porque no alteran el valor de en ningún intervalo ni de ni de ningún momento superior. A veces se eligen como cero, y a veces como Esto último es apropiado en el contexto de la estimación por el método de máxima verosimilitud . En el contexto del análisis de Fourier , se puede tomar el valor de o como porque entonces la transformada inversa de muchas transformadas integrales de esta función uniforme devolverá la función misma, en lugar de una función que es igual " casi en todas partes ", es decir, excepto en un conjunto de puntos con medida cero . Además, es coherente con la función de signo , que no tiene tal ambigüedad.

Toda función de densidad de probabilidad se integra a , por lo que la función de densidad de probabilidad de la distribución uniforme continua se representa gráficamente como un rectángulo donde es la longitud de la base y es la altura. A medida que aumenta la longitud de la base, la altura (la densidad en cualquier valor particular dentro de los límites de la distribución) disminuye. [4]

En términos de media y varianza, la función de densidad de probabilidad de la distribución uniforme continua es

Función de distribución acumulativa

La función de distribución acumulativa de la distribución uniforme continua es:

Su inversa es:

En términos de media y varianza, la función de distribución acumulativa de la distribución uniforme continua es:

Su inversa es:

Ejemplo 1.Utilizando la función de distribución uniforme continua

Para una variable aleatoria encuentre

En una representación gráfica de la función de distribución uniforme continua , el área bajo la curva dentro de los límites especificados, que muestra la probabilidad, es un rectángulo. Para el ejemplo específico anterior, la base sería y la altura sería [5]

Ejemplo 2.Utilizando la función de distribución uniforme continua (condicional)

Para una variable aleatoria encuentre

El ejemplo anterior es un caso de probabilidad condicional para la distribución uniforme continua: dado que es verdadero, ¿cuál es la probabilidad de que La probabilidad condicional cambie el espacio muestral, por lo que se debe calcular una nueva longitud de intervalo , donde y [5] La representación gráfica seguiría el Ejemplo 1, donde el área bajo la curva dentro de los límites especificados muestra la probabilidad; la base del rectángulo sería y la altura sería [5]

Funciones generadoras

Función generadora de momentos

La función generadora de momentos de la distribución uniforme continua es: [6]

a partir de los cuales podemos calcular los momentos brutos

Para una variable aleatoria que sigue una distribución uniforme continua, el valor esperado es y la varianza es

Para el caso especial, la función de densidad de probabilidad de la distribución uniforme continua es:

La función generadora de momentos se reduce a la forma simple:

Función generadora de cumulantes

Para el -ésimo cumulante de la distribución uniforme continua en el intervalo es donde es el -ésimo número de Bernoulli . [ 7 ]

Distribución uniforme estándar

La distribución uniforme continua con parámetros e ie se denomina distribución uniforme estándar .

Una propiedad interesante de la distribución uniforme estándar es que si tiene una distribución uniforme estándar, entonces también la tiene Esta propiedad se puede utilizar para generar variables antitéticas , entre otras cosas. En otras palabras, esta propiedad se conoce como el método de inversión donde la distribución uniforme estándar continua se puede utilizar para generar números aleatorios para cualquier otra distribución continua. [4] Si es un número aleatorio uniforme con distribución uniforme estándar, es decir con entonces genera un número aleatorio de cualquier distribución continua con la función de distribución acumulativa especificada [4]

Relación con otras funciones

Siempre que se sigan las mismas convenciones en los puntos de transición, la función de densidad de probabilidad de la distribución uniforme continua también puede expresarse en términos de la función de escalón de Heaviside como:

o en términos de la función rectángulo como:

No existe ninguna ambigüedad en el punto de transición de la función de signo . Utilizando la convención de máximo medio en los puntos de transición, la distribución uniforme continua puede expresarse en términos de la función de signo como:

Propiedades

Momentos

La media (primer momento bruto ) de la distribución uniforme continua es:

El segundo momento crudo de esta distribución es:

En general, el momento bruto -ésimo de esta distribución es:

La varianza (segundo momento central ) de esta distribución es:

Estadísticas de pedidos

Sea una muestra iid de y sea la estadística de orden -ésimo de esta muestra.

tiene una distribución beta , con parámetros y

El valor esperado es:

Este hecho es útil al realizar gráficos Q–Q .

La varianza es:

Uniformidad

La probabilidad de que una variable aleatoria distribuida de manera uniforme y continua caiga dentro de cualquier intervalo de longitud fija es independiente de la ubicación del intervalo en sí (pero depende del tamaño del intervalo ), siempre que el intervalo esté contenido en el soporte de la distribución.

De hecho, si y si es un subintervalo de con fijo entonces:

lo cual es independiente de Este hecho motiva el nombre de la distribución.

Distribución uniforme en conjuntos más generales

La distribución uniforme puede generalizarse a conjuntos más generales que los intervalos.

Formalmente, sea un conjunto de Borel de medida de Lebesgue finita y positiva, es decir, La distribución uniforme en se puede especificar definiendo la función de densidad de probabilidad como cero fuera y constantemente igual a en

Un caso especial interesante es cuando el conjunto S es un símplex . Es posible obtener una distribución uniforme en el símplex estándar de n vértices de la siguiente manera. [8] : Teoría 4.1. Tome n variables aleatorias independientes con la misma distribución exponencial ; denotelas por X 1 ,...,X n ; y sea Y i := X i / (suma i X i ). Entonces, el vector Y 1 ,...,Y n está distribuido uniformemente en el símplex.

Distribuciones relacionadas

- Si X tiene una distribución uniforme estándar, entonces, mediante el método de muestreo por transformada inversa , Y = − λ −1 ln( X ) tiene una distribución exponencial con parámetro (de tasa) λ .

- Si X tiene una distribución uniforme estándar, entonces Y = X n tiene una distribución beta con parámetros (1/ n ,1). Por lo tanto,

- La distribución de Irwin-Hall es la suma de n distribuciones i.id U (0,1).

- La distribución de Bates es el promedio de n distribuciones i.id U (0,1).

- La distribución uniforme estándar es un caso especial de la distribución beta , con parámetros (1,1).

- La suma de dos distribuciones uniformes independientes U 1 (a,b)+ U 2 (c,d) produce una distribución trapezoidal , simétrica respecto de su media, sobre el soporte [a+c,b+d]. La meseta tiene un ancho igual a la diferencia absoluta del ancho de U 1 y U 2 . El ancho de las partes inclinadas corresponde al ancho de la distribución uniforme más estrecha.

- Si las distribuciones uniformes tienen el mismo ancho w, el resultado es una distribución triangular , simétrica respecto de su media, sobre el soporte [a+c,a+c+2w].

- La suma de dos distribuciones independientes, uniformes e igualmente distribuidas U 1 (a,b)+ U 2 (a,b) produce una distribución triangular simétrica en el soporte [2a,2b].

- La distancia entre dos variables aleatorias uniformes iid | U 1 (a,b)- U 2 (a,b)| también tiene una distribución triangular , aunque no simétrica, en el soporte [0,ba].

Inferencia estadística

Estimación de parámetros

Estimación del máximo

Estimador imparcial de varianza mínima

Dada una distribución uniforme con valores desconocidos, el estimador insesgado de varianza mínima (UMVUE) para el máximo es:

donde es el máximo de la muestra y es el tamaño de la muestra , muestreo sin reemplazo (aunque esta distinción casi seguramente no hace ninguna diferencia para una distribución continua). Esto se deduce por las mismas razones que la estimación para la distribución discreta , y puede verse como un caso muy simple de estimación de espaciado máximo . Este problema se conoce comúnmente como el problema del tanque alemán , debido a la aplicación de la estimación máxima a las estimaciones de la producción de tanques alemanes durante la Segunda Guerra Mundial .

Método de estimación de momentos

El método del estimador de momentos es:

¿Dónde está la media de la muestra?

Estimador de máxima verosimilitud

El estimador de máxima verosimilitud es:

donde es el máximo de la muestra , también denotado como la estadística de orden máximo de la muestra.

Estimación del mínimo

Dada una distribución uniforme en con a desconocida , el estimador de máxima verosimilitud para a es:

- ,

el mínimo de la muestra . [9]

Estimación del punto medio

El punto medio de la distribución es tanto la media como la mediana de la distribución uniforme. Aunque tanto la media muestral como la mediana muestral son estimadores insesgados del punto medio, ninguno es tan eficiente como el rango medio muestral , es decir, la media aritmética del máximo y el mínimo muestral, que es el estimador UMVU del punto medio (y también la estimación de máxima verosimilitud ).

Intervalo de confianza

Para el máximo

Sea una muestra de donde es el valor máximo en la población. Entonces tiene la densidad de Lebesgue-Borel [10]

- ¿Dónde está la función indicadora de

El intervalo de confianza dado anteriormente es matemáticamente incorrecto, ya que

no se puede resolver sin el conocimiento de . Sin embargo, se puede resolver

- Para cualquier cosa desconocida pero válida.

Luego se elige el intervalo más pequeño posible que cumpla la condición anterior. Nótese que la longitud del intervalo depende de la variable aleatoria.

Ocurrencia y aplicaciones

Las probabilidades de una función de distribución uniforme son fáciles de calcular debido a la simplicidad de la forma de la función. [2] Por lo tanto, existen varias aplicaciones para las que se puede utilizar esta distribución, como se muestra a continuación: situaciones de prueba de hipótesis, casos de muestreo aleatorio, finanzas, etc. Además, generalmente, los experimentos de origen físico siguen una distribución uniforme (por ejemplo, emisión de partículas radiactivas ). [1] Sin embargo, es importante señalar que en cualquier aplicación, existe el supuesto inmutable de que la probabilidad de caer en un intervalo de longitud fija es constante. [2]

Ejemplo económico de distribución uniforme

En el campo de la economía, por lo general la demanda y la reposición pueden no seguir la distribución normal esperada. Como resultado, se utilizan otros modelos de distribución para predecir mejor las probabilidades y tendencias, como el proceso de Bernoulli . [11] Pero según Wanke (2008), en el caso particular de investigar el tiempo de entrega para la gestión de inventario al comienzo del ciclo de vida cuando se analiza un producto completamente nuevo, la distribución uniforme resulta más útil. [11] En esta situación, otra distribución puede no ser viable ya que no hay datos existentes sobre el nuevo producto o que el historial de demanda no está disponible, por lo que realmente no hay una distribución apropiada o conocida. [11] La distribución uniforme sería ideal en esta situación ya que la variable aleatoria del tiempo de entrega (relacionada con la demanda) es desconocida para el nuevo producto, pero es probable que los resultados oscilen entre un rango plausible de dos valores. [11] El tiempo de entrega representaría así la variable aleatoria. A partir del modelo de distribución uniforme, se pudieron calcular otros factores relacionados con el tiempo de entrega, como el nivel de servicio del ciclo y la escasez por ciclo. También se observó que también se utilizó la distribución uniforme debido a la simplicidad de los cálculos. [11]

Muestreo a partir de una distribución arbitraria

La distribución uniforme es útil para el muestreo a partir de distribuciones arbitrarias. Un método general es el método de muestreo por transformada inversa, que utiliza la función de distribución acumulativa (CDF) de la variable aleatoria objetivo. Este método es muy útil en el trabajo teórico. Dado que las simulaciones que utilizan este método requieren invertir la CDF de la variable objetivo, se han ideado métodos alternativos para los casos en los que la CDF no se conoce en forma cerrada. Uno de estos métodos es el muestreo por rechazo .

La distribución normal es un ejemplo importante en el que el método de transformación inversa no es eficiente. Sin embargo, existe un método exacto, la transformación de Box-Muller , que utiliza la transformación inversa para convertir dos variables aleatorias uniformes independientes en dos variables aleatorias independientes distribuidas normalmente .

Error de cuantificación

En la conversión de analógico a digital, se produce un error de cuantificación. Este error se debe a un redondeo o a un truncamiento. Cuando la señal original es mucho mayor que un bit menos significativo (LSB) , el error de cuantificación no está significativamente correlacionado con la señal y tiene una distribución aproximadamente uniforme. Por lo tanto, el error RMS se deriva de la varianza de esta distribución.

Generación de variables aleatorias

Existen muchas aplicaciones en las que resulta útil realizar experimentos de simulación. Muchos lenguajes de programación cuentan con implementaciones para generar números pseudoaleatorios que se distribuyen de manera efectiva de acuerdo con la distribución uniforme estándar.

Por otro lado, los números distribuidos uniformemente se utilizan a menudo como base para la generación de variables aleatorias no uniformes .

Si es un valor muestreado de la distribución uniforme estándar, entonces el valor sigue la distribución uniforme parametrizada por y como se describió anteriormente.

Historia

Si bien los orígenes históricos de la concepción de la distribución uniforme no son concluyentes, se especula que el término "uniforme" surgió del concepto de equiprobabilidad en los juegos de dados (nótese que los juegos de dados tendrían un espacio muestral uniforme discreto y no continuo). La equiprobabilidad fue mencionada en el Liber de Ludo Aleae de Gerolamo Cardano , un manual escrito en el siglo XVI y detallado sobre el cálculo de probabilidad avanzado en relación con los dados. [12]

Véase también

- Distribución uniforme discreta

- Distribución beta

- Transformada de Box-Muller

- Diagrama de probabilidad

- Diagrama Q-Q

- Función rectangular

- Distribución de Irwin-Hall : en el caso degenerado donde n=1, la distribución de Irwin-Hall genera una distribución uniforme entre 0 y 1.

- Distribución de Bates : similar a la distribución de Irwin-Hall, pero reescalada para n. Al igual que la distribución de Irwin-Hall, en el caso degenerado donde n=1, la distribución de Bates genera una distribución uniforme entre 0 y 1.

Referencias

- ^ abc Dekking, Michel (2005). Una introducción moderna a la probabilidad y la estadística: entender por qué y cómo . Londres, Reino Unido: Springer. pp. 60–61. ISBN 978-1-85233-896-1.

- ^ abc Walpole, Ronald; et al. (2012). Probabilidad y estadística para ingenieros y científicos . Boston, EE. UU.: Prentice Hall. págs. 171–172. ISBN 978-0-321-62911-1.

- ^ Park, Sung Y.; Bera, Anil K. (2009). "Modelo de heterocedasticidad condicional autorregresiva de máxima entropía". Journal of Econometrics . 150 (2): 219–230. CiteSeerX 10.1.1.511.9750 . doi :10.1016/j.jeconom.2008.12.014.

- ^ abc «Distribución uniforme (continua)». MathWorks . 2019 . Consultado el 22 de noviembre de 2019 .

- ^ abc Illowsky, Barbara; et al. (2013). Introducción a la estadística. Rice University, Houston, Texas, EE. UU.: OpenStax College. págs. 296–304. ISBN 978-1-938168-20-8.

- ^ Casella y Berger 2001, pág. 626

- ^ Wichura, Michael J. (11 de enero de 2001). «Acumulantes» (PDF) . Folletos de estadísticas 304 . Universidad de Chicago.

- ^ Generación de variables aleatorias no uniformes. doi :10.1007/978-1-4613-8643-8.

- ^

. Dado que tenemos que el factor se maximiza por el mayor posible a , que está limitado en por . Por lo tanto, es el máximo de .

- ^ Nechval KN, Nechval NA, Vasermanis EK, Makeev VY (2002) Construcción de intervalos de confianza de longitud más corta. Transportes y Telecomunicaciones 3 (1) 95-103

- ^ abcde Wanke, Peter (2008). "La distribución uniforme como primer enfoque práctico para la gestión de inventarios de nuevos productos". Revista Internacional de Economía de la Producción . 114 (2): 811–819. doi :10.1016/j.ijpe.2008.04.004 – vía Research Gate.

- ^ Bellhouse, David (mayo de 2005). "Decodificando el Liber de Ludo de Cardano". Historia Matemática . 32 : 180-202. doi : 10.1016/j.hm.2004.04.001 .

Lectura adicional

- Casella, George; Roger L. Berger (2001), Inferencia estadística (2.ª ed.), Thomson Learning, ISBN 978-0-534-24312-8, C.L.C.N. 2001025794

Enlaces externos

- Calculadora en línea de distribución uniforme (continua)

![{\displaystyle {\mathcal {U}}_{[a,b]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/906b38f0905adef68e3c8c7ca6de15858f7742ce)

![{\estilo de visualización [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9c4b788fc5c637e26ee98b45f89a5c08c85f7935)

![{\displaystyle {\begin{cases}{\frac {1}{ba}}&{\text{para }}x\en [a,b]\\0&{\text{en caso contrario}}\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/648692e002b720347c6c981aeec2a8cca7f4182f)

![{\displaystyle {\begin{cases}0&{\text{para }}x<a\\{\frac {xa}{ba}}&{\text{para }}x\in [a,b]\\1&{\text{para }}x>b\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2948c023c98e2478806980eb7f5a03810347a568)

![{\displaystyle f(x)={\begin{cases}{\frac {1}{ba}}&{\text{para }}a\leq x\leq b,\\[8pt]0&{\text{para }}x<a\ {\text{ o }}\ x>b.\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1592bd4a48c6e3defe80032e220d1b4c0ef1e0f5)

![{\estilo de visualización [c,d],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a9d224646c92ef76fbe024ed2eb56cb2964cab95)

![{\displaystyle F(x)={\begin{cases}0&{\text{para }}x<a,\\[8pt]{\frac {xa}{ba}}&{\text{para }}a\leq x\leq b,\\[8pt]1&{\text{para }}x>b.\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/32f8fa14b36ce1147021a210b875bcc4b91d24a3)

![{\displaystyle [f(x){\text{ vs }}x],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d57d12780dd2f37ecebcef1541f0fdccf1d5358e)

![{\displaystyle f(x)={\begin{cases}{\frac {1}{2b}}&{\text{para }}-b\leq x\leq b,\\[8pt]0&{\text{en caso contrario}};\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/528f4cb42767408146084a01d1836f80926a6458)

![{\displaystyle [-{\tfrac {1}{2}},{\tfrac {1}{2}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6cb7c3f1928e147f684b9cba323e45f0840c4ef4)

![{\displaystyle [x,x+\ell ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/884130fbd3c593f4108f325e7ce5f5724e808872)

![{\displaystyle P{\big (}X\in [x,x+\ell ]{\big )}=\int _{x}^{x+\ell }{\frac {dy}{ba}}={\frac {\ell }{ba}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2bf0fab14e4d142e28c428c6f7575ba448bd73d0)

![{\estilo de visualización [0,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ba22e25e8f8604f012c599a7d4962562c4bb3f02)

![{\displaystyle U_{[0,L]},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0e995684064674d2d06963db2a581277bfa0c0e6)

![{\displaystyle f(t)=n{\frac {1}{L}}\left({\frac {t}{L}}\right)^{n-1}\!=n{\frac {t^{n-1}}{L^{n}}}1\!\!1_{[0,L]}(t),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/55bb994d51861c2c29398652df1cf3c2b79caf0a)

![{\displaystyle 1\!\!1_{[0,L]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/79cff43b95a58c16bc9a5d97be265cabd4a635bb)

![{\estilo de visualización [0,L].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/865dd4a189168d3c11e65b12bbb7880568652e1f)

![{\displaystyle \Pr {\big (}[{\hat {\theta }},{\hat {\theta }}+\varepsilon ]\ni \theta {\big )}\geq 1-\alpha }](https://wikimedia.org/api/rest_v1/media/math/render/svg/551b3f94638b0326d17c9d4dca7536f6ceeb3826)

![{\displaystyle \Pr {\big (}[{\hat {\theta }},{\hat {\theta }}(1+\varepsilon )]\ni \theta {\big )}\geq 1-\alpha }](https://wikimedia.org/api/rest_v1/media/math/render/svg/76d99f8778c0be6fce3a7ac95c58b20b2f1a9c0d)

![{\displaystyle L_{n}(a,b)=\prod _{i=1}^{n}f(X_{i})={\frac {1}{(ba)^{n}}}\mathbf {1} _{[a,b]}(X_{1},\puntos ,X_{n})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/964daae30b00147b416f4bfd90cea20f779f5d5d)