Distribución exponencial

Función de densidad de probabilidad  | |||

Función de distribución acumulativa  | |||

| Parámetros | tasa, o escala inversa | ||

|---|---|---|---|

| Apoyo | |||

| CDF | |||

| Cuantil | |||

| Significar | |||

| Mediana | |||

| Modo | |||

| Diferencia | |||

| Oblicuidad | |||

| Exceso de curtosis | |||

| Entropía | |||

| MGF | |||

| CF | |||

| Información de Fisher | |||

| Divergencia de Kullback-Leibler | |||

| Déficit esperado | |||

En teoría de probabilidad y estadística , la distribución exponencial o distribución exponencial negativa es la distribución de probabilidad de la distancia entre eventos en un proceso puntual de Poisson , es decir, un proceso en el que los eventos ocurren de manera continua e independiente a una tasa promedio constante; el parámetro de distancia podría ser cualquier medida unidimensional significativa del proceso, como el tiempo entre errores de producción o la longitud a lo largo de un rollo de tela en el proceso de fabricación de tejidos. [1] Es un caso particular de la distribución gamma . Es el análogo continuo de la distribución geométrica y tiene la propiedad clave de no tener memoria . [2] Además de usarse para el análisis de procesos puntuales de Poisson, se encuentra en varios otros contextos. [3]

La distribución exponencial no es lo mismo que la clase de familias exponenciales de distribuciones. Se trata de una gran clase de distribuciones de probabilidad que incluye la distribución exponencial como uno de sus miembros, pero también incluye muchas otras distribuciones, como la distribución normal , la binomial , la gamma y la de Poisson . [3]

Definiciones

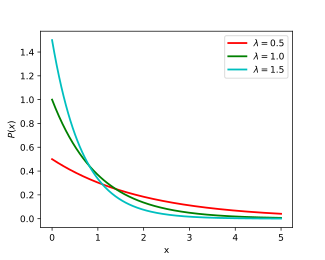

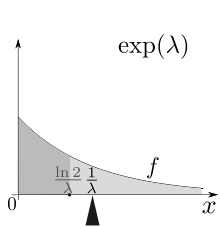

Función de densidad de probabilidad

La función de densidad de probabilidad (pdf) de una distribución exponencial es

Aquí λ > 0 es el parámetro de la distribución, a menudo llamado parámetro de tasa . La distribución se sustenta en el intervalo [0, ∞) . Si una variable aleatoria X tiene esta distribución, escribimos X ~ Exp( λ ) .

La distribución exponencial exhibe divisibilidad infinita .

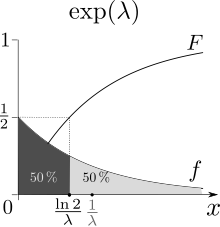

Función de distribución acumulativa

La función de distribución acumulativa está dada por

Parametrización alternativa

La distribución exponencial a veces se parametriza en términos del parámetro de escala β = 1/ λ , que también es la media:

Propiedades

Media, varianza, momentos y mediana

El valor medio o esperado de una variable aleatoria X distribuida exponencialmente con parámetro de tasa λ viene dado por

A la luz de los ejemplos que se dan a continuación, esto tiene sentido: una persona que recibe un promedio de dos llamadas telefónicas por hora puede esperar que el tiempo entre llamadas consecutivas sea de 0,5 horas o 30 minutos.

La varianza de X está dada por lo que la desviación estándar es igual a la media.

Los momentos de X , para están dados por

Los momentos centrales de X , para están dados por donde ! n es el subfactorial de n

La mediana de X está dada por donde ln se refiere al logaritmo natural . Por lo tanto, la diferencia absoluta entre la media y la mediana es

de acuerdo con la desigualdad mediana-media .

Propiedad de falta de memoria de la variable aleatoria exponencial

Una variable aleatoria T distribuida exponencialmente obedece la relación

Esto se puede ver considerando la función de distribución acumulativa complementaria :

Cuando T se interpreta como el tiempo de espera para que ocurra un evento en relación con un tiempo inicial, esta relación implica que, si T está condicionada a la falta de observación del evento durante un período de tiempo inicial s , la distribución del tiempo de espera restante es la misma que la distribución incondicional original. Por ejemplo, si un evento no ha ocurrido después de 30 segundos, la probabilidad condicional de que ocurra tardará al menos 10 segundos más es igual a la probabilidad incondicional de observar el evento más de 10 segundos después del tiempo inicial.

La distribución exponencial y la distribución geométrica son las únicas distribuciones de probabilidad sin memoria .

Cuantiles

La función cuantil (función de distribución acumulativa inversa) para Exp( λ ) es

Los cuartiles son por tanto:

- primer cuartil: ln(4/3)/ λ

- mediana : ln(2)/ λ

- tercer cuartil: ln(4)/ λ

Y como consecuencia el rango intercuartil es ln(3)/ λ .

Valor condicional en riesgo (déficit esperado)

El valor condicional en riesgo (CVaR), también conocido como déficit esperado o supercuantil para Exp( λ ), se deriva de la siguiente manera: [4]

Probabilidad de excedencia amortiguada (bPOE)

La probabilidad amortiguada de excedencia es igual a uno menos el nivel de probabilidad en el que el CVaR es igual al umbral . Se obtiene de la siguiente manera: [4]

Divergencia de Kullback-Leibler

La divergencia dirigida de Kullback-Leibler en nats de (distribución "aproximada") de (distribución "verdadera") está dada por

Distribución de máxima entropía

Entre todas las distribuciones de probabilidad continuas con soporte [0, ∞) y media μ , la distribución exponencial con λ = 1/ μ tiene la entropía diferencial más grande . En otras palabras, es la distribución de probabilidad de entropía máxima para una variable aleatoria X que es mayor o igual a cero y para la cual E[ X ] es fija. [5]

Distribución del mínimo de variables aleatorias exponenciales

Sean X 1 , ..., X n variables aleatorias independientes distribuidas exponencialmente con parámetros de velocidad λ 1 , ..., λ n . Entonces también se distribuye exponencialmente, con parámetro

Esto se puede ver considerando la función de distribución acumulativa complementaria :

El índice de la variable que alcanza el mínimo se distribuye según la distribución categórica

Se puede ver una prueba haciendo . Entonces,

Nótese que no se distribuye exponencialmente, si X 1 , ..., X n no tienen todos parámetro 0. [6]

Momentos conjuntos de estadísticas de orden exponencial iid

Sean variables aleatorias exponenciales independientes e idénticamente distribuidas con parámetro de velocidad λ . Denotemos las estadísticas de orden correspondientes . Para , el momento conjunto de las estadísticas de orden y está dado por

Esto se puede comprobar invocando la ley de la expectativa total y la propiedad de la falta de memoria:

La primera ecuación se desprende de la ley de la expectativa total . La segunda ecuación aprovecha el hecho de que una vez que condicionamos a , debe seguir que . La tercera ecuación se basa en la propiedad sin memoria de reemplazar por .

Suma de dos variables aleatorias exponenciales independientes

La función de distribución de probabilidad (PDF) de una suma de dos variables aleatorias independientes es la convolución de sus PDF individuales . Si y son variables aleatorias exponenciales independientes con respectivos parámetros de tasa y entonces la densidad de probabilidad de está dada por La entropía de esta distribución está disponible en forma cerrada: suponiendo (sin pérdida de generalidad), entonces donde es la constante de Euler-Mascheroni , y es la función digamma . [7]

En el caso de parámetros de velocidad iguales, el resultado es una distribución Erlang con forma 2 y parámetro que a su vez es un caso especial de distribución gamma .

La suma de n variables aleatorias exponenciales independientes Exp( λ) tiene una distribución Gamma(n, λ) .

Distribuciones relacionadas

This section includes a list of general references, but it lacks sufficient corresponding inline citations. (March 2011) |

- Si X ~ Laplace(μ, β −1 ) , entonces | X − µ| ~ Exp(β).

- Si X ~ Pareto(1, λ) , entonces log( X ) ~ Exp(λ).

- Si X ~ SkewLogistic(θ) , entonces .

- Si X i ~ U (0, 1) entonces

- La distribución exponencial es un límite de una distribución beta escalada :

- La distribución exponencial es un caso especial de distribución de Pearson tipo 3 .

- La distribución exponencial es el caso especial de una distribución Gamma con parámetro de forma 1.

- Si X ~ Exp(λ) y X i ~ Exp(λ i ) entonces:

- , cierre bajo escalamiento por un factor positivo.

- 1 + X ~ BenktanderWeibull (λ, 1), que se reduce a una distribución exponencial truncada.

- ke X ~ Pareto ( k , λ).

- e −X ~ Beta (λ, 1).

- 1/a e X ~ Ley de potencia ( k , λ)

- , la distribución de Rayleigh

- , la distribución de Weibull

- μ − β log(λ X ) ∼ Gumbel (μ, β) .

- , una distribución geométrica en 0,1,2,3,...

- , una distribución geométrica en 1,2,3,4,...

- Si además Y ~ Erlang( n , λ) o entonces

- Si también λ ~ Gamma ( k , θ) (forma, parametrización de escala), entonces la distribución marginal de X es Lomax ( k , 1/θ), la mezcla gamma

- λ 1 X 1 − λ 2 Y 2 ~ Laplace(0, 1) .

- mín{ X 1 , ..., X n } ~ Exp(λ 1 + ... + λ n ).

- Si además λ i = λ entonces:

- Si además X i son independientes, entonces:

- ~ Tu (0, 1)

- tiene una función de densidad de probabilidad . Esto se puede utilizar para obtener un intervalo de confianza para .

- Si además λ = 1:

- , la distribución logística

- μ − σ log( X ) ~ GEV(μ, σ, 0) .

- Además, si entonces ( distribución K )

- Si además λ = 1/2 entonces X ∼ χ2

2; es decir, X tiene una distribución de chi-cuadrado con 2 grados de libertad . Por lo tanto:

- Si y ~ Poisson( X ) entonces ( distribución geométrica )

- La distribución de Hoyt se puede obtener a partir de la distribución exponencial y la distribución de arcoseno.

- La distribución exponencial es un límite de la distribución exponencial κ en el caso.

- La distribución exponencial es un límite de la distribución κ-Gamma generalizada en los casos y :

Otras distribuciones relacionadas:

- Distribución hiperexponencial : distribución cuya densidad es una suma ponderada de densidades exponenciales.

- Distribución hipoexponencial : la distribución de una suma general de variables aleatorias exponenciales.

- Distribución exgaussiana : la suma de una distribución exponencial y una distribución normal .

Inferencia estadística

A continuación, supongamos que la variable aleatoria X se distribuye exponencialmente con el parámetro de tasa λ, y son n muestras independientes de X , con media muestral .

Estimación de parámetros

El estimador de máxima verosimilitud para λ se construye de la siguiente manera.

La función de verosimilitud para λ, dada una muestra independiente e idénticamente distribuida x = ( x 1 , ..., x n ) extraída de la variable, es:

donde: es la media de la muestra.

La derivada del logaritmo de la función de verosimilitud es:

En consecuencia, la estimación de máxima verosimilitud para el parámetro de tasa es:

Este no es un estimador imparcial de aunque es un estimador imparcial [9] MLE [10] de y la media de distribución.

El sesgo de es igual a lo que produce el estimador de máxima verosimilitud corregido por sesgo

Se puede encontrar un minimizador aproximado del error cuadrático medio (ver también: equilibrio entre sesgo y varianza ), asumiendo un tamaño de muestra mayor que dos, con un factor de corrección para el error cuadrático medio: Esto se deriva de la media y la varianza de la distribución gamma inversa , . [11]

Información de Fisher

La información de Fisher , denotada , para un estimador del parámetro de tasa se da como:

Conectando la distribución y resolviendo obtenemos:

Esto determina la cantidad de información que cada muestra independiente de una distribución exponencial lleva sobre el parámetro de tasa desconocido .

Intervalos de confianza

Un intervalo de confianza exacto del 100(1 − α)% para el parámetro de tasa de una distribución exponencial viene dado por: [12]

que también es igual a

donde χ2

pág. , vág.es el percentil 100( p ) de la distribución de chi cuadrado con v grados de libertad , n es el número de observaciones y la barra x es el promedio de la muestra. Se puede derivar una aproximación simple a los puntos finales exactos del intervalo utilizando una aproximación normal a χ 2

pág. , vág.distribución. Esta aproximación da los siguientes valores para un intervalo de confianza del 95%:

Esta aproximación puede ser aceptable para muestras que contengan al menos entre 15 y 20 elementos. [13]

Inferencia bayesiana

La distribución conjugada anterior de la distribución exponencial es la distribución gamma (de la cual la distribución exponencial es un caso especial). La siguiente parametrización de la función de densidad de probabilidad gamma resulta útil:

La distribución posterior p puede entonces expresarse en términos de la función de verosimilitud definida anteriormente y una distribución gamma previa:

Ahora se ha especificado la densidad posterior p hasta una constante normalizadora faltante. Dado que tiene la forma de una función de densidad de probabilidad gamma, esto se puede completar fácilmente y se obtiene:

Aquí el hiperparámetro α puede interpretarse como el número de observaciones previas y β como la suma de las observaciones previas. La media posterior aquí es:

Ocurrencia y aplicaciones

Ocurrencia de eventos

La distribución exponencial ocurre naturalmente cuando se describen las longitudes de los tiempos entre llegadas en un proceso de Poisson homogéneo .

La distribución exponencial puede considerarse como una contraparte continua de la distribución geométrica , que describe el número de ensayos de Bernoulli necesarios para que un proceso discreto cambie de estado. Por el contrario, la distribución exponencial describe el tiempo que tarda un proceso continuo en cambiar de estado.

En situaciones del mundo real, el supuesto de una tasa constante (o probabilidad por unidad de tiempo) rara vez se cumple. Por ejemplo, la tasa de llamadas entrantes varía según la hora del día. Pero si nos centramos en un intervalo de tiempo durante el cual la tasa es aproximadamente constante, como de 14 a 16 horas durante los días laborables, la distribución exponencial se puede utilizar como un buen modelo aproximado para el tiempo hasta que llega la siguiente llamada telefónica. Se aplican advertencias similares a los siguientes ejemplos que arrojan variables distribuidas de manera aproximadamente exponencial:

- El tiempo que transcurre hasta que una partícula radiactiva se desintegra , o el tiempo entre los clics de un contador Geiger

- El tiempo entre recibir una llamada telefónica y la siguiente

- El tiempo hasta el impago (en el pago a los tenedores de deuda de la empresa) en el modelo de riesgo crediticio de forma reducida

Las variables exponenciales también se pueden utilizar para modelar situaciones en las que ciertos eventos ocurren con una probabilidad constante por unidad de longitud, como la distancia entre mutaciones en una cadena de ADN o entre animales atropellados en una carretera determinada.

En la teoría de colas , los tiempos de servicio de los agentes en un sistema (por ejemplo, cuánto tarda un cajero de banco, etc., en atender a un cliente) suelen modelarse como variables distribuidas exponencialmente. (La llegada de clientes, por ejemplo, también se modela mediante la distribución de Poisson si las llegadas son independientes y se distribuyen de forma idéntica). La duración de un proceso que puede considerarse como una secuencia de varias tareas independientes sigue la distribución de Erlang (que es la distribución de la suma de varias variables independientes distribuidas exponencialmente). La teoría de la fiabilidad y la ingeniería de la fiabilidad también hacen un uso extensivo de la distribución exponencial. Debido a la propiedad de falta de memoria de esta distribución, es muy adecuada para modelar la parte de tasa de riesgo constante de la curva de la bañera utilizada en la teoría de la fiabilidad. También es muy conveniente porque es muy fácil añadir tasas de fallos en un modelo de fiabilidad. Sin embargo, la distribución exponencial no es adecuada para modelar la vida útil total de organismos o dispositivos técnicos, porque las "tasas de fallos" aquí no son constantes: se producen más fallos en sistemas muy jóvenes y muy antiguos.

En física , si se observa un gas a una temperatura y presión fijas en un campo gravitatorio uniforme , las alturas de las distintas moléculas también siguen una distribución exponencial aproximada, conocida como fórmula barométrica . Esto es una consecuencia de la propiedad de la entropía que se menciona a continuación.

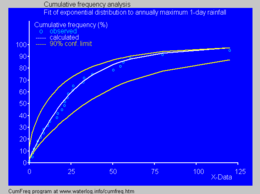

En hidrología , la distribución exponencial se utiliza para analizar valores extremos de variables como los valores máximos mensuales y anuales de las precipitaciones diarias y los volúmenes de descarga de los ríos. [15]

- La imagen azul ilustra un ejemplo de ajuste de la distribución exponencial a las precipitaciones máximas diarias anuales clasificadas, mostrando también el rango de confianza del 90 % basado en la distribución binomial . Los datos de precipitaciones se representan mediante el trazado de posiciones como parte del análisis de frecuencia acumulada .

En la gestión de quirófanos, distribución de la duración de las cirugías para una categoría de cirugías sin un contenido de trabajo típico (como en una sala de urgencias, que abarca todo tipo de cirugías).

Predicción

Tras observar una muestra de n puntos de datos de una distribución exponencial desconocida, una tarea habitual consiste en utilizar estas muestras para hacer predicciones sobre datos futuros de la misma fuente. Una distribución predictiva habitual sobre muestras futuras es la denominada distribución de complemento, que se forma introduciendo una estimación adecuada para el parámetro de tasa λ en la función de densidad exponencial. Una opción habitual de estimación es la proporcionada por el principio de máxima verosimilitud, y su utilización da como resultado la densidad predictiva sobre una muestra futura x n +1 , condicionada a las muestras observadas x = ( x 1 , ..., x n ) dada por

El enfoque bayesiano proporciona una distribución predictiva que tiene en cuenta la incertidumbre del parámetro estimado, aunque esto puede depender fundamentalmente de la elección del valor anterior.

Una distribución predictiva libre de los problemas de elección de valores anteriores que surgen bajo el enfoque bayesiano subjetivo es

que puede considerarse como

- una distribución de confianza frecuentista , obtenida a partir de la distribución de la cantidad fundamental ; [16]

- una probabilidad predictiva de perfil, obtenida eliminando el parámetro λ de la probabilidad conjunta de x n +1 y λ por maximización; [17]

- una distribución posterior predictiva bayesiana objetiva, obtenida utilizando la distribución previa de Jeffreys no informativa 1/ λ ;

- la distribución predictiva de máxima verosimilitud normalizada condicional (CNML), a partir de consideraciones de teoría de la información. [18]

La precisión de una distribución predictiva se puede medir utilizando la distancia o divergencia entre la distribución exponencial verdadera con parámetro de velocidad, λ 0 , y la distribución predictiva basada en la muestra x . La divergencia de Kullback-Leibler es una medida de uso común, libre de parametrización, de la diferencia entre dos distribuciones. Si Δ( λ 0 || p ) denota la divergencia de Kullback-Leibler entre una distribución exponencial con parámetro de velocidad λ 0 y una distribución predictiva p , se puede demostrar que

donde la expectativa se toma con respecto a la distribución exponencial con parámetro de tasa λ 0 ∈ (0, ∞) , y ψ( · ) es la función digamma. Está claro que la distribución predictiva CNML es estrictamente superior a la distribución de complemento de máxima verosimilitud en términos de divergencia promedio de Kullback–Leibler para todos los tamaños de muestra n > 0 .

Generación de variables aleatorias

Un método conceptualmente muy simple para generar variables exponenciales se basa en el muestreo por transformada inversa : dada una variable aleatoria U extraída de la distribución uniforme en el intervalo unitario (0, 1) , la variable

tiene una distribución exponencial, donde F −1 es la función cuantil , definida por

Además, si U es uniforme en (0, 1), entonces también lo es 1 − U . Esto significa que se pueden generar variables exponenciales de la siguiente manera:

Knuth [19] y Devroye [20] analizan otros métodos para generar variables exponenciales .

También está disponible un método rápido para generar un conjunto de variables exponenciales listas para ordenar sin utilizar una rutina de clasificación. [20]

Véase también

- Tiempo muerto : una aplicación de la distribución exponencial al análisis de detectores de partículas.

- Distribución de Laplace , o "distribución exponencial doble".

- Relaciones entre distribuciones de probabilidad

- Distribución exponencial de Marshall-Olkin

Referencias

- ^ "7.2: Distribución exponencial". Statistics LibreTexts . 2021-07-15 . Consultado el 2024-10-11 .

- ^ "Distribución exponencial | Matemáticas | Britannica". www.britannica.com . Consultado el 11 de octubre de 2024 .

- ^ de Weisstein, Eric W. "Distribución exponencial". mathworld.wolfram.com . Consultado el 11 de octubre de 2024 .

- ^ ab Norton, Matthew; Khokhlov, Valentyn; Uryasev, Stan (2019). "Cálculo de CVaR y bPOE para distribuciones de probabilidad comunes con aplicación a la optimización de carteras y estimación de densidad" (PDF) . Anales de investigación de operaciones . 299 (1–2). Springer: 1281–1315. doi :10.1007/s10479-019-03373-1. Archivado desde el original (PDF) el 2023-03-31 . Consultado el 2023-02-27 .

- ^ Park, Sung Y.; Bera, Anil K. (2009). "Modelo de heterocedasticidad condicional autorregresiva de máxima entropía" (PDF) . Journal of Econometrics . 150 (2). Elsevier: 219–230. doi :10.1016/j.jeconom.2008.12.014. Archivado desde el original (PDF) el 2016-03-07 . Consultado el 2011-06-02 .

- ^ Michael, Lugo. «La esperanza del máximo de las exponenciales» (PDF) . Archivado desde el original (PDF) el 20 de diciembre de 2016. Consultado el 13 de diciembre de 2016 .

- ^ Eckford, Andrew W.; Thomas, Peter J. (2016). "Entropía de la suma de dos variables aleatorias exponenciales independientes y no idénticamente distribuidas". arXiv : 1609.02911 [cs.IT].

- ^ Ibe, Oliver C. (2014). Fundamentos de probabilidad aplicada y procesos aleatorios (2.ª ed.). Academic Press. pág. 128. ISBN 9780128010358.

- ^ Richard Arnold Johnson; Dean W. Wichern (2007). Análisis estadístico multivariante aplicado. Pearson Prentice Hall. ISBN 978-0-13-187715-3. Recuperado el 10 de agosto de 2012 .

- ^ Manual electrónico de métodos estadísticos del NIST/SEMATECH

- ^ Elfessi, Abdulaziz; Reineke, David M. (2001). "Una mirada bayesiana a la estimación clásica: la distribución exponencial". Revista de Educación en Estadística . 9 (1). doi : 10.1080/10691898.2001.11910648 .

- ^ Ross, Sheldon M. (2009). Introducción a la probabilidad y la estadística para ingenieros y científicos (4.ª ed.). Associated Press. pág. 267. ISBN 978-0-12-370483-2.

- ^ Guerriero, V. (2012). "Distribución de la ley de potencia: método de estadística inferencial multiescala". Journal of Modern Mathematics Frontier . 1 : 21–28.

- ^ "Cumfreq, un programa informático gratuito para el análisis de frecuencia acumulativa".

- ^ Ritzema, HP, ed. (1994). Análisis de frecuencia y regresión. Capítulo 6 en: Principios y aplicaciones del drenaje, Publicación 16, Instituto Internacional para la Recuperación y Mejora de Tierras (ILRI), Wageningen, Países Bajos. pp. 175–224. ISBN 90-70754-33-9.

- ^ Lawless, JF; Fredette, M. (2005). "Intervalos de predicción frecuentistas y distribuciones predictivas". Biometrika . 92 (3): 529–542. doi :10.1093/biomet/92.3.529.

- ^ Bjornstad, JF (1990). "Probabilidad predictiva: una revisión". Statist. Sci . 5 (2): 242–254. doi : 10.1214/ss/1177012175 .

- ^ DF Schmidt y E. Makalic, "Modelos universales para la distribución exponencial", IEEE Transactions on Information Theory , volumen 55, número 7, págs. 3087-3090, 2009 doi :10.1109/TIT.2009.2018331

- ^ Donald E. Knuth (1998). The Art of Computer Programming , volumen 2: Seminumerical Algorithms , 3.ª ed. Boston: Addison–Wesley. ISBN 0-201-89684-2 . Véase la sección 3.4.1, pág. 133.

- ^ de Luc Devroye (1986). Generación de variables aleatorias no uniformes . Nueva York: Springer-Verlag. ISBN 0-387-96305-7 . Véase el capítulo IX, sección 2, págs. 392-401.

Enlaces externos

- "Distribución exponencial", Enciclopedia de Matemáticas , EMS Press , 2001 [1994]

- Calculadora en línea de distribución exponencial

![{\displaystyle \operatorname {E} [X]={\frac {1}{\lambda }}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9efa3ce3c964c59532609b3d6b8f01ce88f6221)

![{\displaystyle \operatorname {Var} [X]={\frac {1}{\lambda ^{2}}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3c450db5013b1cfdaf5ea71106c9d13834e02d61)

![{\displaystyle \operatorname {E} \left[X^{n}\right]={\frac {n!}{\lambda ^{n}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f5d3a82fbcff5a294e5360fb05b1e5f2166ec09)

![{\displaystyle \operatorname {m} [X]={\frac {\ln(2)}{\lambda }}<\operatorname {E} [X],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7f19becbfbc702d8c33a9698c779384fe3f4dca1)

![{\displaystyle \left|\nombre del operador {E} \left[X\right]-\nombre del operador {m} \left[X\right]\right|={\frac {1-\ln(2)}{\lambda }}<{\frac {1}{\lambda }}=\nombre del operador {\sigma } [X],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e48a50d7c835e2c16f59682fe49712aa41a54d8a)

![{\displaystyle {\begin{aligned}\Pr \left(T>s+t\mid T>s\right)&={\frac {\Pr \left(T>s+t\cap T>s\right)}{\Pr \left(T>s\right)}}\\[4pt]&={\frac {\Pr \left(T>s+t\right)}{\Pr \left(T>s\right)}}\\[4pt]&={\frac {e^{-\lambda (s+t)}}{e^{-\lambda s}}}\\[4pt]&=e^{-\lambda t}\\[4pt]&=\Pr(T>t).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/126da1213459cde98ae372eae857a18183675f5a)

![{\displaystyle {\begin{aligned}{\bar {q}}_{\alpha }(X)&={\frac {1}{1-\alpha }}\int _{\alpha }^{1}q_{p}(X)dp\\&={\frac {1}{(1-\alpha )}}\int _{\alpha }^{1}{\frac {-\ln(1-p)}{\lambda }}dp\\&={\frac {-1}{\lambda (1-\alpha )}}\int _{1-\alpha }^{0}-\ln(y)dy\\&={\frac {-1}{\lambda (1-\alpha )}}\int _{0}^{1-\alpha }\ln(y)dy\\&={\frac {-1}{\lambda (1-\alpha )}}[(1-\alpha )\ln(1-\alpha )-(1-\alpha )]\\&={\frac {-\ln(1-\alpha )+1}{\lambda }}\\\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8cb6c9508565c42978ca1153dc0f6bfd0199a45c)

![{\displaystyle \operatorname {E} \izquierda[X_{(i)}X_{(j)}\derecha]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7d350557a602c2566c092558fff0aefb0049c7c9)

![{\displaystyle {\begin{aligned}\operatorname {E} \left[X_{(i)}X_{(j)}\right]&=\sum _{k=0}^{j-1}{\frac {1}{(nk)\lambda }}\operatorname {E} \left[X_{(i)}\right]+\operatorname {E} \left[X_{(i)}^{2}\right]\\&=\sum _{k=0}^{j-1}{\frac {1}{(nk)\lambda }}\sum _{k=0}^{i-1}{\frac {1}{(nk)\lambda }}+\sum _{k=0}^{i-1}{\frac {1}{((nk)\lambda )^{2}}}+\left(\sum _{k=0}^{i-1}{\frac {1}{(nk)\lambda }}\right)^{2}.\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0135f144a56c4b7565f7faa61cc3abb42afe9c0d)

![{\displaystyle {\begin{aligned}\operatorname {E} \left[X_{(i)}X_{(j)}\right]&=\int _{0}^{\infty }\operatorname {E} \left[X_{(i)}X_{(j)}\mid X_{(i)}=x\right]f_{X_{(i)}}(x)\,dx\\&=\int _{x=0}^{\infty }x\operatorname {E} \left[X_{(j)}\mid X_{(j)}\geq x\right]f_{X_{(i)}}(x)\,dx&&\left({\textrm {ya que}}~X_{(i)}=x\implies X_{(j)}\geq x\right)\\&=\int _{x=0}^{\infty }x\left[\operatorname {E} \left[X_{(j)}\right]+x\right]f_{X_{(i)}}(x)\,dx&&\left({\text{por la propiedad sin memoria}}\right)\\&=\sum _{k=0}^{j-1}{\frac {1}{(nk)\lambda }}\operatorname {E} \left[X_{(i)}\right]+\operatorname {E} \left[X_{(i)}^{2}\right].\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be5949313f3639a86ac81484ac8ca7f4f9edb4d4)

![{\displaystyle \operatorname {E} \left[X_{(j)}\mid X_{(j)}\geq x\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/00169b33907d379235fd4561c63c13d4c51a619a)

![{\displaystyle \operatorname {E} \left[X_{(j)}\right]+x}](https://wikimedia.org/api/rest_v1/media/math/render/svg/775aa6cfd6c5d2b1e4b70ce3108a17f93f7b0224)

![{\displaystyle {\begin{aligned}f_{Z}(z)&=\int _{-\infty }^{\infty }f_{X_{1}}(x_{1})f_{X_{2}}(z-x_{1})\,dx_{1}\\&=\int _{0}^{z}\lambda _{1}e^{-\lambda _{1}x_{1}}\lambda _{2}e^{-\lambda _{2}(z-x_{1})}\,dx_{1}\\&=\lambda _{1}\lambda _{2}e^{-\lambda _{2}z}\int _{0}^{z}e^{(\lambda _{2}-\lambda _{1})x_{1}}\,dx_{1}\\&={\begin{cases}{\dfrac {\lambda _{1}\lambda _{2}}{\lambda _{2}-\lambda _{1}}}\left(e^{-\lambda _{1}z}-e^{-\lambda _{2}z}\right)&{\text{ si }}\lambda _{1}\neq \lambda _{2}\\[4pt]\lambda ^{2}ze^{-\lambda z}&{\text{ si }}\lambda _{1}=\lambda _{2}=\lambda .\end{cases}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c2db15dda49fe8482485a68c9d7c9b1c1d46ee95)

![{\displaystyle {\frac {d}{d\lambda }}\ln L(\lambda )={\frac {d}{d\lambda }}\left(n\ln \lambda -\lambda n{\overline {x}}\right)={\frac {n}{\lambda }}-n{\overline {x}}\ {\begin{cases}>0,&0<\lambda <{\frac {1}{\overline {x}}},\\[8pt]=0,&\lambda ={\frac {1}{\overline {x}}},\\[8pt]<0,&\lambda >{\frac {1}{\overline {x}}}.\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/65ec59bc9ccff1952291621e3eccc741ee1341a2)

![{\displaystyle B\equiv \operatorname {E} \left[\left({\widehat {\lambda }}_{\text{mle}}-\lambda \right)\right]={\frac {\lambda }{n-1}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6df9c9d7b6d1a8ffc31748e7cdf0cc750b442e4)

![{\displaystyle {\mathcal {I}}(\lambda )=\operatorname {E} \left[\left.\left({\frac {\parcial }{\parcial \lambda }}\log f(x;\lambda )\right)^{2}\right|\lambda \right]=\int \left({\frac {\parcial }{\parcial \lambda }}\log f(x;\lambda )\right)^{2}f(x;\lambda )\,dx}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2c70bd835b54bb1b7f344dbf1f04d170bd1d4852)

![{\displaystyle {\begin{aligned}\operatorname {E} _{\lambda _{0}}\left[\Delta (\lambda _{0}\paralelo p_{\rm {ML}})\right]&=\psi (n)+{\frac {1}{n-1}}-\log(n)\\\operatorname {E} _{\lambda _{0}}\left[\Delta (\lambda _{0}\paralelo p_{\rm {CNML}})\right]&=\psi (n)+{\frac {1}{n}}-\log(n)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/02702bfd262096d01f27b67eab961ff7ccb512a9)