Probabilidad condicional

| Parte de una serie sobre estadísticas |

| Teoría de la probabilidad |

|---|

|

|

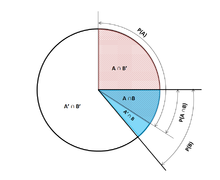

En teoría de la probabilidad , la probabilidad condicional es una medida de la probabilidad de que ocurra un evento , dado que ya se sabe que ocurrió otro evento (por suposición, presunción, afirmación o evidencia). [1] Este método particular se basa en que el evento A ocurre con algún tipo de relación con otro evento B. En esta situación, el evento A puede analizarse mediante una probabilidad condicional con respecto a B. Si el evento de interés es A y se sabe o se supone que ocurrió el evento B , "la probabilidad condicional de A dado B ", o "la probabilidad de A bajo la condición B ", generalmente se escribe como P( A | B ) [2] u ocasionalmente P B ( A ) . Esto también puede entenderse como la fracción de probabilidad B que se cruza con A, o la relación de las probabilidades de que ocurran ambos eventos con respecto al evento "dado" (cuántas veces ocurre A en lugar de no asumir que B ha ocurrido): . [3]

Por ejemplo, la probabilidad de que una persona determinada tenga tos en un día determinado puede ser de tan solo el 5 %. Pero si sabemos o suponemos que la persona está enferma, entonces es mucho más probable que esté tosiendo. Por ejemplo, la probabilidad condicional de que alguien que no se encuentra bien (enfermo) esté tosiendo podría ser del 75 %, en cuyo caso tendríamos que P(Tos) = 5 % y P(Tos|Enfermo) = 75 %. Aunque existe una relación entre A y B en este ejemplo, dicha relación o dependencia entre A y B no es necesaria, ni tienen que ocurrir simultáneamente.

P( A | B ) puede ser o no igual a P( A ) , es decir, la probabilidad incondicional o absoluta de A . Si P( A | B ) = P( A ) , entonces se dice que los eventos A y B son independientes : en tal caso, el conocimiento sobre cualquiera de los eventos no altera la probabilidad de cada uno de ellos. P( A | B ) (la probabilidad condicional de A dado B ) normalmente difiere de P( B | A ) . Por ejemplo, si una persona tiene dengue , podría tener un 90% de posibilidades de que la prueba dé positivo para la enfermedad. En este caso, lo que se está midiendo es que si ha ocurrido el evento B ( tener dengue ), la probabilidad de que A ( dé positivo ) dado que B ocurrió es del 90%, simplemente escribiendo P( A | B ) = 90%. Alternativamente, si una persona da positivo para dengue, puede tener solo un 15% de posibilidades de tener realmente esta rara enfermedad debido a las altas tasas de falsos positivos . En este caso, la probabilidad del evento B ( tener dengue ) dado que el evento A ( dar positivo en la prueba ) ha ocurrido es del 15% o P( B | A ) = 15%. Debería ser evidente ahora que equiparar falsamente las dos probabilidades puede llevar a varios errores de razonamiento, lo que se ve comúnmente a través de falacias de tasa base .

Si bien las probabilidades condicionales pueden brindar información sumamente útil, a menudo se proporciona o se dispone de información limitada. Por lo tanto, puede ser útil invertir o convertir una probabilidad condicional utilizando el teorema de Bayes : . [4] Otra opción es mostrar las probabilidades condicionales en una tabla de probabilidad condicional para ilustrar la relación entre eventos.

Definición

Condicionamiento a un evento

Kolmogorovdefinición

Dados dos eventos A y B del campo sigma de un espacio de probabilidad, con la probabilidad incondicional de B siendo mayor que cero (es decir, P( B ) > 0) , la probabilidad condicional de A dado B ( ) es la probabilidad de que A ocurra si B ha ocurrido o se supone que ha ocurrido. [5] Se supone que A es el conjunto de todos los resultados posibles de un experimento o ensayo aleatorio que tiene un espacio muestral restringido o reducido. La probabilidad condicional se puede encontrar por el cociente de la probabilidad de la intersección conjunta de los eventos A y B , es decir, , la probabilidad en la que A y B ocurren juntos, y la probabilidad de B : [2] [6] [7]

- .

Para un espacio muestral que consta de resultados con la misma probabilidad, la probabilidad del evento A se entiende como la fracción del número de resultados en A respecto del número de todos los resultados en el espacio muestral. Luego, esta ecuación se entiende como la fracción del conjunto respecto del conjunto B. Nótese que la ecuación anterior es una definición, no solo un resultado teórico. Denotamos la cantidad como y la llamamos "probabilidad condicional de A dado B ".

Como axioma de probabilidad

Algunos autores, como de Finetti , prefieren introducir la probabilidad condicional como un axioma de probabilidad :

- .

Esta ecuación para una probabilidad condicional, aunque matemáticamente equivalente, puede ser intuitivamente más fácil de entender. Puede interpretarse como "la probabilidad de que B ocurra multiplicada por la probabilidad de que A ocurra, siempre que B haya ocurrido, es igual a la probabilidad de que A y B ocurran juntas, aunque no necesariamente ocurran al mismo tiempo". Además, esto puede ser preferible filosóficamente; según las principales interpretaciones de probabilidad , como la teoría subjetiva , la probabilidad condicional se considera una entidad primitiva. Además, esta "regla de multiplicación" puede ser prácticamente útil para calcular la probabilidad de e introduce una simetría con el axioma de suma para la fórmula de Poincaré:

- De esta manera, las ecuaciones se pueden combinar para encontrar una nueva representación de:

Como la probabilidad de un evento condicional

La probabilidad condicional se puede definir como la probabilidad de un evento condicional . El evento condicional de Goodman–Nguyen–Van Fraassen se puede definir como:

- , donde y representan estados o elementos de A o B. [8]

Se puede demostrar que

que cumple con la definición de Kolmogorov de probabilidad condicional. [9]

Condicionamiento a un evento de probabilidad cero

Si , entonces según la definición, no está definido .

El caso de mayor interés es el de una variable aleatoria Y , condicionada a que una variable aleatoria continua X dé como resultado un determinado resultado x . El evento tiene probabilidad cero y, como tal, no puede ser condicionado.

En lugar de condicionar que X sea exactamente x , podríamos condicionar que esté más cerca que la distancia de x . El evento generalmente tendrá una probabilidad distinta de cero y, por lo tanto, se puede condicionar. Entonces podemos tomar el límite

| ( 1 ) |

Por ejemplo, si dos variables aleatorias continuas X e Y tienen una densidad conjunta , entonces por la regla de L'Hôpital y la regla integral de Leibniz , al diferenciar con respecto a :

El límite resultante es la distribución de probabilidad condicional de Y dado X y existe cuando el denominador, la densidad de probabilidad , es estrictamente positivo.

Resulta tentador definir la probabilidad indefinida utilizando el límite ( 1 ), pero esto no se puede hacer de manera consistente. En particular, es posible encontrar variables aleatorias X y W y valores x , w tales que los eventos y sean idénticos pero los límites resultantes no lo sean:

La paradoja de Borel-Kolmogorov demuestra esto con un argumento geométrico.

Condicionamiento sobre una variable aleatoria discreta

Sea X una variable aleatoria discreta y sus posibles resultados se denotan por V . Por ejemplo, si X representa el valor de un dado lanzado, entonces V es el conjunto . Supongamos, a modo de ejemplo, que X es una variable aleatoria discreta, de modo que cada valor de V tiene una probabilidad distinta de cero.

Para un valor x en V y un evento A , la probabilidad condicional está dada por . Escribiendo

Para resumir, vemos que es una función de dos variables , x y A.

Para un valor fijo A , podemos formar la variable aleatoria . Representa un resultado de siempre que se observe un valor x de X.

La probabilidad condicional de A dada X puede entonces tratarse como una variable aleatoria Y con resultados en el intervalo . De acuerdo con la ley de probabilidad total , su valor esperado es igual a la probabilidad incondicional de A .

Probabilidad condicional parcial

La probabilidad condicional parcial se refiere a la probabilidad de un evento dado que cada uno de los eventos de la condición ha ocurrido en un grado (grado de creencia, grado de experiencia) que podría ser diferente del 100%. Frecuentemente, la probabilidad condicional parcial tiene sentido si las condiciones se prueban en repeticiones experimentales de una duración apropiada . [10] Dicha probabilidad condicional parcial acotada se puede definir como la ocurrencia promedio condicionalmente esperada del evento en bancos de pruebas de una duración que se adhieran a todas las especificaciones de probabilidad , es decir:

- [10]

En base a esto, la probabilidad condicional parcial se puede definir como

donde [10]

La condicionalización de Jeffrey [11] [12] es un caso especial de probabilidad condicional parcial, en el que los eventos condicionales deben formar una partición :

Ejemplo

Supongamos que alguien lanza en secreto dos dados de seis caras y queremos calcular la probabilidad de que el valor boca arriba del primero sea 2, dada la información de que su suma no es mayor que 5.

Probabilidad de que D 1 = 2

La Tabla 1 muestra el espacio muestral de 36 combinaciones de valores obtenidos de los dos dados, cada una de las cuales ocurre con una probabilidad de 1/36, siendo los números que se muestran en las celdas de color rojo y gris oscuro D 1 + D 2 .

D 1 = 2 en exactamente 6 de los 36 resultados; por lo tanto, P ( D 1 = 2) = 6 ⁄ 36 = 1 ⁄ 6 :

Tabla 1 + D2 1 2 3 4 5 6 D1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Probabilidad de que D 1 + D 2 ≤ 5

La Tabla 2 muestra que D 1 + D 2 ≤ 5 para exactamente 10 de los 36 resultados, por lo tanto P ( D 1 + D 2 ≤ 5) = 10 ⁄ 36 :

Tabla 2 + D2 1 2 3 4 5 6 D1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Probabilidad de que D 1 = 2 dado que D 1 + D 2 ≤ 5

La Tabla 3 muestra que para 3 de estos 10 resultados, D 1 = 2.

Por lo tanto, la probabilidad condicional P( D 1 = 2 | D 1 + D 2 ≤ 5) = 3 ⁄ 10 = 0,3:

Tabla 3 + D2 1 2 3 4 5 6 D1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Aquí, en la notación anterior para la definición de probabilidad condicional, el evento condicionante B es que D 1 + D 2 ≤ 5, y el evento A es D 1 = 2. Tenemos como se ve en la tabla.

Uso en inferencia

En la inferencia estadística , la probabilidad condicional es una actualización de la probabilidad de un evento en función de nueva información. [13] La nueva información se puede incorporar de la siguiente manera: [1]

- Sea A , el evento de interés, en el espacio muestral , digamos ( X , P ).

- La ocurrencia del evento A sabiendo que el evento B ha ocurrido o habrá ocurrido, significa la ocurrencia de A tal como está restringida a B , es decir .

- Sin el conocimiento de la ocurrencia de B , la información sobre la ocurrencia de A sería simplemente P ( A )

- La probabilidad de que A sepa que el evento B ha ocurrido o habrá ocurrido, será la probabilidad relativa a P ( B ), la probabilidad de que B haya ocurrido.

- Esto resulta en siempre que P ( B ) > 0 y 0 en caso contrario.

Este enfoque da como resultado una medida de probabilidad que es coherente con la medida de probabilidad original y satisface todos los axiomas de Kolmogorov . Esta medida de probabilidad condicional también podría haberse obtenido asumiendo que la magnitud relativa de la probabilidad de A con respecto a X se conservará con respecto a B (véase la Derivación Formal a continuación).

La expresión "evidencia" o "información" se utiliza generalmente en la interpretación bayesiana de la probabilidad . El evento condicionante se interpreta como evidencia del evento condicionado. Es decir, P ( A ) es la probabilidad de A antes de tener en cuenta la evidencia E , y P ( A | E ) es la probabilidad de A después de haber tenido en cuenta la evidencia E o después de haber actualizado P ( A ). Esto es coherente con la interpretación frecuentista, que es la primera definición dada anteriormente.

Ejemplo

Cuando se transmite el código Morse , existe una cierta probabilidad de que el "punto" o la "raya" que se recibió sea erróneo. Esto a menudo se considera como una interferencia en la transmisión de un mensaje. Por lo tanto, es importante considerar al enviar un "punto", por ejemplo, la probabilidad de que se haya recibido un "punto". Esto se representa por: En el código Morse, la relación de puntos a rayas es de 3:4 en el momento del envío, por lo que la probabilidad de un "punto" y una "raya" son . Si se supone que la probabilidad de que un punto se transmita como raya es 1/10, y que la probabilidad de que una raya se transmita como punto es igualmente 1/10, entonces se puede utilizar la regla de Bayes para calcular .

Ahora, se puede calcular:

[14]

Independencia estadística

Los eventos A y B se definen como estadísticamente independientes si la probabilidad de la intersección de A y B es igual al producto de las probabilidades de A y B:

Si P ( B ) no es cero, entonces esto es equivalente a la afirmación de que

De manera similar, si P ( A ) no es cero, entonces

también es equivalente. Aunque las formas derivadas pueden parecer más intuitivas, no son la definición preferida ya que las probabilidades condicionales pueden no estar definidas y la definición preferida es simétrica en A y B. La independencia no se refiere a un evento disjunto. [15]

También debe notarse que dado el par de eventos independientes [AB] y un evento C, el par se define como condicionalmente independiente si el producto es verdadero: [16]

Este teorema podría ser útil en aplicaciones donde se observan múltiples eventos independientes.

Eventos independientes vs. eventos mutuamente excluyentes

Los conceptos de eventos mutuamente independientes y eventos mutuamente excluyentes son separados y distintos. La siguiente tabla contrasta los resultados para los dos casos (siempre que la probabilidad del evento condicionante no sea cero).

| Si es estadísticamente independiente | Si son mutuamente excluyentes | |

|---|---|---|

| 0 | ||

| 0 | ||

| 0 |

De hecho, los eventos mutuamente excluyentes no pueden ser estadísticamente independientes (a menos que ambos sean imposibles), ya que saber que uno ocurre da información sobre el otro (en particular, que este último ciertamente no ocurrirá).

Falacias comunes

- Estas falacias no deben confundirse con la "falacia condicional" de Robert K. Shope de 1978, que trata de ejemplos contrafácticos que plantean la pregunta .

Suponiendo que la probabilidad condicional es de tamaño similar a su inversa

En general, no se puede suponer que P ( A | B ) ≈ P ( B | A ). Esto puede ser un error insidioso, incluso para aquellos que están muy familiarizados con las estadísticas. [17] La relación entre P ( A | B ) y P ( B | A ) está dada por el teorema de Bayes :

Es decir, P( A | B ) ≈ P( B | A ) sólo si P ( B )/ P ( A ) ≈ 1, o equivalentemente, P ( A ) ≈ P ( B ).

Suponiendo que las probabilidades marginales y condicionales son de tamaño similar

En general, no se puede suponer que P ( A ) ≈ P ( A | B ). Estas probabilidades están vinculadas a través de la ley de probabilidad total :

donde los eventos forman una partición contable de .

Esta falacia puede surgir a través de un sesgo de selección . [18] Por ejemplo, en el contexto de una reclamación médica, sea S C el evento de que una secuela (enfermedad crónica) S ocurra como consecuencia de la circunstancia (condición aguda) C . Sea H el evento de que un individuo busque ayuda médica. Supongamos que en la mayoría de los casos, C no causa S (de modo que P ( S C ) es baja). Supongamos también que solo se busca atención médica si S ha ocurrido debido a C . Por lo tanto, a partir de la experiencia de los pacientes, un médico puede concluir erróneamente que P ( S C ) es alta. La probabilidad real observada por el médico es P ( S C | H ).

Sobreponderación o subponderación de valores anteriores

No tener en cuenta la probabilidad previa de forma parcial o total se denomina negligencia de la tasa base . Lo inverso, un ajuste insuficiente de la probabilidad previa, es conservadurismo .

Derivación formal

Formalmente, P ( A | B ) se define como la probabilidad de A según una nueva función de probabilidad en el espacio muestral, de modo que los resultados que no están en B tienen probabilidad 0 y que es consistente con todas las medidas de probabilidad originales . [19] [20]

Sea Ω un espacio muestral discreto con eventos elementales { ω }, y sea P la medida de probabilidad con respecto al σ-álgebra de Ω. Supongamos que se nos dice que ha ocurrido el evento B ⊆ Ω. Se debe asignar una nueva distribución de probabilidad (denotada por la notación condicional) a { ω } para reflejar esto. Todos los eventos que no estén en B tendrán probabilidad nula en la nueva distribución. Para los eventos en B , se deben cumplir dos condiciones: la probabilidad de B es uno y se deben conservar las magnitudes relativas de las probabilidades. La primera es requerida por los axiomas de probabilidad , y la segunda surge del hecho de que la nueva medida de probabilidad tiene que ser análoga a P en la que la probabilidad de B es uno - y cada evento que no esté en B , por lo tanto, tiene una probabilidad nula. Por lo tanto, para algún factor de escala α , la nueva distribución debe satisfacer:

Sustituyendo 1 y 2 en 3 para seleccionar α :

Así que la nueva distribución de probabilidad es

Ahora, para un evento general A ,

Véase también

- Teorema de Bayes

- Epistemología bayesiana

- Paradoja de Borel-Kolmogorov

- Regla de la cadena (probabilidad)

- Probabilidades de pertenencia a una clase

- Independencia condicional

- Distribución de probabilidad condicional

- Condicionamiento (probabilidad)

- Teorema de desintegración

- Distribución de probabilidad conjunta

- Problema de Monty Hall

- Distribución independiente por pares

- Probabilidad posterior

- Postselección

- Probabilidad condicional regular

Referencias

- ^ ab Gut, Allan (2013). Probabilidad: un curso de posgrado (segunda edición). Nueva York, NY: Springer. ISBN 978-1-4614-4707-8.

- ^ ab "Probabilidad condicional". www.mathsisfun.com . Consultado el 11 de septiembre de 2020 .

- ^ Dekking, Frederik Michel; Kraaikamp, Cornelis; Lopuhaä, Hendrik Paul; Meester, Ludolf Erwin (2005). "Una introducción moderna a la probabilidad y la estadística". Textos de Springer en estadística : 26. doi : 10.1007/1-84628-168-7. ISBN 978-1-85233-896-1. ISSN 1431-875X.

- ^ Dekking, Frederik Michel; Kraaikamp, Cornelis; Lopuhaä, Hendrik Paul; Meester, Ludolf Erwin (2005). "Una introducción moderna a la probabilidad y la estadística". Textos de Springer en estadística : 25–40. doi :10.1007/1-84628-168-7. ISBN 978-1-85233-896-1. ISSN 1431-875X.

- ^ Reichl, Linda Elizabeth (2016). "2.3 Probabilidad". Un curso moderno de física estadística (4.ª edición revisada y actualizada). WILEY-VCH. ISBN 978-3-527-69049-7.

- ^ Kolmogorov, Andrey (1956), Fundamentos de la teoría de la probabilidad , Chelsea

- ^ "Probabilidad condicional". www.stat.yale.edu . Consultado el 11 de septiembre de 2020 .

- ^ Flaminio, Tommaso; Godo, Lluis; Hosni, Hykel (1 de septiembre de 2020). "Álgebras booleanas de condicionales, probabilidad y lógica". Inteligencia artificial . 286 : 103347. arXiv : 2006.04673 . doi :10.1016/j.artint.2020.103347. ISSN 0004-3702. S2CID 214584872.

- ^ Van Fraassen, Bas C. (1976), Harper, William L.; Hooker, Clifford Alan (eds.), "Probabilidades de condicionales", Fundamentos de la teoría de la probabilidad, inferencia estadística y teorías estadísticas de la ciencia: volumen I Fundamentos y filosofía de las aplicaciones epistémicas de la teoría de la probabilidad , The University of Western Ontario Series in Philosophy of Science, Dordrecht: Springer Netherlands, págs. 261–308, doi :10.1007/978-94-010-1853-1_10, ISBN 978-94-010-1853-1, consultado el 4 de diciembre de 2021

- ^ abc Draheim, Dirk (2017). "Condicionalización generalizada de Jeffrey (una semántica frecuentista de la condicionalización parcial)". Springer . Consultado el 19 de diciembre de 2017 .

- ^ Jeffrey, Richard C. (1983), La lógica de la decisión, 2.ª edición, University of Chicago Press, ISBN 9780226395821

- ^ "Epistemología bayesiana". Stanford Encyclopedia of Philosophy. 2017. Consultado el 29 de diciembre de 2017 .

- ^ Casella, George; Berger, Roger L. (2002). Inferencia estadística . Duxbury Press. ISBN 0-534-24312-6.

- ^ "Probabilidad condicional e independencia" (PDF) . Consultado el 22 de diciembre de 2021 .

- ^ Tijms, Henk (2012). Entendiendo la probabilidad (3.ª ed.). Cambridge: Cambridge University Press. doi :10.1017/cbo9781139206990. ISBN 978-1-107-65856-1.

- ^ Pfeiffer, Paul E. (1978). Independencia condicional en probabilidad aplicada. Boston, MA: Birkhäuser Boston. ISBN 978-1-4612-6335-7.OCLC 858880328 .

- ^ Paulos, JA (1988) Analfabetismo matemático: analfabetismo matemático y sus consecuencias , Hill y Wang. ISBN 0-8090-7447-8 (pág. 63 y siguientes )

- ^ F. Thomas Bruss Der Wyatt-Earp-Effekt oder die betörende Macht kleiner Wahrscheinlichkeiten (en alemán), Spektrum der Wissenschaft (edición alemana de Scientific American), vol 2, 110-113, (2007).

- ^ George Casella y Roger L. Berger (1990), Inferencia estadística , Duxbury Press, ISBN 0-534-11958-1 (p. 18 y siguientes ).

- ^ Introducción a la probabilidad de Grinstead y Snell, pág. 134

Enlaces externos

- Weisstein, Eric W. "Probabilidad condicional". MathWorld .

- Explicación visual de la probabilidad condicional

![{\estilo de visualización [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\displaystyle {\begin{aligned}1&=\sum _{\omega \en \Omega }{P(\omega \mid B)}\\&=\sum _{\omega \en B}{P(\omega \mid B)}+{\cancelto {0}{\sum _{\omega \notin B}P(\omega \mid B)}}\\&=\alpha \sum _{\omega \en B}{P(\omega )}\\[5pt]&=\alpha \cdot P(B)\\[5pt]\Rightarrow \alpha &={\frac {1}{P(B)}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bc21b49c38af5566aeb4794016be9ee06b40458c)

![{\displaystyle {\begin{aligned}P(A\mid B)&=\sum _{\omega \en A\cap B}{P(\omega \mid B)}+{\cancelto {0}{\sum _{\omega \en A\cap B^{c}}P(\omega \mid B)}}\\&=\sum _{\omega \en A\cap B}{\frac {P(\omega )}{P(B)}}\\[5pt]&={\frac {P(A\cap B)}{P(B)}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f6e98f9200e5cf74a15231fc3c753ccfeb8d1c6)