Historia de la teoría cuántica de campos

| Teoría cuántica de campos |

|---|

|

| Historia |

En física de partículas , la historia de la teoría cuántica de campos comienza con su creación por Paul Dirac , cuando intentó cuantificar el campo electromagnético a finales de la década de 1920. Los principales avances en la teoría se produjeron en las décadas de 1940 y 1950, lo que llevó a la introducción de la electrodinámica cuántica renormalizada (EDQ). La teoría de campos detrás de la EQQ fue tan precisa y exitosa en las predicciones que se hicieron esfuerzos para aplicar los mismos conceptos básicos para las otras fuerzas de la naturaleza. A partir de 1954, se encontró el paralelo a través de la teoría de calibre , lo que llevó a finales de la década de 1970 a los modelos de campos cuánticos de fuerza nuclear fuerte y fuerza nuclear débil , unidos en el moderno Modelo Estándar de física de partículas .

Los intentos de describir la gravedad utilizando las mismas técnicas han fracasado hasta la fecha. El estudio de la teoría cuántica de campos sigue floreciendo, al igual que las aplicaciones de sus métodos a muchos problemas físicos. Sigue siendo una de las áreas más vitales de la física teórica en la actualidad, ya que proporciona un lenguaje común a varias ramas diferentes de la física .

Primeros desarrollos

La teoría cuántica de campos surgió en la década de 1920 a partir del problema de crear una teoría mecánico cuántica del campo electromagnético . En particular, de Broglie introdujo en 1924 la idea de una descripción ondulatoria de los sistemas elementales de la siguiente manera: "en este trabajo partimos del supuesto de la existencia de un cierto fenómeno periódico de carácter aún por determinar, que debe atribuirse a cada una de las parcelas de energía aisladas". [1]

En 1925, Werner Heisenberg , Max Born y Pascual Jordan construyeron una teoría de este tipo expresando los grados internos de libertad del campo como un conjunto infinito de osciladores armónicos y luego utilizando el procedimiento de cuantificación canónica para estos osciladores; su artículo se publicó en 1926. [2] [3] [4] Esta teoría suponía que no había cargas o corrientes eléctricas presentes y hoy se llamaría teoría de campo libre .

La primera teoría razonablemente completa de la electrodinámica cuántica , que incluía tanto el campo electromagnético como la materia cargada eléctricamente como objetos mecánicos cuánticos, fue creada por Paul Dirac en 1927. [5] Esta teoría cuántica de campos podría usarse para modelar procesos importantes como la emisión de un fotón por un electrón que cae en un estado cuántico de menor energía, un proceso en el que el número de partículas cambia : un átomo en el estado inicial se convierte en un átomo más un fotón en el estado final. Ahora se entiende que la capacidad de describir tales procesos es una de las características más importantes de la teoría cuántica de campos.

El paso crucial final fue la teoría de la desintegración β de Enrico Fermi (1934). [6] [7] En ella, se demostró que la no conservación de las especies de fermiones se seguía de la segunda cuantificación: la creación y aniquilación de fermiones pasó a primer plano y se vio que la teoría cuántica de campos describía las desintegraciones de partículas. (El avance de Fermi fue algo prefigurado en los estudios abstractos de los físicos soviéticos, Viktor Ambartsumian y Dmitri Ivanenko , en particular la hipótesis de Ambarzumian-Ivanenko de creación de partículas masivas (1930). [8] La idea era que no solo los cuantos del campo electromagnético, los fotones, sino también otras partículas podrían surgir y desaparecer como resultado de su interacción con otras partículas).

Incorporando la relatividad especial

Fue evidente desde el principio que un tratamiento cuántico adecuado del campo electromagnético tenía que incorporar de alguna manera la teoría de la relatividad de Einstein , que había surgido del estudio del electromagnetismo clásico . Esta necesidad de unir la relatividad y la mecánica cuántica fue la segunda motivación principal en el desarrollo de la teoría cuántica de campos. Pascual Jordan y Wolfgang Pauli demostraron en 1928 [9] [10] que los campos cuánticos podían comportarse de la manera predicha por la relatividad especial durante las transformaciones de coordenadas (específicamente, demostraron que los conmutadores de campo eran invariantes de Lorentz ). Un impulso adicional para la teoría cuántica de campos llegó con el descubrimiento de la ecuación de Dirac , que originalmente fue formulada e interpretada como una ecuación de una sola partícula análoga a la ecuación de Schrödinger , pero a diferencia de la ecuación de Schrödinger, la ecuación de Dirac satisface tanto la invariancia de Lorentz, es decir, los requisitos de la relatividad especial, como las reglas de la mecánica cuántica. La ecuación de Dirac acomodó el valor de espín 1/2 del electrón y tuvo en cuenta su momento magnético, además de proporcionar predicciones precisas para los espectros del hidrógeno.

Sin embargo, la interpretación intentada de la ecuación de Dirac como una ecuación de una sola partícula no pudo mantenerse por mucho tiempo, y finalmente se demostró que varias de sus propiedades indeseables (como los estados de energía negativa) podían tener sentido reformulando y reinterpretando la ecuación de Dirac como una verdadera ecuación de campo, en este caso para el "campo de Dirac" cuantizado o el "campo de electrones", con las "soluciones de energía negativa" apuntando a la existencia de antipartículas . Este trabajo fue realizado primero por el propio Dirac con la invención de la teoría de huecos en 1930 y por Wendell Furry , Robert Oppenheimer , Vladimir Fock y otros. Erwin Schrödinger , durante el mismo período en que descubrió su ecuación en 1926, [11] también encontró de forma independiente la generalización relativista de la misma conocida como ecuación de Klein-Gordon, pero la descartó ya que, sin espín , predecía propiedades imposibles para el espectro del hidrógeno. (Véase Oskar Klein y Walter Gordon .) Se dice que todas las ecuaciones de onda relativistas que describen partículas de espín cero son del tipo Klein-Gordon.

Incertidumbre, otra vez

Un análisis sutil y cuidadoso realizado en 1933 por Niels Bohr y Léon Rosenfeld [12] mostró que existe una limitación fundamental en la capacidad de medir simultáneamente las intensidades de los campos eléctrico y magnético que entran en la descripción de las cargas en interacción con la radiación, impuesta por el principio de incertidumbre , que debe aplicarse a todas las cantidades canónicamente conjugadas. Esta limitación es crucial para la formulación e interpretación exitosa de una teoría cuántica de campos de fotones y electrones (electrodinámica cuántica), y de hecho, cualquier teoría cuántica de campos perturbativa . El análisis de Bohr y Rosenfeld explica las fluctuaciones en los valores del campo electromagnético que difieren de los valores clásicamente "permitidos" distantes de las fuentes del campo.

Su análisis fue crucial para demostrar que las limitaciones e implicaciones físicas del principio de incertidumbre se aplican a todos los sistemas dinámicos, ya sean campos o partículas materiales. Su análisis también convenció a la mayoría de los físicos de que cualquier idea de volver a una descripción fundamental de la naturaleza basada en la teoría clásica de campos, como la que Einstein pretendía con sus numerosos y fallidos intentos de una teoría clásica de campos unificados , estaba simplemente fuera de cuestión. Los campos tenían que ser cuantizados .

Segunda cuantificación

El tercer hilo conductor en el desarrollo de la teoría cuántica de campos fue la necesidad de manejar las estadísticas de sistemas de muchas partículas de manera consistente y con facilidad. En 1927, Pascual Jordan intentó extender la cuantificación canónica de campos a las funciones de onda de muchos cuerpos de partículas idénticas [13] [14] usando un formalismo que se conoce como teoría de transformación estadística; [15] este procedimiento ahora se llama a veces segunda cuantificación . [16] [17] A Dirac también se le atribuye la invención, ya que introdujo las ideas clave en un artículo de 1927. [18] [19] En 1928, Jordan y Eugene Wigner descubrieron que el campo cuántico que describe electrones, u otros fermiones , tenía que expandirse usando operadores de creación y aniquilación anticonmutativos debido al principio de exclusión de Pauli (ver transformación de Jordan-Wigner ). Esta línea de desarrollo se incorporó a la teoría de muchos cuerpos e influyó fuertemente en la física de la materia condensada y la física nuclear .

El problema de los infinitos

A pesar de sus primeros éxitos, la teoría cuántica de campos se vio afectada por varias dificultades teóricas serias. Las magnitudes físicas básicas, como la energía propia del electrón o el cambio de energía de los estados del electrón debido a la presencia del campo electromagnético, arrojaban contribuciones infinitas y divergentes (un resultado sin sentido) cuando se calculaban utilizando las técnicas perturbativas disponibles en los años 1930 y la mayor parte de los años 1940. El problema de la energía propia del electrón ya era un problema serio en la teoría clásica de campos electromagnéticos, donde el intento de atribuir al electrón un tamaño o extensión finitos (el radio clásico del electrón) condujo inmediatamente a la cuestión de qué tensiones no electromagnéticas habría que invocar, que presumiblemente mantendrían unido al electrón contra la repulsión de Coulomb de sus "partes" de tamaño finito. La situación era desesperada y tenía ciertas características que recordaban a muchos la " catástrofe de Rayleigh-Jeans ". Sin embargo, lo que hizo que la situación en la década de 1940 fuera tan desesperada y sombría fue el hecho de que los ingredientes correctos (las ecuaciones de campo de Maxwell-Dirac de segunda cuantificación) para la descripción teórica de los fotones y electrones en interacción estaban bien establecidos y no se necesitaba ningún cambio conceptual importante análogo al que era necesario para una explicación finita y físicamente sensata del comportamiento radiativo de los objetos calientes, como lo proporcionaba la ley de radiación de Planck.

Procedimientos de renormalización

Las mejoras en la tecnología de microondas permitieron tomar medidas más precisas del desplazamiento de los niveles de un átomo de hidrógeno , [20] ahora conocido como desplazamiento Lamb y momento magnético del electrón. [21] Estos experimentos expusieron discrepancias que la teoría no podía explicar.

Una primera indicación de una posible salida fue dada por Hans Bethe en 1947, [22] después de asistir a la Conferencia de Shelter Island . [23] Mientras viajaba en tren desde la conferencia a Schenectady, realizó el primer cálculo no relativista del desplazamiento de las líneas del átomo de hidrógeno medido por Lamb y Retherford . [22] A pesar de las limitaciones del cálculo, el acuerdo fue excelente. La idea era simplemente adjuntar infinitos a las correcciones de masa y carga que en realidad estaban fijadas a un valor finito por experimentos. De esta manera, los infinitos se absorben en esas constantes y producen un resultado finito en buen acuerdo con los experimentos. Este procedimiento se denominó renormalización .

Este "problema de divergencia" fue resuelto en el caso de la electrodinámica cuántica a través del procedimiento conocido como renormalización en 1947-49 por Hans Kramers , [24] Hans Bethe , [25] Julian Schwinger , [26] [27] [28] [29] Richard Feynman , [30] [31] [32] y Shin'ichiro Tomonaga ; [33] [34] [35] [36] [37] [38] [39] el procedimiento fue sistematizado por Freeman Dyson en 1949. [40] Se lograron grandes avances después de darse cuenta de que todos los infinitos en la electrodinámica cuántica están relacionados con dos efectos: la autoenergía del electrón/positrón y la polarización del vacío.

La renormalización exige prestar mucha atención a lo que se quiere decir, por ejemplo, con los conceptos de "carga" y "masa" tal como aparecen en las ecuaciones de campo puras, sin interacción. El "vacío" es en sí mismo polarizable y, por lo tanto, está poblado por pares de partículas virtuales ( en la capa y fuera de ella ), y, por lo tanto, es un sistema dinámico en ebullición y actividad por derecho propio. Éste fue un paso crítico para identificar la fuente de los "infinitos" y las "divergencias". La "masa desnuda" y la "carga desnuda" de una partícula, los valores que aparecen en las ecuaciones de campo libre (caso sin interacción), son abstracciones que simplemente no se realizan en el experimento (en interacción). Lo que medimos, y por lo tanto, lo que debemos tener en cuenta con nuestras ecuaciones, y lo que las soluciones deben tener en cuenta, son la "masa renormalizada" y la "carga renormalizada" de una partícula. Es decir, los valores "desplazados" o "vestidos" que deben tener estas cantidades cuando se toma el debido cuidado sistemático para incluir todas las desviaciones de sus "valores desnudos" están dictados por la naturaleza misma de los campos cuánticos.

Electrodinámica cuántica

El primer enfoque que dio sus frutos se conoce como la "representación de interacción" (véase el artículo Imagen de interacción ), una generalización covariante de Lorentz e invariante de calibración de la teoría de perturbaciones dependiente del tiempo utilizada en la mecánica cuántica ordinaria, y desarrollada por Tomonaga y Schwinger, generalizando esfuerzos anteriores de Dirac, Fock y Boris Podolsky . Tomonaga y Schwinger inventaron un esquema covariante relativista para representar conmutadores de campo y operadores de campo intermedios entre las dos representaciones principales de un sistema cuántico, las representaciones de Schrödinger y de Heisenberg. Dentro de este esquema, los conmutadores de campo en puntos separados pueden evaluarse en términos de operadores de creación y aniquilación de campo "desnudos". Esto permite realizar un seguimiento de la evolución temporal de los valores "desnudos" y "renormalizados", o perturbados, del hamiltoniano y expresa todo en términos de ecuaciones de campo "desnudas" acopladas e invariantes de calibración. Schwinger dio la formulación más elegante de este enfoque. El siguiente desarrollo se debió a Richard Feynman , con sus reglas para asignar un gráfico a los términos de la matriz de dispersión (ver matriz S y diagramas de Feynman ). Estas se correspondían directamente (a través de la ecuación de Schwinger-Dyson ) con los procesos físicos mensurables (secciones transversales, amplitudes de probabilidad, anchos de desintegración y tiempos de vida de los estados excitados) que uno necesita poder calcular. Esto revolucionó la forma en que se llevan a cabo los cálculos de la teoría cuántica de campos en la práctica.

Dos libros de texto clásicos de la década de 1960, James D. Bjorken , Sidney David Drell , Relativistic Quantum Mechanics (1964) y JJ Sakurai , Advanced Quantum Mechanics (1967), desarrollaron a fondo las técnicas de expansión de grafos de Feynman utilizando métodos físicamente intuitivos y prácticos que se derivaban del principio de correspondencia , sin preocuparse por los tecnicismos involucrados en la derivación de las reglas de Feynman a partir de la superestructura de la teoría cuántica de campos en sí. Aunque tanto el estilo heurístico y pictórico de Feynman para tratar los infinitos, como los métodos formales de Tomonaga y Schwinger, funcionaron extremadamente bien y dieron respuestas espectacularmente precisas, la verdadera naturaleza analítica de la cuestión de la "renormalizabilidad", es decir, si CUALQUIER teoría formulada como una "teoría cuántica de campos" daría respuestas finitas, no se resolvió hasta mucho más tarde, cuando la urgencia de tratar de formular teorías finitas para las interacciones fuerte y electrodébil (y gravitacional) exigió su solución.

La renormalización en el caso de la electrodinámica cuántica fue en gran medida fortuita debido a la pequeñez de la constante de acoplamiento, el hecho de que el acoplamiento no tiene dimensiones que involucren masa, la llamada constante de estructura fina , y también la masa cero del bosón de calibración involucrado, el fotón, hizo que el comportamiento de pequeña distancia/alta energía de la electrodinámica cuántica fuera manejable. Además, los procesos electromagnéticos son muy "limpios" en el sentido de que no están muy suprimidos/amortiguados y/o ocultos por las otras interacciones de calibración. En 1965, James D. Bjorken y Sidney David Drell observaron: "La electrodinámica cuántica (EQ) ha alcanzado un estado de coexistencia pacífica con sus divergencias...". [41]

La unificación de la fuerza electromagnética con la fuerza débil tropezó con dificultades iniciales debido a la falta de energías de aceleración lo suficientemente altas como para revelar procesos más allá del rango de interacción de Fermi . Además, se tuvo que desarrollar una comprensión teórica satisfactoria de la subestructura de los hadrones, que culminó en el modelo de quarks .

Gracias a los métodos tempranos, un tanto bruscos, ad hoc y heurísticos de Feynman, y a los métodos abstractos de Tomonaga y Schwinger, elegantemente sintetizados por Freeman Dyson , del período de la renormalización temprana, se ha establecido la teoría moderna de la electrodinámica cuántica (EDQ). Sigue siendo la teoría física más precisa conocida, el prototipo de una teoría cuántica de campos exitosa. La electrodinámica cuántica es un ejemplo de lo que se conoce como teoría de gauge abeliana . Se basa en el grupo de simetría U (1) y tiene un campo de gauge sin masa, la simetría de gauge U (1), que dicta la forma de las interacciones que involucran al campo electromagnético, siendo el fotón el bosón de gauge.

Teoría de Yang-Mills

En la década de 1950, Yang y Mills , siguiendo el liderazgo previo de Hermann Weyl , exploraron el impacto de las simetrías e invariancias en la teoría de campos. Todas las teorías de campos, incluida la QED, se generalizaron a una clase de teorías cuánticas de campos conocidas como teorías de calibre . El hecho de que las simetrías dicten, limiten y requieran la forma de interacción entre partículas es la esencia de la "revolución de la teoría de calibre". Yang y Mills formularon el primer ejemplo explícito de una teoría de calibre no abeliana, la teoría de Yang-Mills , con un intento de explicación de las interacciones fuertes en mente. A mediados de la década de 1950, se entendió (incorrectamente) que las interacciones fuertes estaban mediadas por los mesones pi, las partículas predichas por Hideki Yukawa en 1935, [42] basándose en sus profundas reflexiones sobre la conexión recíproca entre la masa de cualquier partícula mediadora de fuerza y el rango de la fuerza que media. Esto fue permitido por el principio de incertidumbre . En ausencia de información dinámica, Murray Gell-Mann fue pionero en la extracción de predicciones físicas a partir de consideraciones de simetría no abeliana pura, e introdujo los grupos de Lie no abelianos en el álgebra actual y, por lo tanto, en las teorías de calibre que la reemplazaron.

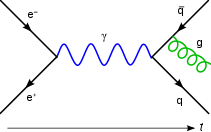

En los años 1960 y 1970 se formuló una teoría de calibración conocida hoy como el Modelo Estándar de la física de partículas , que describe sistemáticamente las partículas elementales y las interacciones entre ellas. Las interacciones fuertes se describen mediante cromodinámica cuántica (QCD), basada en la SU de "color" (3). Las interacciones débiles requieren la característica adicional de la ruptura espontánea de la simetría , dilucidada por Yoichiro Nambu y el mecanismo adjunto de Higgs , que se considera a continuación.

Unificación electrodébil

La parte de interacción electrodébil del Modelo Estándar fue formulada por Sheldon Glashow , Abdus Salam y John Clive Ward en 1959, [43] [44] con su descubrimiento de la estructura de grupo SU(2)xU(1) de la teoría. En 1967, Steven Weinberg invocó el mecanismo de Higgs para la generación de las masas W y Z [45] (los bosones vectoriales intermedios responsables de las interacciones débiles y las corrientes neutras) y mantener la masa del fotón en cero. La idea de Goldstone y Higgs para generar masa en las teorías de gauge surgió a finales de los años 1950 y principios de los 1960, cuando varios teóricos (entre ellos Yoichiro Nambu , Steven Weinberg , Jeffrey Goldstone , François Englert , Robert Brout , GS Guralnik , CR Hagen , Tom Kibble y Philip Warren Anderson ) notaron una analogía posiblemente útil con la ruptura (espontánea) de la simetría U(1) del electromagnetismo en la formación del estado fundamental BCS de un superconductor. El bosón de gauge involucrado en esta situación, el fotón, se comporta como si hubiera adquirido una masa finita.

Existe otra posibilidad de que el vacío físico (estado fundamental) no respete las simetrías implicadas por el lagrangiano electrodébil "ininterrumpido" a partir del cual se llega a las ecuaciones de campo (véase el artículo Interacción electrodébil para más detalles). Gerardus 't Hooft y Martinus Veltman demostraron que la teoría electrodébil de Weinberg y Salam era renormalizable (finita) y, por lo tanto, consistente . La teoría de Glashow–Weinberg–Salam (teoría GWS), en ciertas aplicaciones, ofrece una precisión equivalente a la de la electrodinámica cuántica.

Cromodinámica cuántica

En el caso de las interacciones fuertes, el progreso en relación con su comportamiento a corta distancia y alta energía fue mucho más lento y frustrante. En el caso de las interacciones fuertes con los campos electrodébiles, hubo problemas difíciles relacionados con la fuerza del acoplamiento, la generación de masa de los portadores de fuerza, así como sus interacciones no lineales y propias. Aunque ha habido un progreso teórico hacia una gran teoría unificada de campos cuánticos que incorpora la fuerza electromagnética, la fuerza débil y la fuerza fuerte, la verificación empírica aún está pendiente. La superunificación , que incorpora la fuerza gravitacional, todavía es muy especulativa y está siendo investigada intensivamente por muchas de las mejores mentes de la física teórica contemporánea. La gravitación es una descripción del campo tensorial de un bosón de calibre de espín 2, el " gravitón ", y se analiza más a fondo en los artículos sobre la relatividad general y la gravedad cuántica .

Gravedad cuántica

Desde el punto de vista de las técnicas de la teoría cuántica de campos (cuatro dimensiones), y como lo atestiguan los numerosos esfuerzos por formular una teoría de gravedad cuántica consistente, la cuantificación gravitacional ha sido la campeona reinante del mal comportamiento. [46]

Existen problemas técnicos subyacentes debido a que la constante de gravitación newtoniana tiene dimensiones que involucran potencias inversas de la masa y, como consecuencia simple, está plagada de autointeracciones no lineales que se comportan de manera perturbativa deficiente. La gravedad es en sí misma una fuente de gravedad, análogamente a las teorías de calibración (cuyos acoplamientos, por el contrario, son adimensionales), lo que conduce a divergencias incontrolables en órdenes crecientes de teoría de perturbaciones.

Además, la gravedad se acopla a toda la energía con la misma fuerza, según el principio de equivalencia , lo que hace que la noción de realmente "apagar", "cortar" o separar la interacción gravitacional de otras interacciones sea ambigua, ya que, con la gravitación, estamos tratando con la estructura misma del espacio-tiempo.

Además, no se ha establecido que sea necesaria una teoría de la gravedad cuántica (véase Teoría cuántica de campos en el espacio-tiempo curvo ).

Marco contemporáneo de la renormalización

Los avances paralelos en la comprensión de las transiciones de fase en la física de la materia condensada condujeron a nuevos conocimientos basados en el grupo de renormalización . Implicaron el trabajo de Leo Kadanoff (1966) [47] y Kenneth Geddes Wilson - Michael Fisher (1972) [48] —que amplió el trabajo de Ernst Stueckelberg - André Petermann (1953) [49] y Murray Gell-Mann - Francis Low (1954) [50] —que condujo a la reformulación seminal de la teoría cuántica de campos por Kenneth Geddes Wilson en 1975. [51] Esta reformulación proporcionó conocimientos sobre la evolución de las teorías de campo efectivas con escala, que clasificaron todas las teorías de campo, renormalizables o no. La notable conclusión es que, en general, la mayoría de los observables son "irrelevantes", es decir, la física macroscópica está dominada por solo unos pocos observables en la mayoría de los sistemas.

Durante el mismo período, Leo Kadanoff (1969) [52] introdujo un formalismo de álgebra de operadores para el modelo de Ising bidimensional , un modelo matemático ampliamente estudiado del ferromagnetismo en física estadística . Este desarrollo sugirió que la teoría cuántica de campos describe su límite de escala . Más tarde, se desarrolló la idea de que un número finito de operadores generadores podría representar todas las funciones de correlación del modelo de Ising. La existencia de una simetría mucho más fuerte para el límite de escala de los sistemas críticos bidimensionales fue sugerida por Alexander Belavin , Alexander Markovich Polyakov y Alexander Zamolodchikov en 1984, lo que finalmente condujo al desarrollo de la teoría de campos conforme , [53] [54] un caso especial de la teoría cuántica de campos, que actualmente se utiliza en diferentes áreas de la física de partículas y la física de la materia condensada.

El grupo de renormalización abarca un conjunto de ideas y métodos para monitorear los cambios en el comportamiento de la teoría con escala, proporcionando una comprensión física profunda que provocó lo que se ha llamado la "gran síntesis" de la física teórica, uniendo las técnicas teóricas de campos cuánticos utilizadas en la física de partículas y la física de la materia condensada en un único y poderoso marco teórico.

La teoría del campo de calibración de las interacciones fuertes , la cromodinámica cuántica , se basa fundamentalmente en este grupo de renormalización por sus características distintivas: la libertad asintótica y el confinamiento del color .

Véase también

Referencias

- ^ De Broglie, Luis (1925). "Investigaciones sobre la teoría de los cuantos". Annales de Physique (en francés). 10 (3). Traducido por AF Kracklauer. Ciencias EDP: 22–128. Código bibliográfico : 1925AnPh...10...22D. doi :10.1051/anphys/192510030022. ISSN 0003-4169.

- ^ Todorov, Ivan (2012). "La cuantificación es un misterio". Revista búlgara de física . 39 (2): 107–149. arXiv : 1206.3116 .

- ^ Nacido, M.; Heisenberg, W.; Jordania, P. (1926). "Zur Quantenmechanik II". Zeitschrift für Physik . 35 (8–9): 557–615. Código bibliográfico : 1926ZPhy...35..557B. doi :10.1007/BF01379806. S2CID 186237037.El artículo fue recibido el 16 de noviembre de 1925. [Traducción al inglés en: van Der Waerden, Bartel Leendert (1 de enero de 1968). "15 "Sobre la mecánica cuántica II""Fuentes de la mecánica cuántica. Publicaciones de Dover. ISBN 978-0-486-61881-4.

- ^ Este artículo fue precedido por uno anterior de Born y Jordan publicado en 1925. ( Born, M.; Jordan, P. (1925). "Zur Quantenmechanik". Zeitschrift für Physik . 34 (1): 858. Bibcode : 1925ZPhy ...34..858B : 10.1007/ BF01328531 . 186114542.)

- ^ Dirac, PAM (1 de febrero de 1927). "La teoría cuántica de la emisión y absorción de la radiación". Actas de la Royal Society A: Ciencias matemáticas, físicas y de ingeniería . 114 (767). La Royal Society: 243–265. Bibcode :1927RSPSA.114..243D. doi : 10.1098/rspa.1927.0039 . ISSN 1364-5021.

- ^ Ning Yang, Chen (2012). "Teoría de la desintegración β de Fermi" (PDF) . Asia Pac. Phys. Newslett . 1 : 27. doi :10.1142/S2251158X12000045.

- ^ Fermi, E (1934). "Versuch einer Theorie der Strahlen". Z. Física . 88 (3–4): 161–77. Código Bib : 1934ZPhy...88..161F. doi :10.1007/BF01351864.

- ^ Ambarzumjan, WA; Iwanenko, DD (1930). "Eine quantentheoretische Bemerkung zur einheitlichen Feldtheorie". Doklady URSS Acad. Ciencia . 3 : 45–49.

- ^ Jordania, P.; Pauli, W. (1928). "Zur Quantenelektrodynamik ladungsfreier Felder". Zeitschrift für Physik (en alemán). 47 (3–4). Springer Science y Business Media LLC: 151–173. Código bibliográfico : 1928ZPhy...47..151J. doi :10.1007/bf02055793. ISSN 1434-6001. S2CID 120536476.

- ^ Jagdish Mehra , Helmut Rechenberg , La interpretación de la probabilidad y la teoría de la transformación estadística, la interpretación física y los fundamentos empíricos y matemáticos de la mecánica cuántica 1926-1932 , Springer, 2000, pág. 199.

- ^ Schrödinger, E. (1926). "Quantisierung als Eigenwertproblem; von Erwin Schrödinger". Annalen der Physik . 384 (4): 361–77. Código bibliográfico : 1926AnP...384..361S. doi : 10.1002/andp.19263840404 .

- ^ Bohr, Niels; Rosenfeld, León (1933). "Zur frage der messbarkeit der electromagnetischen feldgrossen". KGL. Danske Videnskabernes Selskab Mat.-Fys. Med . . 12 :8.

- ^ Jordania, P. (1927). "Über eine neue Begründung der Quantenmechanik". Zeitschrift für Physik (en alemán). 40 (11-12). Springer Science y Business Media LLC: 809–838. Código bibliográfico : 1927ZPhy...40..809J. doi :10.1007/bf01390903. ISSN 1434-6001. S2CID 121258722.

- ^ Jordania, P. (1927). "Über eine neue Begründung der Quantenmechanik. II". Zeitschrift für Physik (en alemán). 44 (1–2). Springer Science and Business Media LLC: 1–25. Código bibliográfico : 1927ZPhy...44....1J. doi :10.1007/bf01391714. ISSN 1434-6001. S2CID 186228140.

- ^ Don Howard, "Mecánica cuántica en contexto: Anschauliche Quantentheorie de 1936 de Pascual Jordan".

- ^ Daniel Greenberger, Klaus Hentschel, Friedel Weinert (eds.), Compendio de física cuántica: conceptos, experimentos, historia y filosofía , Springer, 2009: "Cuantización (primera, segunda)".

- ^ Arthur I. Miller, Electrodinámica cuántica temprana: un libro de consulta , Cambridge University Press, 1995, pág. 18.

- ^ Dirac, Paul Adrien Maurice (1927). "La teoría cuántica de la emisión y absorción de la radiación". Actas de la Royal Society de Londres. Serie A, que contiene artículos de carácter matemático y físico . 114 (767): 243–265. Bibcode :1927RSPSA.114..243D. doi : 10.1098/rspa.1927.0039 .

- ^ Duck, Ian; Sudarshan, ECG (1998). "Capítulo 6: La invención de la teoría cuántica de campos por parte de Dirac". Pauli y el teorema de la estadística de espín. World Scientific Publishing. págs. 149–167. ISBN 978-9810231149.

- ^ Lamb, Willis ; Retherford, Robert (1947). "Estructura fina del átomo de hidrógeno mediante un método de microondas". Physical Review . 72 (3): 241–43. Bibcode :1947PhRv...72..241L. doi : 10.1103/PhysRev.72.241 .

- ^ Foley, HM ; Kusch, P. (1948). "Sobre el momento intrínseco del electrón". Physical Review . 73 (3): 412. Bibcode :1948PhRv...73..412F. doi :10.1103/PhysRev.73.412.

- ^ ab H. Bethe (1947). "El cambio electromagnético de los niveles de energía". Physical Review . 72 (4): 339–41. Bibcode :1947PhRv...72..339B. doi :10.1103/PhysRev.72.339. S2CID 120434909.

- ^ Schweber, Silvan (1994). "Capítulo 5". QED y los hombres que lo hicieron: Dyson, Feynman, Schwinger y Tomonaga . Princeton University Press. pág. 230. ISBN 978-0-691-03327-3.

- ↑ Kramers presentó su trabajo en la Conferencia de Shelter Island de 1947 , que se repitió en 1948 en la Conferencia Solvay . Esta última no apareció impresa hasta las Actas de la Conferencia Solvay, publicadas en 1950 (véase Laurie M. Brown (ed.), Renormalization: From Lorentz to Landau (and Beyond) , Springer, 2012, p. 53). El enfoque de Kramers no era relativista (véase Jagdish Mehra , Helmut Rechenberg, The Conceptual Completion and Extensions of Quantum Mechanics 1932-1941. Epilogue: Aspects of the Further Development of Quantum Theory 1942-1999: Volume 6, Part 2 , Springer, 2001, p. 1050).

- ^ H. Bethe (1947). "El cambio electromagnético de los niveles de energía". Physical Review . 72 (4): 339–41. Bibcode :1947PhRv...72..339B. doi :10.1103/PhysRev.72.339. S2CID 120434909.

- ^ Schwinger, Julian (15 de febrero de 1948). "Sobre la electrodinámica cuántica y el momento magnético del electrón". Physical Review . 73 (4). American Physical Society (APS): 416–417. Bibcode :1948PhRv...73..416S. doi : 10.1103/physrev.73.416 . ISSN 0031-899X.

- ^ Schwinger, Julian (15 de noviembre de 1948). "Electrodinámica cuántica. I. Una formulación covariante". Physical Review . 74 (10). American Physical Society (APS): 1439–1461. Bibcode :1948PhRv...74.1439S. doi :10.1103/physrev.74.1439. ISSN 0031-899X.

- ^ Schwinger, Julian (15 de febrero de 1949). "Electrodinámica cuántica. II. Polarización del vacío y autoenergía". Physical Review . 75 (4). American Physical Society (APS): 651–679. Bibcode :1949PhRv...75..651S. doi :10.1103/physrev.75.651. ISSN 0031-899X.

- ^ Schwinger, Julian (15 de septiembre de 1949). "Electrodinámica cuántica. III. Las propiedades electromagnéticas del electrón: correcciones radiativas a la dispersión". Physical Review . 76 (6). American Physical Society (APS): 790–817. Bibcode :1949PhRv...76..790S. doi :10.1103/physrev.76.790. ISSN 0031-899X.

- ^ Feynman, Richard P. (1948). "Aproximación espacio-temporal a la mecánica cuántica no relativista" (PDF) . Reseñas de Física Moderna . 20 (2): 367–387. Bibcode :1948RvMP...20..367F. doi :10.1103/RevModPhys.20.367.

- ^ Feynman, Richard P. (1948). "Un límite relativista para la electrodinámica clásica" (PDF) . Physical Review . 74 (8): 939–946. Bibcode :1948PhRv...74..939F. doi :10.1103/PhysRev.74.939.

- ^ Feynman, Richard P. (1948). "Un límite relativista para la electrodinámica cuántica" (PDF) . Physical Review . 74 (10): 1430–38. Bibcode :1948PhRv...74.1430F. doi :10.1103/PhysRev.74.1430.

- ^ Tomonaga, S. (1 de julio de 1946). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas*". Progreso de la física teórica . 1 (2). Oxford University Press (OUP): 27–42. Bibcode :1946PThPh...1...27T. doi : 10.1143/ptp.1.27 . ISSN 1347-4081.

- ^ Koba, Z.; Tati, T.; Tomonaga, S.-i. (1 de septiembre de 1947). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas. II: caso de campos electromagnéticos y electrónicos en interacción". Progreso de la física teórica . 2 (3). Oxford University Press (OUP): 101–116. Bibcode :1947PThPh...2..101K. doi : 10.1143/ptp/2.3.101 . ISSN 0033-068X.

- ^ Koba, Z.; Tati, T.; Tomonaga, S.-i. (1 de noviembre de 1947). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas. III: Caso de campos electromagnéticos y electrónicos en interacción". Progreso de la física teórica . 2 (4). Oxford University Press (OUP): 198–208. Bibcode :1947PThPh...2..198K. doi : 10.1143/ptp/2.4.198 . ISSN 0033-068X.

- ^ Kanesawa, S.; Tomonaga, S.-i. (1 de febrero de 1948). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas. IV: Caso de campos electromagnéticos y mesónicos en interacción". Progreso de la física teórica . 3 (1). Oxford University Press (OUP): 1–13. doi : 10.1143/ptp/3.1.1 . ISSN 0033-068X.

- ^ Kanesawa, S.; Tomonaga, S.-i. (1 de mayo de 1948). "Sobre una formulación relativistamente invariante de la teoría cuántica de campos de ondas V: caso de campos electromagnéticos y mesónicos en interacción". Progreso de la física teórica . 3 (2). Oxford University Press (OUP): 101–113. Bibcode :1948PThPh...3..101K. doi : 10.1143/ptp/3.2.101 . ISSN 0033-068X.

- ^ Koba, Z.; Tomonaga, S.-i. (1 de agosto de 1948). "Sobre las reacciones de radiación en los procesos de colisión. I: Aplicación del método de sustracción "autoconsistente" a la dispersión elástica de un electrón". Progreso de la física teórica . 3 (3). Oxford University Press (OUP): 290–303. Bibcode :1948PThPh...3..290K. doi :10.1143/ptp/3.3.290. ISSN 0033-068X.

- ^ Tomonaga, Sin-Itiro; Oppenheimer, JR (15 de julio de 1948). "Sobre reacciones de campo infinito en la teoría cuántica de campos". Physical Review . 74 (2). American Physical Society (APS): 224–225. Bibcode :1948PhRv...74..224T. doi :10.1103/physrev.74.224. ISSN 0031-899X.

- ^ FJ Dyson (1949). "Las teorías de la radiación de Tomonaga, Schwinger y Feynman". Phys. Rev . 75 (3): 486–502. Bibcode :1949PhRv...75..486D. doi : 10.1103/PhysRev.75.486 .

- ^ James D. Bjorken y Sidney David Drell, Campos cuánticos relativistas , McGraw-Hill, 1965, pág. 85.

- ^ H. Yukawa (1935). "Sobre la interacción de partículas elementales" (PDF) . Proc. Phys.-Math. Soc. Jpn . 17 (48).

- ^ Glashow, Sheldon L. (1959). "La renormalizabilidad de las interacciones de mesones vectoriales". Física nuclear . 10 . Elsevier BV: 107–117. Código Bibliográfico :1959NucPh..10..107G. doi :10.1016/0029-5582(59)90196-8. ISSN 0029-5582.

- ^ Salam, A. ; Ward, JC (1959). "Interacciones débiles y electromagnéticas". Nuovo Cimento . 11 (4): 568–577. Bibcode :1959NCim...11..568S. doi :10.1007/BF02726525.

- ^ Weinberg, S (1967). "Un modelo de leptones" (PDF) . Phys. Rev. Lett . 19 (21): 1264–66. Código Bibliográfico :1967PhRvL..19.1264W. doi :10.1103/PhysRevLett.19.1264. Archivado desde el original (PDF) el 12 de enero de 2012.

- ^ Brian Hatfield, Fernando Morinigo, Richard P. Feynman, William Wagner (2002) "Conferencias de Feynman sobre la gravitación", ISBN 978-0-8133-4038-8

- ^ Kadanoff, Leo P. (1 de mayo de 1966). "Leyes de escala para modelos de Ising cerca de Tc". Física Física . 2 (6). American Physical Society (APS): 263–272. doi : 10.1103/physicsphysiquefizika.2.263 . ISSN 0554-128X.

- ^ Wilson, Kenneth G.; Fisher, Michael E. (24 de enero de 1972). "Exponentes críticos en 3,99 dimensiones". Physical Review Letters . 28 (4). American Physical Society (APS): 240–243. Código Bibliográfico :1972PhRvL..28..240W. doi :10.1103/physrevlett.28.240. ISSN 0031-9007.

- ^ Stueckelberg, ECG; Petermann, A. (1953). "La renormalización de las constantes en la teoría de cuantos". Helv. Física. Acta . 26 : 499–520.

- ^ Gell-Mann, M. ; Low, FE (1954). "Electrodinámica cuántica a pequeñas distancias" (PDF) . Physical Review . 95 (5): 1300–12. Código Bibliográfico :1954PhRv...95.1300G. doi :10.1103/PhysRev.95.1300.

- ^ Wilson, K. (1975). "El grupo de renormalización: fenómenos críticos y el problema de Kondo". Reseñas de Física Moderna . 47 (4): 773. Bibcode :1975RvMP...47..773W. doi :10.1103/RevModPhys.47.773.

- ^ Kadanoff, Leo P. (22 de diciembre de 1969). "Álgebra de operadores y determinación de índices críticos". Physical Review Letters . 23 (25). American Physical Society (APS): 1430–1433. Código Bibliográfico :1969PhRvL..23.1430K. doi :10.1103/physrevlett.23.1430. ISSN 0031-9007.

- ^ Belavin AA ; Polyakov AM ; Zamolodchikov AB (1984). "Simetría conforme infinita en la teoría cuántica de campos bidimensional". Nucl. Phys. B . 241 (2): 333–80. Código Bibliográfico :1984NuPhB.241..333B. doi :10.1016/0550-3213(84)90052-X.

- ^ Clément Hongler, Invariancia conforme de las correlaciones del modelo de Ising, tesis doctoral, Universidad de Ginebra, 2010, pág. 9.

Lectura adicional

- Pais, Abraham; Inward Bound – Of Matter & Forces in the Physical World , Oxford University Press (1986) ISBN 0-19-851997-4 . Escrito por un ex asistente de Einstein en Princeton, esta es una hermosa y detallada historia de la física fundamental moderna, desde 1895 (descubrimiento de los rayos X) hasta 1983 (descubrimiento de los bosones vectoriales en el CERN ).

- Weinberg, Steven; La teoría cuántica de campos - Fundamentos (vol. I) , Cambridge University Press (1995) ISBN 0-521-55001-7 El primer capítulo (págs. 1-40) del monumental tratado de Weinberg ofrece una breve historia de la QFT, pág. 608.

- Weinberg, Steven; La teoría cuántica de campos: aplicaciones modernas (vol. II), Cambridge University Press:Cambridge, Reino Unido (1996) ISBN 0-521-55001-7 , págs. 489.

- Weinberg, Steven; La teoría cuántica de campos – Supersimetría (vol. III), Cambridge University Press:Cambridge, Reino Unido (2000) ISBN 0-521-55002-5 , págs. 419.

- Schweber, Silvan S.; QED y los hombres que lo crearon: Dyson, Feynman, Schwinger y Tomonaga , Princeton University Press (1994) ISBN 0-691-03327-7

- Ynduráin, Francisco José; Cromodinámica cuántica: una introducción a la teoría de los quarks y los gluones , Springer Verlag, Nueva York, 1983. ISBN 0-387-11752-0

- Miller, Arthur I.; Electrodinámica cuántica temprana: un libro de consulta , Cambridge University Press (1995) ISBN 0-521-56891-9

- Schwinger, Julian; Artículos seleccionados sobre electrodinámica cuántica , Dover Publications, Inc. (1958) ISBN 0-486-60444-6

- O'Raifeartaigh, Lochlainn; El amanecer de la teoría del calibre , Princeton University Press (5 de mayo de 1997) ISBN 0-691-02977-6

- Cao, Tian Yu; Desarrollos conceptuales de las teorías de campo del siglo XX , Cambridge University Press (1997) ISBN 0-521-63420-2

- Darrigol, Olivier; La genèse du concept de champ quantique , Annales de Physique (Francia) 9 (1984) págs. Texto en francés, adaptado del Ph.D. tesis.