Cadena de Markov

| Parte de una serie sobre estadísticas |

| Teoría de la probabilidad |

|---|

|

Una cadena de Markov o proceso de Markov es un proceso estocástico que describe una secuencia de eventos posibles en la que la probabilidad de cada evento depende únicamente del estado alcanzado en el evento anterior. De manera informal, esto puede considerarse como "Lo que sucede a continuación depende únicamente del estado actual de las cosas ". Una secuencia infinitamente contable , en la que la cadena se mueve de estado en pasos de tiempo discretos, da una cadena de Markov de tiempo discreto (DTMC). Un proceso de tiempo continuo se denomina cadena de Markov de tiempo continuo (CTMC). Los procesos de Markov reciben su nombre en honor al matemático ruso Andrey Markov .

Las cadenas de Markov tienen muchas aplicaciones como modelos estadísticos de procesos del mundo real. [1] Proporcionan la base para los métodos generales de simulación estocástica conocidos como Monte Carlo de cadenas de Markov , que se utilizan para simular el muestreo a partir de distribuciones de probabilidad complejas , y han encontrado aplicación en áreas que incluyen estadística bayesiana , biología , química , economía , finanzas , teoría de la información , física , procesamiento de señales y procesamiento de voz . [1] [2] [3]

Los adjetivos markoviano y markoviano se utilizan para describir algo que está relacionado con un proceso de Markov. [4]

Principios

Definición

Un proceso de Markov es un proceso estocástico que satisface la propiedad de Markov (a veces caracterizada como " falta de memoria "). En términos más simples, es un proceso para el cual se pueden hacer predicciones sobre resultados futuros basándose únicamente en su estado actual y, lo que es más importante, dichas predicciones son tan buenas como las que se podrían hacer conociendo la historia completa del proceso. [5] En otras palabras, dependiendo del estado actual del sistema, sus estados futuro y pasado son independientes .

Una cadena de Markov es un tipo de proceso de Markov que tiene un espacio de estados discreto o un conjunto de índices discretos (que a menudo representan el tiempo), pero la definición precisa de una cadena de Markov varía. [6] Por ejemplo, es común definir una cadena de Markov como un proceso de Markov en tiempo discreto o continuo con un espacio de estados contables (por lo tanto, independientemente de la naturaleza del tiempo), [7] [8] [9] [10] pero también es común definir una cadena de Markov como que tiene tiempo discreto en un espacio de estados contables o continuos (por lo tanto, independientemente del espacio de estados). [6]

Tipos de cadenas de Markov

Es necesario especificar el índice de parámetros de tiempo y espacio de estados del sistema . La siguiente tabla ofrece una descripción general de las diferentes instancias de procesos de Markov para diferentes niveles de generalidad de espacio de estados y para tiempo discreto frente a tiempo continuo:

| Espacio de estados contables | Espacio de estados continuo o general | |

|---|---|---|

| Tiempo discreto | Cadena de Markov (de tiempo discreto) en un espacio de estados contable o finito | Cadena de Markov en un espacio de estados medible (por ejemplo, cadena de Harris ) |

| Tiempo continuo | Proceso de Markov en tiempo continuo o proceso de salto de Markov | Cualquier proceso estocástico continuo con la propiedad de Markov (por ejemplo, el proceso de Wiener ) |

Nótese que no hay un acuerdo definitivo en la literatura sobre el uso de algunos de los términos que significan casos especiales de procesos de Markov. Usualmente el término "cadena de Markov" se reserva para un proceso con un conjunto discreto de tiempos, es decir, una cadena de Markov de tiempo discreto (DTMC) , [11] pero algunos autores usan el término "proceso de Markov" para referirse a una cadena de Markov de tiempo continuo (CTMC) sin mención explícita. [12] [13] [14] Además, hay otras extensiones de procesos de Markov que se conocen como tales pero que no necesariamente caen dentro de ninguna de estas cuatro categorías (ver modelo de Markov ). Además, el índice de tiempo no necesariamente necesita ser de valor real; al igual que con el espacio de estados, hay procesos concebibles que se mueven a través de conjuntos de índices con otras construcciones matemáticas. Nótese que la cadena de Markov de tiempo continuo del espacio de estados general es general a tal grado que no tiene un término designado.

Aunque el parámetro de tiempo suele ser discreto, el espacio de estados de una cadena de Markov no tiene ninguna restricción generalmente aceptada: el término puede referirse a un proceso en un espacio de estados arbitrario. [15] Sin embargo, muchas aplicaciones de las cadenas de Markov emplean espacios de estados finitos o numerablemente infinitos , que tienen un análisis estadístico más sencillo. Además de los parámetros de índice de tiempo y de espacio de estados, existen muchas otras variaciones, extensiones y generalizaciones (ver Variaciones). Para simplificar, la mayor parte de este artículo se concentra en el caso de tiempo discreto y espacio de estados discreto, a menos que se indique lo contrario.

Transiciones

Los cambios de estado del sistema se denominan transiciones. Las probabilidades asociadas con varios cambios de estado se denominan probabilidades de transición. El proceso se caracteriza por un espacio de estados, una matriz de transición que describe las probabilidades de transiciones particulares y un estado inicial (o distribución inicial) en el espacio de estados. Por convención, asumimos que todos los estados y transiciones posibles se han incluido en la definición del proceso, por lo que siempre hay un estado siguiente y el proceso no termina.

Un proceso aleatorio de tiempo discreto implica un sistema que se encuentra en un estado determinado en cada paso, y que cambia de estado aleatoriamente entre los pasos. Los pasos suelen considerarse momentos en el tiempo, pero también pueden referirse a distancias físicas o a cualquier otra medida discreta. Formalmente, los pasos son los números enteros o naturales y el proceso aleatorio es una aplicación de estos a estados. La propiedad de Markov establece que la distribución de probabilidad condicional para el sistema en el siguiente paso (y, de hecho, en todos los pasos futuros) depende únicamente del estado actual del sistema y no, además, del estado del sistema en los pasos anteriores.

Dado que el sistema cambia aleatoriamente, generalmente es imposible predecir con certeza el estado de una cadena de Markov en un momento dado en el futuro. Sin embargo, las propiedades estadísticas del futuro del sistema sí se pueden predecir. En muchas aplicaciones, son estas propiedades estadísticas las que son importantes.

Historia

Andrey Markov estudió los procesos de Markov a principios del siglo XX, publicando su primer artículo sobre el tema en 1906. [16] [17] [18] Los procesos de Markov en tiempo continuo se descubrieron mucho antes de su trabajo a principios del siglo XX en la forma del proceso de Poisson . [19] [20] [21] Markov estaba interesado en estudiar una extensión de secuencias aleatorias independientes, motivado por un desacuerdo con Pavel Nekrasov , quien afirmaba que la independencia era necesaria para que se cumpliera la ley débil de los grandes números . [22] En su primer artículo sobre cadenas de Markov, publicado en 1906, Markov demostró que bajo ciertas condiciones los resultados promedio de la cadena de Markov convergerían a un vector fijo de valores, probando así una ley débil de los grandes números sin el supuesto de independencia, [16] [17] [18] que había sido considerado comúnmente como un requisito para que tales leyes matemáticas se cumplieran. [18] Posteriormente, Markov utilizó cadenas de Markov para estudiar la distribución de vocales en Eugene Onegin , escrito por Alexander Pushkin , y demostró un teorema de límite central para dichas cadenas. [16]

En 1912, Henri Poincaré estudió las cadenas de Markov en grupos finitos con el objetivo de estudiar el barajado de cartas. Otros usos tempranos de las cadenas de Markov incluyen un modelo de difusión, introducido por Paul y Tatyana Ehrenfest en 1907, y un proceso de ramificación, introducido por Francis Galton y Henry William Watson en 1873, que precedió al trabajo de Markov. [16] [17] Después del trabajo de Galton y Watson, se reveló más tarde que su proceso de ramificación había sido descubierto y estudiado de forma independiente unas tres décadas antes por Irénée-Jules Bienaymé . [23] A partir de 1928, Maurice Fréchet se interesó en las cadenas de Markov, lo que finalmente lo llevó a publicar en 1938 un estudio detallado sobre las cadenas de Markov. [16] [24]

Andrey Kolmogorov desarrolló en un artículo de 1931 una gran parte de la teoría temprana de los procesos de Markov en tiempo continuo. [25] [26] Kolmogorov se inspiró en parte en el trabajo de 1900 de Louis Bachelier sobre las fluctuaciones en el mercado de valores, así como en el trabajo de Norbert Wiener sobre el modelo de movimiento browniano de Einstein. [25] [27] Introdujo y estudió un conjunto particular de procesos de Markov conocidos como procesos de difusión, donde derivó un conjunto de ecuaciones diferenciales que describen los procesos. [25] [28] Independientemente del trabajo de Kolmogorov, Sydney Chapman derivó en un artículo de 1928 una ecuación, ahora llamada ecuación de Chapman-Kolmogorov , de una manera matemáticamente menos rigurosa que Kolmogorov, mientras estudiaba el movimiento browniano. [29] Las ecuaciones diferenciales ahora se denominan ecuaciones de Kolmogorov [30] o ecuaciones de Kolmogorov-Chapman. [31] Otros matemáticos que contribuyeron significativamente a las bases de los procesos de Markov incluyen a William Feller , a partir de la década de 1930, y luego más tarde a Eugene Dynkin , a partir de la década de 1950. [26]

Ejemplos

- Los paseos aleatorios basados en números enteros y el problema de la ruina del jugador son ejemplos de procesos de Markov. [32] [33] Algunas variaciones de estos procesos se estudiaron cientos de años antes en el contexto de variables independientes. [34] [35] Dos ejemplos importantes de procesos de Markov son el proceso de Wiener , también conocido como el proceso de movimiento browniano , y el proceso de Poisson , [19] que se consideran los procesos estocásticos más importantes y centrales en la teoría de procesos estocásticos. [36] [37] [38] Estos dos procesos son procesos de Markov en tiempo continuo, mientras que los paseos aleatorios sobre los números enteros y el problema de la ruina del jugador son ejemplos de procesos de Markov en tiempo discreto. [32] [33]

- Una famosa cadena de Markov es la llamada "caminata del borracho", un paseo aleatorio por la recta numérica en el que, en cada paso, la posición puede cambiar en +1 o -1 con la misma probabilidad. Desde cualquier posición hay dos transiciones posibles, al siguiente o al anterior entero. Las probabilidades de transición dependen únicamente de la posición actual, no de la forma en que se alcanzó la posición. Por ejemplo, las probabilidades de transición de 5 a 4 y de 5 a 6 son ambas 0,5, y todas las demás probabilidades de transición a partir de 5 son 0. Estas probabilidades son independientes de si el sistema estaba previamente en 4 o 6.

- Una serie de estados independientes (por ejemplo, una serie de lanzamientos de moneda) satisface la definición formal de una cadena de Markov. Sin embargo, la teoría suele aplicarse solo cuando la distribución de probabilidad del siguiente estado depende del actual.

Un ejemplo no markoviano

Supongamos que hay un monedero que contiene cinco monedas de veinticinco centavos (cada una con un valor de 25¢), cinco de diez centavos (cada una con un valor de 10¢) y cinco de cinco centavos (cada una con un valor de 5¢), y una por una, se extraen monedas al azar del monedero y se colocan sobre una mesa. Si representa el valor total de las monedas colocadas sobre la mesa después de n extracciones, con , entonces la secuencia no es un proceso de Markov.

Para ver por qué es así, supongamos que en los primeros seis sorteos se extraen las cinco monedas de cinco centavos y una de veinticinco centavos. Por lo tanto , . Si no solo conocemos , sino también los valores anteriores, entonces podemos determinar qué monedas se han extraído, y sabemos que la siguiente moneda no será una moneda de cinco centavos; por lo tanto, podemos determinarlo con una probabilidad de 1. Pero si no conocemos los valores anteriores, entonces, basándonos solo en el valor, podríamos suponer que habíamos extraído cuatro monedas de diez centavos y dos de cinco centavos, en cuyo caso, sin duda, sería posible extraer otra moneda de cinco centavos a continuación. Por lo tanto, nuestras suposiciones sobre se ven afectadas por nuestro conocimiento de los valores anteriores a .

Sin embargo, es posible modelar este escenario como un proceso de Markov. En lugar de definir para representar el valor total de las monedas en la mesa, podríamos definir para representar el recuento de los diversos tipos de monedas en la mesa. Por ejemplo, podría definirse para representar el estado donde hay una moneda de veinticinco centavos, cero monedas de diez centavos y cinco monedas de cinco centavos en la mesa después de 6 extracciones una por una. Este nuevo modelo podría representarse por estados posibles, donde cada estado representa el número de monedas de cada tipo (de 0 a 5) que están en la mesa. (No todos estos estados son alcanzables dentro de 6 extracciones). Supongamos que la primera extracción da como resultado el estado . La probabilidad de lograrlo ahora depende de ; por ejemplo, el estado no es posible. Después de la segunda extracción, la tercera extracción depende de qué monedas se han extraído hasta ahora, pero ya no solo de las monedas que se extrajeron para el primer estado (ya que desde entonces se ha agregado información probabilísticamente importante al escenario). De esta manera, la probabilidad del estado depende exclusivamente del resultado del estado.

Definición formal

Cadena de Markov de tiempo discreto

Una cadena de Markov de tiempo discreto es una secuencia de variables aleatorias X 1 , X 2 , X 3 , ... con la propiedad de Markov , es decir, que la probabilidad de pasar al siguiente estado depende sólo del estado actual y no de los estados anteriores:

- si ambas probabilidades condicionales están bien definidas, es decir, si

Los posibles valores de Xi forman un conjunto contable S llamado espacio de estados de la cadena.

Variaciones

- Las cadenas de Markov homogéneas en el tiempo son procesos en los que para todo n , la probabilidad de la transición es independiente de n .

- Las cadenas de Markov estacionarias son procesos en los que, para todos los n y k , se puede demostrar que toda cadena estacionaria es homogénea en el tiempo mediante la regla de Bayes.Una condición necesaria y suficiente para que una cadena de Markov homogénea en el tiempo sea estacionaria es que la distribución de sea una distribución estacionaria de la cadena de Markov.

- Una cadena de Markov con memoria (o una cadena de Markov de orden m ) donde m es finito, es un proceso que satisface En otras palabras, el estado futuro depende de los m estados pasados. Es posible construir una cadena a partir de la cual tiene la propiedad 'clásica' de Markov tomando como espacio de estados las m -tuplas ordenadas de valores X , es decir, .

Cadena de Markov de tiempo continuo

Una cadena de Markov de tiempo continuo ( X t ) t ≥ 0 se define por un espacio de estados finito o contable S , una matriz de tasa de transición Q con dimensiones iguales a las del espacio de estados y una distribución de probabilidad inicial definida en el espacio de estados. Para i ≠ j , los elementos q ij son no negativos y describen la tasa de transición del proceso del estado i al estado j . Los elementos q ii se eligen de modo que cada fila de la matriz de tasa de transición sume cero, mientras que las sumas de filas de una matriz de transición de probabilidad en una cadena de Markov (discreta) sean todas iguales a uno.

Existen tres definiciones equivalentes del proceso. [39]

Definición infinitesimal

Sea la variable aleatoria que describe el estado del proceso en el momento t y supongamos que el proceso está en un estado i en el momento t . Entonces, sabiendo que , es independiente de los valores anteriores , y cuando h → 0 para todo j y para todo t , donde es el delta de Kronecker , utilizando la notación de o minúscula . Se puede considerar que mide la rapidez con la que ocurre la transición de i a j .

Definición de cadena de salto/tiempo de retención

Defina una cadena de Markov de tiempo discreto Y n para describir el n º salto del proceso y las variables S 1 , S 2 , S 3 , ... para describir los tiempos de retención en cada uno de los estados donde S i sigue la distribución exponencial con parámetro de velocidad − q Y i Y i .

Definición de probabilidad de transición

Para cualquier valor n = 0, 1, 2, 3, ... y tiempos indexados hasta este valor de n : t 0 , t 1 , t 2 , ... y todos los estados registrados en estos tiempos i 0 , i 1 , i 2 , i 3 , ... se cumple que

donde p ij es la solución de la ecuación directa (una ecuación diferencial de primer orden )

con condición inicial P(0) es la matriz identidad .

Espacio de estados finitos

Si el espacio de estados es finito , la distribución de probabilidad de transición se puede representar mediante una matriz , llamada matriz de transición, con el elemento ( i , j ) de P igual a

Dado que cada fila de P suma uno y todos los elementos no son negativos, P es una matriz estocástica derecha .

Relación de distribución estacionaria con vectores propios y símplices

Una distribución estacionaria π es un vector (fila), cuyas entradas no son negativas y suman 1, no cambia por la operación de la matriz de transición P sobre ella y por lo tanto se define por

Comparando esta definición con la de un vector propio vemos que los dos conceptos están relacionados y que

es un múltiplo normalizado ( ) de un vector propio izquierdo e de la matriz de transición P con un valor propio de 1. Si hay más de un vector propio unitario, entonces una suma ponderada de los estados estacionarios correspondientes también es un estado estacionario. Pero para una cadena de Markov, uno suele estar más interesado en un estado estacionario que sea el límite de la secuencia de distribuciones para alguna distribución inicial.

Los valores de una distribución estacionaria están asociados con el espacio de estados de P y sus vectores propios conservan sus proporciones relativas. Dado que los componentes de π son positivos y la restricción de que su suma es la unidad se puede reescribir como vemos que el producto escalar de π con un vector cuyos componentes son todos 1 es la unidad y que π se encuentra en un símplex .

Cadena de Markov homogénea en el tiempo con un espacio de estados finito

Si la cadena de Markov es homogénea en el tiempo, entonces la matriz de transición P es la misma después de cada paso, por lo que la probabilidad de transición de k pasos se puede calcular como la k -ésima potencia de la matriz de transición, P k .

Si la cadena de Markov es irreducible y aperiódica, entonces existe una distribución estacionaria única π . [40] Además, en este caso P k converge a una matriz de rango uno en la que cada fila es la distribución estacionaria π :

donde 1 es el vector columna con todas las entradas iguales a 1. Esto se establece mediante el teorema de Perron-Frobenius . Si se encuentra, por cualquier medio, entonces la distribución estacionaria de la cadena de Markov en cuestión se puede determinar fácilmente para cualquier distribución inicial, como se explicará a continuación.

Para algunas matrices estocásticas P , el límite no existe mientras que la distribución estacionaria sí, como lo muestra este ejemplo:

(Este ejemplo ilustra una cadena periódica de Markov).

Dado que hay varios casos especiales diferentes a tener en cuenta, el proceso de encontrar este límite, si existe, puede ser una tarea larga. Sin embargo, existen muchas técnicas que pueden ayudar a encontrar este límite. Sea P una matriz n × n y defina

Siempre es cierto que

Restando Q de ambos lados y factorizando obtenemos

donde I n es la matriz identidad de tamaño n , y 0 n , n es la matriz cero de tamaño n × n . Multiplicar entre sí matrices estocásticas siempre produce otra matriz estocástica, por lo que Q debe ser una matriz estocástica (véase la definición anterior). A veces es suficiente utilizar la ecuación matricial anterior y el hecho de que Q es una matriz estocástica para resolver Q . Incluyendo el hecho de que la suma de cada una de las filas en P es 1, hay n+1 ecuaciones para determinar n incógnitas, por lo que es computacionalmente más fácil si por un lado se selecciona una fila en Q y se sustituye cada uno de sus elementos por uno, y por el otro se sustituye el elemento correspondiente (el de la misma columna) en el vector 0 , y luego se multiplica por la izquierda este último vector por la inversa de la matriz anterior transformada para encontrar Q .

He aquí un método para hacerlo: primero, defina la función f ( A ) para devolver la matriz A con su columna más a la derecha reemplazada con todos los 1. Si [ f ( P − I n )] −1 existe, entonces [41] [40]

- Explicación: La ecuación matricial original es equivalente a un sistema de n×n ecuaciones lineales en n×n variables. Y hay n ecuaciones lineales más debido a que Q es una matriz estocástica derecha cuyas filas suman 1. Por lo tanto, necesita n×n ecuaciones lineales independientes de las ecuaciones (n×n+n) para resolver las n×n variables. En este ejemplo, las n ecuaciones de “Q multiplicada por la columna más a la derecha de (P-In)” han sido reemplazadas por las n ecuaciones estocásticas.

Una cosa a tener en cuenta es que si P tiene un elemento Pi , i en su diagonal principal que es igual a 1 y la fila o columna i está llena de ceros, entonces esa fila o columna permanecerá sin cambios en todas las potencias subsiguientes P k . Por lo tanto, la fila o columna i de Q tendrá los 1 y los ceros en las mismas posiciones que en P.

Velocidad de convergencia a la distribución estacionaria

Como se indicó anteriormente, de la ecuación (si existe) la distribución estacionaria (o de estado estable) π es un vector propio izquierdo de la matriz estocástica de filas P . Luego, suponiendo que P es diagonalizable o, equivalentemente, que P tiene n vectores propios linealmente independientes, la velocidad de convergencia se elabora de la siguiente manera. (Para matrices no diagonalizables, es decir, defectuosas , se puede comenzar con la forma normal de Jordan de P y proceder con un conjunto de argumentos un poco más complejo de manera similar. [42] )

Sea U la matriz de vectores propios (cada uno normalizado para tener una norma L2 igual a 1) donde cada columna es un vector propio izquierdo de P y sea Σ la matriz diagonal de valores propios izquierdos de P , es decir, Σ = diag( λ 1 , λ 2 , λ 3 ,..., λ n ). Luego, por descomposición propia

Sean enumerados los valores propios de tal manera que:

Como P es una matriz estocástica por filas, su valor propio izquierdo más grande es 1. Si hay una distribución estacionaria única, entonces el valor propio más grande y el vector propio correspondiente también son únicos (porque no hay otro π que resuelva la ecuación de distribución estacionaria anterior). Sea u i la i -ésima columna de la matriz U , es decir, u i es el vector propio izquierdo de P correspondiente a λ i . Sea también x un vector de fila de longitud n que representa una distribución de probabilidad válida; dado que los vectores propios u i abarcan, podemos escribir

Si multiplicamos x por P desde la derecha y continuamos esta operación con los resultados, al final obtenemos la distribución estacionaria π . En otras palabras, π = a 1 u 1 ← xPP ... P = xP k cuando k → ∞. Esto significa que

Como π es paralelo a u 1 (normalizado por la norma L2) y π ( k ) es un vector de probabilidad, π ( k ) se aproxima a a 1 u 1 = π cuando k → ∞ con una velocidad del orden de λ 2 / λ 1 exponencialmente. Esto se deduce porque, por lo tanto, λ 2 / λ 1 es el término dominante. Cuanto menor sea la relación, más rápida será la convergencia. [43] El ruido aleatorio en la distribución de estados π también puede acelerar esta convergencia a la distribución estacionaria. [44]

Espacio de estados generales

Cadenas de Harris

Muchos resultados para cadenas de Markov con espacio de estados finito se pueden generalizar a cadenas con espacio de estados incontable a través de cadenas de Harris .

El uso de cadenas de Markov en los métodos de Monte Carlo de cadenas de Markov cubre casos en los que el proceso sigue un espacio de estados continuo.

Cadenas de Markov que interactúan localmente

Las "cadenas de Markov que interactúan localmente" son cadenas de Markov con una evolución que tiene en cuenta el estado de otras cadenas de Markov. Esto corresponde a la situación en la que el espacio de estados tiene una forma de producto (cartesiano). Véase sistema de partículas interactuantes y autómatas celulares estocásticos (autómatas celulares probabilísticos). Véase, por ejemplo, Interacción de procesos de Markov [45] o [46] .

Propiedades

Se dice que dos estados se comunican entre sí si ambos pueden alcanzarse entre sí mediante una secuencia de transiciones que tienen una probabilidad positiva. Esta es una relación de equivalencia que produce un conjunto de clases que se comunican. Una clase está cerrada si la probabilidad de abandonar la clase es cero. Una cadena de Markov es irreducible si hay una clase que se comunica, el espacio de estados.

Un estado i tiene período k si k es el máximo común divisor del número de transiciones por las que se puede llegar a i , a partir de i . Es decir:

El estado es periódico si ; en caso contrario y el estado es aperiódico .

Se dice que un estado i es transitorio si, a partir de i , existe una probabilidad distinta de cero de que la cadena nunca regrese a i . En caso contrario, se denomina recurrente (o persistente ). [47] Para un estado recurrente i , el tiempo medio de impacto se define como:

El estado i es recurrente positivo si es finito y nulo en caso contrario. La periodicidad, la transitoriedad, la recurrencia y la recurrencia positiva y nula son propiedades de clase, es decir, si un estado tiene la propiedad, entonces todos los estados en su clase comunicante tienen la propiedad. [48]

Un estado i se denomina absorbente si no hay transiciones salientes desde el estado.

Irreducibilidad

Como la periodicidad es una propiedad de clase, si una cadena de Markov es irreducible, entonces todos sus estados tienen el mismo período. En particular, si un estado es aperiódico, entonces toda la cadena de Markov es aperiódica. [49]

Si una cadena de Markov finita es irreducible, entonces todos los estados son recurrentes positivos y tiene una distribución estacionaria única dada por .

Ergodicidad

Se dice que un estado i es ergódico si es aperiódico y recurrente positivo. En otras palabras, un estado i es ergódico si es recurrente, tiene un período de 1 y un tiempo de recurrencia medio finito.

Si todos los estados de una cadena irreducible de Markov son ergódicos, entonces se dice que la cadena es ergódica. De manera equivalente, existe algún entero tal que todas las entradas de son positivas.

Se puede demostrar que una cadena de Markov irreducible de estados finitos es ergódica si tiene un estado aperiódico. De manera más general, una cadena de Markov es ergódica si existe un número N tal que cualquier estado puede alcanzarse desde cualquier otro estado en cualquier número de pasos menor o igual a un número N . En el caso de una matriz de transición completamente conectada, donde todas las transiciones tienen una probabilidad distinta de cero, esta condición se cumple con N = 1.

Una cadena de Markov con más de un estado y sólo una transición saliente por estado no es irreducible ni aperiódica, por lo tanto no puede ser ergódica.

Terminología

Algunos autores denominan cadenas de Markov irreducibles y positivas como ergódicas, incluso las periódicas. [50] De hecho, las cadenas de Markov meramente irreducibles corresponden a procesos ergódicos , definidos según la teoría ergódica . [51]

Algunos autores llaman a una matriz primitiva si y solo si existe algún entero tal que todas las entradas de son positivas. [52] Algunos la llaman autora regular . [53]

Índice de primitividad

El índice de primitividad , o exponente , de una matriz regular es el más pequeño tal que todas las entradas de son positivas. El exponente es puramente una propiedad de teoría de grafos, ya que depende únicamente de si cada entrada de es cero o positiva y, por lo tanto, se puede encontrar en un grafo dirigido con como su matriz de adyacencia.

Existen varios resultados combinatorios sobre el exponente cuando hay un número finito de estados. Sea el número de estados, entonces [54]

- El exponente es . El único caso en el que es una igualdad es cuando el gráfico de va como .

- Si tiene entradas diagonales, entonces su exponente es .

- Si es simétrico, entonces tiene entradas diagonales positivas, lo que por la proposición anterior significa que su exponente es .

- (Teorema de Dulmage-Mendelsohn) El exponente es donde es la circunferencia del gráfico . Se puede mejorar a , donde es el diámetro del gráfico . [55]

Sistema dinámico que preserva la medida

Si una cadena de Markov tiene una distribución estacionaria, entonces puede convertirse en un sistema dinámico que preserva la medida : Sea el espacio de probabilidad , donde es el conjunto de todos los estados para la cadena de Markov. Sea el álgebra sigma en el espacio de probabilidad generado por los conjuntos de cilindros. Sea la medida de probabilidad generada por la distribución estacionaria y la transición de la cadena de Markov. Sea el operador de desplazamiento: . De manera similar, podemos construir un sistema dinámico de este tipo con en su lugar. [56]

Dado que las cadenas de Markov irreducibles con espacios de estados finitos tienen una distribución estacionaria única, la construcción anterior es inequívoca para las cadenas de Markov irreducibles.

En la teoría ergódica , un sistema dinámico que preserva la medida se denomina "ergódico" si existe algún subconjunto medible que implique o (hasta un conjunto nulo).

La terminología es inconsistente. Dada una cadena de Markov con una distribución estacionaria que es estrictamente positiva en todos los estados, la cadena de Markov es irreducible si y solo si su correspondiente sistema dinámico que preserva la medida es ergódico . [51]

Representaciones markovianas

En algunos casos, los procesos aparentemente no markovianos pueden tener representaciones markovianas, construidas mediante la expansión del concepto de los estados "actual" y "futuro". Por ejemplo, sea X un proceso no markoviano. Luego definamos un proceso Y , de modo que cada estado de Y represente un intervalo de tiempo de estados de X . Matemáticamente, esto toma la forma:

Si Y tiene la propiedad de Markov, entonces es una representación markoviana de X.

Un ejemplo de un proceso no markoviano con una representación markoviana es una serie temporal autorregresiva de orden mayor que uno. [57]

Tiempos de bateo

El tiempo de impacto es el tiempo que transcurre desde que se inicia un conjunto de estados determinado hasta que la cadena llega a un estado o conjunto de estados determinado. La distribución de dicho período de tiempo tiene una distribución de tipo fase. La distribución más simple de este tipo es la de una única transición distribuida exponencialmente.

Tiempos de impacto esperados

Para un subconjunto de estados A ⊆ S , el vector k A de tiempos de impacto (donde elemento representa el valor esperado , comenzando en el estado i en que la cadena ingresa a uno de los estados del conjunto A ) es la solución mínima no negativa de [58]

Inversión del tiempo

Para un CTMC X t , el proceso invertido en el tiempo se define como . Según el lema de Kelly, este proceso tiene la misma distribución estacionaria que el proceso directo.

Se dice que una cadena es reversible si el proceso inverso es el mismo que el proceso directo. El criterio de Kolmogorov establece que la condición necesaria y suficiente para que un proceso sea reversible es que el producto de las velocidades de transición alrededor de un bucle cerrado debe ser el mismo en ambas direcciones.

Cadena de Markov incorporada

Un método para encontrar la distribución de probabilidad estacionaria , π , de una cadena de Markov ergódica de tiempo continuo, Q , es encontrar primero su cadena de Markov incrustada (EMC) . Estrictamente hablando, la EMC es una cadena de Markov regular de tiempo discreto, a veces denominada proceso de salto . Cada elemento de la matriz de probabilidad de transición de un paso de la EMC, S , se denota por s ij y representa la probabilidad condicional de transición del estado i al estado j . Estas probabilidades condicionales se pueden encontrar mediante

A partir de esto, S puede escribirse como

donde I es la matriz identidad y diag( Q ) es la matriz diagonal formada al seleccionar la diagonal principal de la matriz Q y establecer todos los demás elementos en cero.

Para encontrar el vector de distribución de probabilidad estacionaria, debemos encontrar a continuación tal que

siendo un vector fila, de modo que todos los elementos en son mayores que 0 y = 1. A partir de esto, π puede encontrarse como

( S puede ser periódico, incluso si Q no lo es. Una vez que se encuentra π , debe normalizarse a un vector unitario ).

Otro proceso de tiempo discreto que puede derivarse de una cadena de Markov de tiempo continuo es un δ-esqueleto: la cadena de Markov (de tiempo discreto) formada al observar X ( t ) a intervalos de δ unidades de tiempo. Las variables aleatorias X (0), X (δ), X (2δ), ... dan la secuencia de estados visitados por el δ-esqueleto.

Tipos especiales de cadenas de Markov

Modelo de Markov

Los modelos de Markov se utilizan para modelar sistemas cambiantes. Existen cuatro tipos principales de modelos que generalizan las cadenas de Markov en función de si cada estado secuencial es observable o no y de si el sistema se debe ajustar en función de las observaciones realizadas:

| El estado del sistema es totalmente observable | El estado del sistema es parcialmente observable | |

|---|---|---|

| El sistema es autónomo | Cadena de Markov | Modelo oculto de Markov |

| El sistema está controlado | Proceso de decisión de Markov | Proceso de decisión de Markov parcialmente observable |

Esquema de Bernoulli

Un esquema de Bernoulli es un caso especial de una cadena de Markov en la que la matriz de probabilidad de transición tiene filas idénticas, lo que significa que el siguiente estado es independiente incluso del estado actual (además de ser independiente de los estados anteriores). Un esquema de Bernoulli con solo dos estados posibles se conoce como proceso de Bernoulli .

Nótese, sin embargo, que según el teorema de isomorfismo de Ornstein , toda cadena de Markov aperiódica e irreducible es isomorfa a un esquema de Bernoulli; [59] por lo tanto, uno podría igualmente afirmar que las cadenas de Markov son un "caso especial" de esquemas de Bernoulli. El isomorfismo generalmente requiere una recodificación complicada. El teorema de isomorfismo es incluso un poco más fuerte: establece que cualquier proceso estocástico estacionario es isomorfo a un esquema de Bernoulli; la cadena de Markov es solo un ejemplo de ello.

Subdesplazamiento de tipo finito

Cuando la matriz de Markov se reemplaza por la matriz de adyacencia de un grafo finito , el desplazamiento resultante se denomina cadena de Markov topológica o subdesplazamiento de tipo finito . [59] Una matriz de Markov que sea compatible con la matriz de adyacencia puede entonces proporcionar una medida del subdesplazamiento. Muchos sistemas dinámicos caóticos son isomorfos a las cadenas de Markov topológicas; los ejemplos incluyen difeomorfismos de variedades cerradas , el sistema Prouhet–Thue–Morse , el sistema Chacon, sistemas sóficos , sistemas libres de contexto y sistemas de codificación por bloques. [59]

Aplicaciones

Las cadenas de Markov se han empleado en una amplia gama de temas en las ciencias naturales y sociales y en aplicaciones tecnológicas.

Física

Los sistemas markovianos aparecen ampliamente en termodinámica y mecánica estadística , siempre que se utilicen probabilidades para representar detalles desconocidos o no modelados del sistema, si se puede suponer que la dinámica es invariante en el tiempo y que no es necesario considerar ninguna historia relevante que no esté ya incluida en la descripción del estado. [60] [61] Por ejemplo, un estado termodinámico opera bajo una distribución de probabilidad que es difícil o costosa de adquirir. Por lo tanto, el método de Monte Carlo de cadena de Markov se puede utilizar para extraer muestras aleatoriamente de una caja negra para aproximar la distribución de probabilidad de los atributos en un rango de objetos. [61]

Las cadenas de Markov se utilizan en simulaciones QCD de red . [62]

Química

Una red de reacción es un sistema químico que involucra múltiples reacciones y especies químicas. Los modelos estocásticos más simples de tales redes tratan el sistema como una cadena de Markov de tiempo continuo donde el estado es el número de moléculas de cada especie y con reacciones modeladas como posibles transiciones de la cadena. [63] Las cadenas de Markov y los procesos de Markov de tiempo continuo son útiles en química cuando los sistemas físicos se aproximan mucho a la propiedad de Markov. Por ejemplo, imagine una gran cantidad n de moléculas en solución en el estado A, cada una de las cuales puede experimentar una reacción química al estado B con una cierta velocidad promedio. Quizás la molécula sea una enzima y los estados se refieren a cómo está plegada. El estado de cualquier enzima individual sigue una cadena de Markov, y dado que las moléculas son esencialmente independientes entre sí, la cantidad de moléculas en el estado A o B en un momento es n veces la probabilidad de que una molécula dada esté en ese estado.

El modelo clásico de la actividad enzimática, la cinética de Michaelis-Menten , puede verse como una cadena de Markov, donde en cada paso temporal la reacción avanza en alguna dirección. Si bien la cinética de Michaelis-Menten es bastante sencilla, también se pueden modelar redes de reacción mucho más complicadas con cadenas de Markov. [64]

También se utilizó un algoritmo basado en una cadena de Markov para enfocar el crecimiento basado en fragmentos de sustancias químicas in silico hacia una clase deseada de compuestos, como fármacos o productos naturales. [65] A medida que se cultiva una molécula, se selecciona un fragmento de la molécula naciente como el estado "actual". No es consciente de su pasado (es decir, no es consciente de lo que ya está unido a ella). Luego pasa al siguiente estado cuando se le une un fragmento. Las probabilidades de transición se entrenan en bases de datos de clases auténticas de compuestos. [66]

Además, el crecimiento (y la composición) de los copolímeros se puede modelar utilizando cadenas de Markov. En función de las proporciones de reactividad de los monómeros que forman la cadena de polímero en crecimiento, se puede calcular la composición de la cadena (por ejemplo, si los monómeros tienden a agregarse de manera alternada o en largas series del mismo monómero). Debido a los efectos estéricos , los efectos de Markov de segundo orden también pueden desempeñar un papel en el crecimiento de algunas cadenas de polímeros.

De manera similar, se ha sugerido que la cristalización y el crecimiento de algunos materiales de óxido superred epitaxial pueden describirse con precisión mediante cadenas de Markov. [67]

Biología

Las cadenas de Markov se utilizan en diversas áreas de la biología. Algunos ejemplos destacados son:

- Filogenética y bioinformática , donde la mayoría de los modelos de evolución del ADN utilizan cadenas de Markov de tiempo continuo para describir el nucleótido presente en un sitio determinado del genoma .

- Dinámica de poblaciones , donde las cadenas de Markov son en particular una herramienta central en el estudio teórico de los modelos matriciales de población .

- Neurobiología , donde se han utilizado cadenas de Markov, por ejemplo, para simular el neocórtex de los mamíferos. [68]

- Biología de sistemas , por ejemplo con el modelado de la infección viral de células individuales. [69]

- Modelos compartimentados para el modelado de brotes y epidemias de enfermedades.

Pruebas

Varios teóricos han propuesto la idea de la prueba estadística de cadenas de Markov (MCST), un método para unir cadenas de Markov para formar una " manta de Markov ", organizando estas cadenas en varias capas recursivas ("wafering") y produciendo conjuntos de pruebas más eficientes (muestras) como reemplazo de pruebas exhaustivas. [ cita requerida ]

Variabilidad de la irradiación solar

Las evaluaciones de la variabilidad de la irradiación solar son útiles para las aplicaciones de energía solar . La variabilidad de la irradiación solar en cualquier ubicación a lo largo del tiempo es principalmente una consecuencia de la variabilidad determinista de la trayectoria del sol a través de la bóveda celeste y la variabilidad de la nubosidad. La variabilidad de la irradiación solar accesible en la superficie de la Tierra se ha modelado utilizando cadenas de Markov, [70] [71] [72] [73] incluyendo también el modelado de los dos estados de cielo despejado y nubosidad como una cadena de Markov de dos estados. [74] [75]

Reconocimiento de voz

Los modelos ocultos de Markov se han utilizado en sistemas de reconocimiento automático de voz . [76]

Teoría de la información

Las cadenas de Markov se utilizan en todo el procesamiento de información. El famoso artículo de Claude Shannon de 1948 Una teoría matemática de la comunicación , que en un solo paso creó el campo de la teoría de la información , comienza introduciendo el concepto de entropía al modelar textos en un lenguaje natural (como el inglés) generados por un proceso ergódico de Markov, donde cada letra puede depender estadísticamente de letras anteriores. [77] Estos modelos idealizados pueden capturar muchas de las regularidades estadísticas de los sistemas. Incluso sin describir perfectamente la estructura completa del sistema, estos modelos de señales pueden hacer posible una compresión de datos muy efectiva a través de técnicas de codificación de entropía como la codificación aritmética . También permiten una estimación de estado efectiva y el reconocimiento de patrones . Las cadenas de Markov también juegan un papel importante en el aprendizaje de refuerzo .

Las cadenas de Markov también son la base de los modelos ocultos de Markov, que son una herramienta importante en campos tan diversos como las redes telefónicas (que utilizan el algoritmo de Viterbi para la corrección de errores), el reconocimiento de voz y la bioinformática (como en la detección de reordenamientos [78] ).

El algoritmo de compresión de datos sin pérdida LZMA combina cadenas de Markov con compresión Lempel-Ziv para lograr índices de compresión muy altos.

Teoría de colas

Las cadenas de Markov son la base para el tratamiento analítico de las colas ( teoría de colas ). Agner Krarup Erlang inició el tema en 1917. [79] Esto las hace críticas para optimizar el rendimiento de las redes de telecomunicaciones, donde los mensajes a menudo deben competir por recursos limitados (como el ancho de banda). [80]

Numerosos modelos de colas utilizan cadenas de Markov de tiempo continuo. Por ejemplo, una cola M/M/1 es una CTMC de números enteros no negativos donde las transiciones ascendentes de i a i + 1 ocurren a una tasa λ según un proceso de Poisson y describen las llegadas de trabajos, mientras que las transiciones de i a i – 1 (para i > 1) ocurren a una tasa μ (los tiempos de servicio de los trabajos se distribuyen exponencialmente) y describen los servicios completados (salidas) de la cola.

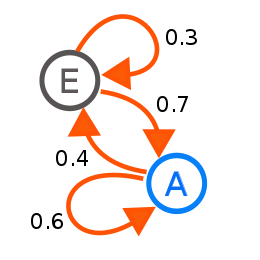

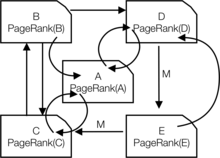

Aplicaciones de Internet

El PageRank de una página web, tal como lo utiliza Google, se define mediante una cadena de Markov. [81] [82] [83] Es la probabilidad de estar en una página en la distribución estacionaria de la siguiente cadena de Markov en todas las páginas web (conocidas). Si es el número de páginas web conocidas y una página tiene enlaces a ella, entonces tiene una probabilidad de transición para todas las páginas que tienen enlaces y para todas las páginas que no tienen enlaces. El parámetro se toma en aproximadamente 0,15. [84]

Los modelos de Markov también se han utilizado para analizar el comportamiento de navegación web de los usuarios. La transición de un usuario a un enlace web en un sitio web en particular se puede modelar utilizando modelos de Markov de primer o segundo orden y se puede utilizar para hacer predicciones sobre la navegación futura y para personalizar la página web para un usuario individual.

Estadística

Los métodos de cadena de Markov también han adquirido gran importancia para generar secuencias de números aleatorios que reflejen con precisión distribuciones de probabilidad deseadas muy complicadas, mediante un proceso llamado Markov Chain Monte Carlo (MCMC). En los últimos años, esto ha revolucionado la viabilidad de los métodos de inferencia bayesianos , permitiendo simular una amplia gama de distribuciones posteriores y determinar numéricamente sus parámetros. [ cita requerida ]

Economía y finanzas

Las cadenas de Markov se utilizan en finanzas y economía para modelar una variedad de fenómenos diferentes, incluyendo la distribución del ingreso, la distribución del tamaño de las empresas, los precios de los activos y las caídas del mercado. DG Champernowne construyó un modelo de cadena de Markov de la distribución del ingreso en 1953. [85] Herbert A. Simon y el coautor Charles Bonini utilizaron un modelo de cadena de Markov para derivar una distribución estacionaria de Yule de tamaños de empresas. [86] Louis Bachelier fue el primero en observar que los precios de las acciones seguían un paseo aleatorio. [87] El paseo aleatorio fue visto más tarde como evidencia a favor de la hipótesis del mercado eficiente y los modelos de paseo aleatorio fueron populares en la literatura de la década de 1960. [88] Los modelos de cambio de régimen de los ciclos económicos fueron popularizados por James D. Hamilton (1989), quien utilizó una cadena de Markov para modelar cambios entre períodos de alto y bajo crecimiento del PIB (o, alternativamente, expansiones económicas y recesiones). [89] Un ejemplo más reciente es el modelo multifractal de cambio de régimen de Markov de Laurent E. Calvet y Adlai J. Fisher, que se basa en la conveniencia de los modelos de cambio de régimen anteriores. [90] [91] Utiliza una cadena de Markov arbitrariamente grande para determinar el nivel de volatilidad de los rendimientos de los activos.

La macroeconomía dinámica hace un uso intensivo de las cadenas de Markov. Un ejemplo es el uso de cadenas de Markov para modelar exógenamente los precios de las acciones en un contexto de equilibrio general . [92]

Las agencias de calificación crediticia elaboran anualmente tablas de las probabilidades de transición para bonos de diferentes calificaciones crediticias. [93]

Ciencias sociales

Las cadenas de Markov se utilizan generalmente para describir argumentos dependientes de la trayectoria , donde las configuraciones estructurales actuales condicionan los resultados futuros. Un ejemplo es la reformulación de la idea, originalmente debido a El capital de Karl Marx , que vincula el desarrollo económico al auge del capitalismo . En la investigación actual, es común utilizar una cadena de Markov para modelar cómo una vez que un país alcanza un nivel específico de desarrollo económico, la configuración de factores estructurales, como el tamaño de la clase media , la relación entre la residencia urbana y rural, la tasa de movilización política , etc., generará una mayor probabilidad de transición de un régimen autoritario a uno democrático . [94]

Juegos

Las cadenas de Markov se pueden utilizar para modelar muchos juegos de azar. Los juegos infantiles Serpientes y escaleras y " Hi Ho! Cherry-O ", por ejemplo, se representan exactamente mediante cadenas de Markov. En cada turno, el jugador comienza en un estado determinado (en una casilla determinada) y a partir de ahí tiene probabilidades fijas de pasar a otros estados (casillas) determinados.

Música

Las cadenas de Markov se emplean en la composición musical algorítmica , particularmente en software como Csound , Max y SuperCollider . En una cadena de primer orden, los estados del sistema se convierten en valores de nota o tono, y se construye un vector de probabilidad para cada nota, completando una matriz de probabilidad de transición (ver más abajo). Se construye un algoritmo para producir valores de nota de salida basados en las ponderaciones de la matriz de transición, que podrían ser valores de nota MIDI , frecuencia ( Hz ) o cualquier otra métrica deseada. [95]

| Nota | A | C ♯ | mi ♭ |

|---|---|---|---|

| A | 0,1 | 0.6 | 0.3 |

| C ♯ | 0,25 | 0,05 | 0,7 |

| mi ♭ | 0,7 | 0.3 | 0 |

| Notas | A | D | GRAMO |

|---|---|---|---|

| Automóvil club británico | 0,18 | 0.6 | 0,22 |

| ANUNCIO | 0,5 | 0,5 | 0 |

| Estado | 0,15 | 0,75 | 0,1 |

| DD | 0 | 0 | 1 |

| ES | 0,25 | 0 | 0,75 |

| Director General | 0.9 | 0,1 | 0 |

| GG | 0,4 | 0,4 | 0,2 |

| Georgia | 0,5 | 0,25 | 0,25 |

| Dios bendiga | 1 | 0 | 0 |

Se puede introducir una cadena de Markov de segundo orden considerando el estado actual y también el estado anterior, como se indica en la segunda tabla. Las cadenas de orden n -ésimo más altas tienden a "agrupar" notas particulares, mientras que ocasionalmente se "dividen" en otros patrones y secuencias. Estas cadenas de orden superior tienden a generar resultados con una sensación de estructura de frase , en lugar del "vagabundeo sin rumbo" producido por un sistema de primer orden. [96]

Las cadenas de Markov se pueden utilizar estructuralmente, como en Analogique A y B de Xenakis. [97] Las cadenas de Markov también se utilizan en sistemas que utilizan un modelo de Markov para reaccionar de forma interactiva a la entrada de música. [98]

Por lo general, los sistemas musicales necesitan imponer restricciones de control específicas a las secuencias de longitud finita que generan, pero las restricciones de control no son compatibles con los modelos de Markov, ya que inducen dependencias de largo alcance que violan la hipótesis de Markov de memoria limitada. Para superar esta limitación, se ha propuesto un nuevo enfoque. [99]

Béisbol

Los modelos de cadena de Markov se han utilizado en el análisis avanzado del béisbol desde 1960, aunque su uso todavía es poco frecuente. Cada media entrada de un juego de béisbol se ajusta al estado de la cadena de Markov cuando se considera el número de corredores y outs. Durante cualquier turno al bate, hay 24 combinaciones posibles de número de outs y posición de los corredores. Mark Pankin demuestra que los modelos de cadena de Markov se pueden utilizar para evaluar las carreras creadas tanto para jugadores individuales como para un equipo. [100] También analiza varios tipos de estrategias y condiciones de juego: cómo se han utilizado los modelos de cadena de Markov para analizar estadísticas para situaciones de juego como el toque de bola y el robo de bases y las diferencias entre jugar en césped y césped artificial . [101]

Generadores de texto de Markov

Los procesos de Markov también se pueden utilizar para generar texto que parezca real a primera vista a partir de un documento de muestra. Los procesos de Markov se utilizan en una variedad de software recreativo " generador de parodias " (consulte Dissociated Press , Jeff Harrison, [102] Mark V. Shaney , [103] [104] y Academias Neutronium). Existen varias bibliotecas de generación de texto de código abierto que utilizan cadenas de Markov.

Pronóstico probabilístico

Las cadenas de Markov se han utilizado para realizar pronósticos en varias áreas: por ejemplo, tendencias de precios, [105] energía eólica, [106] terrorismo estocástico , [107] [108] e irradiancia solar . [109] Los modelos de pronóstico de cadenas de Markov utilizan una variedad de configuraciones, desde la discretización de las series temporales, [106] hasta modelos ocultos de Markov combinados con wavelets, [105] y el modelo de distribución de mezcla de cadenas de Markov (MCM). [109]

Véase también

- Dinámica de las partículas markovianas

- Proceso de Gauss-Markov

- Método de aproximación de cadena de Markov

- Geoestadística de cadenas de Markov

- Tiempo de mezcla de la cadena de Markov

- Teorema del árbol de cadenas de Markov

- Proceso de decisión de Markov

- Fuente de información de Markov

- Odómetro de Markov

- Operador de Markov

- Campo aleatorio de Markov

- Ecuación maestra

- Cadena cuántica de Markov

- Proceso semi-Markoviano

- Autómata celular estocástico

- Cadena telescópica de Markov

- Modelo de Markov de orden variable

Notas

- ^ de Sean Meyn; Richard L. Tweedie (2 de abril de 2009). Cadenas de Markov y estabilidad estocástica. Cambridge University Press. p. 3. ISBN 978-0-521-73182-9.

- ^ Reuven Y. Rubinstein; Dirk P. Kroese (20 de septiembre de 2011). Simulación y método Montecarlo. John Wiley e hijos. pag. 225.ISBN 978-1-118-21052-9.

- ^ Dani Gamerman; Hedibert F. Lopes (10 de mayo de 2006). Cadena de Markov Monte Carlo: simulación estocástica para inferencia bayesiana, segunda edición. CRC Press. ISBN 978-1-58488-587-0.

- ^ "Markoviano" . Diccionario Oxford de inglés (edición en línea). Oxford University Press . (Se requiere suscripción o membresía a una institución participante).

- ^ Øksendal, BK (Bernt Karsten) (2003). Ecuaciones diferenciales estocásticas: una introducción con aplicaciones (6.ª ed.). Berlín: Springer. ISBN 3540047581.OCLC 52203046 .

- ^ ab Søren Asmussen (15 de mayo de 2003). Probabilidad Aplicada y Colas. Medios de ciencia y negocios de Springer. pag. 7.ISBN 978-0-387-00211-8.

- ^ Emanuel Parzen (17 de junio de 2015). Procesos estocásticos. Courier Dover Publications. pág. 188. ISBN 978-0-486-79688-8.

- ^ Samuel Karlin; Howard E. Taylor (2 de diciembre de 2012). Un primer curso sobre procesos estocásticos. Academic Press. pp. 29 y 30. ISBN 978-0-08-057041-9.

- ^ John Lamperti (1977). Procesos estocásticos: un estudio de la teoría matemática. Springer-Verlag. pp. 106-121. ISBN 978-3-540-90275-1.

- ^ Sheldon M. Ross (1996). Procesos estocásticos. Wiley. Págs. 174 y 231. ISBN. 978-0-471-12062-9.

- ^ Everitt, BS (2002) Diccionario de Estadística de Cambridge . ISBN 0-521-81099-X

- ^ Parzen, E. (1962) Procesos estocásticos , Holden-Day. ISBN 0-8162-6664-6 (Tabla 6.1)

- ^ Dodge, Y. (2003) The Oxford Dictionary of Statistical Terms , OUP. ISBN 0-19-920613-9 (entrada para "Cadena de Markov")

- ^ Dodge, Y. Diccionario Oxford de términos estadísticos , OUP. ISBN 0-19-920613-9

- ^ Meyn, S. Sean P. y Richard L. Tweedie. (2009) Cadenas de Markov y estabilidad estocástica . Cambridge University Press. (Prefacio, pág. iii)

- ^ abcde Charles Miller Grinstead; James Laurie Snell (1997). Introducción a la probabilidad. American Mathematical Soc. págs. 464–466. ISBN 978-0-8218-0749-1.

- ^ abc Pierre Bremaud (9 de marzo de 2013). Cadenas de Markov: campos de Gibbs, simulación de Monte Carlo y colas. Springer Science & Business Media. p. ix. ISBN 978-1-4757-3124-8.

- ^ abc Hayes, Brian (2013). "Primeros eslabones de la cadena de Markov". American Scientist . 101 (2): 92–96. doi :10.1511/2013.101.92.

- ^ ab Sheldon M. Ross (1996). Procesos estocásticos. Wiley. págs. 235 y 358. ISBN 978-0-471-12062-9.

- ^ Jarrow, Robert; Protter, Philip (2004). "Una breve historia de la integración estocástica y las finanzas matemáticas: los primeros años, 1880-1970". Un homenaje a Herman Rubin . pp. 75-91. CiteSeerX 10.1.1.114.632 . doi :10.1214/lnms/1196285381. ISBN . 978-0-940600-61-4.

- ^ Guttorp, Peter; Thorarinsdottir, Thordis L. (2012). "¿Qué pasó con el caos discreto, el proceso de Quenouille y la propiedad de Sharp Markov? Un poco de historia de los procesos puntuales estocásticos". Revista estadística internacional . 80 (2): 253–268. doi :10.1111/j.1751-5823.2012.00181.x.

- ^ Seneta, E. (1996). "Markov y el nacimiento de la teoría de la dependencia en cadena". Revista estadística internacional . 64 (3): 255–257. doi :10.2307/1403785. JSTOR 1403785.

- ^ Seneta, E. (1998). "IJ Bienaymé [1796–1878]: criticidad, desigualdad e internacionalización". Revista estadística internacional . 66 (3): 291–292. doi :10.2307/1403518. JSTOR 1403518.

- ^ Bru B, Hertz S (2001). "Maurice Fréchet". En Heyde CC , Seneta E, Crépel P, Fienberg SE, Gani J (eds.). Estadísticos de los siglos . Nueva York, Nueva York: Springer. págs. 331–334. doi :10.1007/978-1-4613-0179-0_71. ISBN 978-0-387-95283-3.

- ^ abc Kendall, DG; Batchelor, GK; Bingham, NH; Hayman, WK; Hyland, JME; Lorentz, GG; Moffatt, HK; Parry, W.; Razborov, AA; Robinson, CA; Whittle, P. (1990). "Andrei Nikolaevich Kolmogorov (1903–1987)". Boletín de la Sociedad Matemática de Londres . 22 (1): 33. doi :10.1112/blms/22.1.31.

- ^ ab Cramér, Harald (1976). "Medio siglo con la teoría de la probabilidad: algunos recuerdos personales". Anales de probabilidad . 4 (4): 509–546. doi : 10.1214/aop/1176996025 .

- ^ Marc Barbut; Bernard Locker; Laurent Mazliak (23 de agosto de 2016). Paul Lévy y Maurice Fréchet: 50 años de correspondencia en 107 cartas. Springer Londres. pag. 5.ISBN 978-1-4471-7262-8.

- ^ Valeriy Skorokhod (5 de diciembre de 2005). Principios básicos y aplicaciones de la teoría de la probabilidad. Springer Science & Business Media. pág. 146. ISBN 978-3-540-26312-8.

- ^ Bernstein, Jeremy (2005). "Bachelier". Revista estadounidense de física . 73 (5): 395–398. Código Bibliográfico :2005AmJPh..73..395B. doi :10.1119/1.1848117.

- ^ William J. Anderson (6 de diciembre de 2012). Cadenas de Markov de tiempo continuo: un enfoque orientado a las aplicaciones. Springer Science & Business Media. pág. vii. ISBN 978-1-4612-3038-0.

- ^ Kendall, DG; Batchelor, GK; Bingham, NH; Hayman, WK; Hyland, JME; Lorentz, GG; Moffatt, HK; Parry, W.; Razborov, AA; Robinson, CA; Whittle, P. (1990). "Andrei Nikolaevich Kolmogorov (1903–1987)". Boletín de la Sociedad Matemática de Londres . 22 (1): 57. doi :10.1112/blms/22.1.31.

- ^ ab Ionut Florescu (7 de noviembre de 2014). Probabilidad y procesos estocásticos. John Wiley & Sons. pp. 373 y 374. ISBN 978-1-118-59320-2.

- ^ de Samuel Karlin; Howard E. Taylor (2 de diciembre de 2012). Un primer curso sobre procesos estocásticos. Academic Press. p. 49. ISBN 978-0-08-057041-9.

- ^ Weiss, George H. (2006). "Paseos aleatorios". Enciclopedia de ciencias estadísticas . p. 1. doi :10.1002/0471667196.ess2180.pub2. ISBN 978-0471667193.

- ^ Michael F. Shlesinger (1985). El maravilloso mundo de la estocástica: un homenaje a Elliott W. Montroll. Holanda Septentrional. pp. 8-10. ISBN 978-0-444-86937-1.

- ^ Emanuel Parzen (17 de junio de 2015). Procesos estocásticos. Courier Dover Publications. pág. 7, 8. ISBN 978-0-486-79688-8.

- ^ Joseph L. Doob (1990). Procesos estocásticos. Wiley. págs. 46, 47.

- ^ Donald L. Snyder; Michael I. Miller (6 de diciembre de 2012). Procesos puntuales aleatorios en el tiempo y el espacio. Springer Science & Business Media. pág. 32. ISBN 978-1-4612-3166-0.

- ^ Norris, JR (1997). "Cadenas de Markov de tiempo continuo I". Cadenas de Markov . págs. 60–107. doi :10.1017/CBO9780511810633.004. ISBN . 9780511810633.

- ^ ab Serfozo, Richard (2009). Fundamentos de procesos estocásticos aplicados . Berlín: Springer. doi :10.1007/978-3-540-89332-5. ISBN 978-3-540-89331-8.

- ^ "Capítulo 11 "Cadenas de Markov"" (PDF) . Consultado el 2 de junio de 2017 .

- ^ Schmitt, Florian; Rothlauf, Franz (2001). "Sobre la importancia del segundo valor propio más grande en la tasa de convergencia de los algoritmos genéticos". Actas del 14.º Simposio sobre sistemas distribuidos fiables . CiteSeerX 10.1.1.28.6191 .

- ^ Rosenthal, Jeffrey S. (1995). "Tasas de convergencia para cadenas de Markov". SIAM Review . 37 (3): 387–405. doi :10.1137/1037083. JSTOR 2132659 . Consultado el 31 de mayo de 2021 .

- ^ Franzke, Brandon; Kosko, Bart (1 de octubre de 2011). "El ruido puede acelerar la convergencia en las cadenas de Markov". Physical Review E . 84 (4): 041112. Bibcode :2011PhRvE..84d1112F. doi :10.1103/PhysRevE.84.041112. PMID 22181092.

- ^ Spitzer, Frank (1970). "Interacción de los procesos de Markov". Avances en Matemáticas . 5 (2): 246–290. doi : 10.1016/0001-8708(70)90034-4 .

- ^ Dobrushin, RL ; Kryukov, VI; Toom, AL (1978). Sistemas celulares estocásticos: ergodicidad, memoria, morfogénesis. Manchester University Press. ISBN 9780719022067. Recuperado el 4 de marzo de 2016 .

- ^ Heyman, Daniel P.; Sobel, Mathew J. (1982). Modelos estocásticos en la investigación de operaciones, volumen 1. Nueva York: McGraw-Hill. pág. 230. ISBN 0-07-028631-0.

- ^ Peres, Yuval . "Muestra que la recurrencia positiva es una propiedad de clase". Mathematics Stack Exchange . Consultado el 1 de febrero de 2024 .

- ^ Lalley, Steve (2016). «Cadenas de Markov: teoría básica» (PDF) . Consultado el 22 de junio de 2024 .

- ^ Parzen, Emanuel (1962). Procesos estocásticos . San Francisco: Holden-Day. pág. 145. ISBN. 0-8162-6664-6.

- ^ ab Shalizi, Cosma (1 de diciembre de 2023). "Teoría ergódica". bactra.org . Consultado el 1 de febrero de 2024 .

- ^ Seneta, E. (Eugene) (1973). Matrices no negativas: una introducción a la teoría y las aplicaciones. Internet Archive. Nueva York, Wiley. ISBN 978-0-470-77605-6.

- ^ "10.3: Cadenas regulares de Markov". Matemáticas LibreTexts . 2020-03-22 . Consultado el 2024-02-01 .

- ^ Seneta, E. (Eugene) (1973). "2.4. Propiedades combinatorias". Matrices no negativas: una introducción a la teoría y aplicaciones. Internet Archive. Nueva York, Wiley. ISBN 978-0-470-77605-6.

- ^ Shen, Jian (15 de octubre de 1996). "Una mejora del teorema de Dulmage-Mendelsohn". Matemáticas discretas . 158 (1): 295–297. doi : 10.1016/0012-365X(95)00060-A .

- ^ Kallenberg, Olav (2002). Fundamentos de la probabilidad moderna . Probabilidad y sus aplicaciones (2. ed., [Nachdr.] ed.). Nueva York, NY Berlin Heidelberg: Springer. Proposición 8.6 (página 145). ISBN 978-0-387-95313-7.

- ^ Doblinger, G. (septiembre de 1998). "Suavizado de señales AR ruidosas utilizando un filtro Kalman adaptativo" (PDF) . 9.ª Conferencia Europea de Procesamiento de Señales (EUSIPCO 1998) : 781–784.

- ^ Norris, JR (1997). "Cadenas de Markov en tiempo continuo II". Cadenas de Markov . págs. 108-127. doi :10.1017/CBO9780511810633.005. ISBN . 9780511810633.

- ^ abc Matthew Nicol y Karl Petersen, (2009) "Teoría ergódica: ejemplos básicos y construcciones", Enciclopedia de complejidad y ciencia de sistemas , Springer https://doi.org/10.1007/978-0-387-30440-3_177

- ^ Fitzpatrick, Richard. "Termodinámica y mecánica estadística" (PDF) . Consultado el 2 de junio de 2017 .

- ^ ab van Ravenzwaaij, Don; Cassey, Pete; Brown, Scott D. (11 de marzo de 2016). "Una introducción sencilla al muestreo de Montecarlo con cadenas de Markov". Psychonomic Bulletin & Review . 25 (1): 143–154. doi :10.3758/s13423-016-1015-8. PMC 5862921 . PMID 26968853.

- ^ Gattringer, Christof; Lang, Christian B (2010). Cromodinámica cuántica en la red. Apuntes de clases de física. Vol. 788. Springer-Verlag Berlin Heidelberg. doi :10.1007/978-3-642-01850-3. ISBN . 978-3-642-01849-7.

- ^ Anderson, David F.; Kurtz, Thomas G. (2011), "Modelos de cadena de Markov de tiempo continuo para redes de reacciones químicas", Diseño y análisis de circuitos biomoleculares , Springer Nueva York, págs. 3–42, doi :10.1007/978-1-4419-6766-4_1, ISBN 9781441967657

- ^ Du, Chao; Kou, SC (septiembre de 2012). "Análisis de correlación de la reacción enzimática de una sola molécula de proteína". Anales de estadística aplicada . 6 (3): 950–976. arXiv : 1209.6210 . Bibcode : 2012arXiv1209.6210D. doi :10.1214/12-aoas541. PMC 3568780. PMID 23408514.

- ^ Kutchukian, Peter; Lou, David; Shakhnovich, Eugene (2009). "FOG: Algoritmo de crecimiento optimizado de fragmentos para la generación de novo de moléculas que ocupan sustancias químicas similares a fármacos". Revista de información y modelado químico . 49 (7): 1630–1642. doi :10.1021/ci9000458. PMID 19527020.

- ^ Kutchukian, PS; Lou, D.; Shakhnovich, Eugene I. (15 de junio de 2009). "FOG: Algoritmo de crecimiento optimizado de fragmentos para la generación de novo de moléculas que ocupan un espacio químico similar al de los fármacos". Revista de información y modelado químico . 49 (7): 1630–1642. doi :10.1021/ci9000458. PMID 19527020.

- ^ Kopp, VS; Kaganer, VM; Schwarzkopf, J.; Waidick, F.; Remmele, T.; Kwasniewski, A.; Schmidbauer, M. (2011). "Difracción de rayos X a partir de estructuras en capas no periódicas con correlaciones: cálculo analítico y experimento en películas mixtas de Aurivillius". Acta Crystallographica Sección A . 68 (Pt 1): 148–155. Bibcode :2012AcCrA..68..148K. doi :10.1107/S0108767311044874. PMID 22186291.

- ^ George, Dileep; Hawkins, Jeff (2009). Friston, Karl J. (ed.). "Hacia una teoría matemática de los microcircuitos corticales". PLOS Comput Biol . 5 (10): e1000532. Bibcode :2009PLSCB...5E0532G. doi : 10.1371/journal.pcbi.1000532 . PMC 2749218 . PMID 19816557.

- ^ Gupta, Ankur; Rawlings, James B. (abril de 2014). "Comparación de métodos de estimación de parámetros en modelos cinéticos químicos estocásticos: ejemplos en biología de sistemas". AIChE Journal . 60 (4): 1253–1268. Bibcode :2014AIChE..60.1253G. doi :10.1002/aic.14409. PMC 4946376 . PMID 27429455.

- ^ Aguiar, RJ; Collares-Pereira, M.; Conde, JP (1988). "Procedimiento simple para generar secuencias de valores de radiación diaria utilizando una biblioteca de matrices de transición de Markov". Energía Solar . 40 (3): 269–279. Bibcode :1988SoEn...40..269A. doi :10.1016/0038-092X(88)90049-7.

- ^ Ngoko, BO; Sugihara, H.; Funaki, T. (2014). "Generación sintética de datos de radiación solar de alta resolución temporal utilizando modelos de Markov". Energía solar . 103 : 160–170. Código Bibliográfico :2014SoEn..103..160N. doi :10.1016/j.solener.2014.02.026.

- ^ Bright, JM; Smith, CI; Taylor, PG; Crook, R. (2015). "Generación estocástica de series temporales sintéticas de irradiancia minuciosa derivadas de datos de observación meteorológica horaria media". Energía solar . 115 : 229–242. Bibcode :2015SoEn..115..229B. doi : 10.1016/j.solener.2015.02.032 .

- ^ Munkhammar, J.; Widén, J. (2018). "Un modelo de distribución de mezcla de cadena de Markov de N estados del índice de cielo despejado". Energía solar . 173 : 487–495. Código Bibliográfico :2018SoEn..173..487M. doi :10.1016/j.solener.2018.07.056.

- ^ Morf, H. (1998). "El modelo estocástico de irradiancia solar de dos estados (STSIM)". Energía solar . 62 (2): 101–112. Código Bibliográfico :1998SoEn...62..101M. doi :10.1016/S0038-092X(98)00004-8.

- ^ Munkhammar, J.; Widén, J. (2018). "Un enfoque de mezcla de distribución de probabilidad de cadena de Markov para el índice de cielo despejado". Energía solar . 170 : 174–183. Código Bibliográfico :2018SoEn..170..174M. doi :10.1016/j.solener.2018.05.055.

- ^ Mor, Bhavya; Garhwal, Sunita; Kumar, Ajay (mayo de 2021). "Una revisión sistemática de los modelos ocultos de Markov y sus aplicaciones". Archivos de métodos computacionales en ingeniería . 28 (3): 1429–1448. doi :10.1007/s11831-020-09422-4. ISSN 1134-3060.

- ^ Thomsen, Samuel W. (2009), "Algunas evidencias sobre la génesis de la teoría de la información de Shannon", Estudios en Historia y Filosofía de la Ciencia , 40 : 81–91, doi :10.1016/j.shpsa.2008.12.011

- ^ Pratas, D; Silva, R; Pinho, A; Ferreira, P (18 de mayo de 2015). "Un método sin alineación para encontrar y visualizar reordenamientos entre pares de secuencias de ADN". Informes científicos . 5 (10203): 10203. Código bibliográfico : 2015NatSR...510203P. doi :10.1038/srep10203. PMC 4434998 . PMID 25984837.

- ^ O'Connor, John J.; Robertson, Edmund F. , "Cadena de Markov", Archivo de Historia de las Matemáticas de MacTutor , Universidad de St Andrews

- ^ SP Meyn, 2007. Técnicas de control para redes complejas Archivado el 13 de mayo de 2015 en Wayback Machine , Cambridge University Press, 2007.

- ^ Patente estadounidense 6.285.999

- ^ Gupta, Brij; Agrawal, Dharma P.; Yamaguchi, Shingo (16 de mayo de 2016). Manual de investigación sobre soluciones criptográficas modernas para la seguridad informática y cibernética. IGI Global. pp. 448–. ISBN 978-1-5225-0106-0.

- ^ Langville, Amy N.; Meyer, Carl D. (2006). "Un reordenamiento para el problema de PageRank" (PDF) . Revista SIAM sobre informática científica . 27 (6): 2112–2113. Bibcode :2006SJSC...27.2112L. CiteSeerX 10.1.1.58.8652 . doi :10.1137/040607551.

- ^ Page, Lawrence; Brin, Sergey; Motwani, Rajeev; Winograd, Terry (1999). El sistema de clasificación de citas PageRank: poniendo orden en la Web (informe técnico). CiteSeerX 10.1.1.31.1768 .

- ^ Champernowne, D (1953). "Un modelo de distribución del ingreso". The Economic Journal . 63 (250): 318–51. doi :10.2307/2227127. JSTOR 2227127.

- ^ Simon, Herbert; C Bonini (1958). "La distribución del tamaño de las empresas comerciales". Am. Econ. Rev. 42 : 425–40.

- ^ Bachiller, Louis (1900). "Teoría de la especulación". Annales Scientifiques de l'École Normale Supérieure . 3 : 21–86. doi :10.24033/asens.476. hdl : 2027/coo.31924001082803 .

- ^ p. ej. Fama, E (1965). "El comportamiento de los precios del mercado de valores". Journal of Business . 38 .

- ^ Hamilton, James (1989). "Un nuevo enfoque para el análisis económico de series temporales no estacionarias y el ciclo económico". Econometrica . 57 (2): 357–84. CiteSeerX 10.1.1.397.3582 . doi :10.2307/1912559. JSTOR 1912559.

- ^ Calvet, Laurent E.; Fisher, Adlai J. (2001). "Pronóstico de la volatilidad multifractal". Revista de econometría . 105 (1): 27–58. doi :10.1016/S0304-4076(01)00069-0.

- ^ Calvet, Laurent; Adlai Fisher (2004). "Cómo pronosticar la volatilidad a largo plazo: cambio de régimen y estimación de procesos multifractales". Journal of Financial Econometrics . 2 : 49–83. CiteSeerX 10.1.1.536.8334 . doi :10.1093/jjfinec/nbh003.

- ^ Brennan, Michael; Xiab, Yihong. "Stock Price Volatility and the Equity Premium" (PDF) . Departamento de Finanzas, Anderson School of Management, UCLA . Archivado desde el original (PDF) el 28 de diciembre de 2008.

- ^ "Un ejemplo de cadena de Markov en el modelado del riesgo crediticio" (PDF) . Universidad de Columbia . Archivado desde el original (PDF) el 24 de marzo de 2016.

- ^ Acemoglu, Daron; Georgy Egorov; Konstantin Sonin (2011). "Modelo político de la evolución social". Actas de la Academia Nacional de Ciencias . 108 (Suppl 4): 21292–21296. Bibcode :2011PNAS..10821292A. CiteSeerX 10.1.1.225.6090 . doi : 10.1073/pnas.1019454108 . PMC 3271566 . PMID 22198760.

- ^ K McAlpine; E Miranda; S Hoggar (1999). "Hacer música con algoritmos: un sistema de estudio de caso". Computer Music Journal . 23 (2): 19–30. doi :10.1162/014892699559733.

- ^ Curtis Roads, ed. (1996). El tutorial de música por computadora . MIT Press. ISBN 978-0-262-18158-7.

- ^ Xenakis, Iannis; Kanach, Sharon (1992) Música formalizada: matemáticas y pensamiento en la composición , Pendragon Press. ISBN 1576470792

- ^ "Continuador". Archivado desde el original el 13 de julio de 2012.

- ^ Pachet, F.; Roy, P.; Barbieri, G. (2011) "Procesos de Markov de longitud finita con restricciones" Archivado el 14 de abril de 2012 en Wayback Machine , Actas de la 22.ª Conferencia conjunta internacional sobre inteligencia artificial , IJCAI, páginas 635–642, Barcelona, España, julio de 2011

- ^ Pankin, Mark D. "MODELOS DE CADENA DE MARKOV: ANTECEDENTES TEÓRICOS". Archivado desde el original el 2007-12-09 . Consultado el 2007-11-26 .

- ^ Pankin, Mark D. "EL BÉISBOL COMO CADENA DE MARKOV" . Consultado el 24 de abril de 2009 .

- ^ "El rincón del poeta – Fieralingue". Archivado desde el original el 6 de diciembre de 2010.

- ^ Kenner, Hugh; O'Rourke, Joseph (noviembre de 1984). "Un generador de parodias para micros". BYTE . 9 (12): 129–131, 449–469.

- ^ Hartman, Charles (1996). Virtual Muse: Experimentos en poesía informática . Hanover, NH: Wesleyan University Press. ISBN 978-0-8195-2239-9.

- ^ ab de Souza e Silva, EG; Legey, LFL; de Souza e Silva, EA (2010). "Pronóstico de las tendencias de los precios del petróleo utilizando wavelets y modelos ocultos de Markov". Economía de la energía . 32 .

- ^ ab Carpinone, A; Giorgio, M; Langella, R.; Testa, A. (2015). "Modelado de cadenas de Markov para la previsión de energía eólica a muy corto plazo". Electric Power Systems Research . 122 : 152–158. doi : 10.1016/j.epsr.2014.12.025 .

- ^ Woo, Gordon (1 de abril de 2002). «Evaluación cuantitativa del riesgo de terrorismo». The Journal of Risk Finance . 4 (1): 7–14. doi :10.1108/eb022949 . Consultado el 5 de octubre de 2023 .

- ^ Woo, Gordon (diciembre de 2003). "Insuring Against Al-Quaeda" (PDF) . Cambridge: National Bureau of Economic Research . Consultado el 26 de marzo de 2024 .

- ^ ab Munkhammar, J.; van der Meer, DW; Widén, J. (2019). "Pronóstico probabilístico de series temporales de índice de cielo despejado de alta resolución utilizando un modelo de distribución de mezcla de cadenas de Markov". Energía solar . 184 : 688–695. Código Bibliográfico :2019SoEn..184..688M. doi :10.1016/j.solener.2019.04.014.

Referencias

- AA Markov (1906) "Rasprostranenie zakona bol'shih chisel na velichiny, zavisyaschie drug ot druga". Izvestiya Fiziko-matematicheskogo obschestva pri Kazanskom universitete , 2-ya seriya, tom 15, págs.

- AA Markov (1971). "Extensión de los teoremas límite de la teoría de la probabilidad a una suma de variables conectadas en una cadena". Reimpreso en el Apéndice B de: R. Howard. Sistemas probabilísticos dinámicos, volumen 1: Cadenas de Markov . John Wiley and Sons.

- Texto clásico en traducción: Markov, AA (2006). "Un ejemplo de investigación estadística del texto Eugene Onegin sobre la conexión de muestras en cadenas". Science in Context . 19 (4). Traducido por Link, David: 591–600. doi :10.1017/s0269889706001074.

- Leo Breiman (1992) [1968] Probabilidad . Edición original publicada por Addison-Wesley; reimpresa por la Sociedad de Matemáticas Industriales y Aplicadas ISBN 0-89871-296-3 . (Véase el capítulo 7)

- JL Doob (1953) Procesos estocásticos . Nueva York: John Wiley and Sons ISBN 0-471-52369-0 .

- SP Meyn y RL Tweedie (1993) Markov Chains and Stochastic Stability . Londres: Springer-Verlag ISBN 0-387-19832-6 . en línea: MCSS . Segunda edición en aparecer, Cambridge University Press, 2009.

- Dynkin, Evgeny Borisovich (1965). Procesos de Markov . Grundlehren der mathematischen Wissenschaften. vol. Yo (121). Traducido por Fabio, Jaap; Greenberg, Vida Lázaro; Maitra, Ashok Prasad; Majone, Giandomenico . Berlín: Springer-Verlag . doi :10.1007/978-3-662-00031-1. ISBN 978-3-662-00033-5. Título No. 5104.; Procesos de Markov . Vol. II (122). 1965. doi :10.1007/978-3-662-25360-1. ISBN 978-3-662-23320-7. Título No. 5105.(NB. Este libro fue publicado originalmente en ruso como Марковские процессы ( Markovskiye protsessy ) por Fizmatgiz en 1963 y traducido al inglés con la ayuda del autor).

- SP Meyn. Control Techniques for Complex Networks . Cambridge University Press, 2007. ISBN 978-0-521-88441-9 . El apéndice contiene una versión abreviada de Meyn & Tweedie. En línea: CTCN

- Booth, Taylor L. (1967). Máquinas secuenciales y teoría de autómatas (1.ª ed.). Nueva York, NY: John Wiley and Sons, Inc. Catálogo de fichas de la Biblioteca del Congreso, número 67-25924.] Libro extenso y de amplio alcance, dirigido a especialistas, escrito tanto para científicos informáticos teóricos como para ingenieros eléctricos. Con explicaciones detalladas de técnicas de minimización de estados, fórmulas de función finita, máquinas de Turing, procesos de Markov e indecidibilidad. Excelente tratamiento de los procesos de Markov (pp. 449 y siguientes). Analiza las transformadas Z y D en su contexto.

- Kemeny, John G.; Hazleton Mirkil; J. Laurie Snell; Gerald L. Thompson (1959). Estructuras matemáticas finitas (1.ª ed.). Englewood Cliffs, NJ: Prentice-Hall, Inc. Catálogo de fichas de la Biblioteca del Congreso, número 59-12841.Texto clásico. Véase el Capítulo 6 Cadenas de Markov finitas, págs. 384 y siguientes.

- John G. Kemeny y J. Laurie Snell (1960) Cadenas finitas de Markov , D. van Nostrand Company ISBN 0-442-04328-7

- E. Nummelin. "Cadenas de Markov irreducibles generales y operadores no negativos". Cambridge University Press, 1984, 2004. ISBN 0-521-60494-X

- Seneta, E. Matrices no negativas y cadenas de Markov . 2.ª ed. rev., 1981, XVI, 288 págs., Tapa blanda Springer Series in Statistics. (Publicado originalmente por Allen & Unwin Ltd., Londres, 1973) ISBN 978-0-387-29765-1

- Kishor S. Trivedi , Probabilidad y estadística con confiabilidad, colas y aplicaciones informáticas , John Wiley & Sons, Inc. Nueva York, 2002. ISBN 0-471-33341-7 .

- KS Trivedi y RASahner, SHARPE a la edad de veintidós años , vol. 36, núm. 4, págs. 52–57, Revisión de evaluación del desempeño de ACM SIGMETRICS, 2009.

- RA Sahner, KS Trivedi y A. Puliafito, Análisis de rendimiento y confiabilidad de sistemas informáticos: un enfoque basado en ejemplos utilizando el paquete de software SHARPE , Kluwer Academic Publishers, 1996. ISBN 0-7923-9650-2 .

- G. Bolch, S. Greiner, H. de Meer y KS Trivedi, Redes de colas y cadenas de Markov , John Wiley, 2.ª edición, 2006. ISBN 978-0-7923-9650-5 .

Enlaces externos

- "Cadena de Markov", Enciclopedia de Matemáticas , EMS Press , 2001 [1994]