Matriz (matemáticas)

En matemáticas , una matriz ( pl.: matrices ) es una matriz rectangular o tabla de números , símbolos o expresiones , con elementos o entradas dispuestos en filas y columnas, que se utiliza para representar un objeto matemático o una propiedad de dicho objeto.

Por ejemplo, es una matriz con dos filas y tres columnas. A menudo se la denomina "matriz de dos por tres", " matriz" o matriz de dimensión .

Las matrices se relacionan comúnmente con el álgebra lineal . Las excepciones notables incluyen las matrices de incidencia y las matrices de adyacencia en la teoría de grafos . [1] Este artículo se centra en las matrices relacionadas con el álgebra lineal y, a menos que se especifique lo contrario, todas las matrices representan aplicaciones lineales o pueden considerarse como tales.

Las matrices cuadradas , matrices con el mismo número de filas y columnas, desempeñan un papel importante en la teoría de matrices. Las matrices cuadradas de una dimensión dada forman un anillo no conmutativo , que es uno de los ejemplos más comunes de un anillo no conmutativo. El determinante de una matriz cuadrada es un número asociado con la matriz, que es fundamental para el estudio de una matriz cuadrada; por ejemplo, una matriz cuadrada es invertible si y solo si tiene un determinante distinto de cero y los valores propios de una matriz cuadrada son las raíces de un determinante polinomial .

En geometría , las matrices se utilizan ampliamente para especificar y representar transformaciones geométricas (por ejemplo, rotaciones ) y cambios de coordenadas . En análisis numérico , muchos problemas computacionales se resuelven reduciéndolos a un cálculo matricial, y esto a menudo implica realizar cálculos con matrices de enormes dimensiones. Las matrices se utilizan en la mayoría de las áreas de las matemáticas y los campos científicos, ya sea directamente o mediante su uso en geometría y análisis numérico.

La teoría de matrices es la rama de las matemáticas que se centra en el estudio de las matrices. Inicialmente era una subrama del álgebra lineal , pero pronto se expandió para incluir temas relacionados con la teoría de grafos , el álgebra , la combinatoria y la estadística .

Definición

Una matriz es una matriz rectangular de números (u otros objetos matemáticos), denominadas las entradas de la matriz. Las matrices están sujetas a operaciones estándar como la suma y la multiplicación. [2] Lo más común es que una matriz sobre un cuerpo F sea una matriz rectangular de elementos de F. [3] [4] Una matriz real y una matriz compleja son matrices cuyas entradas son, respectivamente, números reales o números complejos . A continuación se analizan tipos de entradas más generales. Por ejemplo, esta es una matriz real:

Los números, símbolos o expresiones de la matriz se denominan sus entradas o sus elementos . Las líneas horizontales y verticales de entradas de una matriz se denominan filas y columnas , respectivamente.

Tamaño

El tamaño de una matriz se define por el número de filas y columnas que contiene. No hay límite para el número de filas y columnas que una matriz (en el sentido habitual) puede tener siempre que sean números enteros positivos. Una matriz con filas y columnas se denomina matriz, o matriz por matriz, donde y se denominan sus dimensiones . Por ejemplo, la matriz anterior es una matriz.

Las matrices con una sola fila se denominan vectores fila y las que tienen una sola columna se denominan vectores columna . Una matriz con el mismo número de filas y columnas se denomina matriz cuadrada . [5] Una matriz con un número infinito de filas o columnas (o ambas) se denomina matriz infinita. En algunos contextos, como en los programas de álgebra computacional , es útil considerar una matriz sin filas o sin columnas, llamada matriz vacía.

| Nombre | Tamaño | Ejemplo | Descripción | Notación |

|---|---|---|---|---|

| Vector de fila | 1 × n | Una matriz con una fila, a veces utilizada para representar un vector. | ||

| Vector de columna | n × 1 | Una matriz con una columna, a veces utilizada para representar un vector. | ||

| Matriz cuadrada | n × n | Una matriz con el mismo número de filas y columnas, a veces utilizada para representar una transformación lineal de un espacio vectorial a sí mismo, como la reflexión , la rotación o el corte . |

Notación

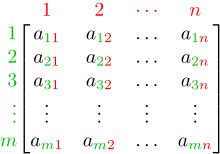

Los detalles de la notación simbólica de matrices varían ampliamente, con algunas tendencias predominantes. Las matrices se escriben comúnmente entre corchetes o paréntesis , de modo que una matriz se representa como Esto se puede abreviar escribiendo solo un término genérico, posiblemente junto con índices, como en o en el caso de que .

Las matrices se simbolizan generalmente con letras mayúsculas (como en los ejemplos anteriores), mientras que las letras minúsculas correspondientes , con dos índices subscritos (por ejemplo, o ), representan las entradas. Además de utilizar letras mayúsculas para simbolizar matrices, muchos autores utilizan un estilo tipográfico especial , comúnmente Roman en negrita (no cursiva), para distinguir aún más las matrices de otros objetos matemáticos. Una notación alternativa implica el uso de un doble subrayado con el nombre de la variable, con o sin estilo en negrita, como en .

La entrada en la fila i y la columna j de una matriz A se denomina a veces entrada o de la matriz y se denota comúnmente por o . Las notaciones alternativas para esa entrada son y . Por ejemplo, la entrada de la siguiente matriz es 5 (también denotada como , o ) :

A veces, las entradas de una matriz se pueden definir mediante una fórmula como . Por ejemplo, cada una de las entradas de la siguiente matriz está determinada por la fórmula .

En este caso, la propia matriz a veces se define mediante esa fórmula, entre corchetes o paréntesis dobles. Por ejemplo, la matriz anterior se define como o . Si el tamaño de la matriz es , la fórmula mencionada anteriormente es válida para cualquier y cualquier . Esto se puede especificar por separado o indicar utilizando como subíndice. Por ejemplo, la matriz anterior es , y se puede definir como o .

Algunos lenguajes de programación utilizan matrices con subíndice doble (o matrices de matrices) para representar una matriz de m por n . Algunos lenguajes de programación comienzan la numeración de los índices de las matrices en cero, en cuyo caso las entradas de una matriz de m por n se indexan mediante y . [6] Este artículo sigue la convención más común en la escritura matemática, donde la enumeración comienza desde 1 .

El conjunto de todas las matrices reales m por n se denota a menudo como o El conjunto de todas las matrices m por n sobre otro cuerpo , o sobre un anillo R , se denota de manera similar como o Si m = n , como en el caso de matrices cuadradas , no se repite la dimensión: o [7] A menudo, , o , se utiliza en lugar de

Operaciones básicas

Se pueden aplicar varias operaciones básicas a las matrices. Algunas, como la transposición y la submatriz, no dependen de la naturaleza de las entradas. Otras, como la suma de matrices , la multiplicación escalar , la multiplicación de matrices y las operaciones de fila , implican operaciones sobre las entradas de la matriz y, por lo tanto, requieren que las entradas de la matriz sean números o pertenezcan a un cuerpo o un anillo . [8]

En esta sección, se supone que las entradas de la matriz pertenecen a un anillo fijo, que normalmente es un campo de números.

Suma, multiplicación escalar, resta y transposición

La suma A + B de dos matrices m × n A y B se calcula entrada por entrada: Por ejemplo,

El producto c A de un número c (también llamado escalar en este contexto) y una matriz A se calcula multiplicando cada entrada de A por c : Esta operación se llama multiplicación escalar , pero su resultado no se llama "producto escalar" para evitar confusiones, ya que "producto escalar" se usa a menudo como sinónimo de " producto interno ". Por ejemplo:

La resta de dos matrices m × n se define componiendo la suma de matrices con la multiplicación escalar por –1 :

La transpuesta de una matriz A m × n es la matriz A n × m (también denotada A tr o t A ) formada al convertir filas en columnas y viceversa: Por ejemplo:

Las propiedades familiares de los números se extienden a estas operaciones con matrices: por ejemplo, la adición es conmutativa , es decir, la suma de matrices no depende del orden de los sumandos: A + B = B + A . [9] La transpuesta es compatible con la adición y la multiplicación escalar, como se expresa por ( c A ) T = c ( A T ) y ( A + B ) T = A T + B T . Finalmente, ( A T ) T = A .

Multiplicación de matrices

La multiplicación de dos matrices se define si y solo si el número de columnas de la matriz izquierda es igual al número de filas de la matriz derecha. Si A es una matriz m × n y B es una matriz n × p , entonces su producto matricial AB es la matriz m × p cuyos valores están dados por el producto escalar de la fila correspondiente de A y la columna correspondiente de B : [10]

donde 1 ≤ i ≤ m y 1 ≤ j ≤ p . [11] Por ejemplo, la entrada subrayada 2340 en el producto se calcula como (2 × 1000) + (3 × 100) + (4 × 10) = 2340:

La multiplicación de matrices satisface las reglas ( AB ) C = A ( BC ) ( asociatividad ), y ( A + B ) C = AC + BC así como C ( A + B ) = CA + CB ( distributividad izquierda y derecha ), siempre que el tamaño de las matrices sea tal que los diversos productos estén definidos. [12] El producto AB puede definirse sin que se defina BA , es decir, si A y B son matrices m × n y n × k , respectivamente, y m ≠ k . Incluso si ambos productos están definidos, generalmente no necesitan ser iguales, es decir:

En otras palabras, la multiplicación de matrices no es conmutativa , en marcado contraste con los números (racionales, reales o complejos), cuyo producto es independiente del orden de los factores. [10] Un ejemplo de dos matrices que no conmutan entre sí es:

mientras

Además de la multiplicación matricial ordinaria que acabamos de describir, también existen otras operaciones con matrices menos utilizadas que pueden considerarse formas de multiplicación, como el producto de Hadamard y el producto de Kronecker . [13] Surgen al resolver ecuaciones matriciales como la ecuación de Sylvester .

Operaciones de fila

Hay tres tipos de operaciones de fila:

- suma de filas, es decir agregar una fila a otra.

- multiplicación de filas, es decir, multiplicar todas las entradas de una fila por una constante distinta de cero;

- cambio de filas, es decir, intercambiar dos filas de una matriz;

Estas operaciones se utilizan de varias maneras, incluida la resolución de ecuaciones lineales y la búsqueda de inversas de matrices .

Submatriz

Una submatriz de una matriz es una matriz que se obtiene eliminando cualquier conjunto de filas y/o columnas. [14] [15] [16] Por ejemplo, a partir de la siguiente matriz de 3 por 4, podemos construir una submatriz de 2 por 3 eliminando la fila 3 y la columna 2:

Los menores y cofactores de una matriz se encuentran calculando el determinante de ciertas submatrices. [16] [17]

Una submatriz principal es una submatriz cuadrada que se obtiene eliminando ciertas filas y columnas. La definición varía de un autor a otro. Según algunos autores, una submatriz principal es una submatriz en la que el conjunto de índices de fila que quedan es el mismo que el conjunto de índices de columna que quedan. [18] [19] Otros autores definen una submatriz principal como aquella en la que las primeras k filas y columnas, para algún número k , son las que quedan; [20] este tipo de submatriz también se ha denominado submatriz principal principal . [21]

Ecuaciones lineales

Las matrices se pueden utilizar para escribir y trabajar de forma compacta con múltiples ecuaciones lineales, es decir, sistemas de ecuaciones lineales. Por ejemplo, si A es una matriz m × n , x designa un vector columna (es decir, una matriz n × 1 ) de n variables x 1 , x 2 , ..., x n , y b es un vector columna m × 1 , entonces la ecuación matricial

es equivalente al sistema de ecuaciones lineales [22]

Usando matrices, esto se puede resolver de manera más compacta de lo que sería posible escribiendo todas las ecuaciones por separado. Si n = m y las ecuaciones son independientes , entonces esto se puede hacer escribiendo

donde A −1 es la matriz inversa de A . Si A no tiene inversa, las soluciones (si las hay) se pueden encontrar utilizando su inversa generalizada .

Transformaciones lineales

Las matrices y la multiplicación de matrices revelan sus características esenciales cuando se relacionan con transformaciones lineales , también conocidas como aplicaciones lineales . Una matriz real m por n A da lugar a una transformación lineal que aplica cada vector x en al producto (matriz) Ax , que es un vector en A la inversa, cada transformación lineal surge de una matriz única m por n A : explícitamente, la entrada ( i , j ) de A es la i ésima coordenada de f ( e j ) , donde e j = (0, ..., 0, 1, 0, ..., 0) es el vector unitario con 1 en la j ésima posición y 0 en el resto. Se dice que la matriz A representa la aplicación lineal f , y A se denomina matriz de transformación de f .

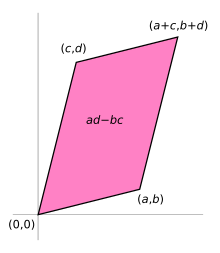

Por ejemplo, la matriz 2×2

puede verse como la transformación del cuadrado unitario en un paralelogramo con vértices en (0, 0) , ( a , b ) , ( a + c , b + d ) y ( c , d ) . El paralelogramo que se muestra a la derecha se obtiene multiplicando A por cada uno de los vectores columna , y , a su vez. Estos vectores definen los vértices del cuadrado unitario.

La siguiente tabla muestra varias matrices reales de 2×2 con las aplicaciones lineales asociadas de El original azul se asigna a la cuadrícula y las formas verdes . El origen (0, 0) está marcado con un punto negro.

| Esfuerzo cortante horizontal con m = 1,25. | Reflexión a través del eje vertical | Mapeo de compresión con r = 3/2 | Escala por un factor de 3/2 | Rotación de π /6 = 30° |

|  |  |  |  |

Bajo la correspondencia 1 a 1 entre matrices y mapas lineales, la multiplicación de matrices corresponde a la composición de mapas: [23] si una matriz B de k por m representa otro mapa lineal , entonces la composición g ∘ f está representada por BA ya que

La última igualdad se deriva de la asociatividad de la multiplicación de matrices antes mencionada.

El rango de una matriz A es el número máximo de vectores fila linealmente independientes de la matriz, que es el mismo que el número máximo de vectores columna linealmente independientes. [24] Equivalentemente, es la dimensión de la imagen del mapa lineal representado por A . [25] El teorema de rango-nulidad establece que la dimensión del núcleo de una matriz más el rango es igual al número de columnas de la matriz. [26]

Matriz cuadrada

Una matriz cuadrada es una matriz con el mismo número de filas y columnas. [5] Una matriz n por n se conoce como una matriz cuadrada de orden n . Se pueden sumar y multiplicar dos matrices cuadradas cualesquiera del mismo orden. Las entradas a ii forman la diagonal principal de una matriz cuadrada. Se encuentran en la línea imaginaria que va desde la esquina superior izquierda hasta la esquina inferior derecha de la matriz.

Tipos principales

Nombre Ejemplo con n = 3 Matriz diagonal Matriz triangular inferior Matriz triangular superior

Matriz diagonal y triangular

Si todas las entradas de A por debajo de la diagonal principal son cero, A se denomina matriz triangular superior . De manera similar, si todas las entradas de A por encima de la diagonal principal son cero, A se denomina matriz triangular inferior . Si todas las entradas fuera de la diagonal principal son cero, A se denomina matriz diagonal .

Matriz de identidad

La matriz identidad I n de tamaño n es la matriz n por n en la que todos los elementos de la diagonal principal son iguales a 1 y todos los demás elementos son iguales a 0, por ejemplo, Es una matriz cuadrada de orden n , y también un tipo especial de matriz diagonal . Se llama matriz identidad porque la multiplicación por ella deja una matriz sin cambios: para cualquier matriz m por n A .

Un múltiplo escalar distinto de cero de una matriz identidad se denomina matriz escalar . Si las entradas de la matriz provienen de un cuerpo, las matrices escalares forman un grupo, en virtud de la multiplicación de matrices, que es isomorfo al grupo multiplicativo de elementos distintos de cero del cuerpo.

Matriz simétrica o antisimétrica

Una matriz cuadrada A que es igual a su transpuesta, es decir, A = A T , es una matriz simétrica . Si, en cambio, A es igual al negativo de su transpuesta, es decir, A = − A T , entonces A es una matriz antisimétrica . En matrices complejas, la simetría se suele sustituir por el concepto de matrices hermíticas , que satisface A ∗ = A , donde la estrella o asterisco denota la transpuesta conjugada de la matriz, es decir, la transpuesta del conjugado complejo de A .

Por el teorema espectral , las matrices simétricas reales y las matrices hermíticas complejas tienen una base propia ; es decir, cada vector se puede expresar como una combinación lineal de vectores propios. En ambos casos, todos los valores propios son reales. [27] Este teorema se puede generalizar a situaciones de dimensión infinita relacionadas con matrices con infinitas filas y columnas, véase más abajo.

Matriz invertible y su inversa

Una matriz cuadrada A se denomina invertible o no singular si existe una matriz B tal que [28] [29] donde I n es la matriz identidad n × n con 1 en la diagonal principal y 0 en el resto. Si B existe, es única y se denomina matriz inversa de A , denotada A −1 .

Matriz definida

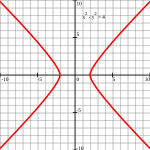

| Matriz definida positiva | Matriz indefinida |

|---|---|

Puntos tales que ( Elipse ) |  Puntos tales que ( Hipérbola ) |

Una matriz real simétrica A se llama definida positiva si la forma cuadrática asociada tiene un valor positivo para cada vector distinto de cero x en Si f ( x ) solo produce valores negativos, entonces A es definida negativamente ; si f produce valores negativos y positivos, entonces A es indefinida . [30] Si la forma cuadrática f produce solo valores no negativos (positivos o cero), la matriz simétrica se llama semidefinida positiva (o si solo produce valores no positivos, entonces semidefinida negativa); por lo tanto, la matriz es indefinida precisamente cuando no es ni semidefinida positiva ni semidefinida negativa.

Una matriz simétrica es positiva-definida si y sólo si todos sus valores propios son positivos, es decir, la matriz es positiva-semidefinida y es invertible. [31] La tabla de la derecha muestra dos posibilidades para matrices de 2 por 2.

Al permitir como entrada dos vectores diferentes, se obtiene la forma bilineal asociada a A : [32]

En el caso de matrices complejas, se aplican la misma terminología y resultado, con matriz simétrica , forma cuadrática , forma bilineal y transpuesta x T reemplazadas respectivamente por matriz hermítica , forma hermítica , forma sesquilineal y transpuesta conjugada x H.

Matriz ortogonal

Una matriz ortogonal es una matriz cuadrada con elementos reales cuyas columnas y filas son vectores unitarios ortogonales (es decir, vectores ortonormales ). De manera equivalente, una matriz A es ortogonal si su transpuesta es igual a su inversa :

Lo que implica

donde I n es la matriz identidad de tamaño n .

Una matriz ortogonal A es necesariamente invertible (con inversa A −1 = A T ), unitaria ( A −1 = A * ), y normal ( A * A = AA * ). El determinante de cualquier matriz ortogonal es +1 o −1 . Una matriz ortogonal especial es una matriz ortogonal con determinante +1. Como transformación lineal , toda matriz ortogonal con determinante +1 es una rotación pura sin reflexión, es decir, la transformación conserva la orientación de la estructura transformada, mientras que toda matriz ortogonal con determinante -1 invierte la orientación, es decir, es una composición de una reflexión pura y una rotación (posiblemente nula). Las matrices identidad tienen determinante 1 y son rotaciones puras por un ángulo cero.

El análogo complejo de una matriz ortogonal es una matriz unitaria .

Operaciones principales

Rastro

La traza tr ( A ) de una matriz cuadrada A es la suma de sus elementos diagonales. Si bien la multiplicación de matrices no es conmutativa como se mencionó anteriormente, la traza del producto de dos matrices es independiente del orden de los factores:

Esto se desprende inmediatamente de la definición de multiplicación de matrices:

De ello se deduce que la traza del producto de más de dos matrices es independiente de las permutaciones cíclicas de las matrices, sin embargo, esto no se aplica en general a permutaciones arbitrarias (por ejemplo, tr( ABC ) ≠ tr( BAC ) , en general). Además, la traza de una matriz es igual a la de su transpuesta, es decir,

Determinante

El determinante de una matriz cuadrada A (denotado det( A ) o | A | ) es un número que codifica ciertas propiedades de la matriz. Una matriz es invertible si y solo si su determinante es distinto de cero. Su valor absoluto es igual al área (en ) o volumen (en ) de la imagen del cuadrado (o cubo) unitario, mientras que su signo corresponde a la orientación de la función lineal correspondiente: el determinante es positivo si y solo si se conserva la orientación.

El determinante de matrices de 2 por 2 viene dado por

- [33]

El determinante de matrices de 3 x 3 implica 6 términos ( regla de Sarrus ). La fórmula de Leibniz, más extensa, generaliza estas dos fórmulas a todas las dimensiones. [34]

El determinante de un producto de matrices cuadradas es igual al producto de sus determinantes: o usando notación alternativa: [35] Sumar un múltiplo de cualquier fila a otra fila, o un múltiplo de cualquier columna a otra columna no cambia el determinante. Intercambiar dos filas o dos columnas afecta al determinante multiplicándolo por −1. [36] Usando estas operaciones, cualquier matriz puede transformarse en una matriz triangular inferior (o superior), y para tales matrices, el determinante es igual al producto de las entradas en la diagonal principal; esto proporciona un método para calcular el determinante de cualquier matriz. Finalmente, la expansión de Laplace expresa el determinante en términos de menores , es decir, determinantes de matrices más pequeñas. [37] Esta expansión puede usarse para una definición recursiva de determinantes (tomando como caso inicial el determinante de una matriz 1 por 1, que es su única entrada, o incluso el determinante de una matriz 0 por 0, que es 1), que puede verse como equivalente a la fórmula de Leibniz. Los determinantes se pueden utilizar para resolver sistemas lineales utilizando la regla de Cramer , donde la división de los determinantes de dos matrices cuadradas relacionadas equivale al valor de cada una de las variables del sistema. [38]

Valores propios y vectores propios

Un número y un vector distinto de cero v que satisfacen

se denominan valor propio y vector propio de A , respectivamente. [39] [40] El número λ es un valor propio de una matriz n × n A si y solo si ( A − λ I n ) no es invertible, lo que es equivalente a

- [41]

El polinomio p A en una indeterminada X dada por la evaluación del determinante det( X I n − A ) se llama polinomio característico de A . Es un polinomio mónico de grado n . Por lo tanto, la ecuación polinómica p A (λ) = 0 tiene como máximo n soluciones diferentes, es decir, valores propios de la matriz. [42] Pueden ser complejos incluso si las entradas de A son reales. Según el teorema de Cayley-Hamilton , p A ( A ) = 0 , es decir, el resultado de sustituir la propia matriz en su polinomio característico produce la matriz cero .

Aspectos computacionales

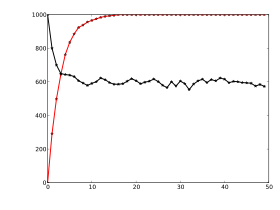

Los cálculos matriciales se pueden realizar a menudo con diferentes técnicas. Muchos problemas se pueden resolver tanto con algoritmos directos como con enfoques iterativos. Por ejemplo, los vectores propios de una matriz cuadrada se pueden obtener hallando una secuencia de vectores x n que convergen a un vector propio cuando n tiende a infinito . [43]

Para elegir el algoritmo más adecuado para cada problema específico, es importante determinar tanto la efectividad como la precisión de todos los algoritmos disponibles. El dominio que estudia estas cuestiones se denomina álgebra lineal numérica . [44] Como ocurre con otras situaciones numéricas, dos aspectos principales son la complejidad de los algoritmos y su estabilidad numérica .

Determinar la complejidad de un algoritmo significa encontrar límites superiores o estimaciones de cuántas operaciones elementales, como sumas y multiplicaciones de escalares, son necesarias para realizar algún algoritmo, por ejemplo, la multiplicación de matrices . Calcular el producto matricial de dos matrices n por n utilizando la definición dada anteriormente necesita n 3 multiplicaciones, ya que para cualquiera de las n 2 entradas del producto, son necesarias n multiplicaciones. El algoritmo de Strassen supera a este algoritmo "ingenuo"; necesita solo n 2,807 multiplicaciones. [45] Un enfoque refinado también incorpora características específicas de los dispositivos informáticos.

En muchas situaciones prácticas, se conoce información adicional sobre las matrices involucradas. Un caso importante son las matrices dispersas , es decir, matrices cuya mayoría de entradas son cero. Existen algoritmos específicamente adaptados para, por ejemplo, resolver sistemas lineales Ax = b para matrices dispersas A , como el método del gradiente conjugado . [46]

Un algoritmo es, en términos generales, numéricamente estable si pequeñas desviaciones en los valores de entrada no conducen a grandes desviaciones en el resultado. Por ejemplo, calcular la inversa de una matriz mediante la expansión de Laplace ( adj( A ) denota la matriz adjunta de A ) puede conducir a errores de redondeo significativos si el determinante de la matriz es muy pequeño. La norma de una matriz se puede utilizar para capturar el condicionamiento de problemas algebraicos lineales, como el cálculo de la inversa de una matriz. [47]

La mayoría de los lenguajes de programación informática admiten matrices, pero no están diseñados con comandos integrados para matrices. En cambio, las bibliotecas externas disponibles proporcionan operaciones matriciales en matrices, en casi todos los lenguajes de programación utilizados actualmente. La manipulación de matrices fue una de las primeras aplicaciones numéricas de las computadoras. [48] El BASIC Dartmouth original tenía comandos integrados para aritmética matricial en matrices desde su implementación de la segunda edición en 1964. Ya en la década de 1970, algunas computadoras de escritorio de ingeniería como la HP 9830 tenían cartuchos ROM para agregar comandos BASIC para matrices . Algunos lenguajes informáticos como APL fueron diseñados para manipular matrices, y se pueden usar varios programas matemáticos para ayudar a la computación con matrices. [49] A partir de 2023, la mayoría de las computadoras tienen algún tipo de operaciones matriciales integradas a un nivel bajo que implementan la especificación BLAS estándar , en la que se basan la mayoría de las bibliotecas de álgebra lineal y de matriz de nivel superior (por ejemplo, EISPACK , LINPACK , LAPACK ). Si bien la mayoría de estas bibliotecas requieren un nivel profesional de codificación, se puede acceder a LAPACK mediante enlaces de nivel superior (y fáciles de usar) como NumPy / SciPy , R , GNU Octave , MATLAB .

Descomposición

Existen varios métodos para convertir las matrices en una forma más accesible. Generalmente se las conoce como técnicas de descomposición matricial o factorización matricial . El interés de todas estas técnicas es que preservan ciertas propiedades de las matrices en cuestión, como el determinante, el rango o la inversa, de modo que estas cantidades se puedan calcular después de aplicar la transformación, o que ciertas operaciones matriciales sean algorítmicamente más fáciles de llevar a cabo para algunos tipos de matrices.

La descomposición LU factoriza matrices como un producto de matrices triangulares inferior ( L ) y superior ( U ). [50] Una vez calculada esta descomposición, los sistemas lineales se pueden resolver de manera más eficiente, mediante una técnica simple llamada sustitución hacia adelante y hacia atrás . Asimismo, las inversas de matrices triangulares son algorítmicamente más fáciles de calcular. La eliminación gaussiana es un algoritmo similar; transforma cualquier matriz a forma escalonada por filas . [51] Ambos métodos proceden multiplicando la matriz por matrices elementales adecuadas , que corresponden a permutar filas o columnas y agregar múltiplos de una fila a otra fila. La descomposición en valores singulares expresa cualquier matriz A como un producto UDV ∗ , donde U y V son matrices unitarias y D es una matriz diagonal.

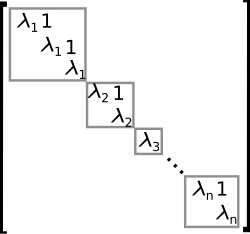

La descomposición propia o diagonalización expresa A como un producto VDV −1 , donde D es una matriz diagonal y V es una matriz invertible adecuada. [52] Si A se puede escribir en esta forma, se llama diagonalizable . De manera más general, y aplicable a todas las matrices, la descomposición de Jordan transforma una matriz en forma normal de Jordan , es decir, matrices cuyas únicas entradas distintas de cero son los valores propios λ 1 a λ n de A , colocados en la diagonal principal y posiblemente entradas iguales a una directamente sobre la diagonal principal, como se muestra a la derecha. [53] Dada la descomposición propia, la n ésima potencia de A (es decir, la multiplicación de matrices iterada n veces) se puede calcular mediante y la potencia de una matriz diagonal se puede calcular tomando las potencias correspondientes de las entradas diagonales, lo que es mucho más fácil que hacer la exponenciación para A en su lugar. Esto se puede utilizar para calcular la exponencial matricial e A , una necesidad que surge con frecuencia al resolver ecuaciones diferenciales lineales , logaritmos matriciales y raíces cuadradas de matrices . [54] Para evitar situaciones numéricamente mal condicionadas , se pueden emplear otros algoritmos como la descomposición de Schur . [55]

Aspectos algebraicos abstractos y generalizaciones

Las matrices se pueden generalizar de diferentes maneras. El álgebra abstracta utiliza matrices con entradas en campos más generales o incluso anillos , mientras que el álgebra lineal codifica las propiedades de las matrices en la noción de mapas lineales. Es posible considerar matrices con infinitas columnas y filas. Otra extensión son los tensores , que pueden verse como matrices de números de dimensiones superiores, a diferencia de los vectores, que a menudo pueden realizarse como secuencias de números, mientras que las matrices son matrices rectangulares o bidimensionales de números. [56] Las matrices, sujetas a ciertos requisitos, tienden a formar grupos conocidos como grupos de matrices. De manera similar, bajo ciertas condiciones, las matrices forman anillos conocidos como anillos de matrices . Aunque el producto de matrices no es en general conmutativo, ciertas matrices forman campos conocidos como campos de matrices . En general, las matrices y su multiplicación también forman una categoría , la categoría de matrices .

Matrices con entradas más generales

Este artículo se centra en matrices cuyas entradas son números reales o complejos. Sin embargo, las matrices pueden considerarse con tipos de entradas mucho más generales que los números reales o complejos. Como primer paso de generalización, cualquier cuerpo , es decir, un conjunto donde las operaciones de suma , resta , multiplicación y división están definidas y se comportan bien, puede usarse en lugar de o por ejemplo números racionales o cuerpos finitos . Por ejemplo, la teoría de codificación hace uso de matrices sobre cuerpos finitos. Siempre que se consideren valores propios , como estos son raíces de un polinomio, pueden existir solo en un cuerpo mayor que el de las entradas de la matriz; por ejemplo, pueden ser complejos en el caso de una matriz con entradas reales. La posibilidad de reinterpretar las entradas de una matriz como elementos de un cuerpo mayor (por ejemplo, ver una matriz real como una matriz compleja cuyas entradas son todas reales) permite entonces considerar que cada matriz cuadrada posee un conjunto completo de valores propios. Alternativamente, se pueden considerar solo matrices con entradas en un campo algebraicamente cerrado , como desde el principio.

De manera más general, las matrices con entradas en un anillo R se usan ampliamente en matemáticas. [57] Los anillos son una noción más general que los campos en el sentido de que no necesita existir una operación de división. Las mismas operaciones de adición y multiplicación de matrices se extienden también a este contexto. El conjunto M( n , R ) (también denotado M n (R) [7] ) de todas las matrices cuadradas n -por- n sobre R es un anillo llamado anillo de matrices , isomorfo al anillo de endomorfismo del módulo R izquierdo R n . [ 58 ] Si el anillo R es conmutativo , es decir, su multiplicación es conmutativa, entonces el anillo M( n , R ) es también un álgebra asociativa sobre R . El determinante de matrices cuadradas sobre un anillo conmutativo R todavía se puede definir utilizando la fórmula de Leibniz ; Una matriz de este tipo es invertible si y sólo si su determinante es invertible en R , generalizando la situación sobre un cuerpo F , donde cada elemento distinto de cero es invertible. [59] Las matrices sobre superanillos se denominan supermatrices . [60]

Las matrices no siempre tienen todas sus entradas en el mismo anillo , o incluso en ningún anillo. Un caso especial pero común son las matrices de bloques , que pueden considerarse como matrices cuyas entradas son matrices. Las entradas no necesitan ser matrices cuadradas y, por lo tanto, no necesitan ser miembros de ningún anillo ; pero sus tamaños deben cumplir ciertas condiciones de compatibilidad.

Relación con los mapas lineales

Las aplicaciones lineales son equivalentes a matrices de m por n , como se describió anteriormente. De manera más general, cualquier aplicación lineal f : V → W entre espacios vectoriales de dimensión finita se puede describir mediante una matriz A = ( a ij ) , después de elegir las bases v 1 , ..., v n de V , y w 1 , ..., w m de W (por lo que n es la dimensión de V y m es la dimensión de W ), que es tal que

En otras palabras, la columna j de A expresa la imagen de v j en términos de los vectores base w I de W ; por lo tanto, esta relación determina de manera única las entradas de la matriz A . La matriz depende de la elección de las bases: diferentes elecciones de bases dan lugar a matrices diferentes, pero equivalentes . [61] Muchas de las nociones concretas anteriores pueden reinterpretarse a la luz de esto, por ejemplo, la matriz transpuesta A T describe la transpuesta de la función lineal dada por A , en relación con las bases duales . [62]

Estas propiedades se pueden replantear de forma más natural: la categoría de matrices con entradas en un campo con multiplicación como composición es equivalente a la categoría de espacios vectoriales de dimensión finita y mapas lineales sobre este campo. [63]

De manera más general, el conjunto de matrices m × n se puede utilizar para representar las funciones R -lineales entre los módulos libres R m y R n para un anillo arbitrario R con unidad. Cuando n = m es posible la composición de estas funciones, y esto da lugar al anillo matricial de matrices n × n que representa el anillo de endomorfismo de R n .

Grupos matriciales

Un grupo es una estructura matemática que consiste en un conjunto de objetos junto con una operación binaria , es decir, una operación que combina dos objetos cualesquiera en un tercero, sujeto a ciertos requisitos. [64] Un grupo en el que los objetos son matrices y la operación del grupo es la multiplicación de matrices se llama grupo matricial . [65] [66] Dado que un grupo de cada elemento debe ser invertible, los grupos matriciales más generales son los grupos de todas las matrices invertibles de un tamaño dado, llamados grupos lineales generales .

Cualquier propiedad de matrices que se conserva bajo productos de matrices e inversas se puede utilizar para definir grupos de matrices adicionales. Por ejemplo, matrices con un tamaño dado y con un determinante de 1 forman un subgrupo de (es decir, un grupo más pequeño contenido en) su grupo lineal general, llamado grupo lineal especial . [67] Las matrices ortogonales , determinadas por la condición forman el grupo ortogonal . [68] Toda matriz ortogonal tiene determinante 1 o −1. Las matrices ortogonales con determinante 1 forman un subgrupo llamado grupo ortogonal especial .

Todo grupo finito es isomorfo a un grupo matricial, como se puede ver al considerar la representación regular del grupo simétrico . [69] Los grupos generales se pueden estudiar utilizando grupos matriciales, que se entienden relativamente bien, utilizando la teoría de la representación . [70]

Matrices infinitas

También es posible considerar matrices con un número infinito de filas y/o columnas [71], aunque, al ser objetos infinitos, no se pueden escribir explícitamente. Lo único que importa es que para cada elemento del conjunto que indexa las filas y cada elemento del conjunto que indexa las columnas, existe una entrada bien definida (estos conjuntos de índices ni siquiera necesitan ser subconjuntos de los números naturales). Las operaciones básicas de suma, resta, multiplicación escalar y transposición aún se pueden definir sin problemas; sin embargo, la multiplicación de matrices puede implicar sumas infinitas para definir las entradas resultantes, y estas no están definidas en general.

Si R es un anillo cualquiera con unidad, entonces el anillo de endomorfismos de como módulo R derecho es isomorfo al anillo de matrices finitas de columna cuyas entradas están indexadas por , y cuyas columnas contienen cada una sólo un número finito de entradas distintas de cero. Los endomorfismos de M considerados como módulo R izquierdo dan como resultado un objeto análogo, las matrices finitas de fila cuyas filas tienen cada una sólo un número finito de entradas distintas de cero.

Si se utilizan matrices infinitas para describir aplicaciones lineales, entonces sólo se pueden utilizar aquellas matrices cuyas columnas tengan sólo un número finito de entradas distintas de cero, por la siguiente razón. Para que una matriz A describa una aplicación lineal f : V → W , se deben haber elegido bases para ambos espacios; recuerde que por definición esto significa que cada vector en el espacio se puede escribir únicamente como una combinación lineal (finita) de vectores base, de modo que escrito como un vector (columna) ve de coeficientes , sólo un número finito de entradas v I son distintas de cero. Ahora bien, las columnas de A describen las imágenes por f de vectores base individuales de V en la base de W , lo que sólo tiene sentido si estas columnas tienen sólo un número finito de entradas distintas de cero. Sin embargo, no hay ninguna restricción en las filas de A : en el producto A · v sólo hay un número finito de coeficientes distintos de cero de v involucrados, por lo que cada una de sus entradas, incluso si se da como una suma infinita de productos, implica sólo un número finito de términos distintos de cero y, por tanto, está bien definida. Además, esto equivale a formar una combinación lineal de las columnas de A que efectivamente involucra solo un número finito de ellas, por lo que el resultado solo tiene un número finito de entradas distintas de cero porque cada una de esas columnas las tiene. Los productos de dos matrices del tipo dado están bien definidos (siempre que los conjuntos de índices de columna y de índices de fila coincidan), son del mismo tipo y corresponden a la composición de aplicaciones lineales.

Si R es un anillo normalizado , entonces la condición de finitud de filas o columnas puede ser relajada. Con la norma en su lugar, se pueden utilizar series absolutamente convergentes en lugar de sumas finitas. Por ejemplo, las matrices cuyas sumas de columnas son secuencias convergentes forman un anillo. Análogamente, las matrices cuyas sumas de filas son series convergentes también forman un anillo.

Las matrices infinitas también se pueden utilizar para describir operadores en espacios de Hilbert , donde surgen cuestiones de convergencia y continuidad , lo que a su vez da lugar a ciertas restricciones que deben imponerse. Sin embargo, el punto de vista explícito de las matrices tiende a ofuscar el asunto, [72] y se pueden utilizar en su lugar las herramientas abstractas y más poderosas del análisis funcional .

Matriz vacía

Una matriz vacía es una matriz en la que el número de filas o columnas (o ambos) es cero. [73] [74] Las matrices vacías ayudan a tratar con mapas que involucran el espacio vectorial cero . Por ejemplo, si A es una matriz de 3 por 0 y B es una matriz de 0 por 3, entonces AB es la matriz cero de 3 por 3 correspondiente al mapa nulo de un espacio tridimensional V a sí mismo, mientras que BA es una matriz de 0 por 0. No existe una notación común para las matrices vacías, pero la mayoría de los sistemas de álgebra computacional permiten crearlas y calcular con ellas. El determinante de la matriz de 0 por 0 es 1 de la siguiente manera con respecto al producto vacío que ocurre en la fórmula de Leibniz para el determinante como 1. Este valor también es consistente con el hecho de que el mapa identidad de cualquier espacio de dimensión finita a sí mismo tiene determinante 1, un hecho que a menudo se usa como parte de la caracterización de determinantes.

Aplicaciones

Existen numerosas aplicaciones de matrices, tanto en matemáticas como en otras ciencias. Algunas de ellas simplemente aprovechan la representación compacta de un conjunto de números en una matriz. Por ejemplo, en la teoría de juegos y la economía , la matriz de pagos codifica el pago para dos jugadores, dependiendo de cuál de un conjunto dado (finito) de estrategias elijan los jugadores. [75] La minería de texto y la compilación automatizada de tesauros utilizan matrices de términos de documento como tf-idf para rastrear frecuencias de ciertas palabras en varios documentos. [76]

Los números complejos se pueden representar mediante matrices reales particulares de 2 por 2 mediante

en las que la adición y la multiplicación de números complejos y matrices se corresponden entre sí. Por ejemplo, las matrices de rotación 2 por 2 representan la multiplicación por algún número complejo de valor absoluto 1, como se indicó anteriormente. Una interpretación similar es posible para los cuaterniones [77] y las álgebras de Clifford en general.

Las primeras técnicas de cifrado, como el cifrado Hill, también utilizaban matrices. Sin embargo, debido a la naturaleza lineal de las matrices, estos códigos son comparativamente fáciles de descifrar. [78] Los gráficos por computadora utilizan matrices para representar objetos; para calcular transformaciones de objetos utilizando matrices de rotación afín para realizar tareas como proyectar un objeto tridimensional en una pantalla bidimensional, correspondiente a una observación teórica de la cámara; y para aplicar convoluciones de imagen como nitidez, desenfoque, detección de bordes y más. [79] Las matrices sobre un anillo polinomial son importantes en el estudio de la teoría del control .

La química utiliza matrices de diversas maneras, en particular desde el uso de la teoría cuántica para analizar el enlace molecular y la espectroscopia . Algunos ejemplos son la matriz de superposición y la matriz de Fock, que se utilizan para resolver las ecuaciones de Roothaan y obtener los orbitales moleculares del método de Hartree-Fock .

Teoría de grafos

La matriz de adyacencia de un grafo finito es una noción básica de la teoría de grafos . [80] Registra qué vértices del grafo están conectados por una arista. Las matrices que contienen sólo dos valores diferentes (1 y 0 significan por ejemplo "sí" y "no", respectivamente) se denominan matrices lógicas . La matriz de distancia (o costo) contiene información sobre las distancias de las aristas. [81] Estos conceptos se pueden aplicar a sitios web conectados por hipervínculos o ciudades conectadas por carreteras, etc., en cuyo caso (a menos que la red de conexión sea extremadamente densa) las matrices tienden a ser dispersas , es decir, contienen pocas entradas distintas de cero. Por lo tanto, se pueden utilizar algoritmos matriciales específicamente diseñados en la teoría de redes .

Análisis y geometría

La matriz hessiana de una función diferenciable consta de las segundas derivadas de ƒ con respecto a las distintas direcciones de coordenadas, es decir, [82]

Codifica información sobre el comportamiento de crecimiento local de la función: dado un punto crítico x = ( x 1 , ..., x n ) , es decir, un punto donde las primeras derivadas parciales de ƒ se desvanecen, la función tiene un mínimo local si la matriz hessiana es definida positiva . La programación cuadrática se puede utilizar para encontrar mínimos o máximos globales de funciones cuadráticas estrechamente relacionadas con las asociadas a matrices (ver arriba). [83]

Otra matriz frecuentemente utilizada en situaciones geométricas es la matriz de Jacobi de una función diferenciable. Si f 1 , ..., f m denotan los componentes de f , entonces la matriz de Jacobi se define como [84]

Si n > m , y si el rango de la matriz de Jacobi alcanza su valor máximo m , f es localmente invertible en ese punto, por el teorema de la función implícita . [85]

Las ecuaciones diferenciales parciales se pueden clasificar considerando la matriz de coeficientes de los operadores diferenciales de orden superior de la ecuación. Para las ecuaciones diferenciales parciales elípticas esta matriz es definida positiva, lo que tiene una influencia decisiva en el conjunto de posibles soluciones de la ecuación en cuestión. [86]

El método de elementos finitos es un método numérico importante para resolver ecuaciones diferenciales parciales, ampliamente aplicado en la simulación de sistemas físicos complejos. Intenta aproximar la solución de alguna ecuación mediante funciones lineales por partes, donde las partes se eligen en relación con una cuadrícula suficientemente fina, que a su vez puede reformularse como una ecuación matricial. [87]

Teoría de la probabilidad y estadística

Las matrices estocásticas son matrices cuadradas cuyas filas son vectores de probabilidad , es decir, cuyas entradas no son negativas y suman uno. Las matrices estocásticas se utilizan para definir cadenas de Markov con un número finito de estados. [88] Una fila de la matriz estocástica proporciona la distribución de probabilidad para la siguiente posición de alguna partícula que se encuentra actualmente en el estado que corresponde a la fila. Las propiedades de los estados absorbentes similares a cadenas de Markov , es decir, estados que cualquier partícula alcanza eventualmente, se pueden leer a partir de los vectores propios de las matrices de transición. [89]

La estadística también utiliza matrices en muchas formas diferentes. [90] La estadística descriptiva se ocupa de describir conjuntos de datos, que a menudo se pueden representar como matrices de datos , que luego pueden someterse a técnicas de reducción de dimensionalidad . La matriz de covarianza codifica la varianza mutua de varias variables aleatorias . [91] Otra técnica que utiliza matrices son los mínimos cuadrados lineales , un método que aproxima un conjunto finito de pares ( x 1 , y 1 ), ( x 2 , y 2 ), ..., ( x N , y N ) , mediante una función lineal

que puede formularse en términos de matrices, relacionadas con la descomposición en valores singulares de matrices. [92]

Las matrices aleatorias son matrices cuyas entradas son números aleatorios, sujetos a distribuciones de probabilidad adecuadas , como la distribución normal de matrices . Más allá de la teoría de la probabilidad, se aplican en dominios que van desde la teoría de números hasta la física . [93] [94]

Simetrías y transformaciones en física

Las transformaciones lineales y las simetrías asociadas desempeñan un papel clave en la física moderna. Por ejemplo, las partículas elementales en la teoría cuántica de campos se clasifican como representaciones del grupo de Lorentz de la relatividad especial y, más específicamente, por su comportamiento bajo el grupo de espín . Las representaciones concretas que involucran las matrices de Pauli y las matrices gamma más generales son una parte integral de la descripción física de los fermiones , que se comportan como espinores . [95] Para los tres quarks más ligeros , existe una representación teórica de grupos que involucra al grupo unitario especial SU(3); para sus cálculos, los físicos utilizan una representación matricial conveniente conocida como las matrices de Gell-Mann , que también se utilizan para el grupo de calibración SU(3) que forma la base de la descripción moderna de las interacciones nucleares fuertes, la cromodinámica cuántica . La matriz Cabibbo–Kobayashi–Maskawa , a su vez, expresa el hecho de que los estados básicos de los quarks que son importantes para las interacciones débiles no son los mismos que, sino que están relacionados linealmente con los estados básicos de los quarks que definen partículas con masas específicas y distintas . [96]

Combinaciones lineales de estados cuánticos

El primer modelo de mecánica cuántica ( Heisenberg , 1925) representó los operadores de la teoría mediante matrices de dimensión infinita que actúan sobre estados cuánticos. [97] Esto también se conoce como mecánica matricial . Un ejemplo particular es la matriz de densidad que caracteriza el estado "mixto" de un sistema cuántico como una combinación lineal de estados propios elementales, "puros" . [98]

Otra matriz sirve como herramienta clave para describir los experimentos de dispersión que forman la piedra angular de la física de partículas experimental: las reacciones de colisión como las que ocurren en los aceleradores de partículas , donde las partículas que no interactúan se dirigen unas hacia otras y chocan en una pequeña zona de interacción, con un nuevo conjunto de partículas que no interactúan como resultado, se pueden describir como el producto escalar de los estados de partículas salientes y una combinación lineal de los estados de partículas entrantes. La combinación lineal está dada por una matriz conocida como la matriz S , que codifica toda la información sobre las posibles interacciones entre partículas. [99]

Modos normales

Una aplicación general de las matrices en física es la descripción de sistemas armónicos acoplados linealmente. Las ecuaciones de movimiento de tales sistemas se pueden describir en forma matricial, con una matriz de masa que multiplica una velocidad generalizada para dar el término cinético, y una matriz de fuerza que multiplica un vector de desplazamiento para caracterizar las interacciones. La mejor manera de obtener soluciones es determinar los vectores propios del sistema , sus modos normales , diagonalizando la ecuación matricial. Técnicas como esta son cruciales cuando se trata de la dinámica interna de las moléculas : las vibraciones internas de sistemas que consisten en átomos componentes mutuamente unidos. [100] También son necesarias para describir vibraciones mecánicas y oscilaciones en circuitos eléctricos. [101]

Óptica geométrica

La óptica geométrica ofrece otras aplicaciones matriciales. En esta teoría aproximada, se descuida la naturaleza ondulatoria de la luz. El resultado es un modelo en el que los rayos de luz son, de hecho, rayos geométricos . Si la desviación de los rayos de luz por los elementos ópticos es pequeña, la acción de una lente o un elemento reflectante sobre un rayo de luz dado se puede expresar como la multiplicación de un vector de dos componentes por una matriz de dos por dos denominada análisis matricial de transferencia de rayos : los componentes del vector son la pendiente del rayo de luz y su distancia desde el eje óptico, mientras que la matriz codifica las propiedades del elemento óptico. Hay dos tipos de matrices, a saber, una matriz de refracción que describe la refracción en la superficie de una lente, y una matriz de traslación , que describe la traslación del plano de referencia a la siguiente superficie refractante, donde se aplica otra matriz de refracción. El sistema óptico, que consiste en una combinación de lentes y/o elementos reflectantes, se describe simplemente mediante la matriz resultante del producto de las matrices de los componentes. [102]

Electrónica

El análisis de malla tradicional y el análisis nodal en electrónica conducen a un sistema de ecuaciones lineales que pueden describirse con una matriz.

El comportamiento de muchos componentes electrónicos se puede describir mediante matrices. Sea A un vector bidimensional con el voltaje de entrada del componente v 1 y la corriente de entrada I 1 como sus elementos, y sea B un vector bidimensional con el voltaje de salida del componente v 2 y la corriente de salida I 2 como sus elementos. Entonces el comportamiento del componente electrónico se puede describir mediante B = H · A , donde H es una matriz 2 x 2 que contiene un elemento de impedancia ( h 12 ), un elemento de admitancia ( h 21 ) y dos elementos adimensionales ( h 11 y h 22 ). Calcular un circuito ahora se reduce a multiplicar matrices.

Historia

Las matrices tienen una larga historia de aplicación en la resolución de ecuaciones lineales , pero se las conocía como matrices hasta el siglo XIX. El texto chino Los nueve capítulos sobre el arte matemático escrito en el siglo X-II a. C. es el primer ejemplo del uso de métodos de matrices para resolver ecuaciones simultáneas , [103] incluido el concepto de determinantes . En 1545, el matemático italiano Gerolamo Cardano introdujo el método en Europa cuando publicó Ars Magna . [104] El matemático japonés Seki utilizó los mismos métodos de matrices para resolver ecuaciones simultáneas en 1683. [105] El matemático holandés Jan de Witt representó transformaciones utilizando matrices en su libro de 1659 Elementos de curvas (1659). [106] Entre 1700 y 1710 Gottfried Wilhelm Leibniz publicitó el uso de matrices para registrar información o soluciones y experimentó con más de 50 sistemas diferentes de matrices. [104] Cramer presentó su regla en 1750.

El término "matriz" (del latín "útero", "presa" (animal hembra no humano mantenido para la reproducción), "fuente", "origen", "lista" y "registro", se derivan de mater —madre [107] ) fue acuñado por James Joseph Sylvester en 1850, [108] quien entendió una matriz como un objeto que da lugar a varios determinantes hoy llamados menores , es decir, determinantes de matrices más pequeñas que derivan de la original eliminando columnas y filas. En un artículo de 1851, Sylvester explica: [109]

En artículos anteriores he definido una "Matriz" como un conjunto rectangular de términos, a partir del cual se pueden generar diferentes sistemas de determinantes a partir del vientre de un padre común.

Arthur Cayley publicó un tratado sobre transformaciones geométricas utilizando matrices que no eran versiones rotadas de los coeficientes que se estaban investigando como se había hecho previamente. En su lugar, definió operaciones como la suma, la resta, la multiplicación y la división como transformaciones de esas matrices y demostró que se mantenían las propiedades asociativas y distributivas. Cayley investigó y demostró la propiedad no conmutativa de la multiplicación de matrices, así como la propiedad conmutativa de la adición de matrices. [104] La teoría de matrices temprana había limitado el uso de matrices casi exclusivamente a determinantes y las operaciones matriciales abstractas de Arthur Cayley fueron revolucionarias. Fue decisivo en la propuesta de un concepto de matriz independiente de los sistemas de ecuaciones. En 1858, Cayley publicó su A memoir on the theory of matrices [110] [111] en la que propuso y demostró el teorema de Cayley-Hamilton . [104]

El matemático inglés Cuthbert Edmund Cullis fue el primero en utilizar la notación de corchetes moderna para matrices en 1913 y simultáneamente demostró el primer uso significativo de la notación A = [ a i,j ] para representar una matriz donde a i,j se refiere a la i- ésima fila y la j -ésima columna. [104]

El estudio moderno de los determinantes surgió de varias fuentes. [112] Los problemas de teoría de números llevaron a Gauss a relacionar los coeficientes de las formas cuadráticas , es decir, expresiones como x 2 + xy − 2 y 2 , y las aplicaciones lineales en tres dimensiones con matrices. Eisenstein desarrolló aún más estas nociones, incluida la observación de que, en el lenguaje moderno, los productos matriciales no son conmutativos . Cauchy fue el primero en demostrar afirmaciones generales sobre los determinantes, utilizando como definición del determinante de una matriz A = [ a i, j ] lo siguiente: reemplace las potencias akj

por un jk en el polinomio

- ,

donde denota el producto de los términos indicados. También demostró, en 1829, que los valores propios de las matrices simétricas son reales. [113] Jacobi estudió los "determinantes funcionales" —posteriormente llamados determinantes de Jacobi por Sylvester— que pueden usarse para describir transformaciones geométricas a nivel local (o infinitesimal ), véase más arriba. Vorlesungen über die Theorie der Determinanten [114] de Kronecker y Zur Determinantentheorie de Weierstrass , [115] ambos publicados en 1903, trataron por primera vez los determinantes de manera axiomática , en oposición a enfoques previos más concretos como la fórmula mencionada de Cauchy. En ese punto, los determinantes quedaron firmemente establecidos.

Muchos teoremas se establecieron primero solo para matrices pequeñas, por ejemplo, el teorema de Cayley-Hamilton fue demostrado para matrices de 2 × 2 por Cayley en la memoria antes mencionada, y por Hamilton para matrices de 4 × 4. Frobenius , trabajando en formas bilineales , generalizó el teorema a todas las dimensiones (1898). También a fines del siglo XIX, la eliminación de Gauss-Jordan (generalizando un caso especial ahora conocido como eliminación de Gauss ) fue establecida por Wilhelm Jordan . A principios del siglo XX, las matrices alcanzaron un papel central en el álgebra lineal, [116] en parte debido a su uso en la clasificación de los sistemas numéricos hipercomplejos del siglo anterior.

El inicio de la mecánica matricial por Heisenberg , Born y Jordan condujo al estudio de matrices con infinitas filas y columnas. [117] Posteriormente, von Neumann llevó a cabo la formulación matemática de la mecánica cuántica , desarrollando aún más nociones analíticas funcionales como los operadores lineales sobre espacios de Hilbert , que, a grandes rasgos, corresponden al espacio euclidiano , pero con una infinidad de direcciones independientes .

Otros usos históricos de la palabra «matriz» en matemáticas

La palabra ha sido utilizada de manera inusual por al menos dos autores de importancia histórica.

Bertrand Russell y Alfred North Whitehead , en sus Principia Mathematica (1910-1913), utilizan la palabra "matriz" en el contexto de su axioma de reducibilidad . Propusieron este axioma como un medio para reducir cualquier función a una de tipo inferior, sucesivamente, de modo que en el "fondo" (orden 0) la función sea idéntica a su extensión : [118]

Denominemos matriz a cualquier función, cualquiera que sea el número de variables, que no implique ninguna variable aparente . Entonces, cualquier función posible distinta de una matriz se deriva de una matriz por generalización, es decir, considerando la proposición de que la función en cuestión es verdadera con todos los valores posibles o con algún valor de uno de los argumentos, permaneciendo indeterminados el otro argumento o los otros argumentos.

Por ejemplo, una función Φ( x, y ) de dos variables x e y puede reducirse a una colección de funciones de una única variable, por ejemplo, y , "considerando" la función para todos los valores posibles de los "individuos" a i sustituidos en lugar de una variable x . Y luego la colección resultante de funciones de la única variable y , es decir, ∀ a i : Φ( a i , y ) , puede reducirse a una "matriz" de valores "considerando" la función para todos los valores posibles de los "individuos" b i sustituidos en lugar de la variable y :

Alfred Tarski en su Introducción a la lógica de 1946 utilizó la palabra "matriz" como sinónimo de la noción de tabla de verdad tal como se utiliza en la lógica matemática. [119]

Véase también

- Lista de matrices con nombre

- Multiplicidad algebraica – Multiplicidad de un valor propio como raíz del polinomio característico

- Multiplicidad geométrica : dimensión del espacio propio asociado a un valor propio

- Proceso de Gram-Schmidt : ortonormalización de un conjunto de vectores

- Matriz irregular

- Cálculo matricial : notación especializada para cálculo multivariable

- Función matricial : Función que asigna matrices a matrices.Pages displaying short descriptions of redirect targets

- Algoritmo de multiplicación de matrices

- Tensor : una generalización de matrices con cualquier número de índices

- Matrices de Bohemia – Conjunto de matrices

- Categoría de matrices — La estructura algebraica formada por matrices y su multiplicación

Notas

- ^ Sin embargo, en el caso de matrices de adyacencia, la multiplicación de matrices o una variante de ella permite el cálculo simultáneo del número de caminos entre dos vértices y de la longitud más corta de un camino entre dos vértices.

- ^ Lang 2002

- ^ Fraleigh (1976, pág. 209)

- ^ Nering (1970, pág. 37)

- ^ de Weisstein, Eric W. "Matrix". mathworld.wolfram.com . Consultado el 19 de agosto de 2020 .

- ^ Oualline 2003, cap. 5

- ^ ab Pop; Furdui (2017). Matrices cuadradas de orden 2. Springer International Publishing. ISBN 978-3-319-54938-5.

- ^ Brown 1991, Definición I.2.1 (suma), Definición I.2.4 (multiplicación escalar) y Definición I.2.33 (transposición)

- ^ Brown 1991, Teorema I.2.6

- ^ ab "Cómo multiplicar matrices". www.mathsisfun.com . Consultado el 19 de agosto de 2020 .

- ^ Brown 1991, Definición I.2.20

- ^ Brown 1991, Teorema I.2.24

- ^ Horn & Johnson 1985, cap. 4 y 5

- ^ Bronson (1970, pág. 16)

- ^ Kreyszig (1972, pág. 220)

- ^ ab Protter y Morrey (1970, pág. 869)

- ^ Kreyszig (1972, págs.241, 244)

- ^ Schneider, Hans; Barker, George Phillip (2012), Matrices y álgebra lineal, Dover Books on Mathematics, Courier Dover Corporation, pág. 251, ISBN 978-0-486-13930-2.

- ^ Perlis, Sam (1991), Teoría de matrices, Libros de Dover sobre matemáticas avanzadas, Courier Dover Corporation, pág. 103, ISBN 978-0-486-66810-9.

- ^ Anton, Howard (2010), Álgebra lineal elemental (10.ª ed.), John Wiley & Sons, pág. 414, ISBN 978-0-470-45821-1.

- ^ Horn, Roger A.; Johnson, Charles R. (2012), Análisis de matrices (2.ª ed.), Cambridge University Press, pág. 17, ISBN 978-0-521-83940-2.

- ^ Brown 1991, I.2.21 y 22

- ^ Greub 1975, Sección III.2

- ^ Brown 1991, Definición II.3.3

- ^ Greub 1975, Sección III.1

- ^ Brown 1991, Teorema II.3.22

- ^ Horn y Johnson 1985, Teorema 2.5.6

- ^ Brown 1991, Definición I.2.28

- ^ Brown 1991, Definición I.5.13

- ^ Horn y Johnson 1985, Capítulo 7

- ^ Horn y Johnson 1985, Teorema 7.2.1

- ^ Horn & Johnson 1985, Ejemplo 4.0.6, pág. 169

- ^ "Matriz | matemáticas". Enciclopedia Británica . Consultado el 19 de agosto de 2020 .

- ^ Brown 1991, Definición III.2.1

- ^ Brown 1991, Teorema III.2.12

- ^ Brown 1991, Corolario III.2.16

- ^ Mirsky 1990, Teorema 1.4.1

- ^ Brown 1991, Teorema III.3.18

- ^ Eigen significa "propio" en alemán y en holandés .

- ^ Brown 1991, Definición III.4.1

- ^ Brown 1991, Definición III.4.9

- ^ Brown 1991, Corolario III.4.10

- ^ Householder 1975, cap. 7

- ^ Bau III y Trefethen 1997

- ^ Golub & Van Loan 1996, Algoritmo 1.3.1

- ^ Golub & Van Loan 1996, Capítulos 9 y 10, especialmente la sección 10.2

- ^ Golub y Van Loan 1996, Capítulo 2.3

- ^ Grcar, Joseph F. (1 de enero de 2011). "Análisis de la eliminación gaussiana de John von Neumann y los orígenes del análisis numérico moderno". SIAM Review . 53 (4): 607–682. doi :10.1137/080734716. ISSN 0036-1445.

- ^ Por ejemplo, Mathematica , véase Wolfram 2003, cap. 3.7

- ^ Press, Flannery y Teukolsky y otros, 1992

- ^ Stoer y Bulirsch 2002, sección 4.1

- ^ Horn y Johnson 1985, Teorema 2.5.4

- ^ Horn y Johnson 1985, cap. 3.1, 3.2

- ^ Arnold y Cooke 1992, Secciones 14.5, 7, 8

- ^ Bronson 1989, cap. 15

- ^ Coburn 1955, cap. V

- ^ Lang 2002, Capítulo XIII

- ^ Lang 2002, XVII.1, pág. 643

- ^ Lang 2002, Proposición XIII.4.16

- ^ Reichl 2004, Sección L.2

- ^ Greub 1975, Sección III.3

- ^ Greub 1975, Sección III.3.13

- ^ Perrone (2024), págs. 99-100

- ^ Ver cualquier referencia estándar en un grupo.

- ^ Además, el grupo debe estar cerrado en el grupo lineal general.

- ^ Baker 2003, Definición 1.30

- ^ Baker 2003, Teorema 1.2

- ^ Artin 1991, Capítulo 4.5

- ^ Rowen 2008, Ejemplo 19.2, pág. 198

- ^ Véase cualquier referencia en teoría de la representación o representación de grupos .

- ^ Véase el artículo "Matrix" en Itõ, ed. 1987

- ^ "No hay mucho de la teoría de matrices que se pueda trasladar a espacios de dimensión infinita, y lo que sí se puede trasladar no es tan útil, pero a veces ayuda". Halmos 1982, p. 23, Capítulo 5

- ^ "Matriz vacía: una matriz está vacía si la dimensión de su fila o columna es cero", Glosario Archivado el 29 de abril de 2009 en Wayback Machine , Guía del usuario de O-Matrix v6

- ^ "Una matriz que tiene al menos una dimensión igual a cero se denomina matriz vacía", Estructuras de datos de MATLAB Archivado el 28 de diciembre de 2009 en Wayback Machine.

- ^ Fudenberg y Tirole 1983, Sección 1.1.1

- ^ Manning 1999, Sección 15.3.4

- ^ Ward 1997, cap. 2.8

- ^ Stinson 2005, cap. 1.1.5 y 1.2.4

- ^ Asociación de Maquinaria Informática 1979, cap. 7

- ^ Godsil y Royle 2004, cap. 8.1

- ^ Punnen 2002

- ^ Lang 1987a, cap. XVI.6

- ^ Nocedal 2006, cap. 16

- ^ Lang 1987a, cap. XVI.1

- ^ Lang 1987a, cap. XVI.5. Para una exposición más amplia y general, véase Lang 1969, cap. VI.2.

- ^ Gilbarg y Trudinger 2001

- ^ Šolin 2005, cap. 2.5. Véase también método de rigidez .

- ^ Latouche y Ramaswami 1999

- ^ Mehata y Srinivasan 1978, cap. 2.8

- ^ Healy, Michael (1986), Matrices para estadísticas , Oxford University Press , ISBN 978-0-19-850702-4

- ^ Krzanowski 1988, cap. 2.2., pág. 60

- ^ Krzanowski 1988, cap. 4.1

- ^ Conrey 2007

- ^ Zabrodin, Brezin y Kazakov et al. 2006

- ^ Itzykson y Zuber 1980, cap. 2

- ^ ver Burgess & Moore 2007, sección 1.6.3. (SU(3)), sección 2.4.3.2. (Matriz Kobayashi-Maskawa)

- ^ Schiff 1968, cap. 6

- ^ Bohm 2001, secciones II.4 y II.8

- ^ Weinberg 1995, cap. 3

- ^ Wherrett 1987, parte II

- ^ Riley, Hobson y Bence 1997, 7.17

- ^ Guenther 1990, cap. 5

- ^ Shen, Crossley y Lun 1999 citados por Bretscher 2005, pág. 1

- ^ abcde Matemáticas discretas 4.ª ed. Dossey, Otto, Spense, Vanden Eynden, publicado por Addison Wesley, 10 de octubre de 2001 ISBN 978-0-321-07912-1 , pág. 564-565

- ^ Needham, Joseph ; Wang Ling (1959). Ciencia y civilización en China. Vol. III. Cambridge: Cambridge University Press. pág. 117. ISBN 978-0-521-05801-8.

- ^ Matemáticas discretas 4.ª ed. Dossey, Otto, Spense, Vanden Eynden, publicado por Addison Wesley, 10 de octubre de 2001 ISBN 978-0-321-07912-1 , pág. 564

- ^ Diccionario Merriam-Webster, Merriam-Webster , consultado el 20 de abril de 2009

- ^ Aunque muchas fuentes afirman que JJ Sylvester acuñó el término matemático "matriz" en 1848, Sylvester no publicó nada en 1848. (Para la prueba de que Sylvester no publicó nada en 1848, véase JJ Sylvester con HF Baker, ed., The Collected Mathematical Papers of James Joseph Sylvester (Cambridge, Inglaterra: Cambridge University Press, 1904), vol. 1.) Su primer uso del término "matriz" ocurre en 1850 en JJ Sylvester (1850) "Adiciones a los artículos en el número de septiembre de esta revista, "Sobre una nueva clase de teoremas", y sobre el teorema de Pascal", The London, Edinburgh, and Dublin Philosophical Magazine and Journal of Science , 37 : 363-370. De la página 369: "Para este propósito, debemos comenzar, no con un cuadrado, sino con una disposición oblonga de términos que consiste, supongamos, en m líneas y n columnas. Esto no representa en sí mismo un determinante, sino que es, por así decirlo, una Matriz a partir de la cual podemos formar varios sistemas de determinantes..."

- ^ Los documentos matemáticos recopilados de James Joseph Sylvester: 1837–1853, Documento 37, pág. 247

- ^ Phil.Trans. 1858, vol. 148, págs . 17-37, Documentos de matemáticas II 475-496

- ^ Dieudonné, ed. 1978, vol. 1, cap. III, pág. 96

- ^ Knobloch 1994

- ^ Hawkins 1975

- ^ Kronecker 1897

- ^ Weierstrass 1915, págs. 271–286

- ^ Bôcher 2004

- ^ Mehra y Rechenberg 1987

- ^ Whitehead, Alfred North; y Russell, Bertrand (1913) Principia Mathematica hasta *56 , Cambridge en University Press, Cambridge, Reino Unido (republicado en 1962) cf página 162ff.

- ^ Tarski, Alfred; (1946) Introducción a la lógica y la metodología de las ciencias deductivas , Dover Publications, Inc, Nueva York NY, ISBN 0-486-28462-X .

Referencias

- Anton, Howard (1987), Álgebra lineal elemental (5.ª ed.), Nueva York: Wiley , ISBN 0-471-84819-0

- Arnold, Vladimir I. ; Cooke, Roger (1992), Ecuaciones diferenciales ordinarias , Berlín, DE; Nueva York, NY: Springer-Verlag , ISBN 978-3-540-54813-3

- Artin, Michael (1991), Álgebra , Prentice Hall , ISBN 978-0-89871-510-1

- Asociación para Maquinaria Computacional (1979), Gráficos de Computadora , Tata McGraw–Hill, ISBN 978-0-07-059376-3

- Baker, Andrew J. (2003), Grupos matriciales: una introducción a la teoría de los grupos de mentiras , Berlín, DE; Nueva York, Nueva York: Springer-Verlag, ISBN 978-1-85233-470-3

- Bau III, David; Trefethen, Lloyd N. (1997), Álgebra lineal numérica , Filadelfia, PA: Sociedad de Matemáticas Industriales y Aplicadas, ISBN 978-0-89871-361-9

- Beauregard, Raymond A.; Fraleigh, John B. (1973), Un primer curso de álgebra lineal: con introducción opcional a grupos, anillos y campos , Boston: Houghton Mifflin Co. , ISBN 0-395-14017-X

- Bretscher, Otto (2005), Álgebra lineal con aplicaciones (3.ª ed.), Prentice Hall

- Bronson, Richard (1970), Métodos matriciales: una introducción , Nueva York: Academic Press , LCCN 70097490

- Bronson, Richard (1989), Esquema de Schaum de la teoría y los problemas de las operaciones matriciales , Nueva York: McGraw–Hill , ISBN 978-0-07-007978-6

- Brown, William C. (1991), Matrices y espacios vectoriales , Nueva York, NY: Marcel Dekker , ISBN 978-0-8247-8419-5

- Coburn, Nathaniel (1955), Análisis de vectores y tensores , Nueva York, NY: Macmillan, OCLC 1029828

- Conrey, J. Brian (2007), Rangos de curvas elípticas y teoría de matrices aleatorias , Cambridge University Press , ISBN 978-0-521-69964-8

- Fraleigh, John B. (1976), Un primer curso de álgebra abstracta (2.ª ed.), Lectura: Addison-Wesley , ISBN 0-201-01984-1

- Fudenberg, Drew; Tirole, Jean (1983), Teoría de juegos , MIT Press

- Gilbarg, David; Trudinger, Neil S. (2001), Ecuaciones diferenciales parciales elípticas de segundo orden (2.ª ed.), Berlín, DE; Nueva York, NY: Springer-Verlag, ISBN 978-3-540-41160-4

- Godsil, Chris ; Royle, Gordon (2004), Teoría de grafos algebraicos , Textos de posgrado en matemáticas, vol. 207, Berlín, DE; Nueva York, NY: Springer-Verlag, ISBN 978-0-387-95220-8

- Golub, Gene H. ; Van Loan, Charles F. (1996), Cálculos matriciales (3.ª ed.), Johns Hopkins, ISBN 978-0-8018-5414-9

- Greub, Werner Hildbert (1975), Álgebra lineal , Textos de Graduado en Matemáticas, Berlín, DE; Nueva York, Nueva York: Springer-Verlag, ISBN 978-0-387-90110-7

- Halmos, Paul Richard (1982), Un libro de problemas del espacio de Hilbert , Graduate Texts in Mathematics, vol. 19 (2.ª ed.), Berlín, DE; Nueva York, NY: Springer-Verlag, ISBN 978-0-387-90685-0, Sr. 0675952

- Horn, Roger A. ; Johnson, Charles R. (1985), Análisis de matrices , Cambridge University Press, ISBN 978-0-521-38632-6

- Householder, Alston S. (1975), La teoría de matrices en el análisis numérico , Nueva York, NY: Dover Publications , MR 0378371

- Kreyszig, Erwin (1972), Matemáticas avanzadas de ingeniería (3.ª ed.), Nueva York: Wiley , ISBN 0-471-50728-8.

- Krzanowski, Wojtek J. (1988), Principios del análisis multivariado , Oxford Statistical Science Series, vol. 3, The Clarendon Press Oxford University Press, ISBN 978-0-19-852211-9, Sr. 0969370

- Itô, Kiyosi, ed. (1987), Diccionario enciclopédico de matemáticas. vol. I-IV (2ª ed.), MIT Press, ISBN 978-0-262-09026-1, Sr. 0901762

- Lang, Serge (1969), Análisis II , Addison-Wesley

- Lang, Serge (1987a), Cálculo de varias variables (3.ª ed.), Berlín, DE; Nueva York, NY: Springer-Verlag, ISBN 978-0-387-96405-8

- Lang, Serge (1987b), Álgebra lineal , Berlín, DE; Nueva York, Nueva York: Springer-Verlag, ISBN 978-0-387-96412-6

- Lang, Serge (2002), Álgebra , Textos de posgrado en matemáticas , vol. 211 (tercera edición revisada), Nueva York: Springer-Verlag, ISBN 978-0-387-95385-4, Sr. 1878556

- Latouche, Guy; Ramaswami, Vaidyanathan (1999), Introducción a los métodos analíticos matriciales en el modelado estocástico (1.ª ed.), Filadelfia, PA: Society for Industrial and Applied Mathematics, ISBN 978-0-89871-425-8

- Manning, Christopher D.; Schütze, Hinrich (1999), Fundamentos del procesamiento estadístico del lenguaje natural , MIT Press, ISBN 978-0-262-13360-9

- Mehata, KM; Srinivasan, SK (1978), Procesos estocásticos , Nueva York, NY: McGraw–Hill, ISBN 978-0-07-096612-3

- Mirsky, Leonid (1990), Introducción al álgebra lineal, Courier Dover Publications, ISBN 978-0-486-66434-7

- Nering, Evar D. (1970), Álgebra lineal y teoría de matrices (2.ª ed.), Nueva York: Wiley , LCCN 76-91646

- Nocedal, Jorge; Wright, Stephen J. (2006), Optimización numérica (2.ª ed.), Berlín, DE; Nueva York, NY: Springer-Verlag, pág. 449, ISBN 978-0-387-30303-1

- Oualline, Steve (2003), Programación práctica en C++ , O'Reilly , ISBN 978-0-596-00419-4

- Perrone, Paolo (2024), Teoría de categorías iniciales, World Scientific, doi :10.1142/9789811286018_0005, ISBN 978-981-12-8600-1

- Press, William H.; Flannery, Brian P.; Teukolsky, Saul A .; Vetterling, William T. (1992), "LU Decomposition and Its Applications" (PDF) , Recetas numéricas en FORTRAN: el arte de la computación científica (2.ª ed.), Cambridge University Press, págs. 34–42, archivado desde el original el 6 de septiembre de 2009

{{citation}}: CS1 maint: unfit URL (link) - Protter, Murray H.; Morrey, Charles B. Jr. (1970), Cálculo universitario con geometría analítica (2.ª ed.), Reading: Addison-Wesley , LCCN 76087042

- Punnen, Abraham P.; Gutin, Gregory (2002), El problema del viajante de comercio y sus variaciones , Boston, MA: Kluwer Academic Publishers, ISBN 978-1-4020-0664-7

- Reichl, Linda E. (2004), La transición al caos: sistemas clásicos conservadores y manifestaciones cuánticas , Berlín, DE; Nueva York, NY: Springer-Verlag, ISBN 978-0-387-98788-0

- Rowen, Louis Halle (2008), Álgebra de posgrado: visión no conmutativa , Providence, RI: American Mathematical Society , ISBN 978-0-8218-4153-2

- Šolin, Pavel (2005), Ecuaciones diferenciales parciales y el método de elementos finitos , Wiley-Interscience , ISBN 978-0-471-76409-0

- Stinson, Douglas R. (2005), Criptografía , Matemáticas discretas y sus aplicaciones, Chapman & Hall/CRC, ISBN 978-1-58488-508-5

- Stoer, Josef; Bulirsch, Roland (2002), Introducción al análisis numérico (3ª ed.), Berlín, DE; Nueva York, Nueva York: Springer-Verlag, ISBN 978-0-387-95452-3

- Ward, JP (1997), Cuaterniones y números de Cayley , Matemáticas y sus aplicaciones, vol. 403, Dordrecht, NL: Kluwer Academic Publishers Group, doi :10.1007/978-94-011-5768-1, ISBN 978-0-7923-4513-8, Sr. 1458894

- Wolfram, Stephen (2003), El libro de Mathematica (quinta edición), Champaign, IL: Wolfram Media, ISBN 978-1-57955-022-6

Referencias de física

- Bohm, Arno (2001), Mecánica cuántica: fundamentos y aplicaciones , Springer, ISBN 0-387-95330-2

- Burgess, Cliff; Moore, Guy (2007), El modelo estándar. Una introducción , Cambridge University Press, ISBN 978-0-521-86036-9

- Guenther, Robert D. (1990), Óptica moderna , John Wiley, ISBN 0-471-60538-7

- Itzykson, Claude; Zuber, Jean-Bernard (1980), Teoría cuántica de campos , McGraw-Hill, ISBN 0-07-032071-3

- Riley, Kenneth F.; Hobson, Michael P.; Bence, Stephen J. (1997), Métodos matemáticos para la física y la ingeniería , Cambridge University Press, ISBN 0-521-55506-X

- Schiff, Leonard I. (1968), Mecánica cuántica (3.ª ed.), McGraw–Hill

- Weinberg, Steven (1995), La teoría cuántica de campos. Volumen I: Fundamentos, Cambridge University Press, ISBN 0-521-55001-7

- Wherrett, Brian S. (1987), Teoría de grupos para átomos, moléculas y sólidos , Prentice–Hall International, ISBN 0-13-365461-3

- Zabrodin, Antón; Brezin, Édouard; Kazakov, Vladimir; Serbio, Didina; Wiegmann, Paul (2006), Aplicaciones de matrices aleatorias en física (Serie científica II de la OTAN: Matemáticas, física y química) , Berlín, DE; Nueva York, Nueva York: Springer-Verlag , ISBN 978-1-4020-4530-1

Referencias históricas

- A. Cayley Memorias sobre la teoría de matrices . Phil. Trans. 148 1858 17–37; Math. Papers II 475–496

- Bôcher, Maxime (2004), Introducción al álgebra superior , Nueva York, NY: Dover Publications , ISBN 978-0-486-49570-5, reimpresión de la edición original de 1907

- Cayley, Arthur (1889), Los documentos matemáticos recopilados de Arthur Cayley, vol. I (1841–1853), Cambridge University Press , págs. 123–126

- Dieudonné, Jean , ed. (1978), Abrégé d'histoire des mathématiques 1700-1900 , París, FR: Hermann