Descomposición en valores singulares

- Arriba: La acción de M , indicada por su efecto sobre el disco unitario D y los dos vectores unitarios canónicos e 1 y e 2 .

- Izquierda: La acción de V ⁎ , una rotación, sobre D , e 1 y e 2 .

- Abajo: La acción de Σ , una escala por los valores singulares σ 1 horizontalmente y σ 2 verticalmente.

- Derecha: La acción de U , otra rotación.

En álgebra lineal , la descomposición en valores singulares ( SVD ) es una factorización de una matriz real o compleja en una rotación, seguida de un reescalamiento seguido de otra rotación. Generaliza la descomposición propia de una matriz normal cuadrada con una base propia ortonormal a cualquier matriz . Está relacionada con la descomposición polar .

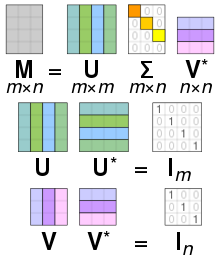

Específicamente, la descomposición en valores singulares de una matriz compleja es una factorización de la forma donde es una matriz unitaria compleja , es una matriz diagonal rectangular con números reales no negativos en la diagonal, es una matriz unitaria compleja y es la transpuesta conjugada de . Dicha descomposición siempre existe para cualquier matriz compleja. Si es real, entonces y se puede garantizar que son matrices ortogonales reales ; en tales contextos, la SVD a menudo se denota

Las entradas diagonales de están determinadas de forma única por y se conocen como valores singulares de . El número de valores singulares distintos de cero es igual al rango de . Las columnas de y las columnas de se denominan vectores singulares izquierdos y vectores singulares derechos de , respectivamente. Forman dos conjuntos de bases ortonormales y y si se ordenan de modo que los valores singulares con valor cero estén todos en las columnas (o filas) con el número más alto, la descomposición en valores singulares se puede escribir como

¿Dónde está el rango de

La descomposición SVD no es única, sin embargo, siempre es posible elegir la descomposición de modo que los valores singulares estén en orden descendente. En este caso, (pero no y ) está determinada de manera única por

El término a veces se refiere a la descomposición SVD compacta , una descomposición similar en la que es una diagonal cuadrada de tamaño donde es el rango de y tiene solo los valores singulares distintos de cero. En esta variante, es una matriz semiunitaria y es una matriz semiunitaria , tal que

Las aplicaciones matemáticas de la descomposición en valores singulares incluyen el cálculo de la pseudoinversa , la aproximación matricial y la determinación del rango, el rango y el espacio nulo de una matriz. La descomposición en valores singulares también es extremadamente útil en todas las áreas de la ciencia, la ingeniería y la estadística , como el procesamiento de señales , el ajuste de datos por mínimos cuadrados y el control de procesos .

Interpretaciones intuitivas

Rotación, escala de coordenadas y reflexión

En el caso especial en que es una matriz cuadrada real , las matrices y pueden elegirse como matrices reales también . En ese caso, "unitario" es lo mismo que " ortogonal " . Entonces, interpretando tanto las matrices unitarias como la matriz diagonal, resumida aquí como como una transformación lineal del espacio las matrices y representan rotaciones o reflexiones del espacio, mientras que representa el escalado de cada coordenada por el factor Así, la descomposición SVD descompone cualquier transformación lineal de en una composición de tres transformaciones geométricas : una rotación o reflexión ( ), seguida de un escalado coordenada por coordenada ( ), seguido de otra rotación o reflexión ( ).

En particular, si tiene un determinante positivo, entonces y pueden elegirse para que sean ambas rotaciones con reflexiones, o ambas rotaciones sin reflexiones. [ cita requerida ] Si el determinante es negativo, exactamente uno de ellos tendrá una reflexión. Si el determinante es cero, cada uno puede elegirse independientemente para que sea de cualquier tipo.

Si la matriz es real pero no cuadrada, es decir con se puede interpretar como una transformación lineal de a Entonces y se pueden elegir para que sean rotaciones/reflexiones de y respectivamente; y además de escalar las primeras coordenadas, también extiende el vector con ceros, es decir, elimina las coordenadas finales, de modo de convertir en

Valores singulares como semiejes de una elipse o elipsoide

Como se muestra en la figura, los valores singulares se pueden interpretar como la magnitud de los semiejes de una elipse en 2D. Este concepto se puede generalizar al espacio euclidiano -dimensional , con los valores singulares de cualquier matriz cuadrada siendo vistos como la magnitud del semieje de un elipsoide -dimensional . De manera similar, los valores singulares de cualquier matriz se pueden ver como la magnitud del semieje de un elipsoide -dimensional en el espacio -dimensional, por ejemplo como una elipse en un plano 2D (inclinado) en un espacio 3D. Los valores singulares codifican la magnitud del semieje, mientras que los vectores singulares codifican la dirección. Vea a continuación para más detalles.

Las columnas detúyVson bases ortonormales

Dado que y son unitarios, las columnas de cada uno de ellos forman un conjunto de vectores ortonormales , que pueden considerarse como vectores base . La matriz asigna el vector base al vector unitario estirado Por la definición de una matriz unitaria, lo mismo es cierto para sus transpuestas conjugadas y excepto que se pierde la interpretación geométrica de los valores singulares como estiramientos. En resumen, las columnas de y son bases ortonormales . Cuando es una matriz hermítica semidefinida positiva , y son ambas iguales a la matriz unitaria utilizada para diagonalizar Sin embargo, cuando no es semidefinida positiva y hermítica pero aún es diagonalizable , su descomposición propia y su descomposición en valores singulares son distintas.

Relación con los cuatro subespacios fundamentales

- Las primeras columnas de son una base del espacio de columnas de .

- Las últimas columnas de son una base del espacio nulo de .

- Las primeras columnas de son una base del espacio de columnas de ( el espacio de filas de en el caso real).

- Las últimas columnas de son una base del espacio nulo de .

Significado geométrico

Como y son unitarios, sabemos que las columnas de producen una base ortonormal de y las columnas de producen una base ortonormal de (con respecto a los productos escalares estándar en estos espacios).

tiene una descripción particularmente simple con respecto a estas bases ortonormales: tenemos

donde es la -ésima entrada diagonal de y para

El contenido geométrico del teorema SVD puede entonces resumirse de la siguiente manera: para cada función lineal se pueden encontrar bases ortonormales de y tales que asigna el -ésimo vector base de a un múltiplo no negativo del -ésimo vector base de y envía los vectores base restantes a cero. Con respecto a estas bases, la función se representa, por lo tanto, mediante una matriz diagonal con entradas diagonales reales no negativas.

Para obtener una idea más visual de los valores singulares y la factorización SVD –al menos cuando se trabaja con espacios vectoriales reales–, considere la esfera de radio uno en La función lineal asigna esta esfera a un elipsoide en Los valores singulares distintos de cero son simplemente las longitudes de los semiejes de este elipsoide. Especialmente cuando y todos los valores singulares son distintos y distintos de cero, la SVD de la función lineal se puede analizar fácilmente como una sucesión de tres movimientos consecutivos: considere el elipsoide y específicamente sus ejes; luego considere las direcciones en enviadas por sobre estos ejes. Estas direcciones resultan ser mutuamente ortogonales. Aplica primero una isometría enviando estas direcciones a los ejes de coordenadas de En un segundo movimiento, aplica un endomorfismo diagonalizado a lo largo de los ejes de coordenadas y estirándose o encogiéndose en cada dirección, usando las longitudes de los semiejes de como coeficientes de estiramiento. La composición envía luego la esfera-unidad sobre un elipsoide isométrico a Para definir el tercer y último movimiento, aplica una isometría a este elipsoide para obtener Como se puede comprobar fácilmente, la composición coincide con

Ejemplo

Considere la matriz

Una descomposición en valores singulares de esta matriz viene dada por

La matriz de escala es cero fuera de la diagonal (cursiva gris) y un elemento de la diagonal es cero (negrita roja, negrita azul claro en modo oscuro). Además, debido a que las matrices y son unitarias , al multiplicarlas por sus respectivas transpuestas conjugadas se obtienen matrices identidad , como se muestra a continuación. En este caso, debido a que y tienen valores reales, cada una es una matriz ortogonal .

Esta descomposición en valores singulares en particular no es única. Elegir de manera que

También es una descomposición en valores singulares válida.

SVD y descomposición espectral

Valores singulares, vectores singulares y su relación con la SVD

Un número real no negativo es un valor singular para si y solo si existen vectores de longitud unitaria en y en tales que

Los vectores y se denominan vectores singulares izquierdos y singulares derechos para respectivamente.

En cualquier descomposición en valores singulares

Las entradas diagonales de son iguales a los valores singulares de Las primeras columnas de y son, respectivamente, vectores singulares izquierdo y derecho para los valores singulares correspondientes. En consecuencia, el teorema anterior implica que:

- Una matriz tiene como máximo valores singulares distintos .

- Siempre es posible encontrar una base unitaria para con un subconjunto de vectores base que abarcan los vectores singulares izquierdos de cada valor singular de

- Siempre es posible encontrar una base unitaria para con un subconjunto de vectores base que abarcan los vectores singulares derechos de cada valor singular de

Un valor singular para el cual podemos encontrar dos vectores singulares izquierdos (o derechos) que son linealmente independientes se llama degenerado . Si y son dos vectores singulares izquierdos que corresponden ambos al valor singular σ, entonces cualquier combinación lineal normalizada de los dos vectores es también un vector singular izquierdo correspondiente al valor singular σ. La afirmación similar es cierta para los vectores singulares derechos. El número de vectores singulares izquierdos y derechos independientes coincide, y estos vectores singulares aparecen en las mismas columnas de y correspondientes a elementos diagonales de todos con el mismo valor

Como excepción, los vectores singulares izquierdo y derecho de valor singular 0 comprenden todos los vectores unitarios en el cokernel y kernel , respectivamente, de que por el teorema de rango-nulidad no pueden tener la misma dimensión si Incluso si todos los valores singulares son distintos de cero, si entonces el cokernel no es trivial, en cuyo caso se rellena con vectores ortogonales del cokernel. Por el contrario, si entonces se rellena con vectores ortogonales del kernel. Sin embargo, si el valor singular de existe, las columnas adicionales de o ya aparecen como vectores singulares izquierdo o derecho.

Los valores singulares no degenerados siempre tienen vectores singulares izquierdo y derecho únicos, hasta la multiplicación por un factor de fase unitaria (para el caso real hasta un signo). En consecuencia, si todos los valores singulares de una matriz cuadrada son no degenerados y distintos de cero, entonces su descomposición en valores singulares es única, hasta la multiplicación de una columna de por un factor de fase unitaria y la multiplicación simultánea de la columna correspondiente de por el mismo factor de fase unitaria. En general, la descomposición en valores singulares es única hasta transformaciones unitarias arbitrarias aplicadas uniformemente a los vectores columna de y que abarcan los subespacios de cada valor singular, y hasta transformaciones unitarias arbitrarias en vectores de y que abarcan el núcleo y el conúcleo, respectivamente, de

Relación con la descomposición de valores propios

La descomposición en valores singulares es muy general en el sentido de que se puede aplicar a cualquier matriz , mientras que la descomposición en valores propios solo se puede aplicar a matrices diagonalizables cuadradas . Sin embargo, las dos descomposiciones están relacionadas.

Si tiene SVD se cumplen las dos relaciones siguientes:

Los lados derechos de estas relaciones describen las descomposiciones de valores propios de los lados izquierdos. En consecuencia:

- Las columnas de (denominadas vectores singulares derechos) son vectores propios de

- Las columnas de (denominadas vectores singulares izquierdos) son vectores propios de

- Los elementos distintos de cero de (valores singulares distintos de cero) son las raíces cuadradas de los valores propios distintos de cero de o

En el caso especial de ser una matriz normal , y por lo tanto también cuadrada, el teorema espectral asegura que puede ser diagonalizada unitariamente usando una base de vectores propios , y por lo tanto descompuesta como para alguna matriz unitaria y matriz diagonal con elementos complejos a lo largo de la diagonal. Cuando es semidefinida positiva , serán números reales no negativos de modo que la descomposición es también una descomposición en valores singulares. De lo contrario, se puede reformular como una SVD moviendo la fase de cada una a su correspondiente o La conexión natural de la SVD con matrices no normales es a través del teorema de descomposición polar : donde es semidefinida positiva y normal , y es unitaria .

Por lo tanto, excepto para matrices semidefinidas positivas, la descomposición en valores propios y la SVD de aunque relacionadas, difieren: la descomposición en valores propios es donde no es necesariamente unitaria y no es necesariamente semidefinida positiva, mientras que la SVD es donde es diagonal y semidefinida positiva, y y son matrices unitarias que no están necesariamente relacionadas excepto a través de la matriz Mientras que solo las matrices cuadradas no defectuosas tienen una descomposición en valores propios, cualquier matriz tiene una SVD.

Aplicaciones de la SVD

Pseudoinversa

La descomposición en valores singulares se puede utilizar para calcular la pseudoinversa de una matriz . La pseudoinversa de la matriz con descomposición en valores singulares es ,

donde es la pseudoinversa de , que se forma reemplazando cada entrada diagonal distinta de cero por su recíproca y transponiendo la matriz resultante. La pseudoinversa es una forma de resolver problemas de mínimos cuadrados lineales .

Resolución de ecuaciones lineales homogéneas

Un conjunto de ecuaciones lineales homogéneas se puede escribir como para una matriz y un vector Una situación típica es que se conoce y se debe determinar un distinto de cero que satisface la ecuación. Tal pertenece al espacio nulo de y a veces se llama vector nulo (derecho) de El vector se puede caracterizar como un vector singular derecho correspondiente a un valor singular de que es cero. Esta observación significa que si es una matriz cuadrada y no tiene ningún valor singular evanescente, la ecuación no tiene ningún distinto de cero como solución. También significa que si hay varios valores singulares evanescentes, cualquier combinación lineal de los vectores singulares derechos correspondientes es una solución válida. De manera análoga a la definición de un vector nulo (derecho), un distinto de cero que satisface con que denota la transpuesta conjugada de se denomina vector nulo izquierdo de

Minimización total por mínimos cuadrados

Un problema de mínimos cuadrados totales busca el vector que minimiza la norma 2 de un vector bajo la restricción La solución resulta ser el vector singular derecho de correspondiente al valor singular más pequeño.

Rango, espacio nulo y rango

Otra aplicación de la SVD es que proporciona una representación explícita del rango y el espacio nulo de una matriz Los vectores singulares derechos correspondientes a valores singulares que se desvanecen de abarcan el espacio nulo de y los vectores singulares izquierdos correspondientes a los valores singulares distintos de cero de abarcan el rango de Por ejemplo, en el ejemplo anterior, el espacio nulo está abarcado por la última fila de y el rango está abarcado por las primeras tres columnas de

Como consecuencia, el rango de es igual al número de valores singulares distintos de cero, que es el mismo que el número de elementos diagonales distintos de cero en . En álgebra lineal numérica, los valores singulares se pueden utilizar para determinar el rango efectivo de una matriz, ya que el error de redondeo puede conducir a valores singulares pequeños pero distintos de cero en una matriz deficiente en rango. Se supone que los valores singulares más allá de un espacio significativo son numéricamente equivalentes a cero.

Aproximación de matriz de bajo rango

Algunas aplicaciones prácticas necesitan resolver el problema de aproximar una matriz con otra matriz , llamada truncada, que tiene un rango específico . En el caso de que la aproximación se base en minimizar la norma de Frobenius de la diferencia entre y bajo la restricción de que resulte que la solución está dada por la SVD de a saber

donde es la misma matriz que excepto que contiene solo los valores singulares más grandes (los otros valores singulares se reemplazan por cero). Esto se conoce como el teorema de Eckart-Young , ya que fue demostrado por esos dos autores en 1936 (aunque luego se descubrió que lo conocían autores anteriores; consulte Stewart 1993).

Modelos separables

La descomposición de una matriz en una suma ponderada y ordenada de matrices separables se puede considerar como la descomposición de una matriz en una suma ponderada y ordenada de matrices separables. Por separable, queremos decir que una matriz se puede escribir como un producto externo de dos vectores o , en coordenadas, Específicamente , la matriz se puede descomponer como,

Aquí y son las -ésimas columnas de las matrices SVD correspondientes, son los valores singulares ordenados, y cada es separable. La SVD se puede utilizar para encontrar la descomposición de un filtro de procesamiento de imágenes en filtros horizontales y verticales separables. Nótese que el número de distintos de cero es exactamente el rango de la matriz. [ cita requerida ] Los modelos separables surgen a menudo en sistemas biológicos, y la factorización SVD es útil para analizar tales sistemas. Por ejemplo, algunos campos receptivos de células simples del área visual V1 se pueden describir bien [1] mediante un filtro de Gabor en el dominio espacial multiplicado por una función de modulación en el dominio temporal. Así, dado un filtro lineal evaluado mediante, por ejemplo, correlación inversa , se pueden reorganizar las dos dimensiones espaciales en una dimensión, produciendo así un filtro bidimensional (espacio, tiempo) que se puede descomponer mediante SVD. La primera columna de en la factorización SVD es entonces un Gabor mientras que la primera columna de representa la modulación temporal (o viceversa). Se puede entonces definir un índice de separabilidad

que es la fracción de la potencia en la matriz M que se explica por la primera matriz separable en la descomposición. [2]

Matriz ortogonal más cercana

Es posible utilizar la SVD de una matriz cuadrada para determinar la matriz ortogonal más cercana a La proximidad del ajuste se mide por la norma de Frobenius de La solución es el producto [3] Esto intuitivamente tiene sentido porque una matriz ortogonal tendría la descomposición donde es la matriz identidad, de modo que si entonces el producto equivale a reemplazar los valores singulares con unos. Equivalentemente, la solución es la matriz unitaria de la Descomposición Polar en cualquier orden de estiramiento y rotación, como se describió anteriormente.

Un problema similar, con aplicaciones interesantes en el análisis de formas , es el problema ortogonal de Procrustes , que consiste en encontrar una matriz ortogonal que se asemeje más estrechamente a Específicamente ,

donde denota la norma de Frobenius.

Este problema es equivalente a encontrar la matriz ortogonal más cercana a una matriz dada .

El algoritmo de Kabsch

El algoritmo de Kabsch (llamado en otros campos el problema de Wahba ) utiliza la descomposición en valores singulares (SVD) para calcular la rotación óptima (con respecto a la minimización por mínimos cuadrados) que alineará un conjunto de puntos con un conjunto de puntos correspondiente. Se utiliza, entre otras aplicaciones, para comparar las estructuras de las moléculas.

Procesamiento de señales

La SVD y la pseudoinversa se han aplicado con éxito al procesamiento de señales , [4] procesamiento de imágenes [5] y big data (por ejemplo, en el procesamiento de señales genómicas). [6] [7] [8] [9]

Otros ejemplos

La SVD también se aplica ampliamente al estudio de problemas inversos lineales y es útil en el análisis de métodos de regularización como el de Tikhonov . Se usa ampliamente en estadística, donde se relaciona con el análisis de componentes principales y el análisis de correspondencias , y en el procesamiento de señales y el reconocimiento de patrones . También se usa en el análisis modal de solo salida, donde las formas modales no escaladas se pueden determinar a partir de los vectores singulares. Otro uso es la indexación semántica latente en el procesamiento de texto en lenguaje natural.

En los cálculos numéricos generales que involucran sistemas lineales o linealizados, existe una constante universal que caracteriza la regularidad o singularidad de un problema, que es el "número de condición" del sistema . A menudo controla la tasa de error o la tasa de convergencia de un esquema computacional dado en tales sistemas. [10] [11]

La descomposición de Schmidt también desempeña un papel crucial en el campo de la información cuántica , en una forma que a menudo se denomina descomposición de Schmidt . A través de ella, los estados de dos sistemas cuánticos se descomponen de forma natural, proporcionando una condición necesaria y suficiente para que se enreden : que el rango de la matriz sea mayor que uno.

Una aplicación de SVD a matrices bastante grandes es la predicción numérica del tiempo , donde se utilizan los métodos de Lanczos para estimar las pocas perturbaciones de crecimiento más rápido y lineal de la predicción numérica central del tiempo durante un período de tiempo inicial dado hacia adelante; es decir, los vectores singulares correspondientes a los valores singulares más grandes del propagador linealizado para el tiempo global durante ese intervalo de tiempo. Los vectores singulares de salida en este caso son sistemas meteorológicos completos. Estas perturbaciones luego se ejecutan a través del modelo no lineal completo para generar un pronóstico de conjunto , lo que da un control sobre parte de la incertidumbre que se debe permitir en torno a la predicción central actual.

La descomposición en valores singulares también se ha aplicado al modelado de orden reducido. El objetivo del modelado de orden reducido es reducir el número de grados de libertad en un sistema complejo que se va a modelar. La descomposición en valores singulares se acopló con funciones de base radial para interpolar soluciones a problemas de flujo inestable tridimensionales. [12]

Curiosamente, la SVD se ha utilizado para mejorar el modelado de formas de onda gravitacionales mediante el interferómetro de ondas gravitacionales terrestre aLIGO. [13] La SVD puede ayudar a aumentar la precisión y la velocidad de la generación de formas de onda para respaldar las búsquedas de ondas gravitacionales y actualizar dos modelos de formas de onda diferentes.

La descomposición en valores singulares se utiliza en sistemas de recomendación para predecir las calificaciones de los artículos por parte de las personas. [14] Se han desarrollado algoritmos distribuidos con el fin de calcular la descomposición en valores singulares en grupos de máquinas de productos básicos. [15]

La SVD de bajo rango se ha aplicado para la detección de puntos críticos a partir de datos espaciotemporales con aplicación a la detección de brotes de enfermedades . [16] También se ha aplicado una combinación de SVD y SVD de orden superior para la detección de eventos en tiempo real a partir de flujos de datos complejos (datos multivariados con dimensiones espaciales y temporales) en la vigilancia de enfermedades . [17]

En astrodinámica , la SVD y sus variantes se utilizan como una opción para determinar direcciones de maniobra adecuadas para el diseño de trayectorias de transferencia [18] y el mantenimiento de la posición orbital . [19]

Prueba de existencia

Un valor propio de una matriz se caracteriza por la relación algebraica Cuando es hermítico , también está disponible una caracterización variacional. Sea una matriz simétrica real . Definir

Por el teorema del valor extremo , esta función continua alcanza un máximo en algún momento cuando se restringe a la esfera unitaria. Por el teorema de los multiplicadores de Lagrange , necesariamente satisface

para algún número real El símbolo nabla, , es el operador del (diferenciación con respecto a ). Usando la simetría de obtenemos

Por lo tanto , entonces es un vector propio de longitud unitaria de Para cada vector propio de longitud unitaria de su valor propio es entonces es el valor propio más grande de El mismo cálculo realizado en el complemento ortogonal de da el siguiente valor propio más grande y así sucesivamente. El caso hermítico complejo es similar; hay una función de valor real de variables reales.

Los valores singulares son similares en el sentido de que pueden describirse algebraicamente o a partir de principios variacionales. Aunque, a diferencia del caso de los valores propios, la hermiticidad o simetría de ya no es necesaria.

Esta sección presenta estos dos argumentos a favor de la existencia de la descomposición en valores singulares.

Basado en el teorema espectral

Sea una matriz compleja . Como es semidefinida positiva y hermítica, por el teorema espectral , existe una matriz unitaria tal que

donde es diagonal y definida positiva, de dimensión , con el número de valores propios distintos de cero de (que se puede demostrar que verifica ). Nótese que aquí es por definición una matriz cuya -ésima columna es el -ésimo vector propio de , correspondiente al valor propio . Además, la -ésima columna de , para , es un vector propio de con valor propio . Esto se puede expresar escribiendo como , donde las columnas de y por lo tanto contienen los vectores propios de correspondientes a valores propios distintos de cero y cero, respectivamente. Usando esta reescritura de , la ecuación se convierte en:

Esto implica que

Además, la segunda ecuación implica . [20] Finalmente, la unicidad de se traduce, en términos de y , en las siguientes condiciones:

donde los subíndices en las matrices identidad se utilizan para indicar que son de dimensiones diferentes.

Definamos ahora

Entonces,

ya que Esto también puede verse como una consecuencia inmediata del hecho de que . Esto es equivalente a la observación de que si es el conjunto de vectores propios de correspondientes a valores propios no nulos , entonces es un conjunto de vectores ortogonales, y es un conjunto (generalmente no completo) de vectores ortonormales . Esto coincide con el formalismo matricial utilizado anteriormente que denota con la matriz cuyas columnas son , con la matriz cuyas columnas son los vectores propios de con valor propio nulo, y la matriz cuyas columnas son los vectores .

Vemos que este es casi el resultado deseado, excepto que y en general no son unitarios, ya que podrían no ser cuadrados. Sin embargo, sabemos que el número de filas de no es menor que el número de columnas, ya que las dimensiones de no son mayores que y . Además, dado que

Las columnas de son ortonormales y pueden extenderse a una base ortonormal. Esto significa que podemos elegir una que sea unitaria.

Para ya tenemos para hacerlo unitario. Ahora, definamos

donde se agregan o eliminan filas cero adicionales para hacer que el número de filas cero sea igual al número de columnas de y, por lo tanto, las dimensiones generales de sean iguales a . Entonces

¿Cuál es el resultado deseado?

Nótese que el argumento podría comenzar diagonalizando en lugar de (Esto demuestra directamente que y tienen los mismos valores propios distintos de cero).

Basado en caracterización variacional

Los valores singulares también pueden caracterizarse como los máximos de considerados como una función de y sobre subespacios particulares. Los vectores singulares son los valores de y donde se alcanzan estos máximos.

Sea una matriz con entradas reales. Sea la esfera unitaria en , y definamos

Consideremos la función restringida a Dado que tanto como son conjuntos compactos , su producto también es compacto. Además, dado que es continua, alcanza un valor máximo para al menos un par de vectores en y en Este valor máximo se denota y los vectores correspondientes se denotan y Dado que es el valor más grande de debe ser no negativo. Si fuera negativo, cambiar el signo de o de lo haría positivo y, por lo tanto, más grande.

Declaración. y son vectores singulares izquierdo y derecho de con valor singular correspondiente

Demostración. De manera similar al caso de los valores propios, suponiendo que los dos vectores satisfacen la ecuación del multiplicador de Lagrange:

Después de un poco de álgebra, esto se convierte en

Multiplicando la primera ecuación desde la izquierda por y la segunda ecuación desde la izquierda por y teniendo en cuenta se obtiene

Conectando esto al par de ecuaciones anteriores, tenemos

Esto prueba la afirmación.

Se pueden encontrar más vectores singulares y valores singulares maximizando sobre los normalizados y que son ortogonales a y respectivamente.

El paso de lo real a lo complejo es similar al caso del valor propio.

Calculando la SVD

Algoritmo de Jacobi unilateral

El algoritmo de Jacobi unilateral es un algoritmo iterativo, [21] donde una matriz se transforma iterativamente en una matriz con columnas ortogonales. La iteración elemental se da como una rotación de Jacobi ,

donde el ángulo de la matriz de rotación de Jacobi se elige de manera que después de la rotación las columnas con números y se vuelvan ortogonales. Los índices se barren cíclicamente, , donde es el número de columnas.

Una vez convergido el algoritmo, la descomposición en valores singulares se recupera de la siguiente manera: la matriz es la acumulación de matrices de rotación de Jacobi, la matriz se da normalizando las columnas de la matriz transformada y los valores singulares se dan como las normas de las columnas de la matriz transformada .

Algoritmo de Jacobi de dos caras

El algoritmo SVD de Jacobi de dos lados (una generalización del algoritmo de valores propios de Jacobi ) es un algoritmo iterativo en el que una matriz cuadrada se transforma iterativamente en una matriz diagonal. Si la matriz no es cuadrada, primero se realiza la descomposición QR y luego se aplica el algoritmo a la matriz. La iteración elemental pone a cero un par de elementos fuera de la diagonal aplicando primero una rotación de Givens para simetrizar el par de elementos y luego aplicando una transformación de Jacobi para ponerlos a cero.

donde es la matriz de rotación de Givens con el ángulo elegido de modo que el par dado de elementos fuera de la diagonal se vuelva igual después de la rotación, y donde es la matriz de transformación de Jacobi que pone a cero estos elementos fuera de la diagonal. Las iteraciones se realizan exactamente como en el algoritmo de valores propios de Jacobi: mediante barridos cíclicos sobre todos los elementos fuera de la diagonal.

Una vez que el algoritmo ha convergido, la matriz diagonal resultante contiene los valores singulares. Las matrices y se acumulan de la siguiente manera: , .

Enfoque numérico

La descomposición en valores singulares se puede calcular utilizando las siguientes observaciones:

- Los vectores singulares izquierdos de son un conjunto de vectores propios ortonormales de .

- Los vectores singulares derechos de son un conjunto de vectores propios ortonormales de .

- Los valores singulares distintos de cero de (que se encuentran en las entradas diagonales de ) son las raíces cuadradas de los valores propios distintos de cero de y .

La SVD de una matriz se calcula típicamente mediante un procedimiento de dos pasos. En el primer paso, la matriz se reduce a una matriz bidiagonal . Esto requiere operaciones de punto flotante de orden (flop), asumiendo que El segundo paso es calcular la SVD de la matriz bidiagonal. Este paso solo se puede hacer con un método iterativo (como con los algoritmos de valores propios ). Sin embargo, en la práctica es suficiente calcular la SVD hasta una cierta precisión, como la máquina épsilon . Si esta precisión se considera constante, entonces el segundo paso requiere iteraciones, cada una con un costo de flops. Por lo tanto, el primer paso es más costoso y el costo total es de flops (Trefethen & Bau III 1997, Conferencia 31).

El primer paso se puede realizar utilizando reflexiones de Householder por un costo de flops, asumiendo que solo se necesitan los valores singulares y no los vectores singulares. Si es mucho mayor que entonces es ventajoso reducir primero la matriz a una matriz triangular con la descomposición QR y luego utilizar reflexiones de Householder para reducir aún más la matriz a la forma bidiagonal; el costo combinado es flops (Trefethen & Bau III 1997, Conferencia 31).

El segundo paso se puede realizar mediante una variante del algoritmo QR para el cálculo de valores propios, que fue descrito por primera vez por Golub y Kahan (1965). La subrutina LAPACK DBDSQR [22] implementa este método iterativo, con algunas modificaciones para cubrir el caso en el que los valores singulares son muy pequeños (Demmel y Kahan 1990). Junto con un primer paso que utiliza reflexiones de Householder y, si corresponde, descomposición QR, esto forma la rutina DGESVD [23] para el cálculo de la descomposición en valores singulares.

El mismo algoritmo está implementado en la Biblioteca Científica GNU (GSL). La GSL también ofrece un método alternativo que utiliza una ortogonalización de Jacobi unilateral en el paso 2 (GSL Team 2007). Este método calcula la SVD de la matriz bidiagonal resolviendo una secuencia de problemas de SVD , de manera similar a cómo el algoritmo de valores propios de Jacobi resuelve una secuencia de métodos de valores propios (Golub y Van Loan 1996, §8.6.3). Otro método para el paso 2 utiliza la idea de algoritmos de valores propios de divide y vencerás (Trefethen y Bau III 1997, lección 31).

Existe una forma alternativa que no utiliza explícitamente la descomposición en valores propios. [ 24 ] Por lo general, el problema de valor singular de una matriz se convierte en un problema de valor propio simétrico equivalente como o

Los enfoques que utilizan descomposiciones de valores propios se basan en el algoritmo QR , que está bien desarrollado para ser estable y rápido. Nótese que los valores singulares son reales y no se requieren vectores singulares de derecha e izquierda para formar transformaciones de similitud. Uno puede alternar iterativamente entre la descomposición QR y la descomposición LQ para encontrar las matrices hermíticas diagonales reales . La descomposición QR da y la descomposición LQ de da Por lo tanto, en cada iteración, tenemos actualizar y repetir las ortogonalizaciones. Finalmente, [ aclaración necesaria ] esta iteración entre la descomposición QR y la descomposición LQ produce matrices singulares unitarias de izquierda y derecha. Este enfoque no se puede acelerar fácilmente, como el algoritmo QR puede con los cambios espectrales o la deflación. Esto se debe a que el método de cambio no se define fácilmente sin usar transformaciones de similitud. Sin embargo, este enfoque iterativo es muy sencillo de implementar, por lo que es una buena opción cuando la velocidad no es importante. Este método también proporciona información sobre cómo las transformaciones puramente ortogonales/unitarias pueden obtener la SVD.

Resultado analítico de 2 × 2 SVD

Los valores singulares de una matriz se pueden encontrar analíticamente. Sea la matriz

donde son números complejos que parametrizan la matriz, es la matriz identidad, y denotan las matrices de Pauli . Entonces sus dos valores singulares están dados por

SVD reducidos

En las aplicaciones, es bastante inusual que se requiera la descomposición unitaria completa del espacio nulo de la matriz. En cambio, a menudo es suficiente (además de ser más rápido y más económico para el almacenamiento) calcular una versión reducida de la descomposición unitaria. Se puede distinguir lo siguiente para una matriz de rango :

SVD delgada

La SVD delgada, o de tamaño económico, de una matriz está dada por [25]

donde las matrices y contienen solo las primeras columnas de y y contiene solo los primeros valores singulares de La matriz es, por tanto , es diagonal, y es

La SVD delgada utiliza significativamente menos espacio y tiempo de cálculo si La primera etapa en su cálculo generalmente será una descomposición QR de lo que puede generar un cálculo significativamente más rápido en este caso.

SVD compacto

La SVD compacta de una matriz está dada por

Solo se calculan los vectores columna de y los vectores fila de correspondientes a los valores singulares distintos de cero . Los vectores restantes de y no se calculan . Esto es más rápido y más económico que la SVD delgada si la matriz es , por lo tanto , diagonal y es

SVD truncado

En muchas aplicaciones, el número de valores singulares distintos de cero es grande, lo que hace que incluso la descomposición en valores singulares compacta sea poco práctica de calcular. En tales casos, puede ser necesario truncar los valores singulares más pequeños para calcular solo los valores singulares distintos de cero. La descomposición en valores singulares truncada ya no es una descomposición exacta de la matriz original , sino que proporciona la aproximación óptima de la matriz de bajo rango mediante cualquier matriz de un rango fijo .

donde la matriz es es diagonal, y es Solo se calculan los vectores columna de y vectores fila de correspondientes a los valores singulares más grandes . Esto puede ser mucho más rápido y económico que el SVD compacto si pero requiere un conjunto de herramientas completamente diferente de solucionadores numéricos.

En aplicaciones que requieren una aproximación a la inversa de Moore-Penrose de la matriz son de interés los valores singulares más pequeños de , que son más difíciles de calcular en comparación con los más grandes.

La SVD truncada se emplea en la indexación semántica latente . [26]

Normas

Normas de Ky Fan

La suma de los valores singulares más grandes de es una norma matricial , la -norma Ky Fan de [27]

La primera de las normas de Ky Fan, la 1-norma de Ky Fan, es la misma que la norma del operador de como operador lineal con respecto a las normas euclidianas de y En otras palabras, la 1-norma de Ky Fan es la norma del operador inducida por el producto interno euclidiano estándar. Por esta razón, también se le llama la 2-norma del operador. Se puede verificar fácilmente la relación entre la 1-norma de Ky Fan y los valores singulares. Es cierto en general, para un operador acotado en espacios de Hilbert (posiblemente de dimensión infinita)

Pero, en el caso de la matriz, es una matriz normal , por lo que es el mayor valor propio de es decir, el mayor valor singular de

La última de las normas de Ky Fan, la suma de todos los valores singulares, es la norma de traza (también conocida como "norma nuclear"), definida por (los valores propios de son los cuadrados de los valores singulares).

Norma de Hilbert-Schmidt

Los valores singulares están relacionados con otra norma en el espacio de operadores. Consideremos el producto interno de Hilbert-Schmidt en las matrices , definido por

Por lo tanto la norma inducida es

Dado que la traza es invariante bajo equivalencia unitaria, esto demuestra

donde son los valores singulares de Esto se llama norma de Frobenius , norma 2 de Schatten o norma de Hilbert-Schmidt de El cálculo directo muestra que la norma de Frobenius de coincide con:

Además, la norma de Frobenius y la norma de traza (la norma nuclear) son casos especiales de la norma de Schatten .

Variaciones y generalizaciones

SVD invariante de escala

Los valores singulares de una matriz están definidos de forma única y son invariantes con respecto a las transformaciones unitarias izquierda y/o derecha de En otras palabras, los valores singulares de para matrices unitarias y son iguales a los valores singulares de Esta es una propiedad importante para aplicaciones en las que es necesario preservar las distancias euclidianas y la invariancia con respecto a las rotaciones.

La SVD invariante de escala, o SI-SVD, [28] es análoga a la SVD convencional excepto que sus valores singulares determinados de manera única son invariantes con respecto a las transformaciones diagonales de En otras palabras, los valores singulares de para matrices diagonales invertibles y son iguales a los valores singulares de Esta es una propiedad importante para aplicaciones para las que se necesita invariancia a la elección de unidades en las variables (por ejemplo, unidades métricas versus imperiales).

Operadores acotados en espacios de Hilbert

La factorización se puede extender a un operador acotado en un espacio de Hilbert separable . Es decir , para cualquier operador acotado existe una isometría parcial , un espacio de medida unitario y un medible no negativo tal que

donde es la multiplicación por en

Esto se puede demostrar imitando el argumento algebraico lineal para el caso matricial anterior. es la única raíz cuadrada positiva de como se da por el cálculo funcional de Borel para operadores autoadjuntos . La razón por la que no necesita ser unitario es que, a diferencia del caso de dimensión finita, dada una isometría con núcleo no trivial, no se puede encontrar un adecuado tal que

es un operador unitario.

En cuanto a las matrices, la factorización en valores singulares es equivalente a la descomposición polar para operadores: podemos simplemente escribir

y observe que sigue siendo una isometría parcial mientras que es positivo.

Valores singulares y operadores compactos

La noción de valores singulares y vectores singulares izquierdo/derecho se puede extender al operador compacto en el espacio de Hilbert ya que tienen un espectro discreto. Si es compacto, cada distinto de cero en su espectro es un valor propio. Además, un operador autoadjunto compacto se puede diagonalizar por sus vectores propios. Si es compacto, también lo es . Aplicando el resultado de la diagonalización, la imagen unitaria de su raíz cuadrada positiva tiene un conjunto de vectores propios ortonormales correspondientes a valores propios estrictamente positivos . Para cualquier en

donde la serie converge en la topología de la norma en Nótese cómo esto se asemeja a la expresión del caso de dimensión finita. se denominan valores singulares de (resp. ) pueden considerarse los vectores singulares izquierdos (resp. singulares derechos) de

Los operadores compactos en un espacio de Hilbert son la clausura de los operadores de rango finito en la topología de operadores uniforme. La expresión en serie anterior proporciona una representación explícita de este tipo. Una consecuencia inmediata de esto es:

- Teorema. es compacto si y sólo si es compacto.

Historia

La descomposición en valores singulares fue desarrollada originalmente por geómetras diferenciales , quienes deseaban determinar si una forma bilineal real podía hacerse igual a otra mediante transformaciones ortogonales independientes de los dos espacios sobre los que actúa. Eugenio Beltrami y Camille Jordan descubrieron independientemente, en 1873 y 1874 respectivamente, que los valores singulares de las formas bilineales, representadas como una matriz, forman un conjunto completo de invariantes para formas bilineales bajo sustituciones ortogonales. James Joseph Sylvester también llegó a la descomposición en valores singulares para matrices cuadradas reales en 1889, aparentemente independientemente de Beltrami y Jordan. Sylvester llamó a los valores singulares los multiplicadores canónicos de la matriz . El cuarto matemático en descubrir la descomposición en valores singulares de forma independiente es Autonne en 1915, quien llegó a ella mediante la descomposición polar . La primera prueba de la descomposición en valores singulares para matrices rectangulares y complejas parece ser de Carl Eckart y Gale J. Young en 1936; [29] Lo vieron como una generalización de la transformación del eje principal para matrices hermíticas .

En 1907, Erhard Schmidt definió un análogo de los valores singulares para los operadores integrales (que son compactos, bajo algunas suposiciones técnicas débiles); parece que no estaba al tanto del trabajo paralelo sobre los valores singulares de matrices finitas. Esta teoría fue desarrollada posteriormente por Émile Picard en 1910, quien fue el primero en llamar a los números valores singulares (o en francés, valeurs singulières ).

Los métodos prácticos para calcular la SVD se remontan a Kogbetliantz en 1954-1955 y Hestenes en 1958, [30] que se asemejan mucho al algoritmo de valores propios de Jacobi , que utiliza rotaciones de planos o rotaciones de Givens . Sin embargo, estos fueron reemplazados por el método de Gene Golub y William Kahan publicado en 1965, [31] que utiliza transformaciones o reflexiones de Householder. En 1970, Golub y Christian Reinsch [32] publicaron una variante del algoritmo de Golub/Kahan que sigue siendo el más utilizado en la actualidad.

Véase también

- Correlación canónica

- Forma canónica

- Análisis de correspondencia (AC)

- La maldición de la dimensionalidad

- Procesamiento de señales digitales

- Reducción de dimensionalidad

- Descomposición propia de una matriz

- Funciones ortogonales empíricas (EOF)

- Análisis de Fourier

- Descomposición generalizada en valores singulares

- Desigualdades sobre valores singulares

- K-SVD

- Análisis semántico latente

- Indexación semántica latente

- Mínimos cuadrados lineales

- Lista de transformadas relacionadas con Fourier

- Hashing sensible a la localidad

- Aproximación de bajo rango

- Descomposición matricial

- Análisis de componentes principales multilineales (MPCA)

- Búsqueda de vecino más cercano

- Mínimos cuadrados parciales iterativos no lineales

- Descomposición polar

- Análisis de componentes principales (PCA)

- Descomposición de Schmidt

- Forma normal de Smith

- Valor singular

- Serie temporal

- Descomposición en valores singulares bidimensionales (2DSVD)

- Rastro de desigualdad de von Neumann

- Compresión wavelet

Notas

- ^ DeAngelis, GC; Ohzawa, I.; Freeman, RD (octubre de 1995). "Dinámica del campo receptivo en las vías visuales centrales". Trends Neurosci . 18 (10): 451–8. doi :10.1016/0166-2236(95)94496-R. PMID 8545912. S2CID 12827601.

- ^ Depireux, DA; Simon, JZ; Klein, DJ; Shamma, SA (marzo de 2001). "Caracterización del campo de respuesta espectrotemporal con ondulaciones dinámicas en la corteza auditiva primaria del hurón". J. Neurophysiol . 85 (3): 1220–34. doi :10.1152/jn.2001.85.3.1220. PMID 11247991.

- ^ La descomposición en valores singulares en la ortogonalización simétrica (Lowdin) y la compresión de datos

- ^ Sahidullah, Md.; Kinnunen, Tomi (marzo de 2016). "Características de variabilidad espectral local para la verificación del hablante". Procesamiento de señales digitales . 50 : 1–11. doi :10.1016/j.dsp.2015.10.011.

- ^ Mademlis, Ioannis; Tefas, Anastasios; Pitas, Ioannis (2018). "Saliencia de fotogramas de vídeo basada en SVD regularizada para el resumen de vídeo de actividad no supervisada". Conferencia internacional IEEE de 2018 sobre acústica, habla y procesamiento de señales (ICASSP). IEEE. págs. 2691–2695. doi :10.1109/ICASSP.2018.8462274. ISBN . 978-1-5386-4658-8. S2CID 52286352 . Consultado el 19 de enero de 2023 .

- ^ O. Alter, PO Brown y D. Botstein (septiembre de 2000). "Descomposición en valores singulares para el procesamiento y modelado de datos de expresión de todo el genoma". PNAS . 97 (18): 10101–10106. Bibcode :2000PNAS...9710101A. doi : 10.1073/pnas.97.18.10101 . PMC 27718 . PMID 10963673.

- ^ O. Alter; GH Golub (noviembre de 2004). "El análisis integrativo de datos a escala del genoma mediante proyección pseudoinversa predice una nueva correlación entre la replicación del ADN y la transcripción del ARN". PNAS . 101 (47): 16577–16582. Bibcode :2004PNAS..10116577A. doi : 10.1073/pnas.0406767101 . PMC 534520 . PMID 15545604.

- ^ O. Alter; GH Golub (agosto de 2006). "La descomposición en valores singulares de la distribución de longitudes de ARNm a escala del genoma revela asimetría en el ensanchamiento de bandas de electroforesis en gel de ARN". PNAS . 103 (32): 11828–11833. Bibcode :2006PNAS..10311828A. doi : 10.1073/pnas.0604756103 . PMC 1524674 . PMID 16877539.

- ^ Bertagnolli, NM; Drake, JA; Tennessen, JM; Alter, O. (noviembre de 2013). "SVD identifica funciones de distribución de longitud de transcripción a partir de datos de microarrays de ADN y revela fuerzas evolutivas que afectan globalmente al metabolismo de GBM". PLOS ONE . 8 (11): e78913. Bibcode :2013PLoSO...878913B. doi : 10.1371/journal.pone.0078913 . PMC 3839928 . PMID 24282503. Destacado.

- ^ Edelman, Alan (1992). "Sobre la distribución de un número de condición escalado" (PDF) . Math. Comp . 58 (197): 185–190. Bibcode :1992MaCom..58..185E. doi : 10.1090/S0025-5718-1992-1106966-2 .

- ^ Shen, Jianhong (Jackie) (2001). "Sobre los valores singulares de matrices aleatorias gaussianas". Linear Alg. Appl . 326 (1–3): 1–14. doi : 10.1016/S0024-3795(00)00322-0 .

- ^ Walton, S.; Hassan, O.; Morgan, K. (2013). "Modelado de orden reducido para flujo de fluido inestable utilizando descomposición ortogonal adecuada y funciones de base radial". Modelado matemático aplicado . 37 (20–21): 8930–8945. doi : 10.1016/j.apm.2013.04.025 .

- ^ Setyawati, Y.; Ohme, F.; Khan, S. (2019). "Mejora del modelo de forma de onda gravitacional mediante calibración dinámica". Physical Review D . 99 (2): 024010. arXiv : 1810.07060 . Código Bibliográfico :2019PhRvD..99b4010S. doi :10.1103/PhysRevD.99.024010. S2CID 118935941.

- ^ Sarwar, Badrul; Karypis, George; Konstan, Joseph A. y Riedl, John T. (2000). "Aplicación de la reducción de la dimensionalidad en el sistema de recomendación: un estudio de caso" (PDF) . Universidad de Minnesota .

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Bosagh Zadeh, Reza; Carlsson, Gunnar (2013). "Matriz cuadrada independiente de la dimensión utilizando MapReduce" (PDF) . arXiv : 1304.1467 . Código Bibliográfico :2013arXiv1304.1467B.

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Hadi Fanaee Tork; João Gama (septiembre de 2014). "Método de espacio propio para la detección de puntos calientes espaciotemporales". Expert Systems . 32 (3): 454–464. arXiv : 1406.3506 . Código Bibliográfico :2014arXiv1406.3506F. doi :10.1111/exsy.12088. S2CID 15476557.

- ^ Hadi Fanaee Tork; João Gama (mayo de 2015). "EigenEvent: Un algoritmo para la detección de eventos a partir de flujos de datos complejos en vigilancia sindrómica". Análisis inteligente de datos . 19 (3): 597–616. arXiv : 1406.3496 . doi :10.3233/IDA-150734. S2CID 17966555.

- ^ Muralidharan, Vivek; Howell, Kathleen (2023). "Direcciones de estiramiento en el espacio cislunar: aplicaciones para el diseño de partidas y transferencias". Astrodynamics . 7 (2): 153–178. Bibcode :2023AsDyn...7..153M. doi :10.1007/s42064-022-0147-z. S2CID 252637213.

- ^ Muralidharan, Vivek; Howell, Kathleen (2022). "Aprovechamiento de las direcciones de estiramiento para el mantenimiento de la posición en órbitas de halo Tierra-Luna". Avances en la investigación espacial . 69 (1): 620–646. Código Bibliográfico :2022AdSpR..69..620M. doi :10.1016/j.asr.2021.10.028. S2CID 239490016.

- ^ Para ver esto, sólo tenemos que notar que , y recordar que .

- ^ Rijk, PPM de (1989). "Un algoritmo de Jacobi unilateral para calcular la descomposición en valores singulares en una computadora vectorial". SIAM J. Sci. Stat. Comput . 10 : 359.

- ^ Netlib.org

- ^ Netlib.org

- ^ mathworks.co.kr/matlabcentral/fileexchange/12674-simple-svd

- ^ Demmel, James (2000). "Descomposiciones". Plantillas para la solución de problemas algebraicos de valores propios. Por Bai, Zhaojun; Demmel, James; Dongarra, Jack J.; Ruhe, Axel; van der Vorst, Henk A. Sociedad de Matemáticas Industriales y Aplicadas. doi :10.1137/1.9780898719581. ISBN 978-0-89871-471-5.

- ^ Chicco, D; Masseroli, M (2015). "Paquete de software para predicción de anotaciones de genes y proteínas y búsqueda de similitud". Transacciones IEEE/ACM sobre biología computacional y bioinformática . 12 (4): 837–843. doi :10.1109/TCBB.2014.2382127. hdl : 11311/959408 . PMID 26357324. S2CID 14714823.

- ^ Fan, Ky. (1951). "Propiedades máximas y desigualdades para los valores propios de operadores completamente continuos". Actas de la Academia Nacional de Ciencias de los Estados Unidos de América . 37 (11): 760–766. Bibcode :1951PNAS...37..760F. doi : 10.1073/pnas.37.11.760 . PMC 1063464 . PMID 16578416.

- ^ Uhlmann, Jeffrey (2018), Una matriz inversa generalizada que es consistente con respecto a las transformaciones diagonales (PDF) , SIAM Journal on Matrix Analysis, vol. 239, págs. 781–800, archivado desde el original (PDF) el 17 de junio de 2019

- ^ Eckart, C. ; Young, G. (1936). "La aproximación de una matriz por otra de rango inferior". Psychometrika . 1 (3): 211–8. doi :10.1007/BF02288367. S2CID 10163399.

- ^ Hestenes, MR (1958). "Inversión de matrices por biortogonalización y resultados relacionados". Revista de la Sociedad de Matemáticas Industriales y Aplicadas . 6 (1): 51–90. doi :10.1137/0106005. JSTOR 2098862. MR 0092215.

- ^ (Golub y Kahan 1965)

- ^ Golub, GH ; Reinsch, C. (1970). "Descomposición de valores singulares y soluciones de mínimos cuadrados". Matemática numérica . 14 (5): 403–420. doi :10.1007/BF02163027. SEÑOR 1553974. S2CID 123532178.

Referencias

- Banerjee, Sudipto; Roy, Anindya (2014), Álgebra lineal y análisis matricial para estadística , Textos en ciencia estadística (1.ª ed.), Chapman y Hall/CRC, ISBN 978-1420095388

- Bisgard, James (2021). Análisis y álgebra lineal: la descomposición en valores singulares y sus aplicaciones . Biblioteca de Matemáticas para Estudiantes (1.ª ed.). AMS. ISBN 978-1-4704-6332-8.

- Chicco, D; Masseroli, M (2015). "Paquete de software para predicción de anotaciones de genes y proteínas y búsqueda de similitud". Transacciones IEEE/ACM sobre biología computacional y bioinformática . 12 (4): 837–843. doi :10.1109/TCBB.2014.2382127. hdl : 11311/959408 . PMID 26357324. S2CID 14714823.

- Trefethen, Lloyd N. ; Bau III, David (1997). Álgebra lineal numérica . Filadelfia: Sociedad de Matemáticas Industriales y Aplicadas. ISBN 978-0-89871-361-9.

- Demmel, James ; Kahan, William (1990). "Valores singulares precisos de matrices bidiagonales". Revista SIAM sobre computación científica y estadística . 11 (5): 873–912. CiteSeerX 10.1.1.48.3740 . doi :10.1137/0911052.

- Golub, Gene H. ; Kahan, William (1965). "Cálculo de los valores singulares y pseudoinversos de una matriz". Revista de la Sociedad de Matemáticas Industriales y Aplicadas, Serie B: Análisis numérico . 2 (2): 205–224. Bibcode :1965SJNA....2..205G. doi :10.1137/0702016. JSTOR 2949777.

- Golub, Gene H. ; Van Loan, Charles F. (1996). Cálculos matriciales (3.ª ed.). Johns Hopkins. ISBN 978-0-8018-5414-9.

- Equipo GSL (2007). «§14.4 Descomposición en valores singulares». Biblioteca científica GNU. Manual de referencia .

- Halldor, Bjornsson y Venegas, Silvia A. (1997). "Un manual para análisis de datos climáticos mediante EOF y SVD". Universidad McGill, Informe CCGCR N.º 97-1, Montreal, Quebec, 52 págs.

- Hansen, PC (1987). "La SVD truncada como método de regularización". BIT . 27 (4): 534–553. doi :10.1007/BF01937276. S2CID 37591557.

- Horn, Roger A.; Johnson, Charles R. (1985). "Sección 7.3". Análisis de matrices . Cambridge University Press. ISBN 978-0-521-38632-6.

- Horn, Roger A.; Johnson, Charles R. (1991). "Capítulo 3" . Temas de análisis matricial . Cambridge University Press. ISBN 978-0-521-46713-1.

- Samet, H. (2006). Fundamentos de estructuras de datos multidimensionales y métricas . Morgan Kaufmann. ISBN 978-0-12-369446-1.

- Strang G. (1998). "Sección 6.7". Introducción al álgebra lineal (3.ª ed.). Wellesley-Cambridge Press. ISBN 978-0-9614088-5-5.

- Stewart, GW (1993). "Sobre la historia temprana de la descomposición en valores singulares". SIAM Review . 35 (4): 551–566. CiteSeerX 10.1.1.23.1831 . doi :10.1137/1035134. hdl :1903/566. JSTOR 2132388.

- Wall, Michael E.; Rechtsteiner, Andreas; Rocha, Luis M. (2003). "Descomposición en valores singulares y análisis de componentes principales". En DP Berrar; W. Dubitzky; M. Granzow (eds.). Un enfoque práctico para el análisis de datos de microarrays . Norwell, MA: Kluwer. págs. 91–109.

- Press, WH; Teukolsky, SA; Vetterling, WT; Flannery, BP (2007), "Sección 2.6", Recetas numéricas: el arte de la computación científica (3.ª ed.), Nueva York: Cambridge University Press, ISBN 978-0-521-88068-8

Enlaces externos

- Calculadora de SVD en línea

![{\displaystyle {\begin{aligned}\mathbf {U} &={\begin{bmatrix}\color {Verde}0&\color {Azul}-1&\color {Cian}0&\color {Esmeralda}0\\\color {Verde}-1&\color {Azul}0&\color {Cian}0&\color {Esmeralda}0\\\color {Verde}0&\color {Azul}0&\color {Cian}0&\color {Esmeralda}-1\\\color {Verde}0&\color {Azul}0&\color {Cian}-1&\color {Esmeralda}0\end{bmatrix}}\\[6pt]\mathbf {\Sigma } &={\begin{bmatrix}3&0&0&0&\color {Gris}{\mathit {0}}\\0&{\sqrt {5}}&0&0&\color {Gris}{\mathit {0}}\\0&0&2&0&\color {Gris}{\mathit {0}}\\0&0&0&\color {Rojo}\mathbf {0} &\color {Gris}{\mathit {0}}\end{bmatrix}}\\[6pt]\mathbf {V} ^{*}&={\begin{bmatrix}\color {Violeta}0&\color {Violeta}0&\color {Violeta}-1&\color {Violeta}0&\color {Violeta}0\\\color {Ciruela}-{\sqrt {0.2}}&\color {Ciruela}0&\color {Ciruela}0&\color {Ciruela}0&\color {Ciruela}-{\sqrt {0.8}}\\\color {Magenta}0&\color {Magenta}-1&\color {Magenta}0&\color {Magenta}0&\color {Magenta}0\\\color {Orquídea}0&\color {Orquídea}0&\color {Orquídea}0&\color {Orquídea}1&\color {Orquídea}0\\\color {Púrpura}-{\sqrt {0.8}}&\color {Púrpura}0&\color {Púrpura}0&\color {Púrpura}0&\color {Púrpura}{\sqrt {0.2}}\end{bmatrix}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c98ad3dd760d4b25f274add6c40e8412d351976a)

![{\displaystyle {\begin{alineado}\mathbf {U} \mathbf {U} ^{*}&={\begin{bmatrix}1&0&0&0\\0&1&0&0\\0&0&1&0\\0&0&0&1\end{bmatrix}}=\mathbf {I} _{4}\\[6pt]\mathbf {V} \mathbf {V} ^{*}&={\begin{bmatrix}1&0&0&0&0\\0&1&0&0&0\\0&0&1&0&0\\0&0&0&1&0\\0&0&0&0&1\end{bmatrix}}=\mathbf {I} _{5}\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47909bf34c8f6bf555462da282152e537800e0b2)

![{\displaystyle {\begin{alineado}\mathbf {Mv} &=\sigma \mathbf {u} ,\\[3mu]\mathbf {M} ^{*}\mathbf {u} &=\sigma \mathbf {v} .\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5ef40237646a1b9680a40c90fb157936cee0ad1d)

![{\displaystyle {\begin{aligned}\mathbf {M} ^{*}\mathbf {M} &=\mathbf {V} \mathbf {\Sigma } ^{*}\mathbf {U} ^{*}\ ,\mathbf {U} \mathbf {\Sigma } \mathbf {V} ^{*}=\mathbf {V} (\mathbf {\Sigma } ^{*}\mathbf {\Sigma } )\mathbf {V} ^{*},\\[3mu]\mathbf {M} \mathbf {M} ^{*}&=\mathbf {U} \mathbf {\Sigma } \mathbf {V} ^{*}\,\mathbf {V} \mathbf {\Sigma } ^{*}\mathbf {U} ^{*}=\mathbf {U} (\mathbf {\Sigma } \mathbf {\Sigma } ^{*})\mathbf {U} ^{*}.\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f02e41f55548643d74b09b78124e6ab72ab72a13)