Estadística matemática

| Estadística |

|---|

|

| Part of a series on | ||

| Mathematics | ||

|---|---|---|

Mathematics Portal Mathematics Portal | ||

La estadística matemática es la aplicación de la teoría de la probabilidad , una rama de las matemáticas , a la estadística , en contraposición a las técnicas para recopilar datos estadísticos. Las técnicas matemáticas específicas que se utilizan para esto incluyen el análisis matemático , el álgebra lineal , el análisis estocástico , las ecuaciones diferenciales y la teoría de la medida . [1] [2]

Introducción

La recopilación de datos estadísticos se ocupa de la planificación de estudios, especialmente del diseño de experimentos aleatorios y de la planificación de encuestas mediante muestreo aleatorio . El análisis inicial de los datos suele seguir el protocolo de estudio especificado antes de que se llevara a cabo el estudio. Los datos de un estudio también pueden analizarse para considerar hipótesis secundarias inspiradas en los resultados iniciales o para sugerir nuevos estudios. Un análisis secundario de los datos de un estudio planificado utiliza herramientas del análisis de datos y el proceso para hacerlo se denomina estadística matemática.

El análisis de datos se divide en:

- estadística descriptiva : la parte de la estadística que describe los datos, es decir, resume los datos y sus propiedades típicas.

- estadística inferencial – la parte de la estadística que extrae conclusiones de los datos (usando algún modelo para los datos): por ejemplo, la estadística inferencial implica seleccionar un modelo para los datos, verificar si los datos cumplen las condiciones de un modelo particular y cuantificar la incertidumbre involucrada (por ejemplo, usando intervalos de confianza ).

Si bien las herramientas de análisis de datos funcionan mejor con datos provenientes de estudios aleatorios, también se aplican a otros tipos de datos, por ejemplo, de experimentos naturales y estudios observacionales , en cuyo caso la inferencia depende del modelo elegido por el estadístico y, por lo tanto, es subjetiva. [3] [4]

Temas

Los siguientes son algunos de los temas importantes en estadística matemática: [5] [6]

Distribuciones de probabilidad

Una distribución de probabilidad es una función que asigna una probabilidad a cada subconjunto medible de los posibles resultados de un experimento aleatorio , una encuesta o un procedimiento de inferencia estadística . Se encuentran ejemplos en experimentos cuyo espacio muestral no es numérico, donde la distribución sería una distribución categórica ; experimentos cuyo espacio muestral está codificado por variables aleatorias discretas , donde la distribución puede especificarse mediante una función de masa de probabilidad ; y experimentos con espacios muestrales codificados por variables aleatorias continuas, donde la distribución puede especificarse mediante una función de densidad de probabilidad . Experimentos más complejos, como los que involucran procesos estocásticos definidos en tiempo continuo , pueden exigir el uso de medidas de probabilidad más generales .

Una distribución de probabilidad puede ser univariante o multivariante . Una distribución univariante da las probabilidades de que una única variable aleatoria adopte varios valores alternativos; una distribución multivariante (una distribución de probabilidad conjunta ) da las probabilidades de que un vector aleatorio (un conjunto de dos o más variables aleatorias) adopte varias combinaciones de valores. Las distribuciones de probabilidad univariante importantes y de uso común incluyen la distribución binomial , la distribución hipergeométrica y la distribución normal . La distribución normal multivariante es una distribución multivariante de uso común.

Distribuciones especiales

- Distribución normal , la distribución continua más común.

- Distribución de Bernoulli , para el resultado de un único ensayo de Bernoulli (por ejemplo, éxito/fracaso, sí/no)

- Distribución binomial , para el número de "ocurrencias positivas" (por ejemplo, éxitos, votos afirmativos, etc.) dado un número total fijo de ocurrencias independientes

- Distribución binomial negativa , para observaciones de tipo binomial pero donde la cantidad de interés es el número de fallas antes de que ocurra un número dado de éxitos

- Distribución geométrica , para observaciones de tipo binomial pero donde la cantidad de interés es el número de fallos antes del primer éxito; un caso especial de la distribución binomial negativa, donde el número de éxitos es uno.

- Distribución uniforme discreta , para un conjunto finito de valores (por ejemplo, el resultado de un dado justo)

- Distribución uniforme continua , para valores distribuidos de forma continua

- Distribución de Poisson , para el número de ocurrencias de un evento de tipo Poisson en un período de tiempo determinado

- Distribución exponencial , para el tiempo antes de que ocurra el siguiente evento de tipo Poisson

- Distribución gamma , para el tiempo antes de que ocurran los siguientes k eventos de tipo Poisson

- Distribución de chi-cuadrado , distribución de una suma de variables normales estándar al cuadrado; útil, por ejemplo, para inferencias sobre la varianza de muestra de muestras distribuidas normalmente (ver prueba de chi-cuadrado )

- Distribución t de Student , distribución de la relación entre una variable normal estándar y la raíz cuadrada de una variable chi cuadrado escalada ; útil para la inferencia sobre la media de muestras distribuidas normalmente con varianza desconocida (ver prueba t de Student )

- Distribución beta , para una única probabilidad (número real entre 0 y 1); conjugada a la distribución de Bernoulli y distribución binomial

Inferencia estadística

La inferencia estadística es el proceso de extraer conclusiones de datos que están sujetos a variación aleatoria, por ejemplo, errores de observación o variación de muestreo. [7] Los requisitos iniciales de un sistema de procedimientos de inferencia e inducción de este tipo son que el sistema debe producir respuestas razonables cuando se aplica a situaciones bien definidas y que debe ser lo suficientemente general como para ser aplicado en una variedad de situaciones. Las estadísticas inferenciales se utilizan para probar hipótesis y hacer estimaciones utilizando datos de muestra. Mientras que las estadísticas descriptivas describen una muestra, las estadísticas inferenciales infieren predicciones sobre una población más grande que la muestra representa.

El resultado de la inferencia estadística puede ser una respuesta a la pregunta "¿qué se debe hacer a continuación?", que puede ser una decisión sobre la realización de más experimentos o encuestas, o sobre la obtención de una conclusión antes de implementar alguna política organizacional o gubernamental. En su mayor parte, la inferencia estadística formula proposiciones sobre poblaciones, utilizando datos extraídos de la población de interés mediante alguna forma de muestreo aleatorio. En términos más generales, los datos sobre un proceso aleatorio se obtienen a partir de su comportamiento observado durante un período finito de tiempo. Dado un parámetro o hipótesis sobre el cual se desea realizar una inferencia, la inferencia estadística utiliza con mayor frecuencia:

- un modelo estadístico del proceso aleatorio que se supone genera los datos, que se conoce cuando se ha utilizado la aleatorización, y

- una realización particular del proceso aleatorio, es decir, un conjunto de datos.

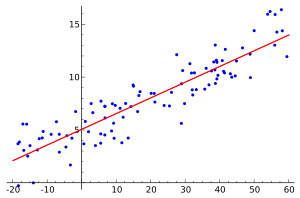

Regresión

En estadística , el análisis de regresión es un proceso estadístico para estimar las relaciones entre variables. Incluye muchas formas de modelar y analizar varias variables, cuando el enfoque está en la relación entre una variable dependiente y una o más variables independientes . Más específicamente, el análisis de regresión ayuda a comprender cómo cambia el valor típico de la variable dependiente (o "variable de criterio") cuando se varía cualquiera de las variables independientes, mientras que las otras variables independientes se mantienen fijas. Lo más común es que el análisis de regresión estime la expectativa condicional de la variable dependiente dadas las variables independientes, es decir, el valor promedio de la variable dependiente cuando las variables independientes son fijas. Con menos frecuencia, el enfoque está en un cuartil u otro parámetro de ubicación de la distribución condicional de la variable dependiente dadas las variables independientes. En todos los casos, el objetivo de la estimación es una función de las variables independientes llamada función de regresión . En el análisis de regresión, también es de interés caracterizar la variación de la variable dependiente alrededor de la función de regresión, que puede describirse mediante una distribución de probabilidad .

Se han desarrollado muchas técnicas para realizar análisis de regresión. Los métodos conocidos, como la regresión lineal , son paramétricos , en el sentido de que la función de regresión se define en términos de un número finito de parámetros desconocidos que se estiman a partir de los datos (por ejemplo, utilizando mínimos cuadrados ordinarios ). La regresión no paramétrica se refiere a técnicas que permiten que la función de regresión se encuentre en un conjunto específico de funciones , que pueden ser de dimensión infinita .

Estadísticas no paramétricas

Las estadísticas no paramétricas son valores calculados a partir de datos de una manera que no se basa en familias parametrizadas de distribuciones de probabilidad . Incluyen tanto estadísticas descriptivas como inferenciales . Los parámetros típicos son las expectativas, la varianza, etc. A diferencia de las estadísticas paramétricas , las estadísticas no paramétricas no hacen suposiciones sobre las distribuciones de probabilidad de las variables que se evalúan. [8]

Los métodos no paramétricos se utilizan ampliamente para estudiar poblaciones que adoptan un orden jerárquico (como las reseñas de películas que reciben de una a cuatro estrellas). El uso de métodos no paramétricos puede ser necesario cuando los datos tienen una clasificación pero no una interpretación numérica clara, como cuando se evalúan las preferencias . En términos de niveles de medición , los métodos no paramétricos dan como resultado datos "ordinales".

Como los métodos no paramétricos hacen menos suposiciones, su aplicabilidad es mucho más amplia que la de los métodos paramétricos correspondientes. En particular, pueden aplicarse en situaciones en las que se sabe menos sobre la aplicación en cuestión. Además, debido a que dependen de menos suposiciones, los métodos no paramétricos son más robustos .

Una desventaja de los métodos no paramétricos es que, dado que no se basan en suposiciones, generalmente son menos potentes que sus contrapartes paramétricas. [9] Las pruebas no paramétricas de baja potencia son problemáticas porque un uso común de estos métodos es cuando una muestra tiene un tamaño de muestra bajo. [9] Se ha demostrado que muchos métodos paramétricos son las pruebas más potentes a través de métodos como el lema de Neyman-Pearson y la prueba de razón de verosimilitud .

Otra justificación para el uso de métodos no paramétricos es la simplicidad. En ciertos casos, incluso cuando el uso de métodos paramétricos está justificado, los métodos no paramétricos pueden ser más fáciles de usar. Debido tanto a esta simplicidad como a su mayor solidez, algunos estadísticos consideran que los métodos no paramétricos dejan menos margen para el uso indebido y los malentendidos.

Estadística, matemáticas y estadística matemática

La estadística matemática es un subconjunto clave de la disciplina de la estadística . Los teóricos estadísticos estudian y mejoran los procedimientos estadísticos con las matemáticas, y la investigación estadística a menudo plantea cuestiones matemáticas.

Matemáticos y estadísticos como Gauss , Laplace y CS Peirce utilizaron la teoría de la decisión con distribuciones de probabilidad y funciones de pérdida (o funciones de utilidad ). El enfoque teórico de la decisión para la inferencia estadística fue revigorizado por Abraham Wald y sus sucesores, [10] [11] [12] [13] [14] [15] [16] y hace un uso extensivo de la computación científica , el análisis y la optimización ; para el diseño de experimentos , los estadísticos utilizan el álgebra y la combinatoria . Pero si bien la práctica estadística a menudo se basa en la probabilidad y la teoría de la decisión , su aplicación puede ser controvertida [4]

Véase también

Referencias

- ^ Kannan, D.; Lakshmikantham, V., eds. (2002). Manual de análisis estocástico y aplicaciones . Nueva York: M. Dekker. ISBN 0824706609.

- ^ Schervish, Mark J. (1995). Teoría de la estadística (Corr. 2.ª edición impresa). Nueva York: Springer. ISBN 0387945466.

- ^ Freedman, DA (2005) Modelos estadísticos: teoría y práctica , Cambridge University Press. ISBN 978-0-521-67105-7

- ^ ab Freedman, David A. (2010). Collier, David; Sekhon, Jasjeet S.; Stark, Philp B. (eds.). Modelos estadísticos e inferencia causal: un diálogo con las ciencias sociales. Cambridge University Press. ISBN 978-0-521-12390-7.

- ^ Hogg, RV, A. Craig y JW McKean. "Introducción a la estadística matemática" (2005).

- ^ Larsen, Richard J. y Marx, Morris L. "Introducción a la estadística matemática y sus aplicaciones" (2012). Prentice Hall.

- ^ Upton, G., Cook, I. (2008) Diccionario Oxford de Estadística , OUP. ISBN 978-0-19-954145-4

- ^ "Métodos no paramétricos de investigación". Universidad Carnegie Mellon . Consultado el 30 de agosto de 2022 .

- ^ ab "Pruebas no paramétricas". sphweb.bumc.bu.edu . Consultado el 31 de agosto de 2022 .

- ^ Wald, Abraham (1947). Análisis secuencial . Nueva York: John Wiley and Sons. ISBN 0-471-91806-7Véase la reimpresión de Dover

, 2004: ISBN 0-486-43912-7

- ^ Wald, Abraham (1950). Funciones de decisión estadística . John Wiley and Sons, Nueva York.

- ^ Lehmann, Erich (1997). Prueba de hipótesis estadísticas (2.ª ed.). ISBN 0-387-94919-4.

- ^ Lehmann, Erich ; Cassella, George (1998). Teoría de la estimación puntual (2.ª ed.). ISBN 0-387-98502-6.

- ^ Bickel, Peter J. ; Doksum, Kjell A. (2001). Estadística matemática: temas básicos y selectos . Vol. 1 (Segunda edición (impresión actualizada en 2007)). Pearson Prentice-Hall.

- ^ Le Cam, Lucien (1986). Métodos asintóticos en la teoría de decisiones estadísticas . Springer-Verlag. ISBN 0-387-96307-3.

- ^ Liese, Friedrich y Miescke, Klaus-J. (2008). Teoría de la decisión estadística: estimación, prueba y selección . Springer.

Lectura adicional

- Borovkov, AA (1999). Estadística matemática . CRC Press. ISBN 90-5699-018-7

- Laboratorios virtuales de probabilidad y estadística (Universidad de Alabama-Huntsville)

- StatiBot, sistema experto interactivo en línea sobre pruebas estadísticas.

- Ray, Manohar; Sharma, Har Swarup (1966). Estadística Matemática. Ram Prasad e hijos. Número de publicación: 978-9383385188