Estadística de pedidos

En estadística , la estadística de orden k de una muestra estadística es igual a su valor k más pequeño. [1] Junto con las estadísticas de rango , las estadísticas de orden se encuentran entre las herramientas más fundamentales en la estadística no paramétrica y la inferencia .

Los casos especiales importantes de las estadísticas de orden son el valor mínimo y máximo de una muestra y (con algunas salvedades que se analizan a continuación) la mediana de la muestra y otros cuartiles de la muestra .

Cuando se utiliza la teoría de probabilidad para analizar las estadísticas de orden de muestras aleatorias de una distribución continua , se utiliza la función de distribución acumulativa para reducir el análisis al caso de las estadísticas de orden de la distribución uniforme .

Notación y ejemplos

Por ejemplo, supongamos que se observan o registran cuatro números, lo que da como resultado una muestra de tamaño 4. Si los valores de la muestra son

- 6, 9, 3, 7,

Las estadísticas del pedido se indicarían

donde el subíndice ( i ) entre paréntesis indica el estadístico de orden i de la muestra.

La estadística de primer orden (o estadística de orden más pequeño ) es siempre el mínimo de la muestra, es decir,

donde, siguiendo una convención común, utilizamos letras mayúsculas para referirnos a variables aleatorias y letras minúsculas (como arriba) para referirnos a sus valores reales observados.

De manera similar, para una muestra de tamaño n , el estadístico de orden n (o estadístico de orden más grande ) es el máximo , es decir,

El rango de muestra es la diferencia entre el máximo y el mínimo. Es una función de las estadísticas de orden:

Una estadística importante similar en el análisis de datos exploratorios que está simplemente relacionada con las estadísticas de orden es el rango intercuartil de la muestra .

La mediana de la muestra puede ser o no un estadístico de orden, ya que hay un único valor medio solo cuando el número n de observaciones es impar . Más precisamente, si n = 2 m +1 para algún entero m , entonces la mediana de la muestra es y, por lo tanto, es un estadístico de orden. Por otro lado, cuando n es par , n = 2 m y hay dos valores medios, y , y la mediana de la muestra es alguna función de los dos (generalmente el promedio) y, por lo tanto, no es un estadístico de orden. Observaciones similares se aplican a todos los cuantiles de la muestra.

Análisis probabilístico

Dadas cualesquiera variables aleatorias X 1 , X 2 , ..., X n , las estadísticas de orden X (1) , X (2) , ..., X ( n ) también son variables aleatorias, definidas al ordenar los valores ( realizaciones ) de X 1 , ..., X n en orden creciente.

Cuando las variables aleatorias X 1 , X 2 , ..., X n forman una muestra son independientes y se distribuyen de forma idéntica . Este es el caso que se trata a continuación. En general, las variables aleatorias X 1 , ..., X n pueden surgir al muestrear más de una población. Entonces son independientes , pero no necesariamente se distribuyen de forma idéntica, y su distribución de probabilidad conjunta viene dada por el teorema de Bapat–Beg .

A partir de ahora, supondremos que las variables aleatorias en consideración son continuas y, cuando sea conveniente, supondremos también que tienen una función de densidad de probabilidad (PDF), es decir, que son absolutamente continuas . Las peculiaridades del análisis de distribuciones que asignan masa a puntos (en particular, distribuciones discretas ) se discuten al final.

Función de distribución acumulativa de las estadísticas de orden

Para una muestra aleatoria como la anterior, con distribución acumulativa , las estadísticas de orden para esa muestra tienen distribuciones acumulativas como las siguientes [2] (donde r especifica qué estadística de orden):

La función de densidad de probabilidad correspondiente se puede derivar de este resultado, y se encuentra que es

Además, hay dos casos especiales, que tienen CDF que son fáciles de calcular.

Lo cual puede deducirse mediante una cuidadosa consideración de las probabilidades.

Distribuciones de probabilidad de las estadísticas de orden

Estadísticas de orden tomadas de una distribución uniforme

En esta sección mostramos que las estadísticas de orden de la distribución uniforme en el intervalo unitario tienen distribuciones marginales que pertenecen a la familia de distribuciones beta . También proporcionamos un método simple para derivar la distribución conjunta de cualquier número de estadísticas de orden y, finalmente, traducimos estos resultados a distribuciones continuas arbitrarias utilizando la función de distribución acumulativa (cdf) .

En esta sección asumimos que se trata de una muestra aleatoria extraída de una distribución continua con función de distribución acumulativa . Denotando que obtenemos la muestra aleatoria correspondiente de la distribución uniforme estándar . Nótese que las estadísticas de orden también satisfacen .

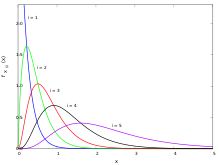

La función de densidad de probabilidad de la estadística de orden es igual a [3]

Es decir, la estadística de orden k de la distribución uniforme es una variable aleatoria distribuida en beta . [3] [4]

La prueba de estas afirmaciones es la siguiente. Para que u esté entre u y u + du , es necesario que exactamente k − 1 elementos de la muestra sean menores que u , y que al menos uno esté entre u y u + d u . La probabilidad de que más de uno esté en este último intervalo ya es , por lo que tenemos que calcular la probabilidad de que exactamente k − 1, 1 y n − k observaciones caigan en los intervalos , y respectivamente. Esto es igual a (consulte la distribución multinomial para obtener más detalles)

y el resultado sigue.

La media de esta distribución es k / ( n + 1).

Distribución conjunta de las estadísticas de orden de la distribución uniforme

De manera similar, para i < j , se puede demostrar que la función de densidad de probabilidad conjunta de las dos estadísticas de orden U ( i ) < U ( j ) es

que es (hasta términos de orden superior a ) la probabilidad de que i − 1, 1, j − 1 − i , 1 y n − j elementos de muestra caigan en los intervalos , , , , respectivamente.

Se razona de una manera completamente análoga para derivar las distribuciones conjuntas de orden superior. Tal vez sea sorprendente que la densidad conjunta de las estadísticas de orden n resulte constante :

Una forma de entender esto es que la muestra no ordenada tiene una densidad constante igual a 1, y que hay n ! permutaciones diferentes de la muestra correspondientes a la misma secuencia de estadísticas de orden. Esto está relacionado con el hecho de que 1/ n ! es el volumen de la región . También está relacionado con otra particularidad de las estadísticas de orden de las variables aleatorias uniformes: de la desigualdad BRS se deduce que el número máximo esperado de variables aleatorias uniformes U(0,1] que se pueden elegir de una muestra de tamaño n con una suma que no exceda de está acotado por encima de , que es, por tanto, invariante en el conjunto de todas con producto constante .

Utilizando las fórmulas anteriores, se puede derivar la distribución del rango de las estadísticas de orden, es decir, la distribución de , es decir, el máximo menos el mínimo. De manera más general, para , también tiene una distribución beta: A partir de estas fórmulas podemos derivar la covarianza entre dos estadísticas de orden: La fórmula se deduce de notar que y comparar eso con donde , que es la distribución real de la diferencia.

Estadísticas de orden muestreadas a partir de una distribución exponencial

Para una muestra aleatoria de tamaño n de una distribución exponencial con parámetro λ , las estadísticas de orden X ( i ) para i = 1,2,3, ..., n tienen cada una distribución

donde Z j son variables aleatorias exponenciales estándar iid (es decir, con parámetro de tasa 1). Este resultado fue publicado por primera vez por Alfréd Rényi . [5] [6]

Estadísticas de orden extraídas de una distribución Erlang

La transformada de Laplace de las estadísticas de orden se puede muestrear a partir de una distribución de Erlang a través de un método de conteo de trayectorias [ aclaración necesaria ] . [7]

La distribución conjunta de las estadísticas de orden de una distribución absolutamente continua

Si F X es absolutamente continua , tiene una densidad tal que , y podemos usar las sustituciones

y

para derivar las siguientes funciones de densidad de probabilidad para las estadísticas de orden de una muestra de tamaño n extraída de la distribución de X :

- dónde

- dónde

Aplicación: intervalos de confianza para cuantiles

Una pregunta interesante es qué tan bien funcionan las estadísticas de orden como estimadores de los cuantiles de la distribución subyacente.

Un ejemplo de muestra de tamaño pequeño

El caso más simple a considerar es qué tan bien la mediana de la muestra estima la mediana de la población.

Como ejemplo, considere una muestra aleatoria de tamaño 6. En ese caso, la mediana de la muestra se define generalmente como el punto medio del intervalo delimitado por las estadísticas de tercer y cuarto orden. Sin embargo, sabemos por la discusión anterior que la probabilidad de que este intervalo contenga realmente la mediana de la población es [ aclaración necesaria ]

Aunque la mediana de la muestra es probablemente una de las mejores estimaciones puntuales independientes de la distribución de la mediana de la población, lo que ilustra este ejemplo es que no es particularmente buena en términos absolutos. En este caso particular, un mejor intervalo de confianza para la mediana es el delimitado por las estadísticas de segundo y quinto orden, que contiene la mediana de la población con probabilidad

Con un tamaño de muestra tan pequeño, si se desea tener al menos un 95% de confianza, se debe decir que la mediana está entre el mínimo y el máximo de las 6 observaciones con una probabilidad de 31/32 o aproximadamente el 97%. El tamaño 6 es, de hecho, el tamaño de muestra más pequeño tal que el intervalo determinado por el mínimo y el máximo es al menos un intervalo de confianza del 95% para la mediana de la población.

Muestras de gran tamaño

Para la distribución uniforme, cuando n tiende a infinito, el p -ésimo cuartil de muestra se distribuye normalmente de forma asintótica , ya que se aproxima mediante

Para una distribución general F con una densidad continua distinta de cero en F −1 ( p ), se aplica una normalidad asintótica similar:

donde f es la función de densidad y F −1 es la función cuantil asociada a F . Una de las primeras personas en mencionar y demostrar este resultado fue Frederick Mosteller en su artículo seminal de 1946. [8] Investigaciones posteriores condujeron en la década de 1960 a la representación de Bahadur , que proporciona información sobre los límites de error. La convergencia a la distribución normal también se cumple en un sentido más fuerte, como la convergencia en entropía relativa o la divergencia KL . [9]

Se puede hacer una observación interesante en el caso en que la distribución es simétrica y la mediana de la población es igual a la media de la población. En este caso, la media de la muestra , según el teorema del límite central , también se distribuye normalmente de forma asintótica, pero con una varianza σ 2 /n en su lugar. Este análisis asintótico sugiere que la media supera a la mediana en casos de baja curtosis y viceversa. Por ejemplo, la mediana logra mejores intervalos de confianza para la distribución de Laplace , mientras que la media funciona mejor para X que se distribuyen normalmente.

Prueba

Se puede demostrar que

dónde

siendo Z i variables aleatorias exponenciales independientes distribuidas de forma idéntica con tasa 1. Dado que X / n e Y / n se distribuyen normalmente de forma asintótica mediante la CLT, nuestros resultados se obtienen mediante la aplicación del método delta .

Aplicación: Estimación de densidad no paramétrica

Los momentos de la distribución para la estadística de primer orden se pueden utilizar para desarrollar un estimador de densidad no paramétrico. [10] Supongamos que queremos estimar la densidad en el punto . Consideremos las variables aleatorias , que son iid con función de distribución . En particular, .

El valor esperado de la estadística de primer orden dada una muestra de observaciones totales da como resultado:

donde es la función cuantil asociada con la distribución , y . Esta ecuación en combinación con una técnica de jackknifing se convierte en la base para el siguiente algoritmo de estimación de densidad,

Entrada: una muestra de observaciones, puntos de evaluación de densidad, parámetro de ajuste (normalmente 1/3). Salida: densidad estimada en los puntos de evaluación.

1: Conjunto 2: Conjunto 3: Cree una matriz que contenga subconjuntos con observaciones cada uno. 4: Cree un vector para almacenar las evaluaciones de densidad. 5: para hacer 6: para hacer 7: Encuentra la distancia más cercana al punto actual dentro del subconjunto n 8: fin para 9: Calcular el promedio del subconjunto de distancias a 10: Calcular la estimación de densidad en 11: fin para 12: regresar

A diferencia de los parámetros de ajuste basados en el ancho de banda/longitud para los enfoques basados en histogramas y kernel , el parámetro de ajuste para el estimador de densidad basado en la estadística de orden es el tamaño de los subconjuntos de la muestra. Este estimador es más robusto que los enfoques basados en histogramas y kernel; por ejemplo, las densidades como la distribución de Cauchy (que carece de momentos finitos) se pueden inferir sin la necesidad de modificaciones especializadas como los anchos de banda basados en IQR . Esto se debe a que el primer momento de la estadística de orden siempre existe si el valor esperado de la distribución subyacente existe, pero lo inverso no es necesariamente cierto. [11]

Manejo de variables discretas

Supongamos que hay variables aleatorias iid de una distribución discreta con función de distribución acumulativa y función de masa de probabilidad . Para encontrar las probabilidades de las estadísticas de orden, primero se necesitan tres valores, a saber:

La función de distribución acumulativa de la estadística de orden se puede calcular observando que

De manera similar, se da por

Nótese que la función de masa de probabilidad de es simplemente la diferencia de estos valores, es decir

Cálculo de estadísticas de pedidos

El problema de calcular el k -ésimo elemento más pequeño (o más grande) de una lista se denomina problema de selección y se resuelve mediante un algoritmo de selección. Aunque este problema es difícil para listas muy grandes, se han creado algoritmos de selección sofisticados que pueden resolver este problema en un tiempo proporcional al número de elementos de la lista, incluso si la lista está totalmente desordenada. Si los datos se almacenan en ciertas estructuras de datos especializadas, este tiempo se puede reducir a O(log n ). En muchas aplicaciones se requieren todas las estadísticas de orden, en cuyo caso se puede utilizar un algoritmo de ordenación y el tiempo empleado es O( n log n ).

Véase también

- Clasificación

- Diagrama de caja

- Desigualdad BRS

- Concomitante (estadística)

- Distribución de Fisher-Tippett

- Teorema de Bapat-Beg para las estadísticas de orden de variables aleatorias independientes pero no necesariamente idénticamente distribuidas

- Polinomio de Bernstein

- Estimador L : combinaciones lineales de estadísticas de orden

- Distribución por tamaño de rango

- Algoritmo de selección

Ejemplos de estadísticas de pedidos

- Muestra máxima y mínima

- Cuantil

- Percentil

- Décimo

- Cuartilla

- Mediana

- Significar

- Media y covarianza de la muestra

Aplicaciones

Las estadísticas de orden tienen muchas aplicaciones en áreas como la teoría de la confiabilidad, las matemáticas financieras, el análisis de supervivencia, la epidemiología, los deportes, el control de calidad, el riesgo actuarial, etc. Existe una extensa literatura dedicada a estudios sobre aplicaciones de las estadísticas de orden en estos campos.

Por ejemplo, una aplicación reciente en riesgo actuarial se puede encontrar en [12] , donde se proporcionan algunos principios de prima ponderada en términos de reclamaciones récord y k-ésimas reclamaciones récord.

This article includes a list of general references, but it lacks sufficient corresponding inline citations. (December 2010) |

Referencias

- ^ David, HA; Nagaraja, HN (2003). Estadísticas de pedidos . Serie Wiley en probabilidad y estadística. doi :10.1002/0471722162. ISBN 9780471722168.

- ^ Casella, George; Berger, Roger (2002). Inferencia estadística (2.ª ed.). Cengage Learning. pág. 229. ISBN 9788131503942.

- ^ ab Gentle, James E. (2009), Estadística computacional, Springer, pág. 63, ISBN 9780387981444.

- ^ Jones, MC (2009), "Distribución de Kumaraswamy: una distribución de tipo beta con algunas ventajas de manejabilidad", Metodología estadística , 6 (1): 70–81, doi :10.1016/j.stamet.2008.04.001,

Como es bien sabido, la distribución beta es la distribución del estadístico de orden

m

de una muestra aleatoria de tamaño

n

de la distribución uniforme (en (0,1)).

- ^ David, HA; Nagaraja, HN (2003), "Capítulo 2. Teoría básica de la distribución", Estadísticas de orden , Serie Wiley en probabilidad y estadística, p. 9, doi :10.1002/0471722162.ch2, ISBN 9780471722168

- ^ Rényi, Alfred (1953). "Sobre la teoría de la estadística del orden". Acta Mathematica Hungarica . 4 (3): 191–231. doi : 10.1007/BF02127580 .

- ^ Hlynka, M.; Brill, PH; Horn, W. (2010). "Un método para obtener transformadas de Laplace de estadísticas de orden de variables aleatorias de Erlang". Statistics & Probability Letters . 80 : 9–18. doi :10.1016/j.spl.2009.09.006.

- ^ Mosteller, Frederick (1946). "Sobre algunas estadísticas útiles e ineficientes". Anales de estadística matemática . 17 (4): 377–408. doi : 10.1214/aoms/1177730881 . Consultado el 26 de febrero de 2015 .

- ^ M. Cardone, A. Dytso y C. Rush, "Teorema del límite central entrópico para estadísticas de orden", en IEEE Transactions on Information Theory, vol. 69, núm. 4, págs. 2193-2205, abril de 2023, doi: 10.1109/TIT.2022.3219344.

- ^ Garg, Vikram V.; Tenorio, Luis; Willcox, Karen (2017). "Estimación de densidad de distancia local mínima". Comunicaciones en Estadística - Teoría y Métodos . 46 (1): 148–164. arXiv : 1412.2851 . doi :10.1080/03610926.2014.988260. S2CID 14334678.

- ^ David, HA; Nagaraja, HN (2003), "Capítulo 3. Valores esperados y momentos", Order Statistics , Wiley Series in Probability and Statistics, pág. 34, doi :10.1002/0471722162.ch3, ISBN 9780471722168

- ^ Castaño-Martínez, A.; López-Blázquez, F.; Pigueiras, G.; Sordo, MA (2020). "Un método para construir e interpretar algunos principios de prima ponderada". ASTIN Bulletin: The Journal of the IAA . 50(3): 1037–1064. doi :10.1017/asb.2020.15.

Enlaces externos

- Estadísticas de pedidos en PlanetMath . Consultado el 2 de febrero de 2005.

- Weisstein, Eric W. "Estadística de orden". MathWorld .Recuperado el 2 de febrero de 2005

- Estadísticas de orden dinámico de código fuente C++

![{\displaystyle F_{X_{(r)}}(x)=\sum _{j=r}^{n}{\binom {n}{j}}[F_{X}(x)]^{j }[1-F_{X}(x)]^{nj}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83743dea76239b9e15addd74a877f0c3b51ac769)

![{\displaystyle f_{X_{(r)}}(x)={\frac {n!}{(r-1)!(nr)!}}f_{X}(x)[F_{X}(x)]^{r-1}[1-F_{X}(x)]^{nr}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0bfc29ad37f782caf50c1fab6d501876a397a9a2)

![{\displaystyle F_{X_{(n)}}(x)=\operatorname {Prob} (\max\{\,X_{1},\ldots ,X_{n}\,\}\leq x)=[F_{X}(x)]^{n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/892b889a61d2577115a5d8c8ea010aaa6a03e840)

![{\displaystyle F_{X_{(1)}}(x)=\operatorname {Prob} (\min\{\,X_{1},\ldots ,X_{n}\,\}\leq x)=1-[1-F_{X}(x)]^{n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4600e4a349458eb8c93b2bcdc7dd7e10f491423)

![{\displaystyle f_{X_{(k)}}(x)={\frac {n!}{(k-1)!(nk)!}}[F_{X}(x)]^{k-1}[1-F_{X}(x)]^{nk}f_{X}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a3b85adac3788d1a67f96c80edfc10ad56cc8dba)

![{\displaystyle f_{X_{(j)},X_{(k)}}(x,y)={\frac {n!}{(j-1)!(kj-1)!(nk)!} }[F_{X}(x)]^{j-1}[F_{X}(y)-F_{X}(x)]^{k-1-j}[1-F_{X}(y )]^{nk}f_{X}(x)f_{X}(y)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7a57558c8a25cfa2a2648f386caa9679006499df)

^{6}={25 \sobre 32}\aproximadamente 78\%.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/092bfad29672b7903b0d5df1efb34f6c30c85c09)

![{\displaystyle X_{(\lceil np\rceil )}\sim AN\left(F^{-1}(p),{\frac {p(1-p)}{n[f(F^{-1}(p))]^{2}}}\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9ec5ea20cea909919df56456bd279b4c26c1091b)