Estadística

| Estadística |

|---|

|

| Parte de una serie sobre | ||

| Matemáticas | ||

|---|---|---|

Portal de Matemáticas Portal de Matemáticas | ||

La estadística (del alemán : Statistik , orig. "descripción de un estado , un país" [1] ) es la disciplina que se ocupa de la recopilación, organización, análisis, interpretación y presentación de datos . [2] Al aplicar la estadística a un problema científico, industrial o social, es convencional comenzar con una población estadística o un modelo estadístico a estudiar. Las poblaciones pueden ser grupos diversos de personas u objetos como "todas las personas que viven en un país" o "cada átomo que compone un cristal". La estadística se ocupa de todos los aspectos de los datos, incluida la planificación de la recopilación de datos en términos del diseño de encuestas y experimentos . [3]

Cuando no se pueden recopilar datos del censo , los estadísticos recopilan datos mediante el desarrollo de diseños de experimentos específicos y muestras de encuestas . El muestreo representativo garantiza que las inferencias y conclusiones puedan extenderse razonablemente de la muestra a la población en su conjunto. Un estudio experimental implica tomar medidas del sistema en estudio, manipular el sistema y luego tomar medidas adicionales utilizando el mismo procedimiento para determinar si la manipulación ha modificado los valores de las mediciones. Por el contrario, un estudio observacional no implica manipulación experimental.

En el análisis de datos se utilizan dos métodos estadísticos principales : la estadística descriptiva , que resume los datos de una muestra utilizando índices como la media o la desviación estándar , y la estadística inferencial , que extrae conclusiones de los datos que están sujetos a variación aleatoria (por ejemplo, errores de observación, variación de muestreo). [4] La estadística descriptiva se ocupa con mayor frecuencia de dos conjuntos de propiedades de una distribución (muestra o población): la tendencia central (o ubicación ) busca caracterizar el valor central o típico de la distribución, mientras que la dispersión (o variabilidad ) caracteriza el grado en que los miembros de la distribución se apartan de su centro y entre sí. Las inferencias realizadas mediante estadística matemática emplean el marco de la teoría de la probabilidad , que se ocupa del análisis de fenómenos aleatorios.

Un procedimiento estadístico estándar implica la recopilación de datos que conducen a una prueba de la relación entre dos conjuntos de datos estadísticos, o un conjunto de datos y datos sintéticos extraídos de un modelo idealizado. Se propone una hipótesis para la relación estadística entre los dos conjuntos de datos, una alternativa a una hipótesis nula idealizada de que no hay relación entre dos conjuntos de datos. El rechazo o la refutación de la hipótesis nula se realiza mediante pruebas estadísticas que cuantifican el sentido en el que la hipótesis nula puede demostrarse falsa, dados los datos que se utilizan en la prueba. Al trabajar a partir de una hipótesis nula, se reconocen dos formas básicas de error: errores de tipo I (la hipótesis nula se rechaza cuando de hecho es verdadera, dando un "falso positivo") y errores de tipo II (la hipótesis nula no se rechaza cuando de hecho es falsa, dando un "falso negativo"). Múltiples problemas han llegado a asociarse con este marco, que van desde la obtención de un tamaño de muestra suficiente hasta la especificación de una hipótesis nula adecuada. [4]

Los procesos de medición estadística también son propensos a errores en relación con los datos que generan. Muchos de estos errores se clasifican como aleatorios (ruido) o sistemáticos ( sesgo ), pero también pueden ocurrir otros tipos de errores (por ejemplo, errores garrafales, como cuando un analista informa unidades incorrectas). La presencia de datos faltantes o censurados puede dar lugar a estimaciones sesgadas y se han desarrollado técnicas específicas para abordar estos problemas.

Introducción

La estadística es un cuerpo de ciencias matemáticas que se ocupa de la recopilación, análisis, interpretación o explicación y presentación de datos [5] o como una rama de las matemáticas [6] . Algunos consideran que la estadística es una ciencia matemática distinta en lugar de una rama de las matemáticas. Si bien muchas investigaciones científicas hacen uso de datos, la estadística generalmente se ocupa del uso de datos en el contexto de la incertidumbre y la toma de decisiones ante la incertidumbre [7] [8] .

Al aplicar la estadística a un problema, es una práctica común comenzar con una población o un proceso a estudiar. Las poblaciones pueden ser temas diversos, como "todas las personas que viven en un país" o "cada átomo que compone un cristal". Lo ideal es que los estadísticos recopilen datos sobre toda la población (una operación llamada censo ). Esto puede ser organizado por institutos estadísticos gubernamentales. Las estadísticas descriptivas se pueden utilizar para resumir los datos de la población. Los descriptores numéricos incluyen la media y la desviación estándar para datos continuos (como el ingreso), mientras que la frecuencia y el porcentaje son más útiles en términos de descripción de datos categóricos (como la educación).

Cuando no es posible realizar un censo, se estudia un subconjunto elegido de la población, llamado muestra . Una vez que se determina una muestra que es representativa de la población, se recopilan datos de los miembros de la muestra en un entorno observacional o experimental . Nuevamente, se pueden utilizar estadísticas descriptivas para resumir los datos de la muestra. Sin embargo, extraer la muestra contiene un elemento de aleatoriedad; por lo tanto, los descriptores numéricos de la muestra también son propensos a la incertidumbre. Para extraer conclusiones significativas sobre toda la población, se necesitan estadísticas inferenciales . Utiliza patrones en los datos de la muestra para extraer inferencias sobre la población representada teniendo en cuenta la aleatoriedad. Estas inferencias pueden tomar la forma de responder a preguntas de sí/no sobre los datos ( prueba de hipótesis ), estimar características numéricas de los datos ( estimación ), describir asociaciones dentro de los datos ( correlación ) y modelar relaciones dentro de los datos (por ejemplo, utilizando análisis de regresión ). La inferencia puede extenderse al pronóstico , predicción y estimación de valores no observados ya sea en la población en estudio o asociados con ella. Puede incluir extrapolación e interpolación de series de tiempo o datos espaciales , así como minería de datos .

Estadística matemática

La estadística matemática es la aplicación de las matemáticas a la estadística. Las técnicas matemáticas utilizadas para ello incluyen el análisis matemático , el álgebra lineal , el análisis estocástico , las ecuaciones diferenciales y la teoría de la probabilidad basada en la medida . [9] [10]

Historia

Las discusiones formales sobre la inferencia se remontan a los matemáticos y criptógrafos de la Edad de Oro islámica entre los siglos VIII y XIII. Al-Khalil (717-786) escribió el Libro de los mensajes criptográficos , que contiene uno de los primeros usos de permutaciones y combinaciones , para enumerar todas las posibles palabras árabes con y sin vocales. [11] El Manuscrito de Al-Kindi sobre el descifrado de mensajes criptográficos proporcionó una descripción detallada de cómo utilizar el análisis de frecuencia para descifrar mensajes cifrados , proporcionando un ejemplo temprano de inferencia estadística para la decodificación . Ibn Adlan (1187-1268) más tarde hizo una importante contribución sobre el uso del tamaño de la muestra en el análisis de frecuencia. [11]

Aunque el término estadística fue introducido por el erudito italiano Girolamo Ghilini en 1589 con referencia a una colección de hechos e información sobre un estado, fue el alemán Gottfried Achenwall en 1749 quien comenzó a usar el término como una colección de información cuantitativa, en el uso moderno para esta ciencia. [12] [13] El primer escrito que contiene estadísticas en Europa se remonta a 1663, con la publicación de Natural and Political Observations upon the Bills of Mortality de John Graunt . [14] Las primeras aplicaciones del pensamiento estadístico giraban en torno a las necesidades de los estados de basar la política en datos demográficos y económicos, de ahí su etimología estadística . El alcance de la disciplina de la estadística se amplió a principios del siglo XIX para incluir la recopilación y el análisis de datos en general. Hoy en día, la estadística se emplea ampliamente en el gobierno, los negocios y las ciencias naturales y sociales.

Los fundamentos matemáticos de la estadística se desarrollaron a partir de discusiones sobre juegos de azar entre matemáticos como Gerolamo Cardano , Blaise Pascal , Pierre de Fermat y Christiaan Huygens . Aunque la idea de probabilidad ya se examinaba en el derecho y la filosofía antiguos y medievales (como en la obra de Juan Caramuel ), la teoría de la probabilidad como disciplina matemática recién tomó forma a fines del siglo XVII, particularmente en la obra póstuma de Jacob Bernoulli , Ars Conjectandi . [15] Este fue el primer libro en el que el reino de los juegos de azar y el reino de lo probable (que involucraba la opinión, la evidencia y el argumento) se combinaron y se sometieron a un análisis matemático. [16] El método de mínimos cuadrados fue descrito por primera vez por Adrien-Marie Legendre en 1805, aunque Carl Friedrich Gauss presumiblemente lo utilizó una década antes, en 1795. [17]

El campo moderno de la estadística surgió a finales del siglo XIX y principios del XX en tres etapas. [18] La primera ola, a principios del siglo, fue liderada por el trabajo de Francis Galton y Karl Pearson , quienes transformaron la estadística en una disciplina matemática rigurosa utilizada para el análisis, no solo en la ciencia, sino también en la industria y la política. Las contribuciones de Galton incluyeron la introducción de los conceptos de desviación estándar , correlación , análisis de regresión y la aplicación de estos métodos al estudio de la variedad de características humanas: altura, peso y longitud de las pestañas, entre otras. [19] Pearson desarrolló el coeficiente de correlación producto-momento de Pearson , definido como un producto-momento, [20] el método de momentos para el ajuste de distribuciones a muestras y la distribución de Pearson , entre muchas otras cosas. [21] Galton y Pearson fundaron Biometrika como la primera revista de estadística matemática y bioestadística (entonces llamada biometría ), y este último fundó el primer departamento de estadística universitaria del mundo en el University College de Londres . [22]

La segunda ola de las décadas de 1910 y 1920 fue iniciada por William Sealy Gosset y alcanzó su culminación en las ideas de Ronald Fisher , quien escribió los libros de texto que definirían la disciplina académica en las universidades de todo el mundo. Las publicaciones más importantes de Fisher fueron su artículo seminal de 1918 The Correlation between Relatives on the Supposition of Mendelian Inheritance (que fue el primero en utilizar el término estadístico varianza ), su obra clásica de 1925 Statistical Methods for Research Workers y su obra de 1935 The Design of Experiments , [23] [24] [25] donde desarrolló modelos rigurosos de diseño de experimentos . Originó los conceptos de suficiencia , estadística auxiliar , discriminador lineal de Fisher e información de Fisher . [26] También acuñó el término hipótesis nula durante el experimento de la dama degustando té , que "nunca se prueba ni se establece, pero posiblemente se refuta, en el curso de la experimentación". [27] [28] En su libro de 1930 La teoría genética de la selección natural , aplicó la estadística a varios conceptos biológicos como el principio de Fisher [29] (al que AWF Edwards llamó "probablemente el argumento más celebrado en biología evolutiva ") y el desbocado fisheriano , [30] [31] [32] [33] [34] [35] un concepto en selección sexual sobre un efecto desbocado de retroalimentación positiva encontrado en la evolución .

La última ola, que se caracterizó principalmente por el refinamiento y la expansión de los desarrollos anteriores, surgió del trabajo colaborativo entre Egon Pearson y Jerzy Neyman en la década de 1930. Introdujeron los conceptos de error " tipo II ", potencia de una prueba e intervalos de confianza . En 1934, Jerzy Neyman demostró que el muestreo aleatorio estratificado era en general un mejor método de estimación que el muestreo intencional (por cuotas). [36]

En la actualidad, los métodos estadísticos se aplican en todos los campos que implican la toma de decisiones, para hacer inferencias precisas a partir de un conjunto de datos recopilados y para tomar decisiones en situaciones de incertidumbre basadas en la metodología estadística. El uso de computadoras modernas ha acelerado los cálculos estadísticos a gran escala y también ha hecho posible nuevos métodos que son poco prácticos para realizar manualmente. La estadística sigue siendo un área de investigación activa, por ejemplo, en el problema de cómo analizar grandes cantidades de datos . [37]

Datos estadísticos

Recopilación de datos

Muestreo

Cuando no es posible recopilar datos censales completos, los estadísticos recopilan datos de muestra mediante el desarrollo de diseños de experimentos específicos y muestras de encuestas . La estadística en sí también proporciona herramientas para la predicción y el pronóstico a través de modelos estadísticos .

Para utilizar una muestra como guía para una población entera, es importante que represente verdaderamente a la población en general. El muestreo representativo garantiza que las inferencias y conclusiones puedan extenderse con seguridad de la muestra a la población en su conjunto. Un problema importante radica en determinar en qué medida la muestra elegida es realmente representativa. La estadística ofrece métodos para estimar y corregir cualquier sesgo en la muestra y en los procedimientos de recolección de datos. También existen métodos de diseño experimental que pueden reducir estos problemas al comienzo de un estudio, fortaleciendo su capacidad para discernir verdades sobre la población.

La teoría del muestreo es parte de la disciplina matemática de la teoría de la probabilidad . La probabilidad se utiliza en las estadísticas matemáticas para estudiar las distribuciones de muestreo de las estadísticas de muestra y, de manera más general, las propiedades de los procedimientos estadísticos . El uso de cualquier método estadístico es válido cuando el sistema o la población en consideración satisface los supuestos del método. La diferencia de punto de vista entre la teoría de la probabilidad clásica y la teoría del muestreo es, a grandes rasgos, que la teoría de la probabilidad parte de los parámetros dados de una población total para deducir probabilidades que pertenecen a las muestras. La inferencia estadística, sin embargo, se mueve en la dirección opuesta: infiere inductivamente a partir de muestras los parámetros de una población más grande o total.

Estudios experimentales y observacionales

Un objetivo común de un proyecto de investigación estadística es investigar la causalidad y, en particular, extraer una conclusión sobre el efecto de los cambios en los valores de los predictores o las variables independientes sobre las variables dependientes . Hay dos tipos principales de estudios estadísticos causales: estudios experimentales y estudios observacionales . En ambos tipos de estudios, se observa el efecto de las diferencias de una variable independiente (o variables) sobre el comportamiento de la variable dependiente. La diferencia entre los dos tipos radica en cómo se lleva a cabo realmente el estudio. Cada uno puede ser muy eficaz. Un estudio experimental implica tomar medidas del sistema en estudio, manipular el sistema y luego tomar medidas adicionales con diferentes niveles utilizando el mismo procedimiento para determinar si la manipulación ha modificado los valores de las mediciones. Por el contrario, un estudio observacional no implica manipulación experimental . En cambio, se recopilan datos y se investigan las correlaciones entre los predictores y la respuesta. Si bien las herramientas de análisis de datos funcionan mejor con datos de estudios aleatorios , también se aplican a otros tipos de datos (como experimentos naturales y estudios observacionales [38] ), para los cuales un estadístico usaría un método de estimación modificado y más estructurado (por ejemplo, estimación de diferencias en diferencias y variables instrumentales , entre muchos otros) que producen estimadores consistentes .

Experimentos

Los pasos básicos de un experimento estadístico son:

- Planificación de la investigación, incluida la búsqueda del número de réplicas del estudio, utilizando la siguiente información: estimaciones preliminares sobre el tamaño de los efectos del tratamiento , hipótesis alternativas y la variabilidad experimental estimada . Es necesario tener en cuenta la selección de sujetos experimentales y la ética de la investigación. Los estadísticos recomiendan que los experimentos comparen (al menos) un tratamiento nuevo con un tratamiento estándar o control, para permitir una estimación imparcial de la diferencia en los efectos del tratamiento.

- Diseño de experimentos , utilizando bloqueos para reducir la influencia de variables de confusión y asignación aleatoria de tratamientos a sujetos para permitir estimaciones imparciales de los efectos del tratamiento y del error experimental. En esta etapa, los experimentadores y estadísticos redactan el protocolo experimental que guiará la realización del experimento y que especifica el análisis primario de los datos experimentales.

- Realizar el experimento siguiendo el protocolo experimental y analizar los datos siguiendo el protocolo experimental.

- Examinar más a fondo el conjunto de datos en análisis secundarios, para sugerir nuevas hipótesis para estudios futuros.

- Documentar y presentar los resultados del estudio.

Los experimentos sobre el comportamiento humano tienen especial interés. El famoso estudio Hawthorne examinó los cambios en el entorno de trabajo en la planta Hawthorne de la Western Electric Company . Los investigadores estaban interesados en determinar si el aumento de la iluminación aumentaría la productividad de los trabajadores de la línea de montaje . Primero midieron la productividad en la planta, luego modificaron la iluminación en un área de la planta y verificaron si los cambios en la iluminación afectaban la productividad. Resultó que la productividad efectivamente mejoró (en las condiciones experimentales). Sin embargo, el estudio es muy criticado hoy en día por errores en los procedimientos experimentales, específicamente por la falta de un grupo de control y la ceguera . El efecto Hawthorne se refiere a encontrar que un resultado (en este caso, la productividad del trabajador) cambió debido a la observación en sí. Los participantes en el estudio Hawthorne se volvieron más productivos no porque se cambiara la iluminación, sino porque estaban siendo observados. [39]

Estudio observacional

Un ejemplo de un estudio observacional es aquel que explora la asociación entre el tabaquismo y el cáncer de pulmón. Este tipo de estudio normalmente utiliza una encuesta para recopilar observaciones sobre el área de interés y luego realiza un análisis estadístico. En este caso, los investigadores recopilarían observaciones tanto de fumadores como de no fumadores, tal vez a través de un estudio de cohorte , y luego buscarían el número de casos de cáncer de pulmón en cada grupo. [40] Un estudio de casos y controles es otro tipo de estudio observacional en el que se invita a participar a personas con y sin el resultado de interés (por ejemplo, cáncer de pulmón) y se recopilan sus antecedentes de exposición.

Tipos de datos

Se han hecho varios intentos para producir una taxonomía de niveles de medición . El psicofísico Stanley Smith Stevens definió las escalas nominal, ordinal, de intervalo y de razón. Las mediciones nominales no tienen un orden de clasificación significativo entre los valores y permiten cualquier transformación uno a uno (inyectiva). Las mediciones ordinales tienen diferencias imprecisas entre valores consecutivos, pero tienen un orden significativo para esos valores y permiten cualquier transformación que preserve el orden. Las mediciones de intervalo tienen distancias significativas entre mediciones definidas, pero el valor cero es arbitrario (como en el caso de las mediciones de longitud y temperatura en Celsius o Fahrenheit ), y permiten cualquier transformación lineal. Las mediciones de razón tienen un valor cero significativo y las distancias entre diferentes mediciones definidas, y permiten cualquier transformación de reescalado.

Debido a que las variables que se ajustan únicamente a mediciones nominales u ordinales no se pueden medir razonablemente de forma numérica, a veces se agrupan como variables categóricas , mientras que las mediciones de razón e intervalo se agrupan como variables cuantitativas , que pueden ser discretas o continuas , debido a su naturaleza numérica. Tales distinciones a menudo se pueden correlacionar vagamente con el tipo de datos en informática, en el sentido de que las variables categóricas dicotómicas se pueden representar con el tipo de datos booleano , las variables categóricas politómicas con números enteros asignados arbitrariamente en el tipo de datos integral y las variables continuas con el tipo de datos real que implica aritmética de punto flotante . Pero la asignación de los tipos de datos de informática a los tipos de datos estadísticos depende de qué categorización de estos últimos se esté implementando.

Se han propuesto otras categorizaciones. Por ejemplo, Mosteller y Tukey (1977) [41] distinguieron grados, rangos, fracciones contadas, conteos, cantidades y saldos. Nelder (1990) [42] describió conteos continuos, razones continuas, razones de conteo y modos categóricos de datos. (Véase también: Chrisman (1998), [43] van den Berg (1991). [44] )

La cuestión de si es o no apropiado aplicar diferentes tipos de métodos estadísticos a datos obtenidos a partir de diferentes tipos de procedimientos de medición se complica por cuestiones relacionadas con la transformación de variables y la interpretación precisa de las preguntas de investigación. "La relación entre los datos y lo que describen simplemente refleja el hecho de que ciertos tipos de afirmaciones estadísticas pueden tener valores de verdad que no son invariables bajo ciertas transformaciones. Que sea o no sensato contemplar una transformación depende de la pregunta que uno esté tratando de responder". [45] : 82

Métodos

Esta sección necesita citas adicionales para su verificación . ( Diciembre de 2020 ) |

Estadísticas descriptivas

Una estadística descriptiva (en el sentido de sustantivo contable ) es una estadística de resumen que describe o resume cuantitativamente las características de una colección de información , [46] mientras que la estadística descriptiva en el sentido de sustantivo de masa es el proceso de usar y analizar esas estadísticas. La estadística descriptiva se distingue de la estadística inferencial (o estadística inductiva), en que la estadística descriptiva tiene como objetivo resumir una muestra , en lugar de usar los datos para aprender sobre la población que se cree que representa la muestra de datos. [47]

Estadística inferencial

La inferencia estadística es el proceso de utilizar el análisis de datos para deducir propiedades de una distribución de probabilidad subyacente . [48] El análisis estadístico inferencial infiere propiedades de una población , por ejemplo, probando hipótesis y derivando estimaciones. Se supone que el conjunto de datos observados se toma como muestra de una población más grande. Las estadísticas inferenciales se pueden contrastar con las estadísticas descriptivas . Las estadísticas descriptivas se ocupan únicamente de las propiedades de los datos observados y no se basan en el supuesto de que los datos provienen de una población más grande. [49]

Terminología y teoría de la estadística inferencial

Estadísticas, estimadores y magnitudes fundamentales

Considérense variables aleatorias independientes distribuidas idénticamente (IID) con una distribución de probabilidad dada : la teoría de estimación e inferencia estadística estándar define una muestra aleatoria como el vector aleatorio dado por el vector columna de estas variables IID. [50] La población que se examina se describe mediante una distribución de probabilidad que puede tener parámetros desconocidos.

Una estadística es una variable aleatoria que es una función de la muestra aleatoria, pero no una función de parámetros desconocidos . Sin embargo, la distribución de probabilidad de la estadística puede tener parámetros desconocidos. Consideremos ahora una función del parámetro desconocido: un estimador es una estadística utilizada para estimar dicha función. Los estimadores comúnmente utilizados incluyen la media de la muestra , la varianza de la muestra no sesgada y la covarianza de la muestra .

Una variable aleatoria que es una función de la muestra aleatoria y del parámetro desconocido, pero cuya distribución de probabilidad no depende del parámetro desconocido se denomina magnitud pivote o pivote. Entre los pivotes más utilizados se encuentran la puntuación z , el estadístico de chi cuadrado y el valor t de Student .

Entre dos estimadores de un parámetro dado, se dice que el que tiene un error cuadrático medio menor es más eficiente . Además, se dice que un estimador es insesgado si su valor esperado es igual al valor verdadero del parámetro desconocido que se está estimando, y asintóticamente insesgado si su valor esperado converge en el límite al valor verdadero de dicho parámetro.

Otras propiedades deseables para los estimadores incluyen: estimadores UMVUE que tienen la varianza más baja para todos los valores posibles del parámetro a estimar (esta suele ser una propiedad más fácil de verificar que la eficiencia) y estimadores consistentes que convergen en probabilidad al valor verdadero de dicho parámetro.

Esto aún deja la cuestión de cómo obtener estimadores en una situación dada y realizar el cálculo, se han propuesto varios métodos: el método de momentos , el método de máxima verosimilitud , el método de mínimos cuadrados y el más reciente método de estimación de ecuaciones .

Hipótesis nula e hipótesis alternativa

La interpretación de la información estadística a menudo puede implicar el desarrollo de una hipótesis nula que suele ser (aunque no necesariamente) que no existe relación entre las variables o que no se produjo ningún cambio a lo largo del tiempo. [51] [52]

La mejor ilustración para un novato es la situación difícil que se presenta en un juicio penal. La hipótesis nula, H 0 , afirma que el acusado es inocente, mientras que la hipótesis alternativa, H 1 , afirma que el acusado es culpable. La acusación se produce debido a la sospecha de culpabilidad. La H 0 (statu quo) se opone a H 1 y se mantiene a menos que H 1 esté respaldada por pruebas "más allá de toda duda razonable". Sin embargo, "no rechazar H 0 " en este caso no implica inocencia, sino simplemente que las pruebas eran insuficientes para condenar. Por lo tanto, el jurado no necesariamente acepta H 0 pero no rechaza H 0 . Si bien no se puede "probar" una hipótesis nula, se puede probar qué tan cerca está de ser verdadera con una prueba de potencia , que prueba los errores de tipo II .

Lo que los estadísticos llaman una hipótesis alternativa es simplemente una hipótesis que contradice la hipótesis nula.

Error

Partiendo de una hipótesis nula , se reconocen dos grandes categorías de error:

- Errores tipo I donde la hipótesis nula se rechaza falsamente, dando un "falso positivo".

- Errores de tipo II en los que no se puede rechazar la hipótesis nula y se pasa por alto una diferencia real entre poblaciones, lo que da un "falso negativo".

La desviación estándar se refiere al grado en que las observaciones individuales de una muestra difieren de un valor central, como la media de la muestra o de la población, mientras que el error estándar se refiere a una estimación de la diferencia entre la media de la muestra y la media de la población.

Un error estadístico es la cantidad en la que una observación difiere de su valor esperado . Un residuo es la cantidad en la que una observación difiere del valor que el estimador del valor esperado supone en una muestra dada (también llamado predicción).

El error cuadrático medio se utiliza para obtener estimadores eficientes , una clase de estimadores ampliamente utilizada. El error cuadrático medio es simplemente la raíz cuadrada del error cuadrático medio.

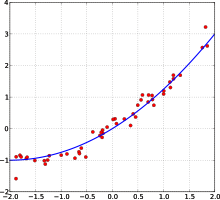

Muchos métodos estadísticos buscan minimizar la suma residual de cuadrados , y estos se denominan " métodos de mínimos cuadrados " en contraste con las desviaciones mínimas absolutas . Este último da el mismo peso a los errores pequeños y grandes, mientras que el primero da más peso a los errores grandes. La suma residual de cuadrados también es diferenciable , lo que proporciona una propiedad útil para hacer regresión . Los mínimos cuadrados aplicados a la regresión lineal se denominan método de mínimos cuadrados ordinarios y los mínimos cuadrados aplicados a la regresión no lineal se denominan mínimos cuadrados no lineales . También en un modelo de regresión lineal, la parte no determinista del modelo se denomina término de error, perturbación o, más simplemente, ruido. Tanto la regresión lineal como la regresión no lineal se abordan en los mínimos cuadrados polinomiales , que también describen la varianza en una predicción de la variable dependiente (eje y) como una función de la variable independiente (eje x) y las desviaciones (errores, ruido, perturbaciones) de la curva estimada (ajustada).

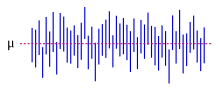

Los procesos de medición que generan datos estadísticos también están sujetos a errores. Muchos de estos errores se clasifican como aleatorios (ruido) o sistemáticos ( sesgo ), pero otros tipos de errores (por ejemplo, errores garrafales, como cuando un analista informa unidades incorrectas) también pueden ser importantes. La presencia de datos faltantes o censura puede dar lugar a estimaciones sesgadas y se han desarrollado técnicas específicas para abordar estos problemas. [53]

Estimación de intervalos

La mayoría de los estudios solo toman una muestra de una parte de la población, por lo que los resultados no representan completamente a toda la población. Cualquier estimación obtenida de la muestra solo se aproxima al valor de la población. Los intervalos de confianza permiten a los estadísticos expresar qué tan cerca la estimación de la muestra coincide con el valor verdadero en toda la población. A menudo se expresan como intervalos de confianza del 95%. Formalmente, un intervalo de confianza del 95% para un valor es un rango donde, si el muestreo y el análisis se repitieran en las mismas condiciones (lo que generaría un conjunto de datos diferente), el intervalo incluiría el valor verdadero (población) en el 95% de todos los casos posibles. Esto no implica que la probabilidad de que el valor verdadero esté en el intervalo de confianza sea del 95%. Desde la perspectiva frecuentista , tal afirmación ni siquiera tiene sentido, ya que el valor verdadero no es una variable aleatoria . El valor verdadero está o no está dentro del intervalo dado. Sin embargo, es cierto que, antes de que se muestren los datos y se proporcione un plan para construir el intervalo de confianza, la probabilidad de que el intervalo que aún no se ha calculado cubra el valor verdadero es del 95 %: en este punto, los límites del intervalo son variables aleatorias que aún no se han observado . Un enfoque que produce un intervalo que puede interpretarse como que tiene una probabilidad dada de contener el valor verdadero es utilizar un intervalo creíble de las estadísticas bayesianas : este enfoque depende de una forma diferente de interpretar lo que se entiende por "probabilidad" , es decir, como una probabilidad bayesiana .

En principio, los intervalos de confianza pueden ser simétricos o asimétricos. Un intervalo puede ser asimétrico porque funciona como límite inferior o superior de un parámetro (intervalo del lado izquierdo o intervalo del lado derecho), pero también puede ser asimétrico porque el intervalo bilateral se construye violando la simetría en torno a la estimación. A veces, los límites de un intervalo de confianza se alcanzan asintóticamente y estos se utilizan para aproximar los límites verdaderos.

Significado

Las estadísticas rara vez dan una respuesta simple del tipo Sí/No a la pregunta que se analiza. La interpretación a menudo se reduce al nivel de significación estadística aplicado a los números y, a menudo, se refiere a la probabilidad de que un valor rechace con precisión la hipótesis nula (a veces denominada valor p ).

El enfoque estándar [50] es probar una hipótesis nula contra una hipótesis alternativa. Una región crítica es el conjunto de valores del estimador que lleva a refutar la hipótesis nula. La probabilidad de error de tipo I es, por lo tanto, la probabilidad de que el estimador pertenezca a la región crítica dado que la hipótesis nula es verdadera ( significancia estadística ) y la probabilidad de error de tipo II es la probabilidad de que el estimador no pertenezca a la región crítica dado que la hipótesis alternativa es verdadera. El poder estadístico de una prueba es la probabilidad de que rechace correctamente la hipótesis nula cuando la hipótesis nula es falsa.

Hacer referencia a la significación estadística no significa necesariamente que el resultado general sea significativo en términos del mundo real. Por ejemplo, en un estudio a gran escala sobre un fármaco se puede demostrar que el fármaco tiene un efecto beneficioso estadísticamente significativo pero muy pequeño, de modo que es poco probable que el fármaco ayude al paciente de forma notable.

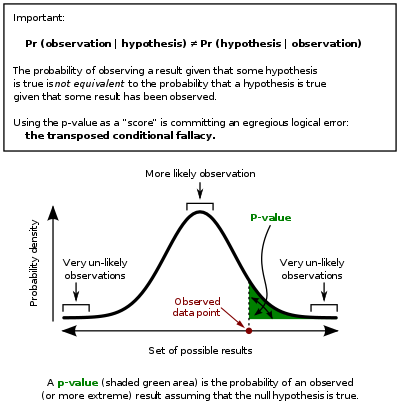

Aunque en principio el nivel aceptable de significación estadística puede ser objeto de debate, el nivel de significación es el valor p más grande que permite que la prueba rechace la hipótesis nula. Esta prueba es lógicamente equivalente a decir que el valor p es la probabilidad, suponiendo que la hipótesis nula es verdadera, de observar un resultado al menos tan extremo como el estadístico de prueba . Por lo tanto, cuanto menor sea el nivel de significación, menor será la probabilidad de cometer un error de tipo I.

Este marco suele estar asociado a algunos problemas (véase la crítica a las pruebas de hipótesis ):

- Una diferencia que es estadísticamente muy significativa puede no tener importancia práctica, pero es posible formular pruebas adecuadas para tenerla en cuenta. Una respuesta implica ir más allá de informar solo el nivel de significación para incluir el valor p al informar si una hipótesis es rechazada o aceptada. El valor p, sin embargo, no indica el tamaño o la importancia del efecto observado y también puede parecer exagerar la importancia de diferencias menores en estudios grandes. Un enfoque mejor y cada vez más común es informar los intervalos de confianza . Aunque estos se producen a partir de los mismos cálculos que los de las pruebas de hipótesis o los valores p , describen tanto el tamaño del efecto como la incertidumbre que lo rodea.

- Falacia del condicional transpuesto, también conocida como falacia del fiscal : las críticas surgen porque el enfoque de prueba de hipótesis obliga a favorecer una hipótesis (la hipótesis nula ), ya que lo que se evalúa es la probabilidad del resultado observado dada la hipótesis nula y no la probabilidad de la hipótesis nula dado el resultado observado. Una alternativa a este enfoque la ofrece la inferencia bayesiana , aunque requiere establecer una probabilidad previa . [54]

- Rechazar la hipótesis nula no prueba automáticamente la hipótesis alternativa.

- Como todo en estadística inferencial, se basa en el tamaño de la muestra y, por lo tanto, en colas gruesas, los valores p pueden calcularse de manera muy incorrecta. [ aclaración necesaria ]

Ejemplos

Algunas pruebas y procedimientos estadísticos bien conocidos son:

- Análisis de varianza (ANOVA)

- Prueba de chi-cuadrado

- Correlación

- Análisis factorial

- Universidad Mann-Whitney

- Desviación ponderada por el cuadrado medio (MSWD)

- Coeficiente de correlación producto-momento de Pearson

- Análisis de regresión

- Coeficiente de correlación de rangos de Spearman

- Prueba t de Student

- Análisis de series temporales

- Análisis conjunto

Análisis exploratorio de datos

El análisis exploratorio de datos ( EDA ) es un método para analizar conjuntos de datos con el fin de resumir sus características principales, a menudo con métodos visuales. Se puede utilizar un modelo estadístico o no, pero el EDA sirve principalmente para ver qué pueden decirnos los datos más allá de la tarea formal de modelado o prueba de hipótesis.

Mal uso

El uso incorrecto de las estadísticas puede producir errores sutiles pero graves en la descripción y la interpretación; sutiles en el sentido de que incluso los profesionales experimentados cometen esos errores, y graves en el sentido de que pueden conducir a errores de toma de decisiones devastadores. Por ejemplo, la política social, la práctica médica y la fiabilidad de estructuras como los puentes dependen del uso adecuado de las estadísticas.

Incluso cuando se aplican correctamente las técnicas estadísticas, los resultados pueden ser difíciles de interpretar para quienes carecen de experiencia. La significación estadística de una tendencia en los datos (que mide hasta qué punto una tendencia podría ser causada por una variación aleatoria en la muestra) puede o no coincidir con una sensación intuitiva de su significación. El conjunto de habilidades estadísticas básicas (y escepticismo) que las personas necesitan para manejar la información en su vida cotidiana de manera adecuada se conoce como alfabetización estadística .

Existe una percepción general de que el conocimiento estadístico se utiliza con demasiada frecuencia de forma intencionada y errónea al encontrar formas de interpretar solo los datos que son favorables para el presentador. [55] La desconfianza y la incomprensión de las estadísticas se asocian con la cita " Hay tres tipos de mentiras: mentiras, malditas mentiras y estadísticas ". El uso indebido de las estadísticas puede ser tanto involuntario como intencional, y el libro Cómo mentir con las estadísticas , [55] de Darrell Huff , describe una serie de consideraciones. En un intento de arrojar luz sobre el uso y el uso indebido de las estadísticas, se realizan revisiones de las técnicas estadísticas utilizadas en campos particulares (por ejemplo, Warne, Lazo, Ramos y Ritter (2012)). [56]

Las formas de evitar el mal uso de las estadísticas incluyen el uso de diagramas adecuados y evitar el sesgo . [57] El mal uso puede ocurrir cuando las conclusiones se generalizan en exceso y se afirma que son representativas de más de lo que realmente son, a menudo pasando por alto deliberada o inconscientemente el sesgo de muestreo. [58] Los gráficos de barras son posiblemente los diagramas más fáciles de usar y entender, y se pueden hacer a mano o con programas informáticos simples. [57] La mayoría de las personas no buscan sesgos o errores, por lo que no se notan. Por lo tanto, las personas a menudo pueden creer que algo es cierto incluso si no está bien representado . [58] Para que los datos recopilados de las estadísticas sean creíbles y precisos, la muestra tomada debe ser representativa del conjunto. [59] Según Huff, "La confiabilidad de una muestra puede ser destruida por [el sesgo]... permítase un cierto grado de escepticismo". [60]

Para ayudar a la comprensión de las estadísticas, Huff propuso una serie de preguntas que se plantearían en cada caso: [55]

- ¿Quién lo dice? (¿Tiene algún problema personal?)

- ¿Cómo lo sabe? (¿Tiene los recursos para conocer los hechos?)

- ¿Qué falta? (¿Nos da una imagen completa?)

- ¿Alguien cambió de tema? (¿Nos ofrece la respuesta correcta al problema equivocado?)

- ¿Tiene sentido? (¿Su conclusión es lógica y consistente con lo que ya sabemos?)

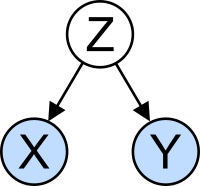

Interpretación errónea: correlación

El concepto de correlación es particularmente notable por la posible confusión que puede causar. El análisis estadístico de un conjunto de datos a menudo revela que dos variables (propiedades) de la población en consideración tienden a variar juntas, como si estuvieran conectadas. Por ejemplo, un estudio de los ingresos anuales que también analiza la edad de muerte, podría descubrir que las personas pobres tienden a tener vidas más cortas que las personas adineradas. Se dice que las dos variables están correlacionadas; sin embargo, pueden o no ser la causa una de la otra. Los fenómenos de correlación podrían ser causados por un tercer fenómeno, previamente no considerado, llamado variable latente o variable de confusión . Por esta razón, no hay forma de inferir inmediatamente la existencia de una relación causal entre las dos variables.

Aplicaciones

Estadística aplicada, estadística teórica y estadística matemática

La estadística aplicada, a veces denominada ciencia estadística, [61] comprende la estadística descriptiva y la aplicación de la estadística inferencial. [62] [63] La estadística teórica se ocupa de los argumentos lógicos que sustentan la justificación de los enfoques de la inferencia estadística , además de abarcar la estadística matemática . La estadística matemática incluye no solo la manipulación de las distribuciones de probabilidad necesarias para derivar resultados relacionados con los métodos de estimación e inferencia, sino también varios aspectos de la estadística computacional y el diseño de experimentos .

Los consultores estadísticos pueden ayudar a las organizaciones y empresas que no cuentan con experiencia interna relevante para sus preguntas específicas.

Aprendizaje automático y minería de datos

Los modelos de aprendizaje automático son modelos estadísticos y probabilísticos que capturan patrones en los datos mediante el uso de algoritmos computacionales.

La estadística en el ámbito académico

La estadística es aplicable a una amplia variedad de disciplinas académicas , incluidas las ciencias naturales y sociales , el gobierno y los negocios. La estadística empresarial aplica métodos estadísticos en econometría , auditoría y producción y operaciones, incluyendo la mejora de servicios y la investigación de mercados. [64] Un estudio de dos revistas de biología tropical encontró que las 12 pruebas estadísticas más frecuentes son: análisis de varianza (ANOVA), prueba de chi-cuadrado , prueba t de Student , regresión lineal , coeficiente de correlación de Pearson , prueba U de Mann-Whitney , prueba de Kruskal-Wallis , índice de diversidad de Shannon , prueba de rango de Tukey , análisis de conglomerados , coeficiente de correlación de rango de Spearman y análisis de componentes principales . [65]

Un curso típico de estadística cubre estadística descriptiva, probabilidad, distribuciones binomiales y normales , prueba de hipótesis e intervalos de confianza, regresión lineal y correlación. [66] Los cursos de estadística fundamental modernos para estudiantes universitarios se centran en la selección correcta de pruebas, la interpretación de resultados y el uso de software estadístico gratuito . [65]

Computación estadística

Los rápidos y sostenidos aumentos en la capacidad computacional a partir de la segunda mitad del siglo XX han tenido un impacto sustancial en la práctica de la ciencia estadística. Los primeros modelos estadísticos eran casi siempre de la clase de modelos lineales , pero las computadoras potentes, junto con los algoritmos numéricos adecuados , provocaron un mayor interés en los modelos no lineales (como las redes neuronales ), así como la creación de nuevos tipos, como los modelos lineales generalizados y los modelos multinivel .

El aumento de la potencia de cálculo también ha dado lugar a la creciente popularidad de los métodos computacionalmente intensivos basados en el remuestreo , como las pruebas de permutación y el bootstrap , mientras que técnicas como el muestreo de Gibbs han hecho más factible el uso de modelos bayesianos . La revolución informática tiene implicaciones para el futuro de la estadística con un nuevo énfasis en la estadística "experimental" y "empírica". En la actualidad, se encuentra disponible una gran cantidad de software estadístico tanto de propósito general como especial . Entre los ejemplos de software disponible capaz de realizar cálculos estadísticos complejos se incluyen programas como Mathematica , SAS , SPSS y R.

Estadísticas empresariales

En el ámbito empresarial, la "estadística" es una herramienta de apoyo a la toma de decisiones y la gestión muy utilizada . Se aplica especialmente en la gestión financiera , la gestión de marketing y la gestión de la producción , los servicios y las operaciones . [67] [68] La estadística también se utiliza mucho en la contabilidad de gestión y la auditoría . La disciplina de la ciencia de la gestión formaliza el uso de la estadística y otras matemáticas en el ámbito empresarial. ( La econometría es la aplicación de métodos estadísticos a los datos económicos con el fin de dar contenido empírico a las relaciones económicas ).

Un curso típico de "Estadística empresarial" está destinado a los estudiantes de negocios y cubre [69] estadísticas descriptivas ( recopilación , descripción, análisis y resumen de datos), probabilidad (normalmente las distribuciones binomial y normal ), prueba de hipótesis e intervalos de confianza, regresión lineal y correlación; los cursos (de seguimiento) pueden incluir pronósticos , series temporales , árboles de decisión , regresión lineal múltiple y otros temas de análisis empresarial en general. Los programas de certificación profesional , como el CFA , a menudo incluyen temas de estadística.

Estadística aplicada a las matemáticas o las artes

Tradicionalmente, la estadística se ocupaba de extraer inferencias utilizando una metodología semiestandarizada que era un "aprendizaje obligatorio" en la mayoría de las ciencias. Esta tradición ha cambiado con el uso de la estadística en contextos no inferenciales. Lo que antes se consideraba una materia árida, que en muchos campos se tomaba como requisito para obtener un título, ahora se ve con entusiasmo. [¿ Según quién? ] Inicialmente ridiculizada por algunos puristas matemáticos, ahora se considera una metodología esencial en ciertas áreas.

- En teoría de números , los diagramas de dispersión de datos generados por una función de distribución pueden transformarse con herramientas familiares utilizadas en estadística para revelar patrones subyacentes, que luego pueden conducir a hipótesis.

- Los métodos predictivos de estadística en la previsión que combinan la teoría del caos y la geometría fractal se pueden utilizar para crear obras de vídeo. [70]

- El arte procesual de Jackson Pollock se basaba en experimentos artísticos mediante los cuales se revelaban artísticamente distribuciones subyacentes en la naturaleza. [71] Con la llegada de las computadoras, se aplicaron métodos estadísticos para formalizar dichos procesos naturales impulsados por la distribución para crear y analizar videoarte en movimiento. [ cita requerida ]

- Los métodos estadísticos pueden utilizarse de forma predictiva en el arte escénico , como en un truco de cartas basado en un proceso de Markov que sólo funciona algunas veces y cuya ocurrencia puede predecirse utilizando una metodología estadística.

- Las estadísticas se pueden utilizar para crear arte de manera predictiva, como en el caso de la música estadística o estocástica inventada por Iannis Xenakis , donde la música es específica para cada interpretación. Aunque este tipo de arte no siempre resulta como se espera, se comporta de maneras que son predecibles y ajustables mediante el uso de las estadísticas.

Disciplinas especializadas

Las técnicas estadísticas se utilizan en una amplia gama de tipos de investigación científica y social, entre las que se incluyen: bioestadística , biología computacional , sociología computacional , biología de redes , ciencias sociales , sociología e investigación social . Algunos campos de investigación utilizan la estadística aplicada de forma tan extensa que cuentan con una terminología especializada . Estas disciplinas incluyen:

- Ciencia actuarial (evalúa el riesgo en las industrias de seguros y finanzas)

- Economía de la información aplicada

- Astroestadística (evaluación estadística de datos astronómicos)

- Bioestadística

- Quimiometría (para el análisis de datos de química )

- Minería de datos (aplicación de estadísticas y reconocimiento de patrones para descubrir conocimiento a partir de datos)

- Ciencia de datos ( )

- Demografía (estudio estadístico de las poblaciones)

- Econometría (análisis estadístico de datos económicos)

- Estadísticas energéticas

- Estadísticas de ingeniería

- Epidemiología (análisis estadístico de enfermedades)

- Geografía y sistemas de información geográfica , específicamente en análisis espacial

- Procesamiento de imágenes

- Jurimetría ( derecho )

- Estadísticas médicas

- Ciencia política

- Estadísticas psicológicas

- Ingeniería de confiabilidad

- Estadísticas sociales

- Mecánica estadística

Además, existen tipos particulares de análisis estadístico que también han desarrollado su propia terminología y metodología especializada:

- Remuestreo de Bootstrap / Jackknife

- Estadísticas multivariadas

- Clasificación estadística

- Análisis de datos estructurados

- Modelado de ecuaciones estructurales

- Metodología de la encuesta

- Análisis de supervivencia

- Estadísticas en varios deportes, particularmente en el béisbol (conocidas como sabermetría ) y el cricket

Las estadísticas son una herramienta fundamental en los negocios y la industria. Se utilizan para comprender la variabilidad de los sistemas de medición, controlar procesos (como en el control estadístico de procesos o SPC), resumir datos y tomar decisiones basadas en datos.

Véase también

- Estimación de abundancia

- Glosario de probabilidad y estadística

- Lista de asociaciones académicas de estadística

- Lista de publicaciones importantes en estadística

- Listado de servicios estadísticos nacionales e internacionales

- Lista de software estadístico

- Lista de artículos sobre estadísticas

- Listado de centros de consultoría estadística universitaria

- Notación en probabilidad y estadística

- Educación en estadística

- Día Mundial de la Estadística

- Estadísticas robustas

- Fundamentos y áreas principales de la estadística

- Filosofía de la estadística

- Interpretaciones de probabilidad

- Fundamentos de estadística

- Lista de estadísticos

- Estadísticas oficiales

- Análisis multivariante de varianza

Referencias

- ^

- "estadísticas" . Oxford English Dictionary (edición en línea). Oxford University Press . (Se requiere suscripción o membresía a una institución participante).

- "Estadística". Digitales Wörterbuch der deutschen Sprache (en alemán). Berlin-Brandenburgischen Akademie der Wissenschaften. Agosto de 2024.

- ^

- "Estadísticas". Referencia de Oxford . Oxford University Press. 2008. ISBN 978-0-19-954145-4.

- Romijn, Jan-Willem (2014). "Filosofía de la estadística". Stanford Encyclopedia of Philosophy .

- "Estadística". Diccionario Cambridge .

- ^ Dodge, Yadolah (2003). Diccionario Oxford de términos estadísticos . Oxford University Press. ISBN 0-19-920613-9.

- ^ ab Lund Research Ltd. "Estadística descriptiva e inferencial". statistics.laerd.com. Archivado desde el original el 2020-10-26 . Consultado el 2014-03-23 .

- ^ Moses, Lincoln E. (1986) Piense y explique con estadísticas , Addison-Wesley, ISBN 978-0-201-15619-5 , págs. 1-3

- ^ Hays, William Lee, (1973) Estadísticas para las ciencias sociales , Holt, Rinehart y Winston, pág. xii, ISBN 978-0-03-077945-9

- ^ Moore, David (1992). "La enseñanza de la estadística como una asignatura respetable". En F. Gordon; S. Gordon (eds.). Estadística para el siglo XXI . Washington, DC: Asociación Matemática de Estados Unidos. pp. 14-25. ISBN 978-0-88385-078-7.

- ^ Chance, Beth L .; Rossman, Allan J. (2005). "Prefacio" (PDF) . Investigación de conceptos, aplicaciones y métodos estadísticos . Duxbury Press. ISBN 978-0-495-05064-3Archivado (PDF) del original el 22 de noviembre de 2020. Consultado el 6 de diciembre de 2009 .

- ^ Lakshmikantham, D.; Kannan, V. (2002). Manual de análisis estocástico y aplicaciones . Nueva York: M. Dekker. ISBN 0824706609.

- ^ Schervish, Mark J. (1995). Teoría de la estadística (Corr. 2.ª edición impresa). Nueva York: Springer. ISBN 0387945466.

- ^ ab Broemeling, Lyle D. (1 de noviembre de 2011). "Un relato de la inferencia estadística temprana en la criptología árabe". The American Statistician . 65 (4): 255–257. doi :10.1198/tas.2011.10191. S2CID 123537702.

- ^ Ostasiewicz, Walenty (2014). "El surgimiento de la ciencia estadística". Śląski Przegląd Statystyczny . 12 (18): 76–77. doi : 10.15611/sps.2014.12.04 .

- ^ Bruneau, Quentin (2022). Los Estados y los amos del capital: préstamos soberanos, antiguos y nuevos. Columbia University Press . ISBN 978-0231555647.

- ^ Willcox, Walter (1938) "El fundador de la estadística". Revista del Instituto Internacional de Estadística 5(4): 321–328. JSTOR 1400906

- ^ Franklin, James (2002). La ciencia de la conjetura . Baltimore: Taylor & Francis. ISBN 978-0-8018-7109-2.

- ^

- Grattan-Guinness, I., ed. (2005). Escritos emblemáticos en matemáticas occidentales 1640-1940 . Elsevier. págs. 88-103. doi :10.1016/b978-0-444-50871-3.x5080-3. ISBN . 978-0-444-50871-3.

- Bernoulli, Jacob (2006) [1713]. El arte de conjeturar, junto con Carta a un amigo sobre sets en tenis de cancha. Traducido por Sylla, ED Johns Hopkins University Press. ISBN 978-0-8018-8235-7.

- ^ Lim, M. (2021). "Gauss, mínimos cuadrados y el planeta perdido". Actuaries Digital . Consultado el 1 de noviembre de 2022 .

- ^ Walker, Helen Mary (1975). Estudios sobre la historia del método estadístico. Arno. ISBN 978-0405066283.

- ^ Galton, F. (1877). "Leyes típicas de la herencia". Nature . 15 (388): 492–553. Bibcode :1877Natur..15..492.. doi : 10.1038/015492a0 .

- ^ Stigler, SM (1989). "Relato de Francis Galton sobre la invención de la correlación". Ciencia estadística . 4 (2): 73–79. doi : 10.1214/ss/1177012580 .

- ^ Pearson, K. (1900). "Sobre el criterio de que un sistema dado de desviaciones de lo probable en el caso de un sistema correlacionado de variables es tal que puede suponerse razonablemente que ha surgido de un muestreo aleatorio". Philosophical Magazine . Serie 5. 50 (302): 157–175. doi :10.1080/14786440009463897.

- ^ "Karl Pearson (1857–1936)". Departamento de Ciencias Estadísticas, University College London . Archivado desde el original el 25 de septiembre de 2008.

- ^ Box, JF (febrero de 1980). "RA Fisher y el diseño de experimentos, 1922-1926". The American Statistician . 34 (1): 1–7. doi :10.2307/2682986. JSTOR 2682986.

- ^ Yates, F. (junio de 1964). "Sir Ronald Fisher y el diseño de experimentos". Biometrics . 20 (2): 307–321. doi :10.2307/2528399. JSTOR 2528399.

- ^ Stanley, Julian C. (1966). "La influencia de "El diseño de experimentos" de Fisher en la investigación educativa treinta años después". Revista de investigación educativa estadounidense . 3 (3): 223–229. doi :10.3102/00028312003003223. JSTOR 1161806. S2CID 145725524.

- ^ Agresti, Alan; Hichcock, David B. (2005). "Inferencia bayesiana para análisis de datos categóricos" (PDF) . Métodos y aplicaciones estadísticas . 14 (3): 298. doi :10.1007/s10260-005-0121-y. S2CID 18896230. Archivado (PDF) desde el original el 2013-12-19 . Consultado el 2013-12-19 .

- ^ Cita OED: 1935 RA Fisher, El diseño de experimentos ii. 19, "Podemos hablar de esta hipótesis como la 'hipótesis nula', y la hipótesis nula nunca se prueba ni se establece, pero posiblemente se refuta en el curso de la experimentación".

- ^ Fisher 1971. Capítulo II: Los principios de la experimentación, ilustrados por un experimento psicofísico, Sección 8. La hipótesis nula

- ^ Edwards, AWF (1998). "Selección natural y proporción sexual: fuentes de Fisher". American Naturalist . 151 (6): 564–569. doi :10.1086/286141. PMID 18811377. S2CID 40540426.

- ^ Fisher, RA (1915) La evolución de la preferencia sexual. Eugenics Review (7) 184:192

- ^ Fisher, RA (1999) [1930]. La teoría genética de la selección natural . Oxford University Press. ISBN 0-19-850440-3.

- ^ Edwards, AWF (2000) Perspectivas: comentarios anecdóticos, históricos y críticos sobre genética. The Genetics Society of America (154) 1419:1426

- ^ Andersson, Malte (1994). Selección sexual. Princeton University Press. ISBN 0-691-00057-3.

- ^ Andersson, M. y Simmons, LW (2006) Selección sexual y elección de pareja. Tendencias, ecología y evolución (21) 296:302

- ^ Gayon, J. (2010) Selección sexual: otro proceso darwiniano. Cuentas Rendus Biologías (333) 134:144

- ^ Neyman, J. (1934). "Sobre los dos aspectos diferentes del método representativo: el método de muestreo estratificado y el método de selección intencional". Journal of the Royal Statistical Society . 97 (4): 557–625. doi :10.2307/2342192. JSTOR 2342192.

- ^ "La ciencia en un mundo complejo: Big Data: ¿oportunidad o amenaza?". Santa Fe Institute . 2 de diciembre de 2013. Archivado desde el original el 30 de mayo de 2016. Consultado el 13 de octubre de 2014 .

- ^ Freedman, DA (2005) Modelos estadísticos: teoría y práctica , Cambridge University Press. ISBN 978-0-521-67105-7

- ^ McCarney R, Warner J, Iliffe S, van Haselen R, Griffin M, Fisher P (2007). "El efecto Hawthorne: un ensayo controlado aleatorizado". BMC Med Res Methodol . 7 (1): 30. doi : 10.1186/1471-2288-7-30 . PMC 1936999 . PMID 17608932.

- ^ Rothman, Kenneth J; Greenland, Sander; Lash, Timothy, eds. (2008). "7". Epidemiología moderna (3.ª ed.). Lippincott Williams & Wilkins. pág. 100. ISBN 978-0781755641.

- ^ Mosteller, F. ; Tukey, JW (1977). Análisis de datos y regresión . Boston: Addison-Wesley.

- ^ Nelder, JA (1990). El conocimiento necesario para informatizar el análisis y la interpretación de la información estadística. En Expert systems and artificial intelligence: the need for information about data . Library Association Report, Londres, marzo, 23-27.

- ^ Chrisman, Nicholas R (1998). "Replanteamiento de los niveles de medición para la cartografía". Cartografía y ciencia de la información geográfica . 25 (4): 231–242. Bibcode :1998CGISy..25..231C. doi :10.1559/152304098782383043.

- ^ van den Berg, G. (1991). Elegir un método de análisis . Leiden: Prensa DSWO

- ^ Hand, DJ (2004). Teoría y práctica de la medición: El mundo a través de la cuantificación. Londres: Arnold.

- ^ Mann, Prem S. (1995). Introducción a la estadística (2.ª ed.). Wiley. ISBN 0-471-31009-3.

- ^ "Estadísticas descriptivas | Research Connections" (en inglés). www.researchconnections.org . Consultado el 10 de enero de 2023 .

- ^ Upton, G., Cook, I. (2008) Diccionario Oxford de Estadística , OUP. ISBN 978-0-19-954145-4 .

- ^ "Estadística inferencial básica - Purdue OWL® - Purdue University". owl.purdue.edu . Consultado el 10 de enero de 2023 .

- ^ ab Piazza Elio, Probabilità e Statistica, Esculapio 2007

- ^ Everitt, Brian (1998). Diccionario de estadística de Cambridge. Cambridge, Reino Unido. Nueva York: Cambridge University Press. ISBN 0521593468.

- ^ "Cohen (1994) La Tierra es redonda (p < .05)". YourStatsGuru.com. Archivado desde el original el 5 de septiembre de 2015. Consultado el 20 de julio de 2015 .

- ^ Rubin, Donald B.; Little, Roderick JA, Análisis estadístico con datos faltantes, Nueva York: Wiley 2002

- ^ Ioannidis, JPA (2005). "Por qué la mayoría de los hallazgos de investigación publicados son falsos". PLOS Medicine . 2 (8): e124. doi : 10.1371/journal.pmed.0020124 . PMC 1182327 . PMID 16060722.

- ^ abc Huff, Darrell (1954) Cómo mentir con estadísticas , WW Norton & Company, Inc. Nueva York. ISBN 0-393-31072-8

- ^ Warne, R. Lazo; Ramos, T.; Ritter, N. (2012). "Métodos estadísticos utilizados en revistas de educación para superdotados, 2006-2010". Gifted Child Quarterly . 56 (3): 134–149. doi :10.1177/0016986212444122. S2CID 144168910.

- ^ ab Drennan, Robert D. (2008). "Estadísticas en arqueología". En Pearsall, Deborah M. (ed.). Enciclopedia de arqueología . Elsevier Inc. pp. 2093–2100. ISBN 978-0-12-373962-9.

- ^ ab Cohen, Jerome B. (diciembre de 1938). "Uso indebido de las estadísticas". Revista de la Asociación Estadounidense de Estadística . 33 (204). JSTOR: 657–674. doi :10.1080/01621459.1938.10502344.

- ^ Freund, JE (1988). "Estadística elemental moderna". Referencia Credo .

- ^ Huff, Darrell; Irving Geis (1954). Cómo mentir con las estadísticas . Nueva York: Norton.

La fiabilidad de una muestra puede verse destruida por [el sesgo]... permítase cierto grado de escepticismo.

- ^ Nelder, John A. (1999). "From Statistics to Statistical Science" . Revista de la Royal Statistical Society. Serie D (The Statistician) . 48 (2): 257–269. doi :10.1111/1467-9884.00187. ISSN 0039-0526. JSTOR 2681191. Archivado desde el original el 2022-01-15 . Consultado el 2022-01-15 .

- ^ Nikoletseas, MM (2014) "Estadísticas: conceptos y ejemplos". ISBN 978-1500815684

- ^ Anderson, DR; Sweeney, DJ; Williams, TA (1994) Introducción a la estadística: conceptos y aplicaciones , págs. 5-9. West Group. ISBN 978-0-314-03309-3

- ^ "Journal of Business & Economic Statistics". Revista de estadísticas económicas y empresariales . Taylor & Francis. Archivado desde el original el 27 de julio de 2020. Consultado el 16 de marzo de 2020 .

- ^ ab Natalia Loaiza Velásquez, María Isabel González Lutz y Julián Monge-Nájera (2011). "¿Qué estadísticas deberían aprender los biólogos tropicales?" (PDF) . Revista de Biología Tropical . 59 (3): 983–992. PMID 22017105. Archivado (PDF) desde el original el 19 de octubre de 2020 . Consultado el 26 de abril de 2020 .

- ^ Pekoz, Erol (2009). La guía de estadística para administradores . Erol Pekoz. ISBN 978-0979570438.

- ^ "Objetivos y alcance". Journal of Business & Economic Statistics . Taylor & Francis. Archivado desde el original el 23 de junio de 2021 . Consultado el 16 de marzo de 2020 .

- ^ "Journal of Business & Economic Statistics". Revista de estadísticas económicas y empresariales . Taylor & Francis. Archivado desde el original el 27 de julio de 2020. Consultado el 16 de marzo de 2020 .

- ^ Existen numerosos textos que reflejan el alcance y la extensión de la disciplina en el mundo empresarial:

- Sharpe, N. (2014). Estadísticas empresariales , Pearson. ISBN 978-0134705217

- Wegner, T. (2010). Estadística empresarial aplicada: métodos y aplicaciones basadas en Excel, Juta Academic. ISBN 0702172863

- Holmes, L., Illowsky, B., Dean, S. (2017). Introducción a las estadísticas empresariales Archivado el 16 de junio de 2021 en Wayback Machine.

- Nica, M. (2013). Principios de estadística empresarial Archivado el 18 de mayo de 2021 en Wayback Machine.

- ^ Cline, Graysen (2019). Métodos estadísticos no paramétricos utilizando R. EDTECH. ISBN 978-1-83947-325-8. OCLC 1132348139. Archivado desde el original el 15 de mayo de 2022. Consultado el 16 de septiembre de 2021 .

- ^ Palacios, Bernardo; Rosario, Alfonso; Wilhelmus, Monica M.; Zetina, Sandra; Zenit, Roberto (2019-10-30). "Pollock evitó las inestabilidades hidrodinámicas para pintar con su técnica de goteo". PLOS ONE . 14 (10): e0223706. Bibcode :2019PLoSO..1423706P. doi : 10.1371/journal.pone.0223706 . ISSN 1932-6203. PMC 6821064 . PMID 31665191.

Lectura adicional

- Lydia Denworth, "Un problema significativo: los métodos científicos estándar están bajo fuego. ¿Cambiará algo?", Scientific American , vol. 321, núm. 4 (octubre de 2019), pp. 62-67. "El uso de valores p durante casi un siglo [desde 1925] para determinar la significación estadística de los resultados experimentales ha contribuido a una ilusión de certeza y [a] crisis de reproducibilidad en muchos campos científicos . Existe una creciente determinación de reformar el análisis estadístico... Algunos [investigadores] sugieren cambiar los métodos estadísticos, mientras que otros eliminarían un umbral para definir resultados "significativos"". (p. 63.)

- Barbara Illowsky; Susan Dean (2014). Introducción a la estadística. OpenStax CNX. ISBN 978-1938168208.

- Stockburger, David W. "Introducción a la estadística: conceptos, modelos y aplicaciones". Universidad Estatal de Missouri (3.ª edición web). Archivado desde el original el 28 de mayo de 2020.

- Estadísticas de OpenIntro Archivado el 16 de junio de 2019 en Wayback Machine , tercera edición por Diez, Barr y Cetinkaya-Rundel

- Stephen Jones, 2010. Estadística en psicología: explicaciones sin ecuaciones. Palgrave Macmillan. ISBN 978-1137282392 .

- Cohen, J (1990). "Cosas que he aprendido (hasta ahora)" (PDF) . American Psychologist . 45 (12): 1304–1312. doi :10.1037/0003-066x.45.12.1304. S2CID 7180431. Archivado desde el original (PDF) el 18 de octubre de 2017.

- Gigerenzer, G (2004). "Estadísticas sin sentido". Revista de socioeconomía . 33 (5): 587–606. doi :10.1016/j.socec.2004.09.033.

- Ioannidis, JPA (2005). "Por qué la mayoría de los hallazgos de investigación publicados son falsos". PLOS Medicine . 2 (4): 696–701. doi : 10.1371/journal.pmed.0040168 . PMC 1855693 . PMID 17456002.

Enlaces externos

- (Versión electrónica): TIBCO Software Inc. (2020). Libro de texto de ciencia de datos.

- Educación en estadística en línea: un curso de estudio multimedia interactivo. Desarrollado por la Universidad Rice (desarrollador principal), la Universidad de Houston Clear Lake, la Universidad Tufts y la Fundación Nacional de Ciencias.

- Recursos de computación estadística de la UCLA (archivados el 17 de julio de 2006)

- Filosofía de la estadística de la Enciclopedia de Filosofía de Stanford