Procesamiento de imágenes digitales

El procesamiento de imágenes digitales es el uso de una computadora digital para procesar imágenes digitales a través de un algoritmo . [1] [2] Como subcategoría o campo del procesamiento de señales digitales , el procesamiento de imágenes digitales tiene muchas ventajas sobre el procesamiento de imágenes analógicas . Permite aplicar una gama mucho más amplia de algoritmos a los datos de entrada y puede evitar problemas como la acumulación de ruido y distorsión durante el procesamiento. Dado que las imágenes se definen en dos dimensiones (quizás más), el procesamiento de imágenes digitales se puede modelar en forma de sistemas multidimensionales . La generación y el desarrollo del procesamiento de imágenes digitales se ven afectados principalmente por tres factores: primero, el desarrollo de las computadoras; [3] segundo, el desarrollo de las matemáticas (especialmente la creación y mejora de la teoría de las matemáticas discretas); [4] tercero, ha aumentado la demanda de una amplia gama de aplicaciones en el medio ambiente, la agricultura, el ejército, la industria y la ciencia médica. [5]

Historia

Muchas de las técnicas de procesamiento de imágenes digitales , o procesamiento de imágenes digitales como a menudo se lo llamaba, se desarrollaron en la década de 1960, en los Laboratorios Bell , el Laboratorio de Propulsión a Chorro , el Instituto Tecnológico de Massachusetts , la Universidad de Maryland y algunas otras instalaciones de investigación, con aplicación a imágenes satelitales , conversión de estándares de fotografía por cable , imágenes médicas , videoteléfono , reconocimiento de caracteres y mejora de fotografías. [6] El propósito del procesamiento de imágenes temprano era mejorar la calidad de la imagen. Estaba destinado a los seres humanos para mejorar el efecto visual de las personas. En el procesamiento de imágenes, la entrada es una imagen de baja calidad y la salida es una imagen con calidad mejorada. El procesamiento de imágenes común incluye la mejora, restauración, codificación y compresión de imágenes. La primera aplicación exitosa fue el Laboratorio Americano de Propulsión a Chorro (JPL). Utilizaron técnicas de procesamiento de imágenes como corrección geométrica, transformación de gradación, eliminación de ruido, etc. en las miles de fotos lunares enviadas por el Space Detector Ranger 7 en 1964, teniendo en cuenta la posición del Sol y el entorno de la Luna. El éxito de la elaboración de un mapa de la superficie lunar por ordenador ha sido un éxito. Más tarde, se realizó un procesamiento de imágenes más complejo de las casi 100.000 fotografías enviadas por la nave espacial, de modo que se obtuvieron el mapa topográfico, el mapa en color y el mosaico panorámico de la Luna, que lograron resultados extraordinarios y sentaron una base sólida para el aterrizaje humano en la Luna. [7]

Sin embargo, el costo del procesamiento era bastante alto con el equipo informático de esa época. Eso cambió en la década de 1970, cuando el procesamiento de imágenes digitales proliferó a medida que se disponía de computadoras más baratas y hardware dedicado. Esto llevó a que las imágenes se procesaran en tiempo real, para algunos problemas dedicados como la conversión de estándares de televisión . A medida que las computadoras de uso general se volvieron más rápidas, comenzaron a asumir el papel de hardware dedicado para todas las operaciones, excepto las más especializadas y de uso intensivo de la computadora. Con las computadoras rápidas y los procesadores de señales disponibles en la década de 2000, el procesamiento de imágenes digitales se ha convertido en la forma más común de procesamiento de imágenes y generalmente se usa porque no solo es el método más versátil, sino también el más barato.

Sensores de imagen

La base de los sensores de imagen modernos es la tecnología de semiconductor de óxido de metal (MOS), [8] inventada en Bell Labs entre 1955 y 1960, [9] [10] [11] [12] [13] [14] Esto condujo al desarrollo de sensores de imagen de semiconductores digitales, incluido el dispositivo de carga acoplada (CCD) y más tarde el sensor CMOS . [8]

El dispositivo acoplado por carga fue inventado por Willard S. Boyle y George E. Smith en Bell Labs en 1969. [15] Mientras investigaban la tecnología MOS, se dieron cuenta de que una carga eléctrica era la analogía de la burbuja magnética y que podía almacenarse en un pequeño condensador MOS . Como era bastante sencillo fabricar una serie de condensadores MOS en fila, les conectaron un voltaje adecuado para que la carga pudiera pasar de uno al siguiente. [8] El CCD es un circuito semiconductor que luego se utilizó en las primeras cámaras de video digitales para transmisión televisiva . [16]

El sensor de píxeles activos NMOS (APS) fue inventado por Olympus en Japón a mediados de la década de 1980. Esto fue posible gracias a los avances en la fabricación de dispositivos semiconductores MOS , con la escala MOSFET alcanzando niveles más pequeños de micrones y luego submicrones . [17] [18] El APS NMOS fue fabricado por el equipo de Tsutomu Nakamura en Olympus en 1985. [19] El sensor de píxeles activos CMOS (sensor CMOS) fue desarrollado posteriormente por el equipo de Eric Fossum en el Laboratorio de Propulsión a Chorro de la NASA en 1993. [20] En 2007, las ventas de sensores CMOS habían superado a las de los sensores CCD. [21]

Los sensores de imagen MOS se utilizan ampliamente en la tecnología de ratones ópticos . El primer ratón óptico, inventado por Richard F. Lyon en Xerox en 1980, utilizaba un chip sensor de circuito integrado NMOS de 5 μm . [22] [23] Desde el primer ratón óptico comercial, el IntelliMouse presentado en 1999, la mayoría de los dispositivos de ratón óptico utilizan sensores CMOS. [24] [25]

Compresión de imagen

Un desarrollo importante en la tecnología de compresión de imágenes digitales fue la transformada de coseno discreta (DCT), una técnica de compresión con pérdida propuesta por primera vez por Nasir Ahmed en 1972. [26] La compresión DCT se convirtió en la base de JPEG , que fue introducido por el Joint Photographic Experts Group en 1992. [27] JPEG comprime las imágenes a tamaños de archivo mucho más pequeños y se ha convertido en el formato de archivo de imagen más utilizado en Internet . [28] Su algoritmo de compresión DCT altamente eficiente fue en gran parte responsable de la amplia proliferación de imágenes digitales y fotografías digitales , [29] con varios miles de millones de imágenes JPEG producidas todos los días a partir de 2015. [actualizar][ 30]

Las técnicas de imágenes médicas producen cantidades muy grandes de datos, especialmente de las modalidades de TC, RMN y PET. Como resultado, el almacenamiento y las comunicaciones de datos de imágenes electrónicas son prohibitivos sin el uso de compresión. [31] [32] La compresión de imágenes JPEG 2000 es utilizada por el estándar DICOM para el almacenamiento y la transmisión de imágenes médicas. El costo y la viabilidad de acceder a grandes conjuntos de datos de imágenes a través de anchos de banda bajos o diversos se abordan además mediante el uso de otro estándar DICOM, llamado JPIP , para permitir la transmisión eficiente de los datos de imágenes comprimidas JPEG 2000. [33]

Procesador de señal digital (DSP)

El procesamiento de señales electrónicas se revolucionó con la amplia adopción de la tecnología MOS en la década de 1970. [34] La tecnología de circuitos integrados MOS fue la base de los primeros microprocesadores y microcontroladores de un solo chip a principios de la década de 1970, [35] y luego los primeros chips procesadores de señal digital (DSP) de un solo chip a fines de la década de 1970. [36] [37] Desde entonces, los chips DSP se han utilizado ampliamente en el procesamiento de imágenes digitales. [36]

El algoritmo de compresión de imágenes de transformada de coseno discreta (DCT) se ha implementado ampliamente en chips DSP, y muchas empresas desarrollan chips DSP basados en la tecnología DCT. Las DCT se utilizan ampliamente para codificación , decodificación, codificación de video , codificación de audio , multiplexación , señales de control, señalización , conversión de analógico a digital , formateo de diferencias de luminancia y color, y formatos de color como YUV444 y YUV411 . Las DCT también se utilizan para operaciones de codificación como estimación de movimiento , compensación de movimiento , predicción entre cuadros , cuantificación , ponderación perceptual, codificación de entropía , codificación variable y vectores de movimiento , y operaciones de decodificación como la operación inversa entre diferentes formatos de color ( YIQ , YUV y RGB ) para fines de visualización. Las DCT también se utilizan comúnmente para chips codificadores/decodificadores de televisión de alta definición (HDTV). [38]

Imágenes médicas

En 1972, el ingeniero de la empresa británica EMI Housfield inventó el aparato de tomografía computarizada de rayos X para el diagnóstico de la cabeza, que es lo que se suele llamar TC (tomografía computarizada). El método del núcleo de la TC se basa en la proyección de la sección de la cabeza humana y se procesa por ordenador para reconstruir la imagen de la sección transversal, lo que se denomina reconstrucción de imagen. En 1975, EMI desarrolló con éxito un dispositivo de TC para todo el cuerpo, que obtenía una imagen tomográfica clara de varias partes del cuerpo humano. En 1979, esta técnica de diagnóstico ganó el Premio Nobel. [7] La tecnología de procesamiento de imágenes digitales para aplicaciones médicas fue incluida en el Salón de la Fama de la Tecnología Espacial de la Fundación Espacial en 1994. [39]

En 2010, se habían realizado 5 mil millones de estudios de imágenes médicas en todo el mundo. [40] [41] La exposición a la radiación de las imágenes médicas en 2006 representó aproximadamente el 50% de la exposición total a la radiación ionizante en los Estados Unidos. [42] Los equipos de imágenes médicas se fabrican utilizando tecnología de la industria de semiconductores , incluidos chips de circuitos integrados CMOS , dispositivos semiconductores de potencia , sensores como sensores de imagen (en particular sensores CMOS ) y biosensores , y procesadores como microcontroladores , microprocesadores , procesadores de señales digitales , procesadores de medios y dispositivos de sistema en chip . En 2015 , los envíos anuales de chips de imágenes médicas ascienden a 46 millones de unidades y 1.100 millones de dólares . [43] [44][actualizar]

Tareas

El procesamiento de imágenes digitales permite el uso de algoritmos mucho más complejos y, por lo tanto, puede ofrecer un rendimiento más sofisticado en tareas simples y la implementación de métodos que serían imposibles por medios analógicos.

En particular, el procesamiento de imágenes digitales es una aplicación concreta y una tecnología práctica basada en:

- Clasificación

- Extracción de características

- Análisis de señales multiescala

- Reconocimiento de patrones

- Proyección

Algunas técnicas que se utilizan en el procesamiento de imágenes digitales incluyen:

- Difusión anisotrópica

- Modelos ocultos de Markov

- Edición de imágenes

- Restauración de imagen

- Análisis de componentes independientes

- Filtrado lineal

- Redes neuronales

- Ecuaciones diferenciales parciales

- Pixelación

- Coincidencia de características puntuales

- Análisis de componentes principales

- Mapas autoorganizados

- Ondículas

Transformaciones de imágenes digitales

Filtración

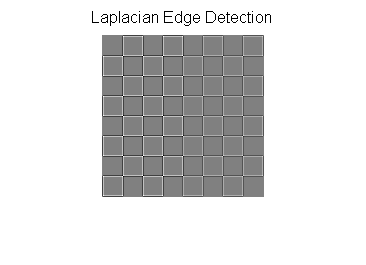

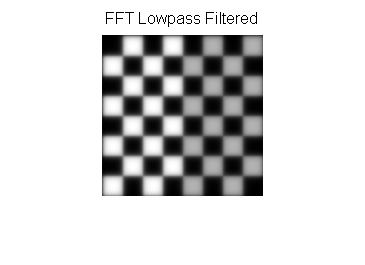

Los filtros digitales se utilizan para desenfocar y enfocar imágenes digitales. El filtrado se puede realizar de la siguiente manera:

- convolución con núcleos diseñados específicamente (matriz de filtros) en el dominio espacial [45]

- enmascaramiento de regiones de frecuencia específicas en el dominio de frecuencia (Fourier)

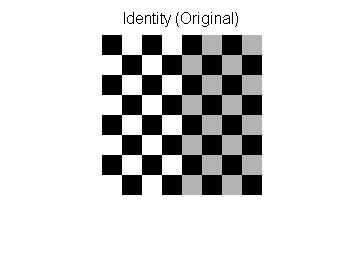

Los siguientes ejemplos muestran ambos métodos: [46]

| Tipo de filtro | Núcleo o máscara | Ejemplo |

|---|---|---|

| Imagen original |  | |

| Paso bajo espacial |  | |

| Paso alto espacial |  | |

| Representación de Fourier | Pseudocódigo: imagen = tablero de ajedrez F = Transformada de Fourier de la imagen Mostrar imagen: log(1+Valor absoluto(F)) |  |

| Paso bajo de Fourier |  |  |

| Paso alto de Fourier |  |  |

Relleno de imágenes en el filtrado de dominios de Fourier

Las imágenes generalmente se rellenan antes de transformarlas al espacio de Fourier; las imágenes filtradas de paso alto que aparecen a continuación ilustran las consecuencias de las diferentes técnicas de relleno:

| Cero rellenado | Borde repetido acolchado |

|---|---|

|  |

Tenga en cuenta que el filtro de paso alto muestra bordes adicionales cuando se rellena con ceros en comparación con el relleno de borde repetido.

Ejemplos de código de filtrado

Ejemplo de MATLAB para filtrado de paso alto en el dominio espacial.

img = checkerboard ( 20 ); % generar tablero de ajedrez % **************************** DOMINIO ESPACIAL *************************** klaplace =[ 0 - 1 0 ; - 1 5 - 1 ; 0 - 1 0 ]; % núcleo de filtro laplaciano X = conv2 ( img , klaplace ); % convolucionar probar img con % núcleo laplaciano 3x3 figure () imshow ( X ,[]) % mostrar título filtrado laplaciano ( 'Detección de bordes laplacianos' ) Transformaciones afines

Las transformaciones afines permiten transformaciones básicas de imágenes, incluyendo escala, rotación, traslación, espejo y corte, como se muestra en los siguientes ejemplos: [46]

| Nombre de la transformación | Matriz afín | Ejemplo |

|---|---|---|

| Identidad |  | |

| Reflexión |  | |

| Escala |  | |

| Girar |  donde θ = π/6 =30° donde θ = π/6 =30° | |

| Cortar |  |

Para aplicar la matriz afín a una imagen, la imagen se convierte en una matriz en la que cada entrada corresponde a la intensidad del píxel en esa ubicación. Luego, la ubicación de cada píxel se puede representar como un vector que indica las coordenadas de ese píxel en la imagen, [x, y], donde x e y son la fila y la columna de un píxel en la matriz de la imagen. Esto permite que la coordenada se multiplique por una matriz de transformación afín, que proporciona la posición en la que se copiará el valor del píxel en la imagen de salida.

Sin embargo, para permitir transformaciones que requieren transformaciones de traslación, se necesitan coordenadas homogéneas tridimensionales . La tercera dimensión suele establecerse en una constante distinta de cero, normalmente 1, de modo que la nueva coordenada sea [x, y, 1]. Esto permite que el vector de coordenadas se multiplique por una matriz de 3 por 3, lo que permite realizar cambios de traslación. Por lo tanto, la tercera dimensión, que es la constante 1, permite la traslación.

Como la multiplicación de matrices es asociativa, se pueden combinar múltiples transformaciones afines en una única transformación afín multiplicando la matriz de cada transformación individual en el orden en que se realizan las transformaciones. Esto da como resultado una única matriz que, cuando se aplica a un vector de puntos, da el mismo resultado que todas las transformaciones individuales realizadas en el vector [x, y, 1] en secuencia. Por lo tanto, una secuencia de matrices de transformación afín se puede reducir a una única matriz de transformación afín.

Por ejemplo, las coordenadas bidimensionales solo permiten la rotación sobre el origen (0, 0). Pero las coordenadas homogéneas tridimensionales se pueden utilizar para trasladar primero cualquier punto a (0, 0), luego realizar la rotación y, por último, trasladar el origen (0, 0) de nuevo al punto original (lo opuesto a la primera traslación). Estas 3 transformaciones afines se pueden combinar en una única matriz, lo que permite la rotación alrededor de cualquier punto de la imagen. [47]

Eliminación de ruido de imágenes con Morfología

La morfología matemática es adecuada para eliminar el ruido de las imágenes. Los elementos estructurantes son importantes en la morfología matemática .

Los siguientes ejemplos tratan sobre elementos estructurantes. La función de eliminación de ruido, la imagen como I y el elemento estructurante como B se muestran a continuación y en la tabla.

p.ej

Defina Dilatación(I, B)(i,j) = . Sea Dilatación(I,B) = D(I,B)

D(I', B)(1,1) =

Defina Erosión(I, B)(i,j) = . Sea Erosión(I,B) = E(I,B)

E(I', B)(1,1) =

Después de la dilatación Después de la erosión

Un método de apertura es simplemente erosión primero y luego dilatación mientras que el método de cierre es al revés. En realidad, D(I,B) y E(I,B) pueden implementarse mediante convolución.

| Elemento estructurante | Mascarilla | Código | Ejemplo |

|---|---|---|---|

| Imagen original | Ninguno | Utilice Matlab para leer la imagen originaloriginal = imread ( 'scene.jpg' ); imagen = rgb2gray ( original ); [ r , c , canal ] = tamaño ( imagen ); se = lógico ([ 1 1 1 ; 1 1 1 ; 1 1 1]) ; [ p , q ] = tamaño ( se ); halfH = floor ( p / 2 ); halfW = floor ( q / 2 ); tiempo = 3 ; % de eliminación de ruido 3 veces con todos los métodos |  |

| Dilatación | Utilice Matlab para la dilataciónimwrite ( imagen , "escena_dil.jpg" ) extractmax = zeros ( tamaño ( imagen ), clase ( imagen )); para i = 1 : tiempo dil_imagen = imread ( 'escena_dil.jpg' ); para col = ( mitadW + 1 ): ( c - mitadW ) para fila = ( mitadH + 1 ) : ( r - mitadH ) dpointD = fila - mitadH ; dpointU = fila + mitadH ; dpointL = col - mitadW ; dpointR = col + mitadW ; dneighbor = dil_image ( dpointD : dpointU , dpointL : dpointR ); filter = dneighbor ( se ); extractmax ( fila , col ) = max ( filtro ); fin fin imwrite ( extraermax , "escena_dil.jpg" ); fin |  | |

| Erosión | Utilice Matlab para la erosiónimwrite ( imagen , 'scene_ero.jpg' ); extractmin = zeros ( tamaño ( imagen ), clase ( imagen )); para i = 1 : tiempo ero_imagen = imread ( 'scene_ero.jpg' ); para col = ( mitadW + 1 ): ( c - mitadW ) para fila = ( mitadH + 1 ): ( r - mitadH ) puntoAbajo = fila - mitadH ; puntoArriba = fila + mitadH ; puntoIzquierda = col - mitadW ; puntoDerecha = col + mitadW ; vecino = ero_imagen ( puntoAbajo : puntoArriba , puntoIzquierda : puntoDerecha ); filtro = vecino ( se ); extractmin ( fila , col ) = min ( filtro ); fin fin imwrite ( extracmin , "scene_ero.jpg" ); fin |  | |

| Apertura | Utilice Matlab para abririmwrite ( extraermin , "escena_apertura.jpg" ) extractopen = zeros ( tamaño ( imagen ), clase ( imagen )); para i = 1 : tiempo dil_imagen = imread ( 'escena_apertura.jpg' ); para col = ( mitadW + 1 ): ( c - mitadW ) para fila = ( mitadH + 1 ) : ( r - mitadH ) dpointD = fila - mitadH ; dpointU = fila + mitadH ; dpointL = col - mitadW ; dpointR = col + mitadW ; dneighbor = dil_image ( dpointD : dpointU , dpointL : dpointR ); filter = dneighbor ( se ); extractopen ( fila , col ) = max ( filtro ); fin fin imwrite ( extraerpen , "escena_apertura.jpg" ); fin |  | |

| Cierre | Utilice Matlab para cerrarimwrite ( extraermax , "escena_cierre.jpg" ) extractclose = zeros ( tamaño ( imagen ), clase ( imagen )); para i = 1 : tiempo ero_image = imread ( 'escena_cierre.jpg' ); para col = ( mitadW + 1 ): ( c - mitadW ) para fila = ( mitadH + 1 ) : ( r - mitadH ) dpointD = fila - mitadH ; dpointU = fila + mitadH ; dpointL = col - mitadW ; dpointR = col + mitadW ; dneighbor = ero_image ( dpointD : dpointU , dpointL : dpointR ); filter = dneighbor ( se ); extractclose ( fila , col ) = min ( filtro ); fin fin imwrite ( extraerclose , "escena_cierre.jpg" ); fin |  |

Aplicaciones

Imágenes de cámaras digitales

Las cámaras digitales generalmente incluyen hardware especializado de procesamiento de imágenes digitales (ya sea chips dedicados o circuitos adicionales en otros chips) para convertir los datos sin procesar de su sensor de imagen en una imagen con corrección de color en un formato de archivo de imagen estándar . Las técnicas de posprocesamiento adicionales aumentan la nitidez de los bordes o la saturación del color para crear imágenes de aspecto más natural.

Película

Westworld (1973) fue el primer largometraje en utilizar el procesamiento de imágenes digitales para pixelar fotografías y simular el punto de vista de un androide. [48] El procesamiento de imágenes también se utiliza ampliamente para producir el efecto de clave cromática que reemplaza el fondo de los actores con un escenario natural o artístico.

Detección de rostros

La detección de rostros se puede implementar con morfología matemática , transformada de coseno discreta , generalmente llamada DCT, y proyección horizontal (matemáticas) .

Método general con método basado en características

El método de detección de rostros basado en características utiliza el tono de piel, la detección de bordes, la forma del rostro y los rasgos del rostro (como los ojos, la boca, etc.) para lograr la detección de rostros. El tono de piel, la forma del rostro y todos los elementos únicos que solo tiene el rostro humano pueden describirse como rasgos.

Explicación del proceso

- Dado un lote de imágenes de rostros, primero se extrae el rango de tonos de piel mediante el muestreo de imágenes de rostros. El rango de tonos de piel es solo un filtro de piel.

- La medida del índice de similitud estructural (SSIM) se puede aplicar para comparar imágenes en términos de extracción del tono de piel.

- Normalmente, los espacios de color HSV o RGB son adecuados para el filtro de piel. Por ejemplo, en el modo HSV, el rango de tonos de piel es [0,48,50] ~ [20,255,255]

- Después de filtrar las imágenes con tono de piel, para obtener el borde del rostro, se utilizan la morfología y la DCT para eliminar el ruido y rellenar las áreas de piel faltantes.

- Se puede utilizar el método de apertura o el método de cierre para lograr rellenar la piel faltante.

- La técnica DCT consiste en evitar objetos con un tono de piel similar, ya que los rostros humanos siempre tienen una textura más alta.

- Se pueden aplicar el operador Sobel u otros operadores para detectar el borde de la cara.

- Para posicionar características humanas como los ojos, usar la proyección y buscar el pico del histograma de proyección ayuda a obtener características detalladas como la boca, el cabello y los labios.

- La proyección consiste simplemente en proyectar la imagen para ver la alta frecuencia, que suele ser la posición característica.

Método de mejora de la calidad de imagen

La calidad de la imagen puede verse afectada por la vibración de la cámara, la sobreexposición, la distribución del nivel de gris demasiado centralizada y el ruido, etc. Por ejemplo, el problema del ruido se puede resolver con el método de suavizado , mientras que el problema de la distribución del nivel de gris se puede mejorar con la ecualización del histograma .

Método de suavizado

En el dibujo, si hay algún color que no satisface, se toma un poco de color alrededor del color que no satisface y se calcula el promedio. Esta es una forma sencilla de pensar en el método de suavizado.

El método de suavizado se puede implementar con máscara y convolución . Tomemos como ejemplo la imagen pequeña y la máscara que se muestra a continuación.

La imagen es

La máscara es

Después de la convolución y el suavizado, la imagen es

Observando la imagen[1, 1], la imagen[1, 2], la imagen[2, 1] y la imagen[2, 2].

Los píxeles de la imagen original son 1, 4, 28, 30. Después de suavizar la máscara, los píxeles se convierten en 9, 10, 9, 9 respectivamente.

nueva imagen[1, 1] = * (imagen[0,0]+imagen[0,1]+imagen[0,2]+imagen[1,0]+imagen[1,1]+imagen[1,2]+imagen[2,0]+imagen[2,1]+imagen[2,2])

nueva imagen[1, 1] = piso( * (2+5+6+3+1+4+1+28+30)) = 9

nueva imagen[1, 2] = piso({ * (5+6+5+1+4+6+28+30+2)) = 10

nueva imagen[2, 1] = piso( * (3+1+4+1+28+30+7+3+2)) = 9

nueva imagen[2, 2] = piso( * (1+4+6+28+30+2+3+2+2)) = 9

Método de histograma de niveles de grises

En general, dado un histograma de niveles de gris de una imagen como la que se muestra a continuación, cambiar el histograma a una distribución uniforme de una imagen suele ser lo que llamamos ecualización de histograma .

En tiempo discreto, el área del histograma de niveles de gris es (ver figura 1) mientras que el área de distribución uniforme es (ver figura 2). Está claro que el área no cambiará, por lo que .

De la distribución uniforme, la probabilidad de es mientras que la

En tiempo continuo, la ecuación es .

Además, basado en la definición de una función, el método del histograma de niveles de Gray es como encontrar una función que satisfaga f(p)=q.

| Método de mejora | Asunto | Antes de la mejora | Proceso | Después de la mejora |

|---|---|---|---|---|

| Método de suavizado | ruido Con Matlab, se agrega sal y pimienta con el parámetro 0,01 |  |

|  |

| Ecualización del histograma | La distribución de niveles de grises está demasiado centralizada |  | Consulte la ecualización del histograma. |  |

Desafíos

- Ruido y distorsiones : las imperfecciones en las imágenes debido a la mala iluminación, sensores limitados y compresión de archivos pueden generar imágenes poco claras que afectan la conversión precisa de imágenes.

- Variabilidad en la calidad de la imagen : las variaciones en la calidad y resolución de la imagen, incluidas imágenes borrosas y detalles incompletos, pueden dificultar el procesamiento uniforme en una base de datos.

- Detección y reconocimiento de objetos : identificar y reconocer objetos dentro de imágenes, especialmente en escenarios complejos con múltiples objetos y oclusiones, plantea un desafío importante.

- Anotación y etiquetado de datos : etiquetar imágenes diversas y múltiples para el reconocimiento por máquina es crucial para una mayor precisión del procesamiento, ya que una identificación incorrecta puede generar resultados poco realistas.

- Intensidad de recursos computacionales : acceder a recursos computacionales adecuados para el procesamiento de imágenes puede ser un desafío y un costo costoso, lo que dificulta el progreso si no se cuentan con recursos suficientes.

Véase también

- Imágenes digitales

- Gráficos de computadora

- Visión por computadora

- Herramientas CVIP

- Digitalización

- Transformada de Fourier

- Condición de contorno libre

- GPGPU

- Filtrado homomórfico

- Análisis de imágenes

- Sociedad de sistemas de transporte inteligente del IEEE

- Análisis espectral de mínimos cuadrados

- Sistemas multidimensionales

- Etiquetado de relajación

- Software de teledetección

- Imagen de prueba estándar

- Superresolución

- Eliminación de ruido por variación total

- Visión artificial

- Variación limitada

- Radiómica

Referencias

- ^ Chakravorty, Pragnan (2018). "¿Qué es una señal? [Notas de clase]". Revista IEEE de procesamiento de señales . 35 (5): 175–177. Bibcode :2018ISPM...35e.175C. doi :10.1109/MSP.2018.2832195. S2CID 52164353.

- ^ González, Rafael (2018). Procesamiento de imágenes digitales . Nueva York, Nueva York: Pearson. ISBN 978-0-13-335672-4.OCLC 966609831 .

- ^ Nagornov, Nikolay N.; Lyakhov, Pavel A.; Bergerman, Maxim V.; Kalita, Diana I. (2024). "Tendencias modernas en la mejora de las características técnicas de dispositivos y sistemas para el procesamiento de imágenes digitales". IEEE Access . 12 : 44659–44681. Bibcode :2024IEEEA..1244659N. doi : 10.1109/ACCESS.2024.3381493 . ISSN 2169-3536.

- ^ Yamni, Mohamed; Daoui, Achraf; Abd El-Latif, Ahmed A. (febrero de 2024). "Esteganografía eficiente de imágenes en color basada en un nuevo sistema dinámico caótico adaptado con transformadas de momento ortogonales discretas". Matemáticas y computadoras en simulación . doi :10.1016/j.matcom.2024.01.023.

- ^ Hung, Che-Lun (28 de mayo de 2020). "Algoritmos computacionales para el procesamiento de imágenes médicas". Imágenes médicas actuales . 16 (5): 467–468. doi :10.2174/157340561605200410144743. PMID 32484080.

- ^ Azriel Rosenfeld, Procesamiento de imágenes por computadora , Nueva York: Academic Press, 1969

- ^ ab Gonzalez, Rafael C. (2008). Procesamiento de imágenes digitales . Woods, Richard E. (Richard Eugene), 1954– (3.ª ed.). Upper Saddle River, NJ: Prentice Hall. pp. 23–28. ISBN 978-0-13-168728-8.OCLC 137312858 .

- ^ abc Williams, JB (2017). La revolución electrónica: inventando el futuro. Springer. pp. 245–8. ISBN 978-3-319-49088-5.

- ^ US2802760A, Lincoln, Derick & Frosch, Carl J., "Oxidación de superficies semiconductoras para difusión controlada", publicado el 13 de agosto de 1957

- ^ Frosch, CJ; Derick, L (1957). "Protección de superficies y enmascaramiento selectivo durante la difusión en silicio". Revista de la Sociedad Electroquímica . 104 (9): 547. doi :10.1149/1.2428650.

- ^ KAHNG, D. (1961). "Dispositivo de superficie de dióxido de silicio y silicio". Memorándum técnico de Bell Laboratories : 583–596. doi :10.1142/9789814503464_0076. ISBN 978-981-02-0209-5.

- ^ Lojek, Bo (2007). Historia de la ingeniería de semiconductores . Berlín, Heidelberg: Springer-Verlag Berlin Heidelberg. pág. 321. ISBN 978-3-540-34258-8.

- ^ Ligenza, JR; Spitzer, WG (1960). "Los mecanismos de oxidación del silicio en vapor y oxígeno". Revista de Física y Química de Sólidos . 14 : 131–136. Bibcode :1960JPCS...14..131L. doi :10.1016/0022-3697(60)90219-5.

- ^ Lojek, Bo (2007). Historia de la ingeniería de semiconductores . Springer Science & Business Media . pág. 120. ISBN. 9783540342588.

- ^ James R. Janesick (2001). Dispositivos científicos acoplados a carga. SPIE Press. pp. 3–4. ISBN 978-0-8194-3698-6.

- ^ Boyle, William S; Smith, George E. (1970). "Dispositivos semiconductores acoplados por carga". Bell Syst. Tech. J . 49 (4): 587–593. Código Bibliográfico :1970BSTJ...49..587B. doi :10.1002/j.1538-7305.1970.tb01790.x.

- ^ Fossum, Eric R. (12 de julio de 1993). "Sensores de píxeles activos: ¿son dinosaurios los CCDS?". En Blouke, Morley M. (ed.). Dispositivos de carga acoplada y sensores ópticos de estado sólido III . Actas del SPIE. Vol. 1900. págs. 2–14. Código Bibliográfico :1993SPIE.1900....2F. CiteSeerX 10.1.1.408.6558 . doi :10.1117/12.148585. S2CID 10556755.

- ^ Fossum, Eric R. (2007). "Active Pixel Sensors" (PDF) . Eric Fossum . S2CID 18831792. Archivado (PDF) del original el 29 de agosto de 2019.

- ^ Matsumoto, Kazuya; et al. (1985). "Un nuevo fototransistor MOS que funciona en un modo de lectura no destructivo". Revista japonesa de física aplicada . 24 (5A): L323. Código Bibliográfico :1985JaJAP..24L.323M. doi :10.1143/JJAP.24.L323. S2CID 108450116.

- ^ Fossum, Eric R. ; Hondongwa, DB (2014). "Una revisión del fotodiodo fijado para sensores de imagen CCD y CMOS". Revista IEEE de la Sociedad de Dispositivos Electrónicos . 2 (3): 33–43. doi : 10.1109/JEDS.2014.2306412 .

- ^ "Las ventas de sensores de imagen CMOS se mantienen a un ritmo récord". IC Insights . 8 de mayo de 2018. Archivado desde el original el 21 de junio de 2019 . Consultado el 6 de octubre de 2019 .

- ^ Lyon, Richard F. (2014). "El ratón óptico: visión biomimética integrada temprana". Avances en visión artificial integrada . Springer. pp. 3–22 (3). ISBN 9783319093871.

- ^ Lyon, Richard F. (agosto de 1981). "El ratón óptico y una metodología arquitectónica para sensores digitales inteligentes" (PDF) . En HT Kung; Robert F. Sproull; Guy L. Steele (eds.). Sistemas y cálculos VLSI . Computer Science Press. págs. 1–19. doi :10.1007/978-3-642-68402-9_1. ISBN . 978-3-642-68404-3. S2CID 60722329. Archivado (PDF) del original el 26 de febrero de 2014.

- ^ Brain, Marshall; Carmack, Carmen (24 de abril de 2000). «Cómo funcionan los ratones de ordenador». HowStuffWorks . Consultado el 9 de octubre de 2019 .

- ^ Benchoff, Brian (17 de abril de 2016). "Building the First Digital Camera". Hackaday . Consultado el 30 de abril de 2016 .

La Cyclops fue la primera cámara digital

- ^ Ahmed, Nasir (enero de 1991). "Cómo se me ocurrió la transformada discreta del coseno". Procesamiento de señales digitales . 1 (1): 4–5. Código Bibliográfico :1991DSP.....1....4A. doi :10.1016/1051-2004(91)90086-Z. Archivado desde el original el 10 de junio de 2016 . Consultado el 10 de octubre de 2019 .

- ^ "T.81 – Compresión digital y codificación de imágenes fijas de tono continuo – requisitos y directrices" (PDF) . CCITT . Septiembre de 1992. Archivado (PDF) desde el original el 17 de julio de 2019 . Consultado el 12 de julio de 2019 .

- ^ Svetlik, Joe (31 de mayo de 2018). "Explicación del formato de imagen JPEG". BT Group . Archivado desde el original el 5 de agosto de 2019. Consultado el 5 de agosto de 2019 .

- ^ Caplan, Paul (24 de septiembre de 2013). «¿Qué es un JPEG? El objeto invisible que vemos todos los días» . The Atlantic . Archivado desde el original el 9 de octubre de 2019. Consultado el 13 de septiembre de 2019 .

- ^ Baraniuk, Chris (15 de octubre de 2015). «JPeg lockdown: Restriction options wanted by committee» (Bloqueo de JPeg: opciones de restricción buscadas por el comité). BBC News . Archivado desde el original el 9 de octubre de 2019. Consultado el 13 de septiembre de 2019 .

- ^ Nagornov, Nikolay N.; Lyakhov, Pavel A.; Valueva, Maria V.; Bergerman, Maxim V. (2022). "Aceleradores FPGA basados en RNS para procesamiento wavelet de imágenes médicas 3D de alta calidad utilizando coeficientes de filtro escalados". IEEE Access . 10 : 19215–19231. Bibcode :2022IEEEA..1019215N. doi : 10.1109/ACCESS.2022.3151361 . ISSN 2169-3536. S2CID 246895876 .

Los sistemas de imágenes médicas producen imágenes cada vez más precisas con una calidad mejorada utilizando resoluciones espaciales y profundidad de bits de color más altas. Estas mejoras aumentan la cantidad de información que se debe almacenar, procesar y transmitir.

- ^ Dhouib, D.; Naït-Ali, A.; Olivier, C.; Naceur, MS (junio de 2021). "Estrategia de compresión basada en ROI de conjuntos de datos cerebrales de resonancia magnética 3D para comunicaciones inalámbricas". IRBM . 42 (3): 146–153. doi :10.1016/j.irbm.2020.05.001. S2CID 219437400.

Debido a la gran cantidad de datos de imágenes médicas, el proceso de transmisión se vuelve complicado en las aplicaciones de telemedicina. Por lo tanto, para adaptar los flujos de bits de datos a las restricciones relacionadas con la limitación de los anchos de banda, es esencial una reducción del tamaño de los datos mediante la compresión de las imágenes.

- ^ Xin, Gangtao; Fan, Pingyi (11 de junio de 2021). "Un método de compresión sin pérdida para imágenes médicas de múltiples componentes basado en minería de datos masivos". Scientific Reports . 11 (1): 12372. doi : 10.1038/s41598-021-91920-x . ISSN 2045-2322. PMC 8196061 . PMID 34117350.

- ^ Grant, Duncan Andrew; Gowar, John (1989). MOSFET de potencia: teoría y aplicaciones. Wiley . p. 1. ISBN 978-0-471-82867-9El transistor de efecto de campo de metal

-óxido-semiconductor (MOSFET) es el dispositivo activo más utilizado en la integración a gran escala de circuitos integrados digitales (VLSI). Durante la década de 1970, estos componentes revolucionaron el procesamiento de señales electrónicas, los sistemas de control y las computadoras.

- ^ Shirriff, Ken (30 de agosto de 2016). "La sorprendente historia de los primeros microprocesadores". IEEE Spectrum . 53 (9). Instituto de Ingenieros Eléctricos y Electrónicos : 48–54. doi :10.1109/MSPEC.2016.7551353. S2CID 32003640. Archivado desde el original el 13 de octubre de 2019 . Consultado el 13 de octubre de 2019 .

- ^ ab «1979: Se introduce el procesador de señal digital de un solo chip». The Silicon Engine . Museo de Historia de la Computación . Archivado desde el original el 3 de octubre de 2019 . Consultado el 14 de octubre de 2019 .

- ^ Taranovich, Steve (27 de agosto de 2012). «30 años de DSP: desde un juguete infantil hasta 4G y más allá». EDN . Archivado desde el original el 14 de octubre de 2019. Consultado el 14 de octubre de 2019 .

- ^ Stanković, Radomir S.; Astola, Jaakko T. (2012). "Reminiscencias de los primeros trabajos en DCT: entrevista con KR Rao" (PDF) . Reimpresiones de los primeros días de las ciencias de la información . 60 . Archivado (PDF) del original el 13 de octubre de 2019 . Consultado el 13 de octubre de 2019 .

- ^ "Salón de la Fama de la Tecnología Espacial: Tecnologías Incorporadas/1994". Fundación Espacial. 1994. Archivado desde el original el 4 de julio de 2011. Consultado el 7 de enero de 2010 .

- ^ Roobottom CA, Mitchell G, Morgan-Hughes G (noviembre de 2010). "Estrategias de reducción de radiación en angiografía por tomografía computarizada cardíaca". Radiología clínica . 65 (11): 859–67. doi : 10.1016/j.crad.2010.04.021 . PMID 20933639.

- ^ Scialpi M, Reginelli A, D'Andrea A, Gravante S, Falcone G, Baccari P, Manganaro L, Palumbo B, Cappabianca S (abril de 2016). "Imágenes de tumores pancreáticos: una actualización" (PDF) . Revista internacional de cirugía . 28 (Supl 1): S142-55. doi : 10.1016/j.ijsu.2015.12.053 . hdl :11573/908479. PMID 26777740. Archivado (PDF) desde el original el 24 de agosto de 2019.

- ^ Rahbar H, Partridge SC (febrero de 2016). "Imágenes por resonancia magnética multiparamétricas del cáncer de mama". Clínicas de imágenes por resonancia magnética de Norteamérica . 24 (1): 223–238. doi :10.1016/j.mric.2015.08.012. PMC 4672390. PMID 26613883 .

- ^ "El volumen global de unidades de chips de imágenes médicas aumentará en los próximos cinco años". Silicon Semiconductor . 8 de septiembre de 2016 . Consultado el 25 de octubre de 2019 .

- ^ Banerjee R, Pavlides M, Tunnicliffe EM, Piechnik SK, Sarania N, Philips R, Collier JD, Booth JC, Schneider JE, Wang LM, Delaney DW, Fleming KA, Robson MD, Barnes E, Neubauer S (enero de 2014). "Resonancia magnética multiparamétrica para el diagnóstico no invasivo de la enfermedad hepática". Revista de hepatología . 60 (1): 69–77. doi :10.1016/j.jhep.2013.09.002. PMC 3865797 . PMID 24036007.

- ^ Zhang, MZ; Livingston, AR; Asari, VK (2008). "Una arquitectura de alto rendimiento para la implementación de convolución 2-D con núcleos simétricos de cuadrante". Revista internacional de computadoras y aplicaciones . 30 (4): 298–308. doi :10.1080/1206212x.2008.11441909. S2CID 57289814.

- ^ ab Gonzalez, Rafael (2008). Procesamiento de imágenes digitales, 3.° grado . Pearson Hall. ISBN 978-0-13-168728-8.

- ^ House, Keyser (6 de diciembre de 2016). Transformaciones afines (PDF) . Fundamentos de modelado y animación basados en la física. AK Peters/CRC Press. ISBN 978-1-4822-3460-2. Archivado (PDF) del original el 30 de agosto de 2017 . Consultado el 26 de marzo de 2019 .

{{cite book}}:|website=ignorado ( ayuda ) - ^ Una breve historia temprana de los gráficos por computadora en el cine Archivado el 17 de julio de 2012 en Wayback Machine , Larry Yaeger , 16 de agosto de 2002 (última actualización), consultado el 24 de marzo de 2010

Lectura adicional

- Solomon, CJ; Breckon, TP (2010). Fundamentos del procesamiento de imágenes digitales: un enfoque práctico con ejemplos en Matlab . Wiley-Blackwell. doi :10.1002/9780470689776. ISBN 978-0-470-84473-1.

- Wilhelm Burger; Mark J. Burge (2007). Procesamiento de imágenes digitales: un enfoque algorítmico con Java. Springer . ISBN 978-1-84628-379-6.

- R. Fisher; K. Dawson-Howe; A. Fitzgibbon; C. Robertson; E. Trucco (2005). Diccionario de visión artificial y procesamiento de imágenes . John Wiley. ISBN 978-0-470-01526-1.

- Rafael C. Gonzalez; Richard E. Woods; Steven L. Eddins (2004). Procesamiento de imágenes digitales con MATLAB . Pearson Education. ISBN 978-81-7758-898-9.

- Tim Morris (2004). Visión artificial y procesamiento de imágenes . Palgrave Macmillan. ISBN 978-0-333-99451-1.

- Vipin Tyagi (2018). Comprensión del procesamiento de imágenes digitales . Taylor and Francis CRC Press. ISBN 978-11-3856-6842.

- Milan Sonka; Vaclav Hlavac; Roger Boyle (1999). Procesamiento de imágenes, análisis y visión artificial . PWS Publishing. ISBN 978-0-534-95393-5.

- González, Rafael C.; Woods, Richard E. (2008). Procesamiento de imágenes digitales . Upper Saddle River, NJ: Prentice Hall. ISBN 978-0-13-168728-8.OCLC 137312858 .

- Kovalevsky, Vladimir (2019). Algoritmos modernos para el procesamiento de imágenes: imágenes por computadora a modo de ejemplo utilizando C# . [Nueva York, Nueva York]. ISBN 978-1-4842-4237-7.OCLC 1080084533 .

{{cite book}}: CS1 maint: location missing publisher (link)

Enlaces externos

- Conferencias sobre procesamiento de imágenes, por Alan Peters. Universidad de Vanderbilt. Actualizado el 7 de enero de 2016.

- Procesamiento de imágenes digitales con algoritmos informáticos