Distribución normal multivariante

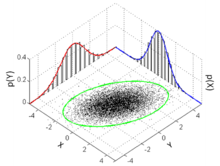

Función de densidad de probabilidad  Muchos puntos de muestra de una distribución normal multivariada con y , que se muestran junto con la elipse de 3 sigma, las dos distribuciones marginales y los dos histogramas 1-d. | |||

| Notación | |||

|---|---|---|---|

| Parámetros | μ ∈ R k — ubicación Σ ∈ R k × k — covarianza ( matriz semidefinida positiva ) | ||

| Apoyo | x ∈ μ + span( Σ ) ⊆ R k | ||

existe solo cuando Σ es definida positiva | |||

| Significar | micras | ||

| Modo | micras | ||

| Diferencia | Σ | ||

| Entropía | |||

| MGF | |||

| CF | |||

| Divergencia de Kullback-Leibler | Véase § Divergencia de Kullback–Leibler | ||

En teoría de probabilidad y estadística , la distribución normal multivariada , distribución gaussiana multivariada o distribución normal conjunta es una generalización de la distribución normal unidimensional ( univariada ) a dimensiones superiores . Una definición es que se dice que un vector aleatorio tiene una distribución normal de k -variadas si cada combinación lineal de sus k componentes tiene una distribución normal univariante. Su importancia deriva principalmente del teorema del límite central multivariado . La distribución normal multivariada se utiliza a menudo para describir, al menos aproximadamente, cualquier conjunto de variables aleatorias de valor real (posiblemente) correlacionadas , cada una de las cuales se agrupa alrededor de un valor medio.

Definiciones

Notación y parametrización

La distribución normal multivariada de un vector aleatorio de dimensión k se puede escribir en la siguiente notación:

o para hacer saber explícitamente que X es k -dimensional,

con vector medio de dimensión k

tal que y . La inversa de la matriz de covarianza se llama matriz de precisión , denotada por .

Vector aleatorio normal estándar

Un vector aleatorio real se denomina vector aleatorio normal estándar si todos sus componentes son independientes y cada uno es una variable aleatoria distribuida normalmente con varianza unitaria de media cero, es decir, si para todos . [1] : p. 454

Vector aleatorio normal centrado

Un vector aleatorio real se denomina vector aleatorio normal centrado si existe una matriz determinista que tiene la misma distribución que donde es un vector aleatorio normal estándar con componentes. [1] : p. 454

Vector aleatorio normal

Un vector aleatorio real se denomina vector aleatorio normal si existe un -vector aleatorio , que es un vector aleatorio normal estándar, un -vector y una matriz , tales que . [2] : p. 454 [1] : p. 455

Formalmente:

Aquí la matriz de covarianza es .

En el caso degenerado en el que la matriz de covarianza es singular , la distribución correspondiente no tiene densidad; consulte la sección siguiente para obtener más detalles. Este caso surge con frecuencia en estadística ; por ejemplo, en la distribución del vector de residuos en la regresión de mínimos cuadrados ordinarios . En general , no son independientes; pueden verse como el resultado de aplicar la matriz a una colección de variables gaussianas independientes .

Definiciones equivalentes

Las siguientes definiciones son equivalentes a la definición dada anteriormente. Un vector aleatorio tiene una distribución normal multivariada si satisface una de las siguientes condiciones equivalentes.

- Toda combinación lineal de sus componentes se distribuye normalmente . Es decir, para cualquier vector constante , la variable aleatoria tiene una distribución normal univariante, donde una distribución normal univariante con varianza cero es una masa puntual sobre su media.

- Hay un vector k y una matriz semidefinida positiva simétrica , tal que la función característica de es

La distribución normal esférica se puede caracterizar como la única distribución donde los componentes son independientes en cualquier sistema de coordenadas ortogonales. [3] [4]

Función de densidad

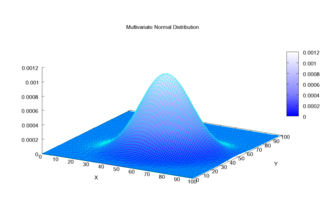

Caso no degenerado

Se dice que la distribución normal multivariante es "no degenerada" cuando la matriz de covarianza simétrica es definida positiva . En este caso, la distribución tiene densidad [5]

donde es un vector columna real de dimensión k y es el determinante de , también conocido como varianza generalizada . La ecuación anterior se reduce a la de la distribución normal univariante si es una matriz (es decir, un solo número real).

La versión circularmente simétrica de la distribución normal compleja tiene una forma ligeramente diferente.

Cada lugar geométrico de isodensidad (el lugar geométrico de los puntos en el espacio k -dimensional, cada uno de los cuales da el mismo valor particular de la densidad) es una elipse o su generalización de dimensión superior; por lo tanto, la normal multivariada es un caso especial de las distribuciones elípticas .

La cantidad se conoce como la distancia de Mahalanobis , que representa la distancia del punto de prueba desde la media . La distancia de Mahalanobis al cuadrado se descompone en una suma de k términos, siendo cada término un producto de tres componentes significativos. [6] Nótese que en el caso cuando , la distribución se reduce a una distribución normal univariante y la distancia de Mahalanobis se reduce al valor absoluto de la puntuación estándar . Véase también Intervalo a continuación.

Caso bivariado

En el caso no singular bidimensional ( ), la función de densidad de probabilidad de un vector es: donde es la correlación entre y y donde y . En este caso,

En el caso bivariado, la primera condición equivalente para la reconstrucción multivariada de la normalidad puede hacerse menos restrictiva, ya que es suficiente verificar que un conjunto infinito numerable de combinaciones lineales distintas de y son normales para concluir que el vector de es normal bivariado. [7]

Los lugares de isodensidad bivariados representados en el plano son elipses , cuyos ejes principales están definidos por los vectores propios de la matriz de covarianza (los semidiámetros mayor y menor de la elipse son iguales a la raíz cuadrada de los valores propios ordenados).

A medida que aumenta el valor absoluto del parámetro de correlación , estos loci se comprimen hacia la siguiente línea:

Esto se debe a que esta expresión, con (donde sgn es la función Signo ) reemplazada por , es la mejor predicción lineal imparcial de dado un valor de . [8]

Caso degenerado

Si la matriz de covarianza no es de rango completo, entonces la distribución normal multivariante es degenerada y no tiene densidad. Más precisamente, no tiene densidad con respecto a la medida de Lebesgue de dimensión k (que es la medida habitual que se asume en los cursos de probabilidad a nivel de cálculo). Sólo los vectores aleatorios cuyas distribuciones son absolutamente continuas con respecto a una medida se dice que tienen densidades (con respecto a esa medida). Para hablar de densidades pero evitar lidiar con complicaciones de teoría de la medida, puede ser más simple restringir la atención a un subconjunto de las coordenadas de tal que la matriz de covarianza para este subconjunto sea definida positiva; entonces las otras coordenadas pueden considerarse como una función afín de estas coordenadas seleccionadas. [9]

Para hablar de densidades de manera significativa en casos singulares, entonces, debemos seleccionar una medida base diferente. Usando el teorema de desintegración podemos definir una restricción de la medida de Lebesgue al subespacio afín de dimensión α de donde se sustenta la distribución gaussiana, es decir . Con respecto a esta medida, la distribución tiene la densidad del siguiente motivo:

donde es la inversa generalizada y es el pseudodeterminante . [10]

Función de distribución acumulativa

La noción de función de distribución acumulativa (cdf) en dimensión 1 se puede extender de dos maneras al caso multidimensional, basado en regiones rectangulares y elipsoidales.

La primera forma es definir la función de distribución de un vector aleatorio como la probabilidad de que todos los componentes sean menores o iguales a los valores correspondientes en el vector : [11]

Aunque no existe una forma cerrada para , hay varios algoritmos que la estiman numéricamente. [11] [12]

Otra forma es definir la cdf como la probabilidad de que una muestra se encuentre dentro del elipsoide determinado por su distancia de Mahalanobis desde la gaussiana, una generalización directa de la desviación estándar. [13] Para calcular los valores de esta función, existe una fórmula analítica cerrada, [13] como sigue.

Intervalo

El intervalo para la distribución normal multivariada produce una región que consiste en aquellos vectores x que satisfacen

Aquí hay un vector -dimensional, es el vector medio -dimensional conocido , es la matriz de covarianza conocida y es la función cuantil para la probabilidad de la distribución de chi-cuadrado con grados de libertad. [14] Cuando la expresión define el interior de una elipse y la distribución de chi-cuadrado se simplifica a una distribución exponencial con media igual a dos (tasa igual a la mitad).

Función de distribución acumulativa complementaria (distribución de cola)

La función de distribución acumulativa complementaria (ccdf) o distribución de cola se define como . Cuando , entonces la ccdf se puede escribir como una probabilidad máxima de las variables gaussianas dependientes: [15]

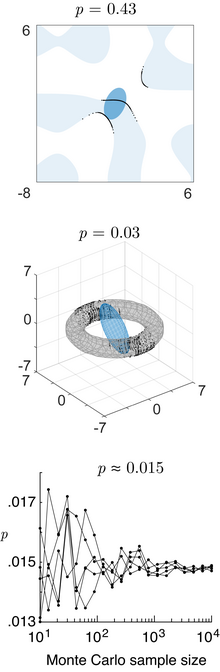

Si bien no existe una fórmula cerrada simple para calcular la ccdf, el máximo de variables gaussianas dependientes se puede estimar con precisión a través del método de Monte Carlo . [15] [16]

Propiedades

Probabilidad en diferentes dominios

El contenido de probabilidad de la normal multivariada en un dominio cuadrático definido por (donde es una matriz, es un vector y es un escalar), que es relevante para la teoría de clasificación/decisión bayesiana utilizando el análisis discriminante gaussiano, está dado por la distribución chi-cuadrado generalizada . [17] El contenido de probabilidad dentro de cualquier dominio general definido por (donde es una función general) se puede calcular utilizando el método numérico de trazado de rayos [17] (código Matlab).

Momentos más elevados

Los momentos de orden k de x están dados por

donde r 1 + r 2 + ⋯ + r N = k .

Los momentos centrales de orden k son los siguientes

- Si k es impar, μ 1, ..., N ( x − μ ) = 0 .

- Si k es par con k = 2 λ , entonces [ ambiguo ]

donde la suma se toma sobre todas las asignaciones del conjunto en pares λ (no ordenados). Es decir, para un momento central k (= 2 λ = 6) , se suman los productos de λ = 3 covarianzas (el valor esperado μ se toma como 0 en aras de la parsimonia):

Esto produce términos en la suma (15 en el caso anterior), cada uno de los cuales es el producto de λ (en este caso 3) covarianzas. Para los momentos de cuarto orden (cuatro variables) hay tres términos. Para los momentos de sexto orden hay 3 × 5 = 15 términos, y para los momentos de octavo orden hay 3 × 5 × 7 = 105 términos.

Las covarianzas se determinan entonces reemplazando los términos de la lista por los términos correspondientes de la lista que consiste en r 1 unos, luego r 2 dos, etc. Para ilustrar esto, examine el siguiente caso de momento central de cuarto orden:

donde es la covarianza de X i y X j . Con el método anterior, primero se encuentra el caso general para un k- ésimo momento con k variables X diferentes , , y luego se simplifica en consecuencia. Por ejemplo, para , se deja X i = X j y se usa el hecho de que .

Funciones de un vector normal

Una forma cuadrática de un vector normal , (donde es una matriz, es un vector y es un escalar), es una variable chi-cuadrado generalizada . [17] La dirección de un vector normal sigue una distribución normal proyectada . [18]

Si es una función escalar general de un vector normal, su función de densidad de probabilidad , su función de distribución acumulativa y su función de distribución acumulativa inversa se pueden calcular con el método numérico de trazado de rayos (código Matlab). [17]

Función de verosimilitud

Si se conocen la media y la matriz de covarianza, la probabilidad logarítmica de un vector observado es simplemente el logaritmo de la función de densidad de probabilidad :

- ,

La versión circularmente simétrica del caso complejo no central, donde es un vector de números complejos, sería

es decir, con la transpuesta conjugada (indicada por ) reemplazando a la transpuesta normal (indicada por ). Esto es ligeramente diferente que en el caso real, porque la versión circularmente simétrica de la distribución normal compleja tiene una forma ligeramente diferente para la constante de normalización .

Se utiliza una notación similar para la regresión lineal múltiple . [19]

Dado que la verosimilitud logarítmica de un vector normal es una forma cuadrática del vector normal, se distribuye como una variable chi-cuadrado generalizada . [17]

Entropía diferencial

La entropía diferencial de la distribución normal multivariada es [20]

,

donde las barras denotan el determinante de la matriz , k es la dimensionalidad del espacio vectorial y el resultado tiene unidades de nats .

Divergencia de Kullback-Leibler

La divergencia de Kullback–Leibler de a , para matrices no singulares Σ 1 y Σ 0 , es: [21]

donde denota el determinante de la matriz , es la traza , es el logaritmo natural y es la dimensión del espacio vectorial.

El logaritmo debe tomarse en base e, ya que los dos términos que siguen al logaritmo son en sí mismos logaritmos en base e de expresiones que son factores de la función de densidad o surgen de manera natural. Por lo tanto, la ecuación da un resultado medido en nats . Dividiendo toda la expresión anterior por log e 2 se obtiene la divergencia en bits .

Cuando ,

Información mutua

La información mutua de una distribución es un caso especial de la divergencia de Kullback-Leibler en la que es la distribución multivariante completa y es el producto de las distribuciones marginales unidimensionales. En la notación de la sección de divergencia de Kullback-Leibler de este artículo, es una matriz diagonal con las entradas diagonales de , y . La fórmula resultante para la información mutua es:

donde es la matriz de correlación construida a partir de . [22]

En el caso bivariado la expresión para la información mutua es:

Normalidad articular

Distribuida normalmente e independiente

Si y se distribuyen normalmente y son independientes , esto implica que están "distribuidas normalmente de manera conjunta", es decir, el par debe tener una distribución normal multivariante. Sin embargo, un par de variables distribuidas normalmente de manera conjunta no necesita ser independiente (solo lo sería si no estuviera correlacionada, ).

Dos variables aleatorias distribuidas normalmente no necesitan ser conjuntamente normales bivariadas

El hecho de que dos variables aleatorias tengan una distribución normal no implica que el par tenga una distribución normal conjunta. Un ejemplo sencillo es aquel en el que X tiene una distribución normal con un valor esperado de 0 y una varianza de 1, y si y si , donde . Existen contraejemplos similares para más de dos variables aleatorias. En general, suman un modelo mixto . [ cita requerida ]

Correlaciones e independencia

En general, las variables aleatorias pueden no estar correlacionadas pero ser estadísticamente dependientes. Pero si un vector aleatorio tiene una distribución normal multivariante, entonces dos o más de sus componentes que no están correlacionados son independientes . Esto implica que dos o más de sus componentes que son independientes por pares son independientes. Pero, como se señaló anteriormente, no es cierto que dos variables aleatorias que están ( por separado , marginalmente) distribuidas normalmente y no correlacionadas sean independientes.

Distribuciones condicionales

Si x N -dimensional se particiona de la siguiente manera

y en consecuencia μ y Σ se dividen de la siguiente manera

entonces la distribución de x 1 condicional a x 2 = a es normal multivariada [23] ( x 1 | x 2 = a ) ~ N ( μ , Σ ) donde

y matriz de covarianza

- [24]

Aquí está la inversa generalizada de . La matriz es el complemento de Schur de Σ 22 en Σ . Es decir, la ecuación anterior es equivalente a invertir la matriz de covarianza general, eliminar las filas y columnas correspondientes a las variables que se condicionan y volver a invertir para obtener la matriz de covarianza condicional.

Nótese que saber que x 2 = a altera la varianza, aunque la nueva varianza no depende del valor específico de a ; quizás más sorprendente aún, la media se desplaza en ; compare esto con la situación de no conocer el valor de a , en cuyo caso x 1 tendría una distribución .

Un hecho interesante derivado para probar este resultado es que los vectores aleatorios y son independientes.

La matriz Σ 12 Σ 22 −1 se conoce como la matriz de coeficientes de regresión .

Caso bivariado

En el caso bivariado donde x se divide en y , la distribución condicional de dado es [25]

¿Dónde está el coeficiente de correlación entre y ?

Esperanza condicional bivariada

En el caso general

La esperanza condicional de X 1 dado X 2 es:

Demostración: el resultado se obtiene tomando la esperanza de la distribución condicional anterior.

En el caso centrado con variaciones unitarias

La esperanza condicional de X 1 dado X 2 es

y la varianza condicional es

Por lo tanto, la varianza condicional no depende de x 2 .

La expectativa condicional de X 1 dado que X 2 es menor/mayor que z es: [26] : 367

donde la relación final aquí se llama relación de Mills inversa .

Demostración: los dos últimos resultados se obtienen utilizando el resultado , de modo que

- y luego utilizando las propiedades de la expectativa de una distribución normal truncada .

Distribuciones marginales

Para obtener la distribución marginal sobre un subconjunto de variables aleatorias normales multivariadas, sólo es necesario eliminar las variables irrelevantes (las variables que se quieren marginar) del vector de medias y de la matriz de covarianza. La prueba de esto se desprende de las definiciones de distribuciones normales multivariadas y del álgebra lineal. [27]

Ejemplo

Sean X = [ X 1 , X 2 , X 3 ] variables aleatorias normales multivariadas con vector medio μ = [ μ 1 , μ 2 , μ 3 ] y matriz de covarianza Σ (parametrización estándar para distribuciones normales multivariadas). Entonces la distribución conjunta de X ′ = [ X 1 , X 3 ] es normal multivariada con vector medio μ ′ = [ μ 1 , μ 3 ] y matriz de covarianza .

Transformación afín

Si Y = c + BX es una transformación afín de donde c es un vector de constantes y B es una matriz constante , entonces Y tiene una distribución normal multivariada con valor esperado c + Bμ y varianza BΣB T es decir, . En particular, cualquier subconjunto de X i tiene una distribución marginal que también es normal multivariada. Para ver esto, considere el siguiente ejemplo: para extraer el subconjunto ( X 1 , X 2 , X 4 ) T , use

que extrae directamente los elementos deseados.

Otro corolario es que la distribución de Z = b · X , donde b es un vector constante con el mismo número de elementos que X y el punto indica el producto escalar , es gaussiana univariante con . Este resultado se deduce utilizando

Observe cómo la definición positiva de Σ implica que la varianza del producto escalar debe ser positiva.

Una transformación afín de X como 2 X no es lo mismo que la suma de dos realizaciones independientes de X.

Interpretación geométrica

Los contornos de equidensidad de una distribución normal multivariada no singular son elipsoides (es decir, transformaciones afines de hiperesferas ) centrados en la media. [28] Por lo tanto, la distribución normal multivariada es un ejemplo de la clase de distribuciones elípticas . Las direcciones de los ejes principales de los elipsoides están dadas por los vectores propios de la matriz de covarianza . Las longitudes relativas al cuadrado de los ejes principales están dadas por los valores propios correspondientes.

Si Σ = UΛU T = UΛ 1/2 ( UΛ 1/2 ) T es una descomposición propia donde las columnas de U son vectores propios unitarios y Λ es una matriz diagonal de los valores propios, entonces tenemos

Además, U puede elegirse como una matriz de rotación , ya que invertir un eje no tiene ningún efecto sobre N (0, Λ ), pero invertir una columna cambia el signo del determinante de U. La distribución N ( μ , Σ ) es en efecto N (0, I ) escalada por Λ 1/2 , rotada por U y trasladada por μ .

Por el contrario, cualquier elección de μ , matriz de rango completo U y entradas diagonales positivas Λ i produce una distribución normal multivariante no singular. Si cualquier Λ i es cero y U es cuadrado, la matriz de covarianza resultante UΛU T es singular . Geométricamente, esto significa que cada elipsoide de contorno es infinitamente delgado y tiene volumen cero en el espacio n -dimensional, ya que al menos uno de los ejes principales tiene una longitud de cero; este es el caso degenerado .

"El radio alrededor de la media verdadera en una variable aleatoria normal bivariada, reescrita en coordenadas polares (radio y ángulo), sigue una distribución de Hoyt ". [29]

En una dimensión, la probabilidad de encontrar una muestra de la distribución normal en el intervalo es aproximadamente 68,27%, pero en dimensiones superiores la probabilidad de encontrar una muestra en la región de la elipse de desviación estándar es menor. [30]

| Dimensionalidad | Probabilidad |

|---|---|

| 1 | 0,6827 |

| 2 | 0,3935 |

| 3 | 0,1987 |

| 4 | 0.0902 |

| 5 | 0,0374 |

| 6 | 0,0144 |

| 7 | 0,0052 |

| 8 | 0,0018 |

| 9 | 0,0006 |

| 10 | 0,0002 |

Inferencia estadística

Estimación de parámetros

La derivación del estimador de máxima verosimilitud de la matriz de covarianza de una distribución normal multivariada es sencilla.

En resumen, la función de densidad de probabilidad (pdf) de una normal multivariada es

y el estimador ML de la matriz de covarianza de una muestra de n observaciones es [31]

que es simplemente la matriz de covarianza de la muestra . Este es un estimador sesgado cuya expectativa es

Una covarianza de muestra imparcial es

- (forma matricial; es la matriz identidad, J es una matriz de unos; el término entre paréntesis es por tanto la matriz de centrado)

La matriz de información de Fisher para estimar los parámetros de una distribución normal multivariante tiene una expresión en forma cerrada. Esta se puede utilizar, por ejemplo, para calcular el límite de Cramér-Rao para la estimación de parámetros en este contexto. Consulte la información de Fisher para obtener más detalles.

Inferencia bayesiana

En estadística bayesiana , la distribución conjugada a priori del vector de media es otra distribución normal multivariante, y la distribución conjugada a priori de la matriz de covarianza es una distribución Wishart inversa . Supongamos entonces que se han realizado n observaciones.

y que se ha asignado un conjugado anterior, donde

dónde

y

Entonces [31]

dónde

Pruebas de normalidad multivariante

Las pruebas de normalidad multivariante comprueban la similitud de un conjunto de datos con la distribución normal multivariante . La hipótesis nula es que el conjunto de datos es similar a la distribución normal, por lo tanto, un valor p suficientemente pequeño indica datos no normales. Las pruebas de normalidad multivariante incluyen la prueba de Cox-Small [32] y la adaptación de Smith y Jain [33] de la prueba de Friedman-Rafsky creada por Larry Rafsky y Jerome Friedman . [34]

La prueba de Mardia [35] se basa en extensiones multivariadas de medidas de asimetría y curtosis . Para una muestra { x 1 , ..., x n } de vectores k -dimensionales calculamos

Bajo la hipótesis nula de normalidad multivariada, el estadístico A tendrá aproximadamente una distribución de chi-cuadrado con 1/6 ⋅ k ( k + 1)( k + 2) grados de libertad, y B será aproximadamente la normal estándar N (0,1).

La estadística de curtosis de Mardia está sesgada y converge muy lentamente a la distribución normal límite. Para muestras de tamaño medio , se modifican los parámetros de la distribución asintótica de la estadística de curtosis [36] . Para pruebas de muestras pequeñas ( ) se utilizan valores críticos empíricos. Rencher [37] proporciona tablas de valores críticos para ambas estadísticas para k = 2, 3, 4.

Las pruebas de Mardia son invariantes afines pero no consistentes. Por ejemplo, la prueba de asimetría multivariante no es consistente frente a alternativas no normales simétricas. [38]

La prueba BHEP [39] calcula la norma de la diferencia entre la función característica empírica y la función característica teórica de la distribución normal. El cálculo de la norma se realiza en el espacio L 2 ( μ ) de funciones integrables al cuadrado con respecto a la función de ponderación gaussiana . La estadística de prueba es

La distribución límite de esta estadística de prueba es una suma ponderada de variables aleatorias de chi-cuadrado. [39]

Está disponible un estudio detallado de estos y otros procedimientos de prueba. [40]

Clasificación en clases normales multivariadas

Análisis discriminante gaussiano

Supongamos que se supone que las observaciones (que son vectores) provienen de una de varias distribuciones normales multivariadas, con medias y covarianzas conocidas. Entonces, cualquier observación dada puede asignarse a la distribución de la que tiene la mayor probabilidad de surgir. Este procedimiento de clasificación se denomina análisis discriminante gaussiano. El rendimiento de la clasificación, es decir, las probabilidades de los diferentes resultados de la clasificación y el error de clasificación general, se pueden calcular mediante el método numérico de trazado de rayos [17] (código Matlab).

Métodos computacionales

Extraer valores de la distribución

Un método ampliamente utilizado para extraer (muestrear) un vector aleatorio x de la distribución normal multivariada N -dimensional con vector medio μ y matriz de covarianza Σ funciona de la siguiente manera: [41]

- Encuentre cualquier matriz real A tal que AA T = Σ . Cuando Σ es positiva-definida, la descomposición de Cholesky se usa típicamente, y la forma extendida de esta descomposición siempre se puede usar (ya que la matriz de covarianza puede ser solo semi-definida positiva) en ambos casos se obtiene una matriz A adecuada . Una alternativa es usar la matriz A = UΛ 1/2 obtenida a partir de una descomposición espectral Σ = UΛU −1 de Σ . El primer enfoque es computacionalmente más sencillo pero las matrices A cambian para diferentes ordenamientos de los elementos del vector aleatorio, mientras que el último enfoque da matrices que están relacionadas por reordenamientos simples. En teoría, ambos enfoques dan formas igualmente buenas de determinar una matriz A adecuada , pero hay diferencias en el tiempo de cálculo.

- Sea z = ( z 1 , ..., z N ) T un vector cuyos componentes son N variables normales estándar independientes (que pueden generarse, por ejemplo, utilizando la transformada de Box-Muller ).

- Sea x μ + Az . Esta tiene la distribución deseada debido a la propiedad de transformación afín .

Véase también

- Distribución Chi , la función de densidad de probabilidad de la norma 2 ( norma euclidiana o longitud del vector ) de un vector multivariado distribuido normalmente (no correlacionado y centrado en cero).

- Distribución de Rayleigh , la función de densidad de probabilidad de la longitud del vector de un vector normalmente distribuido bivariado (no correlacionado y centrado en cero)

- Distribución de Rice , la función de densidad de probabilidad de la longitud del vector de un vector normalmente distribuido bivariado (no correlacionado y no centrado)

- Distribución de Hoyt , la función de densidad de probabilidad de la longitud del vector de un vector distribuido normalmente bivariado (correlacionado y centrado)

- Distribución normal compleja , una aplicación de la distribución normal bivariada

- Cópula , para la definición del modelo de cópula gaussiana o normal.

- Distribución t multivariada , que es otra distribución multivariada esféricamente simétrica ampliamente utilizada.

- Extensión de la distribución estable multivariada de la distribución normal multivariada, cuando el índice (exponente en la función característica) está entre cero y dos.

- Distancia de Mahalanobis

- Distribución de Wishart

- Distribución normal matricial

Referencias

- ^ abc Lapidoth, Amos (2009). Una base para la comunicación digital . Cambridge University Press. ISBN 978-0-521-19395-5.

- ^ Gut, Allan (2009). Un curso intermedio de probabilidad . Springer. ISBN 978-1-441-90161-3.

- ^ Kac, M. (1939). "Sobre una caracterización de la distribución normal". American Journal of Mathematics . 61 (3): 726–728. doi :10.2307/2371328. JSTOR 2371328.

- ^ Sinz, Fabian; Gerwinn, Sebastian; Bethge, Matthias (2009). "Caracterización de la distribución normal p-generalizada". Journal of Multivariate Analysis . 100 (5): 817–820. doi : 10.1016/j.jmva.2008.07.006 .

- ^ Simon JD Prince (junio de 2012). Visión artificial: modelos, aprendizaje e inferencia Archivado el 28 de octubre de 2020 en Wayback Machine . Cambridge University Press. 3.7: "Distribución normal multivariante".

- ^ Kim, M. G. (2000). "Valores atípicos multivariados y descomposiciones de la distancia de Mahalanobis". Comunicaciones en Estadística – Teoría y Métodos . 29 (7): 1511–1526. doi :10.1080/03610920008832559.

- ^ Hamedani, GG; Tata, MN (1975). "Sobre la determinación de la distribución normal bivariada a partir de distribuciones de combinaciones lineales de las variables". The American Mathematical Monthly . 82 (9): 913–915. doi :10.2307/2318494. JSTOR 2318494.

- ^ Wyatt, John (26 de noviembre de 2008). "Estimación de error cuadrático medio mínimo lineal" (PDF) . Apuntes del curso de probabilidad aplicada . Archivado desde el original (PDF) el 10 de octubre de 2015. Consultado el 23 de enero de 2012 .

- ^ "Álgebra lineal - Mapeo entre funciones de coordenadas afines". Intercambio de pila de matemáticas . Consultado el 24 de junio de 2022 .

- ^ Rao, CR (1973). Inferencia estadística lineal y sus aplicaciones . Nueva York: Wiley. pp. 527–528. ISBN 0-471-70823-2.

- ^ ab Botev, ZI (2016). "La ley normal bajo restricciones lineales: simulación y estimación mediante inclinación minimax". Revista de la Royal Statistical Society, Serie B. 79 : 125–148. arXiv : 1603.04166 . Código Bibliográfico :2016arXiv160304166B. doi :10.1111/rssb.12162. S2CID : 88515228.

- ^ Genz, Alan (2009). Cálculo de probabilidades normales y t multivariadas. Springer. ISBN 978-3-642-01689-9.

- ^ de Bensimhoun Michael, Función acumulativa de dimensión N y otros datos útiles sobre gaussianas y densidades normales (2006)

- ^ Siotani, Minoru (1964). "Regiones de tolerancia para una población normal multivariante" (PDF) . Anales del Instituto de Matemática Estadística . 16 (1): 135–153. doi :10.1007/BF02868568. S2CID 123269490.

- ^ ab Botev, ZI; Mandjes, M.; Ridder, A. (6–9 de diciembre de 2015). "Distribución de cola del máximo de variables aleatorias gaussianas correlacionadas". Conferencia de simulación de invierno de 2015 (WSC) . Huntington Beach, California, EE. UU.: IEEE. págs. 633–642. doi :10.1109/WSC.2015.7408202. hdl : 10419/130486 . ISBN . 978-1-4673-9743-8.

- ^ Adler, RJ; Blanchet, J.; Liu, J. (7–10 de diciembre de 2008). "Simulación eficiente para probabilidades de cola de campos aleatorios gaussianos". Conferencia de simulación de invierno de 2008 (WSC) . Miami, Florida, EE. UU.: IEEE. págs. 328–336. doi :10.1109/WSC.2008.4736085. ISBN . 978-1-4244-2707-9.

{{cite conference}}: CS1 maint: date and year (link) - ^ abcdefghi Das, Abhranil; Wilson S Geisler (2020). "Métodos para integrar multinormales y calcular medidas de clasificación". arXiv : 2012.14331 [stat.ML].

- ^ Hernandez-Stumpfhauser, Daniel; Breidt, F. Jay; van der Woerd, Mark J. (2017). "La distribución normal proyectada general de dimensión arbitraria: modelado e inferencia bayesiana". Análisis bayesiano . 12 (1): 113–133. doi : 10.1214/15-BA989 .

- ^ Tong, T. (2010) Regresión lineal múltiple: MLE y sus resultados distributivos Archivado el 16 de junio de 2013 en WebCite , Notas de la conferencia

- ^ Gokhale, DV; Ahmed, NA; Res, BC; Piscataway, NJ (mayo de 1989). "Expresiones de entropía y sus estimadores para distribuciones multivariadas". IEEE Transactions on Information Theory . 35 (3): 688–692. doi :10.1109/18.30996.

- ^ Duchi, J. "Derivaciones para álgebra lineal y optimización" (PDF) : 13.

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ MacKay, David JC (6 de octubre de 2003). Teoría de la información, inferencia y algoritmos de aprendizaje (edición ilustrada). Cambridge: Cambridge University Press. ISBN 978-0-521-64298-9.

- ^ Holt, W.; Nguyen, D. (2023). "Aspectos esenciales de la imputación de datos bayesianos". SSRN 4494314.

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Eaton, Morris L. (1983). Estadística multivariante: un enfoque de espacio vectorial . John Wiley and Sons. págs. 116-117. ISBN 978-0-471-02776-8.

- ^ Jensen, J (2000). Estadísticas para ingenieros petroleros y geocientíficos . Ámsterdam: Elsevier. p. 207. ISBN 0-444-50552-0.

- ^ Maddala, GS (1983). Variables dependientes y cualitativas limitadas en econometría . Cambridge University Press. ISBN 0-521-33825-5.

- ^ Se muestra un cálculo algebraico de la distribución marginal aquí http://fourier.eng.hmc.edu/e161/lectures/gaussianprocess/node7.html Archivado el 17 de enero de 2010 en Wayback Machine . Se describe una prueba mucho más breve aquí https://math.stackexchange.com/a/3832137

- ^ Nikolaus Hansen (2016). "La estrategia de evolución de CMA: un tutorial" (PDF) . arXiv : 1604.00772 . Código Bibliográfico :2016arXiv160400772H. Archivado desde el original (PDF) el 2010-03-31 . Consultado el 2012-01-07 .

- ^ Daniel Wollschlaeger. "La distribución Hoyt (Documentación para el paquete R 'shotGroups' versión 0.6.2)".[ enlace muerto permanente ]

- ^ Wang, Bin; Shi, Wenzhong; Miao, Zelang (13 de marzo de 2015). Rocchini, Duccio (ed.). "Análisis de confianza de la elipse de desviación estándar y su extensión al espacio euclidiano de mayor dimensión". PLOS ONE . 10 (3): e0118537. Bibcode :2015PLoSO..1018537W. doi : 10.1371/journal.pone.0118537 . ISSN 1932-6203. PMC 4358977 . PMID 25769048.

- ^ ab Holt, W.; Nguyen, D. (2023). "Introducción a la imputación de datos bayesianos". SSRN 4494314.

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Cox, DR; Small, NJH (1978). "Prueba de normalidad multivariante". Biometrika . 65 (2): 263. doi :10.1093/biomet/65.2.263.

- ^ Smith, SP; Jain, AK (1988). "Una prueba para determinar la normalidad multivariada de un conjunto de datos". IEEE Transactions on Pattern Analysis and Machine Intelligence . 10 (5): 757. doi :10.1109/34.6789.

- ^ Friedman, JH; Rafsky, LC (1979). "Generalizaciones multivariadas de las pruebas de dos muestras de Wald-Wolfowitz y Smirnov". Anales de estadística . 7 (4): 697. doi : 10.1214/aos/1176344722 .

- ^ Mardia, KV (1970). "Medidas de asimetría y curtosis multivariadas con aplicaciones". Biometrika . 57 (3): 519–530. doi :10.1093/biomet/57.3.519.

- ^ Rencher (1995), páginas 112–113.

- ^ Rencher (1995), páginas 493–495.

- ^ Baringhaus, L.; Henze, N. (1991). "Distribuciones límite para medidas de asimetría y curtosis multivariadas basadas en proyecciones". Journal of Multivariate Analysis . 38 : 51–69. doi : 10.1016/0047-259X(91)90031-V .

- ^ ab Baringhaus, L.; Henze, N. (1988). "Una prueba consistente para normalidad multivariante basada en la función característica empírica". Metrika . 35 (1): 339–348. doi :10.1007/BF02613322. S2CID 122362448.

- ^ Henze, Norbert (2002). "Pruebas invariantes para normalidad multivariante: una revisión crítica". Documentos estadísticos . 43 (4): 467–506. doi :10.1007/s00362-002-0119-6. S2CID 122934510.

- ^ Gentle, JE (2009). Estadística computacional. Estadística y computación. Nueva York: Springer. pp. 315–316. doi :10.1007/978-0-387-98144-4. ISBN 978-0-387-98143-7.

Literatura

- Rencher, AC (1995). Métodos de análisis multivariante . Nueva York: Wiley.

- Tong, YL (1990). La distribución normal multivariante . Springer Series in Statistics. Nueva York: Springer-Verlag. doi :10.1007/978-1-4613-9655-0. ISBN . 978-1-4613-9657-4.S2CID120348131 .

![{\displaystyle {\boldsymbol {\mu }}=\left[{\begin{smallmatrix}0\\0\end{smallmatrix}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/288f20c89fee827ad086cec03369439ba3615d7f)

![{\displaystyle {\boldsymbol {\Sigma }}=\left[{\begin{smallmatrix}1&3/5\\3/5&2\end{smallmatrix}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ee3a76f734b37fcce91f30617152fe104b2782bc)

![{\displaystyle {\boldsymbol {\mu }}=\nombredeloperador {E} [\mathbf {X} ]=(\nombredeloperador {E} [X_{1}],\nombredeloperador {E} [X_{2}],\ldots ,\nombredeloperador {E} [X_{k}])^{\mathrm {T} },}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a0ff77227bef5ec255a816fbb1a31d5c1e0fba21)

![{\displaystyle \Sigma _{i,j}=\operatorname {E} [(X_{i}-\mu _{i})(X_{j}-\mu _{j})]=\operatorname {Cov } [X_ {i}, X_ {j}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c970083f8469366521881996464f23d376b7c40b)

![{\displaystyle {\text{[XY]}}\prime }](https://wikimedia.org/api/rest_v1/media/math/render/svg/faffc663dc20d1db9845a496c725e6b07029f263)

![{\displaystyle f(x,y)={\frac {1}{2\pi \sigma _{X}\sigma _{Y}{\sqrt {1-\rho ^{2}}}}}\exp \left(-{\frac {1}{2\left[1-\rho ^{2}\right]}}\left[\left({\frac {x-\mu _{X}}{\sigma _{X}}}\right)^{2}-2\rho \left({\frac {x-\mu _{X}}{\sigma _{X}}}\right)\left({\frac {y-\mu _{Y}}{\sigma _{Y}}}\right)+\left({\frac {y-\mu _{Y}}{\sigma _{Y}}}\right)^{2}\right]\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bf91aebe806d84bb97ab95715e8e10e619387356)

![{\displaystyle \mu _{1,\ldots ,N}(\mathbf {x} )\mathrel {\stackrel {\mathrm {def} }{=}} \mu _{r_{1},\ldots ,r_ {N}}(\mathbf {x} )\mathrel {\stackrel {\mathrm {def} }{=}} \operatorname {E} \left[\prod _{j=1}^{N}X_{j }^{r_{j}}\derecha]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e19f7eec8adb98477e74dd88285ec1a07ce29aef)

![{\displaystyle {\begin{aligned}&\nombreoperador {E} [X_{1}X_{2}X_{3}X_{4}X_{5}X_{6}]\\[8pt]={}&\nombreoperador {E} [X_{1}X_{2}]\nombreoperador {E} [X_{3}X_{4}]\nombreoperador {E} [X_{5}X_{6}]+\nombreoperador {E} [X_{1}X_{2}]\nombreoperador {E} [X_{3}X_{5}]\nombreoperador {E} [X_{4}X_{6}]+\nombreoperador {E} [X_{1}X_{2}]\nombreoperador {E} [X_{3}X_{6}]\nombreoperador {E} [X_{4}X_{5}]\\[4pt]&{}+\nombreoperador {E} [X_{1}X_{3}]\nombreoperador {E} [X_{2}X_{4}]\nombre del operador {E} [X_{5}X_{6}]+\nombre del operador {E} [X_{1}X_{3}]\nombre del operador {E} [X_{2}X_{5}]\nombre del operador {E} [X_{4}X_{6}]+\nombre del operador {E} [X_{1}X_{3}]\nombre del operador {E} [X_{2}X_{6}]\nombre del operador {E} [X_{4}X_{5}]\\[4pt]&{}+\nombre del operador {E} [X_{1}X_{4}]\nombre del operador {E} [X_{2}X_{3}]\nombre del operador {E} [X_{5}X_{6}]+\nombre del operador {E} [X_{1}X_{4}]\nombre del operador {E} [X_{2}X_{5}]\nombre del operador {E} [X_{3}X_{6}]+\nombre del operador {E} [X_{1}X_{4}]\nombre del operador {E} [X_{2}X_{6}]\nombre del operador {E} [X_{3}X_{5}]\\[4pt]&{}+\nombre del operador {E} [X_{1}X_{5}]\nombre del operador {E} [X_{2}X_{3}]\nombre del operador {E} [X_{4}X_{6}]+\nombre del operador {E} [X_{1}X_{5}]\nombre del operador {E} [X_{2}X_{4}]\nombre del operador {E} [X_{3}X_{6}]+\nombre del operador {E} [X_{1}X_{5}]\nombre del operador {E} [X_{2}X_{6}]\nombre del operador {E} [X_{3}X_{4}]\\[4pt]&{}+\nombre del operador {E} [X_{1}X_{6}]\nombre del operador {E} [X_{2}X_{3}]\nombre del operador {E} [X_{4}X_{5}]+\nombre del operador {E} [X_{1}X_{6}]\nombre del operador {E} [X_{2}X_{4}]\nombre del operador {E} [X_{3}X_{5}]+\nombre del operador {E} [X_{1}X_{6}]\nombre del operador {E} [X_{2}X_{5}]\nombre del operador {E} [X_{3}X_{4}].\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0517839a9528128fa6d69cedfe4f5003a34716f4)

![{\displaystyle [1,\ldots ,2\lambda ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a605bf32a38577fe9df1bc5715a4a3cac5869832)

![{\displaystyle {\begin{aligned}\nombredeloperador {E} \left[X_{i}^{4}\right]&=3\sigma _{ii}^{2}\\[4pt]\nombredeloperador {E} \left[X_{i}^{3}X_{j}\right]&=3\sigma _{ii}\sigma _{ij}\\[4pt]\nombredeloperador {E} \left[X_{i}^{2}X_{j}^{2}\right]&=\sigma _{ii}\sigma _{jj}+2\sigma _{ij}^{2}\\[4pt]\nombredeloperador {E} \left[X_{i}^{2}X_{j}X_{k}\right]&=\sigma _{ii}\sigma _{jk}+2\sigma _{ij}\sigma _{ik}\\[4pt]\nombredeloperador {E} \left[X_{i}X_{j}X_{k}X_{n}\right]&=\sigma _{ij}\sigma _{kn}+\sigma _{ik}\sigma _{jn}+\sigma _{in}\sigma _{jk}.\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4e08f5bc180e3f1f4379c1026100e833ea85de97)

![{\displaystyle E\left[X_{i}X_{j}X_{k}X_{n}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0b4bbbf2becaf15b246898e928a37e7d0ab6f93a)

![{\displaystyle \nombre del operador {E} [X_{i}^{2}X_{k}X_{n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f7bc1920d0e524aa567ca471bdb54dcf7ef7e673)

![{\displaystyle \ln L({\boldsymbol {x}})=-{\frac {1}{2}}\left[\ln(|{\boldsymbol {\Sigma }}|\,)+({\boldsymbol {x}}-{\boldsymbol {\mu }})'{\boldsymbol {\Sigma }}^{-1}({\boldsymbol {x}}-{\boldsymbol {\mu }})+k\ln(2\pi )\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ad05643016bbf6ac76a826320bea00704b50982)

![{\displaystyle E\left[{\widehat {\boldsymbol {\Sigma }}}\right]={\frac {n-1}{n}}{\boldsymbol {\Sigma }}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/12908e94489d8fcdd7c2aa360d3ce85c26bc611a)

![{\displaystyle {\widehat {\boldsymbol {\Sigma }}}={\frac {1}{n-1}}\sum _{i=1}^{n}(\mathbf {x} _{i}-{\overline {\mathbf {x} }})(\mathbf {x} _{i}-{\overline {\mathbf {x} }})^{\rm {T}}={\frac {1}{n-1}}\left[X'\left(I-{\frac {1}{n}}\cdot J\right)X\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b483843b0f64ecbfea751011ef0ab8e61c7f0dcc)

![{\displaystyle {\begin{aligned}&{\widehat {\boldsymbol {\Sigma }}}={1 \over n}\sum _ {j=1}^{n}\left(\mathbf {x} _ {j}-{\bar {\mathbf {x} }}\right)\left(\mathbf {x} _{j}-{\bar {\mathbf {x} }}\right)^{\mathrm { T} }\\&A={1 \over 6n}\sum _{i=1}^{n}\sum _{j=1}^{n}\left[(\mathbf {x} _{i} -{\bar {\mathbf {x} }})^{\mathrm {T} }\;{\widehat {\boldsymbol {\Sigma }}}^{-1}(\mathbf {x} _{j}-{\bar {\mathbf {x} }})\right]^{3}\\&B={\sqrt {\frac {n}{8k(k+2)}}}\left\ {{1 \sobre n}\suma _{i=1}^{n}\left[(\mathbf {x} _{i}-{\bar {\mathbf {x} }})^{\mathrm { T} }\;{\widehat {\boldsymbol {\Sigma }}}^{-1}(\mathbf {x} _{i}-{\bar {\mathbf {x} }})\right]^{ 2}-k(k+2)\derecha\}\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2d6fcd342cc6e6df3c6fcd10852c7908e248829d)