Análisis de regresión

| Parte de una serie sobre |

| Análisis de regresión |

|---|

| Modelos |

| Estimación |

| Fondo |

| Part of a series on |

| Machine learning and data mining |

|---|

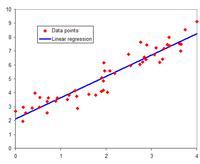

En modelado estadístico , el análisis de regresión es un conjunto de procesos estadísticos para estimar las relaciones entre una variable dependiente (a menudo llamada variable de resultado o respuesta , o una etiqueta en la jerga del aprendizaje automático) y una o más variables independientes libres de errores (a menudo llamadas regresores , predictores , covariables , variables explicativas o características ). La forma más común de análisis de regresión es la regresión lineal , en la que se encuentra la línea (o una combinación lineal más compleja ) que se ajusta mejor a los datos de acuerdo con un criterio matemático específico. Por ejemplo, el método de mínimos cuadrados ordinarios calcula la línea única (o hiperplano ) que minimiza la suma de las diferencias al cuadrado entre los datos verdaderos y esa línea (o hiperplano). Por razones matemáticas específicas (ver regresión lineal ), esto permite al investigador estimar la expectativa condicional (o valor promedio de la población ) de la variable dependiente cuando las variables independientes toman un conjunto dado de valores. Las formas menos comunes de regresión utilizan procedimientos ligeramente diferentes para estimar parámetros de ubicación alternativos (por ejemplo, regresión cuantil o análisis de condición necesaria [1] ) o estiman la expectativa condicional en una colección más amplia de modelos no lineales (por ejemplo, regresión no paramétrica ).

El análisis de regresión se utiliza principalmente para dos propósitos conceptualmente distintos. En primer lugar, el análisis de regresión se utiliza ampliamente para la predicción y el pronóstico , donde su uso tiene una superposición sustancial con el campo del aprendizaje automático . En segundo lugar, en algunas situaciones, el análisis de regresión se puede utilizar para inferir relaciones causales entre las variables independientes y dependientes. Es importante destacar que las regresiones por sí mismas solo revelan relaciones entre una variable dependiente y una colección de variables independientes en un conjunto de datos fijo. Para utilizar regresiones para la predicción o para inferir relaciones causales, respectivamente, un investigador debe justificar cuidadosamente por qué las relaciones existentes tienen poder predictivo para un nuevo contexto o por qué una relación entre dos variables tiene una interpretación causal. Esto último es especialmente importante cuando los investigadores esperan estimar relaciones causales utilizando datos observacionales . [2] [3]

Historia

La primera forma de regresión fue el método de mínimos cuadrados , publicado por Legendre en 1805, [4] y por Gauss en 1809. [5] Legendre y Gauss aplicaron el método al problema de determinar, a partir de observaciones astronómicas, las órbitas de los cuerpos alrededor del Sol (principalmente cometas, pero también más tarde los recién descubiertos planetas menores). Gauss publicó un desarrollo posterior de la teoría de mínimos cuadrados en 1821, [6] incluyendo una versión del teorema de Gauss-Markov .

El término "regresión" fue acuñado por Francis Galton en el siglo XIX para describir un fenómeno biológico. El fenómeno era que las alturas de los descendientes de antepasados altos tienden a retroceder hacia un promedio normal (un fenómeno también conocido como regresión hacia la media ). [7] [8] Para Galton, la regresión tenía solo este significado biológico, [9] [10] pero su trabajo fue posteriormente ampliado por Udny Yule y Karl Pearson a un contexto estadístico más general. [11] [12] En el trabajo de Yule y Pearson, se supone que la distribución conjunta de las variables de respuesta y explicativas es gaussiana . Esta suposición fue debilitada por RA Fisher en sus trabajos de 1922 y 1925. [13] [14] [15] Fisher asumió que la distribución condicional de la variable de respuesta es gaussiana, pero la distribución conjunta no necesita serlo. En este sentido, la suposición de Fisher se acerca más a la formulación de Gauss de 1821.

En los años 1950 y 1960, los economistas utilizaban calculadoras electromecánicas de escritorio para calcular regresiones. Antes de 1970, a veces se necesitaban hasta 24 horas para recibir el resultado de una regresión. [16]

Los métodos de regresión siguen siendo un área de investigación activa. En las últimas décadas, se han desarrollado nuevos métodos para la regresión robusta , la regresión que implica respuestas correlacionadas como series temporales y curvas de crecimiento , la regresión en la que el predictor (variable independiente) o las variables de respuesta son curvas, imágenes, gráficos u otros objetos de datos complejos, los métodos de regresión que se adaptan a varios tipos de datos faltantes, la regresión no paramétrica , los métodos bayesianos para la regresión, la regresión en la que las variables predictoras se miden con error, la regresión con más variables predictoras que observaciones y la inferencia causal con regresión.

Modelo de regresión

En la práctica, los investigadores primero seleccionan un modelo que desean estimar y luego utilizan el método elegido (por ejemplo, mínimos cuadrados ordinarios ) para estimar los parámetros de ese modelo. Los modelos de regresión involucran los siguientes componentes:

- Los parámetros desconocidos , a menudo denominados escalares o vectoriales .

- Las variables independientes , que se observan en los datos y a menudo se denotan como un vector (donde denota una fila de datos).

- La variable dependiente , que se observa en los datos y a menudo se denota mediante el escalar .

- Los términos de error , que no se observan directamente en los datos y a menudo se denotan utilizando el escalar .

En diversos campos de aplicación se utilizan diferentes terminologías en lugar de variables dependientes e independientes .

La mayoría de los modelos de regresión proponen que es una función ( función de regresión ) de y , que representa un término de error aditivo que puede reemplazar a determinantes no modelados de o ruido estadístico aleatorio:

Tenga en cuenta que se supone que las variables independientes están libres de errores. Este importante supuesto suele pasarse por alto, aunque se pueden utilizar modelos de errores en las variables cuando se supone que las variables independientes contienen errores.

El objetivo de los investigadores es estimar la función que mejor se ajusta a los datos. Para llevar a cabo un análisis de regresión, se debe especificar la forma de la función. A veces, la forma de esta función se basa en el conocimiento sobre la relación entre y que no depende de los datos. Si no se dispone de dicho conocimiento, se elige una forma flexible o conveniente para . Por ejemplo, una regresión univariante simple puede proponer , lo que sugiere que el investigador cree que es una aproximación razonable para el proceso estadístico que genera los datos.

Una vez que los investigadores determinan su modelo estadístico preferido , diferentes formas de análisis de regresión proporcionan herramientas para estimar los parámetros . Por ejemplo, los mínimos cuadrados (incluida su variante más común, los mínimos cuadrados ordinarios ) encuentran el valor de que minimiza la suma de los errores al cuadrado . Un método de regresión dado proporcionará en última instancia una estimación de , generalmente denotada para distinguir la estimación del valor verdadero (desconocido) del parámetro que generó los datos. Usando esta estimación, el investigador puede usar el valor ajustado para la predicción o para evaluar la precisión del modelo para explicar los datos. Si el investigador está intrínsecamente interesado en la estimación o en el valor predicho dependerá del contexto y sus objetivos. Como se describe en los mínimos cuadrados ordinarios , los mínimos cuadrados se usan ampliamente porque la función estimada se aproxima a la expectativa condicional . [5] Sin embargo, las variantes alternativas (por ejemplo, las desviaciones absolutas mínimas o la regresión cuantil ) son útiles cuando los investigadores quieren modelar otras funciones .

Es importante tener en cuenta que debe haber suficientes datos para estimar un modelo de regresión. Por ejemplo, supongamos que un investigador tiene acceso a filas de datos con una variable dependiente y dos independientes: . Supongamos además que el investigador quiere estimar un modelo lineal bivariado mediante mínimos cuadrados : . Si el investigador solo tiene acceso a puntos de datos, entonces podría encontrar infinitas combinaciones que expliquen los datos igualmente bien: se puede elegir cualquier combinación que satisfaga , todas las cuales conducen a y, por lo tanto, son soluciones válidas que minimizan la suma de los residuos al cuadrado . Para entender por qué hay infinitas opciones, observe que el sistema de ecuaciones debe resolverse para 3 incógnitas, lo que hace que el sistema esté subdeterminado . Alternativamente, uno puede visualizar infinitos planos tridimensionales que pasan por puntos fijos.

En términos más generales, para estimar un modelo de mínimos cuadrados con parámetros distintos, se deben tener puntos de datos distintos. Si , entonces generalmente no existe un conjunto de parámetros que se ajusten perfectamente a los datos. La cantidad aparece a menudo en el análisis de regresión y se conoce como grados de libertad en el modelo. Además, para estimar un modelo de mínimos cuadrados, las variables independientes deben ser linealmente independientes : no se debe poder reconstruir ninguna de las variables independientes sumando y multiplicando las variables independientes restantes. Como se discutió en mínimos cuadrados ordinarios , esta condición asegura que es una matriz invertible y, por lo tanto, que existe una solución única .

Supuestos subyacentes

This section needs additional citations for verification. (December 2020) |

En sí misma, una regresión es simplemente un cálculo que utiliza los datos. Para interpretar el resultado de la regresión como una cantidad estadística significativa que mide las relaciones del mundo real, los investigadores suelen basarse en una serie de supuestos clásicos . Estos supuestos suelen incluir:

- La muestra es representativa de la población en general.

- Las variables independientes se miden sin error.

- Las desviaciones del modelo tienen un valor esperado de cero, condicional a las covariables:

- La varianza de los residuos es constante en todas las observaciones ( homocedasticidad ).

- Los residuos no están correlacionados entre sí. Matemáticamente, la matriz de varianza-covarianza de los errores es diagonal .

Un puñado de condiciones son suficientes para que el estimador de mínimos cuadrados posea propiedades deseables: en particular, los supuestos de Gauss-Markov implican que las estimaciones de los parámetros serán insesgadas , consistentes y eficientes en la clase de estimadores lineales insesgados. Los profesionales han desarrollado una variedad de métodos para mantener algunas o todas estas propiedades deseables en entornos del mundo real, porque es poco probable que estos supuestos clásicos se mantengan exactamente. Por ejemplo, modelar errores en las variables puede llevar a estimaciones razonables las variables independientes se miden con errores. Los errores estándar consistentes con la heterocedasticidad permiten que la varianza de cambie entre valores de . Los errores correlacionados que existen dentro de subconjuntos de los datos o siguen patrones específicos se pueden manejar utilizando errores estándar agrupados, regresión ponderada geográfica o errores estándar de Newey-West , entre otras técnicas. Cuando las filas de datos corresponden a ubicaciones en el espacio, la elección de cómo modelar dentro de unidades geográficas puede tener consecuencias importantes. [17] [18] El subcampo de la econometría se centra en gran medida en el desarrollo de técnicas que permitan a los investigadores sacar conclusiones razonables en situaciones del mundo real, donde los supuestos clásicos no se cumplen exactamente.

Regresión lineal

En la regresión lineal, la especificación del modelo es que la variable dependiente es una combinación lineal de los parámetros (pero no necesita ser lineal en las variables independientes ). Por ejemplo, en la regresión lineal simple para modelar puntos de datos hay una variable independiente: , y dos parámetros, y :

- línea recta:

En la regresión lineal múltiple, hay varias variables independientes o funciones de variables independientes.

Añadiendo un término a la regresión anterior obtenemos:

- parábola:

Esta sigue siendo una regresión lineal; aunque la expresión del lado derecho es cuadrática en la variable independiente , es lineal en los parámetros y

En ambos casos, es un término de error y el subíndice indexa una observación particular.

Volviendo nuestra atención al caso de la línea recta: dada una muestra aleatoria de la población, estimamos los parámetros de la población y obtenemos el modelo de regresión lineal de la muestra:

El residuo , , es la diferencia entre el valor de la variable dependiente predicho por el modelo, , y el valor verdadero de la variable dependiente, . Un método de estimación es el de mínimos cuadrados ordinarios . Este método obtiene estimaciones de parámetros que minimizan la suma de los residuos al cuadrado , SSR :

La minimización de esta función da como resultado un conjunto de ecuaciones normales , un conjunto de ecuaciones lineales simultáneas en los parámetros, que se resuelven para obtener los estimadores de parámetros, .

En el caso de regresión simple, las fórmulas para las estimaciones de mínimos cuadrados son

donde es la media (promedio) de los valores y es la media de los valores.

Suponiendo que el término de error poblacional tiene una varianza constante, la estimación de esa varianza viene dada por:

Esto se denomina error cuadrático medio (MSE) de la regresión. El denominador es el tamaño de la muestra reducido por el número de parámetros del modelo estimados a partir de los mismos datos, para regresores o si se utiliza una intersección. [19] En este caso, el denominador es .

Los errores estándar de las estimaciones de los parámetros se dan por

Bajo el supuesto adicional de que el término de error poblacional se distribuye normalmente, el investigador puede utilizar estos errores estándar estimados para crear intervalos de confianza y realizar pruebas de hipótesis sobre los parámetros poblacionales .

Modelo lineal general

En el modelo de regresión múltiple más general, hay variables independientes:

donde es la -ésima observación de la -ésima variable independiente. Si la primera variable independiente toma el valor 1 para todos los , entonces se denomina intersección de regresión .

Las estimaciones de los parámetros de mínimos cuadrados se obtienen a partir de ecuaciones normales. El residuo se puede escribir como

Las ecuaciones normales son

En notación matricial, las ecuaciones normales se escriben como

donde el elemento de es , el elemento del vector columna es y el elemento de es . Por lo tanto es , es y es . La solución es

Diagnóstico

Una vez que se ha construido un modelo de regresión, puede ser importante confirmar la bondad del ajuste del modelo y la significancia estadística de los parámetros estimados. Las comprobaciones de bondad del ajuste que se utilizan habitualmente incluyen el R-cuadrado , los análisis del patrón de residuos y las pruebas de hipótesis. La significancia estadística se puede comprobar mediante una prueba F del ajuste general, seguida de pruebas t de parámetros individuales.

Las interpretaciones de estas pruebas diagnósticas dependen en gran medida de los supuestos del modelo. Aunque el examen de los residuos puede utilizarse para invalidar un modelo, los resultados de una prueba t o una prueba F a veces son más difíciles de interpretar si se violan los supuestos del modelo. Por ejemplo, si el término de error no tiene una distribución normal, en muestras pequeñas los parámetros estimados no seguirán distribuciones normales y complicarán la inferencia. Sin embargo, con muestras relativamente grandes, se puede invocar un teorema del límite central de modo que la prueba de hipótesis pueda proceder utilizando aproximaciones asintóticas.

Variables dependientes limitadas

Las variables dependientes limitadas , que son variables de respuesta que son variables categóricas o variables restringidas a caer solo dentro de un cierto rango, a menudo surgen en econometría .

La variable de respuesta puede ser no continua ("limitada" a encontrarse en algún subconjunto de la línea real). Para las variables binarias (cero o uno), si el análisis procede con regresión lineal de mínimos cuadrados, el modelo se denomina modelo de probabilidad lineal . Los modelos no lineales para variables dependientes binarias incluyen el modelo probit y logit . El modelo probit multivariado es un método estándar para estimar una relación conjunta entre varias variables dependientes binarias y algunas variables independientes. Para las variables categóricas con más de dos valores existe el logit multinomial . Para las variables ordinales con más de dos valores, existen los modelos logit ordenado y probit ordenado . Los modelos de regresión censurada se pueden utilizar cuando la variable dependiente solo se observa algunas veces, y los modelos de tipo corrección de Heckman se pueden utilizar cuando la muestra no se selecciona aleatoriamente de la población de interés. Una alternativa a tales procedimientos es la regresión lineal basada en la correlación policórica (o correlaciones poliseriales) entre las variables categóricas. Tales procedimientos difieren en las suposiciones realizadas sobre la distribución de las variables en la población. Si la variable es positiva con valores bajos y representa la repetición de la ocurrencia de un evento, entonces se pueden utilizar modelos de conteo como la regresión de Poisson o el modelo binomial negativo .

Regresión no lineal

Cuando la función del modelo no es lineal en los parámetros, la suma de cuadrados debe minimizarse mediante un procedimiento iterativo. Esto introduce muchas complicaciones que se resumen en Diferencias entre mínimos cuadrados lineales y no lineales .

Predicción (interpolación y extrapolación)

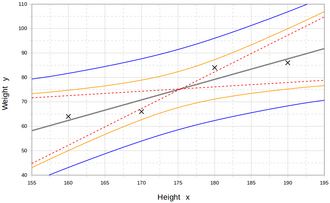

Los modelos de regresión predicen un valor de la variable Y dados los valores conocidos de las variables X. La predicción dentro del rango de valores en el conjunto de datos utilizado para el ajuste del modelo se conoce informalmente como interpolación . La predicción fuera de este rango de datos se conoce como extrapolación . La realización de la extrapolación depende en gran medida de los supuestos de la regresión. Cuanto más se aleje la extrapolación de los datos, más margen habrá para que el modelo falle debido a las diferencias entre los supuestos y los datos de muestra o los valores verdaderos.

La predicción puntual puede ir acompañada de un intervalo de predicción que represente la incertidumbre. Dichos intervalos tienden a expandirse rápidamente a medida que los valores de las variables independientes se desplazan fuera del rango cubierto por los datos observados.

Por estas y otras razones, algunos tienden a decir que podría ser imprudente realizar extrapolaciones. [21]

Selección de modelo

La suposición de una forma particular para la relación entre Y y X es otra fuente de incertidumbre. Un análisis de regresión realizado correctamente incluirá una evaluación de hasta qué punto la forma supuesta se corresponde con los datos observados, pero sólo puede hacerlo dentro del rango de valores de las variables independientes realmente disponibles. Esto significa que cualquier extrapolación depende especialmente de las suposiciones que se hagan sobre la forma estructural de la relación de regresión. Si este conocimiento incluye el hecho de que la variable dependiente no puede salir de un cierto rango de valores, esto se puede utilizar para seleccionar el modelo, incluso si el conjunto de datos observados no tiene valores particularmente cercanos a esos límites. Las implicaciones de este paso de elegir una forma funcional apropiada para la regresión pueden ser importantes cuando se considera la extrapolación. Como mínimo, puede garantizar que cualquier extrapolación que surja de un modelo ajustado sea "realista" (o acorde con lo que se sabe).

Cálculos de potencia y tamaño de muestra

No existen métodos generalmente aceptados para relacionar el número de observaciones versus el número de variables independientes en el modelo. Un método conjeturado por Good y Hardin es , donde es el tamaño de la muestra, es el número de variables independientes y es el número de observaciones necesarias para alcanzar la precisión deseada si el modelo tuviera solo una variable independiente. [22] Por ejemplo, un investigador está construyendo un modelo de regresión lineal utilizando un conjunto de datos que contiene 1000 pacientes ( ). Si el investigador decide que se necesitan cinco observaciones para definir con precisión una línea recta ( ), entonces el número máximo de variables independientes que el modelo puede admitir es 4, porque

- .

Otros métodos

Aunque los parámetros de un modelo de regresión se estiman habitualmente mediante el método de mínimos cuadrados, otros métodos que se han utilizado incluyen:

- Métodos bayesianos , por ejemplo, regresión lineal bayesiana

- Regresión porcentual, para situaciones en las que se considera más apropiado reducir los errores porcentuales . [23]

- Desviaciones absolutas mínimas , que son más robustas en presencia de valores atípicos, lo que conduce a la regresión cuantil

- La regresión no paramétrica requiere una gran cantidad de observaciones y es computacionalmente intensiva.

- Optimización de escenarios , que conduce a modelos predictores de intervalos

- Aprendizaje de métricas de distancia, que se aprende mediante la búsqueda de una métrica de distancia significativa en un espacio de entrada dado. [24]

Software

Todos los principales paquetes de software estadístico realizan análisis e inferencias de regresión por mínimos cuadrados . La regresión lineal simple y la regresión múltiple mediante mínimos cuadrados se pueden realizar en algunas aplicaciones de hojas de cálculo y en algunas calculadoras. Si bien muchos paquetes de software estadístico pueden realizar varios tipos de regresión no paramétrica y robusta, estos métodos están menos estandarizados. Diferentes paquetes de software implementan diferentes métodos, y un método con un nombre determinado puede implementarse de manera diferente en diferentes paquetes. Se ha desarrollado software de regresión especializado para su uso en campos como el análisis de encuestas y la neuroimagen.

Véase también

- Cuarteto de Anscombe

- Ajuste de curvas

- Teoría de la estimación

- Pronóstico

- Fracción de varianza no explicada

- Aproximación de funciones

- Modelo lineal generalizado

- Kriging (un algoritmo de estimación de mínimos cuadrados lineal)

- Regresión local

- Problema de unidad de área modificable

- Regresión spline adaptativa multivariante

- Distribución normal multivariante

- Coeficiente de correlación de Pearson

- Cuasi-varianza

- Intervalo de predicción

- Validación de regresión

- Regresión robusta

- Regresión segmentada

- Procesamiento de señales

- Regresión por pasos

- Geometría del taxi

- Estimación de tendencia lineal

Referencias

- ^ Análisis de condiciones necesarias

- ^ David A. Freedman (27 de abril de 2009). Modelos estadísticos: teoría y práctica. Cambridge University Press. ISBN 978-1-139-47731-4.

- ^ R. Dennis Cook; Crítica de Sanford Weisberg y análisis de la influencia en la regresión, Metodología sociológica , vol. 13 (1982), págs. 313-361

- ^ SOY Legendre . Nouvelles méthodes pour la détermination des orbites des comètes, Firmin Didot, París, 1805. “Sur la Méthode des moindres quarrés” aparece como apéndice.

- ^ ab Capítulo 1 de: Angrist, JD, y Pischke, JS (2008). Mostly Harmless Econometrics: An Empiricist's Companion . Princeton University Press.

- ^ CF Gauss. Teoria combinacionis observacionum erroribus minimis obnoxiae. (1821/1823)

- ^ Mogull, Robert G. (2004). Estadística aplicada del segundo semestre . Kendall/Hunt Publishing Company. pág. 59. ISBN 978-0-7575-1181-3.

- ^ Galton, Francis (1989). "Parentesco y correlación (reimpreso en 1989)". Ciencia estadística . 4 (2): 80–86. doi : 10.1214/ss/1177012581 . JSTOR 2245330.

- ^ Francis Galton . "Leyes típicas de la herencia", Nature 15 (1877), 492–495, 512–514, 532–533. (Galton utiliza el término "reversión" en este artículo, que analiza el tamaño de los guisantes).

- ^ Francis Galton. Discurso presidencial, Sección H, Antropología. (1885) (Galton utiliza el término "regresión" en este artículo, que analiza la altura de los seres humanos.)

- ^ Yule, G. Udny (1897). "Sobre la teoría de la correlación". Revista de la Royal Statistical Society . 60 (4): 812–54. doi :10.2307/2979746. JSTOR 2979746.

- ^ Pearson, Karl ; Yule, GU; Blanchard, Norman; Lee, Alice (1903). "La ley de la herencia ancestral". Biometrika . 2 (2): 211–236. doi :10.1093/biomet/2.2.211. JSTOR 2331683.

- ^ Fisher, RA (1922). "La bondad de ajuste de las fórmulas de regresión y la distribución de los coeficientes de regresión". Journal of the Royal Statistical Society . 85 (4): 597–612. doi :10.2307/2341124. JSTOR 2341124. PMC 1084801 .

- ^ Ronald A. Fisher (1954). Métodos estadísticos para investigadores (duodécima edición). Edimburgo : Oliver and Boyd. ISBN 978-0-05-002170-5.

- ^ Aldrich, John (2005). "Fisher y la regresión" (PDF) . Ciencia estadística . 20 (4): 401–417. doi : 10.1214/088342305000000331 . JSTOR 20061201.

- ^ Rodney Ramcharan. Regresiones: ¿Por qué los economistas están obsesionados con ellas?, marzo de 2006. Consultado el 3 de diciembre de 2011.

- ^ Fotheringham, A. Stewart; Brunsdon, Chris; Charlton, Martin (2002). Regresión ponderada geográficamente: el análisis de relaciones que varían espacialmente (edición reimpresa). Chichester, Inglaterra: John Wiley. ISBN 978-0-471-49616-8.

- ^ Fotheringham, AS; Wong, DWS (1 de enero de 1991). "El problema de la unidad de área modificable en el análisis estadístico multivariante". Environment and Planning A . 23 (7): 1025–1044. Bibcode :1991EnPlA..23.1025F. doi :10.1068/a231025. S2CID 153979055.

- ^ Steel, RGD, y Torrie, JH, Principios y procedimientos de estadística con especial referencia a las ciencias biológicas. , McGraw Hill , 1960, página 288.

- ^ Rouaud, Mathieu (2013). Probabilidad, estadística y estimación (PDF) . pág. 60.

- ^ Chiang, CL, (2003) Métodos estadísticos de análisis , World Scientific. ISBN 981-238-310-7 - página 274 sección 9.7.4 "interpolación vs extrapolación"

- ^ Good, PI ; Hardin, JW (2009). Errores comunes en estadística (y cómo evitarlos) (3.ª ed.). Hoboken, Nueva Jersey: Wiley. pág. 211. ISBN 978-0-470-45798-6.

- ^ Tofallis, C. (2009). "Regresión porcentual de mínimos cuadrados". Revista de métodos estadísticos aplicados modernos . 7 : 526–534. doi :10.2139/ssrn.1406472. hdl : 2299/965 . SSRN 1406472.

- ^ YangJing Long (2009). "Estimación de la edad humana mediante aprendizaje métrico para problemas de regresión" (PDF) . Proc. International Conference on Computer Analysis of Images and Patterns : 74–82. Archivado desde el original (PDF) el 8 de enero de 2010.

Lectura adicional

- William H. Kruskal y Judith M. Tanur , ed. (1978), "Hipótesis lineales", Enciclopedia Internacional de Estadística , Free Press, vol. 1,

- Evan J. Williams, "I. Regresión", págs. 523–41.

- Julian C. Stanley , "II. Análisis de varianza", págs. 541–554.

- Lindley, DV (1987). "Análisis de regresión y correlación", New Palgrave: A Dictionary of Economics , v. 4, págs. 120-23.

- Birkes, David y Dodge, Y. , Métodos alternativos de regresión . ISBN 0-471-56881-3

- Chatfield, C. (1993) "Cálculo de pronósticos de intervalo", Journal of Business and Economic Statistics, 11 , págs. 121–135.

- Draper, NR; Smith, H. (1998). Análisis de regresión aplicada (3.ª ed.). John Wiley. ISBN 978-0-471-17082-2.

- Fox, J. (1997). Análisis de regresión aplicado, modelos lineales y métodos relacionados. Sage

- Hardle, W., Regresión no paramétrica aplicada (1990), ISBN 0-521-42950-1

- Meade, Nigel; Islam, Towhidul (1995). "Intervalos de predicción para pronósticos de curvas de crecimiento". Journal of Forecasting . 14 (5): 413–430. doi :10.1002/for.3980140502.

- A. Sen, M. Srivastava, Análisis de regresión: teoría, métodos y aplicaciones , Springer-Verlag, Berlín, 2011 (cuarta impresión).

- T. Strutz: Ajuste de datos e incertidumbre (Una introducción práctica a los mínimos cuadrados ponderados y más allá) . Vieweg+Teubner, ISBN 978-3-8348-1022-9 .

- Stulp, Freek y Olivier Sigaud. Muchos algoritmos de regresión, un modelo unificado: una revisión. Neural Networks, vol. 69, septiembre de 2015, págs. 60–79. https://doi.org/10.1016/j.neunet.2015.05.005.

- Malakooti, B. (2013). Sistemas de producción y operaciones con objetivos múltiples. John Wiley & Sons.

- Chicco, Davide; Warrens, Matthijs J.; Jurman, Giuseppe (2021). "El coeficiente de determinación R-cuadrado es más informativo que SMAPE, MAE, MAPE, MSE y RMSE en la evaluación del análisis de regresión". PeerJ Ciencias de la Computación . 7 (e623): e623. doi : 10.7717/peerj-cs.623 . PMC 8279135 . PMID 34307865.

Enlaces externos

- "Análisis de regresión", Enciclopedia de Matemáticas , EMS Press , 2001 [1994]

- Usos más antiguos: Regresión: historia básica y referencias

- ¿Para qué se utiliza la regresión múltiple? – Regresión múltiple

- Regresión de datos débilmente correlacionados: cómo pueden aparecer errores de regresión lineal cuando el rango Y es mucho menor que el rango X