Ataque de desinformación

Los ataques de desinformación son campañas de engaño estratégico [1] que implican la manipulación de los medios y la manipulación de Internet , [2] para difundir información engañosa , [3] con el objetivo de confundir , paralizar y polarizar a una audiencia . [4] La desinformación puede considerarse un ataque cuando ocurre como una campaña narrativa adversaria que convierte en armas múltiples estrategias retóricas y formas de conocimiento, incluidas no solo falsedades sino también verdades, medias verdades y juicios cargados de valores, para explotar y amplificar controversias impulsadas por la identidad. [5] Los ataques de desinformación utilizan la manipulación de los medios para atacar a los medios de difusión como los canales de televisión y radios patrocinados por el estado. [6] [7] Debido al uso cada vez mayor de la manipulación de Internet en las redes sociales , [2] pueden considerarse una amenaza cibernética . [8] [9] Las herramientas digitales como bots , algoritmos y tecnología de IA , junto con agentes humanos, incluidos los influencers , difunden y amplifican la desinformación a poblaciones microobjetivo en plataformas en línea como Instagram , Twitter , Google , Facebook y YouTube . [10] [5]

Según un informe de 2018 de la Comisión Europea , [11] los ataques de desinformación pueden suponer amenazas a la gobernanza democrática , al disminuir la legitimidad de la integridad de los procesos electorales . Los ataques de desinformación son utilizados por y contra gobiernos , corporaciones , científicos, periodistas, activistas y otros individuos privados. [12] [13] [14] [15] Estos ataques se emplean comúnmente para reformular actitudes y creencias, impulsar una agenda particular o provocar ciertas acciones de un público objetivo. Las tácticas incluyen la circulación de información incorrecta o engañosa, la creación de incertidumbre y el socavamiento de la legitimidad de las fuentes de información oficiales. [16] [17] [18]

Un área emergente de investigación se centra en las contramedidas a los ataques de desinformación. [19] [20] [18] Tecnológicamente, las medidas defensivas incluyen aplicaciones de aprendizaje automático que pueden marcar la desinformación en plataformas digitales . [17] Socialmente, también se están desarrollando programas educativos para enseñar a las personas cómo discernir mejor entre hechos y desinformación en línea [21] y recomendaciones de periodistas para evaluar las fuentes. [22] Comercialmente, se proponen revisiones de algoritmos, publicidad y prácticas de influencia en plataformas digitales. [2] Las intervenciones individuales incluyen acciones que pueden tomar las personas para mejorar sus propias habilidades en el manejo de la información (por ejemplo, alfabetización mediática ) y acciones individuales para desafiar la desinformación.

Objetivos

Los ataques de desinformación implican la difusión intencional de información falsa, con el objetivo final de engañar, confundir, fomentar la violencia [23] , ganar dinero, poder o reputación [24] . Pueden involucrar a actores políticos, económicos e individuales. Pueden intentar influir en actitudes y creencias, impulsar una agenda específica, hacer que las personas actúen de maneras específicas o destruir la credibilidad de individuos o instituciones. La presentación de información incorrecta puede ser la parte más obvia de un ataque de desinformación, pero no es el único propósito. La creación de incertidumbre y el debilitamiento tanto de la información correcta como de la credibilidad de las fuentes de información también suelen ser objetivos [16] [17] [18]

Convencer a la gente de creer información incorrecta

Si se puede convencer a las personas de algo que es factualmente incorrecto, pueden tomar decisiones que, de hecho, van en contra de sus propios intereses y de los que las rodean. Si se puede convencer a la mayoría de las personas de una sociedad de algo que es factualmente incorrecto, la desinformación puede conducir a decisiones políticas y sociales que no sean las mejores para esa sociedad, lo que puede tener graves consecuencias tanto a nivel individual como social. [25]

En la década de 1990, un médico británico que poseía una patente sobre una vacuna contra el sarampión de una sola dosis promovió la desconfianza hacia la vacuna combinada MMR . Sus afirmaciones fraudulentas tenían como objetivo promover las ventas de su propia vacuna. El frenesí mediático posterior aumentó el miedo y muchos padres decidieron no vacunar a sus hijos. [26] Esto fue seguido por un aumento significativo en los casos, hospitalizaciones y muertes que se habrían podido prevenir con la vacuna MMR. [27] [28] También condujo al gasto de dinero sustancial en investigación de seguimiento que puso a prueba las afirmaciones hechas en la desinformación, [29] y en campañas de información pública que intentaban corregir la desinformación. La afirmación fraudulenta continúa siendo referenciada y aumenta las dudas sobre la vacuna . [30]

En el caso de las elecciones presidenciales de Estados Unidos de 2020 , se utilizó la desinformación en un intento de convencer a la gente de creer algo que no era cierto y cambiar el resultado de las elecciones. [31] [32] Los mensajes de desinformación repetidos sobre la posibilidad de fraude electoral se introdujeron años antes de que se celebraran las elecciones reales, ya en 2016. [33] [34] Los investigadores descubrieron que gran parte de las noticias falsas se originaron en grupos nacionales de derecha. La Asociación de Integridad Electoral no partidista informó antes de las elecciones que "lo que estamos viendo ahora son esencialmente semillas que se plantan, docenas de semillas cada día, de historias falsas... Todas se están plantando de tal manera que puedan ser citadas y reactivadas... después de las elecciones". [35] Se sentaron las bases a través de múltiples y repetidos ataques de desinformación para afirmar que la votación fue injusta y deslegitimar los resultados de las elecciones una vez que ocurrieron. [35] Aunque los resultados de las elecciones presidenciales de Estados Unidos de 2020 se confirmaron, algunas personas todavía creen en la " gran mentira ". [32]

Las personas que se informan a través de diversas fuentes de noticias, no solo de fuentes que tienen un punto de vista particular, tienen más probabilidades de detectar la desinformación. [36] Algunos consejos para detectar la desinformación incluyen leer fuentes de noticias confiables a nivel local o nacional, en lugar de confiar en las redes sociales. Tenga cuidado con los titulares sensacionalistas que buscan atraer la atención y despertar emociones. Verifique la información de manera amplia, no solo en una plataforma habitual o entre amigos. Verifique la fuente original de la información. Pregunte qué se dijo realmente, quién lo dijo y cuándo. Considere posibles agendas o conflictos de intereses por parte del orador o de quienes transmiten la información. [37] [38] [39] [40] [41]

Socavando la información correcta

En ocasiones, el objetivo más importante de la desinformación es socavar la creencia en una información correcta que convencer a la gente de que adopte una nueva creencia. En el caso de las vacunas combinadas MMR, la desinformación tenía como objetivo original convencer a la gente de una afirmación fraudulenta específica y, con ello, promover las ventas de un producto competidor. [26] Sin embargo, el impacto de la desinformación se hizo mucho más amplio. El temor a que un tipo de vacuna pudiera suponer un peligro alimentó los temores generales de que las vacunas pudieran suponer un riesgo. En lugar de convencer a la gente de que eligiera un producto en lugar de otro, se erosionó la creencia en todo un ámbito de la investigación médica. [30]

Creación de incertidumbre

Existe un amplio consenso en que la desinformación está difundiendo confusión. [42] Esto no es sólo un efecto secundario; confundir y abrumar a la gente es un objetivo intencional. [43] [44] Ya sea que los ataques de desinformación se utilicen contra oponentes políticos o contra la “ciencia comercialmente inconveniente”, siembran dudas e incertidumbre como una forma de socavar el apoyo a una posición opuesta y evitar una acción efectiva. [45]

Un artículo de 2016 describe las tácticas de desinformación política impulsadas por las redes sociales como una "manguera de falsedad" que "entretiene, confunde y abruma a la audiencia". [46] Se ilustraron cuatro características con respecto a la propaganda rusa. La desinformación se utiliza de una manera que es 1) de gran volumen y multicanal 2) continua y repetitiva 3) ignora la realidad objetiva y 4) ignora la coherencia. Se vuelve efectiva al crear confusión y oscurecer, perturbar y disminuir la verdad. Cuando se expone una falsedad, "los propagandistas la descartan y pasan a una nueva explicación (aunque no necesariamente más plausible)". [46] El propósito no es convencer a la gente de una narrativa específica, sino "Negar, desviar, distraer". [47]

Contrarrestar esto es difícil, en parte porque "se necesita menos tiempo para inventar hechos que para verificarlos". [46] Hay evidencia de que las "cascadas" de información falsa viajan más lejos, más rápido y más ampliamente que la información veraz, tal vez debido a la novedad y la carga emocional. [48] Tratar de luchar contra una hidra de desinformación de muchas cabezas puede ser menos efectivo que crear conciencia sobre cómo funciona la desinformación y cómo identificarla, antes de que ocurra un ataque. [46] Por ejemplo, Ucrania pudo advertir a los ciudadanos y periodistas sobre el posible uso de deepfakes patrocinados por el estado antes de un ataque real, lo que probablemente desaceleró su propagación. [49]

Otra forma de contrarrestar la desinformación es centrarse en identificar y contrarrestar su objetivo real. [46] Por ejemplo, si la desinformación está tratando de desalentar a los votantes, hay que encontrar formas de empoderarlos y elevar la información fidedigna sobre cuándo, dónde y cómo votar. [50] Si se presentan denuncias de fraude electoral, hay que proporcionar mensajes claros sobre cómo se lleva a cabo el proceso de votación y remitir a las personas a fuentes confiables que puedan abordar sus inquietudes. [51]

Socavamiento de la confianza

La desinformación implica algo más que una simple competencia entre información inexacta y precisa. La desinformación, los rumores y las teorías conspirativas ponen en tela de juicio la confianza subyacente en múltiples niveles. El debilitamiento de la confianza puede dirigirse a los científicos, los gobiernos y los medios de comunicación y tener consecuencias muy reales. La confianza pública en la ciencia es esencial para el trabajo de los responsables de las políticas y para la buena gobernanza, en particular en cuestiones de medicina, salud pública y ciencias ambientales. Es esencial que las personas, las organizaciones y los gobiernos tengan acceso a información precisa a la hora de tomar decisiones. [13] [14]

Un ejemplo de ello es la desinformación en torno a las vacunas contra la COVID-19, que se ha dirigido contra los propios productos, los investigadores y las organizaciones que los han desarrollado, los profesionales sanitarios y las organizaciones que los administran, y los responsables de las políticas que han apoyado su desarrollo y recomendado su uso. [13] [52] [53] Los países en los que los ciudadanos tenían mayores niveles de confianza en la sociedad y el gobierno parecen haberse movilizado de forma más eficaz contra el virus, como lo demuestra la menor propagación del virus y las menores tasas de mortalidad. [54]

Los estudios sobre las creencias de la gente acerca de la cantidad de desinformación y desinformación en los medios de comunicación sugieren que la desconfianza en los medios tradicionales tiende a estar asociada con la dependencia de fuentes de información alternativas, como las redes sociales. El apoyo estructural a la libertad de prensa, una prensa independiente más fuerte y la evidencia de la credibilidad y honestidad de la prensa pueden ayudar a restablecer la confianza en los medios tradicionales como proveedores de información independiente, honesta y transparente. [55] [44]

Socavamiento de la credibilidad

Una de las principales tácticas de desinformación es atacar e intentar socavar la credibilidad de personas y organizaciones cuyas investigaciones o posición de autoridad las colocan en posición de oponerse a la narrativa de desinformación. [56] Esto puede incluir políticos, funcionarios gubernamentales, científicos, periodistas, activistas, defensores de los derechos humanos y otros. [15]

Por ejemplo, un informe del New Yorker de 2023 reveló detalles sobre la campaña llevada a cabo por los Emiratos Árabes Unidos , en virtud de la cual el presidente emiratí Mohamed bin Zayed pagó millones de euros a un empresario suizo, Mario Brero, para "relaciones públicas oscuras" contra sus objetivos. Brero y su empresa Alp Services utilizaron el dinero de los Emiratos Árabes Unidos para crear entradas condenatorias en Wikipedia y publicar artículos de propaganda contra Qatar y aquellos con vínculos con la Hermandad Musulmana . Los objetivos incluían a la empresa Lord Energy, que finalmente se declaró en quiebra tras acusaciones no probadas de vínculos con el terrorismo. [57] Los Emiratos Árabes Unidos también pagaron a Alp para que publicara 100 artículos de propaganda al año contra Qatar. [58]

Los ataques de desinformación contra los científicos y la ciencia, incluidos los ataques financiados por las industrias del tabaco y los combustibles fósiles, han sido minuciosamente documentados en libros como Merchants of Doubt , [56] [59] [60] Doubt Is Their Product , [61] [62] y The Triumph of Doubt : Dark Money and the Science of Deception (2020). [63] [64] Si bien los científicos, médicos y maestros son considerados los profesionales más confiables a nivel mundial, [14] los científicos están preocupados por si la confianza en la ciencia ha disminuido. [14] [53] Sudip Parikh, director ejecutivo de la Asociación Estadounidense para el Avance de la Ciencia (AAAS) en 2022, es citado diciendo: "Ahora tenemos una minoría significativa de la población que es hostil a la empresa científica... Vamos a tener que trabajar duro para recuperar la confianza". [53] Dicho esto, al mismo tiempo que la desinformación plantea una amenaza, el uso generalizado de las redes sociales por parte de los científicos ofrece una oportunidad sin precedentes para la comunicación científica y la participación entre los científicos y el público, con el potencial de aumentar el conocimiento público. [14] [65]

El Consejo Estadounidense de Ciencia y Salud ofrece consejos a los científicos que se enfrentan a una campaña de desinformación y señala que las campañas de desinformación suelen incorporar algunos elementos de verdad para hacerlas más convincentes. Las cinco recomendaciones incluyen identificar y reconocer cualquier parte de la historia que sea realmente cierta; explicar por qué otras partes son falsas, están fuera de contexto o manipuladas; señalar las motivaciones que pueden estar detrás de la desinformación, como intereses financieros o poder; preparar una "auditoría de acusaciones" en previsión de nuevos ataques; y mantener la calma y el autocontrol. [66] Otros recomiendan informarse sobre las plataformas que uno utiliza y las herramientas de privacidad que ofrecen para proteger la información personal y silenciar, bloquear y denunciar a los participantes en línea. Es poco probable que los desinformadores y los trolls en línea participen en una discusión razonada o interactúen de buena fe, y responderles rara vez es útil. [67]

Los estudios documentan claramente el acoso a los científicos, tanto a nivel personal como en términos de credibilidad científica. En 2021, una encuesta de Nature informó que casi el 60% de los científicos que habían hecho declaraciones públicas sobre la COVID-19 vieron atacada su credibilidad. Los ataques afectaron desproporcionadamente a quienes pertenecían a grupos de identidad no dominantes, como las mujeres, las personas transgénero y las personas de color. [67] Un ejemplo muy visible es Anthony S. Fauci . Es profundamente respetado a nivel nacional e internacional como experto en enfermedades infecciosas. También ha sido objeto de intimidación, acoso y amenazas de muerte alimentadas por ataques de desinformación y teorías conspirativas. [68] [69] [70] A pesar de esas experiencias, Fauci anima a los científicos que recién comienzan su carrera a "no dejarse intimidar, porque la satisfacción y el grado de contribución que pueden hacer a la sociedad al ingresar al servicio público y la salud pública es inconmensurable". [71]

Socavamiento de la acción colectiva, incluida la votación

Las decisiones individuales, como la de fumar o no, son blancos importantes de la desinformación. También lo son los procesos de formulación de políticas, como la formulación de políticas de salud pública, la recomendación y adopción de medidas políticas y la aceptación o regulación de procesos y productos. La opinión pública y las políticas interactúan: la opinión pública y la popularidad de las medidas de salud pública pueden influir fuertemente en las políticas gubernamentales y en la creación y aplicación de estándares industriales. La desinformación intenta socavar la opinión pública e impedir la organización de acciones de recolección de información, incluidos los debates sobre políticas, la acción gubernamental, la regulación y los litigios. [45]

Un tipo importante de actividad colectiva es el acto de votar. En las elecciones generales de Kenia de 2017 , el 87% de los kenianos encuestados informaron haber encontrado desinformación antes de las elecciones de agosto, y el 35% informó no haber podido tomar una decisión de voto informada como resultado. [7] Las campañas de desinformación a menudo se dirigen a grupos específicos, como los votantes negros o latinos, para desalentar la votación y el compromiso cívico . Se utilizan cuentas falsas y bots para amplificar la incertidumbre sobre si votar realmente importa, si los votantes son "apreciados" y qué intereses les importan a los políticos. [72] [73] La microsegmentación puede presentar mensajes diseñados con precisión para una población elegida, mientras que la geofencing puede localizar a las personas en función de dónde van, como los feligreses. En algunos casos, los ataques de supresión de votantes han hecho circular información incorrecta sobre dónde y cuándo votar. [74] Durante las primarias demócratas estadounidenses de 2020, surgieron narrativas de desinformación en torno al uso de mascarillas y el uso de papeletas de voto por correo, relacionadas con si la gente votaría y cómo lo haría. [75]

Debilitamiento del gobierno funcional

La desinformación ataca los cimientos del gobierno democrático: “la idea de que la verdad es cognoscible y que los ciudadanos pueden discernirla y utilizarla para gobernarse a sí mismos”. [76] Las campañas de desinformación son diseñadas por actores tanto extranjeros como nacionales para obtener ventajas políticas y económicas. El debilitamiento del gobierno funcional debilita el Estado de derecho y puede permitir que actores tanto extranjeros como nacionales obtengan beneficios políticos y económicos. En el país y en el extranjero, el objetivo es debilitar a los oponentes. Las elecciones son un objetivo especialmente crítico, pero también se socava la capacidad cotidiana de gobernar. [76] [77]

El Oxford Internet Institute de la Universidad de Oxford informa que en 2020, las campañas organizadas de manipulación de las redes sociales estuvieron activas en 81 países, un aumento respecto de los 70 países de 2019. 76 de esos países utilizaron ataques de desinformación. El informe describe la desinformación como algo que se produce globalmente "a escala industrial". [78]

Una operación rusa conocida como la Agencia de Investigación de Internet (IRA) gastó miles de dólares en anuncios en las redes sociales para influir en las elecciones presidenciales de Estados Unidos de 2016 , confundir al público sobre cuestiones políticas clave y sembrar discordia. Estos anuncios políticos aprovecharon los datos de los usuarios para microsegmentar ciertas poblaciones y difundir información engañosa, con el objetivo final de exacerbar la polarización y erosionar la confianza pública en las instituciones políticas. [9] [79] [19] El Proyecto de Propaganda Computacional de la Universidad de Oxford descubrió que los anuncios de la IRA buscaban específicamente sembrar desconfianza hacia el gobierno de Estados Unidos entre los mexicano-estadounidenses y desalentar la participación electoral entre los afroamericanos . [80]

Un análisis de la actividad en Twitter antes de las elecciones presidenciales francesas de 2017 indica que el 73% de la desinformación detectada por Le Monde se podía rastrear hasta dos comunidades políticas: una asociada con François Fillon (de derecha, con el 50,75% de los enlaces falsos compartidos) y otra con Marine Le Pen (de extrema derecha, 22,21%). El 6% de las cuentas de la comunidad de Fillon y el 5% de la comunidad de Le Pen fueron los primeros en difundir la desinformación. La desinformación se desmintió desde otras comunidades y, con mayor frecuencia, estaba relacionada con Emmanuel Macron (39,18% de los desmentidos) y Jean-Luc Mélenchon (14% de los desmentidos). [81]

Otro análisis de la campaña de desinformación #MacronLeaks de 2017 ilustra patrones frecuentes de campañas de desinformación relacionadas con las elecciones. Estas campañas suelen alcanzar su punto máximo uno o dos días antes de una elección. La escala de una campaña como #MacronLeaks puede ser comparable al volumen de discusión regular en ese período de tiempo, lo que sugiere que puede obtener una atención colectiva considerable. Alrededor del 18 por ciento de los usuarios involucrados en #MacronLeaks fueron identificables como bots. Los picos en el contenido de bots tendieron a ocurrir ligeramente antes de los picos de contenido creado por humanos, lo que sugiere que los bots pudieron desencadenar cascadas de desinformación. Algunas cuentas de bots mostraron un patrón de uso previo: creación poco antes de la elección presidencial estadounidense de 2016, uso breve entonces y ninguna actividad posterior hasta principios de mayo de 2017, antes de la elección francesa. Personalidades de los medios de comunicación de extrema derecha, como el británico Paul Joseph Watson y el estadounidense Jack Posobiec, compartieron de manera destacada contenido de MacronLeaks antes de la elección francesa. [82] Los expertos temen que los ataques de desinformación se utilicen cada vez más para influir en las elecciones nacionales y los procesos democráticos. [9]

| Videos externos | |

|---|---|

"La psicología y la política de las teorías de la conspiración", Knowable Magazine , 27 de octubre de 2021. "La psicología y la política de las teorías de la conspiración", Knowable Magazine , 27 de octubre de 2021. |

En A Lot of People Are Saying: The New Conspiracism and the Assault on Democracy (2020), Nancy L. Rosenblum y Russell Muirhead examinan la historia y la psicología de las teorías de la conspiración y las formas en que se utilizan para deslegitimar el sistema político. Distinguen entre la teoría de la conspiración clásica, en la que se examinan cuestiones y acontecimientos reales (como el asesinato de John F. Kennedy ) y se combinan para crear una teoría, y una nueva forma de "conspiracionismo sin teoría" que se basa en la repetición de declaraciones falsas y rumores sin fundamento fáctico. [83] [84]

Este tipo de desinformación explota el sesgo humano hacia la aceptación de nueva información. Los seres humanos comparten información constantemente y confían en que otros les proporcionen información que no pueden verificar por sí mismos. Gran parte de esa información será verdadera, ya sea que pregunten si hace frío afuera o frío en la Antártida. Como resultado, tienden a creer lo que escuchan. Los estudios muestran un " efecto de verdad ilusoria ": cuanto más a menudo las personas escuchan una afirmación, más probabilidades hay de que la consideren verdadera. Este es el caso incluso cuando las personas identifican una afirmación como falsa la primera vez que la ven; es probable que clasifiquen la probabilidad de que sea verdadera más alta después de múltiples exposiciones. [84] [85] Las redes sociales son particularmente peligrosas como fuente de desinformación porque se utilizan robots y múltiples cuentas falsas para repetir y magnificar el impacto de las declaraciones falsas. Los algoritmos rastrean en qué hacen clic los usuarios y recomiendan contenido similar al que los usuarios han elegido, creando sesgo de confirmación y burbujas de filtro . En comunidades más centradas, se potencia un efecto de cámara de eco . [86] [87] [84] [88] [89] [19]

Los autócratas han empleado ataques de desinformación a los votantes locales para encubrir la corrupción electoral . La desinformación a los votantes puede incluir declaraciones públicas que afirman que los procesos electorales locales son legítimos y declaraciones que desacreditan a los observadores electorales. Se pueden contratar empresas de relaciones públicas para ejecutar campañas de desinformación especializadas, incluidos anuncios en los medios y cabildeo tras bastidores , para impulsar la narrativa de una elección honesta y democrática. [90] El monitoreo independiente del proceso electoral es esencial para combatir la desinformación electoral. El monitoreo puede incluir tanto observadores electorales ciudadanos como observadores internacionales, siempre que sean creíbles. Las normas para la caracterización precisa de las elecciones se basan en principios éticos, metodologías efectivas y análisis imparcial. Las normas democráticas enfatizan la importancia de los datos electorales abiertos, el libre ejercicio de los derechos políticos y la protección de los derechos humanos. [90]

Aumento de la polarización y legitimación de la violencia

Los ataques de desinformación pueden aumentar la polarización política y alterar el discurso público. [89] Las campañas de manipulación extranjeras pueden intentar amplificar posiciones extremas y debilitar a una sociedad objetivo, mientras que los actores nacionales pueden intentar demonizar a los oponentes políticos. [76] Los Estados con paisajes políticos altamente polarizados y baja confianza pública en los medios y el gobierno locales son particularmente vulnerables a los ataques de desinformación. [91] [92]

Existe la preocupación de que Rusia emplee la desinformación, la propaganda y la intimidación para desestabilizar a los miembros de la OTAN , como los estados bálticos , y obligarlos a aceptar las narrativas y agendas rusas. [80] [91] Durante la guerra ruso-ucraniana de 2014, Rusia combinó la guerra de combate tradicional con ataques de desinformación en una forma de guerra híbrida en su estrategia ofensiva, para sembrar dudas y confusión entre las poblaciones enemigas e intimidar a los adversarios, erosionar la confianza pública en las instituciones ucranianas y aumentar la reputación y la legitimidad de Rusia. [93] Desde que se intensificó la guerra ruso-ucraniana con la invasión rusa de Ucrania en 2022 , CBC News ha descrito el patrón de desinformación de Rusia como "Negar, desviar, distraer". [47]

Miles de historias han sido desacreditadas, incluyendo fotografías manipuladas y deepfakes. Al menos 20 "temas" principales están siendo promovidos por la propaganda rusa, apuntando a audiencias mucho más allá de Ucrania y Rusia. Muchos de ellos intentan reforzar las ideas de que Ucrania está de alguna manera controlada por los nazis, que sus fuerzas militares son débiles y que los daños y las atrocidades se deben a acciones ucranianas, no rusas. [47] Muchas de las imágenes que examinan se comparten en Telegraph . Las organizaciones gubernamentales y los grupos periodísticos independientes como Bellingcat trabajan para confirmar o negar tales informes, a menudo utilizando datos de fuente abierta y herramientas sofisticadas para identificar dónde y cuándo se ha originado la información y si las afirmaciones son legítimas. Bellingcat trabaja para proporcionar un relato preciso de los eventos a medida que ocurren y para crear un registro permanente, verificado y de largo plazo. [94]

El alarmismo y las teorías conspirativas se utilizan para fomentar la polarización, promover narrativas excluyentes y legitimar el discurso de odio y la agresión. [52] [87] Como se ha documentado minuciosamente, el período previo al Holocausto estuvo marcado por la desinformación repetida y la creciente persecución por parte del gobierno nazi , [95] [96] que culminó en el asesinato en masa [97] de 165.200 judíos alemanes [98] por un "estado genocida". [97] Hoy en día se considera que las poblaciones de África, Asia, Europa y Sudamérica corren un grave riesgo de sufrir abusos de los derechos humanos. [7] Las condiciones cambiantes en los Estados Unidos también se han identificado como factores de riesgo crecientes para la violencia. [92]

Las elecciones son momentos de transición política particularmente tensos, cargados de emociones en cualquier momento y cada vez más atacados por la desinformación. Estas condiciones aumentan el riesgo de violencia individual, disturbios civiles y atrocidades masivas. Se considera que los países como Kenia , cuya historia ha implicado violencia étnica o relacionada con las elecciones, interferencia extranjera o nacional y una gran dependencia del uso de las redes sociales para el discurso político, corren un mayor riesgo. El Marco de Análisis de los Crímenes Atroces de las Naciones Unidas identifica las elecciones como un indicador de riesgo de atrocidad: la desinformación puede actuar como un multiplicador de amenazas para los crímenes atroces . El reconocimiento de la gravedad de este problema es esencial para movilizar a los gobiernos, la sociedad civil y las plataformas de redes sociales para que tomen medidas para prevenir daños tanto en línea como fuera de línea. [7]

Canales de desinformación

Investigación científica

Los ataques de desinformación apuntan a la credibilidad de la ciencia, particularmente en áreas de salud pública [24] y ciencia ambiental . [99] [14] Algunos ejemplos incluyen negar los peligros de la gasolina con plomo , [100] [101] fumar , [102] [103] [104] y el cambio climático . [59] [105] [20] [106]

Un patrón para los ataques de desinformación que involucran fuentes científicas desarrollado en la década de 1920. Ilustra tácticas que se siguen utilizando. [107] Ya en 1910, la toxicóloga industrial Alice Hamilton documentó los peligros asociados con la exposición al plomo . [108] [109] En la década de 1920, Charles Kettering , Thomas Midgley Jr. y Robert A. Kehoe de la Ethyl Gasoline Corporation introdujeron plomo en la gasolina. Después de la locura sensacional y las muertes de trabajadores en sus plantas, se celebró una conferencia del Servicio de Salud Pública en 1925, para revisar el uso de tetraetilo de plomo (TEL). Hamilton y otros advirtieron sobre el peligro potencial de la gasolina con plomo para las personas y el medio ambiente. Cuestionaron la metodología de investigación utilizada por Kehoe, quien afirmó que el plomo era una parte "natural" del medio ambiente y que los altos niveles de plomo en los trabajadores eran "normales". [110] [111] [100] Kettering, Midgley y Kehoe enfatizaron que se necesitaba un aditivo para la gasolina y argumentaron que hasta que "se demuestre... que se ha producido un peligro real para el público como resultado", [108] se debería permitir a la compañía producir su producto. En lugar de exigir a la industria que demostrara que su producto era seguro antes de poder venderlo, la carga de la prueba recayó en los defensores de la salud pública para que mostraran pruebas irrefutables de que se había producido un daño. [108] [112] Los críticos de TEL fueron descritos como "histéricos". [113] Con el apoyo de la industria, Kehoe se convirtió en un destacado experto de la industria y defensor de la posición de que la gasolina con plomo era segura, manteniendo "un monopolio casi completo" en la investigación en el área. [114] Pasarían décadas antes de que su trabajo fuera finalmente desacreditado. [100] En 1988, la EPA estimó que durante los 60 años anteriores, 68 millones de niños sufrieron una alta exposición tóxica al plomo de los combustibles con plomo. [115]

En la década de 1950, la producción y el uso de investigaciones "científicas" tendenciosas formaban parte de un "manual de desinformación" coherente, utilizado por empresas de las industrias del tabaco [116] , los pesticidas [117] y los combustibles fósiles. [59] [105] [118] En muchos casos, los mismos investigadores, grupos de investigación y empresas de relaciones públicas fueron contratados por múltiples industrias. Argumentaron repetidamente que los productos eran seguros a pesar de saber que no lo eran. Cuando se cuestionaban las afirmaciones de seguridad, se argumentaba que los productos eran necesarios. [104] A través de campañas coordinadas y generalizadas, trabajaron para influir en la opinión pública y manipular a los funcionarios gubernamentales y las agencias reguladoras, para evitar acciones regulatorias o legales que pudieran interferir con las ganancias. [45]

Las campañas de desinformación científica siguen utilizando tácticas similares. Cuando se presentan pruebas de que se ha producido un daño, se argumenta que no son suficientes. El argumento de que se necesitan más pruebas se utiliza para posponer la acción hasta un momento futuro. Las demoras se utilizan para bloquear los intentos de limitar o regular la industria y evitar litigios, mientras se siguen obteniendo beneficios. Los expertos financiados por la industria llevan a cabo investigaciones que, con demasiada frecuencia, pueden ser cuestionadas por motivos metodológicos y por conflictos de intereses. Los desinformadores utilizan investigaciones deficientes como base para afirmar que los científicos no están de acuerdo y para generar afirmaciones específicas como parte de una narrativa de desinformación. A menudo se ataca a los oponentes a nivel personal y en relación con su trabajo científico. [119] [45] [120]

Un memorando de la industria tabacalera resumió este enfoque diciendo "La duda es nuestro producto". [119] Los científicos generalmente consideran una pregunta en términos de la probabilidad de que una conclusión esté respaldada, dado el peso de la mejor evidencia científica disponible. La evidencia tiende a implicar medición, y la medición introduce un potencial de error. Un científico puede decir que la evidencia disponible es suficiente para respaldar una conclusión sobre un problema, pero rara vez afirmará que un problema se entiende completamente o que una conclusión es 100% cierta. La retórica de la desinformación intenta socavar la ciencia e influir en la opinión pública utilizando una "estrategia de la duda". Reformulando el proceso científico normal, la desinformación a menudo sugiere que cualquier cosa menos del 100% de certeza implica duda, y que la duda significa que no hay consenso sobre un tema. La desinformación intenta socavar tanto la certeza sobre un tema en particular como sobre la ciencia misma. [119] [45] Décadas de ataques de desinformación han erosionado considerablemente la creencia pública en la ciencia. [45]

La información científica puede distorsionarse a medida que se transfiere entre fuentes científicas primarias, la prensa popular y las redes sociales. Esto puede ocurrir tanto de manera intencional como no intencional. Algunas características de la publicación académica actual, como el uso de servidores de preimpresión, facilitan que la información inexacta se haga pública, en particular si la información divulgada es novedosa o sensacionalista. [37]

Las medidas para proteger la ciencia de la desinformación y la interferencia incluyen tanto acciones individuales por parte de científicos, revisores pares y editores, como acciones colectivas a través de organizaciones de investigación, subvenciones y profesionales, y agencias reguladoras. [45] [121] [122]

Medios de comunicación tradicionales

Los canales de comunicación tradicionales pueden utilizarse para difundir desinformación. Por ejemplo, Russia Today es un canal de noticias financiado por el Estado que se transmite a nivel internacional. Su objetivo es mejorar la reputación de Rusia en el extranjero y también presentar a las naciones occidentales , como Estados Unidos, bajo una luz negativa. Ha servido como plataforma para difundir propaganda y teorías conspirativas destinadas a engañar y desinformar a su audiencia. [6]

En Estados Unidos, el intercambio de desinformación y propaganda se ha asociado con el desarrollo de medios cada vez más "partidistas", más fuertemente en fuentes de derecha como Breitbart , The Daily Caller y Fox News . [123] A medida que los medios de comunicación locales han disminuido, ha habido un aumento de medios de comunicación partidistas que "se hacen pasar" por fuentes de noticias locales. [124] [125] El impacto del partidismo y su amplificación a través de los medios está documentado. Por ejemplo, las actitudes hacia la legislación climática eran bipartidistas en la década de 1990, pero se polarizaron intensamente en 2010. Mientras que los mensajes de los medios sobre el clima de los demócratas aumentaron entre 1990 y 2015 y tendieron a apoyar el consenso científico sobre el cambio climático, los mensajes republicanos sobre el clima disminuyeron y se volvieron más mixtos. [20]

Una "creencia de entrada" que afecta la aceptación de las posiciones y políticas científicas por parte de las personas es su comprensión del grado de acuerdo científico sobre un tema. Por lo tanto, socavar el consenso científico es una táctica de desinformación frecuente. Indicar que existe un consenso científico (y explicar la ciencia involucrada) puede ayudar a contrarrestar la desinformación. [20] Indicar el amplio consenso de los expertos puede ayudar a alinear las percepciones y entendimientos de las personas con la evidencia empírica. [126] Presentar mensajes de una manera que se alinee con el marco de referencia cultural de alguien hace que sea más probable que sean aceptados. [20]

Es importante evitar el falso equilibrio , en el que las afirmaciones opuestas se presentan de una manera que no guarda proporción con la evidencia real de cada lado. Una forma de contrarrestar el falso equilibrio es presentar una declaración de peso de la evidencia que indique explícitamente el peso de la evidencia para las diferentes posiciones. [126] [127]

Redes sociales

Los perpetradores utilizan principalmente los canales de las redes sociales como medio para difundir desinformación, utilizando una variedad de herramientas. [128] Los investigadores han recopilado múltiples acciones a través de las cuales se producen ataques de desinformación en las redes sociales, que se resumen en la siguiente tabla. [2] [129] [130]

| Modos de ataque de desinformación en las redes sociales. [2] [129] [130] | |

|---|---|

| Término | Descripción |

| Algoritmos | Los algoritmos se utilizan para amplificar la difusión de la desinformación. Los algoritmos filtran y adaptan la información a los usuarios y modifican el contenido que consumen. [131] Un estudio concluyó que los algoritmos pueden ser canales de radicalización porque presentan el contenido en función de sus niveles de participación del usuario. Los usuarios se sienten más atraídos por el contenido radical, impactante y de clickbait . [132] Como resultado, las publicaciones extremistas que llaman la atención pueden generar altos niveles de participación a través de algoritmos. Las campañas de desinformación pueden aprovechar los algoritmos para amplificar su contenido extremista y sembrar la radicalización en línea. [133] |

| Césped artificial | Campaña coordinada centralmente que imita el activismo de base haciendo que los participantes se hagan pasar por ciudadanos comunes. El astroturfing consiste en publicar cantidades abrumadoras de contenido que promueve mensajes similares desde múltiples cuentas falsas. Esto da la impresión de un consenso generalizado en torno a un mensaje, simulando una respuesta de base mientras se oculta su origen. El flooding es el spam de las redes sociales con mensajes para dar forma a una narrativa o acallar la oposición. La exposición repetida a un mensaje tiene más probabilidades de establecerlo en la mente de alguien. Los actores de la desinformación a menudo adaptan los mensajes a una audiencia en particular, para interactuar con las personas y generar credibilidad con ellas, antes de exponerlas a puntos de vista más extremos o engañosos. [134] [135] [136] |

| Bots | Los bots son agentes automatizados que pueden producir y difundir contenido en plataformas sociales en línea. Muchos bots pueden participar en interacciones básicas con otros bots y humanos. En las campañas de ataques de desinformación, se los aprovecha para difundir rápidamente desinformación y violar las redes sociales digitales. Los bots pueden producir la ilusión de que una pieza de información proviene de una variedad de fuentes diferentes. Al hacerlo, las campañas de ataques de desinformación hacen que su contenido parezca creíble a través de una exposición repetida y variada. [137] Al inundar los canales de redes sociales con contenido repetido, los bots también pueden alterar los algoritmos y desviar la atención en línea hacia el contenido de desinformación. [17] |

| cebo de clic | El uso deliberado de titulares y miniaturas engañosos para aumentar el tráfico en línea con fines de lucro o popularidad. |

| Teorías de conspiración | Refutaciones de relatos oficiales que proponen explicaciones alternativas en las que individuos o grupos actúan en secreto |

| Guerras culturales | Un fenómeno en el que múltiples grupos de personas, que tienen valores arraigados, intentan dirigir las políticas públicas de manera polémica. |

| Falsificaciones profundas | Un deepfake es un contenido digital (audio y video) que ha sido manipulado. La tecnología deepfake puede utilizarse para difamar, chantajear y suplantar identidades. Debido a sus bajos costos y eficiencia, los deepfakes pueden utilizarse para difundir desinformación con mayor rapidez y en mayor volumen que los humanos. Las campañas de ataques de desinformación pueden aprovechar la tecnología deepfake para generar desinformación sobre personas, estados o narrativas. La tecnología deepfake puede utilizarse como arma para engañar a una audiencia y difundir falsedades. [138] |

| Cámaras de eco | Un entorno epistémico en el que los participantes encuentran creencias y opiniones que coinciden con las suyas. |

| Broma | Noticias en las que se presentan hechos falsos como legítimos |

| Noticias falsas | La creación deliberada de pseudoperiodismo y la instrumentalización del término para deslegitimar a los medios de comunicación |

| Personas | Se pueden crear personas y sitios web con la intención de presentar y difundir información incorrecta de una manera que parezca creíble. Un sitio web falso puede presentarse como perteneciente a una organización profesional o educativa. Una persona puede dar a entender que tiene credenciales o experiencia. Los actores de la desinformación pueden crear redes enteras de supuestas "autoridades" interconectadas. [134] El hecho de que asumamos que alguien es veraz y de que optemos por verificar lo que vemos son predictores de la susceptibilidad a la desinformación. [16] Considere cuidadosamente las fuentes y las afirmaciones de autoridad; verifique la información con una amplia gama de fuentes. |

| Propaganda | Comunicación masiva organizada, con una agenda oculta y con la misión de conformar creencias y acciones eludiendo el razonamiento individual. |

| Pseudociencia | Los relatos que reivindican el poder explicativo de la ciencia toman prestado su lenguaje y su legitimidad pero se apartan sustancialmente de sus criterios de calidad. |

| Rumores | Noticias sin fundamento que circulan sin corroborarlas ni validarlas |

| Troleo | Grupos en red de personas influyentes digitales que operan "ejércitos de clic" diseñados para movilizar el sentimiento público |

Una aplicación llamada “Dawn of Glad Tidings”, desarrollada por miembros del Estado Islámico , ayuda a la organización a difundir rápidamente desinformación en los canales de las redes sociales. Cuando un usuario descarga la aplicación, se le pide que la vincule con su cuenta de Twitter y le permita a la aplicación tuitear desde su cuenta personal. Esta aplicación permite enviar tuits automáticos desde cuentas de usuarios reales y ayuda a crear tendencias en Twitter que amplifican la desinformación producida por el Estado Islámico a nivel internacional. [80]

En muchos casos, se paga a personas y empresas de distintos países para que creen contenido falso y difundan desinformación, y a veces obtienen ingresos por ello tanto en dinero como por publicidad. [128] [2] Los "actores de desinformación a sueldo" suelen promover múltiples cuestiones, o incluso múltiples bandos en una misma cuestión, únicamente para obtener beneficios materiales. [139] Otros tienen motivaciones políticas o psicológicas. [140] [2]

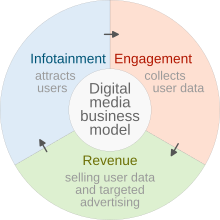

En términos más generales, las redes sociales pueden examinarse en términos de sus prácticas de mercado y las formas en que sus estructuras y prácticas " monetizan " la participación de los espectadores. Los medios de comunicación (1) proporcionan contenido al público a un costo mínimo o nulo, (2) captan y reorientan la atención del público y (3) recopilan, utilizan y revenden datos de los usuarios. Las empresas de publicidad, los editores, los influencers, las marcas y los clientes pueden beneficiarse de la desinformación de diversas maneras. [2]

En 2022, el Journal of Communication publicó un estudio sobre la economía política subyacente a la desinformación en torno a las vacunas. Los investigadores identificaron 59 "actores" de habla inglesa que proporcionaban "publicaciones casi exclusivamente contra la vacunación". Sus sitios web monetizaban la desinformación mediante peticiones de donaciones, ventas de medios basados en contenidos y otros productos, publicidad de terceros y cuotas de afiliación. Algunos mantenían un grupo de sitios web vinculados, atrayendo visitantes con un sitio y pidiendo dinero y vendiendo productos en otros. En la forma en que ganaron atención y obtuvieron financiación, sus actividades mostraron una "estrategia de monetización híbrida". Atrajeron la atención combinando aspectos llamativos de "noticias basura" y promoción de celebridades en línea. Al mismo tiempo, desarrollaron comunidades específicas de campaña para publicitar y legitimar su posición, de manera similar a los movimientos sociales radicales. [140]

Ingeniería social

Las emociones se utilizan y manipulan para difundir desinformación y creencias falsas. [19] Despertar emociones puede ser persuasivo. Cuando las personas sienten algo con fuerza, es más probable que lo consideren cierto. [85] La emoción también puede hacer que las personas piensen con menos claridad sobre lo que están leyendo y sobre la credibilidad de su fuente. El contenido que apela a las emociones tiene más probabilidades de difundirse rápidamente en Internet. El miedo, la confusión y la distracción pueden interferir en la capacidad de las personas para pensar de manera crítica y tomar buenas decisiones. [141]

La psicología humana se aprovecha para hacer que los ataques de desinformación sean más potentes y virales. [19] Los fenómenos psicológicos, como los estereotipos, el sesgo de confirmación , la atención selectiva y las cámaras de eco , contribuyen a la viralidad y el éxito de la desinformación en las plataformas digitales. [137] [142] [5] Los ataques de desinformación a menudo se consideran un tipo de guerra psicológica debido a su uso de técnicas psicológicas para manipular a las poblaciones. [143] [25]

Las percepciones de identidad y el sentido de pertenencia se manipulan para influir en las personas. [19] Los sentimientos de pertenencia social se refuerzan para fomentar la afiliación a un grupo y desalentar la disidencia. Esto puede hacer que las personas sean más susceptibles a un "influenciador" o líder que puede alentar a sus " seguidores comprometidos " a atacar a otros. El tipo de comportamiento se ha comparado con el comportamiento colectivo de las turbas y es similar a la dinámica dentro de las sectas . [67] [144] [145]

Medidas de defensa

Como ha señalado el Knight First Amendment Institute de la Universidad de Columbia, "el problema de la desinformación es social y no sólo tecnológico o legal". [146] Plantea graves cuestiones éticas sobre cómo nos relacionamos unos con otros. [147] La Cumbre de 2023 sobre "Verdad, Confianza y Esperanza", celebrada por el Comité del Premio Nobel y la Academia Nacional de Ciencias, identificó la desinformación como más peligrosa que cualquier otra crisis, debido a la forma en que obstaculiza el abordaje y la resolución de todos los demás problemas. [148]

Las medidas defensivas contra la desinformación pueden darse en una amplia variedad de niveles, en sociedades diversas, bajo diferentes leyes y condiciones. Las respuestas a la desinformación pueden involucrar instituciones, individuos y tecnologías, incluyendo la regulación gubernamental, la autorregulación, el monitoreo por parte de terceros, las acciones de actores privados, la influencia de las multitudes y los cambios tecnológicos en la arquitectura de las plataformas y los comportamientos algorítmicos. [149] [150] Es importante desarrollar y compartir las mejores prácticas para contrarrestar la desinformación y generar resiliencia contra ella. [76]

Las directrices sociales, jurídicas y reglamentarias existentes pueden no ser fácilmente aplicables a las acciones en un mundo virtual internacional, donde las corporaciones privadas compiten por la rentabilidad, a menudo sobre la base de la participación de los usuarios. [149] [2] Las preocupaciones éticas se aplican a algunas de las posibles respuestas a la desinformación, ya que las personas debaten cuestiones de moderación de contenidos, libertad de expresión, derecho a la privacidad personal, identidad humana, dignidad humana, supresión de los derechos humanos y la libertad religiosa, y el uso de datos. [147] El alcance del problema significa que "crear resiliencia y contrarrestar las campañas de información manipuladoras es un esfuerzo de toda la sociedad". [76]

Leyes nacionales e internacionales

Si bien los regímenes autoritarios han optado por utilizar los ataques de desinformación como herramienta política, su uso plantea peligros específicos para los gobiernos democráticos: el uso de tácticas equivalentes profundizará aún más la desconfianza pública en los procesos políticos y socavará la base de un gobierno democrático y legítimo. “Las democracias no deberían tratar de influir de manera encubierta en el debate público, ya sea difundiendo deliberadamente información falsa o engañosa o participando en prácticas engañosas, como el uso de personajes ficticios en línea”. [151] Además, se alienta a las democracias a aprovechar sus puntos fuertes, incluido el estado de derecho, el respeto por los derechos humanos, la cooperación con socios y aliados, el poder blando y la capacidad técnica para enfrentar las amenazas cibernéticas. [151]

Las normas constitucionales que gobiernan una sociedad son necesarias tanto para que la gobernanza sea eficaz como para evitar la tiranía . [146] Proporcionar información precisa y contrarrestar la desinformación son actividades legítimas del gobierno. La OCDE sugiere que la comunicación pública de las respuestas políticas debe seguir los principios de gobierno abierto de integridad, transparencia, rendición de cuentas y participación ciudadana. [152] Un análisis de la capacidad del gobierno de los EE. UU. para responder legalmente a la desinformación sostiene que las respuestas deben basarse en principios de transparencia y generalidad. Las respuestas deben evitar los ataques ad hominem , los llamamientos raciales o la selectividad en la persona a la que se responde. La crítica debe centrarse primero en proporcionar información correcta y, en segundo lugar, en explicar por qué la información falsa es incorrecta, en lugar de centrarse en el orador o repetir la narrativa falsa. [146] [141] [153]

En el caso de la pandemia de COVID-19 , múltiples factores crearon "espacio para que prolifere la desinformación". Las respuestas de los gobiernos a este problema de salud pública indican varias áreas de debilidad, incluidas lagunas en el conocimiento básico de salud pública, falta de coordinación en la comunicación gubernamental y confusión sobre cómo abordar una situación que implica una incertidumbre significativa. Las lecciones de la pandemia incluyen la necesidad de admitir la incertidumbre cuando existe y distinguir claramente entre lo que se sabe y lo que aún no se sabe. La ciencia es un proceso y es importante reconocer y comunicar que la comprensión científica y el asesoramiento relacionado cambiarán con el tiempo sobre la base de nueva evidencia. [152]

La regulación de la desinformación plantea cuestiones éticas. El derecho a la libertad de expresión está reconocido como un derecho humano en la Declaración Universal de Derechos Humanos y en el derecho internacional de los derechos humanos de las Naciones Unidas . Muchos países tienen leyes constitucionales que protegen la libertad de expresión. Las leyes de un país pueden identificar categorías específicas de expresión que están o no protegidas, y partes específicas cuyas acciones están restringidas. [149]

Estados Unidos

La Primera Enmienda de la Constitución de los Estados Unidos protege tanto la libertad de expresión como la libertad de prensa de la interferencia del Congreso de los Estados Unidos . Como resultado, la regulación de la desinformación en los Estados Unidos tiende a dejarse en manos de la acción privada en lugar de la acción gubernamental. [149]

La Primera Enmienda no protege el discurso utilizado para incitar a la violencia o quebrantar la ley, [154] ni la “obscenidad, la pornografía infantil, el discurso difamatorio, la publicidad falsa, las amenazas verdaderas y las palabras belicosas”. [155] Con estas excepciones, se espera que debatir asuntos de “interés público o general” de una manera “desinhibida, sólida y abierta” beneficie a una sociedad democrática. [156]

La Primera Enmienda tiende a basarse en el contradiscurso como una medida correctiva viable, prefiriendo la refutación de la falsedad a la regulación. [149] [146] Existe una suposición subyacente de que las partes identificables tendrán la oportunidad de compartir sus puntos de vista en un campo de juego relativamente nivelado, donde una figura pública que se vea arrastrada a un debate tendrá un mayor acceso a los medios y una oportunidad de refutación. [156] Esto puede no ser cierto ya cuando se lanzan ataques de desinformación rápidos y masivos contra un individuo o grupo a través de terceros anónimos o múltiples, donde "Un retraso de medio día es toda una vida para una mentira en línea". [146]

Otras leyes civiles y penales tienen por objeto proteger a las personas y organizaciones en los casos en que el discurso implica difamación del carácter ( libelo o calumnia ) o fraude . En tales casos, ser incorrecto no es suficiente para justificar una acción legal o gubernamental. La información incorrecta debe causar daño demostrable a otros o permitir que el mentiroso obtenga un beneficio injustificado. Alguien que haya difundido desinformación a sabiendas y haya utilizado esa desinformación para ganar dinero puede ser acusado de fraude. [157] No está claro en qué medida estas leyes existentes se pueden aplicar de manera efectiva contra los ataques de desinformación. [149] [146] [158] Según este enfoque, un subconjunto de la desinformación, que no solo es falsa sino que "se comunica con el propósito de obtener ganancias o ventajas mediante el engaño y causa daño como resultado" podría considerarse "fraude al público", [31] y ya no se considera un tipo de discurso protegido. Gran parte del discurso que constituye desinformación no pasaría esta prueba. [31]

unión Europea

La Ley de Servicios Digitales (DSA) es un Reglamento en la legislación de la UE que establece un marco legal dentro de la Unión Europea para la gestión de contenido en intermediarios, incluido el contenido ilegal, la publicidad transparente y la desinformación. [159] [160] El Parlamento Europeo aprobó la DSA junto con la Ley de Mercados Digitales el 5 de julio de 2022. [161] El Consejo Europeo dio su aprobación final al Reglamento sobre una Ley de Servicios Digitales el 4 de octubre de 2022. [162] Se publicó en el Diario Oficial de la Unión Europea el 19 de octubre de 2022. Los proveedores de servicios afectados tendrán hasta el 1 de enero de 2024 para cumplir con sus disposiciones. [161] La DSA tiene como objetivo armonizar las diferentes leyes a nivel nacional en la Unión Europea [159] incluyendo Alemania ( NetzDG ), Austria ("Kommunikationsplattformen-Gesetz") y Francia (" Loi Avia "). [163] Las plataformas con más de 45 millones de usuarios en la Unión Europea , entre ellas Facebook , YouTube , Twitter y TikTok, estarían sujetas a las nuevas obligaciones. Las empresas que no cumplan con esas obligaciones podrían arriesgarse a recibir multas de hasta el 10% de su facturación anual. [164]

A partir del 25 de abril de 2023, Wikipedia fue una de las 17 plataformas designadas como Plataforma en línea muy grande (VLOP) por la Comisión Europea, con regulaciones que entraron en vigor a partir del 25 de agosto de 2023. [165] Además de las medidas adoptadas por la Fundación Wikimedia, el cumplimiento de Wikipedia con la Ley de Servicios Digitales será auditado de forma independiente, anualmente, a partir de 2024. [166]

Rusia y China

Se ha sugerido que China y Rusia están presentando conjuntamente a Estados Unidos y la Unión Europea de una manera adversa en términos del uso de la información y la tecnología. Esta narrativa es luego utilizada por China y Rusia para justificar la restricción de la libertad de expresión, el acceso a los medios independientes y las libertades en Internet. Han pedido conjuntamente la "internacionalización de la gobernanza de Internet", es decir, la distribución del control de Internet a estados soberanos individuales. En contraste, los llamados a la gobernanza global de Internet enfatizan la existencia de una Internet libre y abierta, cuya gobernanza involucra a los ciudadanos y a la sociedad civil. [167] [76] Los gobiernos democráticos deben ser conscientes del impacto potencial de las medidas utilizadas para restringir la desinformación tanto en el país como en el extranjero. Este no es un argumento que deba bloquear la legislación, pero debe tomarse en consideración al momento de formularla. [76]

Regulación privada

En los Estados Unidos, la Primera Enmienda limita las acciones del Congreso, no las de los particulares, las empresas y los empleadores. [154] Las entidades privadas pueden establecer sus propias reglas (sujetas a las leyes locales e internacionales) para tratar la información. [155] Las plataformas de redes sociales como Facebook, Twitter y Telegram podrían establecer legalmente pautas para la moderación de la información y la desinformación en sus plataformas. Lo ideal sería que las plataformas intentaran equilibrar la libertad de expresión de sus usuarios con la moderación o eliminación de expresiones dañinas e ilegales. [38] [168]

El intercambio de información a través de los medios de difusión y los periódicos ha sido en gran medida autorregulado. Ha dependido de la autogestión voluntaria y del establecimiento de normas por parte de organizaciones profesionales como la Sociedad de Periodistas Profesionales de Estados Unidos (SPJ, por sus siglas en inglés). La SPJ tiene un código de ética para la responsabilidad profesional, que incluye la búsqueda y la divulgación de la verdad, la minimización del daño, la rendición de cuentas y la transparencia. [169] El código establece que "quienquiera que disfrute de una medida especial de libertad, como un periodista profesional, tiene la obligación ante la sociedad de utilizar sus libertades y poderes de manera responsable". [170] Cualquiera puede escribir una carta al editor del New York Times , pero el Times no publicará esa carta a menos que decida hacerlo. [171]

Se podría decir que las plataformas de redes sociales reciben un trato más parecido al de una oficina de correos (que transmite información sin revisarla) que al de los periodistas y editores de medios impresos, que toman decisiones editoriales y se espera que asuman la responsabilidad de lo que publican. Los tipos de marcos éticos, sociales y legales que han desarrollado el periodismo y la publicación impresa no se han aplicado a las plataformas de redes sociales. [172]

Se ha señalado que las plataformas de redes sociales como Facebook y Twitter carecen de incentivos para controlar la desinformación o para autorregularse. [169] [149] [173] En la medida en que las plataformas dependen de la publicidad para obtener ingresos, les beneficia económicamente maximizar la participación de los usuarios, y la atención de los usuarios se capta de manera demostrable con contenido sensacionalista. [19] [174] Los algoritmos que impulsan contenido en función de los historiales de búsqueda de los usuarios, los clics frecuentes y la publicidad paga conducen a información desequilibrada, mal documentada y activamente engañosa. También es muy rentable. [169] [173] [175] Al contrarrestar la desinformación, el uso de algoritmos para monitorear el contenido es más barato que contratar personas para revisar y verificar los hechos del contenido. Las personas son más eficaces para detectar la desinformación. Las personas también pueden traer sus propios sesgos (o los sesgos de su empleador) a la tarea de moderación. [172]

Las plataformas de redes sociales de propiedad privada, como Facebook y Twitter, pueden desarrollar legalmente regulaciones, procedimientos y herramientas para identificar y combatir la desinformación en sus plataformas. [176] Por ejemplo, Twitter puede utilizar aplicaciones de aprendizaje automático para marcar el contenido que no cumple con sus términos de servicio e identificar publicaciones extremistas que alientan el terrorismo. Facebook y Google han desarrollado un sistema de jerarquía de contenido donde los verificadores de hechos pueden identificar y desclasificar la posible desinformación y ajustar los algoritmos en consecuencia. [9] Las empresas también están considerando la posibilidad de utilizar sistemas legales procesales para regular el contenido en sus plataformas. En concreto, están considerando la posibilidad de utilizar sistemas de apelación: las publicaciones pueden ser eliminadas por violar los términos de servicio y plantear una amenaza de desinformación, pero los usuarios pueden impugnar esta acción a través de una jerarquía de órganos de apelación. [133]

La tecnología blockchain se ha sugerido como un mecanismo de defensa potencial contra la manipulación de Internet. [177] Si bien blockchain se desarrolló originalmente para crear un libro de contabilidad de transacciones para la moneda digital bitcoin , ahora se usa ampliamente en aplicaciones donde se desea un registro o historial permanente de activos, transacciones y actividades. Proporciona un potencial de transparencia y rendición de cuentas, [178] La tecnología blockchain podría aplicarse para hacer que el transporte de datos sea más seguro en los espacios en línea y las redes de Internet de las cosas , lo que dificulta que los actores alteren o censuren el contenido y realicen ataques de desinformación. [179] La aplicación de técnicas como blockchain y marcas de agua con clave en las plataformas de redes sociales/mensajería también podría ayudar a detectar y frenar los ataques de desinformación. La densidad y la tasa de reenvío de un mensaje podrían observarse para detectar patrones de actividad que sugieran el uso de bots y actividad de cuentas falsas en ataques de desinformación. Blockchain podría respaldar tanto el seguimiento hacia atrás como hacia adelante de eventos que involucran la propagación de desinformación. Si el contenido se considera peligroso o inapropiado, su propagación podría frenarse de inmediato. [177]

Es comprensible que los métodos para contrarrestar la desinformación que implican una gobernanza algorítmica planteen cuestiones éticas. El uso de tecnologías que rastrean y manipulan la información plantea interrogantes sobre "quién es responsable de su funcionamiento, si pueden crear injusticias y erosionar las normas cívicas, y cómo deberíamos resolver sus consecuencias (no) deseadas". [169] [180] [181]

Un estudio del Pew Research Center informa que el apoyo público a la restricción de la desinformación tanto por parte de las empresas de tecnología como del gobierno aumentó entre los estadounidenses entre 2018 y 2021. Sin embargo, las opiniones sobre si el gobierno y las empresas de tecnología deberían tomar tales medidas se volvieron cada vez más partidistas y polarizadas durante el mismo período de tiempo. [182]

Medidas de colaboración

Los expertos en ciberseguridad afirman que es necesaria la colaboración entre los sectores público y privado para combatir con éxito los ataques de desinformación. [19] Las estrategias de defensa cooperativa recomendadas incluyen:

- La creación de "consorcios de detección de desinformación" donde las partes interesadas (es decir, empresas de redes sociales privadas y gobiernos) se reúnen para discutir ataques de desinformación y elaborar estrategias de defensa mutua. [17]

- Compartir información crítica entre empresas de redes sociales privadas y el gobierno, para que se puedan desarrollar estrategias de defensa más efectivas. [183] [17]

- Coordinación entre gobiernos para crear una respuesta unificada y eficaz contra las campañas de desinformación transnacionales. [17]

Sin embargo, en Estados Unidos, el Partido Republicano se opone activamente tanto a la investigación de la desinformación como a la participación del gobierno en la lucha contra la desinformación. Los republicanos obtuvieron la mayoría en la Cámara en enero de 2023. Desde entonces, el Comité Judicial de la Cámara ha utilizado acciones legales para enviar cartas, citaciones y amenazas de acciones legales a los investigadores, exigiendo notas, correos electrónicos y otros registros de los investigadores e incluso de los estudiantes en prácticas, desde 2015. Las instituciones afectadas incluyen el Observatorio de Internet de Stanford en la Universidad de Stanford , la Universidad de Washington , el Laboratorio de Investigación Forense Digital del Atlantic Council y la empresa de análisis de redes sociales Graphika. Los proyectos incluyen la Election Integrity Partnership, formada para identificar intentos "de suprimir la votación, reducir la participación, confundir a los votantes o deslegitimar los resultados electorales sin pruebas" [184] y el Virality Project, que ha examinado la difusión de afirmaciones falsas sobre las vacunas. Los investigadores argumentan que tienen libertad académica para estudiar las redes sociales y la desinformación, así como libertad de expresión para informar sus resultados. [184] [185] [186] A pesar de las afirmaciones conservadoras de que el gobierno actuó para censurar el discurso en línea, "no ha surgido evidencia de que los funcionarios del gobierno obligaran a las empresas a tomar medidas contra las cuentas". [184]

A nivel estatal, los gobiernos estatales que estaban alineados políticamente con los activistas antivacunas solicitaron con éxito una orden judicial preliminar para impedir que la Administración Biden instara a las empresas de redes sociales a luchar contra la desinformación sobre la salud pública. La orden emitida por el Tribunal de Apelaciones de los Estados Unidos para el Quinto Circuito en 2023 "limita severamente la capacidad de la Casa Blanca, el director general de servicios de salud [y] los Centros para el Control y la Prevención de Enfermedades... para comunicarse con las empresas de redes sociales sobre contenido relacionado con la COVID-19... que el gobierno considere desinformación". [187]

Fortalecimiento de la sociedad civil

Los informes sobre desinformación en Armenia [52] y Asia [76] identifican cuestiones clave y formulan recomendaciones que pueden aplicarse a muchos otros países, en particular a aquellos que experimentan "tanto una profunda perturbación como una oportunidad de cambio". [52] El informe destaca la importancia de fortalecer la sociedad civil protegiendo la integridad de las elecciones y reconstruyendo la confianza en las instituciones públicas. Las medidas para apoyar la integridad de las elecciones incluyen: garantizar un proceso libre y justo, permitir la observación y el monitoreo independientes, permitir el acceso de periodistas independientes e investigar las infracciones electorales. Otras sugerencias incluyen repensar las estrategias de comunicación del Estado para permitir que todos los niveles de gobierno se comuniquen de manera más eficaz y para abordar los ataques de desinformación. [52]

Se recomienda un diálogo nacional que reúna a diversos actores públicos, comunitarios, políticos, estatales y no estatales como partes interesadas para lograr una planificación estratégica eficaz a largo plazo. Se recomienda crear una estrategia unificada para la legislación que aborde los espacios de información. Es fundamental equilibrar las preocupaciones sobre la libertad de expresión con las protecciones para las personas y las instituciones democráticas. [52] [188] [189]

Otra preocupación es el desarrollo de un entorno informativo saludable que apoye el periodismo basado en hechos, el discurso veraz y la información independiente, al mismo tiempo que rechace la manipulación de la información y la desinformación. Entre las cuestiones clave para el apoyo de unos medios de comunicación independientes y resilientes se encuentran la transparencia de la propiedad, la viabilidad financiera, la independencia editorial, la ética de los medios y las normas profesionales, y los mecanismos de autorregulación. [52] [188] [189] [190] [76]

Durante las elecciones generales mexicanas de 2018 , se estableció el proyecto de periodismo colaborativo Verificado 2018 para abordar la desinformación. Involucró al menos ochenta organizaciones, incluidos medios de comunicación locales y nacionales, universidades y grupos de la sociedad civil y de defensa. El grupo investigó afirmaciones en línea y declaraciones políticas y publicó verificaciones conjuntas. Durante el transcurso de la elección, produjeron más de 400 notas y 50 videos que documentaban afirmaciones falsas y sitios sospechosos, y rastrearon instancias en las que las noticias falsas se volvieron virales. [191] Verificado.mx recibió 5,4 millones de visitas durante la elección, y sus organizaciones asociadas registraron millones más. [192] : 25 Para lidiar con el intercambio de mensajes cifrados a través de WhatsApp , Verificado estableció una línea directa donde los usuarios de WhatsApp podían enviar mensajes para verificación y desacreditación. Más de 10,000 usuarios se suscribieron a la línea directa de Verificado. [191]

| Videos externos | |

|---|---|

"Estrategias de seguridad física para periodistas", PEN America , 12 de junio de 2020. "Estrategias de seguridad física para periodistas", PEN America , 12 de junio de 2020. |

Las organizaciones que promueven la sociedad civil y la democracia, los periodistas independientes, los defensores de los derechos humanos y otros activistas son cada vez más objeto de campañas de desinformación y violencia. Su protección es esencial. Los periodistas, activistas y organizaciones pueden ser aliados clave para combatir las narrativas falsas, promover la inclusión y alentar la participación cívica. Los órganos de supervisión y ética también son fundamentales. [52] [193] Las organizaciones que han desarrollado recursos y capacitaciones para apoyar mejor a los periodistas contra la violencia en línea y fuera de línea y la violencia contra las mujeres incluyen la Coalición contra la Violencia en Línea, [194] [195] el Centro Knight para el Periodismo en las Américas , [196] la Fundación Internacional de Mujeres en los Medios de Comunicación , [197] la UNESCO , [193] [196] PEN América . [198] y otros. [199]

Educación y concienciación

| Videos externos | |

|---|---|

"Entender y contrarrestar la desinformación", Red YALI, 29 de septiembre de 2022. "Entender y contrarrestar la desinformación", Red YALI, 29 de septiembre de 2022. |

Se recomienda que las escuelas públicas y las universidades impartan educación en alfabetización mediática e información sobre cómo identificar y combatir la desinformación. [52] En 2022, los países de la Unión Europea fueron clasificados en un Índice de Alfabetización Mediática para medir la resiliencia frente a la desinformación. Finlandia , el país con la clasificación más alta, ha desarrollado un extenso plan de estudios que enseña el pensamiento crítico y la resistencia a la guerra de la información, y lo ha integrado en su sistema de educación pública. Los finlandeses también tienen una alta calificación en cuanto a confianza en las autoridades gubernamentales y los medios de comunicación. [200] [201] Tras un ciberataque en 2007 que incluyó tácticas de desinformación, el país de Estonia se centró en mejorar sus ciberdefensas e hizo de la educación en alfabetización mediática un foco principal desde el jardín de infancia hasta la escuela secundaria. [202] [203]

En 2018, el vicepresidente ejecutivo de la Comisión Europea para Una Europa Adaptada a la Era Digital reunió a un grupo de expertos para elaborar un informe con recomendaciones para la enseñanza de la alfabetización digital. Los planes de estudio de alfabetización digital propuestos familiarizan a los estudiantes con sitios web de verificación de datos como Snopes y FactCheck.org . Este plan de estudios tiene como objetivo dotar a los estudiantes de habilidades de pensamiento crítico para discernir entre contenido factual y desinformación en línea. [21] Las áreas sugeridas en las que centrarse incluyen habilidades de pensamiento crítico , [204] alfabetización informativa , [205] [206] alfabetización científica [207] y alfabetización sanitaria . [24]

Otro enfoque consiste en crear juegos interactivos , como el juego Cranky Uncle , que enseña a pensar críticamente e inmuniza a los jugadores contra las técnicas de desinformación y negación científica. El juego Cranky Uncle está disponible gratuitamente y ha sido traducido a al menos nueve idiomas. [208] [209] También se pueden encontrar en Internet vídeos para enseñar a pensar críticamente y abordar la desinformación. [210] [211]

Grupos de periodistas, científicos y otros están desarrollando y compartiendo capacitaciones y mejores prácticas para identificar y contrarrestar la desinformación (por ejemplo, Climate Action Against Disinformation, [22] PEN America , [212] [213] [214] UNESCO , [44] Union of Concerned Scientists , [215] [216] Young African Leaders Initiative [217] ).

Las investigaciones indican que varias tácticas han resultado útiles contra la desinformación científica en torno al cambio climático, entre ellas: 1) ofrecer explicaciones claras sobre por qué se está produciendo el cambio climático; 2) indicar que existe un consenso científico sobre la existencia del cambio climático y sobre su base en las acciones humanas; 3) presentar la información de maneras que estén culturalmente alineadas con el oyente; 4) "inocular" a la gente identificando claramente la desinformación (idealmente antes de que se encuentre un mito, pero también más tarde mediante el desmentido). [20] [18]

En el artículo "Una caja de herramientas de intervención contra la desinformación y la manipulación en línea" se analizan las investigaciones sobre intervenciones centradas en el individuo para combatir la desinformación y su posible eficacia. Las tácticas incluyen: [218] [219]

- Indicaciones de precisión: las redes sociales y otras fuentes de información pueden indicar a las personas que piensen en la precisión antes de compartir información en línea [220] [221]

- Desmitificación: para exponer la información falsa, primero hay que centrarse en destacar los hechos verdaderos, antes de señalar que se va a dar información engañosa y, sólo entonces, especificar la información errónea y explicar por qué es incorrecta. Por último, se debe reforzar la explicación correcta. [141] [153] Esta forma de contrarrestar la desinformación se conoce a veces como un " sándwich de verdad ". [222]

- Evite la confrontación. La evidencia sugiere que cuando alguien se siente desafiado o amenazado por información que no se ajusta a su visión del mundo existente, “redoblará” sus creencias anteriores en lugar de considerar la nueva información. Sin embargo, si se puede presentar evidencia clara de una manera amistosa y no confrontativa, sin despertar agresión u hostilidad, es más probable que se considere la nueva información. [19]

- Fricción: el clickbait, cuyo objetivo es difundir desinformación, intenta que la gente reaccione rápidamente y de forma emocional. Darle a la gente señales para que reduzca la velocidad y piense en sus acciones (por ejemplo, mostrando un mensaje como "¿Quieres leer esto antes de compartirlo?") puede limitar la difusión de la desinformación. [223]

- Inoculación – Advertir a las personas de forma preventiva sobre la posible desinformación y las técnicas utilizadas para difundirla, antes de que se expongan a un mensaje falso intencionado, puede ayudarlas a identificar mensajes falsos e intentos de manipulación. [224] [225] Los vídeos cortos que describen tácticas específicas como el alarmismo, el uso de lenguaje emocional o falsos expertos, ayudan a las personas a resistir las técnicas de persuasión en línea. [226]

- Lectura lateral: verifique la información buscando fuentes independientes y confiables. Verifique la credibilidad de la información en un sitio web buscando en la Web de manera independiente, no solo mirando el sitio original. [227] [228]

- Consejos de alfabetización mediática: las estrategias específicas para detectar noticias falsas, como las utilizadas en los "Consejos para detectar noticias falsas" de Facebook de 2017 (por ejemplo, "ser escéptico con los titulares", "mirar atentamente la URL") pueden ayudar a los usuarios a discriminar mejor entre noticias reales y falsas. [229] [202]