Cinematografía virtual

Este artículo necesita citas adicionales para su verificación . ( septiembre de 2017 ) |

Gráficos por computadora en tres dimensiones (3D) |

|---|

|

| Fundamentos |

| Usos principales |

| Temas relacionados |

La cinematografía virtual es el conjunto de técnicas cinematográficas realizadas en un entorno de gráficos por ordenador . Incluye una amplia variedad de temas, como la fotografía de objetos reales, a menudo con una configuración estereoscópica o multicámara , con el fin de recrearlos como objetos tridimensionales, y algoritmos para la creación automatizada de ángulos de cámara reales y simulados . La cinematografía virtual se puede utilizar para filmar escenas desde ángulos de cámara que de otro modo serían imposibles, crear la fotografía de películas animadas y manipular la apariencia de efectos generados por ordenador.

Historia

Etapas tempranas

Un ejemplo temprano de una película que integra un entorno virtual es la película de 1998 What Dreams May Come , protagonizada por Robin Williams . El equipo de efectos especiales de la película utilizó planos de edificios reales para generar modelos de estructura alámbrica a escala que luego se utilizaron para generar el mundo virtual. [1] La película cosechó numerosas nominaciones y premios, incluido el Premio de la Academia a los mejores efectos visuales y el Premio del Sindicato de Directores de Arte a la Excelencia en Diseño de Producción. [2] El término "cinematografía virtual" surgió en 1999 cuando el artista de efectos especiales John Gaeta y su equipo quisieron nombrar las nuevas tecnologías cinematográficas que habían creado. [3]

Cinematografía virtual moderna

La trilogía Matrix ( Matrix , Matrix Reloaded y Matrix Revolutions ) utilizó las primeras técnicas de Cinematografía Virtual para desarrollar una "filmación" virtual de imágenes realistas generadas por ordenador. El resultado del trabajo de John Gaeta y su equipo en ESC Entertainment fue la creación de versiones CGI fotorrealistas de los intérpretes, los decorados y las acciones. Su trabajo se basó en los hallazgos de Paul Debevec et al. sobre la adquisición y posterior simulación del campo de reflectancia sobre el rostro humano adquirido utilizando la más simple de las etapas de luz en 2000. [4] Las escenas famosas que habrían sido imposibles o que habrían llevado demasiado tiempo producir dentro del contexto de la cinematografía tradicional incluyen la fuerte pelea en Matrix Reloaded (2003) donde Neo lucha contra hasta 100 Agentes Smith y el comienzo del enfrentamiento final en Matrix Revolutions (2003), donde Neo le da un puñetazo en el pómulo al Agente Smith [5] dejando al doble digital ileso.

Para la trilogía Matrix , los realizadores recurrieron en gran medida a la cinematografía virtual para atraer al público. Bill Pope , el director de fotografía , utilizó esta herramienta de una manera mucho más sutil. No obstante, estas escenas lograron alcanzar un alto nivel de realismo y dificultaron que el público se diera cuenta de que en realidad estaban viendo una toma creada completamente por artistas de efectos visuales que utilizaban herramientas de gráficos por computadora en 3D. [6]

En Spider-Man 2 (2004), los realizadores manipularon las cámaras para hacer que la audiencia se sintiera como si estuvieran balanceándose junto con Spider-Man por la ciudad de Nueva York. Usando el radar de la cámara de captura de movimiento , el camarógrafo se mueve simultáneamente con la animación mostrada. [7] Esto hace que la audiencia experimente la perspectiva de Spider-Man y aumenta la sensación de realidad. En Avengers: Infinity War (2018), las escenas de la secuencia del Titán se crearon usando cinematografía virtual. Para hacer la escena más realista, los productores decidieron filmar toda la escena nuevamente con una cámara diferente para que viajara de acuerdo con el movimiento del Titán. [8] Los realizadores produjeron lo que se conoce como un destello de lente sintético, lo que hace que el destello sea muy parecido al metraje producido originalmente. Cuando la clásica película animada El Rey León fue rehecha en 2019, los productores usaron cinematografía virtual para hacer una animación realista. En la escena de batalla final entre Scar y Simba , el camarógrafo vuelve a mover la cámara de acuerdo con los movimientos de los personajes. [9] El objetivo de esta tecnología es sumergir aún más a la audiencia en la escena.

Métodos

Cinematografía virtual en postproducción

En la posproducción se utilizan tecnologías avanzadas para modificar, redirigir y mejorar las escenas capturadas en el set. Las configuraciones estéreo o multicámara fotografían objetos reales de tal manera que se puedan recrear como objetos y algoritmos 3D. Se pueden utilizar equipos de captura de movimiento , como puntos de seguimiento y cámaras en cascos, en el set para facilitar la recopilación de datos retroactivos en la posproducción. [10]

La tecnología de visión artificial denominada fotogrametría utiliza escáneres 3D para capturar geometría 3D. Por ejemplo, el escáner 3D Arius utilizado para las secuelas de Matrix fue capaz de captar detalles como arrugas finas y poros de la piel de hasta 100 μm. [4]

Los cineastas también han experimentado con equipos multicámara para capturar datos de movimiento sin necesidad de contar con equipos de captura de movimiento en el set. Por ejemplo, se utilizó una técnica de captura de movimiento sin marcadores y captura fotogramétrica con configuración multicámara denominada flujo óptico para crear imitaciones digitales para las películas de Matrix. [4]

Más recientemente, la película policial de Martin Scorsese, The Irishman, utilizó un sistema de captura facial completamente nuevo desarrollado por Industrial Light & Magic (ILM), que utilizaba un equipo especial que consistía en dos cámaras digitales colocadas a ambos lados de la cámara principal para capturar datos de movimiento en tiempo real con las actuaciones principales. En la posproducción, estos datos se utilizaron para renderizar digitalmente versiones generadas por computadora de los actores. [11] [12]

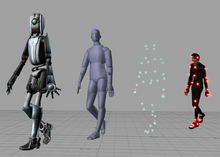

Los equipos de cámara virtuales ofrecen a los directores de fotografía la posibilidad de manipular una cámara virtual dentro de un mundo 3D y fotografiar los modelos 3D generados por ordenador . Una vez que el contenido virtual se ha ensamblado en una escena dentro de un motor 3D , las imágenes se pueden componer de forma creativa, volver a iluminar y volver a fotografiar desde otros ángulos como si la acción estuviera sucediendo por primera vez. La "filmación" virtual de esta CGI realista también permite movimientos de cámara físicamente imposibles, como las escenas en tiempo bala de Matrix . [4]

La cinematografía virtual también se puede utilizar para construir mundos virtuales completos desde cero. Los controladores de movimiento más avanzados y las interfaces de tabletas han hecho posible este tipo de técnicas de visualización dentro de las limitaciones presupuestarias de las producciones cinematográficas más pequeñas. [13]

Efectos en el set

La adopción generalizada de efectos visuales generó un deseo de producir estos efectos directamente en el set de maneras que no afectaran las actuaciones de los actores. [14] Los artistas de efectos comenzaron a implementar técnicas cinematográficas virtuales en el set, haciendo que los elementos generados por computadora de una toma determinada fueran visibles para los actores y directores de fotografía responsables de capturarla. [13]

Técnicas como la renderización en tiempo real , que permite crear un efecto antes de filmar una escena en lugar de insertarlo digitalmente después, utilizan tecnologías que antes no estaban relacionadas, como motores de videojuegos, proyectores y cámaras avanzadas, para fusionar la cinematografía convencional con su contraparte virtual. [15] [16] [17]

El primer efecto de imagen en movimiento en tiempo real fue desarrollado por Industrial Light & Magic junto con Epic Games , utilizando Unreal Engine para mostrar el clásico efecto de "velocidad de la luz" de Star Wars para la película de 2018 Solo: A Star Wars Story . [15] [18] La tecnología utilizada para la película, denominada "Stagecraft" por sus creadores, fue posteriormente utilizada por ILM para varios proyectos de Star Wars, así como para el remake animado fotorrealista de El Rey León de 2019 de su empresa matriz Disney . [19] [20]

En lugar de escanear y representar una imagen existente con técnicas cinematográficas virtuales, los efectos en tiempo real requieren un trabajo adicional mínimo en posproducción. Las tomas que incluyen cinematografía virtual en el set no requieren ninguno de los métodos avanzados de posproducción; los efectos se pueden lograr utilizando la animación CGI tradicional.

Software

- Autodesk Maya es un software de gráficos por computadora en 3D que se ejecuta en Windows , OS X y Linux .

- Autodesk 3ds Max es un programa profesional de gráficos por computadora en 3D para realizar animaciones, modelos, juegos e imágenes en 3D solo para Windows.

- Blender (software) es un producto de software de gráficos por computadora en 3D, gratuito y de código abierto , utilizado para crear películas animadas, efectos visuales, arte, modelos impresos en 3D, aplicaciones 3D interactivas y videojuegos, destinado a directores de fotografía virtuales aficionados .

- Pointstream Software de Arius3D es un sistema profesional de captura de movimiento denso y flujo óptico que utiliza un píxel y su movimiento como unidad de seguimiento, generalmente en una configuración de varias cámaras .

Véase también

- Tecnología del entretenimiento

- Realidad extendida

- Historia de la animación por ordenador

- Producción virtual en el set

- Cronología de la animación por ordenador en cine y televisión

- Cronología del CGI en el cine

- Sistema de cámara virtual

- Valle inquietante

- Actor virtual

Referencias

- ^ Silberman, Steve (1 de mayo de 2003). «MATRIX2». Wired . ISSN 1059-1028 . Consultado el 2 de abril de 2020 .

- ^ What Dreams May Come, IMDb , consultado el 2 de abril de 2020

- ^ Feeny, Catherine (9 de marzo de 2004). «'The Matrix' Revealed: An Interview with John Gaeta». VFXPro . Comunidades Creative Planet, United Entertainment Media. Archivado desde el original el 18 de marzo de 2004. Consultado el 2 de abril de 2020 .

- ^ abcd Paul Debevec ; Tim Hawkins; Chris Tchou; Haarm-Pieter Diuker; Westley Sarokin; Mark Sagar (2000). "Adquisición del campo de reflectancia de un rostro humano". Actas de la 27.ª conferencia anual sobre gráficos por ordenador y técnicas interactivas - SIGGRAPH '00. págs. 145–156. doi : 10.1145/344779.344855 . ISBN 1-58113-208-5. S2CID 2860203 . Archivado desde el original el 3 de mayo de 2024 – vía ACM Digital Library.

- ^ George Borshukov, presentado en Imagina'04. "Cómo se hizo The Superpunch" (PDF).

- ^ David Fincher – Invisible Details, archivado del original el 21 de diciembre de 2021 , consultado el 2 de abril de 2020

- ^ The Amazing Spider-Man 2 – Cinematografía virtual, archivado del original el 21 de diciembre de 2021 , consultado el 2 de abril de 2020

- ^ Avengers: Infinity War VFX | Desglose – Cinematografía | Weta Digital , consultado el 2 de abril de 2020

- ^ El Rey León – cinematografía virtual y efectos visuales, archivado del original el 21 de diciembre de 2021 , consultado el 2 de abril de 2020

- ^ Breznican, Anthony (9 de diciembre de 2019). "The Irishman, Avengers: Endgame y la tecnología antienvejecimiento que podría cambiar la actuación para siempre". Vanity Fair . Consultado el 3 de abril de 2020 .

- ^ "Robert De Niro dijo que no habría pantalla verde. No habría puntos en la cara. Cómo la rejuvenecimiento de 'El Irlandés' cambia Hollywood". Los Angeles Times . 2 de enero de 2020 . Consultado el 3 de abril de 2020 .

- ^ Desowitz, Bill (6 de diciembre de 2019). «'The Irishman': cómo los innovadores efectos visuales antienvejecimiento de Industrial Light & Magic rescataron la epopeya de la mafia de Martin Scorsese». IndieWire . Consultado el 3 de abril de 2020 .

- ^ ab "Cinematografía virtual: más allá de la producción en grandes estudios". idea.library.drexel.edu . Consultado el 2 de abril de 2020 .

- ^ "Sir Ian McKellen: Filmar El Hobbit me hizo pensar que debería dejar de actuar". Radio Times . Consultado el 2 de abril de 2020 .

- ^ ab Roettgers, Janko (15 de mayo de 2019). «Cómo los motores de videojuegos ayudan a crear efectos visuales en sets de películas en tiempo real». Variety . Consultado el 2 de abril de 2020 .

- ^ Leonard Barolli; Fatos Xhafa; Makoto Ikeda, eds. (2016). CISIS 2016: 2016 10th International Conference on Complex, Intelligent, and Software Intensive Systems: actas: Instituto Tecnológico de Fukuoka (FIT), Fukuoka, Japón, 6-8 de julio de 2016. Los Alamitos, California: IEEE Computer Society. ISBN 9781509009879.OCLC 972631841 .

- ^ Choi, Wanho; Lee, Taehyung; Kang, Wonchul (2019). "Más allá de la pantalla". SIGGRAPH Asia 2019 Technical Briefs . Brisbane, Queensland, Australia: ACM Press. págs. 65–66. doi :10.1145/3355088.3365140. ISBN 978-1-4503-6945-9.S2CID 184931978 .

- ^ Morin, David (14 de febrero de 2019). "Unreal Engine potencia el conjunto de herramientas de producción virtual de VR de ILM en "Solo: A Star Wars Story"". www.unrealengine.com . Consultado el 2 de abril de 2023 .

- ^ "Cómo la nueva tecnología "Stagecraft" de Lucasfilm dio vida a 'The Mandalorian' y podría cambiar el futuro de la televisión". /Film . 20 de noviembre de 2019 . Consultado el 2 de abril de 2020 .

- ^ "La realidad virtual de 'El Rey León' ayudó a que la película fuera un éxito. También podría cambiar la forma de hacer películas". Los Angeles Times . 26 de julio de 2019 . Consultado el 2 de abril de 2020 .

Lectura adicional

- Debevec, Paul (2006). «Cinematografía virtual: reiluminación mediante computación» (PDF) . Computer . 39 (8). IEEE: 57–65. doi :10.1109/MC.2006.285. ISSN 0018-9162. S2CID 11904037. Archivado desde el original (PDF) el 9 de febrero de 2007. Consultado el 6 de noviembre de 2006 .

- Jhala, Arnav (2005). "Introducción a la cinematografía virtual" (PDF) . Universidad Estatal de Carolina del Norte . Consultado el 6 de noviembre de 2006 .[ enlace muerto ]

- Newman, Bruce (2003). "Matrix sequel: Virtual Cinematography". San Jose Mercury News . Archivado desde el original el 27 de abril de 2006. Consultado el 7 de noviembre de 2006 .