Cálculo bayesiano aproximado

| Parte de una serie sobre |

| Estadísticas bayesianas |

|---|

| Posterior = Probabilidad × Anterior ÷ Evidencia |

| Fondo |

| Construcción de modelos |

| Posterior approximation |

|

| Estimators |

| Evidence approximation |

| Model evaluation |

El cálculo bayesiano aproximado ( ABC ) constituye una clase de métodos computacionales basados en estadísticas bayesianas que pueden utilizarse para estimar las distribuciones posteriores de los parámetros del modelo.

En toda inferencia estadística basada en modelos , la función de verosimilitud es de importancia central, ya que expresa la probabilidad de los datos observados bajo un modelo estadístico particular y, por lo tanto, cuantifica el respaldo que prestan los datos a valores particulares de parámetros y a elecciones entre diferentes modelos. Para modelos simples, normalmente se puede derivar una fórmula analítica para la función de verosimilitud. Sin embargo, para modelos más complejos, una fórmula analítica puede resultar difícil de obtener o la función de verosimilitud puede ser computacionalmente muy costosa de evaluar.

Los métodos ABC pasan por alto la evaluación de la función de verosimilitud. De esta manera, amplían el ámbito de los modelos para los que se puede considerar la inferencia estadística. Los métodos ABC están bien fundamentados matemáticamente, pero inevitablemente hacen suposiciones y aproximaciones cuyo impacto debe evaluarse cuidadosamente. Además, el dominio de aplicación más amplio de los métodos ABC exacerba los desafíos de la estimación de parámetros y la selección de modelos .

El ABC ha ganado popularidad rápidamente en los últimos años y en particular para el análisis de problemas complejos que surgen en las ciencias biológicas , por ejemplo, en genética de poblaciones , ecología , epidemiología , biología de sistemas y en propagación de radio . [1]

Historia

Las primeras ideas relacionadas con ABC se remontan a la década de 1980. Donald Rubin , al discutir la interpretación de las declaraciones bayesianas en 1984, [2] describió un mecanismo de muestreo hipotético que produce una muestra de la distribución posterior . Este esquema era más un experimento mental conceptual para demostrar qué tipo de manipulaciones se realizan al inferir las distribuciones posteriores de los parámetros. La descripción del mecanismo de muestreo coincide exactamente con la del esquema de rechazo ABC, y este artículo puede considerarse el primero en describir el cálculo bayesiano aproximado. Sin embargo, Francis Galton construyó un quincuncio de dos etapas a fines del siglo XIX que puede verse como una implementación física de un esquema de rechazo ABC para un solo desconocido (parámetro) y una sola observación. [3] Rubin hizo otro punto profético cuando argumentó que en la inferencia bayesiana, los estadísticos aplicados no deberían conformarse solo con modelos analíticamente manejables, sino que deberían considerar métodos computacionales que les permitan estimar la distribución posterior de interés. De esta manera, se puede considerar una gama más amplia de modelos. Estos argumentos son particularmente relevantes en el contexto del ABC.

En 1984, Peter Diggle y Richard Gratton sugirieron utilizar un esquema de simulación sistemática para aproximar la función de probabilidad en situaciones donde su forma analítica es intratable . [4] Su método se basó en definir una cuadrícula en el espacio de parámetros y usarla para aproximar la probabilidad ejecutando varias simulaciones para cada punto de la cuadrícula. Luego, la aproximación se mejoró aplicando técnicas de suavizado a los resultados de las simulaciones. Si bien la idea de utilizar la simulación para probar hipótesis no era nueva, [5] [6] Diggle y Gratton aparentemente introdujeron el primer procedimiento que usa simulación para hacer inferencia estadística en una circunstancia donde la probabilidad es intratable.

Aunque el enfoque de Diggle y Gratton había abierto una nueva frontera, su método todavía no era exactamente idéntico a lo que ahora se conoce como ABC, ya que apuntaba a aproximar la probabilidad en lugar de la distribución posterior. Un artículo de Simon Tavaré y coautores fue el primero en proponer un algoritmo ABC para la inferencia posterior. [7] En su trabajo seminal, se consideró la inferencia sobre la genealogía de los datos de la secuencia de ADN y, en particular, el problema de decidir la distribución posterior del tiempo hasta el ancestro común más reciente de los individuos muestreados. Tal inferencia es analíticamente intratable para muchos modelos demográficos, pero los autores presentaron formas de simular árboles coalescentes bajo los modelos putativos. Se obtuvo una muestra de la parte posterior de los parámetros del modelo aceptando/rechazando propuestas basadas en la comparación del número de sitios segregantes en los datos sintéticos y reales. Este trabajo fue seguido por un estudio aplicado sobre el modelado de la variación en el cromosoma Y humano por Jonathan K. Pritchard y coautores utilizando el método ABC. [8] Finalmente, el término cálculo bayesiano aproximado fue establecido por Mark Beaumont y coautores, [9] ampliando aún más la metodología ABC y discutiendo la idoneidad del enfoque ABC más específicamente para problemas en genética de poblaciones. Desde entonces, el ABC se ha extendido a aplicaciones fuera de la genética de poblaciones, como la biología de sistemas, la epidemiología y la filogeografía .

El cálculo bayesiano aproximado puede entenderse como una especie de versión bayesiana de la inferencia indirecta . [10] [11]

Se han desarrollado varios enfoques eficientes basados en Monte Carlo para realizar muestreos de la distribución posterior ABC con fines de estimación y problemas de predicción. Una opción popular es el algoritmo SMC Samplers [12] [13] [14] adaptado al contexto ABC en el método (SMC-ABC). [15] [11] [16] [17]

Método

Motivación

Una encarnación común del teorema de Bayes relaciona la probabilidad condicional (o densidad) de un valor de parámetro particular dados los datos con la probabilidad dada por la regla .

- ,

donde denota la probabilidad posterior, la probabilidad previa y la evidencia (también denominada probabilidad marginal o probabilidad predictiva previa de los datos). Nótese que el denominador normaliza la probabilidad total de la densidad posterior a uno y se puede calcular de esa manera.

El anterior representa creencias o conocimiento (como restricciones físicas) sobre antes de que esté disponible. Dado que el anterior reduce la incertidumbre, las estimaciones posteriores tienen menos varianza, pero pueden estar sesgadas. Por conveniencia, el anterior se especifica a menudo eligiendo una distribución particular entre un conjunto de familias de distribuciones bien conocidas y manejables, de modo que tanto la evaluación de las probabilidades anteriores como la generación aleatoria de valores de sean relativamente sencillas. Para ciertos tipos de modelos, es más pragmático especificar el anterior utilizando una factorización de la distribución conjunta de todos los elementos de en términos de una secuencia de sus distribuciones condicionales. Si uno solo está interesado en las plausibilidades posteriores relativas de diferentes valores de , la evidencia puede ignorarse, ya que constituye una constante normalizadora , que se cancela para cualquier proporción de probabilidades posteriores. Sin embargo, sigue siendo necesario evaluar la probabilidad y el anterior . Para numerosas aplicaciones, es computacionalmente costoso , o incluso completamente inviable, evaluar la probabilidad, [18] lo que motiva el uso de ABC para evitar este problema.

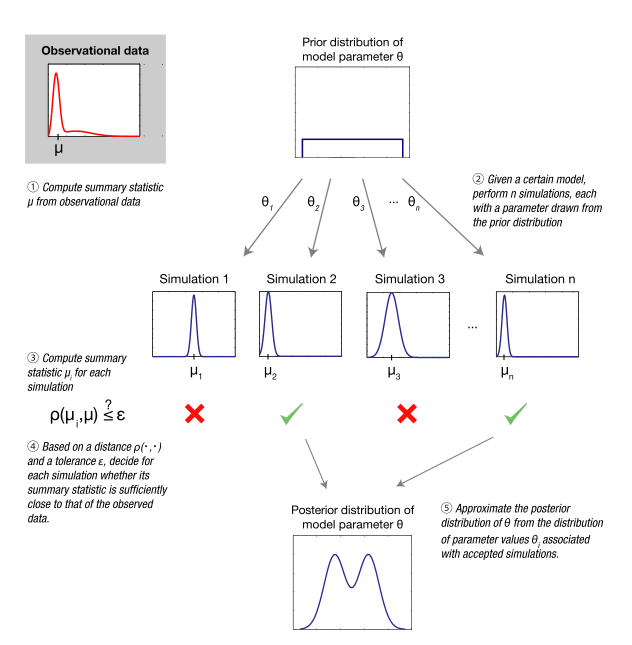

El algoritmo de rechazo ABC

Todos los métodos basados en ABC aproximan la función de verosimilitud mediante simulaciones, cuyos resultados se comparan con los datos observados. [19] [11] [20] [21] [22] Más específicamente, con el algoritmo de rechazo ABC —la forma más básica de ABC— primero se muestrea un conjunto de puntos de parámetros de la distribución anterior. Dado un punto de parámetro muestreado , luego se simula un conjunto de datos bajo el modelo estadístico especificado por . Si el generado es demasiado diferente de los datos observados , el valor del parámetro muestreado se descarta. En términos precisos, se acepta con tolerancia si:

- ,

donde la medida de distancia determina el nivel de discrepancia entre y en función de una métrica dada (por ejemplo, la distancia euclidiana ). Por lo general, es necesaria una tolerancia estrictamente positiva, ya que la probabilidad de que el resultado de la simulación coincida exactamente con los datos (evento ) es insignificante para todas las aplicaciones excepto triviales de ABC, lo que en la práctica conduciría al rechazo de casi todos los puntos de parámetros muestreados. El resultado del algoritmo de rechazo ABC es una muestra de valores de parámetros distribuidos aproximadamente de acuerdo con la distribución posterior deseada y, fundamentalmente, obtenidos sin la necesidad de evaluar explícitamente la función de verosimilitud.

Resumen de estadísticas

La probabilidad de generar un conjunto de datos con una distancia pequeña a , generalmente disminuye a medida que aumenta la dimensionalidad de los datos. Esto conduce a una disminución sustancial en la eficiencia computacional del algoritmo de rechazo ABC básico anterior. Un enfoque común para reducir este problema es reemplazar con un conjunto de estadísticas de resumen de menor dimensión , que se seleccionan para capturar la información relevante en . El criterio de aceptación en el algoritmo de rechazo ABC se convierte en:

- .

Si las estadísticas de resumen son suficientes con respecto a los parámetros del modelo , el aumento de eficiencia obtenido de esta manera no introduce ningún error. [23] De hecho, por definición, la suficiencia implica que toda la información en acerca de es capturada por .

Como se explica a continuación, normalmente es imposible, fuera de la familia exponencial de distribuciones , identificar un conjunto finito-dimensional de estadísticas suficientes. No obstante, en aplicaciones en las que se realiza la inferencia con métodos ABC se suelen utilizar estadísticas resumidas informativas, pero posiblemente insuficientes.

Ejemplo

Un ejemplo ilustrativo es un sistema biestable que puede ser caracterizado por un modelo oculto de Markov (HMM) sujeto a ruido de medición. Dichos modelos se emplean para muchos sistemas biológicos: por ejemplo, se han utilizado en desarrollo, señalización celular , activación /desactivación, procesamiento lógico y termodinámica del no equilibrio . Por ejemplo, el comportamiento del factor de transcripción Sonic hedgehog (Shh) en Drosophila melanogaster puede modelarse con un HMM. [24] El modelo dinámico (biológico) consta de dos estados: A y B. Si la probabilidad de una transición de un estado al otro se define como en ambas direcciones, entonces la probabilidad de permanecer en el mismo estado en cada paso de tiempo es . La probabilidad de medir el estado correctamente es (y a la inversa, la probabilidad de una medición incorrecta es ).

Debido a las dependencias condicionales entre estados en diferentes puntos de tiempo, el cálculo de la probabilidad de los datos de series de tiempo es algo tedioso, lo que ilustra la motivación para usar ABC. Un problema computacional para ABC básico es la gran dimensionalidad de los datos en una aplicación como esta. La dimensionalidad se puede reducir utilizando la estadística de resumen , que es la frecuencia de cambios entre los dos estados. La diferencia absoluta se utiliza como una medida de distancia con tolerancia . La inferencia posterior sobre el parámetro se puede realizar siguiendo los cinco pasos presentados en.

Paso 1: Supongamos que los datos observados forman la secuencia de estados AAAABAABBAAAAAABAAAA, que se genera utilizando y . La estadística de resumen asociada (la cantidad de cambios entre los estados en los datos experimentales) es .

Paso 2: Suponiendo que no se sabe nada acerca de , se emplea una distribución previa uniforme en el intervalo . Se supone que el parámetro es conocido y fijo al valor generador de datos , pero en general también podría estimarse a partir de las observaciones. Se extrae un total de puntos de parámetro de la distribución previa y se simula el modelo para cada uno de los puntos de parámetro , lo que da como resultado secuencias de datos simulados. En este ejemplo, , con cada parámetro extraído y conjunto de datos simulados registrados en la Tabla 1, columnas 2-3. En la práctica, tendría que ser mucho mayor para obtener una aproximación adecuada.

| i | Conjuntos de datos simulados (paso 2) | Resumen estadístico (paso 3) | Distancia (paso 4) | Resultado (paso 4) | |

|---|---|---|---|---|---|

| 1 | 0,08 | AABAAAABAABAAABAAAAA | 8 | 2 | aceptado |

| 2 | 0,68 | ABBABABAAABBABABBAB | 13 | 7 | rechazado |

| 3 | 0,87 | BBBABBBABBBBABABBBBBA | 9 | 3 | rechazado |

| 4 | 0,43 | AABAAAAABBABBBBBBBBA | 6 | 0 | aceptado |

| 5 | 0,53 | ABBBBBAABBABBABAABBB | 9 | 3 | rechazado |

Paso 3: Se calcula la estadística de resumen para cada secuencia de datos simulados .

Paso 4: Se calcula la distancia entre las frecuencias de transición observadas y simuladas para todos los puntos de parámetros. Los puntos de parámetros para los cuales la distancia es menor o igual a se aceptan como muestras aproximadas de la parte posterior.

Paso 5: La distribución posterior se aproxima con los puntos de parámetros aceptados. La distribución posterior debe tener una probabilidad no despreciable para los valores de los parámetros en una región cercana al valor verdadero de en el sistema si los datos son suficientemente informativos. En este ejemplo, la masa de probabilidad posterior se divide equitativamente entre los valores 0,08 y 0,43.

Las probabilidades posteriores se obtienen a través de ABC con grande utilizando la estadística de resumen (con y ) y la secuencia de datos completa (con ). Estas se comparan con la probabilidad posterior verdadera, que se puede calcular de manera exacta y eficiente utilizando el algoritmo de Viterbi . La estadística de resumen utilizada en este ejemplo no es suficiente, ya que la desviación de la probabilidad posterior teórica es significativa incluso bajo el estricto requisito de . Se necesitaría una secuencia de datos observada mucho más larga para obtener una probabilidad posterior concentrada alrededor de , el valor verdadero de .

Este ejemplo de aplicación del ABC utiliza simplificaciones con fines ilustrativos. Hay aplicaciones más realistas del ABC disponibles en un número cada vez mayor de artículos revisados por pares. [20] [21] [22] [25] [26]

Comparación de modelos con ABC

Además de la estimación de parámetros, el marco ABC se puede utilizar para calcular las probabilidades posteriores de diferentes modelos candidatos. [27] [28] [29] En tales aplicaciones, una posibilidad es utilizar el muestreo de rechazo de manera jerárquica. Primero, se toma una muestra de un modelo a partir de la distribución previa de los modelos. Luego, se toman muestras de los parámetros a partir de la distribución previa asignada a ese modelo. Finalmente, se realiza una simulación como en el modelo ABC único. Las frecuencias de aceptación relativas para los diferentes modelos ahora se aproximan a la distribución posterior para estos modelos. Nuevamente, se han propuesto mejoras computacionales para ABC en el espacio de modelos, como la construcción de un filtro de partículas en el espacio conjunto de modelos y parámetros. [29]

Una vez estimadas las probabilidades posteriores de los modelos, se pueden aprovechar al máximo las técnicas de comparación de modelos bayesianos . Por ejemplo, para comparar las plausibilidades relativas de dos modelos y , se puede calcular su razón posterior, que está relacionada con el factor de Bayes :

- .

Si los valores anteriores del modelo son iguales, es decir, el factor de Bayes es igual a la relación posterior.

En la práctica, como se analiza más adelante, estas medidas pueden ser muy sensibles a la elección de las distribuciones previas de los parámetros y las estadísticas de resumen, por lo que las conclusiones de la comparación de modelos deben extraerse con cautela.

Errores y soluciones

| Origen del error | Problema potencial | Solución | Subsección |

|---|---|---|---|

| Tolerancia distinta de cero | La inexactitud introduce sesgo en la distribución posterior calculada. | Estudios teóricos/prácticos de la sensibilidad de la distribución posterior a la tolerancia. ABC ruidoso. | #Aproximación de la parte posterior |

| Estadísticas de resumen insuficientes | La pérdida de información provoca intervalos de confianza inflados. | Selección automática/identificación semiautomática de estadísticas suficientes. Comprobaciones de validación de modelos (p. ej., Templeton 2009 [30] ). | #Elección y suficiencia de las estadísticas resumidas |

| Número reducido de modelos/modelos incorrectamente especificados | Los modelos investigados no son representativos/carecen de poder predictivo. | Selección cuidadosa de modelos. Evaluación del poder predictivo. | #Pequeño número de modelos |

| Priores y rangos de parámetros | Las conclusiones pueden ser sensibles a la elección de los datos previos. La elección del modelo puede no tener importancia. | Comprobar la sensibilidad de los factores de Bayes a la elección de valores a priori. Se dispone de algunos resultados teóricos sobre la elección de valores a priori. Utilizar métodos alternativos para la validación del modelo. | #Distribución previa y rangos de parámetros |

| La maldición de la dimensionalidad | Bajas tasas de aceptación de parámetros. Los errores del modelo no se pueden distinguir de una exploración insuficiente del espacio de parámetros. Riesgo de sobreajuste. | Métodos de reducción de modelos, si corresponde. Métodos para acelerar la exploración de parámetros. Controles de calidad para detectar sobreajustes. | #Maldición de la dimensionalidad |

| Clasificación de modelos con estadísticas resumidas | El cálculo de los factores de Bayes en las estadísticas de resumen puede no estar relacionado con los factores de Bayes en los datos originales, lo que puede hacer que los resultados carezcan de sentido. | Utilice únicamente estadísticas de resumen que cumplan las condiciones necesarias y suficientes para producir una elección de modelo bayesiano consistente. Utilice métodos alternativos para la validación del modelo. | Factor de Bayes con ABC y estadísticas de resumen |

| Implementación | Baja protección ante supuestos comunes en el proceso de simulación e inferencia. | Comprobaciones de la idoneidad de los resultados. Estandarización del software. | #Controles de calidad indispensables |

Como ocurre con todos los métodos estadísticos, se requieren de manera inherente una serie de suposiciones y aproximaciones para la aplicación de métodos basados en ABC a problemas de modelado reales. Por ejemplo, establecer el parámetro de tolerancia ϵ {\displaystyle \epsilon } en cero garantiza un resultado exacto, pero normalmente hace que los cálculos sean prohibitivamente costosos. Por lo tanto, en la práctica se utilizan valores mayores que cero, lo que introduce un sesgo. Asimismo, normalmente no se dispone de suficientes estadísticas y, en su lugar, se utilizan otras estadísticas de resumen, lo que introduce un sesgo adicional debido a la pérdida de información. Las fuentes adicionales de sesgo (por ejemplo, en el contexto de la selección de modelos) pueden ser más sutiles. [23] [31]

Al mismo tiempo, algunas de las críticas que se han dirigido a los métodos ABC, en particular dentro del campo de la filogeografía , [30] [32] [33] no son específicas del ABC y se aplican a todos los métodos bayesianos o incluso a todos los métodos estadísticos (por ejemplo, la elección de la distribución previa y los rangos de parámetros). [20] [34] Sin embargo, debido a la capacidad de los métodos ABC para manejar modelos mucho más complejos, algunas de estas trampas generales son de particular relevancia en el contexto de los análisis ABC.

En esta sección se analizan estos riesgos potenciales y se revisan las posibles formas de abordarlos.

Aproximación de la posterior

Un valor no despreciable tiene el precio de que se toma una muestra de en lugar de la distribución posterior verdadera . Con una tolerancia suficientemente pequeña y una medida de distancia sensata, la distribución resultante a menudo debería aproximarse razonablemente bien a la distribución objetivo real. Por otro lado, una tolerancia que sea lo suficientemente grande como para que cada punto en el espacio de parámetros sea aceptado producirá una réplica de la distribución anterior. Existen estudios empíricos de la diferencia entre y como una función de , [35] [11] y resultados teóricos para un límite superior dependiente de para el error en las estimaciones de parámetros. [36] También se ha investigado la precisión de la posterior (definida como la pérdida cuadrática esperada) entregada por ABC como una función de . [37] Sin embargo, la convergencia de las distribuciones cuando se acerca a cero, y cómo depende de la medida de distancia utilizada, es un tema importante que aún debe investigarse en mayor detalle. En particular, sigue siendo difícil desenredar los errores introducidos por esta aproximación de los errores debidos a la especificación incorrecta del modelo. [20]

Como un intento de corregir parte del error debido a un valor distinto de cero , se ha sugerido el uso de regresión lineal ponderada local con ABC para reducir la varianza de las estimaciones posteriores. [9] El método asigna pesos a los parámetros de acuerdo con qué tan bien se adhieren los resúmenes simulados a los observados y realiza una regresión lineal entre los resúmenes y los parámetros ponderados en la vecindad de los resúmenes observados. Los coeficientes de regresión obtenidos se utilizan para corregir los parámetros muestreados en la dirección de los resúmenes observados. Se sugirió una mejora en forma de regresión no lineal utilizando un modelo de red neuronal de avance. [38] Sin embargo, se ha demostrado que las distribuciones posteriores obtenidas con estos enfoques no siempre son consistentes con la distribución anterior, lo que llevó a una reformulación del ajuste de regresión que respeta la distribución anterior. [39]

Por último, la inferencia estadística que utiliza el método ABC con una tolerancia distinta de cero no es inherentemente defectuosa: bajo el supuesto de errores de medición, se puede demostrar que el valor óptimo no es cero. [37] [40] De hecho, el sesgo causado por una tolerancia distinta de cero se puede caracterizar y compensar introduciendo una forma específica de ruido en las estadísticas de resumen. Se ha establecido la consistencia asintótica para este “ABC ruidoso”, junto con fórmulas para la varianza asintótica de las estimaciones de los parámetros para una tolerancia fija. [37]

Elección y suficiencia de las estadísticas resumidas

Las estadísticas de resumen se pueden utilizar para aumentar la tasa de aceptación del ABC para datos de alta dimensión. Las estadísticas suficientes de baja dimensión son óptimas para este propósito, ya que capturan toda la información relevante presente en los datos en la forma más simple posible. [22] [41] [42] Sin embargo, las estadísticas suficientes de baja dimensión suelen ser inalcanzables para los modelos estadísticos donde la inferencia basada en ABC es más relevante y, en consecuencia, suele ser necesaria alguna heurística para identificar estadísticas de resumen de baja dimensión útiles. El uso de un conjunto de estadísticas de resumen mal elegidas a menudo conducirá a intervalos creíbles inflados debido a la pérdida implícita de información, [22] lo que también puede sesgar la discriminación entre modelos. Está disponible una revisión de los métodos para elegir estadísticas de resumen, [43] que puede proporcionar una guía valiosa en la práctica.

Un enfoque para capturar la mayor parte de la información presente en los datos sería utilizar muchas estadísticas, pero la precisión y la estabilidad del ABC parecen disminuir rápidamente con un número creciente de estadísticas de resumen. [20] [22] En cambio, una mejor estrategia es centrarse solo en las estadísticas relevantes: la relevancia depende de todo el problema de inferencia, del modelo utilizado y de los datos disponibles. [44]

Se ha propuesto un algoritmo para identificar un subconjunto representativo de estadísticas de resumen, evaluando iterativamente si una estadística adicional introduce una modificación significativa de la posterior. [45] Uno de los desafíos aquí es que un gran error de aproximación ABC puede influir en gran medida en las conclusiones sobre la utilidad de una estadística en cualquier etapa del procedimiento. Otro método [44] se descompone en dos pasos principales. Primero, se construye una aproximación de referencia de la posterior minimizando la entropía . Luego, se evalúan los conjuntos de resúmenes candidatos comparando las posteriores aproximadas ABC con la posterior de referencia.

Con ambas estrategias, se selecciona un subconjunto de estadísticas de un conjunto grande de estadísticas candidatas. En cambio, el enfoque de regresión de mínimos cuadrados parciales utiliza información de todas las estadísticas candidatas, cada una ponderada apropiadamente. [46] Recientemente, un método para construir resúmenes de manera semiautomática ha alcanzado un interés considerable. [37] Este método se basa en la observación de que la elección óptima de las estadísticas de resumen, al minimizar la pérdida cuadrática de las estimaciones puntuales de los parámetros, se puede obtener a través de la media posterior de los parámetros, que se aproxima realizando una regresión lineal basada en los datos simulados. Las estadísticas de resumen para la selección de modelos se han obtenido utilizando regresión logística multinomial sobre datos simulados, tratando a los modelos en competencia como la etiqueta para predecir. [47]

Sería de gran valor contar con métodos para la identificación de estadísticas de resumen que también pudieran evaluar simultáneamente la influencia en la aproximación de la distribución posterior. [48] Esto se debe a que la elección de las estadísticas de resumen y la elección de la tolerancia constituyen dos fuentes de error en la distribución posterior resultante. Estos errores pueden corromper la clasificación de los modelos y también pueden conducir a predicciones incorrectas de los modelos.

Factor de Bayes con ABC y estadísticas de resumen

Se ha demostrado que la combinación de estadísticas de resumen insuficientes y ABC para la selección de modelos puede ser problemática. [23] [31] De hecho, si se permite que el factor de Bayes basado en la estadística de resumen se denote por , la relación entre y toma la forma: [23]

- .

Por tanto, una estadística de resumen es suficiente para comparar dos modelos y si y sólo si:

- ,

lo que resulta en que . También queda claro a partir de la ecuación anterior que podría haber una gran diferencia entre y si la condición no se cumple, como se puede demostrar con ejemplos de juguetes. [23] [28] [31] De manera crucial, se demostró que la suficiencia para o solo, o para ambos modelos, no garantiza la suficiencia para clasificar los modelos. [23] Sin embargo, también se demostró que cualquier estadística de resumen suficiente para un modelo en el que tanto y están anidados es válida para clasificar los modelos anidados . [23]

Por lo tanto, el cálculo de los factores de Bayes en puede ser engañoso para fines de selección de modelos, a menos que la relación entre los factores de Bayes en y esté disponible, o al menos pueda aproximarse razonablemente bien. Alternativamente, recientemente se han derivado condiciones necesarias y suficientes sobre las estadísticas de resumen para una elección de modelo bayesiano consistente, [49] que pueden proporcionar una guía útil.

Sin embargo, esta cuestión sólo es relevante para la selección de modelos cuando se ha reducido la dimensión de los datos. La inferencia basada en ABC, en la que se comparan directamente los conjuntos de datos reales (como es el caso de algunas aplicaciones de biología de sistemas, por ejemplo, véase [50] ), evita este problema.

Controles de calidad indispensables

Como se desprende claramente de la discusión anterior, cualquier análisis ABC requiere decisiones y concesiones que pueden tener un impacto considerable en sus resultados. En concreto, la elección de modelos o hipótesis en competencia, el número de simulaciones, la elección de estadísticas de resumen o el umbral de aceptación no pueden basarse actualmente en reglas generales, sino que el efecto de estas decisiones debe evaluarse y probarse en cada estudio. [21]

Se han propuesto varios enfoques heurísticos para el control de calidad de ABC, como la cuantificación de la fracción de varianza de los parámetros explicada por las estadísticas de resumen. [21] Una clase común de métodos tiene como objetivo evaluar si la inferencia produce o no resultados válidos, independientemente de los datos realmente observados. Por ejemplo, dado un conjunto de valores de parámetros, que normalmente se extraen de las distribuciones previas o posteriores de un modelo, se puede generar una gran cantidad de conjuntos de datos artificiales. De esta manera, la calidad y la solidez de la inferencia ABC se pueden evaluar en un entorno controlado, midiendo qué tan bien el método de inferencia ABC elegido recupera los valores de parámetros verdaderos, y también los modelos si se consideran simultáneamente múltiples modelos estructuralmente diferentes.

Otra clase de métodos evalúa si la inferencia fue exitosa a la luz de los datos observados dados, por ejemplo, comparando la distribución predictiva posterior de las estadísticas de resumen con las estadísticas de resumen observadas. [21] Más allá de eso, las técnicas de validación cruzada [51] y las comprobaciones predictivas [52] [53] representan estrategias futuras prometedoras para evaluar la estabilidad y la validez predictiva fuera de la muestra de las inferencias ABC. Esto es particularmente importante cuando se modelan grandes conjuntos de datos, porque entonces el respaldo posterior de un modelo particular puede parecer abrumadoramente concluyente, incluso si todos los modelos propuestos de hecho son representaciones deficientes del sistema estocástico subyacente a los datos de observación. Las comprobaciones predictivas fuera de la muestra pueden revelar posibles sesgos sistemáticos dentro de un modelo y proporcionar pistas sobre cómo mejorar su estructura o parametrización.

Recientemente se han propuesto enfoques fundamentalmente novedosos para la elección de modelos que incorporan el control de calidad como un paso integral en el proceso. El ABC permite, por construcción, la estimación de las discrepancias entre los datos observados y las predicciones del modelo, con respecto a un conjunto integral de estadísticas. Estas estadísticas no son necesariamente las mismas que las utilizadas en el criterio de aceptación. Las distribuciones de discrepancia resultantes se han utilizado para seleccionar modelos que están de acuerdo con muchos aspectos de los datos simultáneamente, [54] y la inconsistencia del modelo se detecta a partir de resúmenes conflictivos y co-dependientes. Otro método basado en el control de calidad para la selección de modelos emplea el ABC para aproximar el número efectivo de parámetros del modelo y la desviación de las distribuciones predictivas posteriores de resúmenes y parámetros. [55] El criterio de información de desviación se utiliza entonces como medida del ajuste del modelo. También se ha demostrado que los modelos preferidos basados en este criterio pueden entrar en conflicto con los respaldados por factores de Bayes . Por esta razón, es útil combinar diferentes métodos para la selección de modelos para obtener conclusiones correctas.

Los controles de calidad son factibles y, de hecho, se llevan a cabo en muchos trabajos basados en el método ABC, pero, en el caso de determinados problemas, la evaluación del impacto de los parámetros relacionados con el método puede resultar complicada. Sin embargo, cabe esperar que el uso cada vez mayor del método ABC proporcione una comprensión más completa de las limitaciones y la aplicabilidad del mismo.

Los riesgos generales en la inferencia estadística se exacerban en el ABC

En esta sección se analizan los riesgos que, en sentido estricto, no son específicos del método ABC, pero que también son relevantes para otros métodos estadísticos. Sin embargo, la flexibilidad que ofrece el método ABC para analizar modelos muy complejos hace que sea muy relevante analizarlos aquí.

Distribución previa y rangos de parámetros

La especificación del rango y la distribución previa de los parámetros se benefician en gran medida del conocimiento previo sobre las propiedades del sistema. Una crítica ha sido que en algunos estudios “los rangos y distribuciones de los parámetros solo se adivinan en base a la opinión subjetiva de los investigadores”, [56] lo que está conectado con las objeciones clásicas a los enfoques bayesianos. [57]

Con cualquier método computacional, normalmente es necesario restringir los rangos de parámetros investigados. Los rangos de parámetros deberían, si es posible, definirse en base a propiedades conocidas del sistema estudiado, pero para aplicaciones prácticas pueden requerir una suposición fundamentada. Sin embargo, hay resultados teóricos disponibles con respecto a valores anteriores objetivos , que pueden basarse, por ejemplo, en el principio de indiferencia o en el principio de máxima entropía . [58] [59] Por otro lado, los métodos automatizados o semiautomatizados para elegir una distribución anterior a menudo producen densidades impropias . Como la mayoría de los procedimientos ABC requieren generar muestras a partir de los valores anteriores, los valores anteriores impropias no son directamente aplicables a ABC.

También se debe tener en cuenta el propósito del análisis al elegir la distribución a priori. En principio, las distribuciones a priori poco informativas y planas, que exageran nuestra ignorancia subjetiva sobre los parámetros, pueden producir estimaciones de parámetros razonables. Sin embargo, los factores de Bayes son muy sensibles a la distribución a priori de los parámetros. Las conclusiones sobre la elección del modelo basadas en el factor de Bayes pueden ser engañosas a menos que se considere cuidadosamente la sensibilidad de las conclusiones a la elección de las distribuciones a priori.

Pequeño número de modelos

Los métodos basados en modelos han sido criticados por no cubrir exhaustivamente el espacio de hipótesis. [33] De hecho, los estudios basados en modelos a menudo giran en torno a un pequeño número de modelos y, debido al alto costo computacional para evaluar un solo modelo en algunos casos, puede ser difícil cubrir una gran parte del espacio de hipótesis.

Un límite superior al número de modelos candidatos considerados generalmente lo establece el esfuerzo sustancial requerido para definir los modelos y elegir entre muchas opciones alternativas. [21] No existe un procedimiento específico ABC comúnmente aceptado para la construcción de modelos, por lo que se utilizan en su lugar la experiencia y el conocimiento previo. [22] Aunque sería beneficioso contar con procedimientos más robustos para la elección y formulación de modelos a priori , no existe una estrategia única para el desarrollo de modelos en estadística: la caracterización sensata de sistemas complejos siempre requerirá una gran cantidad de trabajo de investigación y el uso de conocimiento experto del dominio del problema.

Algunos oponentes del ABC sostienen que, dado que sólo unos pocos modelos (subjetivamente elegidos y probablemente todos erróneos) pueden considerarse de manera realista, los análisis ABC proporcionan sólo una visión limitada. [33] Sin embargo, existe una distinción importante entre identificar una hipótesis nula plausible y evaluar el ajuste relativo de hipótesis alternativas. [20] Dado que las hipótesis nulas útiles, que potencialmente son verdaderas, pueden plantearse extremadamente raramente en el contexto de modelos complejos, la capacidad predictiva de los modelos estadísticos como explicaciones de fenómenos complejos es mucho más importante que la prueba de una hipótesis nula estadística en este contexto. También es común promediar sobre los modelos investigados, ponderados en función de su plausibilidad relativa, para inferir características del modelo (por ejemplo, valores de parámetros) y hacer predicciones.

Grandes conjuntos de datos

Los grandes conjuntos de datos pueden constituir un cuello de botella computacional para los métodos basados en modelos. Por ejemplo, se ha señalado que en algunos análisis basados en ABC, parte de los datos deben omitirse. [33] Varios autores han argumentado que los grandes conjuntos de datos no son una limitación práctica, [21] [57] aunque la gravedad de este problema depende en gran medida de las características de los modelos. Varios aspectos de un problema de modelado pueden contribuir a la complejidad computacional, como el tamaño de la muestra, el número de variables o características observadas, la resolución temporal o espacial, etc. Sin embargo, con el aumento de la potencia computacional, este problema potencialmente será menos importante.

En lugar de tomar muestras de los parámetros de cada simulación a partir de la anterior, se ha propuesto combinar alternativamente el algoritmo Metropolis-Hastings con ABC, que según se informó dio como resultado una tasa de aceptación más alta que para el ABC simple. [48] Naturalmente, este enfoque hereda las cargas generales de los métodos MCMC, como la dificultad para evaluar la convergencia, la correlación entre las muestras de la posterior, [35] y una paralelización relativamente pobre. [21]

De la misma manera, las ideas de los métodos de Monte Carlo secuencial (SMC) y de Monte Carlo poblacional (PMC) se han adaptado al contexto ABC. [35] [60] La idea general es abordar iterativamente la distribución posterior a partir de la distribución anterior a través de una secuencia de distribuciones objetivo. Una ventaja de estos métodos, en comparación con ABC-MCMC, es que las muestras de la distribución posterior resultante son independientes. Además, con los métodos secuenciales, los niveles de tolerancia no deben especificarse antes del análisis, sino que se ajustan de forma adaptativa. [61]

Es relativamente sencillo paralelizar una serie de pasos en algoritmos ABC basados en muestreo de rechazo y métodos de Monte Carlo secuenciales . También se ha demostrado que los algoritmos paralelos pueden producir aceleraciones significativas para la inferencia basada en MCMC en filogenética, [62] lo que puede ser un enfoque viable también para los métodos basados en ABC. Sin embargo, es muy probable que un modelo adecuado para un sistema complejo requiera cálculos intensivos independientemente del método de inferencia elegido, y depende del usuario seleccionar un método que sea adecuado para la aplicación particular en cuestión.

La maldición de la dimensionalidad

Los conjuntos de datos de alta dimensión y los espacios de parámetros de alta dimensión pueden requerir que se simule una cantidad extremadamente grande de puntos de parámetros en estudios basados en ABC para obtener un nivel razonable de precisión para las inferencias posteriores. En tales situaciones, el costo computacional aumenta considerablemente y, en el peor de los casos, puede hacer que el análisis computacional sea intratable. Estos son ejemplos de fenómenos bien conocidos, a los que generalmente se hace referencia con el término general de maldición de la dimensionalidad . [63]

Para evaluar la gravedad con la que la dimensionalidad de un conjunto de datos afecta el análisis en el contexto de ABC, se han derivado fórmulas analíticas para el error de los estimadores ABC como funciones de la dimensión de las estadísticas de resumen. [64] [65] Además, Blum y François han investigado cómo la dimensión de las estadísticas de resumen se relaciona con el error cuadrático medio para diferentes ajustes de corrección al error de los estimadores ABC. También se argumentó que las técnicas de reducción de dimensión son útiles para evitar la maldición de la dimensionalidad, debido a una estructura subyacente potencialmente de menor dimensión de las estadísticas de resumen. [64] Motivados por minimizar la pérdida cuadrática de los estimadores ABC, Fearnhead y Prangle han propuesto un esquema para proyectar datos (posiblemente de alta dimensión) en estimaciones de las medias posteriores de los parámetros; estas medias, que ahora tienen la misma dimensión que los parámetros, se utilizan luego como estadísticas de resumen para ABC. [65]

El ABC se puede utilizar para inferir problemas en espacios de parámetros de alta dimensión, aunque se debe tener en cuenta la posibilidad de sobreajuste (p. ej., consulte los métodos de selección de modelos en [54] y [55] ). Sin embargo, la probabilidad de aceptar los valores simulados para los parámetros bajo una tolerancia dada con el algoritmo de rechazo ABC generalmente disminuye exponencialmente con el aumento de la dimensionalidad del espacio de parámetros (debido al criterio de aceptación global). [22] Aunque ningún método computacional (basado en ABC o no) parece ser capaz de romper la maldición de la dimensionalidad, recientemente se han desarrollado métodos para manejar espacios de parámetros de alta dimensión bajo ciertos supuestos (p. ej., basados en la aproximación polinomial en cuadrículas dispersas, [66] que potencialmente podrían reducir en gran medida los tiempos de simulación para ABC). Sin embargo, la aplicabilidad de tales métodos depende del problema y, en general, no se debe subestimar la dificultad de explorar los espacios de parámetros. Por ejemplo, la introducción de la estimación determinista de parámetros globales condujo a informes de que los óptimos globales obtenidos en varios estudios previos de problemas de baja dimensión eran incorrectos. [67] Por lo tanto, para ciertos problemas, puede resultar difícil saber si el modelo es incorrecto o, como se ha comentado anteriormente, si la región explorada del espacio de parámetros es inadecuada. [33] Los enfoques más pragmáticos consisten en reducir el alcance del problema mediante la reducción del modelo, [22] la discretización de las variables y el uso de modelos canónicos como los modelos ruidosos. Los modelos ruidosos explotan la información sobre la independencia condicional entre variables. [68]

Software

Actualmente hay varios paquetes de software disponibles para la aplicación del ABC a clases particulares de modelos estadísticos.

| Software | Palabras clave y características | Referencia |

|---|---|---|

| pyABC | Marco de Python para un ABC-SMC (Monte Carlo secuencial) distribuido eficiente. | [69] |

| PyMC | Un paquete de Python para modelado estadístico bayesiano y aprendizaje automático probabilístico. | [70] |

| ABC del bricolaje | Software para el ajuste de datos genéticos a situaciones complejas. Comparación de modelos en competencia. Estimación de parámetros. Cálculo de medidas de sesgo y precisión para un modelo dado y valores de parámetros conocidos. | [71] |

| Paquete R abc | Diversos algoritmos ABC para la estimación de parámetros y la selección de modelos. Métodos de regresión heterocedástica no lineal para ABC. Herramienta de validación cruzada. | [72] [73] |

| Paquete EasyABC R | Varios algoritmos para realizar esquemas de muestreo ABC eficientes, incluidos 4 esquemas de muestreo secuencial y 3 esquemas MCMC. | [74] [75] |

| ABC-SysBio | Paquete Python. Inferencia de parámetros y selección de modelos para sistemas dinámicos. Combina el muestreador de rechazo ABC, ABC SMC para inferencia de parámetros y ABC SMC para selección de modelos. Compatible con modelos escritos en lenguaje de marcado de biología de sistemas (SBML). Modelos deterministas y estocásticos. | [76] |

| Caja de herramientas ABC | Programas de código abierto para diversos algoritmos ABC, incluidos muestreo por rechazo, MCMC sin probabilidad, un muestreador basado en partículas y ABC-GLM. Compatibilidad con la mayoría de los programas de simulación y cálculo de estadísticas de resumen. | [77] |

| Sra. Bayes | Paquete de software de código abierto que consta de varios programas en C y R que se ejecutan con un "front-end" de Perl. Modelos coalescentes jerárquicos. Datos genéticos de poblaciones de múltiples especies codistribuidas. | [78] |

| PopABC | Paquete de software para la inferencia del patrón de divergencia demográfica. Simulación coalescente. Elección del modelo bayesiano. | [79] |

| UN SAMP | Programa basado en la web para estimar el tamaño efectivo de la población a partir de una muestra de genotipos microsatélites. Estimaciones del tamaño efectivo de la población, junto con límites de credibilidad del 95%. | [80] |

| ABC4F | Software para la estimación de estadísticas F para datos dominantes. | [81] |

| 2MALO | Mezcla bayesiana de dos eventos. Software que permite hasta dos eventos de mezcla independientes con hasta tres poblaciones parentales. Estimación de varios parámetros (mezcla, tamaños efectivos, etc.). Comparación de pares de modelos de mezcla. | [82] |

| ELFÍO | Motor para inferencia libre de verosimilitud. ELFI es un paquete de software estadístico escrito en Python para cálculo bayesiano aproximado (ABC), también conocido como inferencia libre de verosimilitud, inferencia basada en simulador, inferencia bayesiana aproximada, etc. | [83] |

| ABCpy | Paquete Python para ABC y otros esquemas de inferencia sin verosimilitud. Varios algoritmos de última generación disponibles. Proporciona una forma rápida de integrar algoritmos generativos existentes (de C++, R, etc.), paralelización fácil de usar mediante MPI o Spark y aprendizaje de estadísticas resumidas (con red neuronal o regresión lineal). | [84] |

La idoneidad de cada paquete de software depende de la aplicación específica, del entorno del sistema informático y de los algoritmos necesarios.

Véase también

Referencias

Este artículo fue adaptado de la siguiente fuente bajo una licencia CC BY 4.0 (2013) (informes de los revisores): Mikael Sunnåker; Alberto Giovanni Busetto; Elina Numminen; Jukka Corander; Matthieu Foll; Christophe Dessimoz (2013). "Cálculo bayesiano aproximado". PLOS Computational Biology . 9 (1): e1002803. doi : 10.1371/JOURNAL.PCBI.1002803 . ISSN 1553-734X. PMC 3547661 . PMID 23341757. Wikidata Q4781761.

Este artículo fue adaptado de la siguiente fuente bajo una licencia CC BY 4.0 (2013) (informes de los revisores): Mikael Sunnåker; Alberto Giovanni Busetto; Elina Numminen; Jukka Corander; Matthieu Foll; Christophe Dessimoz (2013). "Cálculo bayesiano aproximado". PLOS Computational Biology . 9 (1): e1002803. doi : 10.1371/JOURNAL.PCBI.1002803 . ISSN 1553-734X. PMC 3547661 . PMID 23341757. Wikidata Q4781761.

- ^ Bharti, A; Briol, F.-X.; Pedersen, T (2021). "Un método general para calibrar modelos de canales de radio estocásticos con núcleos". Transacciones IEEE sobre antenas y propagación . 70 (6): 3986–4001. arXiv : 2012.09612 . doi :10.1109/TAP.2021.3083761. S2CID 233880538.

- ^ Rubin, DB (1984). "Cálculos de frecuencias bayesianamente justificables y relevantes para el estadístico aplicado". Anales de estadística . 12 (4): 1151–1172. doi : 10.1214/aos/1176346785 .

- ^ Véase la figura 5 en Stigler, Stephen M. (2010). "Darwin, Galton y la Ilustración estadística". Revista de la Royal Statistical Society. Serie A (Estadística en la sociedad) . 173 (3): 469–482. doi :10.1111/j.1467-985X.2010.00643.x. ISSN 0964-1998. S2CID 53333238.

- ^ Diggle, PJ (1984). "Métodos de inferencia de Monte Carlo para modelos estadísticos implícitos". Revista de la Royal Statistical Society, Serie B. 46 ( 2): 193–227. doi :10.1111/j.2517-6161.1984.tb01290.x.

- ^ Bartlett, MS (1963). "El análisis espectral de procesos puntuales". Revista de la Royal Statistical Society, Serie B. 25 ( 2): 264–296. doi :10.1111/j.2517-6161.1963.tb00508.x.

- ^ Hoel, DG; Mitchell, TJ (1971). "Simulación, ajuste y prueba de un modelo estocástico de proliferación celular". Biometrics . 27 (1): 191–199. doi :10.2307/2528937. JSTOR 2528937. PMID 4926451.

- ^ Tavaré, S; Balding, DJ; Griffiths, RC; Donnelly, P (1997). "Inferir tiempos de coalescencia a partir de datos de secuencias de ADN". Genética . 145 (2): 505–518. doi :10.1093/genetics/145.2.505. PMC 1207814 . PMID 9071603.

- ^ Pritchard, JK; Seielstad, MT; Pérez-Lezaun, A; et al. (1999). "Crecimiento poblacional de los cromosomas Y humanos: un estudio de los microsatélites del cromosoma Y". Biología molecular y evolución . 16 (12): 1791–1798. doi : 10.1093/oxfordjournals.molbev.a026091 . PMID 10605120.

- ^ ab Beaumont, MA; Zhang, W; Balding, DJ (2002). "Computación bayesiana aproximada en genética de poblaciones". Genética . 162 (4): 2025–2035. doi :10.1093/genetics/162.4.2025. PMC 1462356 . PMID 12524368.

- ^ Christopher C Drovandi (2018). "ABC e inferencia indirecta". arXiv : 1803.01999 [stat.CO].

- ^ abcd Peters, Gareth (2009). "Avances en computación bayesiana aproximada y metodología de muestreo transdimensional". Revista electrónica SSRN . doi :10.2139/ssrn.3785580. hdl : 1959.4/50086 . ISSN 1556-5068.

- ^ Del Moral, Pierre; Doucet, Arnaud; Jasra, Ajay (2006). "Muestreadores secuenciales de Monte Carlo". Revista de la Real Sociedad de Estadística. Serie B (Metodología Estadística) . 68 (3): 411–436. arXiv : cond-mat/0212648 . doi :10.1111/j.1467-9868.2006.00553.x. ISSN 1369-7412. JSTOR 3879283.

- ^ Del Moral, Pierre; Doucet, Arnaud; Peters, Gareth (2004). "Informe técnico CUED sobre muestreadores secuenciales de Monte Carlo". Revista electrónica SSRN . doi :10.2139/ssrn.3841065. ISSN 1556-5068.

- ^ Peters, Gareth (2005). "Temas en muestreadores secuenciales de Monte Carlo". Revista electrónica SSRN . doi :10.2139/ssrn.3785582. ISSN 1556-5068.

- ^ Sisson, SA; Fan, Y.; Tanaka, Mark M. (6 de febrero de 2007). "Monte Carlo secuencial sin verosimilitudes". Actas de la Academia Nacional de Ciencias . 104 (6): 1760–1765. Bibcode :2007PNAS..104.1760S. doi : 10.1073/pnas.0607208104 . ISSN 0027-8424. PMC 1794282 . PMID 17264216.

- ^ Peters, GW; Sisson, SA; Fan, Y. (1 de noviembre de 2012). "Inferencia bayesiana sin verosimilitud para modelos α-estables". Computational Statistics & Data Analysis . 1.ª edición de Annals of Computational and Financial Econometrics. 56 (11): 3743–3756. doi :10.1016/j.csda.2010.10.004. ISSN 0167-9473.

- ^ Peters, Gareth W.; Wüthrich, Mario V.; Shevchenko, Pavel V. (1 de agosto de 2010). "Método de escalera de cadena: bootstrap bayesiano versus bootstrap clásico". Seguros: Matemáticas y Economía . 47 (1): 36–51. arXiv : 1004.2548 . doi :10.1016/j.insmatheco.2010.03.007. ISSN 0167-6687.

- ^ Busetto AG, Buhmann J. Estimación de parámetros bayesianos estables para sistemas dinámicos biológicos.; 2009. IEEE Computer Society Press págs. 148-157.

- ^ Hunter, Dawn (8 de diciembre de 2006). "Inferencia bayesiana, muestreo de Monte Carlo y riesgo operacional". Journal of Operational Risk . 1 (3): 27–50. doi :10.21314/jop.2006.014.

- ^ abcdef Beaumont, MA (2010). "Computación bayesiana aproximada en evolución y ecología". Revista anual de ecología, evolución y sistemática . 41 : 379–406. doi :10.1146/annurev-ecolsys-102209-144621.

- ^ abcdefgh Bertorelle, G; Benazzo, A; Mona, S (2010). "ABC como marco flexible para estimar la demografía en el espacio y el tiempo: algunas desventajas, muchas ventajas". Ecología molecular . 19 (13): 2609–2625. Bibcode :2010MolEc..19.2609B. doi : 10.1111/j.1365-294x.2010.04690.x . PMID 20561199. S2CID 12129604.

- ^ abcdefgh Csilléry, K; Blum, MGB; Gaggiotti, OE; François, O (2010). "Computación bayesiana aproximada (ABC) en la práctica". Tendencias en ecología y evolución . 25 (7): 410–418. doi :10.1016/j.tree.2010.04.001. PMID 20488578. S2CID 13957079.

- ^ abcdefg Didelot, X; Everitt, RG; Johansen, AM; Lawson, DJ (2011). "Estimación libre de verosimilitud de la evidencia del modelo". Análisis bayesiano . 6 : 49–76. doi : 10.1214/11-ba602 .

- ^ Lai, K; Robertson, MJ; Schaffer, DV (2004). "El sistema de señalización Sonic Hedgehog como un interruptor genético biestable". Biophys. J . 86 (5): 2748–2757. Bibcode :2004BpJ....86.2748L. doi :10.1016/s0006-3495(04)74328-3. PMC 1304145 . PMID 15111393.

- ^ Marin, JM; Pudlo, P; Robert, CP; Ryder, RJ (2012). "Métodos computacionales bayesianos aproximados". Estadística y computación . 22 (6): 1167–1180. arXiv : 1101.0955 . doi :10.1007/s11222-011-9288-2. S2CID 40304979.

- ^ Robert, Christian P. (2016). "Cálculo bayesiano aproximado: una encuesta sobre resultados recientes". En Cools, R.; Nuyens, D. (eds.). Métodos de Monte Carlo y cuasi-Monte Carlo . Springer Proceedings in Mathematics & Statistics. Vol. 163. págs. 185–205. doi :10.1007/978-3-319-33507-0_7. ISBN 978-3-319-33505-6.

- ^ Wilkinson, RG (2007). Estimación bayesiana de los tiempos de divergencia de los primates, tesis doctoral, Universidad de Cambridge.

- ^ ab Grelaud, A; Marin, JM; Robert, C; Rodolphe, F; Tally, F (2009). "Métodos libres de verosimilitud para la elección de modelos en campos aleatorios de Gibbs". Análisis bayesiano . 3 : 427–442.

- ^ ab Toni, Tina; Stumpf, Michael PH (2010). "Selección de modelos basados en simulación para sistemas dinámicos en biología de sistemas y poblaciones". Bioinformática . 26 : 104–110. arXiv : 0911.1705 . doi :10.1093/bioinformatics/btp619.

- ^ ab Templeton, AR (2009). "¿Por qué se sigue utilizando un método que falla? La respuesta". Evolution . 63 (4): 807–812. doi :10.1111/j.1558-5646.2008.00600.x. PMC 2693665 . PMID 19335340.

- ^ abc Robert, CP; Cornuet, JM; Marin, JM; Pillai, NS (2011). "Falta de confianza en la elección aproximada del modelo de cálculo bayesiano". Proc Natl Acad Sci USA . 108 (37): 15112–15117. Bibcode :2011PNAS..10815112R. doi : 10.1073/pnas.1102900108 . PMC 3174657 . PMID 21876135.

- ^ Templeton, AR (2008). "Análisis de clados anidados: un método ampliamente validado para una inferencia filogeográfica sólida". Ecología molecular . 17 (8): 1877–1880. Bibcode :2008MolEc..17.1877T. doi :10.1111/j.1365-294x.2008.03731.x. PMC 2746708 . PMID 18346121.

- ^ abcde Templeton, AR (2009). "Prueba de hipótesis estadística en filogeografía intraespecífica: análisis filogeográfico de clados anidados vs. cálculo bayesiano aproximado". Ecología molecular . 18 (2): 319–331. Bibcode :2009MolEc..18..319T. doi :10.1111/j.1365-294x.2008.04026.x. PMC 2696056 . PMID 19192182.

- ^ Berger, JO; Fienberg, SE; Raftery, AE; Robert, CP (2010). "Inferencia filogeográfica incoherente". Actas de la Academia Nacional de Ciencias de los Estados Unidos de América . 107 (41): E157. Bibcode :2010PNAS..107E.157B. doi : 10.1073/pnas.1008762107 . PMC 2955098 . PMID 20870964.

- ^ abc Sisson, SA; Fan, Y; Tanaka, MM (2007). "Monte Carlo secuencial sin verosimilitudes". Proc Natl Acad Sci USA . 104 (6): 1760–1765. Bibcode :2007PNAS..104.1760S. doi : 10.1073/pnas.0607208104 . PMC 1794282 . PMID 17264216.

- ^ Dean, Thomas A.; Singh, Sumeetpal S.; Jasra, Ajay; Peters, Gareth W. (2011). "Estimación de parámetros para modelos ocultos de Markov con verosimilitudes intratables". arXiv : 1103.5399 [math.ST].

- ^ abcd Fearnhead, Paul; Prangle, Dennis (2010). "Construcción de estadísticas de resumen para el cálculo bayesiano aproximado: ABC semiautomático". arXiv : 1004.1112 [stat.ME].

- ^ Blum, M; Francois, O (2010). "Modelos de regresión no lineal para el cálculo bayesiano aproximado". Stat Comp . 20 : 63–73. arXiv : 0809.4178 . doi :10.1007/s11222-009-9116-0. S2CID 2403203.

- ^ Leuenberger, C; Wegmann, D (2009). "Computación bayesiana y selección de modelos sin probabilidades". Genética . 184 (1): 243–252. doi :10.1534/genetics.109.109058. PMC 2815920 . PMID 19786619.

- ^ Wilkinson, Richard David (2013). "El cálculo bayesiano aproximado (ABC) da resultados exactos bajo el supuesto de error del modelo". Aplicaciones estadísticas en genética y biología molecular . 12 (2). arXiv : 0811.3355 . doi :10.1515/sagmb-2013-0010.

- ^ Peters, Gareth William; Wuthrich, Mario V.; Shevchenko, Pavel V. (2009). "Método de escalera de cadena: bootstrap bayesiano versus bootstrap clásico". Revista electrónica SSRN . arXiv : 1004.2548 . doi :10.2139/ssrn.2980411. ISSN 1556-5068.

- ^ Peters, GW; Sisson, SA; Fan, Y. (23 de diciembre de 2009). "Inferencia bayesiana libre de verosimilitud para modelos alfa-estables". arXiv : 0912.4729 [stat.CO].

- ^ Blum, MGB; Nunes, MA; Prangle, D.; Sisson, SA (2013). "Una revisión comparativa de los métodos de reducción de dimensión en el cálculo bayesiano aproximado". Ciencia estadística . 28 (2). arXiv : 1202.3819 . doi :10.1214/12-STS406.

- ^ ab Nunes, MA; Balding, DJ (2010). "Sobre la selección óptima de estadísticas de resumen para el cálculo bayesiano aproximado". Stat Appl Genet Mol Biol . 9 : Artículo 34. doi :10.2202/1544-6115.1576. PMID 20887273. S2CID 207319754.

- ^ Joyce, P; Marjoram, P (2008). "Estadísticas aproximadamente suficientes y computación bayesiana". Stat Appl Genet Mol Biol . 7 (1): Artículo 26. doi :10.2202/1544-6115.1389. PMID 18764775. S2CID 38232110.

- ^ Wegmann, D; Leuenberger, C; Excoffier, L (2009). "Cálculo bayesiano aproximado eficiente acoplado con el método Monte Carlo de cadena de Markov sin verosimilitud". Genética . 182 (4): 1207–1218. doi :10.1534/genetics.109.102509. PMC 2728860 . PMID 19506307.

- ^ Prangle, Dennis; Fearnhead, Paul; Cox, Murray P.; Biggs, Patrick J.; French, Nigel P. (2014). "Selección semiautomática de estadísticas de resumen para la elección del modelo ABC". Stat Appl Genet Mol Biol : 67–82. arXiv : 1302.5624 . doi :10.1515/sagmb-2013-0012.

- ^ ab Marjoram, P; Molitor, J; Plagnol, V; Tavare, S (2003). "Cadena de Markov Monte Carlo sin verosimilitudes". Proc Natl Acad Sci USA . 100 (26): 15324–15328. Bibcode :2003PNAS..10015324M. doi : 10.1073/pnas.0306899100 . PMC 307566 . PMID 14663152.

- ^ Marin, J. -M.; Pillai, N.; Robert, CP; Rousseau, J. (2011). "Estadísticas relevantes para la elección del modelo bayesiano". arXiv : 1110.4700 [math.ST].

- ^ Toni, T; Welch, D; Strelkowa, N; Ipsen, A; Stumpf, M (2007). "Esquema de cálculo bayesiano aproximado para la inferencia de parámetros y la selección de modelos en sistemas dinámicos". JR Soc Interface . 6 (31): 187–202. doi :10.1098/rsif.2008.0172. PMC 2658655 . PMID 19205079.

- ^ Arlot, S; Celisse, A (2010). "Un estudio de los procedimientos de validación cruzada para la selección de modelos". Encuestas estadísticas . 4 : 40–79. arXiv : 0907.4728 . doi :10.1214/09-ss054. S2CID 14332192.

- ^ Dawid, A. "Situación actual y desarrollos potenciales: Algunas opiniones personales: Teoría estadística: El enfoque precuencial". Journal of the Royal Statistical Society, Serie A. 1984 : 278–292.

- ^ Vehtari, A; Lampinen, J (2002). "Evaluación y comparación de modelos bayesianos utilizando densidades predictivas de validación cruzada". Computación neuronal . 14 (10): 2439–2468. CiteSeerX 10.1.1.16.3206 . doi :10.1162/08997660260293292. PMID 12396570. S2CID 366285.

- ^ ab Ratmann, O; Andrieu, C; Wiuf, C; Richardson, S (2009). "Crítica de modelos basada en inferencia libre de verosimilitud, con una aplicación a la evolución de redes de proteínas". Actas de la Academia Nacional de Ciencias de los Estados Unidos de América . 106 (26): 10576–10581. Bibcode :2009PNAS..10610576R. doi : 10.1073/pnas.0807882106 . PMC 2695753 . PMID 19525398.

- ^ ab Francois, O; Laval, G (2011). "Criterios de información de desviación para la selección de modelos en computación bayesiana aproximada". Stat Appl Genet Mol Biol . 10 : Artículo 33. arXiv : 1105.0269 . Bibcode :2011arXiv1105.0269F. doi :10.2202/1544-6115.1678. S2CID 11143942.

- ^ Templeton, AR (2010). "Inferencia coherente e incoherente en filogeografía y evolución humana". Actas de la Academia Nacional de Ciencias de los Estados Unidos de América . 107 (14): 6376–6381. Bibcode :2010PNAS..107.6376T. doi : 10.1073/pnas.0910647107 . PMC 2851988 . PMID 20308555.

- ^ ab Beaumont, MA; Nielsen, R; Robert, C; Hey, J; Gaggiotti, O; et al. (2010). "En defensa de la inferencia basada en modelos en filogeografía". Ecología molecular . 19 (3): 436–446. Código Bibliográfico :2010MolEc..19..436B. doi :10.1111/j.1365-294x.2009.04515.x. PMC 5743441 . PMID 29284924.

- ^ Jaynes ET (1968) Probabilidades previas. Transacciones IEEE sobre ciencia de sistemas y cibernética 4.

- ^ Berger, JO (2006). "El caso del análisis bayesiano objetivo". Bayesian Analysis . 1 (páginas 385–402 y 457–464): 385–402. doi : 10.1214/06-BA115 .

- ^ Beaumont, MA; Cornuet, JM; Marin, JM; Robert, CP (2009). "Cálculo bayesiano aproximado adaptativo". Biometrika . 96 (4): 983–990. arXiv : 0805.2256 . doi :10.1093/biomet/asp052. S2CID 16579245.

- ^ Del Moral P, Doucet A, Jasra A (2011) Un método de Monte Carlo secuencial adaptativo para el cálculo bayesiano aproximado. Estadística y computación.

- ^ Feng, X; Buell, DA; Rose, JR; Waddellb, PJ (2003). "Algoritmos paralelos para inferencia filogenética bayesiana". Revista de computación paralela y distribuida . 63 (7–8): 707–718. CiteSeerX 10.1.1.109.7764 . doi :10.1016/s0743-7315(03)00079-0.

- ^ Bellman R (1961) Procesos de control adaptativo: una visita guiada: Princeton University Press.

- ^ ab Blum MGB (2010) Cálculo bayesiano aproximado: una perspectiva no paramétrica, Journal of the American Statistical Association (105): 1178-1187

- ^ ab Fearnhead, P; Prangle, D (2012). "Construcción de estadísticas de resumen para el cálculo bayesiano aproximado: cálculo bayesiano aproximado semiautomático". Revista de la Royal Statistical Society, Serie B . 74 (3): 419–474. CiteSeerX 10.1.1.760.7753 . doi :10.1111/j.1467-9868.2011.01010.x. S2CID 53861241.

- ^ Gerstner, T; Griebel, M (2003). "Cuadratura de tensor-producto adaptativa a la dimensión". Computing . 71 : 65–87. CiteSeerX 10.1.1.16.2434 . doi :10.1007/s00607-003-0015-5. S2CID 16184111.

- ^ Singer, AB; Taylor, JW; Barton, PI; Green, WH (2006). "Optimización dinámica global para la estimación de parámetros en cinética química". J Phys Chem A . 110 (3): 971–976. Bibcode :2006JPCA..110..971S. doi :10.1021/jp0548873. PMID 16419997.

- ^ Cardenas, IC (2019). "Sobre el uso de redes bayesianas como un enfoque de metamodelado para analizar incertidumbres en el análisis de estabilidad de taludes". Georisk: evaluación y gestión de riesgos para sistemas de ingeniería y geopeligros . 13 (1): 53–65. Bibcode :2019GAMRE..13...53C. doi :10.1080/17499518.2018.1498524. S2CID 216590427.

- ^ Klinger, E.; Rickert, D.; Hasenauer, J. (2017). pyABC: inferencia distribuida y libre de verosimilitud.

- ^ Salvatier, John; Wiecki, Thomas V.; Fonnesbeck, Christopher (2016). "Programación probabilística en Python usando PyMC3". PeerJ Computer Science . 2 : e55. arXiv : 1507.08050 . doi : 10.7717/peerj-cs.55 .

- ^ Cornuet, JM; Santos, F; Beaumont, M; et al. (2008). "Inferir la historia de la población con ABC DIY: un enfoque fácil de usar para aproximar el cálculo bayesiano". Bioinformática . 24 (23): 2713–2719. doi :10.1093/bioinformatics/btn514. PMC 2639274 . PMID 18842597.

- ^ Csilléry, K; François, O; Blum, MGB (2012). "abc: un paquete R para el cálculo bayesiano aproximado (ABC)". Métodos en ecología y evolución . 3 (3): 475–479. arXiv : 1106.2793 . Código Bibliográfico :2012MEcEv...3..475C. doi :10.1111/j.2041-210x.2011.00179.x. S2CID 16679366.

- ^ Csillery, K; Francois, O; Blum, MGB (21 de febrero de 2012). "Cálculo bayesiano aproximado (ABC) en R: una viñeta" (PDF) . Consultado el 10 de mayo de 2013 .

- ^ Jabot, F; Faure, T; Dumoulin, N (2013). "EasyABC: realización de esquemas de muestreo computacional bayesiano aproximados y eficientes utilizando R". Métodos en ecología y evolución . 4 (7): 684–687. Bibcode :2013MEcEv...4..684J. doi : 10.1111/2041-210X.12050 .

- ^ Jabot, F; Faure, T; Dumoulin, N (3 de junio de 2013). «EasyABC: una viñeta» (PDF) . Archivado desde el original (PDF) el 18 de agosto de 2016. Consultado el 19 de julio de 2016 .

- ^ Liepe, J; Barnes, C; Cule, E; Erguler, K; Kirk, P; Toni, T; Stumpf, MP (2010). "ABC-SysBio: cálculo bayesiano aproximado en Python con soporte de GPU". Bioinformática . 26 (14): 1797–1799. doi :10.1093/bioinformatics/btq278. PMC 2894518 . PMID 20591907.

- ^ Wegmann, D; Leuenberger, C; Neuenschwander, S; Excoffier, L (2010). "ABCtoolbox: un conjunto de herramientas versátil para cálculos bayesianos aproximados". BMC Bioinformatics . 11 : 116. doi : 10.1186/1471-2105-11-116 . PMC 2848233 . PMID 20202215.

- ^ Hickerson, MJ; Stahl, E; Takebayashi, N (2007). "msBayes: canalización para probar historias filogeográficas comparativas utilizando computación bayesiana aproximada jerárquica". BMC Bioinformatics . 8 (268): 1471–2105. doi : 10.1186/1471-2105-8-268 . PMC 1949838 . PMID 17655753.

- ^ Lopes, JS; Balding, D; Beaumont, MA (2009). "PopABC: un programa para inferir parámetros demográficos históricos". Bioinformática . 25 (20): 2747–2749. doi :10.1093/bioinformatics/btp487. PMID 19679678.

- ^ Tallmon, DA; Koyuk, A; Luikart, G; Beaumont, MA (2008). "PROGRAMAS DE COMPUTACIÓN: onesamp: un programa para estimar el tamaño efectivo de la población utilizando el cálculo bayesiano aproximado". Recursos de ecología molecular . 8 (2): 299–301. doi :10.1111/j.1471-8286.2007.01997.x. PMID 21585773. S2CID 9848290.

- ^ Foll, M; Baumont, MA; Gaggiotti, OE (2008). "Un enfoque de computación bayesiana aproximada para superar los sesgos que surgen al utilizar marcadores AFLP para estudiar la estructura de la población". Genética . 179 (2): 927–939. doi :10.1534/genetics.107.084541. PMC 2429886 . PMID 18505879.

- ^ Bray, TC; Sousa, VC; Parreira, B; Bruford, MW; Chikhi, L (2010). "2BAD: una aplicación para estimar las contribuciones parentales durante dos eventos de admisión independientes". Recursos de ecología molecular . 10 (3): 538–541. doi :10.1111/j.1755-0998.2009.02766.x. hdl : 10400.7/205 . PMID 21565053. S2CID 6528668.

- ^ Kangasrääsiö, Antti; Lintusaari, Jarno; Skytén, Kusti; Järvenpää, Marko; Vuollekoski, Henri; Gutmann, Michael; Vehtari, Aki; Corander, Jukka; Kaski, Samuel (2016). "ELFI: motor para inferencias sin probabilidades" (PDF) . Taller NIPS 2016 sobre avances en inferencia bayesiana aproximada . arXiv : 1708.00707 . Código Bib : 2017arXiv170800707L.

- ^ Dutta, R; Schoengens, M; Pacchiardi, L; Ummadisingu, A; Widmer, N; Onnela, JP; Mira, A (2021). "ABCpy: una perspectiva de computación de alto rendimiento para aproximar el cálculo bayesiano". Revista de software estadístico . 100 (7). arXiv : 1711.04694 . doi : 10.18637/jss.v100.i07 . S2CID 88516340.

Enlaces externos

- Darren Wilkinson (31 de marzo de 2013). "Introducción al cálculo bayesiano aproximado" . Consultado el 31 de marzo de 2013 .

- Rasmus Bååth (20 de octubre de 2014). «Tiny Data, Approximate Bayesian Computation and the Socks of Karl Broman» (Datos diminutos, cálculo bayesiano aproximado y los calcetines de Karl Broman) . Consultado el 22 de enero de 2015 .

![{\estilo de visualización [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)