Función de densidad de probabilidad

This article needs additional citations for verification. (June 2022) |

En teoría de probabilidad , una función de densidad de probabilidad ( PDF ), función de densidad o densidad de una variable aleatoria absolutamente continua , es una función cuyo valor en cualquier muestra dada (o punto) en el espacio muestral (el conjunto de valores posibles tomados por la variable aleatoria) puede interpretarse como una probabilidad relativa de que el valor de la variable aleatoria sea igual a esa muestra. [2] [3] La densidad de probabilidad es la probabilidad por unidad de longitud, en otras palabras, mientras que la probabilidad absoluta de que una variable aleatoria continua tome cualquier valor particular es 0 (ya que hay un conjunto infinito de valores posibles para empezar), el valor de la PDF en dos muestras diferentes se puede utilizar para inferir, en cualquier extracción particular de la variable aleatoria, cuánto más probable es que la variable aleatoria esté cerca de una muestra en comparación con la otra muestra.

Más precisamente, la función de densidad de probabilidad se utiliza para especificar la probabilidad de que la variable aleatoria caiga dentro de un rango particular de valores , en lugar de tomar un valor cualquiera. Esta probabilidad está dada por la integral de la función de densidad de probabilidad de esta variable en ese rango, es decir, está dada por el área bajo la función de densidad pero por encima del eje horizontal y entre los valores más bajo y más alto del rango. La función de densidad de probabilidad es no negativa en todas partes, y el área bajo toda la curva es igual a 1.

Los términos función de distribución de probabilidad y función de probabilidad también se han utilizado a veces para designar la función de densidad de probabilidad. Sin embargo, este uso no es estándar entre los probabilistas y estadísticos. En otras fuentes, "función de distribución de probabilidad" puede usarse cuando la distribución de probabilidad se define como una función sobre conjuntos generales de valores o puede referirse a la función de distribución acumulativa , o puede ser una función de masa de probabilidad (PMF) en lugar de la densidad. La "función de densidad" en sí también se utiliza para la función de masa de probabilidad, lo que genera más confusión. [4] Sin embargo, en general, la PMF se utiliza en el contexto de variables aleatorias discretas (variables aleatorias que toman valores en un conjunto contable), mientras que la PDF se utiliza en el contexto de variables aleatorias continuas.

Ejemplo

Supongamos que las bacterias de una determinada especie viven normalmente de 20 a 30 horas. La probabilidad de que una bacteria viva exactamente 5 horas es igual a cero. Muchas bacterias viven aproximadamente 5 horas, pero no hay posibilidad de que una bacteria determinada muera exactamente a las 5,00... horas. Sin embargo, la probabilidad de que la bacteria muera entre 5 horas y 5,01 horas es cuantificable. Supongamos que la respuesta es 0,02 (es decir, 2%). Entonces, la probabilidad de que la bacteria muera entre 5 horas y 5,001 horas debería ser de aproximadamente 0,002, ya que este intervalo de tiempo es una décima parte del anterior. La probabilidad de que la bacteria muera entre 5 horas y 5,0001 horas debería ser de aproximadamente 0,0002, y así sucesivamente.

En este ejemplo, la razón (probabilidad de vivir durante un intervalo) / (duración del intervalo) es aproximadamente constante e igual a 2 por hora (o 2 hora −1 ). Por ejemplo, hay 0,02 probabilidades de morir en el intervalo de 0,01 horas entre 5 y 5,01 horas, y (0,02 probabilidades / 0,01 horas) = 2 hora −1 . Esta cantidad 2 hora −1 se denomina densidad de probabilidad de morir alrededor de las 5 horas. Por lo tanto, la probabilidad de que la bacteria muera a las 5 horas se puede escribir como (2 hora −1 ) dt . Esta es la probabilidad de que la bacteria muera dentro de una ventana de tiempo infinitesimal alrededor de las 5 horas, donde dt es la duración de esta ventana. Por ejemplo, la probabilidad de que viva más de 5 horas, pero menos de (5 horas + 1 nanosegundo), es (2 horas −1 )×(1 nanosegundo) ≈6 × 10 −13 (usando la conversión de unidades 3,6 × 10 12 nanosegundos = 1 hora).

Existe una función de densidad de probabilidad f con f (5 horas) = 2 horas −1 . La integral de f en cualquier ventana de tiempo (no solo ventanas infinitesimales sino también ventanas grandes) es la probabilidad de que la bacteria muera en esa ventana.

Distribuciones univariadas absolutamente continuas

Una función de densidad de probabilidad se asocia más comúnmente con distribuciones univariadas absolutamente continuas . Una variable aleatoria tiene densidad , donde es una función integrable de Lebesgue no negativa , si:

Por lo tanto, si es la función de distribución acumulativa de , entonces: y (si es continua en )

Intuitivamente, se puede pensar en ella como la probabilidad de caer dentro del intervalo infinitesimal .

Definición formal

( Esta definición puede extenderse a cualquier distribución de probabilidad utilizando la definición de probabilidad basada en la teoría de la medida ) .

Una variable aleatoria con valores en un espacio medible (normalmente con los conjuntos de Borel como subconjuntos mesurables) tiene como distribución de probabilidad la medida X ∗ P en : la densidad de con respecto a una medida de referencia en es la derivada de Radon–Nikodym :

Es decir, f es cualquier función medible con la propiedad de que: para cualquier conjunto medible

Discusión

En el caso univariado continuo anterior, la medida de referencia es la medida de Lebesgue . La función de masa de probabilidad de una variable aleatoria discreta es la densidad con respecto a la medida de conteo sobre el espacio muestral (normalmente el conjunto de números enteros o algún subconjunto de este).

No es posible definir una densidad con referencia a una medida arbitraria (por ejemplo, no se puede elegir la medida de conteo como referencia para una variable aleatoria continua). Además, cuando existe, la densidad es casi única, lo que significa que dos de esas densidades coinciden casi en todas partes .

Más detalles

A diferencia de una probabilidad, una función de densidad de probabilidad puede tomar valores mayores que uno; por ejemplo, la distribución uniforme continua en el intervalo [0, 1/2] tiene una densidad de probabilidad f ( x ) = 2 para 0 ≤ x ≤ 1/2 y f ( x ) = 0 en el resto del tiempo.

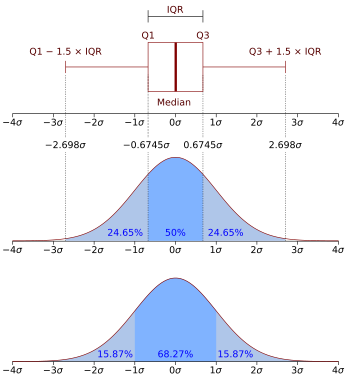

La distribución normal estándar tiene densidad de probabilidad

Si se da una variable aleatoria X y su distribución admite una función de densidad de probabilidad f , entonces el valor esperado de X (si el valor esperado existe) se puede calcular como

No todas las distribuciones de probabilidad tienen una función de densidad: las distribuciones de variables aleatorias discretas no la tienen, ni tampoco la distribución de Cantor , aunque no tiene ningún componente discreto, es decir, no asigna probabilidad positiva a ningún punto individual.

Una distribución tiene una función de densidad si y solo si su función de distribución acumulativa F ( x ) es absolutamente continua . En este caso: F es diferenciable en casi todas partes y su derivada puede utilizarse como densidad de probabilidad:

Si una distribución de probabilidad admite una densidad, entonces la probabilidad de cada conjunto de un punto { a } es cero; lo mismo vale para los conjuntos finitos y contables.

Dos densidades de probabilidad f y g representan la misma distribución de probabilidad precisamente si difieren sólo en un conjunto de medida de Lebesgue cero .

En el campo de la física estadística , generalmente se utiliza como definición de la función de densidad de probabilidad una reformulación no formal de la relación anterior entre la derivada de la función de distribución acumulativa y la función de densidad de probabilidad. Esta definición alternativa es la siguiente:

Si dt es un número infinitamente pequeño, la probabilidad de que X esté incluido dentro del intervalo ( t , t + dt ) es igual a f ( t ) dt , o:

Relación entre distribuciones discretas y continuas

Es posible representar ciertas variables aleatorias discretas, así como variables aleatorias que involucran tanto una parte continua como una discreta, con una función de densidad de probabilidad generalizada utilizando la función delta de Dirac . (Esto no es posible con una función de densidad de probabilidad en el sentido definido anteriormente, se puede hacer con una distribución ). Por ejemplo, considere una variable aleatoria discreta binaria que tiene la distribución de Rademacher , es decir, que toma −1 o 1 como valores, con probabilidad 1 ⁄ 2 cada uno. La densidad de probabilidad asociada con esta variable es:

De manera más general, si una variable discreta puede tomar n valores diferentes entre números reales, entonces la función de densidad de probabilidad asociada es: donde son los valores discretos accesibles a la variable y son las probabilidades asociadas con estos valores.

Esto unifica sustancialmente el tratamiento de las distribuciones de probabilidad discretas y continuas. La expresión anterior permite determinar las características estadísticas de una variable discreta de este tipo (como la media , la varianza y la curtosis ), a partir de las fórmulas dadas para una distribución continua de la probabilidad.

Familias de densidades

Es común que las funciones de densidad de probabilidad (y las funciones de masa de probabilidad ) estén parametrizadas, es decir, que se caractericen por parámetros no especificados . Por ejemplo, la distribución normal está parametrizada en términos de la media y la varianza , denotadas por y respectivamente, dando la familia de densidades Diferentes valores de los parámetros describen diferentes distribuciones de diferentes variables aleatorias en el mismo espacio muestral (el mismo conjunto de todos los valores posibles de la variable); este espacio muestral es el dominio de la familia de variables aleatorias que describe esta familia de distribuciones. Un conjunto dado de parámetros describe una única distribución dentro de la familia que comparte la forma funcional de la densidad. Desde la perspectiva de una distribución dada, los parámetros son constantes, y los términos en una función de densidad que contienen solo parámetros, pero no variables, son parte del factor de normalización de una distribución (el factor multiplicativo que asegura que el área bajo la densidad (la probabilidad de que ocurra algo en el dominio) sea igual a 1). Este factor de normalización está fuera del núcleo de la distribución.

Dado que los parámetros son constantes, repararetrizar una densidad en términos de diferentes parámetros para dar una caracterización de una variable aleatoria diferente en la familia, significa simplemente sustituir los nuevos valores de los parámetros en la fórmula en lugar de los antiguos.

Densidades asociadas a múltiples variables

Para las variables aleatorias continuas X 1 , ..., X n , también es posible definir una función de densidad de probabilidad asociada al conjunto en su conjunto, a menudo llamada función de densidad de probabilidad conjunta . Esta función de densidad se define como una función de las n variables, de modo que, para cualquier dominio D en el espacio n -dimensional de los valores de las variables X 1 , ..., X n , la probabilidad de que una realización de las variables del conjunto caiga dentro del dominio D es

Si F ( x 1 , ..., x n ) = Pr( X 1 ≤ x 1 , ..., X n ≤ x n ) es la función de distribución acumulativa del vector ( X 1 , ..., X n ) , entonces la función de densidad de probabilidad conjunta se puede calcular como una derivada parcial

Densidades marginales

Para i = 1, 2, ..., n , sea f X i ( x i ) la función de densidad de probabilidad asociada únicamente a la variable X i . Esta se denomina función de densidad marginal y se puede deducir a partir de la densidad de probabilidad asociada a las variables aleatorias X 1 , ..., X n integrando sobre todos los valores de las otras n − 1 variables:

Independencia

Las variables aleatorias continuas X 1 , ..., X n que admiten una densidad conjunta son todas independientes entre sí si y solo si

Corolario

Si la función de densidad de probabilidad conjunta de un vector de n variables aleatorias se puede factorizar en un producto de n funciones de una variable (donde cada f i no es necesariamente una densidad), entonces las n variables en el conjunto son todas independientes entre sí, y la función de densidad de probabilidad marginal de cada una de ellas está dada por

Ejemplo

Este ejemplo elemental ilustra la definición anterior de funciones de densidad de probabilidad multidimensionales en el caso simple de una función de un conjunto de dos variables. Llamemos a un vector aleatorio bidimensional de coordenadas ( X , Y ) : la probabilidad de obtener en el cuarto plano de x e y positivos es

Función de variables aleatorias y cambio de variables en la función de densidad de probabilidad

Si la función de densidad de probabilidad de una variable aleatoria (o vector) X se da como f X ( x ) , es posible (pero a menudo no necesario; ver más abajo) calcular la función de densidad de probabilidad de alguna variable Y = g ( X ) . Esto también se denomina "cambio de variable" y en la práctica se utiliza para generar una variable aleatoria de forma arbitraria f g ( X ) = f Y utilizando un generador de números aleatorios conocido (por ejemplo, uniforme).

Es tentador pensar que para encontrar el valor esperado E( g ( X )) , primero hay que encontrar la densidad de probabilidad f g ( X ) de la nueva variable aleatoria Y = g ( X ) . Sin embargo, en lugar de calcular, se puede encontrar

Los valores de las dos integrales son los mismos en todos los casos en los que tanto X como g ( X ) tienen funciones de densidad de probabilidad. No es necesario que g sea una función biunívoca . En algunos casos, la última integral se calcula mucho más fácilmente que la primera. Véase Ley del estadístico inconsciente .

De escalar a escalar

Sea una función monótona , entonces la función de densidad resultante es [5]

Aquí g −1 denota la función inversa .

Esto se deduce del hecho de que la probabilidad contenida en un área diferencial debe ser invariante ante cambios de variables. Es decir, o

Para funciones que no son monótonas, la función de densidad de probabilidad para y es donde n ( y ) es el número de soluciones en x para la ecuación , y son estas soluciones.

De vector a vector

Supóngase que x es una variable aleatoria n -dimensional con densidad conjunta f . Si y = G ( x ) , donde G es una función biyectiva , diferenciable , entonces y tiene densidad p Y : con la diferencial considerada como el jacobiano de la inversa de G (⋅) , evaluada en y . [6]

Por ejemplo, en el caso bidimensional x = ( x 1 , x 2 ) , supongamos que la transformada G se da como y 1 = G 1 ( x 1 , x 2 ) , y 2 = G 2 ( x 1 , x 2 ) con inversas x 1 = G 1 −1 ( y 1 , y 2 ) , x 2 = G 2 −1 ( y 1 , y 2 ) . La distribución conjunta para y = ( y 1 , y 2 ) tiene densidad [7]

Vector a escalar

Sea una función diferenciable y un vector aleatorio que toma valores en , la función de densidad de probabilidad de y la función delta de Dirac . Es posible utilizar las fórmulas anteriores para determinar , la función de densidad de probabilidad de , que estará dada por

Este resultado conduce a la ley del estadístico inconsciente :

Prueba:

Sea una variable aleatoria colapsada con función de densidad de probabilidad (es decir, una constante igual a cero). Sean el vector aleatorio y la transformada definidos como

Es claro que es una aplicación biyectiva, y el jacobiano de viene dado por: que es una matriz triangular superior con unos en la diagonal principal, por lo tanto su determinante es 1. Aplicando el teorema de cambio de variable de la sección anterior obtenemos que que si se marginaliza sobre conduce a la función de densidad de probabilidad deseada.

Sumas de variables aleatorias independientes

La función de densidad de probabilidad de la suma de dos variables aleatorias independientes U y V , cada una de las cuales tiene una función de densidad de probabilidad, es la convolución de sus funciones de densidad separadas:

Es posible generalizar la relación anterior a una suma de N variables aleatorias independientes, con densidades U 1 , ..., U N :

Esto se puede derivar de un cambio bidireccional de variables que involucran Y = U + V y Z = V , de manera similar al ejemplo siguiente para el cociente de variables aleatorias independientes.

Productos y cocientes de variables aleatorias independientes

Dadas dos variables aleatorias independientes U y V , cada una de las cuales tiene una función de densidad de probabilidad, la densidad del producto Y = UV y el cociente Y = U / V se puede calcular mediante un cambio de variables.

Ejemplo: distribución de cocientes

Para calcular el cociente Y = U / V de dos variables aleatorias independientes U y V , defina la siguiente transformación:

Luego, la densidad conjunta p ( y , z ) se puede calcular mediante un cambio de variables de U , V a Y , Z , e Y se puede derivar marginalizando Z de la densidad conjunta.

La transformación inversa es

El valor absoluto del determinante de la matriz jacobiana de esta transformación es:

De este modo:

Y la distribución de Y se puede calcular marginalizando Z :

Este método requiere fundamentalmente que la transformación de U , V a Y , Z sea biyectiva . La transformación anterior cumple con esto porque Z se puede mapear directamente de nuevo a V , y para un V dado el cociente U / V es monótono . Esto es similar al caso para la suma U + V , la diferencia U − V y el producto UV .

Se puede utilizar exactamente el mismo método para calcular la distribución de otras funciones de múltiples variables aleatorias independientes.

Ejemplo: Cociente de dos normales estándar

Dadas dos variables normales estándar U y V , el cociente se puede calcular de la siguiente manera. En primer lugar, las variables tienen las siguientes funciones de densidad:

Nos transformamos como se describe arriba:

Esto conduce a:

Esta es la densidad de una distribución de Cauchy estándar .

Véase también

- Estimación de densidad : estimación de una función de densidad de probabilidad subyacente no observable

- Estimación de la densidad del núcleo – EstimadorPages displaying short descriptions with no spaces

- Función de verosimilitud : función relacionada con la estadística y la teoría de la probabilidad.

- Lista de distribuciones de probabilidad

- Amplitud de probabilidad : Número complejo cuyo valor absoluto al cuadrado es una probabilidad

- Función de masa de probabilidad – Distribución de probabilidad de variable discreta

- Medida secundaria

- Utiliza como densidad de probabilidad de posición :

- Orbital atómico : Función que describe un electrón en un átomo.

- Área de distribución : el área en la que un animal vive y se desplaza periódicamente.

Referencias

- ^ "AP Statistics Review - Curvas de densidad y distribuciones normales". Archivado desde el original el 2 de abril de 2015 . Consultado el 16 de marzo de 2015 .

- ^ Grinstead, Charles M.; Snell, J. Laurie (2009). "Probabilidad condicional - Condicional discreta" (PDF) . Introducción a la probabilidad de Grinstead y Snell . Textos de Orange Grove. ISBN 978-1616100469. Archivado (PDF) del original el 25 de abril de 2003. Consultado el 25 de julio de 2019 .

- ^ "probabilidad - ¿Es un número aleatorio uniforme sobre la línea real una distribución válida?". Validación cruzada . Consultado el 6 de octubre de 2021 .

- ^ Ord, JK (1972) Familias de distribuciones de frecuencias , Griffin. ISBN 0-85264-137-0 (por ejemplo, Tabla 5.1 y Ejemplo 5.4)

- ^ Siegrist, Kyle. "Transformaciones de variables aleatorias". LibreTexts Statistics . Consultado el 22 de diciembre de 2023 .

- ^ Devore, Jay L.; Berk, Kenneth N. (2007). Estadística matemática moderna con aplicaciones. Cengage. pág. 263. ISBN 978-0-534-40473-4.

- ^ David, Stirzaker (1 de enero de 2007). Probabilidad elemental . Cambridge University Press. ISBN 978-0521534284.OCLC 851313783 .

Lectura adicional

- Billingsley, Patrick (1979). Probabilidad y medida . Nueva York, Toronto, Londres: John Wiley and Sons. ISBN 0-471-00710-2.

- Casella, George ; Berger, Roger L. (2002). Inferencia estadística (segunda edición). Thomson Learning. págs. 34–37. ISBN 0-534-24312-6.

- Stirzaker, David (2003). Probabilidad elemental . Cambridge University Press. ISBN 0-521-42028-8.Los capítulos 7 a 9 tratan sobre variables continuas.

Enlaces externos

- Ushakov, NG (2001) [1994], "Densidad de una distribución de probabilidad", Enciclopedia de Matemáticas , EMS Press

- Weisstein, Eric W. "Función de densidad de probabilidad". MathWorld .

![{\displaystyle \Pr[a\leq X\leq b]=\int _{a}^{b}f_{X}(x)\,dx.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/45fd7691b5fbd323f64834d8e5b8d4f54c73a6f8)

![{\estilo de visualización [x,x+dx]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f07271dbe3f8967834a2eaf143decd7e41c61d7a)

![{\displaystyle \Pr[X\in A]=\int _{X^{-1}A}\,dP=\int _{A}f\,d\mu }](https://wikimedia.org/api/rest_v1/media/math/render/svg/591b4a96fefea18b28fe8eb36d3469ad6b33a9db)

![{\displaystyle \operatorname {E} [X]=\int _{-\infty }^{\infty }x\,f(x)\,dx.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/00ce7a00fac378eafc98afb88de88d619e15e996)

![{\displaystyle p_{Y}(\mathbf {y} )=f{\Bigl (}G^{-1}(\mathbf {y} ){\Bigr )}\left|\det \left[\left. {\frac {dG^{-1}(\mathbf {z} )}{d\mathbf {z} }}\right|_{\mathbf {z} =\mathbf {y} }\right]\right| }](https://wikimedia.org/api/rest_v1/media/math/render/svg/48cc1c800c9d64079df336d91594f175aa00dfa0)

![{\displaystyle \operatorname {E} _{Y}[Y]=\int _{\mathbb {R} }yf_{Y}(y)\,dy=\int _{\mathbb {R} }y\int _{\mathbb {R} ^{n}}f_{X}(\mathbf {x} )\delta {\big (}yV(\mathbf {x} ){\big )}\,d\mathbf {x} \,dy=\int _{{\mathbb {R} }^{n}}\int _{\mathbb {R} }yf_{X}(\mathbf {x} )\delta {\big (}yV(\mathbf {x} ){\big )}\,dy\,d\mathbf {x} =\int _{\mathbb {R} ^{n}}V(\mathbf {x} )f_{X}(\mathbf {x} )\,d\mathbf {x} =\nombredeloperador {E} _{X}[V(X)].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ad5325e96f2d76c533cb1a21d2095e8cf16e6fc7)

![{\displaystyle {\begin{aligned}Y&=U/V\\[1ex]Z&=V\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/878eef546b1fb56d8cd6843edf0d6666642a77e2)

![{\displaystyle {\begin{aligned}p(u)&={\frac {1}{\sqrt {2\pi }}}e^{-{u^{2}}/{2}}\\[1ex]p(v)&={\frac {1}{\sqrt {2\pi }}}e^{-{v^{2}}/{2}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ad1edf70beff1658f6db7cafd4dd84111b4d3c0c)

![{\displaystyle {\begin{aligned}p(y)&=\int _{-\infty }^{\infty }p_{U}(yz)\,p_{V}(z)\,|z|\ ,dz\\[5pt]&=\int _{-\infty }^{\infty }{\frac {1}{\sqrt {2\pi }}}e^{-{\frac {1}{2 }}y^{2}z^{2}}{\frac {1}{\sqrt {2\pi }}}e^{-{\frac {1}{2}}z^{2}}| z|\,dz\\[5pt]&=\int _{-\infty }^{\infty }{\frac {1}{2\pi }}e^{-{\frac {1}{2}}\izquierda(y^{2}+1\derecha)z^{2}}|z|\,dz\\[5pt]&=2\int _{0}^{\infty }{\frac {1}{2\pi }}e^{-{\frac {1}{2}}\left(y^{2}+1\right)z^{2}}z\,dz \\[5pt]&=\int _{0}^{\infty }{\frac {1}{\pi }}e^{-\left(y^{2}+1\right)u}\, du&&u={\tfrac {1}{2}}z^{2}\\[5pt]&=\left.-{\frac {1}{\pi \left(y^{2}+1\right) }}e^{-\left(y^{2}+1\right)u}\right|_{u=0}^{\infty }\\[5pt]&={\frac {1}{\pi \left(y^{2}+1\right)}}\end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/63983efb2501c35f094487a9c6473a30e9405551)