Análisis de componentes principales

| Parte de una serie sobre |

| Aprendizaje automático y minería de datos |

|---|

El análisis de componentes principales ( PCA ) es una técnica de reducción de dimensionalidad lineal con aplicaciones en el análisis exploratorio de datos , visualización y preprocesamiento de datos .

Los datos se transforman linealmente en un nuevo sistema de coordenadas de modo que las direcciones (componentes principales) que capturan la mayor variación en los datos se puedan identificar fácilmente.

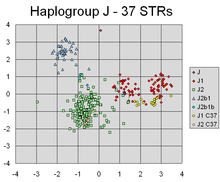

Los componentes principales de una colección de puntos en un espacio de coordenadas real son una secuencia de vectores unitarios , donde el -ésimo vector es la dirección de una línea que se ajusta mejor a los datos mientras es ortogonal a los primeros vectores. Aquí, una línea de mejor ajuste se define como aquella que minimiza la distancia perpendicular al cuadrado promedio de los puntos a la línea . Estas direcciones (es decir, componentes principales) constituyen una base ortonormal en la que diferentes dimensiones individuales de los datos no están correlacionadas linealmente . Muchos estudios utilizan los dos primeros componentes principales para representar gráficamente los datos en dos dimensiones e identificar visualmente grupos de puntos de datos estrechamente relacionados. [1]

El análisis de componentes principales tiene aplicaciones en muchos campos, como la genética de poblaciones , los estudios del microbioma y la ciencia atmosférica .

Descripción general

Al realizar el ACP, el primer componente principal de un conjunto de variables es la variable derivada formada como una combinación lineal de las variables originales que explica la mayor varianza. El segundo componente principal explica la mayor varianza de lo que queda una vez que se elimina el efecto del primer componente, y podemos continuar con iteraciones hasta que se explique toda la varianza. El ACP se utiliza con mayor frecuencia cuando muchas de las variables están altamente correlacionadas entre sí y es deseable reducir su número a un conjunto independiente. El primer componente principal se puede definir de manera equivalente como una dirección que maximiza la varianza de los datos proyectados. El -ésimo componente principal se puede tomar como una dirección ortogonal a los primeros componentes principales que maximiza la varianza de los datos proyectados.

Para cualquiera de los objetivos, se puede demostrar que los componentes principales son vectores propios de la matriz de covarianza de los datos . Por lo tanto, los componentes principales a menudo se calculan mediante la descomposición propia de la matriz de covarianza de los datos o la descomposición en valores singulares de la matriz de datos. El PCA es el más simple de los verdaderos análisis multivariados basados en vectores propios y está estrechamente relacionado con el análisis factorial . El análisis factorial normalmente incorpora suposiciones más específicas del dominio sobre la estructura subyacente y resuelve vectores propios de una matriz ligeramente diferente. El PCA también está relacionado con el análisis de correlación canónica (CCA) . El CCA define sistemas de coordenadas que describen de forma óptima la covarianza cruzada entre dos conjuntos de datos, mientras que el PCA define un nuevo sistema de coordenadas ortogonales que describe de forma óptima la varianza en un único conjunto de datos. [2] [3] [4] [5] También se han propuesto variantes robustas y basadas en la norma L1 del PCA estándar. [6] [7] [8] [5]

Historia

El PCA fue inventado en 1901 por Karl Pearson , [9] como un análogo del teorema del eje principal en mecánica; luego fue desarrollado independientemente y nombrado por Harold Hotelling en la década de 1930. [10] Dependiendo del campo de aplicación, también se le denomina transformada discreta de Karhunen–Loève (KLT) en procesamiento de señales , transformada de Hotelling en control de calidad multivariante, descomposición ortogonal adecuada (POD) en ingeniería mecánica, descomposición en valores singulares (SVD) de X (inventada en el último cuarto del siglo XIX [11] ), descomposición en valores propios (EVD) de X T X en álgebra lineal, análisis factorial (para una discusión de las diferencias entre PCA y análisis factorial, véase el Cap. 7 del Análisis de componentes principales de Jolliffe ), [12] teorema de Eckart–Young (Harman, 1960) o funciones ortogonales empíricas (EOF) en ciencia meteorológica (Lorenz, 1956), descomposición empírica de funciones propias (Sirovich, 1987), modos cuasairmónicos (Brooks et al., 1988), descomposición espectral en ruido y vibración, y análisis modal empírico en dinámica estructural.

Intuición

Se puede pensar en el PCA como el ajuste de un elipsoide p -dimensional a los datos, donde cada eje del elipsoide representa un componente principal. Si algún eje del elipsoide es pequeño, entonces la varianza a lo largo de ese eje también es pequeña.

Para encontrar los ejes del elipsoide, primero debemos centrar los valores de cada variable en el conjunto de datos en 0 restando la media de los valores observados de la variable de cada uno de esos valores. Estos valores transformados se utilizan en lugar de los valores observados originales para cada una de las variables. Luego, calculamos la matriz de covarianza de los datos y calculamos los valores propios y los vectores propios correspondientes de esta matriz de covarianza. Luego debemos normalizar cada uno de los vectores propios ortogonales para convertirlos en vectores unitarios. Una vez hecho esto, cada uno de los vectores propios unitarios mutuamente ortogonales puede interpretarse como un eje del elipsoide ajustado a los datos. Esta elección de base transformará la matriz de covarianza en una forma diagonalizada, en la que los elementos diagonales representan la varianza de cada eje. La proporción de la varianza que representa cada vector propio puede calcularse dividiendo el valor propio correspondiente a ese vector propio por la suma de todos los valores propios.

Los diagramas de biplots y de sedimentación (grado de varianza explicada ) se utilizan para interpretar los resultados del PCA.

Detalles

PCA se define como una transformación lineal ortogonal en un espacio de producto interno real que transforma los datos a un nuevo sistema de coordenadas de modo que la mayor varianza según alguna proyección escalar de los datos llegue a estar en la primera coordenada (llamada primer componente principal), la segunda mayor varianza en la segunda coordenada, y así sucesivamente. [12]

Consideremos una matriz de datos , X , con media empírica cero en cada columna (la media de la muestra de cada columna se ha desplazado a cero), donde cada una de las n filas representa una repetición diferente del experimento y cada una de las p columnas proporciona un tipo particular de característica (por ejemplo, los resultados de un sensor particular).

Matemáticamente, la transformación se define mediante un conjunto de tamaños de vectores p -dimensionales de pesos o coeficientes que asignan cada vector de fila de X a un nuevo vector de puntuaciones de componentes principales , dado por

de tal manera que las variables individuales de t consideradas sobre el conjunto de datos heredan sucesivamente la máxima varianza posible de X , con cada vector de coeficientes w restringido a ser un vector unitario (donde usualmente se selecciona para que sea estrictamente menor que para reducir la dimensionalidad).

Lo anterior puede escribirse de manera equivalente en forma matricial como

donde , , y .

Primer componente

Para maximizar la varianza, el primer vector de peso w (1) debe satisfacer

De manera equivalente, escribir esto en forma de matriz da

Dado que w (1) se ha definido como un vector unitario, también satisface de manera equivalente

La cantidad que se debe maximizar se puede reconocer como un cociente de Rayleigh . Un resultado estándar para una matriz semidefinida positiva como X T X es que el valor máximo posible del cociente es el valor propio más grande de la matriz, lo que ocurre cuando w es el vector propio correspondiente .

Con w (1) encontrado, el primer componente principal de un vector de datos x ( i ) se puede dar como una puntuación t 1( i ) = x ( i ) ⋅ w (1) en las coordenadas transformadas, o como el vector correspondiente en las variables originales, { x ( i ) ⋅ w (1) } w (1) .

Otros componentes

El componente k -ésimo se puede encontrar restando los primeros k − 1 componentes principales de X :

y luego encontrar el vector de peso que extrae la varianza máxima de esta nueva matriz de datos

Resulta que esto da los vectores propios restantes de X T X , con los valores máximos para la cantidad entre paréntesis dados por sus valores propios correspondientes. Por lo tanto, los vectores de peso son vectores propios de X T X .

Por lo tanto, el k -ésimo componente principal de un vector de datos x ( i ) se puede dar como una puntuación t k ( i ) = x ( i ) ⋅ w ( k ) en las coordenadas transformadas, o como el vector correspondiente en el espacio de las variables originales, { x ( i ) ⋅ w ( k ) } w ( k ) , donde w ( k ) es el k -ésimo vector propio de X T X .

Por lo tanto, la descomposición completa de los componentes principales de X se puede expresar como

donde W es una matriz p por p de pesos cuyas columnas son los vectores propios de X T X . La transpuesta de W a veces se denomina transformación de blanqueamiento o esferización . Las columnas de W multiplicadas por la raíz cuadrada de los valores propios correspondientes, es decir, los vectores propios ampliados por las varianzas, se denominan cargas en el ACP o en el análisis factorial.

Covarianzas

X T X en sí puede reconocerse como proporcional a la matriz de covarianza de muestra empírica del conjunto de datos X T . [12] : 30–31

La covarianza de muestra Q entre dos de los diferentes componentes principales del conjunto de datos viene dada por:

donde la propiedad de valor propio de w ( k ) se ha utilizado para pasar de la línea 2 a la línea 3. Sin embargo, los vectores propios w ( j ) y w ( k ) correspondientes a los valores propios de una matriz simétrica son ortogonales (si los valores propios son diferentes), o pueden ortogonalizarse (si los vectores comparten un valor repetido igual). Por lo tanto, el producto en la línea final es cero; no hay covarianza muestral entre los diferentes componentes principales en el conjunto de datos.

Otra forma de caracterizar la transformación de componentes principales es, por tanto, como la transformación en coordenadas que diagonalizan la matriz de covarianza de la muestra empírica.

En forma de matriz, la matriz de covarianza empírica para las variables originales se puede escribir

La matriz de covarianza empírica entre los componentes principales se convierte en

donde Λ es la matriz diagonal de valores propios λ ( k ) de X T X . λ ( k ) es igual a la suma de los cuadrados sobre el conjunto de datos asociado con cada componente k , es decir, λ ( k ) = Σ i t k 2 ( i ) = Σ i ( x ( i ) ⋅ w ( k ) ) 2 .

Reducción de dimensionalidad

La transformación T = X W asigna un vector de datos x ( i ) de un espacio original de p variables a un nuevo espacio de p variables que no están correlacionadas en el conjunto de datos. Sin embargo, no es necesario conservar todos los componentes principales. Si se conservan solo los primeros L componentes principales, obtenidos utilizando solo los primeros L vectores propios, se obtiene la transformación truncada.

donde la matriz T L ahora tiene n filas pero solo L columnas. En otras palabras, PCA aprende una transformación lineal donde las columnas de la matriz p × L forman una base ortogonal para las L características (los componentes de la representación t ) que están decorrelacionadas. [13] Por construcción, de todas las matrices de datos transformadas con solo L columnas, esta matriz de puntuación maximiza la varianza en los datos originales que se han conservado, mientras minimiza el error de reconstrucción cuadrático total o .

Esta reducción de la dimensionalidad puede ser un paso muy útil para visualizar y procesar conjuntos de datos de alta dimensión, manteniendo al mismo tiempo la mayor cantidad posible de varianza en el conjunto de datos. Por ejemplo, al seleccionar L = 2 y mantener solo los dos primeros componentes principales, se encuentra el plano bidimensional a través del conjunto de datos de alta dimensión en el que los datos están más dispersos, por lo que si los datos contienen conglomerados, estos también pueden estar más dispersos y, por lo tanto, ser más visibles para ser representados en un diagrama bidimensional; mientras que si se eligen al azar dos direcciones a través de los datos (o dos de las variables originales), los conglomerados pueden estar mucho menos dispersos entre sí y, de hecho, puede ser mucho más probable que se superpongan sustancialmente entre sí, haciéndolos indistinguibles.

De manera similar, en el análisis de regresión , cuanto mayor sea el número de variables explicativas permitidas, mayor será la probabilidad de sobreajustar el modelo, lo que produciría conclusiones que no se pueden generalizar a otros conjuntos de datos. Un enfoque, especialmente cuando existen fuertes correlaciones entre diferentes posibles variables explicativas, es reducirlas a unos pocos componentes principales y luego ejecutar la regresión contra ellas, un método llamado regresión de componentes principales .

La reducción de la dimensionalidad también puede ser apropiada cuando las variables en un conjunto de datos son ruidosas. Si cada columna del conjunto de datos contiene ruido gaussiano distribuido idénticamente e independiente, entonces las columnas de T también contendrán ruido gaussiano distribuido idénticamente de manera similar (tal distribución es invariante bajo los efectos de la matriz W , que puede considerarse como una rotación de alta dimensión de los ejes de coordenadas). Sin embargo, con una mayor parte de la varianza total concentrada en los primeros componentes principales en comparación con la misma varianza del ruido, el efecto proporcional del ruido es menor: los primeros componentes logran una mayor relación señal-ruido . Por lo tanto, el PCA puede tener el efecto de concentrar gran parte de la señal en los primeros componentes principales, que pueden capturarse de manera útil mediante la reducción de la dimensionalidad; mientras que los componentes principales posteriores pueden estar dominados por el ruido y, por lo tanto, eliminarse sin grandes pérdidas. Si el conjunto de datos no es demasiado grande, la importancia de los componentes principales se puede probar utilizando el bootstrap paramétrico , como una ayuda para determinar cuántos componentes principales retener. [14]

Descomposición en valores singulares

La transformación de componentes principales también se puede asociar con otra factorización matricial, la descomposición en valores singulares (SVD) de X ,

Aquí Σ es una matriz diagonal rectangular de n por p de números positivos σ ( k ) , llamados valores singulares de X ; U es una matriz de n por n , cuyas columnas son vectores unitarios ortogonales de longitud n llamados vectores singulares izquierdos de X ; y W es una matriz de p por p cuyas columnas son vectores unitarios ortogonales de longitud p y llamados vectores singulares derechos de X .

En términos de esta factorización, la matriz X T X puede escribirse

donde es la matriz diagonal cuadrada con los valores singulares de X y los ceros sobrantes eliminados que satisface . La comparación con la factorización de vectores propios de X T X establece que los vectores singulares derechos W de X son equivalentes a los vectores propios de X T X , mientras que los valores singulares σ ( k ) de son iguales a la raíz cuadrada de los valores propios λ ( k ) de X T X .

Utilizando la descomposición en valores singulares, la matriz de puntuación T se puede escribir

De modo que cada columna de T está dada por uno de los vectores singulares izquierdos de X multiplicado por el valor singular correspondiente. Esta forma es también la descomposición polar de T.

Existen algoritmos eficientes para calcular la SVD de X sin tener que formar la matriz X T X , por lo que calcular la SVD es ahora la forma estándar de calcular un análisis de componentes principales a partir de una matriz de datos, [15] a menos que solo se requieran unos pocos componentes.

Al igual que con la descomposición propia, se puede obtener una matriz de puntuación truncada n × L T L considerando solo los primeros L valores singulares más grandes y sus vectores singulares:

El truncamiento de una matriz M o T utilizando una descomposición en valores singulares truncados de esta manera produce una matriz truncada que es la matriz de rango L más cercana posible a la matriz original, en el sentido de que la diferencia entre las dos tiene la norma de Frobenius más pequeña posible , un resultado conocido como el teorema de Eckart-Young [1936].

Consideraciones adicionales

Los valores singulares (en Σ ) son las raíces cuadradas de los valores propios de la matriz X T X . Cada valor propio es proporcional a la porción de la "varianza" (más correctamente de la suma de las distancias al cuadrado de los puntos desde su media multidimensional) que está asociada con cada vector propio. La suma de todos los valores propios es igual a la suma de las distancias al cuadrado de los puntos desde su media multidimensional. El PCA esencialmente rota el conjunto de puntos alrededor de su media para alinearlo con los componentes principales. Esto mueve la mayor parte posible de la varianza (usando una transformación ortogonal) a las primeras dimensiones. Los valores en las dimensiones restantes, por lo tanto, tienden a ser pequeños y se pueden descartar con una pérdida mínima de información (ver más abajo ). El PCA se usa a menudo de esta manera para la reducción de dimensionalidad . El PCA tiene la distinción de ser la transformación ortogonal óptima para mantener el subespacio que tiene la "varianza" más grande (como se define arriba). Esta ventaja, sin embargo, se produce a costa de mayores requisitos computacionales si se compara, por ejemplo, y cuando es aplicable, con la transformada discreta del coseno , y en particular con la DCT-II, que se conoce simplemente como "DCT". Las técnicas de reducción de dimensionalidad no lineal tienden a ser más exigentes computacionalmente que el PCA.

El PCA es sensible a la escala de las variables. Si tenemos sólo dos variables y tienen la misma varianza muestral y están completamente correlacionadas, entonces el PCA implicará una rotación de 45° y los "pesos" (son los cosenos de rotación) para las dos variables con respecto al componente principal serán iguales. Pero si multiplicamos todos los valores de la primera variable por 100, entonces el primer componente principal será casi el mismo que esa variable, con una pequeña contribución de la otra variable, mientras que el segundo componente estará casi alineado con la segunda variable original. Esto significa que siempre que las diferentes variables tengan unidades diferentes (como temperatura y masa), el PCA es un método de análisis algo arbitrario. (Se obtendrían resultados diferentes si se utilizara Fahrenheit en lugar de Celsius, por ejemplo). El artículo original de Pearson se titulaba "Sobre líneas y planos de ajuste más cercano a sistemas de puntos en el espacio"; "en el espacio" implica el espacio euclidiano físico donde no surgen tales preocupaciones. Una forma de hacer que el PCA sea menos arbitrario es utilizar variables escaladas de modo que tengan una varianza unitaria, estandarizando los datos y, por lo tanto, utilizando la matriz de autocorrelación en lugar de la matriz de autocovarianza como base para el PCA. Sin embargo, esto comprime (o expande) las fluctuaciones en todas las dimensiones del espacio de la señal a una varianza unitaria.

La resta de la media (también conocida como "centrado de la media") es necesaria para realizar el PCA clásico a fin de garantizar que el primer componente principal describa la dirección de la varianza máxima. Si no se realiza la resta de la media, el primer componente principal podría corresponder más o menos a la media de los datos. Se necesita una media de cero para encontrar una base que minimice el error cuadrático medio de la aproximación de los datos. [16]

El centrado en la media no es necesario si se realiza un análisis de componentes principales en una matriz de correlación, ya que los datos ya están centrados después de calcular las correlaciones. Las correlaciones se derivan del producto cruzado de dos puntuaciones estándar (puntuaciones Z) o momentos estadísticos (de ahí el nombre: correlación producto-momento de Pearson ). Véase también el artículo de Kromrey y Foster-Johnson (1998) sobre "Centrado en la media en la regresión moderada: mucho ruido y pocas nueces" . Dado que las covarianzas son correlaciones de variables normalizadas ( puntuaciones Z o estándar ), un PCA basado en la matriz de correlación de X es igual a un PCA basado en la matriz de covarianza de Z , la versión estandarizada de X.

El PCA es una técnica primaria popular en el reconocimiento de patrones . Sin embargo, no está optimizada para la separabilidad de clases. [17] Sin embargo, se ha utilizado para cuantificar la distancia entre dos o más clases calculando el centro de masa para cada clase en el espacio de componentes principales y reportando la distancia euclidiana entre el centro de masa de dos o más clases. [18] El análisis discriminante lineal es una alternativa que está optimizada para la separabilidad de clases.

Tabla de símbolos y abreviaturas

| Símbolo | Significado | Dimensiones | Índices |

|---|---|---|---|

| Matriz de datos, que consta del conjunto de todos los vectores de datos, un vector por fila. | | ||

| el número de vectores de fila en el conjunto de datos | escalar | ||

| el número de elementos en cada vector fila (dimensión) | escalar | ||

| el número de dimensiones en el subespacio dimensionalmente reducido, | escalar | ||

| vector de medias empíricas , una media para cada columna j de la matriz de datos | |||

| vector de desviaciones estándar empíricas , una desviación estándar por cada columna j de la matriz de datos | |||

| vector de todos los 1 | |||

| desviaciones de la media de cada columna j de la matriz de datos | | ||

| Puntuaciones z , calculadas utilizando la media y la desviación estándar para cada columna j de la matriz de datos | | ||

| matriz de covarianza | | ||

| matriz de correlación | | ||

| Matriz que consta del conjunto de todos los vectores propios de C , un vector propio por columna | | ||

| matriz diagonal que consiste en el conjunto de todos los valores propios de C a lo largo de su diagonal principal , y 0 para todos los demás elementos (nota utilizada arriba) | | ||

| matriz de vectores base, un vector por columna, donde cada vector base es uno de los vectores propios de C , y donde los vectores en W son un subconjunto de los de V | | ||

| matriz que consta de n vectores fila, donde cada vector es la proyección del vector de datos correspondiente de la matriz X sobre los vectores base contenidos en las columnas de la matriz W. | |

Propiedades y limitaciones

Propiedades

Algunas propiedades del PCA incluyen: [12] [ página necesaria ]

- Propiedad 1 : Para cualquier enteroq, 1 ≤q≤p, considere latransformación lineal

- donde es un vector de q elementos y es una matriz ( q × p ), y sea la matriz de varianza - covarianza para . Entonces, la traza de , denotada , se maximiza tomando , donde consiste en las primeras q columnas de es la transpuesta de . ( no se define aquí)

- Propiedad 2 : Consideremos nuevamente latransformación ortonormal

- con y definido como antes. Luego se minimiza tomando donde consta de las últimas q columnas de .

La implicación estadística de esta propiedad es que los últimos PC no son simplemente restos no estructurados después de eliminar los PC importantes. Debido a que estos últimos PC tienen varianzas lo más pequeñas posibles, son útiles por sí mismos. Pueden ayudar a detectar relaciones lineales casi constantes insospechadas entre los elementos de x , y también pueden ser útiles en la regresión , en la selección de un subconjunto de variables de x y en la detección de valores atípicos.

- Propiedad 3 : (Descomposición espectral de Σ )

Antes de analizar su uso, veamos primero los elementos diagonales ,

Entonces, quizás la principal implicación estadística del resultado es que no solo podemos descomponer las varianzas combinadas de todos los elementos de x en contribuciones decrecientes debidas a cada PC, sino que también podemos descomponer toda la matriz de covarianza en contribuciones de cada PC. Aunque no son estrictamente decrecientes, los elementos de tenderán a volverse más pequeños a medida que aumenta, ya que no son crecientes para , mientras que los elementos de tienden a permanecer aproximadamente del mismo tamaño debido a las restricciones de normalización: .

Limitaciones

Como se señaló anteriormente, los resultados del PCA dependen de la escala de las variables. Esto se puede solucionar escalando cada característica por su desviación estándar, de modo que se obtengan características adimensionales con varianza unitaria. [19]

La aplicabilidad del PCA como se describió anteriormente está limitada por ciertas suposiciones (tácitas) [20] realizadas en su derivación. En particular, el PCA puede capturar correlaciones lineales entre las características, pero falla cuando se viola esta suposición (consulte la Figura 6a en la referencia). En algunos casos, las transformaciones de coordenadas pueden restaurar la suposición de linealidad y luego se puede aplicar el PCA (consulte el PCA del núcleo ).

Otra limitación es el proceso de eliminación de la media antes de construir la matriz de covarianza para PCA. En campos como la astronomía, todas las señales son no negativas, y el proceso de eliminación de la media forzará a que la media de algunas exposiciones astrofísicas sea cero, lo que en consecuencia crea flujos negativos no físicos, [21] y se debe realizar un modelado hacia adelante para recuperar la verdadera magnitud de las señales. [22] Como método alternativo, la factorización matricial no negativa se centra solo en los elementos no negativos de las matrices, lo que es muy adecuado para las observaciones astrofísicas. [23] [24] [25] Ver más en Relación entre PCA y factorización matricial no negativa.

El PCA está en desventaja si los datos no han sido estandarizados antes de aplicarles el algoritmo. El PCA transforma los datos originales en datos que son relevantes para los componentes principales de esos datos, lo que significa que las nuevas variables de datos no pueden interpretarse de la misma manera que las originales. Son interpretaciones lineales de las variables originales. Además, si el PCA no se realiza correctamente, existe una alta probabilidad de pérdida de información. [26]

El PCA se basa en un modelo lineal. Si un conjunto de datos tiene un patrón oculto en su interior que no es lineal, el PCA puede en realidad dirigir el análisis en la dirección completamente opuesta al progreso. [27] [ página necesaria ] Los investigadores de la Universidad Estatal de Kansas descubrieron que el error de muestreo en sus experimentos influía en el sesgo de los resultados del PCA. "Si el número de sujetos o bloques es menor de 30, y/o el investigador está interesado en los PC más allá del primero, puede ser mejor corregir primero la correlación serial, antes de realizar el PCA". [28] Los investigadores de la Universidad Estatal de Kansas también descubrieron que el PCA podría estar "seriamente sesgado si la estructura de autocorrelación de los datos no se maneja correctamente". [28]

PCA y teoría de la información

En general, la reducción de dimensionalidad produce una pérdida de información. La reducción de dimensionalidad basada en PCA tiende a minimizar esa pérdida de información en determinados modelos de señal y ruido.

Bajo el supuesto de que

es decir, que el vector de datos es la suma de la señal portadora de información deseada y una señal de ruido. Se puede demostrar que PCA puede ser óptimo para la reducción de dimensionalidad, desde un punto de vista de teoría de la información.

En particular, Linsker demostró que si es gaussiano y es ruido gaussiano con una matriz de covarianza proporcional a la matriz identidad, el PCA maximiza la información mutua entre la información deseada y la salida de dimensionalidad reducida . [29]

Si el ruido sigue siendo gaussiano y tiene una matriz de covarianza proporcional a la matriz identidad (es decir, los componentes del vector son iid ), pero la señal portadora de información no es gaussiana (lo cual es un escenario común), PCA al menos minimiza un límite superior en la pérdida de información , que se define como [30] [31]

La optimalidad de PCA también se conserva si el ruido es iid y al menos más gaussiano (en términos de la divergencia de Kullback–Leibler ) que la señal portadora de información . [32] En general, incluso si se cumple el modelo de señal anterior, PCA pierde su optimalidad teórica de la información tan pronto como el ruido se vuelve dependiente.

Cálculo mediante el método de covarianza

A continuación se presenta una descripción detallada del PCA utilizando el método de covarianza [33] en oposición al método de correlación. [34]

El objetivo es transformar un conjunto de datos X de dimensión p en un conjunto de datos alternativo Y de dimensión menor L. De manera equivalente, buscamos encontrar la matriz Y , donde Y es la transformada de Karhunen–Loève (KLT) de la matriz X :

- Organizar el conjunto de datos

Supongamos que disponemos de datos que comprenden un conjunto de observaciones de p variables y que queremos reducir los datos de modo que cada observación pueda describirse con solo L variables, L < p . Supongamos, además, que los datos están organizados como un conjunto de n vectores de datos , cada uno de los cuales representa una única observación agrupada de las p variables.

- Escribe como vectores fila, cada uno con p elementos.

- Coloque los vectores de fila en una sola matriz X de dimensiones n × p .

- Calcular la media empírica

- Encuentra la media empírica a lo largo de cada columna j = 1, ..., p .

- Coloque los valores medios calculados en un vector de media empírica u de dimensiones p × 1.

- Calcular las desviaciones de la media

La resta de la media es una parte integral de la solución para encontrar una base de componentes principales que minimice el error cuadrático medio al aproximar los datos. [35] Por lo tanto, procedemos centrando los datos de la siguiente manera:

- Restar el vector de media empírica de cada fila de la matriz de datos X.

- Almacene los datos con la media restada en la matriz n × p B , donde h es un vector columna n × 1 de todos 1:

En algunas aplicaciones, cada variable (columna de B ) también puede escalarse para tener una varianza igual a 1 (ver puntuación Z ). [36] Este paso afecta a los componentes principales calculados, pero los hace independientes de las unidades utilizadas para medir las diferentes variables.

- Encuentra la matriz de covarianza

- Encuentre la matriz de covarianza empírica p × p C a partir de la matriz B : donde es el operador de transposición conjugada . Si B consiste completamente en números reales, lo que sucede en muchas aplicaciones, la "transposición conjugada" es lo mismo que la transposición regular .

- El razonamiento detrás del uso de n − 1 en lugar de n para calcular la covarianza es la corrección de Bessel .

- Encuentra los vectores propios y los valores propios de la matriz de covarianza

- Calcular la matriz V de vectores propios que diagonaliza la matriz de covarianza C : donde D es la matriz diagonal de valores propios de C . Este paso normalmente implicará el uso de un algoritmo informático para calcular vectores propios y valores propios . Estos algoritmos están disponibles como subcomponentes de la mayoría de los sistemas de álgebra matricial , como SAS , [37] R , MATLAB , [38] [39] Mathematica , [40] SciPy , IDL ( Interactive Data Language ) o GNU Octave , así como OpenCV .

- La matriz D tomará la forma de una matriz diagonal p × p , donde es el j -ésimo valor propio de la matriz de covarianza C , y

- La matriz V , también de dimensión p × p , contiene p vectores columna, cada uno de longitud p , que representan los p vectores propios de la matriz de covarianza C.

- Los valores propios y los vectores propios están ordenados y emparejados. El j -ésimo valor propio corresponde al j -ésimo vector propio.

- La matriz V denota la matriz de vectores propios derechos (en contraposición a los vectores propios izquierdos ). En general, la matriz de vectores propios derechos no necesita ser la transpuesta (conjugada) de la matriz de vectores propios izquierdos.

- Reorganizar los vectores propios y los valores propios

- Ordene las columnas de la matriz de vectores propios V y la matriz de valores propios D en orden de valor propio decreciente .

- Asegúrese de mantener los emparejamientos correctos entre las columnas de cada matriz.

- Calcular el contenido de energía acumulada para cada vector propio

- Los valores propios representan la distribución de la energía de los datos de origen [ aclaración necesaria ] entre cada uno de los vectores propios, donde los vectores propios forman una base para los datos. El contenido de energía acumulada g para el j -ésimo vector propio es la suma del contenido de energía en todos los valores propios desde 1 hasta j : [ cita requerida ]

- Seleccione un subconjunto de los vectores propios como vectores base

- Guarde las primeras L columnas de V como la matriz p × L W : donde

- Utilice el vector g como guía para elegir un valor adecuado para L. El objetivo es elegir un valor de L lo más pequeño posible y lograr un valor de g razonablemente alto en términos porcentuales. Por ejemplo, puede elegir L de modo que la energía acumulada g sea superior a un cierto umbral, como el 90 por ciento. En este caso, elija el valor más pequeño de L de modo que

- Proyectar los datos sobre la nueva base

- Los puntos de datos proyectados son las filas de la matriz.

Derivación mediante el método de covarianza

Sea X un vector aleatorio de dimensión d expresado como vector columna. Sin pérdida de generalidad, supongamos que X tiene media cero.

Queremos encontrar una matriz de transformación ortonormal P d × d tal que PX tenga una matriz de covarianza diagonal (es decir, PX es un vector aleatorio con todos sus componentes distintos no correlacionados por pares).

Un cálculo rápido suponiendo que los rendimientos son unitarios:

Por lo tanto, se cumple si y sólo si fueran diagonalizables por .

Esto es muy constructivo, ya que se garantiza que cov( X ) es una matriz definida no negativa y, por lo tanto, se garantiza que es diagonalizable por alguna matriz unitaria.

Cálculo sin covarianza

En implementaciones prácticas, especialmente con datos de alta dimensión ( p grande ), el método de covarianza ingenuo rara vez se utiliza porque no es eficiente debido a los altos costos computacionales y de memoria de determinar explícitamente la matriz de covarianza. El enfoque libre de covarianza evita las np 2 operaciones de calcular y almacenar explícitamente la matriz de covarianza X T X , en su lugar utiliza uno de los métodos libres de matriz , por ejemplo, basado en la función que evalúa el producto X T (X r) al costo de 2 np operaciones.

Computación iterativa

Una forma de calcular el primer componente principal de manera eficiente [41] se muestra en el siguiente pseudocódigo, para una matriz de datos X con media cero, sin calcular nunca su matriz de covarianza.

r = un vector aleatorio de longitud p r = r / norma( r )hacer c veces: s = 0 (un vector de longitud p ) para cada fila x en X s = s + ( x ⋅ r ) x λ = r T s // λ es el valor propio error = |λ ⋅ r − s | r = s / norm( s ) salir si error < tolerancia regresar λ, r

Este algoritmo de iteración de potencia simplemente calcula el vector X T (X r) , normaliza y coloca el resultado nuevamente en r . El valor propio se aproxima por r T (X T X) r , que es el cociente de Rayleigh en el vector unitario r para la matriz de covarianza X T X . Si el valor singular más grande está bien separado del siguiente más grande, el vector r se acerca al primer componente principal de X dentro del número de iteraciones c , que es pequeño en relación con p , al costo total 2cnp . La convergencia de iteración de potencia se puede acelerar sin sacrificar notablemente el pequeño costo por iteración utilizando métodos sin matriz más avanzados , como el algoritmo de Lanczos o el método de gradiente conjugado precondicionado de bloque localmente óptimo ( LOBPCG ).

Los componentes principales subsiguientes se pueden calcular uno por uno mediante deflación o simultáneamente como un bloque. En el primer enfoque, las imprecisiones en los componentes principales aproximados ya calculados afectan de forma aditiva la precisión de los componentes principales calculados posteriormente, aumentando así el error con cada nuevo cálculo. El último enfoque en el método de potencia de bloque reemplaza los vectores individuales r y s con vectores de bloque, matrices R y S . Cada columna de R aproxima uno de los componentes principales principales, mientras que todas las columnas se iteran simultáneamente. El cálculo principal es la evaluación del producto X T (XR) . Implementado, por ejemplo, en LOBPCG , el bloqueo eficiente elimina la acumulación de errores, permite utilizar funciones de producto matriz-matriz BLAS de alto nivel y, por lo general, conduce a una convergencia más rápida, en comparación con la técnica de vector único uno por uno.

El método NIPALS

Los mínimos cuadrados parciales iterativos no lineales (NIPALS) son una variante de la iteración de potencia clásica con deflación de matriz por sustracción implementada para calcular los primeros componentes en un análisis de componentes principales o de mínimos cuadrados parciales . Para conjuntos de datos de muy alta dimensión, como los generados en las ciencias *ómicas (por ejemplo, genómica , metabolómica ), generalmente solo es necesario calcular los primeros PC. El algoritmo de mínimos cuadrados parciales iterativos no lineales (NIPALS) actualiza las aproximaciones iterativas a las puntuaciones y cargas principales t 1 y r 1 T mediante la iteración de potencia que se multiplica en cada iteración por X a la izquierda y a la derecha, es decir, se evita el cálculo de la matriz de covarianza, al igual que en la implementación sin matriz de las iteraciones de potencia a X T X , con base en la función que evalúa el producto X T (X r) = ((X r) T X) T .

La deflación de la matriz por sustracción se realiza restando el producto externo, t 1 r 1 T de X dejando la matriz residual deflacionada utilizada para calcular los PC principales posteriores. [42] Para matrices de datos grandes, o matrices que tienen un alto grado de colinealidad de columna, NIPALS sufre pérdida de ortogonalidad de los PC debido a errores de redondeo de precisión de la máquina acumulados en cada iteración y deflación de la matriz por sustracción. [43] Se aplica un algoritmo de reortogonalización de Gram-Schmidt tanto a las puntuaciones como a las cargas en cada paso de iteración para eliminar esta pérdida de ortogonalidad. [44] La dependencia de NIPALS de multiplicaciones de un solo vector no puede aprovechar BLAS de alto nivel y da como resultado una convergencia lenta para valores singulares principales agrupados; ambas deficiencias se resuelven en solucionadores de bloques sin matriz más sofisticados, como el método de gradiente conjugado preacondicionado de bloque localmente óptimo ( LOBPCG ).

Estimación en línea/secuencial

En una situación de “transmisión en línea” o “en tiempo real” en la que los datos llegan pieza por pieza en lugar de almacenarse en un solo lote, es útil realizar una estimación de la proyección de PCA que se pueda actualizar de manera secuencial. Esto se puede hacer de manera eficiente, pero requiere algoritmos diferentes. [45]

Variables cualitativas

En el ACP, es habitual que queramos introducir variables cualitativas como elementos complementarios. Por ejemplo, se han medido muchas variables cuantitativas en plantas. Para estas plantas, existen algunas variables cualitativas como, por ejemplo, la especie a la que pertenece la planta. Estos datos se sometieron al ACP para variables cuantitativas. Al analizar los resultados, es natural conectar los componentes principales con la variable cualitativa especie . Para ello, se producen los siguientes resultados.

- Identificación, en los planos factoriales, de las diferentes especies, por ejemplo, utilizando diferentes colores.

- Representación, en los planos factoriales, de los centros de gravedad de plantas pertenecientes a una misma especie.

- Para cada centro de gravedad y cada eje, valor p para juzgar la importancia de la diferencia entre el centro de gravedad y el origen.

Estos resultados son lo que se denomina introducir una variable cualitativa como elemento suplementario . Este procedimiento se detalla en Husson, Lê, & Pagès (2009) y Pagès (2013). Pocos software ofrecen esta opción de forma “automática”. Es el caso de SPAD que históricamente, siguiendo el trabajo de Ludovic Lebart , fue el primero en proponer esta opción, y del paquete R FactoMineR.

Aplicaciones

Inteligencia

La primera aplicación del análisis factorial fue la localización y medición de los componentes de la inteligencia humana. Se creía que la inteligencia tenía varios componentes no correlacionados, como la inteligencia espacial, la inteligencia verbal, la inducción, la deducción, etc., y que las puntuaciones de estos componentes podían deducirse mediante el análisis factorial a partir de los resultados de varias pruebas, para dar un índice único conocido como el cociente intelectual (CI). El psicólogo estadístico pionero Spearman desarrolló el análisis factorial en 1904 para su teoría de dos factores de la inteligencia, añadiendo una técnica formal a la ciencia de la psicometría . En 1924, Thurstone buscó 56 factores de inteligencia, desarrollando el concepto de edad mental. Las pruebas de CI estándar actuales se basan en este trabajo temprano. [46]

Diferenciación residencial

En 1949, Shevky y Williams introdujeron la teoría de la ecología factorial , que dominó los estudios de diferenciación residencial desde la década de 1950 hasta la de 1970. [47] Los barrios de una ciudad eran reconocibles o podían distinguirse entre sí por varias características que podían reducirse a tres mediante el análisis factorial. Estas se conocían como "rango social" (un índice de estatus ocupacional), "familismo" o tamaño de la familia y "etnicidad"; el análisis de conglomerados podía entonces aplicarse para dividir la ciudad en conglomerados o distritos según los valores de las tres variables factoriales clave. Se desarrolló una extensa literatura en torno a la ecología factorial en la geografía urbana, pero el enfoque pasó de moda después de 1980 por ser metodológicamente primitivo y tener poco lugar en los paradigmas geográficos posmodernos.

Uno de los problemas del análisis factorial siempre ha sido encontrar nombres convincentes para los diversos factores artificiales. En 2000, Flood revivió el enfoque de la ecología factorial para demostrar que el análisis de componentes principales realmente brindaba respuestas significativas de manera directa, sin recurrir a la rotación de factores. Los componentes principales eran en realidad variables duales o precios sombra de las "fuerzas" que empujan a las personas a acercarse o alejarse en las ciudades. El primer componente era la "accesibilidad", la clásica disyuntiva entre la demanda de viajes y la demanda de espacio, en torno a la cual se basa la economía urbana clásica. Los dos componentes siguientes eran la "desventaja", que mantiene a las personas de estatus similar en barrios separados (mediada por la planificación), y la etnicidad, donde las personas de orígenes étnicos similares tratan de ubicarse en el mismo lugar. [48]

Casi al mismo tiempo, la Oficina Australiana de Estadísticas definió distintos índices de ventajas y desventajas tomando el primer componente principal de conjuntos de variables clave que se consideraban importantes. Estos índices SEIFA se publican periódicamente para varias jurisdicciones y se utilizan con frecuencia en el análisis espacial. [49]

Índices de desarrollo

El PCA puede utilizarse como método formal para el desarrollo de índices. Como alternativa, se ha propuesto el análisis compuesto confirmatorio para desarrollar y evaluar índices. [50]

El Índice de Desarrollo Urbano fue desarrollado por PCA a partir de unos 200 indicadores de resultados de las ciudades en una encuesta de 1996 de 254 ciudades del mundo. El primer componente principal fue sujeto a una regresión iterativa, agregando las variables originales una por una hasta que se tuvo en cuenta aproximadamente el 90% de su variación. El índice utilizó finalmente unos 15 indicadores, pero fue un buen predictor de muchas más variables. Su valor comparativo concordaba muy bien con una evaluación subjetiva de la condición de cada ciudad. Los coeficientes de los elementos de infraestructura eran aproximadamente proporcionales a los costos promedio de proporcionar los servicios subyacentes, lo que sugiere que el Índice era en realidad una medida de la inversión física y social efectiva en la ciudad.

El Índice de Desarrollo Humano (IDH) a nivel de país del PNUD , que se publica desde 1990 y se utiliza ampliamente en estudios de desarrollo, [51] tiene coeficientes muy similares en indicadores similares, lo que sugiere firmemente que originalmente se construyó utilizando PCA.

Genética de poblaciones

En 1978, Cavalli-Sforza y otros fueron pioneros en el uso del análisis de componentes principales (PCA) para resumir datos sobre la variación de las frecuencias de los genes humanos en las distintas regiones. Los componentes mostraron patrones distintivos, incluidos gradientes y ondas sinusoidales. Ellos interpretaron estos patrones como resultado de eventos migratorios antiguos específicos.

Desde entonces, el PCA ha sido omnipresente en la genética de poblaciones, con miles de artículos que lo utilizan como mecanismo de visualización. La genética varía en gran medida según la proximidad, por lo que los dos primeros componentes principales en realidad muestran la distribución espacial y pueden usarse para mapear la ubicación geográfica relativa de diferentes grupos de población, mostrando así a los individuos que se han alejado de sus ubicaciones originales. [52]

El PCA en genética ha sido técnicamente controvertido, ya que la técnica se ha aplicado a variables discretas no normales y, a menudo, a marcadores alélicos binarios. La falta de medidas de error estándar en el PCA también es un impedimento para un uso más consistente. En agosto de 2022, el biólogo molecular Eran Elhaik publicó un artículo teórico en Scientific Reports en el que analizaba 12 aplicaciones del PCA. Concluyó que era fácil manipular el método, lo que, en su opinión, generaba resultados "erróneos, contradictorios y absurdos". En concreto, argumentó que los resultados obtenidos en genética de poblaciones se caracterizaban por la selección de los mejores resultados y el razonamiento circular . [53]

Investigación de mercados e índices de actitud

La investigación de mercados ha sido un amplio uso del PCA. Se utiliza para desarrollar puntuaciones de satisfacción o lealtad del cliente para productos y, mediante la agrupación, para desarrollar segmentos de mercado a los que se puedan dirigir campañas publicitarias, de la misma manera que la ecología factorial ubica áreas geográficas con características similares. [54]

El PCA transforma rápidamente grandes cantidades de datos en variables más pequeñas y fáciles de digerir que pueden analizarse con mayor rapidez y facilidad. En cualquier cuestionario de consumo hay una serie de preguntas diseñadas para obtener las actitudes de los consumidores, y los componentes principales buscan variables latentes subyacentes a esas actitudes. Por ejemplo, la Encuesta de Internet de Oxford de 2013 preguntó a 2000 personas sobre sus actitudes y creencias, y de estas preguntas los analistas extrajeron cuatro dimensiones de componentes principales, que identificaron como "escape", "redes sociales", "eficiencia" y "creación de problemas". [55]

Otro ejemplo de Joe Flood en 2008 extrajo un índice de actitud hacia la vivienda a partir de 28 preguntas sobre actitudes en una encuesta nacional de 2697 hogares en Australia. El primer componente principal representaba una actitud general hacia la propiedad y la posesión de una vivienda. El índice, o las preguntas sobre actitudes que incorporaba, podían incorporarse a un modelo lineal general de elección de tenencia. El determinante más fuerte del alquiler privado fue, con diferencia, el índice de actitud, más que los ingresos, el estado civil o el tipo de hogar. [56]

Finanzas cuantitativas

En finanzas cuantitativas , el PCA se utiliza [57] en la gestión del riesgo financiero y se ha aplicado a otros problemas como la optimización de carteras .

El PCA se utiliza comúnmente en problemas que involucran valores de renta fija y carteras , y derivados de tipos de interés . Las valoraciones aquí dependen de toda la curva de rendimiento , que comprende numerosos instrumentos altamente correlacionados, y el PCA se utiliza para definir un conjunto de componentes o factores que explican los movimientos de los tipos, [58] facilitando así el modelado. Una aplicación común de la gestión de riesgos es el cálculo del valor en riesgo , VaR, aplicando el PCA a la simulación de Monte Carlo . [59] Aquí, para cada muestra de simulación, los componentes se estresan, y los tipos, y a su vez los valores de las opciones , se reconstruyen; con el VaR calculado, finalmente, sobre toda la ejecución. El PCA también se utiliza para cubrir la exposición al riesgo de tipos de interés , dadas las duraciones parciales y otras sensibilidades. [58] En ambos casos, los primeros tres, típicamente, componentes principales del sistema son de interés ( que representan "desplazamiento", "giro" y "curvatura"). Estos componentes principales se derivan de una descomposición propia de la matriz de covarianza del rendimiento en vencimientos predefinidos; [60] y donde la varianza de cada componente es su valor propio (y como los componentes son ortogonales , no es necesario incorporar correlación en el modelado posterior).

En el caso de las acciones , una cartera óptima es aquella en la que se maximiza el rendimiento esperado para un nivel de riesgo determinado o, alternativamente, en la que se minimiza el riesgo para un rendimiento determinado; véase el modelo de Markowitz para una discusión. Por lo tanto, un enfoque es reducir el riesgo de la cartera, donde las estrategias de asignación se aplican a las "carteras principales" en lugar de a las acciones subyacentes . Un segundo enfoque es mejorar el rendimiento de la cartera, utilizando los componentes principales para seleccionar las acciones de las empresas con potencial alcista. [61] [62] El PCA también se ha utilizado para comprender las relaciones [57] entre los mercados de acciones internacionales y dentro de los mercados entre grupos de empresas en industrias o sectores .

El PCA también puede aplicarse a las pruebas de estrés , [63] que son esencialmente un análisis de la capacidad de un banco para soportar un escenario económico adverso hipotético . Su utilidad consiste en "destilar la información contenida en [varias] variables macroeconómicas en un conjunto de datos más manejable, que luego puede [utilizarse] para el análisis". [63] Aquí, los factores resultantes se vinculan, por ejemplo, a las tasas de interés (basándose en los elementos más grandes del vector propio del factor ) y luego se observa cómo un "shock" a cada uno de los factores afecta los activos implícitos de cada uno de los bancos.

Neurociencia

Una variante del análisis de componentes principales se utiliza en neurociencia para identificar las propiedades específicas de un estímulo que aumenta la probabilidad de una neurona de generar un potencial de acción . [64] [65] Esta técnica se conoce como análisis de covarianza desencadenado por picos . En una aplicación típica, un experimentador presenta un proceso de ruido blanco como estímulo (generalmente como una entrada sensorial a un sujeto de prueba o como una corriente inyectada directamente en la neurona) y registra un tren de potenciales de acción, o picos, producidos por la neurona como resultado. Presumiblemente, ciertas características del estímulo hacen que la neurona tenga más probabilidades de generar picos. Para extraer estas características, el experimentador calcula la matriz de covarianza del conjunto desencadenado por picos , el conjunto de todos los estímulos (definidos y discretizados en una ventana de tiempo finita, típicamente del orden de 100 ms) que precedieron inmediatamente a un pico. Los vectores propios de la diferencia entre la matriz de covarianza activada por picos y la matriz de covarianza del conjunto de estímulos anterior (el conjunto de todos los estímulos, definidos en la misma ventana de tiempo) indican entonces las direcciones en el espacio de estímulos a lo largo de las cuales la varianza del conjunto activado por picos difería más de la del conjunto de estímulos anterior. Específicamente, los vectores propios con los valores propios positivos más grandes corresponden a las direcciones a lo largo de las cuales la varianza del conjunto activado por picos mostró el cambio positivo más grande en comparación con la varianza del anterior. Dado que estas fueron las direcciones en las que la variación del estímulo condujo a un pico, a menudo son buenas aproximaciones de las características relevantes del estímulo buscadas.

En neurociencia, el PCA también se utiliza para discernir la identidad de una neurona a partir de la forma de su potencial de acción. La clasificación de picos es un procedimiento importante porque las técnicas de registro extracelular a menudo captan señales de más de una neurona. En la clasificación de picos, primero se utiliza el PCA para reducir la dimensionalidad del espacio de las formas de onda del potencial de acción y luego se realiza un análisis de agrupamiento para asociar potenciales de acción específicos con neuronas individuales.

El PCA como técnica de reducción de dimensión es particularmente adecuado para detectar actividades coordinadas de grandes conjuntos neuronales. Se ha utilizado para determinar variables colectivas, es decir, parámetros de orden , durante las transiciones de fase en el cerebro. [66]

Relación con otros métodos

Análisis de correspondencia

El análisis de correspondencias (AC) fue desarrollado por Jean-Paul Benzécri [67] y es conceptualmente similar al PCA, pero escala los datos (que deben ser no negativos) de modo que las filas y columnas se tratan de manera equivalente. Se aplica tradicionalmente a las tablas de contingencia . El AC descompone la estadística de chi-cuadrado asociada a esta tabla en factores ortogonales. [68] Debido a que el AC es una técnica descriptiva, se puede aplicar a tablas para las que la estadística de chi-cuadrado es apropiada o no. Hay varias variantes del AC disponibles, incluido el análisis de correspondencias sin tendencia y el análisis de correspondencias canónico . Una extensión especial es el análisis de correspondencias múltiples , que puede verse como la contraparte del análisis de componentes principales para datos categóricos. [69]

Análisis factorial

El análisis de componentes principales crea variables que son combinaciones lineales de las variables originales. Las nuevas variables tienen la propiedad de que todas son ortogonales. La transformación PCA puede ser útil como paso de preprocesamiento antes de la agrupación. El PCA es un enfoque centrado en la varianza que busca reproducir la varianza total de la variable, en el que los componentes reflejan tanto la varianza común como la única de la variable. El PCA se prefiere generalmente para fines de reducción de datos (es decir, traducir el espacio de variables en un espacio factorial óptimo), pero no cuando el objetivo es detectar el constructo o los factores latentes.

El análisis factorial es similar al análisis de componentes principales, en el sentido de que el análisis factorial también implica combinaciones lineales de variables. A diferencia del PCA, el análisis factorial es un enfoque centrado en la correlación que busca reproducir las intercorrelaciones entre variables, en las que los factores "representan la varianza común de las variables, excluyendo la varianza única". [70] En términos de la matriz de correlación, esto corresponde con centrarse en explicar los términos fuera de la diagonal (es decir, covarianza compartida), mientras que el PCA se centra en explicar los términos que se encuentran en la diagonal. Sin embargo, como resultado secundario, al intentar reproducir los términos en la diagonal, el PCA también tiende a ajustarse relativamente bien a las correlaciones fuera de la diagonal. [12] : 158 Los resultados dados por el PCA y el análisis factorial son muy similares en la mayoría de las situaciones, pero este no siempre es el caso, y hay algunos problemas donde los resultados son significativamente diferentes. El análisis factorial se utiliza generalmente cuando el propósito de la investigación es detectar la estructura de los datos (es decir, constructos o factores latentes) o el modelado causal . Si el modelo factorial está incorrectamente formulado o no se cumplen los supuestos, entonces el análisis factorial arrojará resultados erróneos. [71]

K-significa agrupamiento

Se ha afirmado que la solución relajada del agrupamiento de k -medias , especificada por los indicadores de agrupamiento, está dada por los componentes principales, y el subespacio PCA abarcado por las direcciones principales es idéntico al subespacio del centroide del agrupamiento. [72] [73] Sin embargo, que el PCA es una relajación útil del agrupamiento de k -medias no era un resultado nuevo, [74] y es sencillo descubrir contraejemplos a la afirmación de que el subespacio del centroide del agrupamiento está abarcado por las direcciones principales. [75]

Factorización de matrices no negativas

La factorización matricial no negativa (NMF) es un método de reducción de dimensión en el que solo se utilizan elementos no negativos en las matrices, lo que lo convierte en un método prometedor en astronomía, [23] [24] [25] en el sentido de que las señales astrofísicas no son negativas. Los componentes de PCA son ortogonales entre sí, mientras que los componentes de NMF son todos no negativos y, por lo tanto, construyen una base no ortogonal.

En PCA, la contribución de cada componente se clasifica en función de la magnitud de su valor propio correspondiente, que es equivalente a la varianza residual fraccional (FRV) al analizar datos empíricos. [21] Para NMF, sus componentes se clasifican basándose únicamente en las curvas FRV empíricas. [25] Los gráficos de valores propios fraccionales residuales, es decir, en función del número de componentes dado un total de componentes, para PCA tienen una meseta plana, donde no se capturan datos para eliminar el ruido cuasiestático, luego las curvas caen rápidamente como una indicación de sobreajuste (ruido aleatorio). [21] Las curvas FRV para NMF disminuyen continuamente [25] cuando los componentes NMF se construyen secuencialmente , [24] indicando la captura continua de ruido cuasiestático; luego convergen a niveles más altos que PCA, [25] indicando la propiedad de menor sobreajuste de NMF.

Iconografía de correlaciones

A menudo resulta difícil interpretar los componentes principales cuando los datos incluyen muchas variables de diversos orígenes, o cuando algunas variables son cualitativas. Esto lleva al usuario del ACP a una delicada eliminación de varias variables. Si las observaciones o variables tienen un impacto excesivo en la dirección de los ejes, deben eliminarse y luego proyectarse como elementos suplementarios. Además, es necesario evitar interpretar las proximidades entre los puntos cercanos al centro del plano factorial.

La iconografía de las correlaciones , por el contrario, que no es una proyección sobre un sistema de ejes, no presenta estos inconvenientes. Podemos, por tanto, conservar todas las variables.

El principio del diagrama es subrayar las correlaciones "notables" de la matriz de correlación, mediante una línea continua (correlación positiva) o una línea de puntos (correlación negativa).

Una correlación fuerte no es "notable" si no es directa, sino que está causada por el efecto de una tercera variable. Por el contrario, las correlaciones débiles pueden ser "notables". Por ejemplo, si una variable Y depende de varias variables independientes, las correlaciones de Y con cada una de ellas son débiles y, sin embargo, "notables".

Generalizaciones

PCA dispersa

Una desventaja particular del PCA es que los componentes principales suelen ser combinaciones lineales de todas las variables de entrada. El PCA disperso supera esta desventaja al encontrar combinaciones lineales que contienen solo unas pocas variables de entrada. Amplía el método clásico de análisis de componentes principales (PCA) para la reducción de la dimensionalidad de los datos al agregar una restricción de dispersión a las variables de entrada. Se han propuesto varios enfoques, incluidos

- un marco de regresión, [76]

- un marco de programación semidefinida/relajación convexa, [77]

- Un marco de método de potencia generalizado [78]

- un marco de maximización alternada [79]

- Búsqueda voraz hacia adelante y hacia atrás y métodos exactos que utilizan técnicas de ramificación y acotación, [80]

- Marco de formulación bayesiano. [81]

Los desarrollos metodológicos y teóricos del PCA disperso, así como sus aplicaciones en estudios científicos, fueron revisados recientemente en un artículo de investigación. [82]

PCA no lineal

La mayoría de los métodos modernos para la reducción de dimensionalidad no lineal encuentran sus raíces teóricas y algorítmicas en PCA o K-means. La idea original de Pearson era tomar una línea recta (o plano) que sería "el mejor ajuste" a un conjunto de puntos de datos. Trevor Hastie amplió este concepto al proponer curvas principales [86] como la extensión natural para la interpretación geométrica de PCA, que construye explícitamente una variedad para la aproximación de datos seguida de la proyección de los puntos sobre ella. Véase también el algoritmo de mapa elástico y el análisis geodésico principal . [87] Otra generalización popular es el PCA de kernel , que corresponde al PCA realizado en un espacio de Hilbert de kernel de reproducción asociado con un kernel definido positivo.

En el aprendizaje de subespacios multilineales , [88] [89] [90] el PCA se generaliza al PCA multilineal (MPCA) que extrae características directamente de las representaciones tensoriales. El MPCA se resuelve realizando el PCA en cada modo del tensor de forma iterativa. El MPCA se ha aplicado al reconocimiento facial, al reconocimiento de la marcha, etc. El MPCA se extiende además al MPCA no correlacionado, al MPCA no negativo y al MPCA robusto.

El análisis de componentes principales de N vías se puede realizar con modelos como la descomposición de Tucker , PARAFAC , análisis de factores múltiples, análisis de co-inercia, STATIS y DISTATIS.

PCA robusto

Si bien el PCA encuentra el método matemáticamente óptimo (como en la minimización del error al cuadrado), aún es sensible a los valores atípicos en los datos que producen grandes errores, algo que el método intenta evitar en primer lugar. Por lo tanto, es una práctica común eliminar los valores atípicos antes de calcular el PCA. Sin embargo, en algunos contextos, los valores atípicos pueden ser difíciles de identificar. [91] Por ejemplo, en algoritmos de minería de datos como el agrupamiento por correlación , la asignación de puntos a los clústeres y valores atípicos no se conoce de antemano. Una generalización propuesta recientemente del PCA [92] basada en un PCA ponderado aumenta la robustez al asignar diferentes pesos a los objetos de datos en función de su relevancia estimada.

También se han propuesto variantes de PCA resistentes a valores atípicos, basadas en formulaciones de norma L1 ( L1-PCA ). [6] [4]

El análisis robusto de componentes principales (RPCA) a través de la descomposición en matrices dispersas y de bajo rango es una modificación del PCA que funciona bien con respecto a observaciones extremadamente corruptas. [93] [94] [95]

Técnicas similares

Análisis de componentes independientes

El análisis de componentes independientes (ICA) está dirigido a problemas similares al análisis de componentes principales, pero encuentra componentes separables de forma aditiva en lugar de aproximaciones sucesivas.

Análisis de componentes de red

Dada una matriz , intenta descomponerla en dos matrices tales que . Una diferencia clave con respecto a técnicas como PCA e ICA es que algunas de las entradas de están restringidas a ser 0. Aquí se denomina capa reguladora. Si bien en general una descomposición de este tipo puede tener múltiples soluciones, demuestran que si se cumplen las siguientes condiciones :

- tiene rango de columna completo

- Cada columna de debe tener al menos ceros donde es el número de columnas de (o alternativamente el número de filas de ). La justificación de este criterio es que si se elimina un nodo de la capa reguladora junto con todos los nodos de salida conectados a él, el resultado aún debe caracterizarse por una matriz de conectividad con rango de columna completo.

- Debe tener rango de fila completo.

entonces la descomposición es única hasta la multiplicación por un escalar. [96]

Análisis discriminante de componentes principales

El análisis discriminante de componentes principales (DAPC) es un método multivariante utilizado para identificar y describir grupos de individuos genéticamente relacionados. La variación genética se divide en dos componentes: variación entre grupos y dentro de los grupos, y maximiza la primera. Los discriminantes lineales son combinaciones lineales de alelos que separan mejor los grupos. Los alelos que más contribuyen a esta discriminación son, por lo tanto, aquellos que son más marcadamente diferentes entre los grupos. Las contribuciones de los alelos a las agrupaciones identificadas por DAPC pueden permitir identificar regiones del genoma que impulsan la divergencia genética entre grupos [97]. En DAPC, los datos se transforman primero utilizando un análisis de componentes principales (PCA) y, posteriormente, se identifican los grupos utilizando un análisis discriminante (DA).

Se puede realizar un DAPC en R utilizando el paquete Adegenet. (más información: adegenet en la web)

Análisis de componentes direccionales

El análisis de componentes direccionales (DCA) es un método utilizado en las ciencias atmosféricas para analizar conjuntos de datos multivariados. [98] Al igual que el PCA, permite la reducción de la dimensión, una mejor visualización y una mejor interpretabilidad de grandes conjuntos de datos. También como el PCA, se basa en una matriz de covarianza derivada del conjunto de datos de entrada. La diferencia entre el PCA y el DCA es que el DCA requiere además la entrada de una dirección vectorial, denominada impacto. Mientras que el PCA maximiza la varianza explicada, el DCA maximiza la densidad de probabilidad dado el impacto. La motivación del DCA es encontrar componentes de un conjunto de datos multivariados que sean probables (medidos utilizando la densidad de probabilidad) e importantes (medidos utilizando el impacto). El DCA se ha utilizado para encontrar los patrones de olas de calor más probables y más graves en conjuntos de predicción meteorológica [99] y los cambios más probables y de mayor impacto en las precipitaciones debido al cambio climático [100] .

Software/código fuente

- ALGLIB : una biblioteca de C++ y C# que implementa PCA y PCA truncado

- Analytica : la función incorporada EigenDecomp calcula los componentes principales.

- ELKI – incluye PCA para proyección, incluidas variantes robustas de PCA, así como algoritmos de agrupamiento basados en PCA .

- Gretl : el análisis de componentes principales se puede realizar mediante el

pcacomando o mediante laprincomp()función. - Julia : admite PCA con la

pcafunción en el paquete MultivariateStats - KNIME – Un software de organización nodal basado en Java para análisis, en este los nodos llamados PCA, PCA computar, PCA aplicar, PCA inverso lo hacen fácilmente.

- Maple (software) : el comando PCA se utiliza para realizar un análisis de componentes principales en un conjunto de datos.

- Mathematica : implementa el análisis de componentes principales con el comando PrincipalComponents utilizando métodos de covarianza y correlación.

- MathPHP – Biblioteca matemática PHP con soporte para PCA.

- MATLAB – La función SVD es parte del sistema básico. En la caja de herramientas de estadística, las funciones

princompypca(R2012b) proporcionan los componentes principales, mientras que la funciónpcaresproporciona los residuos y la matriz reconstruida para una aproximación PCA de bajo rango. - Matplotlib – La biblioteca de Python tiene un paquete PCA en el módulo .mlab.

- mlpack – Proporciona una implementación del análisis de componentes principales en C++ .

- mrmath: una biblioteca de matemáticas de alto rendimiento para Delphi y FreePascal que puede realizar PCA; incluidas variantes robustas.

- Biblioteca NAG : el análisis de componentes principales se implementa a través de la

g03aarutina (disponible en ambas versiones Fortran de la biblioteca). - NMath – Biblioteca numérica propietaria que contiene PCA para .NET Framework .

- GNU Octave – Entorno computacional de software libre mayoritariamente compatible con MATLAB, la función

princompproporciona el componente principal. - OpenCV

- Oracle Database 12c: se implementa mediante

DBMS_DATA_MINING.SVDS_SCORING_MODEla especificación de un valor de configuraciónSVDS_SCORING_PCA - Orange (software) : integra PCA en su entorno de programación visual. PCA muestra un gráfico de pantalla (grado de varianza explicada) donde el usuario puede seleccionar de forma interactiva el número de componentes principales.

- Origen – Contiene PCA en su versión Pro.

- Qlucore – Software comercial para analizar datos multivariados con respuesta instantánea utilizando PCA.

- R – Paquete estadístico gratuito , las funciones

princompyprcompse pueden utilizar para el análisis de componentes principales;prcomputiliza la descomposición en valores singulares , que generalmente brinda una mejor precisión numérica. Algunos paquetes que implementan PCA en R incluyen, entre otros:ade4,vegan,ExPosition,dimRedyFactoMineR. - SAS – Software propietario; por ejemplo, véase [101]

- scikit-learn – Biblioteca de Python para aprendizaje automático que contiene PCA, PCA probabilístico, PCA de núcleo, PCA disperso y otras técnicas en el módulo de descomposición.

- Scilab – Paquete computacional numérico multiplataforma, gratuito y de código abierto; la función

princompcalcula el análisis de componentes principales; la funciónpcacalcula el análisis de componentes principales con variables estandarizadas. - SPSS : software propietario utilizado con mayor frecuencia por científicos sociales para PCA, análisis factorial y análisis de conglomerados asociado.

- Weka : biblioteca Java para aprendizaje automático que contiene módulos para calcular componentes principales.

Véase también

- Análisis de correspondencias (para tablas de contingencia)

- Análisis de correspondencias múltiples (para variables cualitativas)

- Análisis factorial de datos mixtos (para variables cuantitativas y cualitativas)

- Correlación canónica

- Aproximación de matriz CUR (puede reemplazar la aproximación SVD de rango bajo)

- Análisis de correspondencia sin tendencia

- Análisis de componentes direccionales

- Descomposición en modo dinámico

- Cara propia

- Algoritmo de expectativa-maximización

- Análisis factorial exploratorio (Wikiversidad)

- Código factorial

- Análisis de componentes principales funcionales

- Análisis de datos geométricos

- Análisis de componentes independientes

- PCA del núcleo

- Análisis de componentes principales según la norma L1

- Aproximación de bajo rango

- Descomposición matricial

- Factorización de matrices no negativas

- Reducción de dimensionalidad no lineal

- La regla de Oja

- Modelo de distribución de puntos (PCA aplicado a morfometría y visión artificial)

- Análisis de componentes principales (Wikilibros)

- Regresión de componentes principales

- Análisis de espectros singulares

- Descomposición en valores singulares

- PCA dispersa

- Codificación de transformación

- Mínimos cuadrados ponderados

Referencias

- ^ Jolliffe, Ian T.; Cadima, Jorge (13 de abril de 2016). "Análisis de componentes principales: una revisión y desarrollos recientes". Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences . 374 (2065): 20150202. Bibcode :2016RSPTA.37450202J. doi :10.1098/rsta.2015.0202. PMC 4792409 . PMID 26953178.

- ^ Barnett, TP y R. Preisendorfer. (1987). "Orígenes y niveles de la habilidad de pronóstico mensual y estacional para las temperaturas del aire en la superficie de los Estados Unidos determinadas por análisis de correlación canónica". Monthly Weather Review . 115 (9): 1825. Bibcode :1987MWRv..115.1825B. doi : 10.1175/1520-0493(1987)115<1825:oaloma>2.0.co;2 .

- ^ Hsu, Daniel; Kakade, Sham M.; Zhang, Tong (2008). Un algoritmo espectral para aprender modelos ocultos de Markov . arXiv : 0811.4413 . Bibcode :2008arXiv0811.4413H.

- ^ ab Markopoulos, Panos P.; Kundu, Sandipan; Chamadia, Shubham; Pados, Dimitris A. (15 de agosto de 2017). "Análisis eficiente de componentes principales de norma L1 mediante inversión de bits". IEEE Transactions on Signal Processing . 65 (16): 4252–4264. arXiv : 1610.01959 . Bibcode :2017ITSP...65.4252M. doi :10.1109/TSP.2017.2708023. S2CID 7931130.

- ^ ab Chachlakis, Dimitris G.; Prater-Bennette, Ashley; Markopoulos, Panos P. (22 de noviembre de 2019). "Descomposición del tensor de Tucker según la norma L1". IEEE Access . 7 : 178454–178465. arXiv : 1904.06455 . doi : 10.1109/ACCESS.2019.2955134 .

- ^ ab Markopoulos, Panos P.; Karystinos, George N.; Pados, Dimitris A. (octubre de 2014). "Algoritmos óptimos para el procesamiento de señales en el subespacio L1". IEEE Transactions on Signal Processing . 62 (19): 5046–5058. arXiv : 1405.6785 . Código Bibliográfico :2014ITSP...62.5046M. doi :10.1109/TSP.2014.2338077. S2CID 1494171.

- ^ Zhan, J.; Vaswani, N. (2015). "PCA robusto con conocimiento parcial del subespacio". IEEE Transactions on Signal Processing . 63 (13): 3332–3347. arXiv : 1403.1591 . Bibcode :2015ITSP...63.3332Z. doi :10.1109/tsp.2015.2421485. S2CID 1516440.

- ^ Kanade, T.; Ke, Qifa (junio de 2005). "Factorización de normas L₁ robusta en presencia de valores atípicos y datos faltantes mediante programación convexa alternativa". Conferencia de la IEEE Computer Society de 2005 sobre visión artificial y reconocimiento de patrones (CVPR'05) . Vol. 1. IEEE. págs. 739–746. CiteSeerX 10.1.1.63.4605 . doi :10.1109/CVPR.2005.309. ISBN. 978-0-7695-2372-9. Número de identificación del sujeto 17144854.

- ^ Pearson, K. (1901). "Sobre líneas y planos de ajuste más cercano a sistemas de puntos en el espacio". Revista filosófica . 2 (11): 559–572. doi :10.1080/14786440109462720. S2CID 125037489.

- ^ Hotelling, H. (1933). Análisis de un complejo de variables estadísticas en componentes principales. Journal of Educational Psychology , 24 , 417–441 y 498–520. Hotelling, H. (1936). "Relaciones entre dos conjuntos de variables". Biometrika . 28 (3/4): 321–377. doi :10.2307/2333955. JSTOR 2333955.

- ^ Stewart, GW (1993). "Sobre la historia temprana de la descomposición en valores singulares". SIAM Review . 35 (4): 551–566. doi :10.1137/1035134. hdl : 1903/566 .

- ^ abcde Jolliffe, IT (2002). Análisis de componentes principales. Springer Series in Statistics. Nueva York: Springer-Verlag. doi :10.1007/b98835. ISBN 978-0-387-95442-4.

- ^ Bengio, Y.; et al. (2013). "Representation Learning: A Review and New Perspectives". IEEE Transactions on Pattern Analysis and Machine Intelligence . 35 (8): 1798–1828. arXiv : 1206.5538 . doi :10.1109/TPAMI.2013.50. PMID 23787338. S2CID 393948.

- ^ Forkman J., Josse, J., Piepho, HP (2019). "Pruebas de hipótesis para el análisis de componentes principales cuando las variables están estandarizadas". Revista de estadísticas agrícolas, biológicas y ambientales . 24 (2): 289–308. doi : 10.1007/s13253-019-00355-5 .

{{cite journal}}: CS1 maint: multiple names: authors list (link) - ^ Boyd, Stephen; Vandenberghe, Lieven (8 de marzo de 2004). Optimización convexa. Cambridge University Press. doi :10.1017/cbo9780511804441. ISBN 978-0-521-83378-3.

- ^ AA Miranda, YA Le Borgne y G. Bontempi. Nuevas rutas desde el error de aproximación mínimo hasta los componentes principales, volumen 27, número 3 / junio de 2008, Neural Processing Letters, Springer

- ^ Fukunaga, Keinosuke (1990). Introducción al reconocimiento estadístico de patrones. Elsevier. ISBN 978-0-12-269851-4.

- ^ Alizadeh, Elaheh; Lyons, Samanthe M; Castle, Jordan M; Prasad, Ashok (2016). "Medición de cambios sistemáticos en la forma de células cancerosas invasivas utilizando momentos de Zernike". Biología Integrativa . 8 (11): 1183–1193. doi :10.1039/C6IB00100A. PMID 27735002.

- ^ Leznik, M; Tofallis, C. 2005 Estimación de componentes principales invariantes utilizando regresión diagonal.

- ^ Jonathon Shlens, Un tutorial sobre análisis de componentes principales.