Factor de impacto

| Parte de una serie sobre |

| Métricas de citación |

|---|

|

El factor de impacto ( FI ) o factor de impacto de la revista ( JIF ) de una revista académica es un índice cienciométrico calculado por Clarivate que refleja la media anual del número de citas de artículos publicados en los últimos dos años en una revista determinada, según el índice de la Web of Science de Clarivate .

Como métrica a nivel de revista , se utiliza frecuentemente como un indicador de la importancia relativa de una revista dentro de su campo; las revistas con valores de factor de impacto más altos reciben el estatus de ser más importantes o tienen más prestigio en sus respectivos campos que aquellas con valores más bajos.

Aunque las universidades y los organismos de financiación lo utilizan con frecuencia para decidir sobre propuestas de promoción e investigación, ha sido criticado por distorsionar las buenas prácticas científicas. [1] [2] [3]

Historia

El factor de impacto fue ideado por Eugene Garfield , fundador del Institute for Scientific Information (ISI) en Filadelfia. Los factores de impacto comenzaron a calcularse anualmente a partir de 1975 para las revistas incluidas en el Journal Citation Reports (JCR). ISI fue adquirida por Thomson Scientific & Healthcare en 1992, [4] y pasó a conocerse como Thomson ISI. En 2018, Thomson-Reuters se separó y vendió ISI a Onex Corporation y Baring Private Equity Asia . [5] Fundaron una nueva corporación, Clarivate, que ahora es la editorial del JCR. [6]

Cálculo

En un año determinado, el factor de impacto de una revista de dos años es la relación entre el número de citas recibidas en ese año por publicaciones en esa revista que se publicaron en los dos años anteriores y el número total de "ítems citables" publicados en esa revista durante los dos años anteriores: [7] [8]

Por ejemplo, Nature tuvo un factor de impacto de 41,577 en 2017: [9]

Esto significa que, en promedio, sus artículos publicados en 2015 y 2016 recibieron aproximadamente 42 citas cada uno en 2017. Los factores de impacto de 2017 se informan en 2018; no se pueden calcular hasta que la agencia de indexación haya procesado todas las publicaciones de 2017.

El valor del factor de impacto depende de cómo se definan las "citas" y las "publicaciones"; a estas últimas se las suele denominar "elementos citables". En la práctica actual, tanto las "citas" como las "publicaciones" se definen exclusivamente por ISI de la siguiente manera. Las "publicaciones" son elementos que se clasifican como "artículo", "revisión" o "documento de actas" [10] en la base de datos Web of Science (WoS); se excluyen otros elementos como editoriales, correcciones, notas, retractaciones y discusiones. WoS es accesible para todos los usuarios registrados, que pueden verificar de forma independiente el número de elementos citables de una revista determinada. Por el contrario, el número de citas no se extrae de la base de datos WoS, sino de una base de datos JCR dedicada, a la que no tienen acceso los lectores generales. Por lo tanto, el "factor de impacto JCR" de uso común es un valor propietario, que es definido y calculado por ISI y no puede ser verificado por usuarios externos. [11]

Las revistas nuevas, que se indexan a partir de su primer número publicado, recibirán un factor de impacto después de dos años de indexación; en este caso, las citas al año anterior al volumen 1 y el número de artículos publicados en el año anterior al volumen 1 son valores cero conocidos. Las revistas que se indexan a partir de un volumen distinto del primero no obtendrán un factor de impacto hasta que hayan estado indexadas durante tres años. Ocasionalmente, Journal Citation Reports asigna un factor de impacto a las revistas nuevas con menos de dos años de indexación, basándose en datos de citas parciales. [12] [13] El cálculo siempre utiliza dos años completos y conocidos de recuentos de ítems, pero para los títulos nuevos uno de los recuentos conocidos es cero. Los anuarios y otras publicaciones irregulares a veces no publican ítems en un año en particular, lo que afecta el recuento. El factor de impacto se relaciona con un período de tiempo específico; es posible calcularlo para cualquier período deseado. Por ejemplo, el JCR también incluye un factor de impacto de cinco años , que se calcula dividiendo el número de citas a la revista en un año determinado por el número de artículos publicados en esa revista en los cinco años anteriores. [14] [15]

Usar

Aunque en un principio se inventó como una herramienta para ayudar a los bibliotecarios universitarios a decidir qué revistas comprar, el factor de impacto pronto se empezó a utilizar como medida para juzgar el éxito académico. Hoeffel resumió este uso de los factores de impacto en 1998: [16]

El factor de impacto no es una herramienta perfecta para medir la calidad de los artículos pero no hay nada mejor y tiene la ventaja de que ya existe y es, por tanto, una buena técnica de evaluación científica. La experiencia ha demostrado que en cada especialidad las mejores revistas son aquellas en las que es más difícil que un artículo sea aceptado, y son éstas las que tienen un factor de impacto alto. La mayoría de estas revistas existían mucho antes de que se ideara el factor de impacto. El uso del factor de impacto como medida de calidad está muy extendido porque encaja bien con la opinión que tenemos en cada campo de las mejores revistas de nuestra especialidad....En conclusión, las revistas de prestigio publican trabajos de alto nivel. Por tanto, su factor de impacto es alto, y no al contrario.

Como los factores de impacto son una métrica a nivel de revista, en lugar de una métrica a nivel de artículo o de individuo, su uso es controvertido. Eugene Garfield, el inventor del JIF, estuvo de acuerdo con Hoeffel, [17] pero advirtió sobre el "mal uso en la evaluación de individuos" porque existe "una amplia variación [de citas] de un artículo a otro dentro de una misma revista". [18] A pesar de esta advertencia, el uso del JIF ha evolucionado y desempeña un papel clave en el proceso de evaluación de investigadores individuales, sus solicitudes de empleo y sus propuestas de financiación. En 2005, The Journal of Cell Biology señaló que:

Los datos del factor de impacto... tienen una fuerte influencia en la comunidad científica, afectando las decisiones sobre dónde publicar, a quién promover o contratar, el éxito de las solicitudes de subvenciones e incluso las bonificaciones salariales. [19]

Una investigación más específica ha comenzado a proporcionar evidencia sólida de cuán profundamente está arraigado el factor de impacto en los procesos formales e informales de evaluación de la investigación. Una revisión realizada en 2019 estudió la frecuencia con la que el JIF aparecía en documentos relacionados con la revisión, promoción y permanencia de científicos en universidades estadounidenses y canadienses. Concluyó que el 40% de las universidades centradas en la investigación académica mencionaban específicamente el JIF como parte de dichos procesos de revisión, promoción y permanencia. [20] Y un estudio de 2017 sobre cómo se comportan los investigadores en las ciencias de la vida concluyó que "las prácticas cotidianas de toma de decisiones están muy regidas por las presiones para publicar en revistas de alto impacto". La naturaleza profundamente arraigada de dichos indicadores no solo afecta la evaluación de la investigación, sino también la cuestión más fundamental de qué investigación se lleva a cabo realmente: "Dadas las formas actuales de evaluación y valoración de la investigación, los proyectos arriesgados, prolongados y poco ortodoxos rara vez ocupan el centro del escenario". [21]

Crítica

Se han hecho numerosas críticas con respecto al uso de factores de impacto, tanto en términos de su validez estadística como de sus implicaciones para la forma en que se lleva a cabo y se evalúa la ciencia. [3] [22] [23] [24] [25] Un estudio de 2007 señaló que el defecto más fundamental es que los factores de impacto presentan la media de los datos que no se distribuyen normalmente , y sugirió que sería más apropiado presentar la mediana de estos datos. [19] También existe un debate más general sobre la validez del factor de impacto como medida de la importancia de la revista y el efecto de las políticas que los editores pueden adoptar para impulsar su factor de impacto (quizás en detrimento de los lectores y escritores). Otras críticas se centran en el efecto del factor de impacto en el comportamiento de los académicos, editores y otras partes interesadas. [26] Otras críticas argumentan que el énfasis en el factor de impacto resulta de la influencia negativa de la política neoliberal en la academia. Algunos de estos argumentos exigen no sólo la sustitución del factor de impacto por métricas más sofisticadas, sino también un debate sobre el valor social de la evaluación de la investigación y la creciente precariedad de las carreras científicas en la educación superior. [27] [28]

Inaplicabilidad del factor de impacto a individuos y diferencias entre disciplinas

Se ha afirmado que los factores de impacto en particular y el análisis de citas en general se ven afectados por factores dependientes del campo [29] que invalidan las comparaciones no solo entre disciplinas sino incluso dentro de diferentes campos de investigación de una disciplina. [30] El porcentaje de citas totales que ocurren en los primeros dos años después de la publicación también varía mucho entre disciplinas, desde el 1-3% en las ciencias matemáticas y físicas hasta el 5-8% en las ciencias biológicas. [31] Por lo tanto, los factores de impacto no se pueden utilizar para comparar revistas entre disciplinas.

Los factores de impacto se utilizan a veces para evaluar no sólo las revistas sino también los artículos que se publican en ellas, devaluando así los artículos sobre determinadas materias. [32] En 2004, el Comité Selecto de Ciencia y Tecnología de la Cámara de los Comunes instó al Consejo de Financiación de la Educación Superior de Inglaterra a recordar a los paneles de evaluación de la investigación que están obligados a evaluar la calidad del contenido de los artículos individuales, no la reputación de la revista en la que se publican. [33] Otros estudios han afirmado repetidamente que el factor de impacto es una métrica para las revistas y no debería utilizarse para evaluar a investigadores o instituciones individuales. [34] [35] [36]

Políticas editoriales cuestionables que afectan el factor de impacto

Debido a que el factor de impacto se acepta comúnmente como un indicador de la calidad de la investigación, algunas revistas adoptan políticas y prácticas editoriales, algunas aceptables y otras de dudoso propósito, para aumentar su factor de impacto. [37] [38] Por ejemplo, las revistas pueden publicar un mayor porcentaje de artículos de revisión que generalmente se citan más que los informes de investigación. [8] Una investigación realizada en 2020 sobre revistas de odontología concluyó que la publicación de "revisiones sistemáticas tiene un efecto significativo en el factor de impacto de la revista ... mientras que los artículos que publican ensayos clínicos no tienen influencia en este factor. Un mayor promedio anual de artículos publicados ... significa un mayor factor de impacto". [39]

Las revistas también pueden intentar limitar el número de "ítems citables" (es decir, el denominador de la ecuación del factor de impacto), ya sea negándose a publicar artículos que es poco probable que sean citados (como informes de casos en revistas médicas) o alterando los artículos (por ejemplo, no permitiendo un resumen o bibliografía con la esperanza de que Journal Citation Reports no los considere un "ítem citable"). Como resultado de las negociaciones sobre si los artículos son "citables", se han observado variaciones del factor de impacto de más del 300%. [40] Los artículos considerados no citables (y por lo tanto no se incorporan a los cálculos del factor de impacto) pueden, si se citan, ingresar en la parte del numerador de la ecuación a pesar de la facilidad con la que tales citas podrían excluirse. Este efecto es difícil de evaluar, ya que la distinción entre comentarios editoriales y artículos originales breves no siempre es obvia. Por ejemplo, las cartas al editor pueden ser parte de cualquiera de las dos clases.

Otra táctica menos insidiosa que emplean las revistas es publicar una gran parte de sus artículos, o al menos los artículos que se espera que sean muy citados, a principios del año calendario. Esto les da más tiempo para reunir citas. Existen varios métodos, no necesariamente con intenciones maliciosas, para que una revista cite artículos de la misma revista, lo que aumentará el factor de impacto de la revista. [41] [42]

Más allá de las políticas editoriales que pueden distorsionar el factor de impacto, las revistas pueden tomar medidas manifiestas para manipular el sistema . Por ejemplo, en 2007, la revista especializada Folia Phoniatrica et Logopaedica , con un factor de impacto de 0,66, publicó un editorial que citaba todos sus artículos de 2005 a 2006 en protesta contra la "absurda situación científica en algunos países" relacionada con el uso del factor de impacto. [43] La gran cantidad de citas hizo que el factor de impacto de esa revista aumentara a 1,44. Como resultado de este aumento, la revista no fue incluida en los Journal Citation Reports de 2008 y 2009. [44]

La citación coercitiva es una práctica en la que un editor obliga a un autor a añadir citas extrañas a un artículo antes de que la revista acepte publicarlo, con el fin de inflar el factor de impacto de la revista. [45] Una encuesta publicada en 2012 indica que la citación coercitiva ha sido experimentada por uno de cada cinco investigadores que trabajan en economía, sociología, psicología y múltiples disciplinas empresariales, y es más común en empresas y en revistas con un factor de impacto más bajo. [46] Los editores de las principales revistas empresariales se unieron para repudiar la práctica. [47] Sin embargo, ocasionalmente se han reportado casos de citación coercitiva para otras disciplinas. [48]

Correlación asumida entre el factor de impacto y la calidad

El factor de impacto de una revista fue diseñado originalmente por Eugene Garfield como una métrica para ayudar a los bibliotecarios a tomar decisiones sobre qué revistas valían la pena indexar, ya que el JIF agrega el número de citas a los artículos publicados en cada revista. Desde entonces, el JIF se ha asociado como una marca de "calidad" de una revista y se ha generalizado su uso para la evaluación de la investigación y los investigadores, incluso a nivel institucional. Por lo tanto, tiene un impacto significativo en la orientación de las prácticas y los comportamientos de investigación. [49] [2] [50]

En 2010, las instituciones nacionales e internacionales de financiación de la investigación ya empezaban a señalar que los indicadores numéricos como el JIF no deberían considerarse una medida de calidad. [nota 1] De hecho, la investigación indicaba que el JIF es una métrica altamente manipulada, [51] [52] [53] y la justificación para su continuo uso generalizado más allá de su estrecho propósito original parece deberse a su simplicidad (número fácilmente calculable y comparable), en lugar de a una relación real con la calidad de la investigación. [54] [55] [56]

La evidencia empírica muestra que el uso indebido del JIF (y de las métricas de clasificación de revistas en general) tiene una serie de consecuencias negativas para el sistema de comunicación académica. Estas incluyen brechas entre el alcance de una revista y la calidad de sus artículos individuales [25] y una cobertura insuficiente de las ciencias sociales y las humanidades, así como de los resultados de investigación de toda América Latina, África y el sudeste asiático [57] . Otros inconvenientes incluyen la marginalización de la investigación en lenguas vernáculas y sobre temas relevantes a nivel local y la inducción a prácticas de autoría y citación poco éticas. En términos más generales, los factores de impacto fomentan una economía de reputación, donde el éxito científico se basa en la publicación en revistas prestigiosas por encima de las cualidades reales de la investigación, como los métodos rigurosos, la replicabilidad y el impacto social. Se ha demostrado que el uso del prestigio de las revistas y del JIF para cultivar un régimen de competencia en el ámbito académico tiene efectos nocivos para la calidad de la investigación [58] .

En la actualidad, existen varias iniciativas regionales e internacionales que ofrecen y sugieren sistemas alternativos de evaluación de la investigación, entre los que se incluyen documentos clave como el Manifiesto de Leiden [nota 2] y la Declaración de San Francisco sobre Evaluación de la Investigación (DORA). El Plan S exige una adopción e implementación más amplia de dichas iniciativas junto con cambios fundamentales en el sistema de comunicación académica. [nota 3] Como medidas adecuadas de calidad para los autores y la investigación, los conceptos de excelencia en la investigación deberían remodelarse en torno a flujos de trabajo transparentes y resultados de investigación accesibles. [59] [60] [61]

Los JIF todavía se utilizan regularmente para evaluar la investigación en muchos países, lo que constituye un problema ya que persisten varios problemas en torno a la opacidad de la métrica y al hecho de que a menudo es negociada por los editores. [62] [63] [19]

Valores negociados

Los resultados de un factor de impacto pueden cambiar drásticamente dependiendo de qué elementos se consideren "citables" y, por lo tanto, se incluyan en el denominador. [64] Un ejemplo notorio de esto ocurrió en 1988 cuando se decidió que los resúmenes de reuniones publicados en FASEB Journal ya no se incluirían en el denominador. El factor de impacto de la revista aumentó de 0,24 en 1988 a 18,3 en 1989. [65] Los editores discuten rutinariamente con Clarivate cómo mejorar la "precisión" del factor de impacto de sus revistas y, por lo tanto, obtener puntuaciones más altas. [40] [25]

Estas discusiones producen rutinariamente "valores negociados" que resultan en cambios dramáticos en las puntuaciones observadas para docenas de revistas, a veces después de eventos no relacionados como la compra por parte de uno de los editores más grandes. [66]

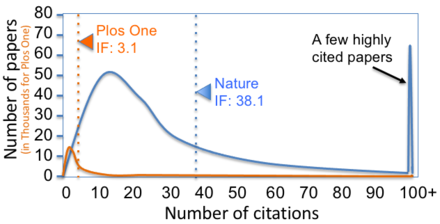

Asimetría de la distribución

Debido a que los recuentos de citas tienen distribuciones altamente sesgadas , [24] el número medio de citas es potencialmente engañoso si se utiliza para medir el impacto típico de los artículos en la revista en lugar del impacto general de la revista en sí. [68] Por ejemplo, alrededor del 90% del factor de impacto de Nature de 2004 se basó en solo una cuarta parte de sus publicaciones. Por lo tanto, el número real de citas para un solo artículo en la revista es en la mayoría de los casos mucho menor que el número medio de citas en todos los artículos. [69] Además, la fuerza de la relación entre los factores de impacto de las revistas y las tasas de citas de los artículos en ellas ha estado disminuyendo constantemente desde que los artículos comenzaron a estar disponibles digitalmente. [70]

El efecto de los valores atípicos se puede ver en el caso del artículo "Una breve historia de SHELX", que incluía esta frase: "Este artículo podría servir como una cita bibliográfica general cuando uno o más de los programas SHELX de código abierto (y la versión SHELXTL de Bruker AXS) se emplean en el curso de una determinación de la estructura cristalina". Este artículo recibió más de 6.600 citas. Como consecuencia, el factor de impacto de la revista Acta Crystallographica Section A aumentó de 2,051 en 2008 a 49,926 en 2009, más que Nature (con 31,434) y Science (con 28,103). [71] El segundo artículo más citado en Acta Crystallographica Section A en 2008 tuvo solo 28 citas. [72]

Los críticos del JIF afirman que el uso de la media aritmética en su cálculo es problemático porque el patrón de distribución de citas está sesgado [73] y se han propuesto métricas de distribución de citas como una alternativa a los factores de impacto. [74] [75] [76]

Sin embargo, también se ha pedido que se adopte un enfoque más matizado para juzgar la asimetría de la distribución del factor de impacto. Ludo Waltman y Vincent Antonio Traag, en su artículo de 2021, realizaron numerosas simulaciones y concluyeron que "las objeciones estadísticas contra el uso del factor de impacto a nivel de artículos individuales no son convincentes" y que "el factor de impacto puede ser un indicador más preciso del valor de un artículo que el número de citas del artículo". [1]

Reproducibilidad

Si bien el modelo matemático subyacente es de conocimiento público, el conjunto de datos que se utiliza para calcular el JIF no está disponible públicamente. Esto provocó críticas: "Así como los científicos no aceptarían los hallazgos de un artículo científico sin ver los datos primarios, tampoco deberían confiar en el factor de impacto de Thomson Scientific, que se basa en datos ocultos". [19] Sin embargo, un artículo de 2019 demostró que "con acceso a los datos y una limpieza cuidadosa, el JIF se puede reproducir", aunque esto requirió mucho trabajo para lograrlo. [77] Un artículo de investigación de 2020 fue más allá. Indicó que al consultar bases de datos de acceso abierto o parcialmente abierto, como Google Scholar, ResearchGate y Scopus, es posible calcular factores de impacto aproximados sin la necesidad de comprar Web of Science / JCR. [78]

Impacto negativo más amplio sobre la ciencia

Así como el factor de impacto ha sido criticado por varios problemas inmediatos asociados con su aplicación, también ha habido críticas de que su aplicación socava el proceso más amplio de la ciencia. Las investigaciones han indicado que las cifras bibliométricas, en particular el factor de impacto, reducen la calidad de la revisión por pares que recibe un artículo, [79] provocan una renuencia a compartir datos, [21] disminuyen la calidad de los artículos, [80] y reducen el alcance de la investigación publicable. "Para muchos investigadores, las únicas preguntas y proyectos de investigación que parecen viables son aquellos que pueden satisfacer la demanda de una buena puntuación en términos de indicadores de rendimiento métrico, y principalmente el factor de impacto de la revista". [21] Además, el proceso de publicación y la ciencia se ralentizan -los autores automáticamente intentan publicar en las revistas con el factor de impacto más alto- "ya que los editores y revisores tienen la tarea de revisar artículos que no se envían a los lugares más apropiados". [77]

Respuestas institucionales a las críticas al factor de impacto

En vista de las crecientes críticas y de su uso generalizado como medio de evaluación de la investigación, las organizaciones e instituciones han comenzado a tomar medidas para alejarse del factor de impacto de las revistas. En noviembre de 2007, la Asociación Europea de Editores Científicos (EASE) emitió una declaración oficial en la que recomendaba "que los factores de impacto de las revistas se utilicen únicamente -y con cautela- para medir y comparar la influencia de revistas enteras, pero no para la evaluación de artículos individuales y, desde luego, no para la evaluación de investigadores o programas de investigación". [23]

En julio de 2008, el Comité sobre Libertad y Responsabilidad en la Conducta Científica del Consejo Internacional para la Ciencia emitió una "declaración sobre las prácticas e índices de publicación y el papel de la revisión por pares en la evaluación de la investigación", sugiriendo muchas soluciones posibles, por ejemplo, considerar un número límite de publicaciones por año a tener en cuenta para cada científico, o incluso penalizar a los científicos por un número excesivo de publicaciones por año (por ejemplo, más de 20). [81]

En febrero de 2010, la Deutsche Forschungsgemeinschaft (Fundación Alemana de Investigación) publicó nuevas directrices para reducir el número de publicaciones que se podían presentar al solicitar financiación: "El enfoque no se ha centrado en qué investigación ha realizado alguien, sino más bien en cuántos artículos se han publicado y dónde". Señalaron que para las decisiones relativas a "asignaciones de financiación basadas en el rendimiento, calificaciones postdoctorales, nombramientos o revisión de propuestas de financiación, [donde] se ha dado una importancia cada vez mayor a indicadores numéricos como el índice h y el factor de impacto". [82] El Ejercicio de Evaluación de Investigación del Reino Unido para 2014 también prohibió el factor de impacto de las revistas [83], aunque la evidencia sugirió que esta prohibición a menudo se ignoraba. [84]

En respuesta a las crecientes preocupaciones sobre el uso inadecuado de los factores de impacto de las revistas para evaluar los resultados científicos y a los propios científicos, la Sociedad Estadounidense de Biología Celular, junto con un grupo de editores y editores de revistas académicas, creó la Declaración de San Francisco sobre Evaluación de la Investigación (DORA, por sus siglas en inglés). Publicada en mayo de 2013, DORA ha obtenido el apoyo de miles de personas y cientos de instituciones, [28] incluida en marzo de 2015 la Liga de Universidades de Investigación Europeas (un consorcio de 21 de las universidades de investigación más reconocidas de Europa), [85] que han respaldado el documento en el sitio web de DORA.

Los editores, incluso aquellos con altos factores de impacto, también reconocieron los defectos. [86] La revista Nature criticó la excesiva dependencia del JIF, señalando no sólo sus defectos estadísticos sino también los efectos negativos sobre la ciencia: "Las presiones y decepciones resultantes no son más que desmoralizantes, y en laboratorios mal gestionados pueden fomentar una investigación descuidada que, por ejemplo, no prueba los supuestos a fondo o no tiene en cuenta todos los datos antes de presentar grandes afirmaciones". [87] Varios editores utilizan ahora una mezcla de métricas en su sitio web; la serie de revistas PLOS no muestra el factor de impacto. [88] Microsoft Academic adoptó una opinión similar, afirmando que el índice h, el EI/SCI y los factores de impacto de las revistas no se muestran porque "la literatura de investigación ha proporcionado abundante evidencia de que estas métricas son, en el mejor de los casos, una aproximación aproximada del impacto de la investigación y la influencia académica". [89]

En 2021, la Universidad de Utrecht prometió abandonar toda la bibliometría cuantitativa, incluido el factor de impacto. La universidad afirmó que "se ha convertido en un modelo muy enfermizo que va más allá de lo que es realmente relevante para la ciencia y para promover la ciencia". [90] [91] Esto siguió a una decisión de 2018 del principal organismo de financiación holandés para la investigación, NWO , de eliminar todas las referencias a los factores de impacto de las revistas y al índice h en todos los textos de convocatoria y formularios de solicitud. [92] La decisión de Utrecht encontró cierta resistencia. Una carta abierta firmada por más de 150 académicos holandeses argumentó que, aunque imperfecto, el JIF sigue siendo útil y que omitirlo "conducirá a la aleatoriedad y a un compromiso de la calidad científica". [93]

Índices relacionados

Algunas métricas relacionadas, también calculadas y publicadas por la misma organización, incluyen:

- Vida media de las citas : la edad media de los artículos citados en Journal Citation Reports cada año. Por ejemplo, si la vida media de una revista en 2005 es 5, eso significa que las citas de 2001 a 2005 son la mitad de todas las citas de esa revista en 2005, y la otra mitad de las citas son anteriores a 2001. [94]

- Factor de impacto agregado para una categoría temática: se calcula teniendo en cuenta el número de citas a todas las revistas de la categoría temática y el número de artículos de todas las revistas de la categoría temática.

- Índice de inmediatez : número de citas que reciben los artículos de una revista en un año determinado dividido por el número de artículos publicados.

- Indicador de citación de revistas ( JCI ): un JIF que se ajusta al campo científico; es similar al Source Normalized Impact per Paper , calculado con base en la base de datos Scopus . [95] El JCI está disponible para todas las revistas de la Web of Science Core Collection (WoS CC), incluidas AHCI, ESCI, BCI y CPCI, mientras que el JIF solo está disponible para SCIE y SSCI; sin embargo, a partir de junio de 2023, el JIF también se emitirá para todas las revistas de la WoS CC. [96]

- Clasificación de cuartiles JIF : una clasificación basada en los cuatro cuartiles dentro de un tema o categoría de tema determinada. [97]

- Clasificación percentil JIF : una clasificación percentil calculada para una categoría temática particular. [98]

Una revista determinada puede alcanzar un cuartil o percentil diferente en diferentes categorías.

Al igual que con el factor de impacto, esto tiene algunos matices: por ejemplo, Clarivate excluye ciertos tipos de artículos (como noticias, correspondencia y erratas) del denominador. [99] [100] [101] [10]

Otras medidas de impacto científico

Existen otras métricas a nivel de revista disponibles en otras organizaciones. Por ejemplo, CiteScore es una métrica para títulos de publicaciones periódicas en Scopus lanzada en diciembre de 2016 por Elsevier . [102] [103] Si bien estas métricas se aplican solo a las revistas, también hay métricas a nivel de autor , como el índice h , que se aplican a investigadores individuales. Además, las métricas a nivel de artículo miden el impacto a nivel de artículo en lugar de a nivel de revista.

Otras métricas alternativas más generales, o " altmetrics ", que incluyen visualizaciones de artículos, descargas o menciones en redes sociales , ofrecen una perspectiva diferente sobre el impacto de la investigación, concentrándose más en el impacto social inmediato dentro y fuera del ámbito académico. [61] [104]

Factores de impacto falsificados

Los factores de impacto falsos o factores de impacto ficticios son producidos por ciertas empresas o individuos. [105] Según un artículo publicado en Electronic Physician , estos incluyen Global Impact Factor, Citefactor y Universal Impact Factor. [105] Jeffrey Beall mantuvo una lista de tales métricas engañosas. [106] [107] Otra práctica engañosa es informar "factores de impacto alternativos", calculados como el número promedio de citas por artículo utilizando índices de citas distintos de JCR como Google Scholar (por ejemplo, "Google-based Journal Impact Factor") o Microsoft Academic . [108]

Los editores depredadores suelen utilizar factores de impacto falsos . [109] [110] Consultar la lista maestra de revistas de Journal Citation Reports puede confirmar si una publicación está indexada por Journal Citation Reports . [111] El uso de métricas de impacto falsas se considera una señal de alerta . [112]

Véase también

Notas sobre alternativas

- ^ "'Calidad, no cantidad': la DFG adopta normas para contrarrestar la avalancha de publicaciones en el campo de la investigación" (nota de prensa). Deutsche Forschungsgemeinschaft ( Fundación Alemana de Investigación ). 2010. Nota de prensa de la DFG n.º 7.

- ^ "El Manifiesto de Leiden sobre Métricas de Investigación". 2015.

- ^ "Directrices de implementación del Plan S". Febrero de 2019.

Referencias

- ^ ab Waltman, Ludo; Traag, Vincent Antonio (1 de marzo de 2021). "Uso del factor de impacto de revistas para evaluar artículos individuales: ¿estadísticamente defectuoso o no?". F1000Research . 9 : 366. doi : 10.12688/f1000research.23418.2 . PMC 7974631 . PMID 33796272.

- ^ ab Curry S (febrero de 2018). "Vamos más allá de la retórica: es hora de cambiar la forma en que juzgamos la investigación". Nature . 554 (7691): 147. Bibcode :2018Natur.554..147C. doi :10.1038/d41586-018-01642-w. PMID 29420505.

- ^ ab Hutchins, BI; Yuan, X; Anderson, JM; Santangelo, GM (septiembre de 2016). "Relative Citation Ratio (RCR): A New Metric That Uses Citation Rates to Measure Influence at the Article Level" (Ratio relativo de citas [RCR]: una nueva métrica que utiliza las tasas de citas para medir la influencia a nivel de artículo). PLOS Biology . 14 (9): e1002541. doi : 10.1371/journal.pbio.1002541 . PMC 5012559 . PMID 27599104.

- ^ "Thomson Corporation adquirió ISI". En línea . Julio de 1992. Archivado desde el original el 15 de mayo de 2013 . Consultado el 26 de febrero de 2012 .

- ^ "Se completa la adquisición del negocio de propiedad intelectual y ciencia de Thomson Reuters por parte de Onex y Baring Asia" (Comunicado de prensa). 3 de octubre de 2016.

- ^ "Journal Citation Reports". Web of Science Group . Consultado el 14 de septiembre de 2019 .

- ^ "Web of Science Group". Web of Science Group . 5 de agosto de 2019 . Consultado el 28 de julio de 2020 .

- ^ ab "El factor de impacto de Clarivate". Clarivate . 20 de junio de 1994.

- ^ "Nature". 2017 Journal Citation Reports . Web of Science (edición científica). Thomson Reuters . 2018.

- ^ ab McVeigh ME, Mann SJ (septiembre de 2009). "El denominador del factor de impacto de la revista: definición de elementos citables (contados)". JAMA . 302 (10): 1107–9. doi : 10.1001/jama.2009.1301 . PMID 19738096.

- ^ Hubbard SC, McVeigh ME (2011). "Lanzar una red amplia: el numerador del factor de impacto de las revistas". Learned Publishing . 24 (2): 133–137. doi : 10.1087/20110208 . S2CID 20172401.

- ^ "RSC Advances recibe su primer factor de impacto parcial". Blog de RSC Advances . 24 de junio de 2013 . Consultado el 16 de julio de 2018 .

- ^ Konforti, Boyana (30 de julio de 2014). "Nuestro primer factor de impacto (parcial) y nuestra historia continua (completa)". Cell Mentor .

- ^ "JCR con Eigenfactor". Archivado desde el original el 2 de enero de 2010. Consultado el 26 de agosto de 2009 .

- ^ "Factor de impacto de 5 años del ISI". APA . Consultado el 12 de noviembre de 2017 .

- ^ Hoeffel C (diciembre de 1998). "Factores de impacto de revistas". Allergy . 53 (12): 1225. doi :10.1111/j.1398-9995.1998.tb03848.x. PMID 9930604. S2CID 5773127.

- ^ Garfield E (enero de 2006). "La historia y el significado del factor de impacto de las revistas". JAMA . 295 (1): 90–3. Bibcode :2006JAMA..295...90G. doi :10.1001/jama.295.1.90. PMID 16391221. S2CID 31183037.

- ^ Garfield E (junio de 1998). "[El factor de impacto y su aplicación adecuada]". Der Unfallchirurg . 101 (6): 413–4. PMID 9677838.

- ^ abcd Rossner M, Van Epps H, Hill E (diciembre de 2007). "Muéstrame los datos". The Journal of Cell Biology . 179 (6): 1091–2. doi :10.1083/jcb.200711140. PMC 2140038 . PMID 18086910.

- ^ McKiernan EC, Schimanski LA, Muñoz Nieves C, Matthias L, Niles MT, Alperin JP (julio de 2019). "Uso del factor de impacto de las revistas en la revisión académica, la promoción y la evaluación de la permanencia". eLife . 8 . doi : 10.7554/eLife.47338 . PMC 6668985 . PMID 31364991.

- ^ abc Müller, Ruth; de Rijcke, Sarah (1 de julio de 2017). "Pensar con indicadores. Explorando los impactos epistémicos de los indicadores de desempeño académico en las ciencias de la vida". Evaluación de la investigación . 26 (3): 157–168. doi :10.1093/reseval/rvx023. ISSN 0958-2029.

- ^ "Es hora de remodelar el factor de impacto de las revistas". Nature . 535 (7613): 466. Julio 2016. Bibcode :2016Natur.535..466.. doi : 10.1038/535466a . PMID 27466089.

- ^ ab "Declaración de la EASE sobre el uso inadecuado de los factores de impacto". Asociación Europea de Editores Científicos . Archivado desde el original el 14 de agosto de 2012. Consultado el 23 de julio de 2012 .

- ^ ab Callaway E (julio de 2016). "¡Supera el factor de impacto! La élite editorial se vuelve contra la métrica controvertida". Nature . 535 (7611): 210–1. Bibcode :2016Natur.535..210C. doi : 10.1038/nature.2016.20224 . PMID 27411614.

- ^ abc Brembs, Björn; Button, Katherine; Munafò, Marcus (24 de junio de 2013). "Impacto profundo: consecuencias no deseadas del ranking de revistas". Frontiers in Human Neuroscience . 7 : 291. arXiv : 1301.3748 . Bibcode :2013arXiv1301.3748B. doi : 10.3389/fnhum.2013.00291 . ISSN 1662-5161. PMC 3690355 . PMID 23805088.

- ^ van Wesel M (febrero de 2016). "Evaluación por citación: tendencias en el comportamiento de publicación, criterios de evaluación y la búsqueda de publicaciones de alto impacto". Ética en ciencia e ingeniería . 22 (1): 199–225. doi :10.1007/s11948-015-9638-0. PMC 4750571 . PMID 25742806.

- ^ Kansa E (27 de enero de 2014). "Es el neoliberalismo, estúpido: por qué los argumentos instrumentalistas a favor del acceso abierto, los datos abiertos y la ciencia abierta no son suficientes". Blog de impacto de la LSE . Consultado el 16 de julio de 2018 .

- ^ ab Cabello F, Rascón MT (2015). "El índice y la luna. Hipotecando la evaluación científica". Revista Internacional de Comunicación . 9 : 1880–1887.

- ^ Bornmann L, Daniel HD (2008). "¿Qué miden los recuentos de citas? Una revisión de estudios sobre el comportamiento de citación". Journal of Documentation . 64 (1): 45–80. doi :10.1108/00220410810844150. hdl : 11858/00-001M-0000-0013-7A94-3 . S2CID 17260826.

- ^ Anauati MV, Galiani S, Gálvez RM (11 de noviembre de 2014). "Cuantificación del ciclo de vida de artículos académicos en distintos campos de la investigación económica". SSRN 2523078.

- ^ van Nierop E (2009). "¿Por qué las revistas de estadística tienen factores de impacto bajos?". Statistica Neerlandica . 63 (1): 52–62. doi :10.1111/j.1467-9574.2008.00408.x. S2CID 247704905.

- ^ Bohannon J (2016). "¿Odias los factores de impacto de las revistas? Un nuevo estudio te da una razón más". Science . doi :10.1126/science.aag0643.

- ^ "Cámara de los Comunes – Ciencia y tecnología – Décimo informe". 7 de julio de 2004. Consultado el 28 de julio de 2008 .

- ^ Seglen PO (febrero de 1997). "Por qué no se debe utilizar el factor de impacto de las revistas para evaluar la investigación". BMJ . 314 (7079): 498–502. doi :10.1136/bmj.314.7079.497. PMC 2126010 . PMID 9056804.

- ^ "Declaración de la EASE sobre el uso inadecuado de los factores de impacto". Asociación Europea de Editores Científicos . Noviembre de 2007. Archivado desde el original el 14 de agosto de 2012. Consultado el 13 de abril de 2013 .

- ^ Wilsdon J, Allen L, Belfiore E, Campbell P, Curry S, Hill S, et al. (julio de 2015). The Metric Tide: Informe de la revisión independiente del papel de las métricas en la evaluación y gestión de la investigación (informe). doi :10.13140/RG.2.1.4929.1363.

- ^ Monastersky R (14 de octubre de 2005). "El número que devora la ciencia". The Chronicle of Higher Education .

- ^ Arnold DN , Fowler KK (2011). "Números nefastos". Avisos de la American Mathematical Society . 58 (3): 434–437. arXiv : 1010.0278 . Código Bibliográfico :2010arXiv1010.0278A.

- ^ Valderrama P, Escabias M, Valderrama MJ, Jiménez-Contreras E, Baca P (marzo de 2020). "Variables influyentes en el factor de impacto de las revistas de Odontología". Heliyon . 6 (3): e03575. Bibcode :2020Heliy...603575V. doi : 10.1016/j.heliyon.2020.e03575 . PMC 7082530 . PMID 32211547.

- ^ ab The PLoS Medicine Editors (junio de 2006). "El juego del factor de impacto. Es hora de encontrar una mejor manera de evaluar la literatura científica". PLOS Medicine . 3 (6): e291. doi : 10.1371/journal.pmed.0030291 . PMC 1475651 . PMID 16749869.

- ^ Agrawal AA (abril de 2005). "Corrupción de los factores de impacto de las revistas" (PDF) . Trends in Ecology & Evolution . 20 (4): 157. doi :10.1016/j.tree.2005.02.002. PMID 16701362. Archivado desde el original (PDF) el 19 de junio de 2010.

- ^ Fassoulaki A, Papilas K, Paraskeva A, Patris K (agosto de 2002). "Sesgo del factor de impacto y ajustes propuestos para su determinación". Acta Anaesthesiologica Scandinavica . 46 (7): 902–5. doi :10.1034/j.1399-6576.2002.460723.x. PMID 12139549. S2CID 20805963.

- ^ Schutte HK, Svec JG (2007). "Reacción de Folia Phoniatrica et Logopaedica sobre la tendencia actual de las medidas del factor de impacto". Folia Phoniatrica et Logopaedica . 59 (6): 281–5. doi :10.1159/000108334. PMID 17965570. S2CID 7595296.

- ^ "Journal Citation Reports – Notices". Archivado desde el original el 15 de mayo de 2010. Consultado el 24 de septiembre de 2009 .

- ^ McLeod S (25 de septiembre de 2020). "¿Deben los autores citar fuentes sugeridas por revisores pares? Seis antídotos para manejar sugerencias de citas de revisores potencialmente coercitivas". Learned Publishing . 34 (2): 282–286. doi :10.1002/leap.1335. ISSN 0953-1513. S2CID 225004022.

- ^ Wilhite AW, Fong EA (febrero de 2012). "Publicaciones científicas. Citación coercitiva en publicaciones académicas". Science . 335 (6068): 542–3. Bibcode :2012Sci...335..542W. doi :10.1126/science.1212540. PMID 22301307. S2CID 30073305.

- ^ Lynch JG (marzo de 2012). "Las revistas de negocios combaten las citas coercitivas". Science . 335 (6073): 1169.1–1169. Bibcode :2012Sci...335.1169L. doi :10.1126/science.335.6073.1169-a. PMID 22403371.

- ^ Dyer C (febrero de 1997). "La viuda puede ser inseminada con el esperma del marido". BMJ . 314 (7079): 461. doi :10.1136/bmj.314.7079.461d. PMC 2125988 . PMID 9056791.

- ^ Gargouri Y, Hajjem C, Lariviere V, Gingras Y, Carr L, Brody T, Harnad S (2018). "El factor de impacto de la revista: una breve historia, crítica y discusión de los efectos adversos". arXiv : 1801.08992 [cs.DL].

- ^ Al-Hoorie A, Vitta JP (2019). "Los siete pecados de la investigación en L2: una revisión de la calidad estadística de 30 revistas y sus factores de impacto en CiteScore, SJR, SNIP y JCR". Investigación en la enseñanza de lenguas . 23 (6): 727–744. doi :10.1177/1362168818767191. S2CID 149857357.

- ^ Falagas ME, Alexiou VG (2008). "Los diez primeros en manipulación del factor de impacto de revistas". Archivum Immunologiae et Therapiae Experimentalis . 56 (4): 223–6. doi :10.1007/s00005-008-0024-5. PMID 18661263. S2CID 7482376.

- ^ Tort AB, Targino ZH, Amaral OB (2012). "Los crecientes retrasos en la publicación inflan los factores de impacto de las revistas". PLOS ONE . 7 (12): e53374. Bibcode :2012PLoSO...753374T. doi : 10.1371/journal.pone.0053374 . PMC 3534064 . PMID 23300920.

- ^ Fong EA, Wilhite AW (2017). "Autoría y manipulación de citas en la investigación académica". PLOS ONE . 12 (12): e0187394. Bibcode :2017PLoSO..1287394F. doi : 10.1371/journal.pone.0187394 . PMC 5718422 . PMID 29211744.

- ^ Adler R, Ewing J, Taylor P (2009). "Estadísticas de citas: un informe de la Unión Matemática Internacional (IMU) en cooperación con el Consejo Internacional de Matemáticas Industriales y Aplicadas (ICIAM) y el Instituto de Estadística Matemática (IMS)" (PDF) . Ciencia estadística . 24 (1): 1–14. arXiv : 0910.3529 . doi :10.1214/09-STS285. ISSN 0883-4237. JSTOR 20697661. S2CID 219477.

- ^ Brembs B (2018). "Las revistas científicas prestigiosas luchan por alcanzar incluso una confiabilidad promedio". Frontiers in Human Neuroscience . 12 : 37. doi : 10.3389/fnhum.2018.00037 . PMC 5826185 . PMID 29515380.

- ^ Gargouri Y, Hajjem C, Lariviere V, Gingras Y, Carr L, Brody T, Harnad S (2009). "El efecto Matthew del factor de impacto: un experimento natural en bibliometría". arXiv : 0908.3177 [physics.soc-ph].

- ^ Severin, Anna; Strinzel, Michaela; Egger, Matthias; Barros, Tiago; Sokolov, Alexander; Mouatt, Julia Vilstrup; Müller, Stefan (29 de agosto de 2023). Dirnagl, Ulrich (ed.). "Relación entre el factor de impacto de las revistas y la minuciosidad y utilidad de las revisiones por pares". PLOS Biology . 21 (8): e3002238. doi : 10.1371/journal.pbio.3002238 . eISSN 1545-7885. ISSN 1544-9173. LCCN 2003212293. OCLC 1039259630. PMC 10464996 . PMID 37643173.

- ^ Vessuri, Hebe; Guédon, Jean-Claude; Cetto, Ana María (septiembre de 2014). "¿Excelencia o calidad? Impacto del actual régimen de competencia en la ciencia y la publicación científica en América Latina y sus implicaciones para el desarrollo". Sociología actual . 62 (5): 647–665. doi :10.1177/0011392113512839. eISSN 1461-7064. ISSN 0011-3921. S2CID 25166127 – vía Sage Publishing .

- ^ Moore S, Neylon C, Eve MP, O'Donnell DP, Pattinson D (2017). "'Excellence R Us': Investigación universitaria y la fetichización de la excelencia". Palgrave Communications . 3 . doi : 10.1057/palcomms.2016.105 .

- ^ Owen R, Macnaghten P, Stilgoe J (2012). "Investigación e innovación responsables: de la ciencia en la sociedad a la ciencia para la sociedad, con la sociedad". Ciencia y políticas públicas . 39 (6): 751–760. doi :10.1093/scipol/scs093.

- ^ ab Hicks D, Wouters P, Waltman L, de Rijcke S, Rafols I (abril de 2015). "Bibliometría: El Manifiesto de Leiden para las métricas de investigación". Naturaleza . 520 (7548): 429–31. Código Bib :2015Natur.520..429H. doi : 10.1038/520429a . hdl : 10261/132304 . PMID 25903611.

- ^ "Acceso abierto y la división entre lo 'convencional' y lo 'periférico". Como Gerir e Qualificar Revistas Científicas : 1–25.

- ^ Alperin JP, Muñoz Nieves C, Schimanski LA, Fischman GE, Niles MT, McKiernan EC (febrero de 2019). "¿Qué importancia tienen las dimensiones públicas del trabajo del profesorado en los documentos de revisión, promoción y titularidad?". eLife . 8 . doi : 10.7554/eLife.42254 . PMC 6391063 . PMID 30747708.

- ^ Adam D (febrero de 2002). "La casa de contabilidad". Nature . 415 (6873): 726–9. doi : 10.1038/415726a . PMID 11845174. S2CID 4407346.

- ^ Baylis M, Gravenor M, Kao R (septiembre de 1999). "Mejora del factor de impacto". Nature . 401 (6751): 322. doi : 10.1038/43768-c1 . PMID 10517624. S2CID 4356889.

- ^ Brembs B (8 de enero de 2016). "¿Hasta qué punto se han extendido las negociaciones sobre el factor de impacto?" . Consultado el 14 de julio de 2020 .

- ^ Callaway E (julio de 2016). "¡Supera el factor de impacto! La élite editorial se vuelve contra las métricas controvertidas". Nature . 535 (7611): 210–1. Bibcode :2016Natur.535..210C. doi : 10.1038/nature.2016.20224 . PMID 27411614.

- ^ Comité Conjunto sobre Evaluación Cuantitativa de la Investigación (12 de junio de 2008). «Estadísticas de citas» (PDF) . Unión Matemática Internacional.

- ^ "Impacto no tan profundo". Nature . 435 (7045): 1003–4. Junio de 2005. doi : 10.1038/4351003b . PMID 15973362.

- ^ Lozano GA, Larivière V, Gingras Y (2012). "La relación cada vez más débil entre el factor de impacto y las citas de los artículos en la era digital". Revista de la Sociedad Americana de Ciencias de la Información y Tecnología . 63 (11): 2140–2145. arXiv : 1205.4328 . Código Bibliográfico :2012arXiv1205.4328L. doi :10.1002/asi.22731. S2CID 492922.

- ^ Grant B (21 de junio de 2010). «Nuevos factores de impacto arrojan sorpresas». The Scientist . Archivado desde el original el 6 de marzo de 2011. Consultado el 31 de marzo de 2011 .

- ^ McVeigh M (17 de junio de 2010). "¿Qué significa ser el número 2 en Impact?". Archivado desde el original el 12 de octubre de 2017. Consultado el 16 de julio de 2018 .

- ^ Larivière V, Kiermer V, MacCallum CJ, McNutt M, Patterson M, Pulverer B, et al. (2016). "Una propuesta sencilla para la publicación de distribuciones de citas de revistas". bioRxiv 10.1101/062109 .

- ^ Kiermer V (2016). "Medición: los factores de impacto no reflejan las tasas de citación de los artículos". PLOS .

- ^ "Dejar de lado los factores de impacto para obtener datos más profundos". The Scientist . Consultado el 29 de julio de 2016 .

- ^ Corneliussen S (2016). "Mal verano para el factor de impacto de las revistas". Physics Today (8). doi :10.1063/PT.5.8183.

- ^ ab Larivière V, Sugimoto CR (2019), Glänzel W, Moed HF, Schmoch U, Thelwall M (eds.), "El factor de impacto de las revistas: una breve historia, crítica y discusión de los efectos adversos", Springer Handbook of Science and Technology Indicators , Springer Handbooks, Cham: Springer International Publishing, págs. 3–24, arXiv : 1801.08992 , doi :10.1007/978-3-030-02511-3_1, ISBN 978-3-030-02510-6, Número de identificación del sujeto 3677889

- ^ Templ M (19 de junio de 2020). "Modelado y predicción del factor de impacto de revistas que utilizan bases de datos de acceso abierto: con una aplicación al Austrian Journal of Statistics". Revista Austriaca de Estadística . 49 (5): 35–58. doi : 10.17713/ajs.v49i5.1186 . ISSN 1026-597X. S2CID 225704065.

- ^ Stephan, Paula; Veugelers, Reinhilde; Wang, Jian (abril de 2017). "Los revisores están cegados por la bibliometría". Nature . 544 (7651): 411–412. Bibcode :2017Natur.544..411S. doi : 10.1038/544411a . ISSN 0028-0836. PMID 28447652. S2CID 5197138.

- ^ "Informar sobre las opciones de investigación: indicadores y juicios" . Consultado el 16 de agosto de 2021 .

- ^ "Declaración del Consejo Internacional para la Ciencia". Icsu.org. 2 de mayo de 2014. Archivado desde el original el 26 de abril de 2017. Consultado el 18 de mayo de 2014 .

- ^ "Calidad, no cantidad: la DFG adopta normas para contrarrestar la avalancha de publicaciones en el campo de la investigación". Deutsche Forschungsgemeinschaft. 23 de febrero de 2010. Consultado el 16 de julio de 2018 .

- ^ "El índice H departamental es un método más transparente, justo y rentable para distribuir fondos a las universidades". Impact of Social Sciences . 8 de febrero de 2013 . Consultado el 14 de agosto de 2021 .

- ^ "¿Es lo mismo de siempre a la hora de juzgar el valor de un investigador?". The Guardian . 30 de noviembre de 2012 . Consultado el 14 de agosto de 2021 .

- ^ "No todo lo que se puede contar cuenta...". Liga de Universidades de Investigación Europeas. 16 de marzo de 2015. Archivado desde el original el 1 de diciembre de 2017.

- ^ Callaway, Ewen (julio de 2016). "¡Supera el factor de impacto! La élite editorial se vuelve contra las métricas controvertidas". Nature . 535 (7611): 210–211. Bibcode :2016Natur.535..210C. doi : 10.1038/nature.2016.20224 . ISSN 0028-0836. PMID 27411614. S2CID 4452614.

- ^ "Es hora de remodelar el factor de impacto de las revistas". Nature . 535 (7613): 466. Julio 2016. Bibcode :2016Natur.535..466.. doi : 10.1038/535466a . ISSN 0028-0836. PMID 27466089. S2CID 4463743.

- ^ "Información de la revista". PLOS ONE . Consultado el 14 de agosto de 2021 .

- ^ "Preguntas frecuentes". Microsoft Academic . Archivado desde el original el 5 de enero de 2017 . Consultado el 15 de diciembre de 2020 .

- ^ Woolston C (julio de 2021). "Factor de impacto abandonado por la universidad holandesa en decisiones de contratación y promoción". Nature . 595 (7867): 462. Bibcode :2021Natur.595..462W. doi : 10.1038/d41586-021-01759-5 . PMID 34172959. S2CID 235647170.

- ^ "Reconocimientos y recompensas | Universiteit Utrecht". www.uu.nl. Consultado el 19 de julio de 2021 .

- ^ "DORA | NWO". www.nwo.nl . Consultado el 21 de julio de 2021 .

- ^ "Los científicos no se ponen de acuerdo sobre las reformas de la Universidad de Utrecht en los criterios de contratación y promoción". www.natureindex.com . 9 de agosto de 2021 . Consultado el 14 de agosto de 2021 .

- ^ "Factor de impacto, índice de inmediatez, vida media citada". Universidad Sueca de Ciencias Agrícolas. Archivado desde el original el 23 de mayo de 2008. Consultado el 30 de octubre de 2016 .

- ^ "El factor de impacto de las revistas tiene un hermano que se ajusta al campo científico". Ciencia | AAAS . 30 de junio de 2021 . Consultado el 30 de junio de 2021 .

- ^ "Proceso de evaluación y criterios de selección de revistas de Web of Science". Clarivate . 26 de julio de 2022 . Consultado el 18 de enero de 2023 .

- ^ "Investigación científica y académica". Soporte . Clarivate . Consultado el 25 de marzo de 2023 .

- ^ "Percentil del factor de impacto de la revista". jcr.help.clarivate.com . Consultado el 24 de mayo de 2023 .

- ^ "Bibliometría (mediciones de revistas)". Elsevier . Archivado desde el original el 18 de agosto de 2012 . Consultado el 9 de julio de 2012 .

Medida de la velocidad con la que se selecciona y se hace referencia al contenido de una revista en particular.

- ^ "Glosario de terminología científica de Thomson". Thomson Reuters . Archivado desde el original el 20 de abril de 2017. Consultado el 9 de julio de 2012 .

- ^ "Journal Citation Reports Contents – Immediacy Index" ((en línea)) . Clarivate Analytics . Consultado el 9 de julio de 2012 .

El índice de inmediatez es el número promedio de veces que se cita un artículo en el año de su publicación. El índice de inmediatez de una revista indica la rapidez con la que se citan los artículos de una revista. El índice de inmediatez agregado indica la rapidez con la que se citan los artículos de una categoría temática.

- ^ "Métricas – Características – Scopus – Soluciones". www.elsevier.com . Consultado el 9 de diciembre de 2016 .

- ^ Van Noorden R (diciembre de 2016). "El controvertido factor de impacto consigue un rival de peso pesado". Naturaleza . 540 (7633): 325–326. Código Bib :2016Natur.540..325V. doi : 10.1038/naturaleza.2016.21131 . PMID 27974784.

- ^ Priem J, Taraborelli D, Groth P, Neylon C (26 de octubre de 2010). "Altmetrics: un manifiesto".

- ^ ab Jalalian M (2015). "La historia de las empresas con factores de impacto falsos y cómo las detectamos". Electronic Physician . 7 (2): 1069–72. doi :10.14661/2015.1069-1072. PMC 4477767 . PMID 26120416.

- ^ "Métricas engañosas". Acceso abierto académico . Archivado desde el original el 11 de enero de 2017.

- ^ "Métricas engañosas: la lista de Beall".

- ^ Xia J, Smith MP (2018). "Factores de impacto de revistas alternativas en publicaciones de acceso abierto". Learned Publishing . 31 (4): 403–411. doi : 10.1002/leap.1200 . ISSN 0953-1513.

- ^ Beall J. «Acceso abierto académico: factores de impacto falsos». Archivado desde el original el 21 de marzo de 2016.

- ^ Documento de debate: Publicaciones depredadoras (informe). Comité de Ética de Publicaciones. 1 de noviembre de 2019. doi : 10.24318/cope.2019.3.6 .

- ^ "Lista maestra de revistas". Grupo Web of Science . Clarivate.

- ^ Ebrahimzadeh MH (abril de 2016). "Medidas validadas de calidad de publicación: guía para que los investigadores novatos elijan una revista adecuada para enviar artículos". The Archives of Bone and Joint Surgery . 4 (2): 94–6. PMC 4852052 . PMID 27200383.

Lectura adicional

- "¿El 'factor de impacto' influye en las decisiones sobre dónde publicar?". APS News . 15 (4). American Physical Society . Abril de 2006 . Consultado el 1 de julio de 2010 .

- Garfield E (octubre de 1999). "Factor de impacto de revistas: una breve revisión". CMAJ . 161 (8): 979–80. PMC 1230709 . PMID 10551195.

- Gilbert N (noviembre de 2010). "La ciencia del Reino Unido será juzgada por su impacto". Nature . 468 (7322): 357. Bibcode :2010Natur.468..357G. doi : 10.1038/468357a . PMID 21085146.

- Groesser SN (2012). "Dinámica de los factores de impacto de las revistas" (PDF) . Systems Research and Behavioral Science . 29 (6): 624–644. doi :10.1002/sres.2142.

- Lariviere V, Sugimoto CR (2018). "El factor de impacto de las revistas: una breve historia, crítica y discusión de los efectos adversos". arXiv : 1801.08992 [cs.DL].

- Marcus A, Oransky I (22 de mayo de 2015). "¿Qué hay detrás de los grandes fraudes científicos?". Opinión. The New York Times .

- "Ranking de revistas y países: clasificaciones de Scopus y Scimago Lab". Scopus y Scimago Lab . Scimago . Consultado el 23 de octubre de 2018 .