Memoria de acceso aleatorio

| Tipos de memoria de computadora y almacenamiento de datos |

|---|

| Volátil |

| Non-volatile |

La memoria de acceso aleatorio ( RAM ; / r æ m / ) es una forma de memoria electrónica de computadora que se puede leer y cambiar en cualquier orden, generalmente se usa para almacenar datos de trabajo y código de máquina . [1] [2] Un dispositivo de memoria de acceso aleatorio permite que los elementos de datos se lean o escriban en casi la misma cantidad de tiempo independientemente de la ubicación física de los datos dentro de la memoria, en contraste con otros medios de almacenamiento de datos de acceso directo (como discos duros y cintas magnéticas ), donde el tiempo requerido para leer y escribir elementos de datos varía significativamente dependiendo de sus ubicaciones físicas en el medio de grabación, debido a limitaciones mecánicas como las velocidades de rotación del medio y el movimiento del brazo.

En la tecnología actual, la memoria de acceso aleatorio adopta la forma de chips de circuitos integrados (CI) con celdas de memoria MOS (metal-óxido-semiconductor) . La RAM normalmente se asocia con tipos de memoria volátiles en los que la información almacenada se pierde si se corta la energía. Los dos tipos principales de memoria volátil de semiconductores de acceso aleatorio son la memoria estática de acceso aleatorio (SRAM) y la memoria dinámica de acceso aleatorio (DRAM).

También se ha desarrollado la memoria RAM no volátil [3] y otros tipos de memorias no volátiles permiten el acceso aleatorio para operaciones de lectura, pero no permiten operaciones de escritura o tienen otros tipos de limitaciones. Entre ellas se incluyen la mayoría de los tipos de memorias flash ROM y NOR .

El uso de RAM de semiconductores se remonta a 1965, cuando IBM introdujo el chip SRAM SP95 monolítico (de un solo chip) de 16 bits para su computadora System/360 Modelo 95 , y Toshiba utilizó celdas de memoria DRAM bipolares para su calculadora electrónica Toscal BC-1411 de 180 bits , ambas basadas en transistores bipolares . Si bien ofrecía velocidades más altas que la memoria de núcleo magnético , la DRAM bipolar no podía competir con el precio más bajo de la memoria de núcleo magnético dominante en ese momento. [4] En 1966, el Dr. Robert Dennard inventó la arquitectura DRAM moderna en la que hay un solo transistor MOS por capacitor. [5] El primer chip IC DRAM comercial, el 1K Intel 1103 , se introdujo en octubre de 1970. La memoria de acceso aleatorio dinámico sincrónico (SDRAM) se reintrodujo con el chip Samsung KM48SL2000 en 1992.

Historia

Las primeras computadoras usaban relés , contadores mecánicos [6] o líneas de retardo para las funciones de memoria principal. Las líneas de retardo ultrasónicas eran dispositivos seriales que solo podían reproducir datos en el orden en que se escribían. La memoria de tambor se podía expandir a un costo relativamente bajo, pero la recuperación eficiente de elementos de memoria requiere conocimiento de la disposición física del tambor para optimizar la velocidad. Los pestillos construidos a partir de tubos de vacío de triodo y, más tarde, de transistores discretos , se usaban para memorias más pequeñas y rápidas, como registros . Dichos registros eran relativamente grandes y demasiado costosos para usarlos con grandes cantidades de datos; generalmente, solo se podían proporcionar unas pocas docenas o unos pocos cientos de bits de dicha memoria.

La primera forma práctica de memoria de acceso aleatorio fue el tubo Williams . Almacenaba datos como puntos cargados eléctricamente en la cara de un tubo de rayos catódicos . Dado que el haz de electrones del CRT podía leer y escribir los puntos del tubo en cualquier orden, la memoria era de acceso aleatorio. La capacidad del tubo Williams era de unos pocos cientos a alrededor de mil bits, pero era mucho más pequeño, más rápido y más eficiente energéticamente que el uso de pestillos de tubo de vacío individuales. Desarrollado en la Universidad de Manchester en Inglaterra, el tubo Williams proporcionó el medio en el que se implementó el primer programa almacenado electrónicamente en la computadora Manchester Baby , que ejecutó con éxito por primera vez un programa el 21 de junio de 1948. [7] De hecho, en lugar de que la memoria del tubo Williams estuviera diseñada para el Baby, el Baby fue un banco de pruebas para demostrar la confiabilidad de la memoria. [8] [9]

La memoria de núcleo magnético se inventó en 1947 y se desarrolló hasta mediados de la década de 1970. Se convirtió en una forma generalizada de memoria de acceso aleatorio, basada en una matriz de anillos magnetizados. Al cambiar el sentido de la magnetización de cada anillo, se podían almacenar datos con un bit almacenado por anillo. Dado que cada anillo tenía una combinación de cables de dirección para seleccionarlo y leerlo o escribirlo, era posible acceder a cualquier ubicación de memoria en cualquier secuencia. La memoria de núcleo magnético fue la forma estándar de memoria de computadora hasta que fue reemplazada por la memoria de semiconductores en circuitos integrados (CI) a principios de la década de 1970. [10]

Antes del desarrollo de circuitos de memoria de solo lectura (ROM) integrados, la memoria de acceso aleatorio permanente (o de solo lectura ) se construía a menudo utilizando matrices de diodos controladas por decodificadores de direcciones o planos de memoria con núcleos especialmente enrollados . [ cita requerida ]

La memoria de semiconductores apareció en la década de 1960 con la memoria bipolar, que utilizaba transistores bipolares . Aunque era más rápida, no podía competir con el precio más bajo de la memoria de núcleo magnético. [11]

Memoria RAM MOS

En 1957, Frosch y Derick lograron fabricar los primeros transistores de efecto de campo de dióxido de silicio en Bell Labs, los primeros transistores en los que el drenaje y la fuente estaban adyacentes en la superficie. [12] Posteriormente, un equipo demostró un MOSFET funcional en Bell Labs en 1960. [13] [14]

Esto condujo al desarrollo de la memoria de semiconductor de óxido de metal (MOS) por John Schmidt en Fairchild Semiconductor en 1964. [10] [15] Además de velocidades más altas, la memoria de semiconductor MOS era más barata y consumía menos energía que la memoria de núcleo magnético. [10] El desarrollo de la tecnología de circuito integrado MOS de compuerta de silicio (MOS IC) por Federico Faggin en Fairchild en 1968 permitió la producción de chips de memoria MOS . [16] La memoria MOS superó a la memoria de núcleo magnético como la tecnología de memoria dominante a principios de la década de 1970. [10]

La memoria de acceso aleatorio estática bipolar integrada (SRAM) fue inventada por Robert H. Norman en Fairchild Semiconductor en 1963. [17] Fue seguida por el desarrollo de MOS SRAM por John Schmidt en Fairchild en 1964. [10] SRAM se convirtió en una alternativa a la memoria de núcleo magnético, pero requería seis transistores MOS para cada bit de datos. [18] El uso comercial de SRAM comenzó en 1965, cuando IBM introdujo el chip de memoria SP95 para el System/360 Model 95. [ 11]

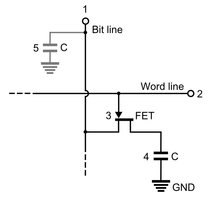

La memoria dinámica de acceso aleatorio (DRAM) permitió reemplazar un circuito de bloqueo de 4 o 6 transistores por un solo transistor para cada bit de memoria, lo que aumentó enormemente la densidad de la memoria a costa de la volatilidad. Los datos se almacenaban en la pequeña capacidad de cada transistor y debían actualizarse periódicamente cada pocos milisegundos antes de que la carga pudiera perderse.

La calculadora electrónica Toscal BC-1411 de Toshiba , que se presentó en 1965, [19] [20] [21] utilizaba una forma de DRAM bipolar de condensadores, que almacenaba datos de 180 bits en celdas de memoria discretas , que consistían en transistores bipolares de germanio y condensadores. [20] [21] Si bien ofrecía velocidades más altas que la memoria de núcleo magnético, la DRAM bipolar no podía competir con el precio más bajo de la memoria de núcleo magnético dominante en ese momento. [22] Los condensadores también se habían utilizado para esquemas de memoria anteriores, como el tambor de la computadora Atanasoff-Berry , el tubo Williams y el tubo Selectron .

En 1966, el Dr. Robert Dennard inventó la arquitectura DRAM moderna para la cual hay un solo transistor MOS por capacitor. [18] Mientras examinaba las características de la tecnología MOS, descubrió que era capaz de construir capacitores , y que almacenar una carga o ninguna carga en el capacitor MOS podría representar el 1 y el 0 de un bit, mientras que el transistor MOS podría controlar la escritura de la carga en el capacitor. Esto lo llevó al desarrollo de una celda de memoria DRAM de un solo transistor. [18] En 1967, Dennard presentó una patente bajo IBM para una celda de memoria DRAM de un solo transistor, basada en tecnología MOS. [23] El primer chip IC DRAM comercial fue el Intel 1103 , que se fabricó en un proceso MOS de 8 μm con una capacidad de 1 kbit , y se lanzó en 1970. [10] [24] [25]

Las primeras DRAM solían estar sincronizadas con el reloj de la CPU (clocked) y se utilizaban con los primeros microprocesadores. A mediados de la década de 1970, las DRAM pasaron al diseño asíncrono, pero en la década de 1990 volvieron al funcionamiento sincrónico. [26] [27] En 1992, Samsung lanzó KM48SL2000, que tenía una capacidad de 16 Mbit . [28] [29] y se produjo en masa en 1993. [28] El primer chip de memoria DDR SDRAM ( Double Data Rate SDRAM) comercial fue el chip DDR SDRAM de 64 Mbit de Samsung , lanzado en junio de 1998. [30] GDDR (Gráficos DDR) es una forma de DDR SGRAM (RAM de gráficos sincrónicos), que fue lanzado por primera vez por Samsung como un chip de memoria de 16 Mbit en 1998. [31]

Tipos

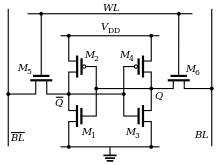

Las dos formas de RAM modernas más utilizadas son la RAM estática (SRAM) y la RAM dinámica (DRAM). En la SRAM, se almacena un bit de datos utilizando el estado de una celda de memoria de seis transistores , normalmente utilizando seis MOSFET. Esta forma de RAM es más cara de producir, pero generalmente es más rápida y requiere menos energía dinámica que la DRAM. En las computadoras modernas, la SRAM se utiliza a menudo como memoria caché para la CPU . La DRAM almacena un bit de datos utilizando un par de transistores y condensadores (normalmente un MOSFET y un condensador MOS , respectivamente), [32] que juntos forman una celda DRAM. El condensador mantiene una carga alta o baja (1 o 0, respectivamente), y el transistor actúa como un interruptor que permite que el circuito de control en el chip lea el estado de carga del condensador o lo cambie. Como esta forma de memoria es menos costosa de producir que la RAM estática, es la forma predominante de memoria de computadora utilizada en las computadoras modernas.

Tanto la RAM estática como la dinámica se consideran volátiles , ya que su estado se pierde o se restablece cuando se corta la energía del sistema. Por el contrario, la memoria de solo lectura (ROM) almacena datos habilitando o deshabilitando permanentemente transistores seleccionados, de modo que la memoria no se pueda alterar. Las variantes de ROM que se pueden escribir (como EEPROM y flash NOR ) comparten propiedades tanto de la ROM como de la RAM, lo que permite que los datos persistan sin energía y se actualicen sin necesidad de equipo especial. La memoria ECC (que puede ser SRAM o DRAM) incluye circuitos especiales para detectar y/o corregir fallas aleatorias (errores de memoria) en los datos almacenados, utilizando bits de paridad o códigos de corrección de errores .

En general, el término RAM se refiere únicamente a dispositivos de memoria de estado sólido (ya sea DRAM o SRAM), y más específicamente a la memoria principal en la mayoría de las computadoras. En el almacenamiento óptico, el término DVD-RAM es un nombre un tanto inapropiado, ya que no es de acceso aleatorio; se comporta de manera muy similar a una unidad de disco duro, aunque un poco más lento. Además, a diferencia de los CD-RW o DVD-RW , los DVD-RAM no necesitan borrarse antes de volver a usarse.

Célula de memoria

La celda de memoria es el componente fundamental de la memoria de la computadora . La celda de memoria es un circuito electrónico que almacena un bit de información binaria y debe configurarse para almacenar un 1 lógico (nivel de voltaje alto) y reiniciarse para almacenar un 0 lógico (nivel de voltaje bajo). Su valor se mantiene/almacena hasta que se modifica mediante el proceso de configuración/reinicio. Se puede acceder al valor de la celda de memoria leyéndolo.

En SRAM, la celda de memoria es un tipo de circuito flip-flop , generalmente implementado mediante FET . Esto significa que la SRAM requiere muy poca energía cuando no se accede a ella, pero es costosa y tiene baja densidad de almacenamiento.

Un segundo tipo, la DRAM, se basa en un condensador. La carga y descarga de este condensador puede almacenar un "1" o un "0" en la celda. Sin embargo, la carga de este condensador se pierde lentamente y debe renovarse periódicamente. Debido a este proceso de renovación, la DRAM utiliza más energía, pero puede lograr mayores densidades de almacenamiento y menores costos unitarios en comparación con la SRAM.

|  |

Direccionamiento

Para ser útiles, las celdas de memoria deben ser legibles y escribibles. Dentro del dispositivo RAM, se utilizan circuitos de multiplexación y demultiplexación para seleccionar celdas de memoria. Normalmente, un dispositivo RAM tiene un conjunto de líneas de dirección y, por cada combinación de bits que se pueda aplicar a estas líneas, se activa un conjunto de celdas de memoria. Debido a este direccionamiento, los dispositivos RAM prácticamente siempre tienen una capacidad de memoria que es una potencia de dos.

Por lo general, varias celdas de memoria comparten la misma dirección. Por ejemplo, un chip de RAM de 4 bits de ancho tiene 4 celdas de memoria para cada dirección. A menudo, el ancho de la memoria y el del microprocesador son diferentes; para un microprocesador de 32 bits, se necesitarían ocho chips de RAM de 4 bits.

A menudo se necesitan más direcciones de las que puede proporcionar un dispositivo. En ese caso, se utilizan multiplexores externos al dispositivo para activar el dispositivo correcto al que se está accediendo. La RAM suele ser direccionable mediante bytes, aunque también es posible hacer que la RAM sea direccionable mediante palabras. [33] [34]

Jerarquía de la memoria

Se pueden leer y sobrescribir datos en la RAM. Muchos sistemas informáticos tienen una jerarquía de memoria que consta de registros de procesador , cachés SRAM integrados , cachés externos , DRAM , sistemas de paginación y memoria virtual o espacio de intercambio en un disco duro. Muchos desarrolladores pueden denominar a todo este conjunto de memoria como "RAM", aunque los diversos subsistemas pueden tener tiempos de acceso muy diferentes , lo que viola el concepto original detrás del término de acceso aleatorio en RAM. Incluso dentro de un nivel de jerarquía como DRAM, la organización específica de filas, columnas, bancos, rangos , canales o intercalaciones de los componentes hace que el tiempo de acceso sea variable, aunque no en la medida en que lo sea el tiempo de acceso a un medio de almacenamiento giratorio o una cinta. El objetivo general de utilizar una jerarquía de memoria es obtener el tiempo de acceso promedio más rápido posible al tiempo que se minimiza el costo total de todo el sistema de memoria (generalmente, la jerarquía de memoria sigue el tiempo de acceso con los registros rápidos de la CPU en la parte superior y el disco duro lento en la parte inferior).

En muchos ordenadores personales modernos, la RAM se presenta en forma de módulos fácilmente actualizables, llamados módulos de memoria o módulos DRAM, del tamaño de unos cuantos chicles. Estos pueden reemplazarse rápidamente si se dañan o cuando las necesidades cambiantes exigen más capacidad de almacenamiento. Como se sugirió anteriormente, también se integran cantidades más pequeñas de RAM (principalmente SRAM) en la CPU y otros circuitos integrados de la placa base , así como en los discos duros, CD-ROM y otras partes del sistema informático.

Otros usos de la RAM

Además de servir como almacenamiento temporal y espacio de trabajo para el sistema operativo y las aplicaciones, la RAM se utiliza de muchas otras maneras.

Memoria virtual

La mayoría de los sistemas operativos modernos emplean un método para ampliar la capacidad de la RAM, conocido como "memoria virtual". Una parte del disco duro del ordenador se reserva para un archivo de paginación o una partición de trabajo , y la combinación de la RAM física y el archivo de paginación forman la memoria total del sistema. (Por ejemplo, si un ordenador tiene 2 GB (1024 3 B) de RAM y un archivo de paginación de 1 GB, el sistema operativo tiene 3 GB de memoria total disponible). Cuando el sistema se queda sin memoria física, puede " cambiar " porciones de RAM al archivo de paginación para hacer espacio para nuevos datos, así como para leer la información intercambiada previamente en la RAM. El uso excesivo de este mecanismo da como resultado un mal funcionamiento y, en general, perjudica el rendimiento general del sistema, principalmente porque los discos duros son mucho más lentos que la RAM.

Disco RAM

El software puede "particionar" una parte de la memoria RAM de una computadora, lo que le permite actuar como un disco duro mucho más rápido, llamado disco RAM . Un disco RAM pierde los datos almacenados cuando se apaga la computadora, a menos que la memoria esté configurada para tener una fuente de batería de respaldo o que los cambios en el disco RAM se escriban en un disco no volátil. El disco RAM se vuelve a cargar desde el disco físico al inicializarse.

RAM de sombra

A veces, el contenido de un chip ROM relativamente lento se copia a una memoria de lectura/escritura para permitir tiempos de acceso más cortos. Luego, el chip ROM se desactiva mientras las ubicaciones de memoria inicializadas se cambian en el mismo bloque de direcciones (a menudo protegidas contra escritura). Este proceso, a veces llamado shadowing , es bastante común tanto en computadoras como en sistemas integrados .

Como ejemplo común, el BIOS de las computadoras personales típicas a menudo tiene una opción llamada "usar BIOS shadow" o similar. Cuando está habilitada, las funciones que dependen de los datos de la ROM del BIOS usan en su lugar ubicaciones de DRAM (la mayoría también puede alternar el sombreado de la ROM de la tarjeta de video u otras secciones de ROM). Dependiendo del sistema, esto puede no resultar en un aumento del rendimiento y puede causar incompatibilidades. Por ejemplo, algunos hardware pueden ser inaccesibles para el sistema operativo si se usa RAM shadow. En algunos sistemas, el beneficio puede ser hipotético porque el BIOS no se usa después del arranque a favor del acceso directo al hardware. La memoria libre se reduce por el tamaño de las ROM shadow. [35]

Muro de la memoria

El " muro de la memoria" es la creciente disparidad de velocidad entre la CPU y el tiempo de respuesta de la memoria (conocido como latencia de la memoria ) fuera del chip de la CPU. Una razón importante para esta disparidad es el limitado ancho de banda de comunicación más allá de los límites del chip, que también se conoce como muro del ancho de banda . De 1986 a 2000, la velocidad de la CPU mejoró a una tasa anual del 55%, mientras que el tiempo de respuesta de la memoria fuera del chip solo mejoró un 10%. Dadas estas tendencias, se esperaba que la latencia de la memoria se convirtiera en un cuello de botella abrumador en el rendimiento de la computadora. [36]

Otra razón para la disparidad es el enorme aumento en el tamaño de la memoria desde el comienzo de la revolución de la PC en la década de 1980. Originalmente, las PC contenían menos de 1 mebibyte de RAM, que a menudo tenía un tiempo de respuesta de 1 ciclo de reloj de CPU, lo que significa que requería 0 estados de espera. Las unidades de memoria más grandes son inherentemente más lentas que las más pequeñas del mismo tipo, simplemente porque las señales tardan más en atravesar un circuito más grande. Construir una unidad de memoria de muchos gibibytes con un tiempo de respuesta de un ciclo de reloj es difícil o imposible. Las CPU de hoy a menudo todavía tienen un mebibyte de memoria caché de 0 estados de espera, pero reside en el mismo chip que los núcleos de la CPU debido a las limitaciones de ancho de banda de la comunicación de chip a chip. También debe construirse a partir de RAM estática, que es mucho más cara que la RAM dinámica utilizada para memorias más grandes. La RAM estática también consume mucha más energía.

Las mejoras en la velocidad de la CPU se han ralentizado significativamente, en parte debido a importantes barreras físicas y en parte porque los diseños actuales de CPU ya han chocado contra el muro de la memoria en cierto sentido. Intel resumió estas causas en un documento de 2005. [37]

En primer lugar, a medida que las geometrías de los chips se reducen y las frecuencias de reloj aumentan, la corriente de fuga del transistor aumenta, lo que genera un exceso de consumo de energía y calor... En segundo lugar, las ventajas de las velocidades de reloj más altas se ven anuladas en parte por la latencia de la memoria, ya que los tiempos de acceso a la memoria no han podido seguir el ritmo de las frecuencias de reloj crecientes. En tercer lugar, para ciertas aplicaciones, las arquitecturas seriales tradicionales se están volviendo menos eficientes a medida que los procesadores se vuelven más rápidos (debido al llamado cuello de botella de von Neumann ), socavando aún más cualquier ganancia que los aumentos de frecuencia podrían comprar de otra manera. Además, en parte debido a las limitaciones en los medios de producir inductancia dentro de los dispositivos de estado sólido, los retrasos de resistencia-capacitancia (RC) en la transmisión de señales están creciendo a medida que se reducen los tamaños de las características, lo que impone un cuello de botella adicional que los aumentos de frecuencia no abordan.

Los retrasos de RC en la transmisión de señales también se observaron en "Clock Rate versus IPC: The End of the Road for Conventional Microarchitectures" [38] que proyectó una mejora máxima del rendimiento promedio anual de la CPU del 12,5 % entre 2000 y 2014.

Un concepto diferente es la brecha de rendimiento entre el procesador y la memoria, que se puede abordar mediante circuitos integrados 3D que reducen la distancia entre los aspectos lógicos y de memoria que están más separados en un chip 2D. [39] El diseño del subsistema de memoria requiere un enfoque en la brecha, que se está ampliando con el tiempo. [40] El método principal para cerrar la brecha es el uso de cachés ; pequeñas cantidades de memoria de alta velocidad que albergan operaciones e instrucciones recientes cerca del procesador, acelerando la ejecución de esas operaciones o instrucciones en los casos en que se las llama con frecuencia. Se han desarrollado múltiples niveles de almacenamiento en caché para lidiar con la brecha cada vez mayor, y el rendimiento de las computadoras modernas de alta velocidad depende de la evolución de las técnicas de almacenamiento en caché. [41] Puede haber hasta un 53% de diferencia entre el crecimiento de la velocidad del procesador y la velocidad de retraso del acceso a la memoria principal. [42]

Los discos duros de estado sólido han seguido aumentando su velocidad, desde ~400 Mbit/s vía SATA3 en 2012 hasta ~7 GB/s vía NVMe / PCIe en 2024, cerrando la brecha entre las velocidades de la RAM y del disco duro, aunque la RAM sigue siendo un orden de magnitud más rápida, con una DDR5 de 8000 MHz de un solo carril capaz de alcanzar 128 GB/s, y la GDDR moderna aún más rápida. Las unidades de estado sólido rápidas, baratas y no volátiles han reemplazado algunas funciones que antes realizaba la RAM, como almacenar ciertos datos para su disponibilidad inmediata en granjas de servidores : se puede conseguir 1 terabyte de almacenamiento SSD por 200 dólares, mientras que 1 TB de RAM costaría miles de dólares. [43] [44]

Cronología

Memoria RAM

| Fecha de introducción | Nombre del chip | Capacidad ( bits ) | Tiempo de acceso | Tipo de SRAM | Fabricante(s) | Proceso | MOSFET | Árbitro |

|---|---|---|---|---|---|---|---|---|

| Marzo de 1963 | — | 1 | ? | Bipolar ( célula ) | Niño justo | — | — | [11] |

| 1965 | ? | 8 | ? | Bipolar | IBM | ? | — | |

| SP95 | 16 | ? | Bipolar | IBM | ? | — | [45] | |

| ? | 64 | ? | MOSFET | Niño justo | ? | PMO | [46] | |

| 1966 | TMC3162 | 16 | ? | Bipolar ( TTL ) | Transitón | ? | — | [10] |

| ? | ? | ? | MOSFET | Comité ejecutivo nacional | ? | ? | [47] | |

| 1968 | ? | 64 | ? | MOSFET | Niño justo | ? | PMO | [47] |

| 144 | ? | MOSFET | Comité ejecutivo nacional | ? | NMO | |||

| 512 | ? | MOSFET | IBM | ? | NMO | [46] | ||

| 1969 | ? | 128 | ? | Bipolar | IBM | ? | — | [11] |

| 1101 | 256 | 850 ns | MOSFET | Intel | 12.000 nm | PMO | [48] [49] [50] [51] | |

| 1972 | 2102 | 1 kbit | ? | MOSFET | Intel | ? | NMO | [48] |

| 1974 | 5101 | 1 kbit | 800 ns | MOSFET | Intel | ? | CMOS | [48] [52] |

| 2102A | 1 kbit | 350 ns | MOSFET | Intel | ? | NMOS ( agotamiento ) | [48] [53] | |

| 1975 | 2114 | 4 kbit | 450 ns | MOSFET | Intel | ? | NMO | [48] [52] |

| 1976 | 2115 | 1 kbit | 70 ns | MOSFET | Intel | ? | NMOS ( HMOS ) | [48] [49] |

| 2147 | 4 kbit | 55 ns | MOSFET | Intel | ? | NMOS (HMOS) | [48] [54] | |

| 1977 | ? | 4 kbit | ? | MOSFET | Toshiba | ? | CMOS | [49] |

| 1978 | HM6147 | 4 kbit | 55 ns | MOSFET | Hitachi | 3.000 nm | CMOS ( de dos pozos ) | [54] |

| TMS4016 | 16 kbit | ? | MOSFET | Instrumentos de Texas | ? | NMO | [49] | |

| 1980 | ? | 16 kbit | ? | MOSFET | Hitachi, Toshiba | ? | CMOS | [55] |

| 64 kbit | ? | MOSFET | Matsushita | |||||

| 1981 | ? | 16 kbit | ? | MOSFET | Instrumentos de Texas | 2.500 nm | NMO | [55] |

| Octubre de 1981 | ? | 4 kbit | 18 ns | MOSFET | Matsushita, Toshiba | 2.000 nm | CMOS | [56] |

| 1982 | ? | 64 kbit | ? | MOSFET | Intel | 1.500 nm | NMOS (HMOS) | [55] |

| Febrero de 1983 | ? | 64 kbit | 50 ns | MOSFET | Mitsubishi | ? | CMOS | [57] |

| 1984 | ? | 256 kbit | ? | MOSFET | Toshiba | 1.200 nm | CMOS | [55] [50] |

| 1987 | ? | 1 Mbit | ? | MOSFET | Sony , Hitachi, Mitsubishi , Toshiba | ? | CMOS | [55] |

| Diciembre de 1987 | ? | 256 kbit | 10 ns | BiMOS | Instrumentos de Texas | 800 nm | BiCMOS | [58] |

| 1990 | ? | 4 Mbit | 15–23 ns | MOSFET | NEC, Toshiba, Hitachi, Mitsubishi | ? | CMOS | [55] |

| 1992 | ? | 16 Mbit | 12–15 ns | MOSFET | Fujitsu , NEC | 400 nm | ||

| Diciembre de 1994 | ? | 512 kbit | 2,5 ns | MOSFET | IBM | ? | CMOS ( SOI ) | [59] |

| 1995 | ? | 4 Mbit | 6 ns | Caché ( SyncBurst ) | Hitachi | 100 nm | CMOS | [60] |

| 256 Mbit | ? | MOSFET | Hyundai | ? | CMOS | [61] |

DRACMA

| Fecha de introducción | Nombre del chip | Capacidad ( bits ) | Tipo de DRAM | Fabricante(s) | Proceso | MOSFET | Área | Árbitro |

|---|---|---|---|---|---|---|---|---|

| 1965 | — | 1 bit | DRAM ( celda ) | Toshiba | — | — | — | [20] [21] |

| 1967 | — | 1 bit | DRAM (celda) | IBM | — | MOSCÚ | — | [23] [47] |

| 1968 | ? | 256 bits | Memoria RAM dinámica ( IC ) | Niño justo | ? | PMO | ? | [10] |

| 1969 | — | 1 bit | DRAM (celda) | Intel | — | PMO | — | [47] |

| 1970 | 1102 | 1 kbit | Memoria RAM dinámica (IC) | Intel, Honeywell | ? | PMO | ? | [47] |

| 1103 | 1 kbit | DRACMA | Intel | 8.000 nm | PMO | 10 mm2 | [62] [63] [24] | |

| 1971 | μPD403 | 1 kbit | DRACMA | Comité ejecutivo nacional | ? | NMO | ? | [64] |

| ? | 2 kbit | DRACMA | Instrumento general | ? | PMO | 13 mm2 | [65] | |

| 1972 | 2107 | 4 kbit | DRACMA | Intel | ? | NMO | ? | [48] [66] |

| 1973 | ? | 8 kbit | DRACMA | IBM | ? | PMO | 19 milímetros 2 | [65] |

| 1975 | 2116 | 16 kbit | DRACMA | Intel | ? | NMO | ? | [67] [10] |

| 1977 | ? | 64 kbit | DRACMA | TNT | ? | NMO | 35 mm2 | [65] |

| 1979 | MK4816 | 16 kbit | Memoria de acceso aleatorio (PSRAM) | Mostek | ? | NMO | ? | [68] |

| ? | 64 kbit | DRACMA | Siemens | ? | VMOS | 25 mm2 | [65] | |

| 1980 | ? | 256 kbit | DRACMA | Comité Ejecutivo Nacional, NTT | 1000–1500 nm | NMO | 34–42 mm2 | [65] |

| 1981 | ? | 288 kbit | DRACMA | IBM | ? | MOSCÚ | 25 mm2 | [69] |

| 1983 | ? | 64 kbit | DRACMA | Intel | 1.500 nm | CMOS | 20 mm2 | [65] |

| 256 kbit | DRACMA | TNT | ? | CMOS | 31 mm2 | |||

| 5 de enero de 1984 | ? | 8 Mbit | DRACMA | Hitachi | ? | MOSCÚ | ? | [70] [71] |

| Febrero de 1984 | ? | 1 Mbit | DRACMA | Hitachi, NEC | 1.000 nm | NMO | 74–76 mm2 | [65] [72] |

| TNT | 800 nm | CMOS | 53 milímetros cuadrados | [65] [72] | ||||

| 1984 | TMS4161 | 64 kbit | Memoria RAM DP ( RAM VRAM ) | Instrumentos de Texas | ? | NMO | ? | [73] [74] |

| Enero de 1985 | μPD41264 | 256 kbit | Memoria RAM DP (VRAM) | Comité ejecutivo nacional | ? | NMO | ? | [75] [76] |

| Junio de 1986 | ? | 1 Mbit | Memoria de acceso aleatorio (PSRAM) | Toshiba | ? | CMOS | ? | [77] |

| 1986 | ? | 4 Mbit | DRACMA | Comité ejecutivo nacional | 800 nm | NMO | 99 milímetros cuadrados | [65] |

| Instrumentos de Texas, Toshiba | 1.000 nm | CMOS | 100–137 mm2 | |||||

| 1987 | ? | 16 Mbit | DRACMA | TNT | 700 nm | CMOS | 148 milímetros cuadrados | [65] |

| Octubre de 1988 | ? | 512 kbit | Memorias SDRAM de alta velocidad | IBM | 1.000 nm | CMOS | 78 milímetros cuadrados | [78] |

| 1991 | ? | 64 Mbit | DRACMA | Matsushita , Mitsubishi , Fujitsu , Toshiba | 400 nm | CMOS | ? | [55] |

| 1993 | ? | 256 Mbit | DRACMA | Hitachi, NEC | 250 nm | CMOS | ? | |

| 1995 | ? | 4 Mbit | Memoria RAM DP (VRAM) | Hitachi | ? | CMOS | ? | [60] |

| 9 de enero de 1995 | ? | 1 Gb | DRACMA | Comité ejecutivo nacional | 250 nm | CMOS | ? | [79] [60] |

| Hitachi | 160 nm | CMOS | ? | |||||

| 1996 | ? | 4 Mbit | MARCO | Samsung | ? | NMO | ? | [80] |

| 1997 | ? | 4 Gbps | CLC-Q | Comité ejecutivo nacional | 150 nm | CMOS | ? | [55] |

| 1998 | ? | 4 Gbps | DRACMA | Hyundai | ? | CMOS | ? | [61] |

| Junio de 2001 | TC51W3216XB | 32 Mbit | Memoria de acceso aleatorio (PSRAM) | Toshiba | ? | CMOS | ? | [81] |

| Febrero de 2001 | ? | 4 Gbps | DRACMA | Samsung | 100 nm | CMOS | ? | [55] [82] |

Memoria SDRAM

| Fecha de introducción | Nombre del chip | Capacidad ( bits ) [83] | Tipo de SDRAM | Fabricante(s) | Proceso | MOSFET | Área | Árbitro |

|---|---|---|---|---|---|---|---|---|

| 1992 | KM48SL2000 | 16 Mbit | DEG | Samsung | ? | CMOS | ? | [84] [28] |

| 1996 | MSM5718C50 | 18 Mbit | Memoria RAM RD | Está bien | ? | CMOS | 325 milímetros cuadrados | [85] |

| Memoria RAM N64 | 36 Mbit | Memoria RAM RD | Comité ejecutivo nacional | ? | CMOS | ? | [86] | |

| ? | 1024 Mbit | DEG | Mitsubishi | 150 nm | CMOS | ? | [55] | |

| 1997 | ? | 1024 Mbit | DEG | Hyundai | ? | SOI | ? | [61] |

| 1998 | MD5764802 | 64 Mbit | Memoria RAM RD | Está bien | ? | CMOS | 325 milímetros cuadrados | [85] |

| Marzo de 1998 | RDRAM directa | 72 Mbit | Memoria RAM RD | Rambus | ? | CMOS | ? | [87] |

| Junio de 1998 | ? | 64 Mbit | RDA | Samsung | ? | CMOS | ? | [88] [89] [90] |

| 1998 | ? | 64 Mbit | RDA | Hyundai | ? | CMOS | ? | [61] |

| 128 Mbit | DEG | Samsung | ? | CMOS | ? | [91] [89] | ||

| 1999 | ? | 128 Mbit | RDA | Samsung | ? | CMOS | ? | [89] |

| 1024 Mbit | RDA | Samsung | 140 nm | CMOS | ? | [55] | ||

| 2000 | Memoria eDRAM GS | 32 Mbit | Memoria RAM electrónica | Sony , Toshiba | 180 nm | CMOS | 279 milímetros cuadrados | [92] |

| 2001 | ? | 288 Mbit | Memoria RAM RD | Hynix | ? | CMOS | ? | [93] |

| ? | DDR2 | Samsung | 100 nm | CMOS | ? | [90] [55] | ||

| 2002 | ? | 256 Mbit | DEG | Hynix | ? | CMOS | ? | [93] |

| 2003 | Memorias electrónicas EE+GS | 32 Mbit | Memoria RAM electrónica | Sony, Toshiba | 90 nm | CMOS | 86 milímetros cuadrados | [92] |

| ? | 72 Mbit | DDR3 | Samsung | 90 nm | CMOS | ? | [94] | |

| 512 Mbit | DDR2 | Hynix | ? | CMOS | ? | [93] | ||

| Elpida | 110 nm | CMOS | ? | [95] | ||||

| 1024 Mbit | DDR2 | Hynix | ? | CMOS | ? | [93] | ||

| 2004 | ? | 2048 Mbit | DDR2 | Samsung | 80 nm | CMOS | ? | [96] |

| 2005 | Memorias electrónicas EE+GS | 32 Mbit | Memoria RAM electrónica | Sony, Toshiba | 65 nm | CMOS | 86 milímetros cuadrados | [97] |

| Memorias eDRAM Xenos | 80 Mbit | Memoria RAM electrónica | Comité ejecutivo nacional | 90 nm | CMOS | ? | [98] | |

| ? | 512 Mbit | DDR3 | Samsung | 80 nm | CMOS | ? | [90] [99] | |

| 2006 | ? | 1024 Mbit | DDR2 | Hynix | 60 nm | CMOS | ? | [93] |

| 2008 | ? | ? | LPDDR2 | Hynix | ? | |||

| Abril de 2008 | ? | 8192 Mbit | DDR3 | Samsung | 50 nm | CMOS | ? | [100] |

| 2008 | ? | 16384 Mbit | DDR3 | Samsung | 50 nm | CMOS | ? | |

| 2009 | ? | ? | DDR3 | Hynix | 44 nm | CMOS | ? | [93] |

| 2048 Mbit | DDR3 | Hynix | 40 nm | |||||

| 2011 | ? | 16384 Mbit | DDR3 | Hynix | 40 nm | CMOS | ? | [101] |

| 2048 Mbit | DDR4 | Hynix | 30 nm | CMOS | ? | [101] | ||

| 2013 | ? | ? | LPDDR4 | Samsung | 20 nm | CMOS | ? | [101] |

| 2014 | ? | 8192 Mbit | LPDDR4 | Samsung | 20 nm | CMOS | ? | [102] |

| 2015 | ? | 12 Gbps | LPDDR4 | Samsung | 20 nm | CMOS | ? | [91] |

| 2018 | ? | 8192 Mbit | LPDDR5 | Samsung | 10 nm | Transformador FinFET | ? | [103] |

| 128 Gbps | DDR4 | Samsung | 10 nm | Transformador FinFET | ? | [104] |

SGRAM y HBM

| Fecha de introducción | Nombre del chip | Capacidad ( bits ) [83] | Tipo de SDRAM | Fabricante(s) | Proceso | MOSFET | Área | Árbitro |

|---|---|---|---|---|---|---|---|---|

| Noviembre de 1994 | HM5283206 | 8 Mbit | SGRAM ( SDR ) | Hitachi | 350 nm | CMOS | 58 milímetros cuadrados | [105] [106] |

| Diciembre de 1994 | μPD481850 | 8 Mbit | SGRAM (SDR) | Comité ejecutivo nacional | ? | CMOS | 280 milímetros cuadrados | [107] [108] |

| 1997 | μPD4811650 | 16 Mbit | SGRAM (SDR) | Comité ejecutivo nacional | 350 nm | CMOS | 280 milímetros cuadrados | [109] [110] |

| Septiembre de 1998 | ? | 16 Mbit | SGRAM ( GDDR ) | Samsung | ? | CMOS | ? | [88] |

| 1999 | KM4132G112 | 32 Mbit | SGRAM (SDR) | Samsung | ? | CMOS | 280 milímetros cuadrados | [111] |

| 2002 | ? | 128 Mbit | Memoria SGRAM ( GDDR2 ) | Samsung | ? | CMOS | ? | [112] |

| 2003 | ? | 256 Mbit | Memoria SGRAM (GDDR2) | Samsung | ? | CMOS | ? | [112] |

| Memoria SGRAM ( GDDR3 ) | ||||||||

| Marzo de 2005 | K4D553238F | 256 Mbit | SGRAM (GDDR) | Samsung | ? | CMOS | 77 milímetros cuadrados | [113] |

| Octubre de 2005 | ? | 256 Mbit | Memoria SGRAM ( GDDR4 ) | Samsung | ? | CMOS | ? | [114] |

| 2005 | ? | 512 Mbit | Memorias SGRAM (GDDR4) | Hynix | ? | CMOS | ? | [93] |

| 2007 | ? | 1024 Mbit | Memoria SGRAM ( GDDR5 ) | Hynix | 60 nm | |||

| 2009 | ? | 2048 Mbit | Memoria SGRAM (GDDR5) | Hynix | 40 nm | |||

| 2010 | K4W1G1646G | 1024 Mbit | Memoria SGRAM (GDDR3) | Samsung | ? | CMOS | 100 mm2 | [115] |

| 2012 | ? | 4096 Mbit | Memoria SGRAM (GDDR3) | SK Hynix | ? | CMOS | ? | [101] |

| 2013 | ? | ? | HBM | |||||

| Marzo de 2016 | MT58K256M32JA | 8 Gbps | Memoria SGRAM ( GDDR5X ) | Micrón | 20 nm | CMOS | 140 milímetros cuadrados | [116] |

| Junio de 2016 | ? | 32 Gbps | HBM2 | Samsung | 20 nm | CMOS | ? | [117] [118] |

| 2017 | ? | 64 Gbps | HBM2 | Samsung | 20 nm | CMOS | ? | [117] |

| Enero de 2018 | K4ZAF325BM | 16 Gbps | Memoria SGRAM ( GDDR6 ) | Samsung | 10 nm | Transformador FinFET | 225 milímetros cuadrados | [119] [120] [121] |

Véase también

Referencias

- ^ "RAM". Diccionario Cambridge English . Consultado el 11 de julio de 2019 .

- ^ "RAM". Diccionario Oxford para estudiantes avanzados . Consultado el 11 de julio de 2019 .

- ^ Gallagher, Sean (4 de abril de 2013). «Memoria que nunca olvida: las DIMM no volátiles llegan al mercado». Ars Technica . Archivado desde el original el 8 de julio de 2017.

- ^ "1966: Las memorias RAM de semiconductores satisfacen las necesidades de almacenamiento de alta velocidad". Museo de Historia de la Computación .

- ^ US3387286A, Dennard, Robert H., "Memoria de transistor de efecto de campo", publicado el 4 de junio de 1968

- ^ "Archivos de IBM: preguntas frecuentes sobre productos y servicios". ibm.com . Archivado desde el original el 23 de octubre de 2012.

- ^ Napper, Brian, Computer 50: La Universidad de Manchester celebra el nacimiento de la computadora moderna, archivado desde el original el 4 de mayo de 2012 , consultado el 26 de mayo de 2012

- ^ Williams, FC; Kilburn, T. (septiembre de 1948), "Computadoras digitales electrónicas", Nature , 162 (4117): 487, Bibcode :1948Natur.162..487W, doi : 10.1038/162487a0 , S2CID 4110351.Reimpreso en Los orígenes de las computadoras digitales .

- ^ Williams, FC; Kilburn, T.; Tootill, GC (febrero de 1951), "Computadoras digitales universales de alta velocidad: una máquina experimental a pequeña escala", Proc. IEE , 98 (61): 13–28, doi :10.1049/pi-2.1951.0004, archivado desde el original el 17 de noviembre de 2013.

- ^ abcdefghi «1970: Los semiconductores compiten con los núcleos magnéticos». Museo de Historia de la Computación . Consultado el 19 de junio de 2019 .

- ^ abcd «1966: Las memorias RAM de semiconductores satisfacen las necesidades de almacenamiento de alta velocidad». Museo de Historia de la Computación . Consultado el 19 de junio de 2019 .

- ^ Frosch, CJ; Derick, L (1957). "Protección de superficies y enmascaramiento selectivo durante la difusión en silicio". Revista de la Sociedad Electroquímica . 104 (9): 547. doi :10.1149/1.2428650.

- ^ KAHNG, D. (1961). "Dispositivo de superficie de dióxido de silicio y silicio". Memorándum técnico de Bell Laboratories : 583–596. doi :10.1142/9789814503464_0076. ISBN 978-981-02-0209-5.

- ^ Lojek, Bo (2007). Historia de la ingeniería de semiconductores . Berlín, Heidelberg: Springer-Verlag Berlin Heidelberg. pág. 321. ISBN 978-3-540-34258-8.

- ^ Diseño de estado sólido – Vol. 6. Horizon House. 1965.

- ^ "1968: Se desarrolló la tecnología de compuerta de silicio para circuitos integrados". Museo de Historia de la Computación . Consultado el 10 de agosto de 2019 .

- ^ Patente estadounidense 3562721, Robert H. Norman, "Solid State Switching and Memory Apparatus", publicada el 9 de febrero de 1971

- ^ abc "DRAM". IBM100 . IBM . 9 de agosto de 2017 . Consultado el 20 de septiembre de 2019 .

- ^ Calculadora Toscal BC-1411. Archivado el 29 de julio de 2017 en Wayback Machine , Science Museum, Londres .

- ^ abc «Hoja de especificaciones de Toshiba «TOSCAL» BC-1411». Old Calculator Web Museum . Archivado desde el original el 3 de julio de 2017. Consultado el 8 de mayo de 2018 .

- ^ abc Calculadora de escritorio Toshiba "Toscal" BC-1411 Archivado el 20 de mayo de 2007 en Wayback Machine.

- ^ "1966: Las memorias RAM de semiconductores satisfacen las necesidades de almacenamiento de alta velocidad". Museo de Historia de la Computación .

- ^ ab "Robert Dennard". Enciclopedia Británica . Consultado el 8 de julio de 2019 .

- ^ ab Lojek, Bo (2007). Historia de la ingeniería de semiconductores. Springer Science & Business Media . págs. 362–363. ISBN 9783540342588

El i1103 se fabricó mediante un proceso P-MOS de compuerta de silicio de 6 máscaras con características mínimas de 8 μm. El producto resultante tenía un

tamaño de celda de memoria de 2400 μm

2

, un tamaño de chip de poco menos de 10 mm2

y se vendía por alrededor de 21 dólares.

- ^ Bellis, Mary. «La invención del Intel 1103». Archivado desde el original el 14 de marzo de 2020. Consultado el 11 de julio de 2015 .

- ^ P. Darche (2020). Microprocesador: Prolegómenos - Funciones de cálculo y almacenamiento - Modelos de cálculo y computación. p. 59. ISBN 9781786305633.

- ^ B. Jacob; SW Ng; DT Wang (2008). Sistemas de memoria: caché, DRAM, disco. Morgan Kaufmann. pág. 324. ISBN 9780080553849.

- ^ abc "Diseño electrónico". Diseño electrónico . 41 (15–21). Hayden Publishing Company. 1993.

La primera DRAM sincrónica comercial, la Samsung KM48SL2000 de 16 Mbit, emplea una arquitectura de banco único que permite a los diseñadores de sistemas realizar fácilmente la transición de sistemas asincrónicos a sincrónicos.

- ^ "Hoja de datos del KM48SL2000-7". Samsung . Agosto de 1992 . Consultado el 19 de junio de 2019 .

- ^ "Samsung Electronics desarrolla la primera SDRAM de 128 Mb con opción de fabricación DDR/SDR". Samsung Electronics . Samsung . 10 de febrero de 1999 . Consultado el 23 de junio de 2019 .

- ^ "Samsung Electronics presenta memorias SGRAM DDR de 16 M ultrarrápidas". Samsung Electronics . Samsung . 17 de septiembre de 1998 . Consultado el 23 de junio de 2019 .

- ^ Sze, Simon M. (2002). Dispositivos semiconductores: física y tecnología (PDF) (2.ª ed.). Wiley . p. 214. ISBN 0-471-33372-7.

- ^ Fundamentos de la organización y arquitectura de computadoras. Jones & Bartlett Learning. 2006. ISBN 978-0-7637-3769-6.

- ^ Anderson, Alexander John (25 de octubre de 2020). Fundamentos de la tecnología informática. CRC Press. ISBN 978-1-000-15371-2.

- ^ "Shadow Ram". Archivado desde el original el 29 de octubre de 2006. Consultado el 24 de julio de 2007 .

- ^ El término fue acuñado en "Copia archivada" (PDF) . Archivado (PDF) desde el original el 6 de abril de 2012. Consultado el 14 de diciembre de 2011 .

{{cite web}}: CS1 maint: archived copy as title (link). - ^ "Plataforma 2015: evolución de los procesadores y plataformas Intel para la próxima década" (PDF) . 2 de marzo de 2005. Archivado (PDF) desde el original el 27 de abril de 2011.

- ^ Agarwal, Vikas; Hrishikesh, MS; Keckler, Stephen W.; Burger, Doug (10-14 de junio de 2000). "Clock Rate versus IPC: The End of the Road for Conventional Microarchitectures" (PDF) . Actas del 27.º Simposio Internacional Anual sobre Arquitectura de Computadores . 27.º Simposio Internacional Anual sobre Arquitectura de Computadores. Vancouver, BC . Consultado el 14 de julio de 2018 .

- ^ Rainer Waser (2012). Nanoelectrónica y tecnología de la información. John Wiley & Sons. pág. 790. ISBN 9783527409273Archivado desde el original el 1 de agosto de 2016 . Consultado el 31 de marzo de 2014 .

- ^ Chris Jesshope y Colin Egan (2006). Advances in Computer Systems Architecture: 11th Asia-Pacific Conference, ACSAC 2006, Shanghái, China, 6-8 de septiembre de 2006, Actas. Springer. pág. 109. ISBN. 9783540400561Archivado desde el original el 1 de agosto de 2016 . Consultado el 31 de marzo de 2014 .

- ^ Ahmed Amine Jerraya y Wayne Wolf (2005). Sistemas multiprocesadores en chips. Morgan Kaufmann. pp. 90–91. ISBN 9780123852519Archivado desde el original el 1 de agosto de 2016 . Consultado el 31 de marzo de 2014 .

- ^ Celso C. Ribeiro y Simone L. Martins (2004). Algoritmos experimentales y eficientes: tercer taller internacional, WEA 2004, Angra Dos Reis, Brasil, 25-28 de mayo de 2004, Actas, Volumen 3. Springer. p. 529. ISBN 9783540220671Archivado desde el original el 1 de agosto de 2016 . Consultado el 31 de marzo de 2014 .

- ^ "Los precios de los SSD siguen bajando, ¡actualice ahora su disco duro!". MiniTool . 2018-09-03 . Consultado el 2019-03-28 .

- ^ Coppock, Mark (31 de enero de 2017). "Si va a comprar o actualizar su PC, espere pagar más por la RAM". www.digitaltrends.com . Consultado el 28 de marzo de 2019 .

- ^ IBM primero en memoria IC. IBM Corporation. 1965 . Consultado el 19 de junio de 2019 .

{{cite book}}:|website=ignorado ( ayuda ) - ^ ab Sah, Chih-Tang (octubre de 1988). "Evolución del transistor MOS: desde su concepción hasta el VLSI" (PDF) . Actas del IEEE . 76 (10): 1280–1326 (1303). Bibcode :1988IEEEP..76.1280S. doi :10.1109/5.16328. ISSN 0018-9219.

- ^ abcde «Finales de los años 1960: comienzos de la memoria MOS» (PDF) . Museo de Historia de Semiconductores de Japón . 23 de enero de 2019. Consultado el 27 de junio de 2019 .

- ^ abcdefgh "Una lista cronológica de los productos Intel. Los productos están ordenados por fecha" (PDF) . Museo Intel . Intel Corporation. Julio de 2005. Archivado desde el original (PDF) el 9 de agosto de 2007. Consultado el 31 de julio de 2007 .

- ^ abcd «1970s: SRAM evolution» (PDF) . Museo de Historia de Semiconductores de Japón . Consultado el 27 de junio de 2019 .

- ^ ab Pimbley, J. (2012). Tecnología avanzada de procesos CMOS. Elsevier . p. 7. ISBN 9780323156806.

- ^ "Memoria Intel". Intel Vintage . Archivado desde el original el 2022-03-19 . Consultado el 2019-07-06 .

- ^ Catálogo de datos de componentes (PDF) . Intel . 1978. p. 3 . Consultado el 27 de junio de 2019 .

- ^ "Silicon Gate MOS 2102A". Intel . Consultado el 27 de junio de 2019 .

- ^ ab "1978: SRAM CMOS rápida de doble pozo (Hitachi)" (PDF) . Museo de Historia de Semiconductores de Japón . Consultado el 5 de julio de 2019 .

- ^ abcdefghijkl «Memoria». STOL (Semiconductor Technology Online) . Consultado el 25 de junio de 2019 .

- ^ Isobe, Mitsuo; Uchida, Yukimasa; Maeguchi, Kenji; Mochizuki, T.; Kimura, M.; Hatano, H.; Mizutani, Y.; Tango, H. (octubre de 1981). "Una RAM estática CMOS/SOS 4K de 18 ns". Revista IEEE de circuitos de estado sólido . 16 (5): 460–465. Código bibliográfico : 1981IJSSC..16..460I. doi :10.1109/JSSC.1981.1051623. S2CID 12992820.

- ^ Yoshimoto, M.; Anami, K.; Shinohara, H.; Yoshihara, T.; Takagi, H.; Nagao, S.; Kayano, S.; Nakano, T. (1983). "Una RAM CMOS completa de 64 Kb con estructura de línea de palabra dividida". Conferencia internacional IEEE sobre circuitos de estado sólido de 1983. Compendio de artículos técnicos . Vol. XXVI. págs. 58–59. doi :10.1109/ISSCC.1983.1156503. S2CID 34837669.

- ^ Havemann, Robert H.; Eklund, RE; Tran, Hiep V.; Haken, RA; Scott, DB; Fung, PK; Ham, TE; Favreau, DP; Virkus, RL (diciembre de 1987). "Una tecnología SRAM BiCMOS de 0,8 μm y 256 K". Reunión internacional de dispositivos electrónicos de 1987. págs. 841–843. doi :10.1109/IEDM.1987.191564. S2CID 40375699.

- ^ Shahidi, Ghavam G .; Davari, Bijan ; Dennard, Robert H .; Anderson, California; Chappell, Licenciatura en Letras; et al. (Diciembre de 1994). "Un CMOS de 0,1 μm a temperatura ambiente en SOI". Transacciones IEEE en dispositivos electrónicos . 41 (12): 2405–2412. Código bibliográfico : 1994ITED...41.2405S. doi : 10.1109/16.337456. S2CID 108832941.

- ^ abc «Perfiles de empresas japonesas» (PDF) . Instituto Smithsoniano . 1996. Consultado el 27 de junio de 2019 .

- ^ abcd «Historia: década de 1990». SK Hynix . Archivado desde el original el 5 de febrero de 2021. Consultado el 6 de julio de 2019 . Error en la cita: La referencia nombrada "hynix90s" fue definida varias veces con contenido diferente (ver la página de ayuda ).

- ^ "Intel: 35 años de innovación (1968–2003)" (PDF) . Intel. 2003 . Consultado el 26 de junio de 2019 .

- ^ La memoria DRAM de Robert Dennard history-computer.com

- ^ "Los fabricantes japoneses entran en el mercado de DRAM y se mejoran las densidades de integración" (PDF) . Museo de Historia de Semiconductores de Japón . Consultado el 27 de junio de 2019 .

- ^ abcdefghij Gealow, Jeffrey Carl (10 de agosto de 1990). "Impacto de la tecnología de procesamiento en el diseño de amplificadores de detección de DRAM" (PDF) . Instituto Tecnológico de Massachusetts . págs. 149–166 . Consultado el 25 de junio de 2019 – vía CORE .

- ^ "Silicon Gate MOS 2107A". Intel . Consultado el 27 de junio de 2019 .

- ^ "Una de las memorias RAM dinámicas de 16K más exitosas: la 4116". Museo Nacional de Historia Estadounidense . Instituto Smithsoniano . Archivado desde el original el 2023-05-31 . Consultado el 20 de junio de 2019 .

- ^ Libro de datos de memoria y guía para diseñadores (PDF) . Mostek . Marzo de 1979. págs. 9 y 183.

- ^ "La vanguardia de la tecnología de circuitos integrados: la primera RAM dinámica de 294 912 bits (288 K)". Museo Nacional de Historia Estadounidense . Instituto Smithsoniano . Consultado el 20 de junio de 2019 .

- ^ "Historia de la informática para 1984". Computer Hope . Consultado el 25 de junio de 2019 .

- ^ "Resúmenes técnicos japoneses". Resúmenes técnicos japoneses . 2 (3–4). Microfilmes universitarios: 161. 1987.

El anuncio de la memoria DRAM de 1 M en 1984 dio inicio a la era de los megabytes.

- ^ ab Robinson, Arthur L. (11 de mayo de 1984). "Los chips de memoria experimentales alcanzan 1 megabit: a medida que se hacen más grandes, las memorias se convierten en una parte cada vez más importante del negocio de los circuitos integrados, tanto tecnológica como económicamente". Science . 224 (4649): 590–592. doi :10.1126/science.224.4649.590. ISSN 0036-8075. PMID 17838349.

- ^ MOS Memory Data Book (PDF) . Texas Instruments . 1984. págs. 4–15 . Consultado el 21 de junio de 2019 .

- ^ "Chips gráficos famosos: TI TMS34010 y VRAM". IEEE Computer Society . 10 de enero de 2019. Consultado el 29 de junio de 2019 .

- ^ "μPD41264 256K Dual Port Graphics Buffer" (PDF) . NEC Electronics . Consultado el 21 de junio de 2019 .

- ^ "Circuito amplificador de detección para conmutar entradas múltiples a baja potencia". Google Patents . Consultado el 21 de junio de 2019 .

- ^ "Las técnicas CMOS de alta calidad crean 1M VSRAM". Resúmenes técnicos japoneses . 2 (3–4). Microfilmes universitarios: 161. 1987.

- ^ Hanafi, Hussein I.; Lu, Nicky CC; Chao, HH; Hwang, Wei; Henkels, WH; Rajeevakumar, TV; Terman, LM; Franch, Robert L. (octubre de 1988). "Una DRAM de alta velocidad de 20 ns y 128 kbit*4 con una velocidad de datos de 330 Mbit/s". IEEE Journal of Solid-State Circuits . 23 (5): 1140–1149. Código Bibliográfico :1988IJSSC..23.1140L. doi :10.1109/4.5936.

- ^ Rompiendo la barrera del gigabit, las DRAM en ISSCC presagian un gran impacto en el diseño de sistemas. (memoria de acceso aleatorio dinámico; Conferencia Internacional de Circuitos de Estado Sólido; investigación y desarrollo de Hitachi Ltd. y NEC Corp.), 9 de enero de 1995

- ^ Scott, JF (2003). "Nano-Ferroelectrics". En Tsakalakos, Thomas; Ovid'ko, Ilya A.; Vasudevan, Asuri K. (eds.). Nanoestructuras: síntesis, propiedades funcionales y aplicaciones . Springer Science & Business Media . págs. 584–600 (597). ISBN . 9789400710191.

- ^ "La nueva pseudo-SRAM de 32 Mb de Toshiba no es una falsificación". The Engineer . 24 de junio de 2001. Archivado desde el original el 29 de junio de 2019 . Consultado el 29 de junio de 2019 .

- ^ "Un estudio de la industria DRAM" (PDF) . MIT . 8 de junio de 2010 . Consultado el 29 de junio de 2019 .

- ^ ab Aquí, K , M , G o T se refieren a los prefijos binarios basados en potencias de 1024.

- ^ "Hoja de datos del KM48SL2000-7". Samsung . Agosto de 1992 . Consultado el 19 de junio de 2019 .

- ^ ab "MSM5718C50/MD5764802" (PDF) . Oki Semiconductor . Febrero de 1999. Archivado (PDF) desde el original el 21 de junio de 2019 . Consultado el 21 de junio de 2019 .

- ^ "Especificaciones técnicas de Ultra 64". Next Generation . N.º 14. Imagine Media . Febrero de 1996. pág. 40.

- ^ "Direct RDRAM" (PDF) . Rambus . 12 de marzo de 1998. Archivado (PDF) desde el original el 21 de junio de 2019 . Consultado el 21 de junio de 2019 .

- ^ ab "Samsung Electronics presenta memorias SGRAM DDR de 16 M ultrarrápidas". Samsung Electronics . Samsung . 17 de septiembre de 1998 . Consultado el 23 de junio de 2019 .

- ^ abc "Samsung Electronics desarrolla la primera SDRAM de 128 Mb con opción de fabricación DDR/SDR". Samsung Electronics . Samsung . 10 de febrero de 1999 . Consultado el 23 de junio de 2019 .

- ^ abc "Samsung demuestra el primer prototipo de memoria DDR 3 del mundo". Phys.org . 17 de febrero de 2005 . Consultado el 23 de junio de 2019 .

- ^ ab "Historia". Samsung Electronics . Samsung . Consultado el 19 de junio de 2019 .

- ^ ab "EL MOTOR EMOCIONAL Y EL SINTETIZADOR GRÁFICO UTILIZADOS EN EL NÚCLEO DE PLAYSTATION SE CONVIERTEN EN UN SOLO CHIP" (PDF) . Sony . 21 de abril de 2003. Archivado (PDF) desde el original el 27 de febrero de 2017 . Consultado el 26 de junio de 2019 .

- ^ abcdefg "Historia: década de 2000". az5miao . Consultado el 4 de abril de 2022 .

- ^ "Samsung desarrolla la memoria SRAM DDR3 más rápida de la industria para aplicaciones de red y de procesamiento electrónico de datos de alto rendimiento". Samsung Semiconductor . Samsung . 29 de enero de 2003 . Consultado el 25 de junio de 2019 .

- ^ "Elpida suministra módulos DDR2 de 2 GB". The Inquirer . 4 de noviembre de 2003. Archivado desde el original el 10 de julio de 2019 . Consultado el 25 de junio de 2019 .

{{cite news}}: CS1 maint: unfit URL (link) - ^ "Samsung muestra la primera SDRAM DDR2 de 2 gigabits de la industria". Samsung Semiconductor . Samsung . 20 de septiembre de 2004 . Consultado el 25 de junio de 2019 .

- ^ "ソニー、65nm対応の半導体設備を導入。3年間で2000億円の投資". pc.watch.impress.co.jp . Archivado desde el original el 13 de agosto de 2016.

- ^ Ingenieros de ATI a través de Dave Baumann de Beyond 3D

- ^ "Nuestra orgullosa herencia de 2000 a 2009". Samsung Semiconductor . Samsung . Consultado el 25 de junio de 2019 .

- ^ "Los chips DDR3 de 2 GB y 50 nm de Samsung son los más pequeños de la industria". SlashGear . 29 de septiembre de 2008 . Consultado el 25 de junio de 2019 .

- ^ abcd «Historia: década de 2010». az5miao . Consultado el 4 de abril de 2022 .

- ^ "Nuestra orgullosa herencia desde 2010 hasta ahora". Samsung Semiconductor . Samsung . Consultado el 25 de junio de 2019 .

- ^ "Samsung Electronics anuncia la primera memoria DRAM LPDDR5 de 8 Gb de la industria para aplicaciones móviles basadas en IA y 5G". Samsung . 17 de julio de 2018 . Consultado el 8 de julio de 2019 .

- ^ "Samsung presenta una amplia memoria RAM DDR4 de 256 GB". Tom's Hardware . 6 de septiembre de 2018. Archivado desde el original el 21 de junio de 2019 . Consultado el 4 de abril de 2022 .

- ^ Hoja de datos HM5283206. Hitachi . 11 de noviembre de 1994. Consultado el 10 de julio de 2019 .

- ^ "Hitachi HM5283206FP10 8Mbit SGRAM" (PDF) . Instituto Smithsoniano . Archivado (PDF) desde el original el 16 de julio de 2003 . Consultado el 10 de julio de 2019 .

- ^ μPD481850 Hoja de datos. NEC . 6 de diciembre de 1994 . Consultado el 10 de julio de 2019 .

- ^ Memoria específica de aplicación de NEC. NEC . Otoño de 1995. pág. 359. Consultado el 21 de junio de 2019 .

- ^ UPD4811650 Hoja de datos. NEC . Diciembre de 1997. Consultado el 10 de julio de 2019 .

- ^ Takeuchi, Kei (1998). "RAM GRÁFICA SINCRÓNICA DE 16 MBIT: μPD4811650". NEC Device Technology International (48) . Consultado el 10 de julio de 2019 .

- ^ "Samsung anuncia el primer SGRAM de 222 MHz y 32 Mbit del mundo para aplicaciones de redes y gráficos 3D". Samsung Semiconductor . Samsung . 12 de julio de 1999 . Consultado el 10 de julio de 2019 .

- ^ ab "Samsung Electronics anuncia JEDEC-Compliant 256Mb GDDR2 para gráficos 3D". Samsung Electronics . Samsung . 28 de agosto de 2003 . Consultado el 26 de junio de 2019 .

- ^ "Hoja de datos del modelo K4D553238F". Samsung Electronics . Marzo de 2005 . Consultado el 10 de julio de 2019 .

- ^ "Samsung Electronics desarrolla la primera memoria DRAM para gráficos GDDR4 ultrarrápida de la industria". Samsung Semiconductor . Samsung . 26 de octubre de 2005 . Consultado el 8 de julio de 2019 .

- ^ "Hoja de datos del K4W1G1646G-BC08" (PDF) . Samsung Electronics . Noviembre de 2010. Archivado (PDF) desde el original el 24 de enero de 2022 . Consultado el 10 de julio de 2019 .

- ^ Shilov, Anton (29 de marzo de 2016). "Micron comienza a muestrear memoria GDDR5X y revela especificaciones de chips". AnandTech . Consultado el 16 de julio de 2019 .

- ^ ab Shilov, Anton (19 de julio de 2017). «Samsung aumenta los volúmenes de producción de chips HBM2 de 8 GB debido a la creciente demanda». AnandTech . Consultado el 29 de junio de 2019 .

- ^ "HBM". Samsung Semiconductor . Samsung . Consultado el 16 de julio de 2019 .

- ^ "Samsung Electronics comienza a producir la primera GDDR6 de 16 gigabits de la industria para sistemas gráficos avanzados". Samsung . 18 de enero de 2018 . Consultado el 15 de julio de 2019 .

- ^ Killian, Zak (18 de enero de 2018). "Samsung pone en marcha sus fundiciones para la producción en masa de memoria GDDR6". Tech Report . Consultado el 18 de enero de 2018 .

- ^ "Samsung comienza a producir la memoria GDDR6 más rápida del mundo". Wccftech . 18 de enero de 2018 . Consultado el 16 de julio de 2019 .