Correlación

En estadística , la correlación o dependencia es cualquier relación estadística, ya sea causal o no, entre dos variables aleatorias o datos bivariados . Aunque en el sentido más amplio, "correlación" puede indicar cualquier tipo de asociación, en estadística suele referirse al grado en que un par de variables están relacionadas linealmente . Ejemplos conocidos de fenómenos dependientes incluyen la correlación entre la altura de los padres y su descendencia, y la correlación entre el precio de un bien y la cantidad que los consumidores están dispuestos a comprar, como se representa en la llamada curva de demanda .

Las correlaciones son útiles porque pueden indicar una relación predictiva que puede aprovecharse en la práctica. Por ejemplo, una empresa de servicios eléctricos puede producir menos energía en un día templado basándose en la correlación entre la demanda de electricidad y el clima. En este ejemplo, existe una relación causal , porque el clima extremo hace que las personas utilicen más electricidad para calefacción o refrigeración. Sin embargo, en general, la presencia de una correlación no es suficiente para inferir la presencia de una relación causal (es decir, la correlación no implica causalidad ).

Formalmente, las variables aleatorias son dependientes si no satisfacen una propiedad matemática de independencia probabilística . En el lenguaje informal, correlación es sinónimo de dependencia . Sin embargo, cuando se utiliza en un sentido técnico, la correlación se refiere a cualquiera de varios tipos específicos de relación matemática entre la expectativa condicional de una variable dado que la otra no es constante a medida que cambia la variable condicionante ; en términos generales, la correlación en este sentido específico se utiliza cuando está relacionada de alguna manera (como linealmente, monótonamente o quizás de acuerdo con alguna forma funcional particular como logarítmica). Esencialmente, la correlación es la medida de cómo dos o más variables se relacionan entre sí. Hay varios coeficientes de correlación , a menudo denotados o , que miden el grado de correlación. El más común de ellos es el coeficiente de correlación de Pearson , que es sensible solo a una relación lineal entre dos variables (que puede estar presente incluso cuando una variable es una función no lineal de la otra). Se han desarrollado otros coeficientes de correlación, como la correlación de rango de Spearman , para que sean más robustos que el de Pearson, es decir, más sensibles a las relaciones no lineales. [1] [2] [3] La información mutua también se puede aplicar para medir la dependencia entre dos variables.

Coeficiente de producto-momento de Pearson

La medida más conocida de dependencia entre dos cantidades es el coeficiente de correlación producto-momento de Pearson (PPMCC), o "coeficiente de correlación de Pearson", comúnmente llamado simplemente "coeficiente de correlación". Se obtiene tomando la razón de la covarianza de las dos variables en cuestión de nuestro conjunto de datos numéricos, normalizada a la raíz cuadrada de sus varianzas. Matemáticamente, uno simplemente divide la covarianza de las dos variables por el producto de sus desviaciones estándar . Karl Pearson desarrolló el coeficiente a partir de una idea similar pero ligeramente diferente de Francis Galton . [4]

Un coeficiente de correlación de producto-momento de Pearson intenta establecer una línea de mejor ajuste a través de un conjunto de datos de dos variables, básicamente exponiendo los valores esperados y el coeficiente de correlación de Pearson resultante indica qué tan lejos está el conjunto de datos real de los valores esperados. Dependiendo del signo de nuestro coeficiente de correlación de Pearson, podemos terminar con una correlación negativa o positiva si existe algún tipo de relación entre las variables de nuestro conjunto de datos. [ cita requerida ]

El coeficiente de correlación poblacional entre dos variables aleatorias con valores esperados y desviaciones estándar se define como:

donde es el operador de valor esperado , significa covarianza y es una notación alternativa ampliamente utilizada para el coeficiente de correlación. La correlación de Pearson se define solo si ambas desviaciones estándar son finitas y positivas. Una fórmula alternativa puramente en términos de momentos es:

Correlación e independencia

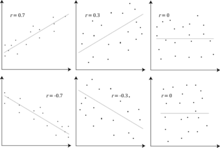

Un corolario de la desigualdad de Cauchy-Schwarz es que el valor absoluto del coeficiente de correlación de Pearson no es mayor que 1. Por lo tanto, el valor de un coeficiente de correlación varía entre −1 y +1. El coeficiente de correlación es +1 en el caso de una relación lineal directa (creciente) perfecta (correlación), −1 en el caso de una relación lineal inversa (decreciente) perfecta ( antimedia correlación ), [5] y algún valor en el intervalo abierto en todos los demás casos, lo que indica el grado de dependencia lineal entre las variables. A medida que se acerca a cero, hay menos relación (más cerca de no correlacionarse). Cuanto más cerca esté el coeficiente de −1 o 1, más fuerte será la correlación entre las variables.

Si las variables son independientes , el coeficiente de correlación de Pearson es 0. Sin embargo, dado que el coeficiente de correlación detecta únicamente dependencias lineales entre dos variables, lo inverso no es necesariamente cierto. Un coeficiente de correlación de 0 no implica que las variables sean independientes [ cita requerida ] .

Por ejemplo, supongamos que la variable aleatoria está distribuida simétricamente alrededor de cero y . Entonces está completamente determinada por , de modo que y son perfectamente dependientes, pero su correlación es cero; no están correlacionadas . Sin embargo, en el caso especial en el que y son conjuntamente normales , la no correlación es equivalente a la independencia.

Aunque los datos no correlacionados no implican necesariamente independencia, se puede comprobar si las variables aleatorias son independientes si su información mutua es cero.

Coeficiente de correlación de muestra

Dada una serie de mediciones del par indexado por , el coeficiente de correlación muestral se puede utilizar para estimar la correlación de Pearson poblacional entre y . El coeficiente de correlación muestral se define como

donde y son las medias muestrales de y , y y son las desviaciones estándar muestrales corregidas de y .

Expresiones equivalentes para son

donde y son las desviaciones estándar de muestra no corregidas de y .

Si y son resultados de mediciones que contienen error de medición, los límites realistas del coeficiente de correlación no son −1 a +1 sino un rango más pequeño. [6] Para el caso de un modelo lineal con una sola variable independiente, el coeficiente de determinación (R al cuadrado) es el cuadrado de , el coeficiente producto-momento de Pearson.

Ejemplo

Considere la distribución de probabilidad conjunta de X e Y que aparece en la siguiente tabla.

- yincógnita

-1 0 1 0 0 1/3 0 1 1/3 0 1/3

Para esta distribución conjunta, las distribuciones marginales son:

Esto produce las siguientes expectativas y variaciones:

Por lo tanto:

Coeficientes de correlación de rango

Los coeficientes de correlación de rango , como el coeficiente de correlación de rango de Spearman y el coeficiente de correlación de rango de Kendall (τ), miden hasta qué punto, a medida que una variable aumenta, la otra tiende a aumentar, sin necesidad de que ese aumento esté representado por una relación lineal. Si, a medida que una variable aumenta, la otra disminuye , los coeficientes de correlación de rango serán negativos. Es común considerar estos coeficientes de correlación de rango como alternativas al coeficiente de Pearson, utilizados ya sea para reducir la cantidad de cálculo o para hacer que el coeficiente sea menos sensible a la no normalidad en las distribuciones. Sin embargo, esta visión tiene poca base matemática, ya que los coeficientes de correlación de rango miden un tipo diferente de relación que el coeficiente de correlación producto-momento de Pearson , y es mejor considerarlos como medidas de un tipo diferente de asociación, en lugar de como una medida alternativa del coeficiente de correlación de población. [7] [8]

Para ilustrar la naturaleza de la correlación de rango y su diferencia con la correlación lineal, considere los siguientes cuatro pares de números :

- (0, 1), (10, 100), (101, 500), (102, 2000).

A medida que pasamos de un par al siguiente par aumenta, y también lo hace . Esta relación es perfecta, en el sentido de que un aumento en siempre va acompañado de un aumento en . Esto significa que tenemos una correlación de rango perfecta, y los coeficientes de correlación de Spearman y Kendall son 1, mientras que en este ejemplo el coeficiente de correlación producto-momento de Pearson es 0,7544, lo que indica que los puntos están lejos de estar en una línea recta. De la misma manera, si siempre disminuye cuando aumenta , los coeficientes de correlación de rango serán −1, mientras que el coeficiente de correlación producto-momento de Pearson puede o no estar cerca de −1, dependiendo de qué tan cerca estén los puntos de una línea recta. Aunque en los casos extremos de correlación de rango perfecta los dos coeficientes son iguales (siendo ambos +1 o ambos −1), este no es generalmente el caso, y por lo tanto los valores de los dos coeficientes no se pueden comparar de manera significativa. [7] Por ejemplo, para los tres pares (1, 1) (2, 3) (3, 2) el coeficiente de Spearman es 1/2, mientras que el coeficiente de Kendall es 1/3.

Otras medidas de dependencia entre variables aleatorias

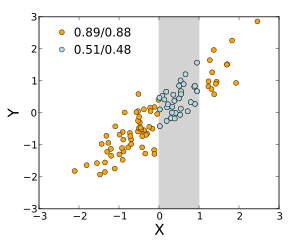

La información proporcionada por un coeficiente de correlación no es suficiente para definir la estructura de dependencia entre variables aleatorias. [9] El coeficiente de correlación define completamente la estructura de dependencia solo en casos muy particulares, por ejemplo cuando la distribución es una distribución normal multivariada . (Véase el diagrama anterior.) En el caso de distribuciones elípticas caracteriza las (hiper)elipses de igual densidad; sin embargo, no caracteriza completamente la estructura de dependencia (por ejemplo, los grados de libertad de una distribución t multivariada determinan el nivel de dependencia de la cola).

Para las variables continuas, se introdujeron múltiples medidas alternativas de dependencia para abordar la deficiencia de la correlación de Pearson de que puede ser cero para las variables aleatorias dependientes (ver [10] y las referencias allí citadas para una descripción general). Todas comparten la propiedad importante de que un valor de cero implica independencia. Esto llevó a algunos autores [10] [11] a recomendar su uso rutinario, particularmente de la correlación de distancia . [12] [13] Otra medida alternativa es el coeficiente de dependencia aleatorio. [14] El RDC es una medida computacionalmente eficiente, basada en cópula, de dependencia entre variables aleatorias multivariadas y es invariante con respecto a escalas no lineales de variables aleatorias.

Una desventaja importante de las medidas alternativas, más generales, es que, cuando se utilizan para comprobar si dos variables están asociadas, tienden a tener una potencia menor en comparación con la correlación de Pearson cuando los datos siguen una distribución normal multivariante. [10] Esta es una implicación del teorema de que no hay almuerzo gratis . Para detectar todo tipo de relaciones, estas medidas tienen que sacrificar potencia en otras relaciones, en particular para el importante caso especial de una relación lineal con marginales gaussianas, para el que la correlación de Pearson es óptima. Otro problema se refiere a la interpretación. Mientras que la correlación de Person se puede interpretar para todos los valores, las medidas alternativas generalmente solo se pueden interpretar de manera significativa en los extremos. [15]

Para dos variables binarias , la razón de probabilidades mide su dependencia y toma números no negativos en el rango, posiblemente infinito: . Las estadísticas relacionadas, como la Y de Yule y la Q de Yule, normalizan esto al rango de correlación . El modelo logístico generaliza la razón de probabilidades para modelar casos donde las variables dependientes son discretas y puede haber una o más variables independientes.

La relación de correlación , la información mutua basada en la entropía , la correlación total , la correlación total dual y la correlación policórica también son capaces de detectar dependencias más generales, como lo es la consideración de la cópula entre ellas, mientras que el coeficiente de determinación generaliza el coeficiente de correlación a la regresión múltiple .

Sensibilidad a la distribución de datos

El grado de dependencia entre las variables X e Y no depende de la escala en la que se expresan las variables. Es decir, si estamos analizando la relación entre X e Y , la mayoría de las medidas de correlación no se ven afectadas por la transformación de X en a + bX e Y en c + dY , donde a , b , c y d son constantes ( b y d son positivas). Esto es cierto para algunas estadísticas de correlación , así como para sus análogos poblacionales . Algunas estadísticas de correlación, como el coeficiente de correlación de rango, también son invariantes a las transformaciones monótonas de las distribuciones marginales de X y/o Y .

La mayoría de las medidas de correlación son sensibles a la forma en que se toman muestras de X e Y. Las dependencias tienden a ser más fuertes si se consideran en un rango más amplio de valores. Por lo tanto, si consideramos el coeficiente de correlación entre las alturas de los padres y sus hijos en todos los varones adultos y lo comparamos con el mismo coeficiente de correlación calculado cuando se selecciona a los padres con una altura de entre 165 cm y 170 cm, la correlación será más débil en el último caso. Se han desarrollado varias técnicas que intentan corregir la restricción del rango en una o ambas variables, y se utilizan comúnmente en el metanálisis; las más comunes son las ecuaciones de caso II y caso III de Thorndike. [16]

Varias medidas de correlación en uso pueden no estar definidas para ciertas distribuciones conjuntas de X e Y. Por ejemplo, el coeficiente de correlación de Pearson se define en términos de momentos y, por lo tanto, no estará definido si los momentos no están definidos. Las medidas de dependencia basadas en cuantiles siempre están definidas. Las estadísticas basadas en muestras destinadas a estimar medidas de dependencia de la población pueden tener o no propiedades estadísticas deseables, como ser imparciales o asintóticamente consistentes , según la estructura espacial de la población de la que se tomaron los datos.

La sensibilidad a la distribución de datos se puede utilizar de forma ventajosa. Por ejemplo, la correlación escalada está diseñada para utilizar la sensibilidad al rango con el fin de seleccionar correlaciones entre componentes rápidos de series temporales . [17] Al reducir el rango de valores de manera controlada, se filtran las correlaciones en escalas de tiempo largas y solo se revelan las correlaciones en escalas de tiempo cortas.

Matrices de correlación

La matriz de correlación de variables aleatorias es la matriz cuya entrada es

Por lo tanto, las entradas diagonales son todas idénticamente una . Si las medidas de correlación utilizadas son coeficientes de momento producto, la matriz de correlación es la misma que la matriz de covarianza de las variables aleatorias estandarizadas para . Esto se aplica tanto a la matriz de correlaciones poblacionales (en cuyo caso es la desviación estándar poblacional) como a la matriz de correlaciones muestrales (en cuyo caso denota la desviación estándar muestral). En consecuencia, cada una es necesariamente una matriz semidefinida positiva . Además, la matriz de correlación es estrictamente definida positiva si ninguna variable puede tener todos sus valores generados exactamente como una función lineal de los valores de las otras.

La matriz de correlación es simétrica porque la correlación entre y es la misma que la correlación entre y .

Una matriz de correlación aparece, por ejemplo, en una fórmula para el coeficiente de determinación múltiple , una medida de bondad de ajuste en regresión múltiple .

En el modelado estadístico , las matrices de correlación que representan las relaciones entre variables se clasifican en diferentes estructuras de correlación, que se distinguen por factores como el número de parámetros necesarios para estimarlas. Por ejemplo, en una matriz de correlación intercambiable , todos los pares de variables se modelan como si tuvieran la misma correlación, por lo que todos los elementos no diagonales de la matriz son iguales entre sí. Por otro lado, una matriz autorregresiva se utiliza a menudo cuando las variables representan una serie temporal, ya que es probable que las correlaciones sean mayores cuando las mediciones están más cerca en el tiempo. Otros ejemplos incluyen independiente, no estructurada, M-dependiente y Toeplitz .

En el análisis exploratorio de datos , la iconografía de correlaciones consiste en sustituir una matriz de correlaciones por un diagrama donde las correlaciones "notables" están representadas por una línea continua (correlación positiva), o una línea de puntos (correlación negativa).

Matriz de correlación válida más cercana

En algunas aplicaciones (por ejemplo, crear modelos de datos a partir de datos observados solo parcialmente) se desea encontrar la matriz de correlación "más cercana" a una matriz de correlación "aproximada" (por ejemplo, una matriz que normalmente carece de positividad semidefinida debido a la forma en que se ha calculado).

En 2002, Higham [18] formalizó la noción de proximidad utilizando la norma de Frobenius y proporcionó un método para calcular la matriz de correlación más cercana utilizando el algoritmo de proyección de Dykstra , del cual está disponible una implementación como una API web en línea. [19]

Esto despertó el interés en el tema, con nuevos resultados teóricos (por ejemplo, el cálculo de la matriz de correlación más cercana con la estructura factorial [20] ) y numéricos (por ejemplo, el uso del método de Newton para calcular la matriz de correlación más cercana [21] ) obtenidos en los años posteriores.

Falta de correlación e independencia de los procesos estocásticos

De manera similar, para dos procesos estocásticos y : si son independientes, entonces no están correlacionados. [22] : p. 151 Lo opuesto de esta afirmación podría no ser cierto. Incluso si dos variables no están correlacionadas, podrían no ser independientes entre sí.

Conceptos erróneos comunes

Correlación y causalidad

El dicho convencional de que " la correlación no implica causalidad " significa que la correlación no puede utilizarse por sí sola para inferir una relación causal entre las variables. [23] Este dicho no debe interpretarse como que las correlaciones no pueden indicar la existencia potencial de relaciones causales. Sin embargo, las causas subyacentes a la correlación, si las hay, pueden ser indirectas y desconocidas, y las correlaciones altas también se superponen con relaciones de identidad ( tautologías ), donde no existe un proceso causal. En consecuencia, una correlación entre dos variables no es una condición suficiente para establecer una relación causal (en cualquier dirección).

La correlación entre la edad y la altura en los niños es bastante transparente en términos de causalidad, pero la correlación entre el estado de ánimo y la salud en las personas no lo es tanto. ¿Un mejor estado de ánimo conduce a una mejor salud, o una buena salud conduce a un buen estado de ánimo, o a ambas cosas? ¿O hay algún otro factor subyacente a ambas? En otras palabras, una correlación puede tomarse como evidencia de una posible relación causal, pero no puede indicar cuál podría ser la relación causal, si la hubiera.

Correlaciones lineales simples

El coeficiente de correlación de Pearson indica la fuerza de una relación lineal entre dos variables, pero su valor generalmente no caracteriza completamente su relación. [24] En particular, si la media condicional de dado , denotado , no es lineal en , el coeficiente de correlación no determinará completamente la forma de .

La imagen adyacente muestra diagramas de dispersión del cuarteto de Anscombe , un conjunto de cuatro pares diferentes de variables creado por Francis Anscombe . [25] Las cuatro variables tienen la misma media (7,5), varianza (4,12), correlación (0,816) y línea de regresión ( ). Sin embargo, como se puede ver en los gráficos, la distribución de las variables es muy diferente. La primera (arriba a la izquierda) parece estar distribuida normalmente, y corresponde a lo que uno esperaría al considerar dos variables correlacionadas y seguir el supuesto de normalidad. La segunda (arriba a la derecha) no está distribuida normalmente; aunque se puede observar una relación obvia entre las dos variables, no es lineal. En este caso, el coeficiente de correlación de Pearson no indica que exista una relación funcional exacta: solo el grado en que esa relación puede aproximarse mediante una relación lineal. En el tercer caso (abajo a la izquierda), la relación lineal es perfecta, excepto por un valor atípico que ejerce suficiente influencia para reducir el coeficiente de correlación de 1 a 0,816. Finalmente, el cuarto ejemplo (abajo a la derecha) muestra otro ejemplo en el que un valor atípico es suficiente para producir un coeficiente de correlación alto, aunque la relación entre las dos variables no sea lineal.

Estos ejemplos indican que el coeficiente de correlación, como estadística de resumen , no puede reemplazar el examen visual de los datos. A veces se dice que los ejemplos demuestran que la correlación de Pearson supone que los datos siguen una distribución normal , pero esto es solo parcialmente correcto. [4] La correlación de Pearson se puede calcular con precisión para cualquier distribución que tenga una matriz de covarianza finita , que incluye la mayoría de las distribuciones encontradas en la práctica. Sin embargo, el coeficiente de correlación de Pearson (tomado junto con la media y la varianza de la muestra) solo es una estadística suficiente si los datos se extraen de una distribución normal multivariada . Como resultado, el coeficiente de correlación de Pearson caracteriza completamente la relación entre las variables si y solo si los datos se extraen de una distribución normal multivariada.

Distribución normal bivariada

Si un par de variables aleatorias sigue una distribución normal bivariada , la media condicional es una función lineal de , y la media condicional es una función lineal de El coeficiente de correlación entre y y las medias y varianzas marginales de y determinan esta relación lineal:

donde y son los valores esperados de y respectivamente, y y son las desviaciones estándar de y respectivamente.

La correlación empírica es una estimación del coeficiente de correlación. Una estimación de distribución para viene dada por

¿Dónde está la función hipergeométrica gaussiana ?

Esta densidad es a la vez una densidad posterior bayesiana y una densidad de distribución de confianza óptima exacta . [26] [27]

Véase también

- Autocorrelación

- Correlación canónica

- Coeficiente de determinación

- Cointegración

- Coeficiente de correlación de concordancia

- Correlación cofenética

- Desatenuación de correlación

- Función de correlación

- Brecha de correlación

- Covarianza

- Covarianza y correlación

- Correlación cruzada

- Correlación ecológica

- Fracción de varianza no explicada

- Correlación genética

- Lambda de Goodman y Kruskal

- Iconografía de correlaciones

- Correlación ilusoria

- Correlación entre clases

- Correlación intraclase

- Ascensor (minería de datos)

- Dependencia media

- Problema de unidad de área modificable

- Correlación múltiple

- Coeficiente de correlación punto-biserial

- Relación de recuento de cuadrantes

- Correlación espuria

- Razón de correlación estadística

- Subindependencia

Referencias

- ^ Croxton, Frederick Emory; Cowden, Dudley Johnstone; Klein, Sidney (1968) Estadística general aplicada , Pitman. ISBN 9780273403159 (página 625)

- ^ Dietrich, Cornelius Frank (1991) Incertidumbre, calibración y probabilidad: las estadísticas de la medición científica e industrial 2.ª edición, A. Higler. ISBN 9780750300605 (página 331)

- ^ Aitken, Alexander Craig (1957) Matemática estadística, octava edición. Oliver & Boyd. ISBN 9780050013007 (página 95)

- ^ ab Rodgers, JL; Nicewander, WA (1988). "Trece maneras de analizar el coeficiente de correlación". The American Statistician . 42 (1): 59–66. doi :10.1080/00031305.1988.10475524. JSTOR 2685263.

- ^ Dowdy, S. y Wearden, S. (1983). "Estadísticas para la investigación", Wiley. ISBN 0-471-08602-9 pp 230

- ^ Francis, DP; Coats AJ; Gibson D (1999). "¿Qué tan alto puede ser un coeficiente de correlación?". Int J Cardiol . 69 (2): 185–199. doi :10.1016/S0167-5273(99)00028-5. PMID 10549842.

- ^ ab Yule, GU y Kendall, MG (1950), "Introducción a la teoría de la estadística", 14.ª edición (quinta edición, 1968). Charles Griffin & Co., págs. 258-270

- ^ Kendall, MG (1955) "Métodos de correlación de rango", Charles Griffin & Co.

- ^ Mahdavi Damghani B. (2013). "El valor no engañoso de la correlación inferida: una introducción al modelo de co-intercalación". Revista Wilmott . 2013 (67): 50–61. doi :10.1002/wilm.10252.

- ^ abc Karch, Julian D.; Perez-Alonso, Andres F.; Bergsma, Wicher P. (4 de agosto de 2024). "Más allá de la correlación de Pearson: pruebas de independencia no paramétricas modernas para la investigación psicológica". Investigación conductual multivariante . doi :10.1080/00273171.2024.2347960.

{{cite journal}}: CS1 maint: date and year (link) - ^ Simon, Noah; Tibshirani, Robert (2014). "Comentario sobre "Detección de nuevas asociaciones en grandes conjuntos de datos" de Reshef et al., Science 16 de diciembre de 2011". pág. 3. arXiv : 1401.7645 [stat.ME].

- ^ Székely, GJ Rizzo; Bakirov, NK (2007). "Medición y prueba de la independencia mediante correlación de distancias". Anales de estadística . 35 (6): 2769–2794. arXiv : 0803.4101 . doi :10.1214/009053607000000505. S2CID 5661488.

- ^ Székely, GJ; Rizzo, ML (2009). "Covarianza de la distancia browniana". Anales de estadística aplicada . 3 (4): 1233–1303. arXiv : 1010.0297 . doi :10.1214/09-AOAS312. PMC 2889501 . PMID 20574547.

- ^ Lopez-Paz D. y Hennig P. y Schölkopf B. (2013). "El coeficiente de dependencia aleatorio", " Conferencia sobre sistemas de procesamiento de información neuronal " Reimpresión

- ^ Reimherr, Matthew; Nicolae, Dan L. (2013). "Sobre la cuantificación de la dependencia: un marco para desarrollar medidas interpretables". Ciencia estadística . 28 (1): 116–130. arXiv : 1302.5233 . doi :10.1214/12-STS405.

- ^ Thorndike, Robert Ladd (1947). Problemas y técnicas de investigación (Informe n.º 3) . Washington DC: Impreso del gobierno de EE. UU.

- ^ Nikolić, D; Muresan, RC; Feng, W; Singer, W (2012). "Análisis de correlación a escala: una mejor manera de calcular un correlograma cruzado". Revista Europea de Neurociencia . 35 (5): 1–21. doi :10.1111/j.1460-9568.2011.07987.x. PMID 22324876. S2CID 4694570.

- ^ Higham, Nicholas J. (2002). "Cálculo de la matriz de correlación más cercana: un problema de finanzas". IMA Journal of Numerical Analysis . 22 (3): 329–343. CiteSeerX 10.1.1.661.2180 . doi :10.1093/imanum/22.3.329.

- ^ "Optimizador de cartera". portfoliooptimizer.io . Consultado el 30 de enero de 2021 .

- ^ Borsdorf, Rudiger; Higham, Nicholas J.; Raydan, Marcos (2010). "Cálculo de una matriz de correlación más cercana con estructura factorial" (PDF) . SIAM J. Matrix Anal. Appl . 31 (5): 2603–2622. doi :10.1137/090776718.

- ^ Qi, HOUDUO; Sun, DEFENG (2006). "Un método de Newton cuadráticamente convergente para calcular la matriz de correlación más cercana". SIAM J. Matrix Anal. Appl . 28 (2): 360–385. doi :10.1137/050624509.

- ^ Park, Kun Il (2018). Fundamentos de probabilidad y procesos estocásticos con aplicaciones a las comunicaciones . Springer. ISBN 978-3-319-68074-3.

- ^ Aldrich, John (1995). "Correlaciones genuinas y espurias en Pearson y Yule". Ciencia estadística . 10 (4): 364–376. doi : 10.1214/ss/1177009870 . JSTOR 2246135.

- ^ Mahdavi Damghani, Babak (2012). "El valor engañoso de la correlación medida". Revista Wilmott . 2012 (1): 64–73. doi :10.1002/wilm.10167. S2CID 154550363.

- ^ Anscombe, Francis J. (1973). "Gráficos en el análisis estadístico". The American Statistician . 27 (1): 17–21. doi :10.2307/2682899. JSTOR 2682899.

- ^ Taraldsen, Gunnar (2021). "La densidad de confianza para la correlación". Sankhya A . 85 : 600–616. doi : 10.1007/s13171-021-00267-y . ISSN 0976-8378. S2CID 244594067.

- ^ Taraldsen, Gunnar (2020). Confianza en la correlación. researchgate.net (preimpresión). doi :10.13140/RG.2.2.23673.49769.

Lectura adicional

- Cohen, J.; Cohen, P.; West, SG y Aiken, LS (2002). Análisis de correlación/regresión múltiple aplicado a las ciencias del comportamiento (3.ª ed.). Psychology Press. ISBN 978-0-8058-2223-6.

- "Correlación (en estadística)", Enciclopedia de Matemáticas , EMS Press , 2001 [1994]

- Oestreicher, J. & DR (26 de febrero de 2015). Plague of Equals: A science thriller of international disease, politics and drug discovery [La plaga de los iguales: un thriller científico sobre enfermedades internacionales, política y descubrimiento de fármacos ]. California: Omega Cat Press. pág. 408. ISBN 978-0963175540.

Enlaces externos

- Página de MathWorld sobre los coeficientes de correlación (cruzada) de una muestra

- Calcular la significancia entre dos correlaciones, para la comparación de dos valores de correlación.

- "Una caja de herramientas de MATLAB para calcular coeficientes de correlación ponderados". Archivado desde el original el 24 de abril de 2021.

- Prueba de que la correlación bivariada de muestra tiene límites más o menos 1

- Simulación Flash interactiva sobre la correlación de dos variables distribuidas normalmente por Juha Puranen.

- Análisis de correlación. Estadísticas biomédicas

- R-Psychologist Visualización de correlación entre dos variables numéricas

![{\displaystyle \rho _{X,Y}=\operatorname {corr} (X,Y)={\operatorname {cov} (X,Y) \over \sigma _{X}\sigma _{Y}}={\operatorname {E} [(X-\mu _{X})(Y-\mu _{Y})] \over \sigma _{X}\sigma _{Y}},\quad {\text{si}}\ \sigma _{X}\sigma _{Y}>0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b551ad29592ae746bf05fe397fbdc56201f483a5)

![{\displaystyle {\begin{aligned}r_{xy}&={\frac {\sum x_{i}y_{i}-n{\bar {x}}{\bar {y}}}{ns'_{x}s'_{y}}}\\[5pt]&={\frac {n\sum x_{i}y_{i}-\sum x_{i}\sum y_{i}}{{\sqrt {n\sum x_{i}^{2}-(\sum x_{i})^{2}}}~{\sqrt {n\sum y_{i}^{2}-(\sum y_{i})^{2}}}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6da33b8144a5e67959969ef2c4830ece1938bbb2)

![{\displaystyle {\begin{alineado}\rho _{X,Y}&={\frac {1}{\sigma _{X}\sigma _{Y}}}\mathrm {E} [(X-\ mu _{X})(Y-\mu _{Y})]\\[5pt]&={\frac {1}{\sigma _{X}\sigma _{Y}}}\sum _{x ,y}{(x-\mu _{X})(y-\mu _{Y})\mathrm {P} (X=x,Y=y)}\\[5pt]&={\frac { 3{\sqrt {3}}}{2}}\left(\left(1-{\frac {2}{3}}\right)(-1-0){\frac {1}{3}} +\izquierda(0-{\frac {2}{3}}\derecha)(0-0){\frac {1}{3}}+\left(1-{\frac {2}{3}}\right)(1-0){\frac {1}{3}}\right)=0.\end{ alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5c3ce03c3f9ad954e17f3a92d5314a9a3f669c29)

![{\displaystyle [0,+\infty ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f32245981f739c86ea8f68ce89b1ad6807428d35)

![{\estilo de visualización [-1,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)