Sociología computacional

| Parte de una serie sobre |

| Sociología |

|---|

|

La sociología computacional es una rama de la sociología que utiliza métodos computacionalmente intensivos para analizar y modelar fenómenos sociales. Mediante simulaciones por computadora , inteligencia artificial , métodos estadísticos complejos y enfoques analíticos como el análisis de redes sociales , la sociología computacional desarrolla y prueba teorías de procesos sociales complejos a través del modelado ascendente de interacciones sociales. [1]

Implica la comprensión de los agentes sociales, la interacción entre estos agentes y el efecto de estas interacciones en el agregado social. [2] Aunque el tema y las metodologías en las ciencias sociales difieren de aquellos en las ciencias naturales o la informática , varios de los enfoques utilizados en la simulación social contemporánea se originaron en campos como la física y la inteligencia artificial . [3] [4] Algunos de los enfoques que se originaron en este campo se han importado a las ciencias naturales, como las medidas de centralidad de la red de los campos del análisis de redes sociales y la ciencia de redes .

En la literatura relevante, la sociología computacional a menudo se relaciona con el estudio de la complejidad social . [5] Los conceptos de complejidad social como sistemas complejos , interconexión no lineal entre procesos macro y micro y emergencia han ingresado al vocabulario de la sociología computacional. [6] Un ejemplo práctico y bien conocido es la construcción de un modelo computacional en forma de una " sociedad artificial ", mediante el cual los investigadores pueden analizar la estructura de un sistema social . [2] [7]

Historia

Fondo

En las últimas cuatro décadas, se ha introducido y ganado popularidad la sociología computacional [ ¿según quién? ] . Esta se ha utilizado principalmente para modelar o construir explicaciones de procesos sociales y depende de la aparición de comportamientos complejos a partir de actividades simples. [8] La idea detrás de la emergencia es que las propiedades de cualquier sistema más grande no siempre tienen que ser propiedades de los componentes que lo componen. [9] Alexander, Morgan y Broad, emergentistas clásicos, introdujeron la idea de emergencia a principios del siglo XX. El objetivo de este método era encontrar un acuerdo lo suficientemente bueno entre dos ontologías diferentes y extremas, que eran el materialismo reduccionista y el dualismo. [8]

Si bien la emergencia ha tenido un papel valioso e importante en la fundación de la sociología computacional, hay quienes no necesariamente están de acuerdo. Un importante líder en el campo, Epstein, dudaba de su uso porque había aspectos que no se podían explicar. Epstein planteó una demanda contra el emergentismo, en la que dice que "es precisamente la suficiencia generativa de las partes lo que constituye la explicación del todo". [8]

Los modelos basados en agentes han tenido una influencia histórica en la Sociología Computacional. Estos modelos surgieron por primera vez en la década de 1960 y se utilizaron para simular procesos de control y retroalimentación en organizaciones, ciudades, etc. Durante la década de 1970, la aplicación introdujo el uso de individuos como unidades principales para los análisis y utilizó estrategias de abajo hacia arriba para modelar comportamientos. La última ola se produjo en la década de 1980. En ese momento, los modelos todavía eran de abajo hacia arriba; la única diferencia es que los agentes interactúan de forma interdependiente. [8]

Teoría de sistemas y funcionalismo estructural

En la era de la posguerra, el analizador diferencial de Vannevar Bush , los autómatas celulares de John von Neumann , la cibernética de Norbert Wiener y la teoría de la información de Claude Shannon se convirtieron en paradigmas influyentes para modelar y comprender la complejidad en los sistemas técnicos. En respuesta, los científicos en disciplinas como la física, la biología, la electrónica y la economía comenzaron a articular una teoría general de sistemas en la que todos los fenómenos naturales y físicos son manifestaciones de elementos interrelacionados en un sistema que tiene patrones y propiedades comunes. Siguiendo el llamado de Émile Durkheim a analizar la sociedad moderna compleja sui generis , [10] los sociólogos funcionalistas estructurales de la posguerra como Talcott Parsons se apoderaron de estas teorías de interacción sistemática y jerárquica entre los componentes constituyentes para intentar generar grandes teorías sociológicas unificadas, como el paradigma AGIL . [11] Sociólogos como George Homans argumentaron que las teorías sociológicas deberían formalizarse en estructuras jerárquicas de proposiciones y terminología precisa de la cual se pudieran derivar y operacionalizar otras proposiciones e hipótesis en estudios empíricos. [12] Debido a que los algoritmos y programas informáticos se habían utilizado ya en 1956 para probar y validar teoremas matemáticos, como el teorema de los cuatro colores , [13] algunos académicos anticiparon que enfoques computacionales similares podrían "resolver" y "probar" problemas y teoremas formalizados de manera análoga de estructuras y dinámicas sociales.

Macrosimulación y microsimulación

A finales de los años 1960 y principios de los años 1970, los científicos sociales utilizaron la tecnología informática cada vez más disponible para realizar macrosimulaciones de procesos de control y retroalimentación en organizaciones, industrias, ciudades y poblaciones globales. Estos modelos utilizaban ecuaciones diferenciales para predecir distribuciones de población como funciones holísticas de otros factores sistemáticos como el control de inventarios, el tráfico urbano, la migración y la transmisión de enfermedades. [14] [15] Aunque las simulaciones de sistemas sociales recibieron una atención sustancial a mediados de los años 1970 después de que el Club de Roma publicara informes que predecían que las políticas que promovían el crecimiento económico exponencial eventualmente traerían una catástrofe ambiental global, [16] las conclusiones incómodas llevaron a muchos autores a tratar de desacreditar los modelos, tratando de hacer que los propios investigadores parecieran poco científicos. [2] [17] Con la esperanza de evitar el mismo destino, muchos científicos sociales dirigieron su atención hacia modelos de microsimulación para hacer pronósticos y estudiar los efectos de las políticas mediante la modelización de cambios agregados en el estado de entidades a nivel individual en lugar de los cambios en la distribución a nivel de población. [18] Sin embargo, estos modelos de microsimulación no permitían que los individuos interactuaran o se adaptaran y no estaban destinados a la investigación teórica básica. [1]

Autómatas celulares y modelado basado en agentes

Los años 1970 y 1980 también fueron una época en la que los físicos y matemáticos intentaban modelar y analizar cómo las unidades componentes simples, como los átomos, dan lugar a propiedades globales, como propiedades materiales complejas a bajas temperaturas, en materiales magnéticos y dentro de flujos turbulentos. [19] Utilizando autómatas celulares, los científicos pudieron especificar sistemas que consistían en una red de celdas en la que cada celda solo ocupaba algunos estados finitos y los cambios entre estados estaban regidos únicamente por los estados de los vecinos inmediatos. Junto con los avances en inteligencia artificial y potencia de microcomputadoras , estos métodos contribuyeron al desarrollo de la " teoría del caos " y la " teoría de la complejidad " que, a su vez, renovaron el interés en comprender los sistemas físicos y sociales complejos a través de los límites disciplinarios. [2] Las organizaciones de investigación dedicadas explícitamente al estudio interdisciplinario de la complejidad también se fundaron en esta era: el Instituto Santa Fe fue establecido en 1984 por científicos con sede en el Laboratorio Nacional de Los Álamos y el grupo BACH en la Universidad de Michigan también comenzó a mediados de la década de 1980.

Este paradigma de autómatas celulares dio lugar a una tercera ola de simulación social que enfatizaba el modelado basado en agentes. Al igual que las microsimulaciones, estos modelos enfatizaban los diseños de abajo hacia arriba, pero adoptaban cuatro supuestos clave que divergían de la microsimulación: autonomía, interdependencia, reglas simples y comportamiento adaptativo. [1] Los modelos basados en agentes se preocupan menos por la precisión predictiva y, en cambio, enfatizan el desarrollo teórico. [20] En 1981, el matemático y politólogo Robert Axelrod y el biólogo evolutivo WD Hamilton publicaron un importante artículo en Science titulado "La evolución de la cooperación", que utilizó un enfoque de modelado basado en agentes para demostrar cómo se puede establecer y estabilizar la cooperación social basada en la reciprocidad en un juego de dilema del prisionero cuando los agentes siguen reglas simples de interés propio. [21] Axelrod y Hamilton demostraron que los agentes individuales que siguen un conjunto de reglas simples de (1) cooperar en el primer turno y (2) a partir de entonces replicar la acción anterior del socio fueron capaces de desarrollar "normas" de cooperación y sanción en ausencia de constructos sociológicos canónicos como la demografía, los valores, la religión y la cultura como condiciones previas o mediadores de la cooperación. [4] A lo largo de la década de 1990, académicos como William Sims Bainbridge , Kathleen Carley , Michael Macy y John Skvoretz desarrollaron modelos basados en múltiples agentes de reciprocidad generalizada , prejuicio , influencia social y procesamiento de información organizacional (psicología) . En 1999, Nigel Gilbert publicó el primer libro de texto sobre simulación social: Simulación para el científico social y estableció su revista más relevante: Journal of Artificial Societies and Social Simulation .

Minería de datos y análisis de redes sociales

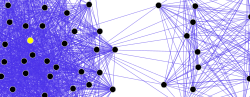

Independientemente de los desarrollos en modelos computacionales de sistemas sociales, el análisis de redes sociales surgió en los años 1970 y 1980 a partir de los avances en la teoría de grafos, las estadísticas y los estudios de la estructura social como un método analítico distinto y fue articulado y empleado por sociólogos como James S. Coleman , Harrison White , Linton Freeman , J. Clyde Mitchell , Mark Granovetter , Ronald Burt y Barry Wellman . [22] La creciente omnipresencia de las tecnologías informáticas y de telecomunicaciones a lo largo de los años 1980 y 1990 exigió técnicas analíticas, como el análisis de redes y el modelado multinivel , que pudieran escalar a conjuntos de datos cada vez más complejos y grandes. La ola más reciente de sociología computacional, en lugar de emplear simulaciones, utiliza el análisis de redes y técnicas estadísticas avanzadas para analizar bases de datos informáticas a gran escala de proxies electrónicos para datos de comportamiento. Los registros electrónicos, como los registros de correo electrónico y mensajes instantáneos, los hipervínculos en la World Wide Web , el uso de teléfonos móviles y las discusiones en Usenet permiten a los científicos sociales observar y analizar directamente el comportamiento social en múltiples puntos en el tiempo y en múltiples niveles de análisis sin las limitaciones de los métodos empíricos tradicionales, como las entrevistas, la observación de los participantes o los instrumentos de encuesta. [23] Las mejoras continuas en los algoritmos de aprendizaje automático también han permitido a los científicos sociales y a los empresarios utilizar técnicas novedosas para identificar patrones latentes y significativos de interacción social y evolución en grandes conjuntos de datos electrónicos. [24] [25]

El análisis automático de corpus textuales ha permitido la extracción de actores y sus redes relacionales a gran escala, convirtiendo los datos textuales en datos de red. Las redes resultantes, que pueden contener miles de nodos, se analizan luego utilizando herramientas de la teoría de redes para identificar los actores clave, las comunidades o partes clave y propiedades generales como la robustez o la estabilidad estructural de la red general, o la centralidad de ciertos nodos. [27] Esto automatiza el enfoque introducido por el análisis narrativo cuantitativo, [28] mediante el cual los tripletes sujeto-verbo-objeto se identifican con pares de actores vinculados por una acción, o pares formados por actor-objeto. [26]

Análisis de contenido computacional

El análisis de contenido ha sido una parte tradicional de las ciencias sociales y los estudios de medios durante mucho tiempo. La automatización del análisis de contenido ha permitido que se produzca una revolución de " big data " en ese campo, con estudios en redes sociales y contenido de periódicos que incluyen millones de noticias. El sesgo de género , la legibilidad , la similitud de contenido, las preferencias del lector e incluso el estado de ánimo se han analizado con base en métodos de minería de texto en millones de documentos. [29] [30] [31] [32] [33] El análisis de legibilidad, sesgo de género y sesgo de tema se demostró en Flaounas et al. [34] mostrando cómo diferentes temas tienen diferentes sesgos de género y niveles de legibilidad; también se demostró la posibilidad de detectar cambios de humor en una vasta población analizando el contenido de Twitter. [35]

Dzogang et al. [36] fueron pioneros en el análisis de grandes cantidades de contenido periodístico histórico y demostraron que es posible descubrir automáticamente estructuras periódicas en periódicos históricos. Se realizó un análisis similar en las redes sociales, que reveló nuevamente estructuras fuertemente periódicas. [37]

Desafíos

La sociología computacional, como cualquier campo de estudio, enfrenta una serie de desafíos. [38] Estos desafíos deben abordarse de manera significativa para lograr el máximo impacto en la sociedad.

Los niveles y sus interacciones

Toda sociedad que se forma tiende a estar en un nivel u otro y existen tendencias de interacción entre estos niveles y a través de ellos. Los niveles no tienen por qué ser sólo de naturaleza micro o macro. Puede haber niveles intermedios en los que exista una sociedad, por ejemplo, grupos, redes, comunidades, etc. [38]

Sin embargo, surge la pregunta de cómo identificar estos niveles y cómo surgen. Y una vez que existen, ¿cómo interactúan entre sí y con otros niveles?

Si consideramos a las entidades (agentes) como nodos y las conexiones entre ellas como los bordes, vemos la formación de redes. Las conexiones en estas redes no surgen de relaciones objetivas entre las entidades, sino que se deciden por factores elegidos por las entidades participantes. [39] El desafío con este proceso es que es difícil identificar cuándo un conjunto de entidades formará una red. Estas redes pueden ser redes de confianza, redes de cooperación, redes de dependencia, etc. Ha habido casos en los que conjuntos heterogéneos de entidades han demostrado formar redes sólidas y significativas entre sí. [40] [41]

Como se ha comentado anteriormente, las sociedades se dividen en niveles y, en uno de ellos, el nivel individual, un vínculo micro-macro [42] se refiere a las interacciones que crean niveles superiores. Hay una serie de preguntas que deben responderse con respecto a estos vínculos micro-macro: ¿cómo se forman? ¿Cuándo convergen? ¿Cuál es la retroalimentación que se envía a los niveles inferiores y cómo se envían?

Otro de los grandes retos en esta categoría es el de la validez de la información y de sus fuentes. En los últimos años se ha producido un auge en la recopilación y el procesamiento de información, pero se ha prestado poca atención a la difusión de información falsa entre las sociedades, por lo que resulta difícil rastrear las fuentes y determinar quién es el propietario de dicha información.

Modelado cultural

La evolución de las redes y los niveles de la sociedad genera diversidad cultural. [43] Sin embargo, surge la pregunta de cómo persiste la diversidad cuando las personas tienden a interactuar y a aceptar más otras culturas y creencias. ¿Por qué no hay convergencia? Un desafío importante es cómo modelar estas diversidades. ¿Existen factores externos, como los medios de comunicación, la localidad de las sociedades, etc., que influyan en la evolución o la persistencia de las diversidades culturales? [ cita requerida ]

Experimentación y evaluación

Todo estudio o modelado, cuando se combina con la experimentación, debe ser capaz de abordar las preguntas que se plantean. Las ciencias sociales computacionales trabajan con datos a gran escala y el desafío se hace mucho más evidente a medida que la escala crece. ¿Cómo se diseñarían simulaciones informativas a gran escala? E incluso si se plantea una simulación a gran escala, ¿cómo se supone que se realizará la evaluación?

Elección del modelo y complejidades del modelo

Otro desafío es identificar los modelos que mejor se ajusten a los datos y a las complejidades de estos modelos. Estos modelos nos ayudarían a predecir cómo podrían evolucionar las sociedades con el tiempo y brindarían posibles explicaciones sobre cómo funcionan las cosas. [44]

Modelos generativos

Los modelos generativos nos ayudan a realizar análisis cualitativos extensos de manera controlada. Un modelo propuesto por Epstein es la simulación basada en agentes, que habla de identificar un conjunto inicial de entidades heterogéneas (agentes) y observar su evolución y crecimiento en base a reglas locales simples. [45]

Pero ¿cuáles son estas reglas locales? ¿Cómo identificarlas para un conjunto de agentes heterogéneos? La evaluación y el impacto de estas reglas plantean un conjunto de nuevas dificultades.

Modelos heterogéneos o de conjunto

La integración de modelos simples que funcionan mejor en tareas individuales para formar un modelo híbrido es un enfoque que se puede estudiar. [46] Estos modelos pueden ofrecer un mejor rendimiento y comprensión de los datos. Sin embargo, la desventaja de identificar y tener una comprensión profunda de las interacciones entre estos modelos simples surge cuando uno necesita crear un modelo combinado que funcione bien. Además, crear herramientas y aplicaciones para ayudar a analizar y visualizar los datos basados en estos modelos híbridos es otro desafío adicional.

Impacto

La sociología computacional puede tener impactos en la ciencia, la tecnología y la sociedad. [38]

Impacto en la ciencia

Para que el estudio de la sociología computacional sea eficaz, tiene que haber innovaciones valiosas. Estas innovaciones pueden adoptar la forma de nuevas herramientas de análisis de datos, mejores modelos y algoritmos. La aparición de tales innovaciones supondrá un auge para la comunidad científica en general. [ cita requerida ]

Impacto en la sociedad

Uno de los mayores desafíos de la sociología computacional es el modelado de procesos sociales [ cita requerida ] . Los distintos legisladores y responsables de políticas podrían ver caminos eficientes y efectivos para emitir nuevas pautas y la masa en general podría evaluar y obtener una comprensión justa de las opciones que se les presentan, lo que permitiría un proceso de decisión abierto y bien equilibrado. [ cita requerida ] .

Véase también

- Revista de sociedades artificiales y simulación social

- Sociedad artificial

- Realidad simulada

- Simulación social

- Simulación social basada en agentes

- Complejidad social

- Economía computacional

- Epidemiología computacional

- Cliodinámica

- Análisis predictivo

Referencias

- ^ abc Macy, Michael W.; Willer, Robert (2002). "De factores a actores: sociología computacional y modelado basado en agentes". Revista anual de sociología . 28 : 143–166. doi :10.1146/annurev.soc.28.110601.141117. JSTOR 3069238. S2CID 1368768.

- ^ abcd Gilbert, Nigel; Troitzsch, Klaus (2005). "Simulación y ciencia social". Simulación para científicos sociales (2.ª ed.). Open University Press.

- ^ Epstein, Joshua M.; Axtell, Robert (1996). Sociedades artificiales en crecimiento: la ciencia social desde abajo . Washington DC: Brookings Institution Press. ISBN 978-0262050531.

- ^ ab Axelrod, Robert (1997). La complejidad de la cooperación: modelos de competencia y colaboración basados en agentes. Princeton, NJ: Princeton University Press. ISBN 0691015678.

- ^ Casti, J (1999). "La computadora como laboratorio: hacia una teoría de sistemas complejos adaptativos". Complejidad . 4 (5): 12–14. doi :10.1002/(SICI)1099-0526(199905/06)4:5<12::AID-CPLX3>3.0.CO;2-4.

- ^ Goldspink, C (2002). "Implicaciones metodológicas de los enfoques de sistemas complejos para la sociabilidad: la simulación como base para el conocimiento". 5 (1). Revista de sociedades artificiales y simulación social.

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Epstein, Joshua (2007). Ciencias sociales generativas: estudios en modelado computacional basado en agentes. Princeton, NJ: Princeton University Press.

- ^ abcd Salgado, Mauricio y Nigel Gilbert. "Aparición y comunicación en la sociología computacional". Journal for the Theory of Social Behaviour 43.1 (2013): 87-110.

- ^ Macy, Michael W. y Robert Willer. "De los factores a los actores: sociología computacional y modelado basado en agentes Archivado el 13 de julio de 2014 en Wayback Machine ." Revisión anual de sociología 28.1 (2002): 143-166.

- ^ Durkheim, Émile. La división del trabajo en la sociedad . Nueva York, Nueva York: Macmillan.

- ^ Bailey, Kenneth D. (2006). "Teoría de sistemas". En Jonathan H. Turner (ed.). Manual de teoría sociológica . Nueva York, NY: Springer Science. pp. 379–404. ISBN 978-0-387-32458-6.

- ^ Bainbridge, William Sims (2007). "Sociología computacional". En Ritzer, George (ed.). Blackwell Encyclopedia of Sociology . Blackwell Reference Online. doi :10.1111/b.9781405124331.2007.x (inactivo 2024-09-17). hdl : 10138/224218 . ISBN 978-1-4051-2433-1.

{{cite encyclopedia}}: CS1 maint: DOI inactive as of September 2024 (link) - ^ Crevier, D. (1993). IA: La tumultuosa historia de la búsqueda de inteligencia artificial . Nueva York, NY: Basic Books. ISBN 9780465001040.

- ^ Forrester, Jay (1971). Dinámica mundial . Cambridge, MA: MIT Press.

- ^ Ignall, Edward J.; Kolesar, Peter; Walker, Warren E. (1978). "Uso de simulación para desarrollar y validar modelos analíticos: algunos estudios de caso". Investigación de operaciones . 26 (2): 237–253. doi :10.1287/opre.26.2.237.

- ^ Meadows, DL; Behrens, WW; Meadows, DH; Naill, RF; Randers, J; Zahn, EK (1974). La dinámica del crecimiento en un mundo finito . Cambridge, MA: MIT Press.

- ^ "Se refuta la visión informática del desastre". The New York Times . 18 de octubre de 1974.

- ^ Orcutt, Guy H. (1990). "De la ingeniería a la microsimulación: una reflexión autobiográfica". Revista de comportamiento económico y organización . 14 (1): 5–27. doi :10.1016/0167-2681(90)90038-F.

- ^ Toffoli, Tommaso; Margolus, Norman (1987). Autómatas celulares: un nuevo entorno para el modelado . Cambridge, MA: MIT Press. ISBN 9780262200608.

- ^ Gilbert, Nigel (1997). "Una simulación de la estructura de la ciencia académica". Sociological Research Online . 2 (2): 1–15. doi :10.5153/sro.85. S2CID 5077349. Archivado desde el original el 1998-05-24 . Consultado el 2009-12-16 .

- ^ Axelrod, Robert; Hamilton, William D. (27 de marzo de 1981). "La evolución de la cooperación". Science . 211 (4489): 1390–1396. Bibcode :1981Sci...211.1390A. doi :10.1126/science.7466396. PMID 7466396.

- ^ Freeman, Linton C. (2004). El desarrollo del análisis de redes sociales: un estudio sobre la sociología de la ciencia . Vancouver, BC: Empirical Press.

- ^ Lazer, David; Pentland, Alex; Adamic, L; Aral, S; Barabasi, AL; Brewer, D; Christakis, N; Contractor, N; et al. (6 de febrero de 2009). "La vida en la red: la era venidera de la ciencia social computacional". Science . 323 (5915): 721–723. doi :10.1126/science.1167742. PMC 2745217 . PMID 19197046.

- ^ Srivastava, Jaideep; Cooley, Robert; Deshpande, Mukund; Tan, Pang-Ning (2000). "Minería de uso web: descubrimiento y aplicaciones de patrones de uso a partir de datos web". Boletín de exploraciones de ACM SIGKDD . 1 (2): 12–23. doi : 10.1145/846183.846188 . S2CID 967595.

- ^ Brin, Sergey; Page, Lawrence (abril de 1998). "La anatomía de un motor de búsqueda hipertextual en la Web a gran escala". Redes informáticas y sistemas ISDN . 30 (1–7): 107–117. CiteSeerX 10.1.1.115.5930 . doi :10.1016/S0169-7552(98)00110-X. S2CID 7587743.

- ^ ab S Sudhahar; GA Veltri; N Cristianini (2015). "Análisis automatizado de las elecciones presidenciales de Estados Unidos utilizando Big Data y análisis de redes". Big Data & Society . 2 (1): 1–28. doi : 10.1177/2053951715572916 . hdl : 2381/31767 .

- ^ S Sudhahar; G De Fazio; R Franzosi; N Cristianini (2013). "Análisis de redes de contenido narrativo en grandes corpus" (PDF) . Ingeniería del lenguaje natural . 21 (1): 1–32. doi :10.1017/S1351324913000247. hdl : 1983/dfb87140-42e2-486a-91d5-55f9007042df . S2CID 3385681.

- ^ Franzosi, Roberto (2010). Análisis narrativo cuantitativo . Universidad Emory.

- ^ I. Flaounas; M. Turchi; O. Ali; N. Fyson; T. De Bie; N. Mosdell; J. Lewis; N. Cristianini (2010). "La estructura de la mediasfera de la UE" (PDF) . PLOS ONE . 5 (12): e14243. Bibcode :2010PLoSO...514243F. doi : 10.1371/journal.pone.0014243 . PMC 2999531 . PMID 21170383.

- ^ V Lampos; N Cristianini (2012). "Predicción inmediata de eventos de la Web social con aprendizaje estadístico" (PDF) . ACM Transactions on Intelligent Systems and Technology . 3 (4): 72. doi :10.1145/2337542.2337557. S2CID 8297993.

- ^ I. Flaounas; O. Ali; M. Turchi; T Snowsill; F Nicart; T De Bie; N Cristianini (2011). NOAM: sistema de análisis y seguimiento de medios de comunicación (PDF) . Actas de la conferencia internacional ACM SIGMOD de 2011 sobre gestión de datos. doi :10.1145/1989323.1989474.

- ^ N Cristianini (2011). "Descubrimiento automático de patrones en contenido multimedia". Coincidencia de patrones combinatorios . Notas de clase en informática. Vol. 6661. págs. 2–13. CiteSeerX 10.1.1.653.9525 . doi :10.1007/978-3-642-21458-5_2. ISBN . 978-3-642-21457-8.

- ^ Lansdall-Welfare, Thomas; Sudhahar, Saatviga; Thompson, James; Lewis, Justin; Equipo, FindMyPast Newspaper; Cristianini, Nello (9 de enero de 2017). "Análisis de contenido de 150 años de publicaciones periódicas británicas". Actas de la Academia Nacional de Ciencias . 114 (4): E457–E465. Bibcode :2017PNAS..114E.457L. doi : 10.1073/pnas.1606380114 . ISSN 0027-8424. PMC 5278459 . PMID 28069962.

- ^ I. Flaounas; O. Ali; M. Turchi; T. Lansdall-Welfare; T. De Bie; N. Mosdell; J. Lewis; N. Cristianini (2012). "Métodos de investigación en la era del periodismo digital". Periodismo digital . 1 : 102–116. doi : 10.1080/21670811.2012.714928 . S2CID 61080552.

- ^ T Lansdall-Welfare; V Lampos; N Cristianini. Efectos de la recesión en el estado de ánimo público en el Reino Unido (PDF) . Actas de la 21.ª Conferencia Internacional sobre la World Wide Web. Sesión de Mining Social Network Dynamics (MSND) sobre aplicaciones de redes sociales. Nueva York, NY, EE. UU., págs. 1221–1226. doi :10.1145/2187980.2188264.

- ^ Dzogang, Fabon; Lansdall-Welfare, Thomas; Equipo, FindMyPast Newspaper; Cristianini, Nello (8 de noviembre de 2016). "Descubrimiento de patrones periódicos en noticias históricas". PLOS ONE . 11 (11): e0165736. Bibcode :2016PLoSO..1165736D. doi : 10.1371/journal.pone.0165736 . ISSN 1932-6203. PMC 5100883 . PMID 27824911.

- ^ Fluctuaciones estacionales en el estado de ánimo colectivo reveladas por búsquedas en Wikipedia y publicaciones en Twitter F Dzogang, T Lansdall-Welfare, N Cristianini - Conferencia internacional IEEE 2016 sobre minería de datos, Taller sobre minería de datos en el análisis de la actividad humana

- ^ abc Conte, Rosaria, et al. "Manifiesto de la ciencia social computacional Archivado el 22 de enero de 2022 en Wayback Machine ." The European Physical Journal Special Topics 214.1 (2012): 325-346.

- ^ Egu´ıluz, VM; Zimmermann, MG; Cela-Conde, CJ; San Miguel, M. "Revista Americana de Sociología" (2005): 110, 977.

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Sichman, JS; Conte, R. "Teoría de la organización matemática y computacional" (2002): 8(2).

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Ehrhardt, G.; Marsili, M.; Vega-Redondo, F. "Physical Review E" (2006): 74(3).

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Billari, Francesco C. Modelado computacional basado en agentes: aplicaciones en demografía, ciencias sociales, económicas y ambientales. Taylor & Francis, 2006.

- ^ Centola, D.; González-Avella, JC; Egu´ıluz, VM; San Miguel, M. “Revista de Resolución de Conflictos” (2007): 51.

{{cite journal}}: Requiere citar revista|journal=( ayuda ) - ^ Weisberg, Michael. Cuando menos es más: compensaciones e idealización en la construcción de modelos [ vínculo roto ] . Tesis doctoral. Universidad de Stanford, 2003.

- ^ Epstein, Joshua M. Ciencias sociales generativas: estudios en modelado computacional basado en agentes. Princeton University Press, 2006.

- ^ Yuan, Yuan; Alabdulkareem, Ahmad; Pentland, Alex 'Sandy' (2018). "Un enfoque interpretable para la formación de redes sociales entre agentes heterogéneos". Nature Communications . 9 (1): 4704. Bibcode :2018NatCo...9.4704Y. doi :10.1038/s41467-018-07089-x. PMC 6224571 . PMID 30410019.

Enlaces externos

- Libro en línea "Simulación para el científico social" de Nigel Gilbert y Klaus G. Troitzsch, 1999, segunda edición 2005

- Revista de sociedades artificiales y simulación social

- Modelos basados en agentes para redes sociales, aplicaciones Java interactivas

- Sitio web de Sociología y Ciencias de la Complejidad

Revistas y publicaciones académicas

- Lista de revistas de investigación sobre complejidad de UIUC, IL

- Grupos de investigación relacionados, de UIUC, IL

Asociaciones, congresos y talleres

- Asociación Norteamericana de Ciencias Computacionales, Sociales y Organizacionales

- ESSA: Asociación Europea de Simulación Social

Programas académicos, departamentos y titulaciones

- Proyecto "Mediapatterns" de la Universidad de Bristol Archivado el 1 de diciembre de 2012 en Wayback Machine.

- Universidad Carnegie Mellon Archivado el 2 de septiembre de 2014 en Wayback Machine , Programa de doctorado en Computación, Organizaciones y Sociedad (COS)

- Universidad de Chicago

- Certificado y Maestría en Ciencias Sociales Computacionales

- Universidad George Mason

- Programa de Doctorado en CSS (Ciencias Sociales Computacionales)

- Programa de Maestría en Estudios Interdisciplinarios, énfasis CSS

- Portland State, programa de doctorado en Ciencias de Sistemas

- Portland State, programa de maestría en Ciencias de Sistemas

- Universidad College de Dublín,

- Programa de Doctorado en Sistemas Complejos y Ciencias Sociales Computacionales

- Máster en Análisis de Datos Sociales

- Licenciatura en Ciencias Sociales Computacionales

- UCLA, especialización en sistemas humanos complejos

- UCLA, Licenciatura en Biología Computacional y de Sistemas (incluidas las ciencias del comportamiento)

- Universidad de Michigan, especialización en sistemas complejos

- Lista de programas de ciencias de sistemas de Portland State. Lista de otros programas relacionados en todo el mundo.

Centros e institutos

América del norte

- Centro de Investigación de Redes y Sistemas Complejos, Universidad de Indiana, Bloomington, IN, EE.UU.

- Centro de Investigación de Sistemas Complejos, Universidad de Illinois en Urbana-Champaign, IL, EE. UU.

- Centro de Complejidad Social, Universidad George Mason, Fairfax, VA, EE.UU.

- Centro de Dinámica Social y Complejidad, Universidad Estatal de Arizona, Tempe, AZ, EE.UU.

- Centro de Estudios de Sistemas Complejos, Universidad de Michigan, Ann Arbor, MI, EE.UU.

- Sistemas complejos humanos, Universidad de California en Los Ángeles, Los Ángeles, CA, EE. UU.

- Instituto de Ciencias Sociales Cuantitativas, Universidad de Harvard, Boston, MA, EE.UU.

- Instituto Northwestern de Sistemas Complejos (NICO), Universidad Northwestern, Evanston, IL, EE. UU.

- Instituto Santa Fe, Santa Fe, NM, EE.UU.

- Centro de análisis de redes de Duke, Universidad de Duke , Durham, Carolina del Norte, EE. UU.

Sudamerica

- Modelagem de Sistemas Complexos, Universidad de São Paulo - EACH, São Paulo, SP, Brasil

- Instituto Nacional de Ciência e Tecnologia de Sistemas Complexos, Centro Brasileiro de Pesquisas Físicas, Río de Janeiro, RJ, Brasil

Asia

- Instituto Bandung Fe, Centro de Complejidad de la Universidad de Surya, Bandung, Indonesia.

Europa

- Centro de Modelado de Políticas, Manchester, Reino Unido.

- Centro de Investigación en Simulación Social, Universidad de Surrey, Reino Unido.

- UCD Dynamics Lab- Centro de Ciencias Sociales Computacionales, Instituto Geary de Políticas Públicas, University College Dublin, Irlanda.

- Centro de Groningen para Estudios de Complejidad Social (GCSCS), Groningen, NL.

- Cátedra de Sociología, en particular de Modelado y Simulación (SOMS), Zúrich, Suiza.

- Grupo de investigación en sociología experimental y computacional (GECS), Brescia, Italia