Teoría de resonancia adaptativa

La teoría de resonancia adaptativa ( ART ) es una teoría desarrollada por Stephen Grossberg y Gail Carpenter sobre aspectos de cómo el cerebro procesa la información . Describe una serie de modelos de redes neuronales artificiales que utilizan métodos de aprendizaje supervisados y no supervisados y abordan problemas como el reconocimiento y la predicción de patrones .

La intuición primaria detrás del modelo ART es que la identificación y el reconocimiento de objetos generalmente ocurren como resultado de la interacción de las expectativas del observador "de arriba hacia abajo" con la información sensorial "de abajo hacia arriba" . El modelo postula que las expectativas "de arriba hacia abajo" toman la forma de una plantilla o prototipo de memoria que luego se compara con las características reales de un objeto tal como lo detectan los sentidos. Esta comparación da lugar a una medida de pertenencia a la categoría. Siempre que esta diferencia entre sensación y expectativa no exceda un umbral establecido llamado "parámetro de vigilancia", el objeto detectado se considerará un miembro de la clase esperada. El sistema ofrece así una solución al problema de "plasticidad/estabilidad", es decir, el problema de adquirir nuevos conocimientos sin alterar el conocimiento existente, lo que también se denomina aprendizaje incremental .

Modelo de aprendizaje

El sistema ART básico es un modelo de aprendizaje no supervisado . Normalmente consta de un campo de comparación y un campo de reconocimiento compuestos por neuronas , un parámetro de vigilancia (umbral de reconocimiento) y un módulo de reinicio .

- El campo de comparación toma un vector de entrada (una matriz unidimensional de valores) y lo transfiere a su mejor coincidencia en el campo de reconocimiento.

- Su mejor coincidencia es la neurona individual cuyo conjunto de pesos (vector de pesos) coincide más estrechamente con el vector de entrada.

- Cada neurona del campo de reconocimiento emite una señal negativa (proporcional a la calidad de coincidencia de esa neurona con el vector de entrada) a cada una de las otras neuronas del campo de reconocimiento y, de este modo, inhibe su salida.

- De esta manera, el campo de reconocimiento exhibe inhibición lateral , permitiendo que cada neurona en él represente una categoría en la que se clasifican los vectores de entrada.

- Una vez clasificado el vector de entrada, el módulo de reinicio compara la fuerza de la coincidencia de reconocimiento con el parámetro de vigilancia.

- Si se supera el parámetro de vigilancia (es decir, el vector de entrada está dentro del rango normal observado en los vectores de entrada anteriores), entonces comienza el entrenamiento:

- Los pesos de la neurona de reconocimiento ganadora se ajustan según las características del vector de entrada.

- De lo contrario, si el nivel de coincidencia está por debajo del parámetro de vigilancia (es decir, la coincidencia del vector de entrada está fuera del rango normal esperado para esa neurona), la neurona de reconocimiento ganadora se inhibe y se lleva a cabo un procedimiento de búsqueda.

- En este procedimiento de búsqueda, las neuronas de reconocimiento se desactivan una por una mediante la función de reinicio hasta que el parámetro de vigilancia es superado por una coincidencia de reconocimiento.

- En particular, en cada ciclo del procedimiento de búsqueda se selecciona la neurona de reconocimiento más activa y luego se apaga, si su activación está por debajo del parámetro de vigilancia.

- (nótese que esto libera las neuronas de reconocimiento restantes de su inhibición).

- En este procedimiento de búsqueda, las neuronas de reconocimiento se desactivan una por una mediante la función de reinicio hasta que el parámetro de vigilancia es superado por una coincidencia de reconocimiento.

- Si ninguna neurona de reconocimiento comprometida supera el parámetro de vigilancia, entonces se compromete una neurona no comprometida y sus pesos se ajustan para que coincida con el vector de entrada.

- Si se supera el parámetro de vigilancia (es decir, el vector de entrada está dentro del rango normal observado en los vectores de entrada anteriores), entonces comienza el entrenamiento:

- El parámetro de vigilancia tiene una influencia considerable en el sistema: una mayor vigilancia produce recuerdos muy detallados (muchas categorías de grano fino), mientras que una menor vigilancia produce recuerdos más generales (menos categorías de grano fino).

Capacitación

Existen dos métodos básicos para entrenar redes neuronales basadas en ART: lento y rápido. En el método de aprendizaje lento, el grado de entrenamiento de los pesos de la neurona de reconocimiento con respecto al vector de entrada se calcula con valores continuos mediante ecuaciones diferenciales y, por lo tanto, depende del tiempo durante el cual se presenta el vector de entrada. Con el aprendizaje rápido, se utilizan ecuaciones algebraicas para calcular el grado de ajuste de los pesos que se deben realizar y se utilizan valores binarios. Si bien el aprendizaje rápido es eficaz y eficiente para una variedad de tareas, el método de aprendizaje lento es biológicamente más plausible y se puede utilizar con redes de tiempo continuo (es decir, cuando el vector de entrada puede variar continuamente).

Tipos

ART 1 [1] [2] es la variedad más simple de redes ART, que solo acepta entradas binarias. ART 2 [3] extiende las capacidades de la red para admitir entradas continuas. ART 2-A [4] es una forma optimizada de ART-2 con un tiempo de ejecución drásticamente acelerado y con resultados cualitativos que solo rara vez son inferiores a la implementación completa de ART-2. ART 3 [5] se basa en ART-2 al simular la regulación rudimentaria de la actividad sináptica por neurotransmisores al incorporar concentraciones simuladas de iones de sodio (Na+) y calcio (Ca2+) en las ecuaciones del sistema, lo que da como resultado un medio fisiológicamente más realista de inhibir parcialmente las categorías que desencadenan restablecimientos de desajustes.

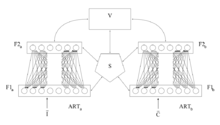

ARTMAP [6] también conocido como ART predictivo , combina dos unidades ART-1 o ART-2 ligeramente modificadas en una estructura de aprendizaje supervisado donde la primera unidad toma los datos de entrada y la segunda unidad toma los datos de salida correctos, que luego se utilizan para realizar el mínimo ajuste posible del parámetro de vigilancia en la primera unidad para realizar la clasificación correcta.

Fuzzy ART [7] implementa lógica difusa en el reconocimiento de patrones de ART, mejorando así la generalización. Una característica opcional (y muy útil) de Fuzzy ART es la codificación complementaria, un medio para incorporar la ausencia de características en las clasificaciones de patrones, lo que ayuda mucho a prevenir la proliferación de categorías ineficiente e innecesaria. Las medidas de similitud aplicadas se basan en la norma L1 . Se sabe que Fuzzy ART es muy sensible al ruido.

Fuzzy ARTMAP [8] es simplemente ARTMAP que utiliza unidades ART difusas, lo que da como resultado un aumento correspondiente en la eficacia.

El ARTMAP difuso simplificado (SFAM) [9] constituye una variante fuertemente simplificada del ARTMAP difuso dedicada a tareas de clasificación .

Gaussian ART [10] y Gaussian ARTMAP [10] utilizan funciones de activación gaussianas y cálculos basados en la teoría de la probabilidad. Por lo tanto, tienen cierta similitud con los modelos de mezcla gaussiana . En comparación con el ART difuso y el ARTMAP difuso, son menos sensibles al ruido. Pero la estabilidad de las representaciones aprendidas se reduce, lo que puede conducir a la proliferación de categorías en tareas de aprendizaje abiertas.

Fusion ART y las redes relacionadas [11] [12] [13] extienden ART y ARTMAP a múltiples canales de patrones. Admiten varios paradigmas de aprendizaje, incluidos el aprendizaje no supervisado, el aprendizaje supervisado y el aprendizaje de refuerzo.

TopoART [14] combina el ART difuso con redes de aprendizaje de topología como el gas neuronal creciente . Además, agrega un mecanismo de reducción de ruido. Existen varias redes neuronales derivadas que extienden TopoART a otros paradigmas de aprendizaje.

Hypersphere ART [15] e Hypersphere ARTMAP [15] están estrechamente relacionados con el ART difuso y el ARTMAP difuso, respectivamente. Pero como utilizan un tipo diferente de representación de categorías (es decir, hiperesferas), no requieren que su entrada se normalice al intervalo [0, 1]. Aplican medidas de similitud basadas en la norma L2 .

LAPART [16] Las redes neuronales de la teoría de resonancia adaptativa con cebadores laterales (LAPART) acoplan dos algoritmos de ART difusos para crear un mecanismo para realizar predicciones basadas en asociaciones aprendidas. El acoplamiento de los dos ART difusos tiene una estabilidad única que permite que el sistema converja rápidamente hacia una solución clara. Además, puede realizar inferencia lógica y aprendizaje supervisado similar al ARTMAP difuso.

Crítica

![[icono]](http://upload.wikimedia.org/wikipedia/commons/thumb/1/1c/Wiki_letter_w_cropped.svg/20px-Wiki_letter_w_cropped.svg.png) | Esta sección necesita ser ampliada . Puedes ayudar agregándole algo. ( Septiembre 2015 ) |

Se ha observado que los resultados de Fuzzy ART y ART 1 (es decir, las categorías aprendidas) dependen críticamente del orden en el que se procesan los datos de entrenamiento. El efecto se puede reducir hasta cierto punto utilizando una tasa de aprendizaje más lenta, pero está presente independientemente del tamaño del conjunto de datos de entrada. Por lo tanto, las estimaciones de Fuzzy ART y ART 1 no poseen la propiedad estadística de consistencia . [17] Este problema puede considerarse como un efecto secundario de los respectivos mecanismos que garantizan un aprendizaje estable en ambas redes.

Las redes ART más avanzadas, como TopoART y Hypersphere TopoART, que resumen las categorías en grupos, pueden resolver este problema, ya que las formas de los grupos no dependen del orden de creación de las categorías asociadas (cf. Fig. 3(g, h) y Fig. 4 de [18] ).

Referencias

- ^ Carpenter, GA y Grossberg, S. (2003), Teoría de la resonancia adaptativa Archivado el 19 de mayo de 2006 en Wayback Machine , en Michael A. Arbib (Ed.), The Handbook of Brain Theory and Neural Networks, segunda edición (pp. 87-90). Cambridge, MA: MIT Press

- ^ Grossberg, S. (1987), Aprendizaje competitivo: de la activación interactiva a la resonancia adaptativa Archivado el 7 de septiembre de 2006 en Wayback Machine , Cognitive Science (revista) , 11, 23-63

- ^ Carpenter, GA y Grossberg, S. (1987), ART 2: Autoorganización de códigos de reconocimiento de categorías estables para patrones de entrada analógicos Archivado el 4 de septiembre de 2006 en Wayback Machine , Applied Optics , 26(23), 4919-4930

- ^ Carpenter, GA, Grossberg, S., y Rosen, DB (1991a), ART 2-A: Un algoritmo de resonancia adaptativa para el aprendizaje y reconocimiento rápido de categorías Archivado el 19 de mayo de 2006 en Wayback Machine , Neural Networks , 4, 493-504

- ^ Carpenter, GA y Grossberg, S. (1990), ART 3: Búsqueda jerárquica utilizando transmisores químicos en arquitecturas de reconocimiento de patrones autoorganizados Archivado el 6 de septiembre de 2006 en Wayback Machine , Neural Networks , 3, 129-152

- ^ Carpenter, GA, Grossberg, S., y Reynolds, JH (1991), ARTMAP: Aprendizaje supervisado en tiempo real y clasificación de datos no estacionarios por una red neuronal autoorganizada Archivado el 19 de mayo de 2006 en Wayback Machine , Neural Networks , 4, 565-588

- ^ Carpenter, GA, Grossberg, S., y Rosen, DB (1991b), Fuzzy ART: aprendizaje rápido y estable y categorización de patrones analógicos mediante un sistema de resonancia adaptativa Archivado el 19 de mayo de 2006 en Wayback Machine , Neural Networks , 4, 759-771

- ^ Carpenter, GA, Grossberg, S., Markuzon, N., Reynolds, JH, y Rosen, DB (1992), Fuzzy ARTMAP: una arquitectura de red neuronal para el aprendizaje supervisado incremental de mapas multidimensionales analógicos Archivado el 19 de mayo de 2006 en Wayback Machine , IEEE Transactions on Neural Networks , 3, 698-713

- ^ Mohammad-Taghi Vakil-Baghmisheh y Nikola Pavešić. (2003) Una red ARTMAP difusa simplificada y rápida, Neural Processing Letters, 17(3):273–316

- ^ por James R. Williamson. (1996), Gaussian ARTMAP: una red neuronal para el aprendizaje incremental rápido de mapas multidimensionales ruidosos, Neural Networks, 9(5):881-897

- ^ YR Asfour, GA Carpenter, S. Grossberg y GW Lesher. (1993) Fusion ARTMAP: una red difusa adaptativa para la clasificación multicanal. En: Actas de la Tercera Conferencia Internacional sobre Control Difuso Industrial y Sistemas Inteligentes (IFIS).

- ^ Tan, A.-H.; Carpenter, GA; Grossberg, S. (2007). "Inteligencia a través de la interacción: hacia una teoría unificada para el aprendizaje". En Liu, D.; Fei, S.; Hou, Z.-G.; Zhang, H.; Sun, C. (eds.). Avances en redes neuronales – ISNN 2007. Apuntes de clase en informática. Vol. 4491. Berlín, Heidelberg: Springer. págs. 1094–1103. doi :10.1007/978-3-540-72383-7_128. ISBN 978-3-540-72383-7.

- ^ Tan, A.-H.; Subagdja, B.; Wang, D.; Meng, L. (2019). "Redes neuronales autoorganizadas para el aprendizaje universal y la codificación de memoria multimodal". Redes neuronales . 120 : 58–73. doi :10.1016/j.neunet.2019.08.020. PMID 31537437. S2CID 202703163.

- ^ Marko Tscherepanow. (2010) TopoART: una red ART jerárquica de aprendizaje de topología, en: Actas de la Conferencia Internacional sobre Redes Neuronales Artificiales (ICANN), Parte III, LNCS 6354, 157-167

- ^ de Georgios C. Anagnostopoulos y Michael Georgiopoulos. (2000), Hypersphere ART y ARTMAP para aprendizaje incremental supervisado y no supervisado, en: Actas de la Conferencia conjunta internacional sobre redes neuronales (IJCNN), vol. 6, 59-64

- ^ Sandia National Laboratories (2017) Documentación de Lapart-python

- ^ Sarle, Warren S. (1995), Por qué los estadísticos no deberían tirarse pedos Archivado el 20 de julio de 2011 en Wayback Machine .

- ^ Marko Tscherepanow. (2012) Agrupamiento incremental en línea con una red neuronal ART jerárquica de aprendizaje de topología utilizando categorías hiperesféricas, en: Póster y actas de la industria de la Conferencia industrial sobre minería de datos (ICDM), 22-34

Wasserman, Philip D. (1989), Computación neuronal: teoría y práctica, Nueva York: Van Nostrand Reinhold, ISBN 0-442-20743-3

Enlaces externos

- Sitio web de Stephen Grossberg

- Implementación de ART para el aprendizaje no supervisado (ART 1, ART 2A, ART 2A-C y ART a distancia)

- Resumen del algoritmo ART

- LibTopoART: implementaciones de TopoART para aprendizaje supervisado y no supervisado (TopoART, TopoART-AM, TopoART-C, TopoART-R, Episodic TopoART, Hypersphere TopoART y Hypersphere TopoART-C)