Historia de la entropía

This article needs additional citations for verification. (November 2024) |

En la historia de la física , el concepto de entropía se desarrolló en respuesta a la observación de que una cierta cantidad de energía funcional liberada de las reacciones de combustión siempre se pierde por disipación o fricción y, por lo tanto, no se transforma en trabajo útil . Los primeros motores alimentados por calor, como el de Thomas Savery (1698), el motor de Newcomen (1712) y el triciclo de vapor de Nicolas-Joseph Cugnot (1769), eran ineficientes, ya que convertían menos del dos por ciento de la energía de entrada en trabajo útil de salida ; una gran cantidad de energía útil se disipaba o se perdía. Durante los dos siglos siguientes, los físicos investigaron este enigma de la energía perdida; el resultado fue el concepto de entropía.

A principios de la década de 1850, Rudolf Clausius formuló el concepto de sistema termodinámico y postuló el argumento de que en cualquier proceso irreversible se disipa de forma incremental una pequeña cantidad de energía térmica δQ a través de los límites del sistema. Clausius continuó desarrollando sus ideas sobre la energía perdida y acuñó el término entropía .

Desde mediados del siglo XX, el concepto de entropía ha encontrado aplicación en el campo de la teoría de la información , describiendo una pérdida análoga de datos en los sistemas de transmisión de información.

Puntos de vista termodinámicos clásicos

En 1803, el matemático Lazare Carnot publicó una obra titulada Principios fundamentales del equilibrio y del movimiento . Esta obra incluye una discusión sobre la eficiencia de las máquinas fundamentales, es decir, poleas y planos inclinados. Carnot analizó todos los detalles de los mecanismos para desarrollar una discusión general sobre la conservación de la energía mecánica. Durante las siguientes tres décadas, el teorema de Carnot se tomó como una afirmación de que en cualquier máquina las aceleraciones y los choques de las partes móviles representan pérdidas de momento de actividad , es decir, el trabajo útil realizado. De esto, Carnot extrajo la inferencia de que el movimiento perpetuo era imposible. Esta pérdida de momento de actividad fue la primera declaración rudimentaria de la segunda ley de la termodinámica y el concepto de "energía de transformación" o entropía , es decir, energía perdida por disipación y fricción. [1]

Carnot murió en el exilio en 1823. Durante el año siguiente su hijo Sadi Carnot , que se había graduado de la escuela de formación de ingenieros École Polytechnique , pero que ahora vivía con media paga con su hermano Hippolyte en un pequeño apartamento en París, escribió Reflexiones sobre la fuerza motriz del fuego . En este libro, Sadi visualizó un motor ideal en el que cualquier calor (es decir, calórico ) convertido en trabajo , podría ser restituido invirtiendo el movimiento del ciclo, un concepto posteriormente conocido como reversibilidad termodinámica . Basándose en el trabajo de su padre, Sadi postuló el concepto de que "siempre se pierde algo de calor" en la conversión en trabajo, incluso en su motor térmico reversible idealizado, que excluía las pérdidas por fricción y otras pérdidas debidas a las imperfecciones de cualquier máquina real. También descubrió que esta eficiencia idealizada dependía solo de las temperaturas de los depósitos de calor entre los que funcionaba el motor, y no de los tipos de fluidos de trabajo . Ningún motor térmico real podía realizar la reversibilidad del ciclo de Carnot y estaba condenado a ser aún menos eficiente. Esta pérdida de calor utilizable fue una forma precursora del aumento de la entropía tal como lo conocemos hoy. Aunque se formuló en términos de calor, en lugar de entropía, fue una idea temprana de la segunda ley de la termodinámica.

Las definiciones de Clausius

Definición de 1854

En sus memorias de 1854, Clausius desarrolla por primera vez los conceptos de trabajo interior , es decir, el «que los átomos del cuerpo ejercen entre sí», y trabajo exterior , es decir, el «que surge de influencias externas [a] las que el cuerpo puede estar expuesto», que pueden actuar sobre un cuerpo de fluido o gas en funcionamiento, normalmente funcionando para hacer funcionar un pistón. A continuación, analiza las tres categorías en las que se puede dividir el calor Q :

- Calor empleado para aumentar el calor realmente existente en el cuerpo.

- Calor empleado en la producción del trabajo interior.

- Calor empleado en la producción de la obra exterior.

Basándose en esta lógica, y tras una presentación matemática del primer teorema fundamental , Clausius presentó la primera formulación matemática de la entropía, aunque en este punto del desarrollo de sus teorías la llamó "valor de equivalencia", tal vez refiriéndose al concepto de equivalente mecánico del calor que se estaba desarrollando en ese momento en lugar de entropía, un término que entraría en uso más tarde. [2] Afirmó: [3]

El segundo teorema fundamental de la teoría mecánica del calor puede enunciarse así:

Si dos transformaciones que, sin necesidad de ningún otro cambio permanente, pueden sustituirse mutuamente, se denominan equivalentes, entonces la generación de la cantidad de calor Q a partir del trabajo a la temperatura T tiene el valor de equivalencia :

y el paso de la cantidad de calor Q de la temperatura T 1 a la temperatura T 2 , tiene el valor de equivalencia:

donde T es una función de la temperatura, independiente de la naturaleza del proceso mediante el cual se efectúa la transformación.

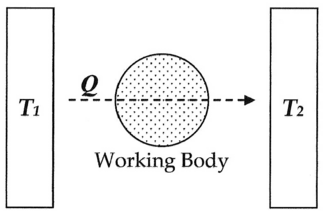

En la terminología moderna, es decir, la terminología introducida por el propio Clausius en 1865, consideramos este valor de equivalencia como "entropía", simbolizada por S . Así, utilizando la descripción anterior, podemos calcular el cambio de entropía Δ S para el paso de la cantidad de calor Q desde la temperatura T 1 , a través del "cuerpo de trabajo" del fluido, que era típicamente un cuerpo de vapor, hasta la temperatura T 2 como se muestra a continuación:

Si hacemos la asignación:

Entonces, el cambio de entropía o "valor de equivalencia" para esta transformación es:

Lo cual es igual a:

y al factorizar Q, tenemos la siguiente forma, tal como la derivó Clausius:

Definición de 1856

En 1856, Clausius enunció lo que llamó el "segundo teorema fundamental en la teoría mecánica del calor " en la siguiente forma:

donde N es el "valor de equivalencia" de todas las transformaciones no compensadas que intervienen en un proceso cíclico. Este valor de equivalencia fue una formulación precursora de la entropía. [4]

Definición de 1862

En 1862, Clausius enunció lo que él llama el "teorema relativo a los valores de equivalencia de las transformaciones" o lo que ahora se conoce como la segunda ley de la termodinámica , como tal:

La suma algebraica de todas las transformaciones que ocurren en un proceso cíclico sólo puede ser positiva o, como caso extremo, igual a nada.

Cuantitativamente, Clausius afirma que la expresión matemática para este teorema es la siguiente.

Sea δQ un elemento del calor cedido por el cuerpo a cualquier depósito de calor durante sus propios cambios, considerándose aquí como negativo el calor que puede absorber de un depósito, y T la temperatura absoluta del cuerpo en el momento de ceder este calor, entonces la ecuación:

debe ser verdadera para todo proceso cíclico reversible, y la relación:

Debe ser válido para cualquier proceso cíclico que sea posible de cualquier manera.

Esta fue una formulación temprana de la segunda ley y una de las formas originales del concepto de entropía.

Definición de 1865

En 1865, Clausius le dio un nombre a la pérdida de calor irreversible, o lo que anteriormente había llamado "valor de equivalencia": [5] [6] [7]

Propongo que S se tome de las palabras griegas 'en-tropie' [dirección intrínseca]. He elegido deliberadamente la palabra entropía para que sea lo más similar posible a la palabra energía: las dos cantidades que se nombrarán con estas palabras están tan estrechamente relacionadas en su significado físico que una cierta similitud en sus nombres parece apropiada. [8]

Clausius no especificó por qué eligió el símbolo S para representar la entropía, y es casi seguro que no es cierto que Clausius eligiera S en honor a Sadi Carnot ; los nombres de pila de los científicos rara vez, o nunca, se usan de esta manera. [9]

Desarrollos posteriores

En 1876, el físico J. Willard Gibbs , basándose en el trabajo de Clausius, Hermann von Helmholtz y otros, propuso que la medición de la "energía disponible" Δ G en un sistema termodinámico podría explicarse matemáticamente restando la "pérdida de energía" T Δ S del cambio total de energía del sistema Δ H . Estos conceptos fueron desarrollados posteriormente por James Clerk Maxwell [1871] y Max Planck [1903]. [ cita requerida ]

Mecánica estadística

En 1877, Ludwig Boltzmann desarrolló una evaluación de la entropía S de un cuerpo en su propio macroestado de equilibrio termodinámico interno, basada en la mecánica estadística . Puede escribirse como:

dónde

- k B denota la constante de Boltzmann y

- Ω denota el número de microestados consistentes con el macroestado de equilibrio dado.

El propio Boltzmann no escribió realmente esta fórmula expresada con la constante nombrada k B , lo que se debe a la lectura que hizo Planck de Boltzmann. [10]

Boltzmann consideraba la entropía como una medida de "confusión" o desorden estadístico. Gibbs pronto perfeccionó este concepto y ahora se lo considera una de las piedras angulares de la teoría de la mecánica estadística .

Relación con los sistemas vivos

Erwin Schrödinger utilizó el trabajo de Boltzmann en su libro de 1944 ¿Qué es la vida? [11] para explicar por qué los sistemas vivos tienen muchos menos errores de replicación de los que se podrían predecir a partir de la mecánica estadística. Schrödinger utilizó la ecuación de Boltzmann en una forma diferente para mostrar el aumento de la entropía.

donde D es el número de estados de energía posibles en el sistema que pueden llenarse aleatoriamente con energía. Postuló una disminución local de la entropía para los sistemas vivos cuando (1/D) representa el número de estados que no pueden distribuirse aleatoriamente, como ocurre en la replicación del código genético.

Sin esta corrección, Schrödinger afirmó que la mecánica estadística predeciría mil mutaciones por millón de réplicas y diez mutaciones por cien réplicas siguiendo la regla de la raíz cuadrada de n , muchas más mutaciones de las que realmente ocurren.

La separación de Schrödinger de los estados de energía aleatorios y no aleatorios es una de las pocas explicaciones de por qué la entropía podría ser baja en el pasado, pero aumentar continuamente en la actualidad. Se ha propuesto como una explicación de la disminución localizada de la entropía [12] en la energía radiante enfocada en reflectores parabólicos y durante la corriente oscura en diodos, que de otro modo violaría la mecánica estadística.

Teoría de la información

Un análogo de la entropía termodinámica es la entropía de la información . En 1948, mientras trabajaba en los Laboratorios Bell Telephone , el ingeniero eléctrico Claude Shannon se propuso cuantificar matemáticamente la naturaleza estadística de la "información perdida" en las señales de las líneas telefónicas. Para ello, Shannon desarrolló el concepto muy general de entropía de la información , una piedra angular fundamental de la teoría de la información . Aunque la historia varía, inicialmente parece que Shannon no era particularmente consciente de la estrecha similitud entre su nueva cantidad y el trabajo anterior en termodinámica. Sin embargo, en 1939, cuando Shannon había estado trabajando en sus ecuaciones durante algún tiempo, visitó por casualidad al matemático John von Neumann . Durante sus discusiones, sobre lo que Shannon debería llamar la "medida de incertidumbre" o atenuación en las señales de las líneas telefónicas con referencia a su nueva teoría de la información, según una fuente: [13]

Mi mayor preocupación era cómo llamarlo. Pensé en llamarlo "información", pero la palabra se usó demasiado, así que decidí llamarlo "incertidumbre". Cuando lo discutí con John von Neumann, él tuvo una idea mejor. Von Neumann me dijo: "Deberías llamarlo entropía, por dos razones: en primer lugar, tu función de incertidumbre se ha utilizado en mecánica estadística con ese nombre, por lo que ya tiene un nombre. En segundo lugar, y más importante, nadie sabe qué es realmente la entropía, por lo que en un debate siempre tendrás la ventaja.

Según otra fuente, cuando von Neumann le preguntó cómo le iba con su teoría de la información, Shannon respondió: [14]

La teoría estaba en muy buenas condiciones, salvo que necesitaba un buen nombre para la "información faltante". "¿Por qué no la llamas entropía?", sugirió von Neumann. "En primer lugar, ya existe un desarrollo matemático muy parecido al tuyo en la mecánica estadística de Boltzmann y, en segundo lugar, nadie entiende muy bien la entropía, por lo que en cualquier discusión estarás en una posición de ventaja.

En 1948 Shannon publicó su artículo fundamental Una teoría matemática de la comunicación , en el que dedicó una sección a lo que él llama Elección, Incertidumbre y Entropía. [15] En esta sección, Shannon introduce una función H de la siguiente forma:

donde K es una constante positiva. Shannon afirma entonces que "cualquier cantidad de esta forma, donde K equivale simplemente a la elección de una unidad de medida, desempeña un papel central en la teoría de la información como medida de información, elección e incertidumbre". Luego, como ejemplo de cómo se aplica esta expresión en varios campos diferentes, hace referencia a los Principios de mecánica estadística de Richard C. Tolman de 1938 , afirmando que

La forma de H se reconocerá como la de la entropía tal como se define en ciertas formulaciones de la mecánica estadística, donde p i es la probabilidad de que un sistema esté en la celda i de su espacio de fases... H es entonces, por ejemplo, la H en el famoso teorema H de Boltzmann .

Así, durante los últimos cincuenta años, desde que se hizo esta afirmación, la gente ha estado superponiendo los dos conceptos o incluso afirmando que son exactamente lo mismo.

La entropía de información de Shannon es un concepto mucho más general que la entropía termodinámica estadística. La entropía de información está presente siempre que haya cantidades desconocidas que puedan describirse únicamente mediante una distribución de probabilidad. En una serie de artículos de ET Jaynes que comenzaron en 1957, [16] [17] la entropía termodinámica estadística puede verse simplemente como una aplicación particular de la entropía de información de Shannon a las probabilidades de que ocurran microestados particulares de un sistema para producir un macroestado particular.

Uso popular

El término entropía se utiliza a menudo en el lenguaje popular para designar una variedad de fenómenos no relacionados. Un ejemplo es el concepto de entropía corporativa , tal como lo plantearon con cierto humor los autores Tom DeMarco y Timothy Lister en su publicación clásica de 1987 Peopleware , un libro sobre el crecimiento y la gestión de equipos productivos y proyectos de software exitosos. En este libro, ven el desperdicio de energía como una burocracia y la ineficiencia del equipo empresarial como una forma de entropía, es decir, energía que se pierde en el derroche. Este concepto se ha popularizado y ahora es una jerga común en las escuelas de negocios.

En otro ejemplo, la entropía es el tema central del cuento de Isaac Asimov " La última pregunta " (cuyo copyright se registró por primera vez en 1956). El relato juega con la idea de que la pregunta más importante es cómo detener el aumento de la entropía.

Superposición terminológica

Cuando es necesario, para desambiguar el concepto termodinámico estadístico de entropía y las fórmulas similares a la entropía propuestas por diferentes investigadores, la entropía termodinámica estadística se denomina más apropiadamente entropía de Gibbs . Los términos entropía de Boltzmann-Gibbs o entropía BG y entropía de Boltzmann-Gibbs-Shannon o entropía BGS también se ven en la literatura.

Véase también

Referencias

- ^ Mendoza, E. (1988). Reflexiones sobre la fuerza motriz del fuego y otros artículos sobre la segunda ley de la termodinámica de E. Clapeyron y R. Clausius . Nueva York: Dover Publications. ISBN 0-486-44641-7.

- ^ Teoría mecánica del calor , de Rudolf Clausius , 1850-1865

- ^ Publicado en Annalen de Poggendoff , diciembre de 1854, vol. xciii. pag. 481; traducido en el Journal de Mathematiques , vol. xx. París, 1855, y en la Revista Filosófica , agosto de 1856, s. 4. vol. xii, pág. 81

- ^ Clausius, Rudolf. (1856). " Sobre la aplicación de la teoría mecánica del calor a la máquina de vapor ". Como se encuentra en: Clausius, R. (1865). La teoría mecánica del calor: con sus aplicaciones a la máquina de vapor y a las propiedades físicas de los cuerpos. Londres: John van Voorst, 1 Paternoster Row. MDCCCLXVII.

- ^ Laidler, Keith J. (1995). El mundo físico de la química . Oxford University Press. pp. 104-105. ISBN 0-19-855919-4.

- ^ OED , segunda edición, 1989, " Clausius (Pogg. Ann. CXXV. 390), asumiendo (de manera no histórica) el sentido etimológico de energía como 'contenido de trabajo' (werk-inhalt), ideó el término entropía como una designación correspondiente para los 'contenidos de transformación' (Verwandlungsinhalt) de un sistema"

- ^ Baierlein, Ralph (diciembre de 1992). "Cómo la entropía obtuvo su nombre". American Journal of Physics . 60 (12): 1151. Bibcode :1992AmJPh..60.1151B. doi :10.1119/1.16966.

- ^ Clausius, Rudolf (1865). "Ueber verschiedene für die Anwendung bequeme Formen der Hauptgleichungen der mechanischen Wärmetheorie (Vorgetragen in der naturforsch. Gesellschaft zu Zürich den 24 de abril de 1865)". Annalen der Physik und Chemie . 125 (7): 353–400. Código bibliográfico : 1865AnP...201..353C. doi : 10.1002/andp.18652010702."sucht man für Seinen bezeichnenden Namen, so könnte man, ähnlich wie von der Gröſse U gesagt ist, sie sey der Wärme- und Werkinhalt des Körpers, von der Gröſse S sagen, sie sey der Verwandlungsinhalt des Körpers. Da ich es aber für besser halte, die Namen derartiger für die Wissenschaft wichtiger Gröſsen aus den alten Sprachen zu entnehmen, damit sie unverändert in allen neuen Sprachen angewandt werden können, so schlage ich vor, die Gröſse S nach dem griechischen Worte ἡ τροπή, die Verwandlung, die Entropie des Körpers zu nennen. Das Wort Entropie habei ich absichtlich dem Worte Energie möglichst ähnlich gebildet, denn die beiden Gröſsen, welche durch diese Worte benannt werden sollen, sind ihren physikalischen Bedeutungen nach einander so nahe verwandt, daſs eine gewisse Gleichartigkeit in der Benennung mir z weckmäſsig zu seyn scheint." (pág. 390).

- ^ Girolami, GS (2020). "Una breve historia de la termodinámica, ilustrada por libros y personas". J. Chem. Eng. Data . 65 (2): 298–311. doi :10.1021/acs.jced.9b00515. S2CID 203146340.

- ^ Partington, JR (1949), Un tratado avanzado sobre química física , vol. 1, Principios fundamentales , Las propiedades de los gases , Londres: Longmans, Green and Co. , pág. 300

- ^ Schrödinger, Erwin (2004). ¿Qué es la vida? (11.ª reimpresión). Cambridge: Canto. pp. 72–73. ISBN 0-521-42708-8.

- ^ "Estados aleatorios y no aleatorios". 27 de agosto de 2014.

- ^ M. Tribus, EC McIrvine, "Energía e información", Scientific American , 224 (septiembre de 1971).

- ^ Avery, John (2003). Teoría de la información y evolución . World Scientific. ISBN 981-238-400-6.

- ^ CE Shannon, "Una teoría matemática de la comunicación", Bell System Technical Journal , vol. 27, págs. 379-423, 623-656, julio, octubre de 1948, Eprint Archivado el 31 de enero de 1998 en Wayback Machine , PDF

- ^ ET Jaynes (1957) Teoría de la información y mecánica estadística, Physical Review 106 :620

- ^ ET Jaynes (1957) Teoría de la información y mecánica estadística II, Physical Review 108 :171