Bootstrapping (estadísticas)

El bootstrapping es un procedimiento para estimar la distribución de un estimador mediante el remuestreo (a menudo con reemplazo ) de los datos propios o de un modelo estimado a partir de los datos. [1] El bootstrapping asigna medidas de precisión ( sesgo , varianza, intervalos de confianza , error de predicción, etc.) a las estimaciones de muestra. [2] [3] Esta técnica permite estimar la distribución de muestreo de casi cualquier estadística utilizando métodos de muestreo aleatorio. [1]

El bootstrap estima las propiedades de un estimando (como su varianza ) midiendo esas propiedades al muestrear de una distribución aproximada. Una opción estándar para una distribución aproximada es la función de distribución empírica de los datos observados. En el caso en que se pueda suponer que un conjunto de observaciones proviene de una población independiente e idénticamente distribuida , esto se puede implementar construyendo una cantidad de remuestreos con reemplazo, del conjunto de datos observados (y de igual tamaño al conjunto de datos observados). Un resultado clave en el artículo seminal de Efron que introdujo el bootstrap [4] es el desempeño favorable de los métodos bootstrap que usan muestreo con reemplazo en comparación con métodos anteriores como el jackknife que muestrea sin reemplazo. Sin embargo, desde su introducción, se han propuesto numerosas variantes del bootstrap, incluidos métodos que muestrean sin reemplazo o que crean muestras bootstrap más grandes o más pequeñas que los datos originales.

El bootstrap también se puede utilizar para construir pruebas de hipótesis . [5] A menudo se utiliza como una alternativa a la inferencia estadística basada en el supuesto de un modelo paramétrico cuando ese supuesto está en duda, o cuando la inferencia paramétrica es imposible o requiere fórmulas complicadas para el cálculo de errores estándar .

Historia

El bootstrap [a] fue descrito por primera vez por Bradley Efron en "Bootstrap methods: another look at the jackknife" (1979), [4] inspirado por trabajos anteriores sobre el jackknife . [6] [7] [8] Se desarrollaron estimaciones mejoradas de la varianza más tarde. [9] [10] Se desarrolló una extensión bayesiana en 1981. [11] El bootstrap acelerado y corregido por sesgo ( ) fue desarrollado por Efron en 1987, [12] y el procedimiento aproximado de intervalo de confianza bootstrap (ABC, o aproximado ) en 1992. [13]

Acercarse

La idea básica del bootstrap es que la inferencia sobre una población a partir de datos de muestra (muestra → población) se puede modelar remuestreando los datos de muestra y realizando inferencia sobre una muestra a partir de datos remuestreados (remuestreado → muestra). [14] Como la población es desconocida, el error verdadero en una estadística de muestra contra su valor de población es desconocido. En los remuestreos bootstrap, la "población" es de hecho la muestra, y esto se conoce; por lo tanto, la calidad de la inferencia de la muestra "verdadera" a partir de datos remuestreados (remuestreado → muestra) es medible.

Más formalmente, el bootstrap funciona tratando la inferencia de la distribución de probabilidad verdadera J , dados los datos originales, como si fuera análoga a una inferencia de la distribución empírica Ĵ , dados los datos remuestreados. La precisión de las inferencias con respecto a Ĵ utilizando los datos remuestreados se puede evaluar porque conocemos Ĵ . Si Ĵ es una aproximación razonable a J , entonces la calidad de la inferencia sobre J se puede inferir a su vez.

Como ejemplo, supongamos que estamos interesados en la altura promedio (o media ) de las personas en todo el mundo. No podemos medir a todas las personas de la población mundial, por lo que, en su lugar, tomamos una muestra de solo una pequeña parte de ella y la medimos. Supongamos que la muestra es de tamaño N ; es decir, medimos las alturas de N individuos. De esa única muestra, solo se puede obtener una estimación de la media. Para razonar sobre la población, necesitamos algún sentido de la variabilidad de la media que hemos calculado. El método bootstrap más simple implica tomar el conjunto de datos original de alturas y, utilizando una computadora, muestrear para formar una nueva muestra (llamada "remuestreo" o muestra bootstrap) que también es de tamaño N . La muestra bootstrap se toma de la original utilizando un muestreo con reemplazo (por ejemplo, podríamos "remuestrear" 5 veces de [1,2,3,4,5] y obtener [2,5,4,4,1]), por lo que, asumiendo que N es suficientemente grande, para todos los fines prácticos hay una probabilidad virtualmente cero de que sea idéntica a la muestra "real" original. Este proceso se repite una gran cantidad de veces (normalmente 1.000 o 10.000 veces) y, para cada una de estas muestras bootstrap, calculamos su media (cada una de ellas se denomina "estimación bootstrap"). Ahora podemos crear un histograma de medias bootstrap. Este histograma proporciona una estimación de la forma de la distribución de la media de la muestra a partir de la cual podemos responder preguntas sobre cuánto varía la media entre las muestras. (El método aquí descrito para la media se puede aplicar a casi cualquier otra estadística o estimador ).

Discusión

This section includes a list of references, related reading, or external links, but its sources remain unclear because it lacks inline citations. (June 2012) |

Ventajas

Una gran ventaja del bootstrap es su simplicidad. Es una forma directa de derivar estimaciones de errores estándar e intervalos de confianza para estimadores complejos de la distribución, como puntos de percentiles, proporciones, Odds ratio y coeficientes de correlación. Sin embargo, a pesar de su simplicidad, el bootstrap se puede aplicar a diseños de muestreo complejos (por ejemplo, para una población dividida en s estratos con n s observaciones por estrato, el bootstrap se puede aplicar para cada estrato). [15] El bootstrap también es una forma adecuada de controlar y comprobar la estabilidad de los resultados. Aunque para la mayoría de los problemas es imposible conocer el verdadero intervalo de confianza, el bootstrap es asintóticamente más preciso que los intervalos estándar obtenidos utilizando la varianza de la muestra y los supuestos de normalidad. [16] El bootstrap también es un método conveniente que evita el costo de repetir el experimento para obtener otros grupos de datos de muestra.

Desventajas

El bootstrapping depende en gran medida del estimador utilizado y, aunque es simple, su uso ingenuo no siempre arrojará resultados asintóticamente válidos y puede conducir a inconsistencias. [17] Aunque el bootstrapping es (bajo ciertas condiciones) asintóticamente consistente , no proporciona garantías generales para muestras finitas. El resultado puede depender de la muestra representativa. La aparente simplicidad puede ocultar el hecho de que se están haciendo suposiciones importantes al realizar el análisis bootstrap (por ejemplo, independencia de las muestras o un tamaño de muestra lo suficientemente grande) cuando estas se enunciarían de manera más formal en otros enfoques. Además, el bootstrapping puede llevar mucho tiempo y no hay mucho software disponible para el bootstrapping, ya que es difícil automatizarlo utilizando paquetes informáticos estadísticos tradicionales. [15]

Recomendaciones

Los investigadores han recomendado que se utilicen más muestras de bootstrap a medida que aumenta la capacidad de cómputo disponible. Si los resultados pueden tener consecuencias sustanciales en el mundo real, entonces se deben utilizar tantas muestras como sea razonable, dada la capacidad de cómputo y el tiempo disponibles. Aumentar el número de muestras no puede aumentar la cantidad de información en los datos originales; solo puede reducir los efectos de los errores de muestreo aleatorios que pueden surgir del propio procedimiento de bootstrap. Además, hay evidencia de que un número de muestras mayor que 100 conduce a mejoras insignificantes en la estimación de los errores estándar. [18] De hecho, según el desarrollador original del método de bootstrap, incluso fijar el número de muestras en 50 es probable que conduzca a estimaciones de error estándar bastante buenas. [19]

Adèr et al. recomiendan el procedimiento bootstrap para las siguientes situaciones: [20]

- Cuando la distribución teórica de una estadística de interés es complicada o desconocida, dado que el procedimiento de bootstrap es independiente de la distribución, proporciona un método indirecto para evaluar las propiedades de la distribución subyacente a la muestra y los parámetros de interés que se derivan de esta distribución.

- Cuando el tamaño de la muestra es insuficiente para realizar una inferencia estadística directa. Si la distribución subyacente es bien conocida, el método bootstrap proporciona una manera de tener en cuenta las distorsiones causadas por la muestra específica que puede no ser totalmente representativa de la población.

- Cuando se deben realizar cálculos de potencia y se dispone de una pequeña muestra piloto, la mayoría de los cálculos de potencia y tamaño de muestra dependen en gran medida de la desviación estándar de la estadística de interés. Si la estimación utilizada es incorrecta, el tamaño de muestra requerido también será incorrecto. Un método para obtener una impresión de la variación de la estadística es utilizar una pequeña muestra piloto y realizar un análisis de arranque sobre ella para obtener una impresión de la varianza.

Sin embargo, Athreya ha demostrado [21] que si se realiza un bootstrap ingenuo sobre la media de la muestra cuando la población subyacente carece de una varianza finita (por ejemplo, una distribución de ley de potencia ), entonces la distribución bootstrap no convergerá al mismo límite que la media de la muestra. Como resultado, los intervalos de confianza basados en una simulación de Monte Carlo del bootstrap podrían ser engañosos. Athreya afirma que "A menos que uno esté razonablemente seguro de que la distribución subyacente no tiene cola pesada , uno debería dudar en utilizar el bootstrap ingenuo".

Tipos de esquema bootstrap

This section includes a list of references, related reading, or external links, but its sources remain unclear because it lacks inline citations. (June 2012) |

En problemas univariados, suele ser aceptable volver a muestrear las observaciones individuales con reemplazo ("remuestreo de casos" a continuación), a diferencia del submuestreo , en el que el remuestreo se realiza sin reemplazo y es válido en condiciones mucho más débiles en comparación con el bootstrap. En muestras pequeñas, puede ser preferible un enfoque bootstrap paramétrico. Para otros problemas, probablemente se prefiera un bootstrap suave .

Para los problemas de regresión, existen otras alternativas disponibles. [2]

Remuestreo de casos

El método bootstrap es generalmente útil para estimar la distribución de una estadística (por ejemplo, media, varianza) sin utilizar supuestos de normalidad (como se requiere, por ejemplo, para una estadística z o una estadística t). En particular, el método bootstrap es útil cuando no hay una forma analítica o una teoría asintótica (por ejemplo, un teorema del límite central aplicable ) para ayudar a estimar la distribución de las estadísticas de interés. Esto se debe a que los métodos bootstrap pueden aplicarse a la mayoría de las cantidades aleatorias, por ejemplo, la relación entre la varianza y la media. Hay al menos dos formas de realizar el remuestreo de casos.

- El algoritmo de Monte Carlo para el remuestreo de casos es bastante simple. Primero, remuestreamos los datos con reemplazo, y el tamaño del remuestreo debe ser igual al tamaño del conjunto de datos original. Luego, se calcula la estadística de interés a partir del remuestreo del primer paso. Repetimos esta rutina muchas veces para obtener una estimación más precisa de la distribución Bootstrap del estadístico. [2]

- La versión "exacta" para el remuestreo de casos es similar, pero enumeramos exhaustivamente cada posible remuestreo del conjunto de datos. Esto puede ser computacionalmente costoso ya que hay un total de remuestreos diferentes, donde n es el tamaño del conjunto de datos. Por lo tanto, para n = 5, 10, 20, 30 hay 126, 92378, 6,89 × 10 10 y 5,91 × 10 16 remuestreos diferentes respectivamente. [22]

Estimación de la distribución de la media de la muestra

Consideremos un experimento de lanzamiento de moneda. Lanzamos la moneda y registramos si cae cara o cruz. Sea X = x 1 , x 2 , …, x 10 10 observaciones del experimento. x i = 1 si el i-ésimo lanzamiento cae cara, y 0 en caso contrario. Invocando el supuesto de que el promedio de los lanzamientos de moneda se distribuye normalmente, podemos usar la estadística t para estimar la distribución de la media de la muestra,

Este supuesto de normalidad se puede justificar como una aproximación de la distribución de cada lanzamiento de moneda individual o como una aproximación de la distribución del promedio de un gran número de lanzamientos de moneda. La primera es una aproximación deficiente porque la distribución real de los lanzamientos de moneda es Bernoulli en lugar de normal. La segunda es una aproximación válida en muestras infinitamente grandes debido al teorema del límite central .

Sin embargo, si no estamos listos para hacer tal justificación, entonces podemos usar el bootstrap en su lugar. Usando el remuestreo de casos, podemos derivar la distribución de . Primero remuestreamos los datos para obtener un remuestreo bootstrap . Un ejemplo del primer remuestreo podría verse así X 1 * = x 2 , x 1 , x 10 , x 10 , x 3 , x 4 , x 6 , x 7 , x 1 , x 9 . Hay algunos duplicados ya que un remuestreo bootstrap proviene del muestreo con reemplazo de los datos. También el número de puntos de datos en un remuestreo bootstrap es igual al número de puntos de datos en nuestras observaciones originales. Luego calculamos la media de este remuestreo y obtenemos la primera media bootstrap : μ 1 *. Repetimos este proceso para obtener el segundo remuestreo X 2 * y calculamos la segunda media bootstrap μ 2 *. Si repetimos esto 100 veces, entonces tenemos μ 1 *, μ 2 *, ..., μ 100 *. Esto representa una distribución bootstrap empírica de la media de la muestra. A partir de esta distribución empírica, se puede derivar un intervalo de confianza bootstrap con el propósito de probar hipótesis.

Regresión

En los problemas de regresión, el remuestreo de casos se refiere al esquema simple de remuestreo de casos individuales, a menudo filas de un conjunto de datos . Para los problemas de regresión, siempre que el conjunto de datos sea bastante grande, este esquema simple suele ser aceptable. [ cita requerida ] Sin embargo, el método está abierto a críticas [ cita requerida ] . [15]

En los problemas de regresión, las variables explicativas suelen ser fijas o, al menos, se observan con más control que la variable de respuesta. Además, el rango de las variables explicativas define la información disponible a partir de ellas. Por lo tanto, volver a muestrear los casos significa que cada muestra de bootstrap perderá algo de información. Por lo tanto, se deben considerar procedimientos de bootstrap alternativos.

Bootstrap bayesiano

El bootstrapping se puede interpretar en un marco bayesiano utilizando un esquema que crea nuevos conjuntos de datos a través de la reponderación de los datos iniciales. Dado un conjunto de puntos de datos, la ponderación asignada al punto de datos en un nuevo conjunto de datos es , donde es una lista ordenada de menor a mayor de números aleatorios distribuidos uniformemente en , precedida por 0 y seguida por 1. Las distribuciones de un parámetro inferidas a partir de la consideración de muchos de esos conjuntos de datos son entonces interpretables como distribuciones posteriores en ese parámetro. [23]

Arranque suave

En este esquema, se añade una pequeña cantidad de ruido aleatorio centrado en cero (generalmente distribuido normalmente) a cada observación remuestreada. Esto es equivalente a muestrear a partir de una estimación de densidad kernel de los datos. Supongamos que K es una función de densidad kernel simétrica con varianza unitaria. El estimador kernel estándar de es

- [24]

donde es el parámetro de suavizado. Y el estimador de la función de distribución correspondiente es

- [24]

Arranque paramétrico

Partiendo del supuesto de que el conjunto de datos original es una realización de una muestra aleatoria de una distribución de un tipo paramétrico específico, en este caso se ajusta un modelo paramétrico por el parámetro θ, a menudo por máxima verosimilitud , y se extraen muestras de números aleatorios de este modelo ajustado. Normalmente, la muestra extraída tiene el mismo tamaño de muestra que los datos originales. Entonces, la estimación de la función original F se puede escribir como . Este proceso de muestreo se repite muchas veces como para otros métodos bootstrap. Considerando la media de la muestra centrada en este caso, la función de distribución original de la muestra aleatoria se sustituye por una muestra aleatoria bootstrap con función , y la distribución de probabilidad de se aproxima por la de , donde , que es la expectativa correspondiente a . [25] El uso de un modelo paramétrico en la etapa de muestreo de la metodología bootstrap conduce a procedimientos que son diferentes de los obtenidos mediante la aplicación de la teoría estadística básica a la inferencia para el mismo modelo.

Remuestreo de residuos

Otro enfoque para el bootstrap en problemas de regresión es remuestrear los residuos . El método se desarrolla de la siguiente manera.

- Ajuste el modelo y conserve los valores ajustados y los residuos .

- Para cada par, ( x i , y i ), en el que x i es la variable explicativa (posiblemente multivariada), agregue un residuo remuestreado aleatoriamente, , al valor ajustado . En otras palabras, cree variables de respuesta sintéticas donde j se selecciona aleatoriamente de la lista (1, ..., n ) para cada i .

- Reajuste el modelo utilizando las variables de respuesta ficticias y conserve las cantidades de interés (a menudo los parámetros, , estimados a partir de la ).

- Repita los pasos 2 y 3 un gran número de veces.

Este esquema tiene la ventaja de que conserva la información de las variables explicativas. Sin embargo, surge la pregunta de qué residuos se deben volver a muestrear. Los residuos brutos son una opción; otra son los residuos estudentizados (en la regresión lineal). Aunque existen argumentos a favor del uso de residuos estudentizados, en la práctica, a menudo hay poca diferencia y es fácil comparar los resultados de ambos esquemas.

Regresión del proceso gaussiano bootstrap

Cuando los datos están correlacionados temporalmente, el método bootstrap directo destruye las correlaciones inherentes. Este método utiliza la regresión de proceso gaussiano (GPR) para ajustar un modelo probabilístico del que luego se pueden extraer réplicas. GPR es un método de regresión no lineal bayesiano. Un proceso gaussiano (GP) es una colección de variables aleatorias, cualquier número finito de las cuales tiene una distribución gaussiana (normal) conjunta. Un GP se define por una función media y una función de covarianza, que especifican los vectores de media y las matrices de covarianza para cada colección finita de las variables aleatorias. [26]

Modelo de regresión:

- es un término de ruido.

Proceso gaussiano previo:

Para cualquier colección finita de variables, x 1 , ..., x n , las salidas de la función se distribuyen conjuntamente de acuerdo con una gaussiana multivariada con matriz de media y covarianza.

Supongamos entonces que ,

donde , y es la función delta de Kronecker estándar. [26]

Proceso gaussiano posterior:

Según el médico de cabecera, podemos conseguir

- ,

donde y

Sea x 1 * ,...,x s * otra colección finita de variables, es obvio que

- ,

dónde , ,

De acuerdo con las ecuaciones anteriores, las salidas y también se distribuyen conjuntamente según una gaussiana multivariante. Por lo tanto,

donde , , , y es la matriz identidad. [26]

Arranque salvaje

El bootstrap salvaje, propuesto originalmente por Wu (1986), [27] es adecuado cuando el modelo exhibe heterocedasticidad . La idea es, como el bootstrap residual, dejar los regresores en su valor de muestra, pero volver a muestrear la variable de respuesta en función de los valores residuales. Es decir, para cada réplica, se calcula una nueva en función de

Por lo tanto, los residuos se multiplican aleatoriamente por una variable aleatoria con media 0 y varianza 1. Para la mayoría de las distribuciones de (pero no para Mammen), este método supone que la distribución residual "real" es simétrica y puede ofrecer ventajas sobre el muestreo residual simple para tamaños de muestra más pequeños. Se utilizan diferentes formas para la variable aleatoria , como

- Una distribución sugerida por Mammen (1993). [28]

- Aproximadamente la distribución de Mammen es:

- O la distribución más simple, vinculada a la distribución de Rademacher :

Bloque de arranque

El bootstrap de bloques se utiliza cuando los datos, o los errores de un modelo, están correlacionados. En este caso, un simple remuestreo de caso o residual fallará, ya que no es capaz de replicar la correlación en los datos. El bootstrap de bloques intenta replicar la correlación mediante el remuestreo dentro de bloques de datos (consulte Bloqueo (estadísticas) ). El bootstrap de bloques se ha utilizado principalmente con datos correlacionados en el tiempo (es decir, series temporales), pero también se puede utilizar con datos correlacionados en el espacio o entre grupos (los llamados datos de clúster).

Serie temporal: Arranque de bloque simple

En el arranque en bloques (simple), la variable de interés se divide en bloques que no se superponen.

Serie temporal: Bloque móvil bootstrap

En el bootstrap de bloques móviles, introducido por Künsch (1989), [29] los datos se dividen en n − b + 1 bloques superpuestos de longitud b : la observación 1 a b será el bloque 1, la observación 2 a b + 1 será el bloque 2, etc. Luego, de estos n − b + 1 bloques, se extraerán n / b bloques al azar con reemplazo. Luego, alineando estos n/b bloques en el orden en que fueron seleccionados, se obtendrán las observaciones bootstrap.

Este método bootstrap funciona con datos dependientes, sin embargo, las observaciones bootstrap ya no serán estacionarias por construcción. Sin embargo, se demostró que variar aleatoriamente la longitud del bloque puede evitar este problema. [30] Este método se conoce como bootstrap estacionario. Otras modificaciones relacionadas con el bootstrap de bloque móvil son el bootstrap markoviano y un método bootstrap estacionario que empareja bloques subsiguientes en función de la desviación estándar.

Series temporales: Bootstrap de máxima entropía

Vinod (2006), [31] presenta un método que utiliza el método bootstrap para series temporales de datos utilizando principios de máxima entropía que satisfacen el teorema ergódico con restricciones que preservan la media y la masa. Existe un paquete R, meboot , [32] que utiliza el método, que tiene aplicaciones en econometría y ciencias de la computación.

Datos del clúster: arranque de bloques

Los datos de conglomerados describen datos en los que se observan muchas observaciones por unidad. Esto podría ser observar muchas empresas en muchos estados o observar a estudiantes en muchas clases. En tales casos, la estructura de correlación se simplifica y, por lo general, se supone que los datos están correlacionados dentro de un grupo/conglomerado, pero que son independientes entre grupos/conglomerados. La estructura del bootstrap de bloques se obtiene fácilmente (donde el bloque solo corresponde al grupo) y, por lo general, solo se vuelven a muestrear los grupos, mientras que las observaciones dentro de los grupos se dejan sin cambios. Cameron et al. (2008) analizan esto para los errores agrupados en la regresión lineal. [33]

Métodos para mejorar la eficiencia computacional

El bootstrap es una técnica potente, aunque puede requerir recursos de computación sustanciales, tanto en tiempo como en memoria. Se han desarrollado algunas técnicas para reducir esta carga. Por lo general, se pueden combinar con muchos de los diferentes tipos de esquemas Bootstrap y con varias opciones de estadísticas.

Procesamiento paralelo

La mayoría de los métodos bootstrap son algoritmos vergonzosamente paralelos . Es decir, la estadística de interés para cada muestra bootstrap no depende de otras muestras bootstrap. Por lo tanto, dichos cálculos se pueden realizar en CPU o nodos de cómputo separados y los resultados de los nodos separados se agregan finalmente para el análisis final.

Arranque de Poisson

El método bootstrap no paramétrico toma elementos de una lista de tamaño n con recuentos extraídos de una distribución multinomial . Si denota la cantidad de veces que se incluye el elemento i en una muestra bootstrap dada, entonces cada uno se distribuye como una distribución binomial con n ensayos y media 1, pero no es independiente de para .

En cambio, el bootstrap de Poisson extrae muestras asumiendo que todos los s se distribuyen de manera independiente e idéntica como variables de Poisson con media 1. La razón es que el límite de la distribución binomial es Poisson:

Hanley y MacGibbon propusieron el bootstrap de Poisson como potencialmente útil para quienes no son estadísticos y utilizan software como SAS y SPSS , que carecían de los paquetes bootstrap de los lenguajes de programación R y S-Plus . [34] Los mismos autores informan que para un valor n suficientemente grande, los resultados son relativamente similares a las estimaciones bootstrap no paramétricas, pero continúan señalando que el bootstrap de Poisson ha tenido un uso mínimo en las aplicaciones.

Otra ventaja propuesta del bootstrap de Poisson es la independencia del método, lo que hace que sea más fácil aplicarlo a grandes conjuntos de datos que deben procesarse como flujos. [35]

Una forma de mejorar el método bootstrap de Poisson, denominado "bootstrap secuencial", es tomar las primeras muestras de modo que la proporción de valores únicos sea ≈0,632 del tamaño de la muestra original n. Esto proporciona una distribución con características empíricas principales dentro de una distancia de . [36] La investigación empírica ha demostrado que este método puede producir buenos resultados. [37] Esto está relacionado con el método bootstrap reducido. [38]

Bolsa de pequeñas botas

En el caso de conjuntos de datos masivos, suele resultar prohibitivo desde el punto de vista computacional mantener todos los datos de muestra en la memoria y volver a muestrear a partir de ellos. El método Bag of Little Bootstraps (BLB) [39] proporciona un método de preagregación de datos antes del bootstrap para reducir las limitaciones computacionales. Esto funciona dividiendo el conjunto de datos en compartimentos de igual tamaño y agregando los datos dentro de cada compartimento. Este conjunto de datos preagregados se convierte en los nuevos datos de muestra sobre los que se extraen muestras con reemplazo. Este método es similar al método Block Bootstrap, pero las motivaciones y definiciones de los bloques son muy diferentes. Bajo ciertas suposiciones, la distribución de la muestra debería aproximarse al escenario de bootstrap completo. Una restricción es el número de compartimentos donde y los autores recomiendan el uso de como solución general.

Elección de la estadística

La distribución bootstrap de un estimador puntual de un parámetro de población se ha utilizado para producir un intervalo de confianza bootstrap para el valor verdadero del parámetro si el parámetro puede escribirse como una función de la distribución de la población .

Los parámetros de población se estiman con muchos estimadores puntuales . Las familias populares de estimadores puntuales incluyen estimadores de varianza mínima sin sesgo de media , estimadores sin sesgo de mediana , estimadores bayesianos (por ejemplo, la moda , la mediana y la media de la distribución posterior ) y estimadores de máxima verosimilitud .

Según la teoría asintótica, un estimador puntual bayesiano y un estimador de máxima verosimilitud tienen un buen rendimiento cuando el tamaño de la muestra es infinito. Para problemas prácticos con muestras finitas, pueden ser preferibles otros estimadores. La teoría asintótica sugiere técnicas que a menudo mejoran el rendimiento de los estimadores bootstrap; el bootstrap de un estimador de máxima verosimilitud a menudo puede mejorarse utilizando transformaciones relacionadas con cantidades fundamentales . [40]

Derivación de intervalos de confianza a partir de la distribución bootstrap

La distribución bootstrap de un estimador de parámetros se utiliza a menudo para calcular intervalos de confianza para su parámetro poblacional. [2] Se han propuesto diversos métodos para construir los intervalos de confianza, aunque no hay acuerdo sobre cuál es el mejor.

Propiedades deseables

El estudio de los métodos de intervalo de confianza bootstrap de DiCiccio y Efron y la consiguiente discusión enumeran varias propiedades deseadas de los intervalos de confianza, que generalmente no se cumplen todas simultáneamente.

- Invariante de transformación : los intervalos de confianza obtenidos al realizar un bootstrap de los datos transformados (por ejemplo, tomando el logaritmo) idealmente serían los mismos que los obtenidos al transformar los intervalos de confianza obtenidos al realizar un bootstrap de los datos no transformados.

- Los intervalos de confianza deben ser válidos o consistentes , es decir, la probabilidad de que un parámetro esté en un intervalo de confianza con nivel nominal debe ser igual a o al menos converger en probabilidad a . El último criterio se refina y se amplía utilizando el marco de Hall. [41] Los refinamientos son para distinguir entre métodos basados en qué tan rápido la probabilidad de cobertura real se acerca al valor nominal, donde un método es (usando la terminología de DiCiccio y Efron) preciso de primer orden si el término de error en la aproximación es y preciso de segundo orden si el término de error es . Además, los métodos se distinguen por la velocidad con la que el punto crítico bootstrap estimado converge al punto verdadero (desconocido), y un método es correcto de segundo orden cuando esta tasa es .

- Gleser, en la discusión del artículo, sostiene que una limitación de las descripciones asintóticas del punto anterior es que los términos no son necesariamente uniformes en los parámetros o la distribución real.

Sesgo, asimetría e intervalos de confianza

- Sesgo : la distribución bootstrap y la muestra pueden discrepar sistemáticamente, en cuyo caso puede producirse sesgo .

- Si la distribución bootstrap de un estimador es simétrica, entonces se suelen utilizar intervalos de confianza de percentiles; dichos intervalos son apropiados especialmente para estimadores medianamente insesgados de riesgo mínimo (con respecto a una función de pérdida absoluta ). El sesgo en la distribución bootstrap conducirá a un sesgo en el intervalo de confianza.

- De lo contrario, si la distribución bootstrap no es simétrica, los intervalos de confianza de percentiles suelen ser inapropiados.

Métodos para intervalos de confianza bootstrap

Existen varios métodos para construir intervalos de confianza a partir de la distribución bootstrap de un parámetro real :

- Bootstrap básico , [40] también conocido como intervalo percentil inverso . [42] El bootstrap básico es un esquema simple para construir el intervalo de confianza: uno simplemente toma los cuantiles empíricos de la distribución bootstrap del parámetro (ver Davison y Hinkley 1997, equ. 5.6 p. 194):

- donde denota el percentil de los coeficientes bootstrap .

- Bootstrap de percentiles . El bootstrap de percentiles se ejecuta de manera similar al bootstrap básico, utilizando percentiles de la distribución bootstrap, pero con una fórmula diferente (nótese la inversión de los cuantiles izquierdo y derecho):

- donde denota el percentil de los coeficientes bootstrap .

- Véase Davison y Hinkley (1997, equ. 5.18 p. 203) y Efron y Tibshirani (1993, equ. 13.5 p. 171).

- Este método se puede aplicar a cualquier estadística. Funcionará bien en casos donde la distribución bootstrap es simétrica y centrada en la estadística observada [43] y donde la estadística de muestra es medianamente imparcial y tiene máxima concentración (o mínimo riesgo con respecto a una función de pérdida de valor absoluto). Cuando se trabaja con tamaños de muestra pequeños (es decir, menos de 50), los intervalos de confianza percentil básicos/inversos y percentiles para (por ejemplo) la estadística de varianza serán demasiado estrechos. De modo que con una muestra de 20 puntos, el intervalo de confianza del 90% incluirá la varianza verdadera solo el 78% del tiempo. [44] Los intervalos de confianza percentil básicos/inversos son más fáciles de justificar matemáticamente [45] [42] pero son menos precisos en general que los intervalos de confianza percentil, y algunos autores desaconsejan su uso. [42]

- Bootstrap estudentizado . El bootstrap estudentizado, también llamado bootstrap-t , se calcula de forma análoga al intervalo de confianza estándar, pero reemplaza los cuantiles de la aproximación normal o de Student por los cuantiles de la distribución bootstrap de la prueba t de Student (véase Davison y Hinkley 1997, ecu. 5.7 p. 194 y Efron y Tibshirani 1993 ecu. 12.22, p. 160):

- donde denota el percentil de la prueba t de Student bootstrap , y es el error estándar estimado del coeficiente en el modelo original.

- La prueba estudentizada disfruta de propiedades óptimas ya que la estadística que se utiliza para el bootstrap es fundamental (es decir, no depende de parámetros molestos ya que la prueba t sigue asintóticamente una distribución N(0,1)), a diferencia del bootstrap de percentiles.

- Bootstrap con corrección de sesgo : ajusta el sesgo en la distribución bootstrap.

- Bootstrap acelerado : el bootstrap acelerado y con corrección de sesgo (BCa), de Efron (1987), [12] ajusta tanto el sesgo como la asimetría en la distribución bootstrap. Este enfoque es preciso en una amplia variedad de entornos, tiene requisitos de cálculo razonables y produce intervalos razonablemente estrechos. [12]

Prueba de hipótesis bootstrap

This article may require cleanup to meet Wikipedia's quality standards. The specific problem is: there are other bootstrap tests. (July 2023) |

Efron y Tibshirani [2] sugieren el siguiente algoritmo para comparar las medias de dos muestras independientes: Sea una muestra aleatoria de la distribución F con media muestral y varianza muestral . Sea otra muestra aleatoria independiente de la distribución G con media y varianza

- Calcular la estadística de prueba

- Cree dos nuevos conjuntos de datos cuyos valores sean y donde es la media de la muestra combinada.

- Extraiga una muestra aleatoria ( ) de tamaño con reemplazo de y otra muestra aleatoria ( ) de tamaño con reemplazo de .

- Calcular la estadística de prueba

- Repita 3 y 4 veces (por ejemplo ) para recopilar valores de la estadística de prueba.

- Estime el valor p como donde cuando la condición es verdadera y 0 en caso contrario.

Ejemplos de aplicaciones

This section includes a list of references, related reading, or external links, but its sources remain unclear because it lacks inline citations. (June 2012) |

Arranque suavizado

En 1878, Simon Newcomb realizó observaciones sobre la velocidad de la luz . [46] El conjunto de datos contiene dos valores atípicos , que influyen en gran medida en la media de la muestra . (La media de la muestra no necesita ser un estimador consistente para ninguna media de la población , porque no es necesario que exista ninguna media para una distribución de cola pesada ). Una estadística bien definida y robusta para la tendencia central es la mediana de la muestra, que es consistente y no tiene sesgo de mediana para la mediana de la población.

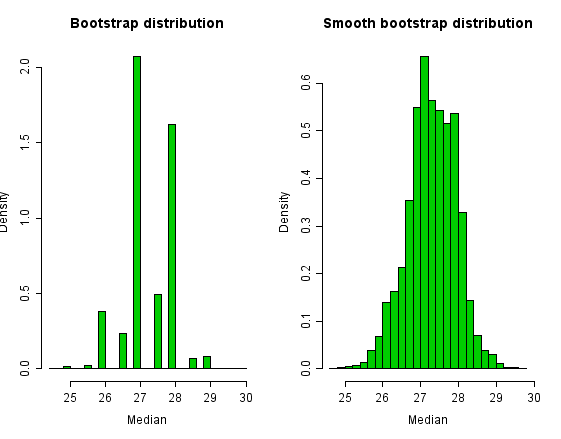

La distribución bootstrap para los datos de Newcomb aparece a continuación. Podemos reducir la discreción de la distribución bootstrap añadiendo una pequeña cantidad de ruido aleatorio a cada muestra bootstrap. Una opción convencional es añadir ruido con una desviación estándar de para un tamaño de muestra n ; este ruido se suele extraer de una distribución t de Student con n-1 grados de libertad. [47] Esto da como resultado un estimador aproximadamente insesgado para la varianza de la media de la muestra. [48] Esto significa que las muestras tomadas de la distribución bootstrap tendrán una varianza que es, en promedio, igual a la varianza de la población total.

A continuación se muestran los histogramas de la distribución bootstrap y de la distribución bootstrap suavizada. La distribución bootstrap de la mediana de la muestra tiene solo una pequeña cantidad de valores. La distribución bootstrap suavizada tiene un soporte más rico . Sin embargo, tenga en cuenta que si el procedimiento bootstrap suavizado o estándar es favorable es un caso por caso y se muestra que depende tanto de la función de distribución subyacente como de la cantidad que se estima. [49]

En este ejemplo, el intervalo de confianza del 95 % (percentil) bootstrap para la mediana de la población es (26, 28,5), que está cerca del intervalo de (25,98, 28,46) para el bootstrap suavizado.

Relación con otros enfoques de inferencia

Relación con otros métodos de remuestreo

El bootstrap se distingue de:

- el procedimiento jackknife , utilizado para estimar sesgos en las estadísticas de muestra y para estimar varianzas, y

- validación cruzada , en la que los parámetros (por ejemplo, pesos de regresión, cargas factoriales) que se estiman en una submuestra se aplican a otra submuestra.

Para obtener más detalles, consulte remuestreo .

La agregación bootstrap (bagging) es un metaalgoritmo basado en promediar las predicciones del modelo obtenidas a partir de modelos entrenados en múltiples muestras bootstrap.

Estadísticas U

En situaciones en las que se puede idear una estadística obvia para medir una característica requerida utilizando solo un pequeño número, r , de elementos de datos, se puede formular una estadística correspondiente basada en la muestra completa. Dado un estadístico de r muestras, se puede crear un estadístico de n muestras mediante algo similar al bootstrap (tomando el promedio del estadístico sobre todas las submuestras de tamaño r ). Se sabe que este procedimiento tiene ciertas buenas propiedades y el resultado es un estadístico U . La media y la varianza de la muestra tienen esta forma, para r = 1 y r = 2.

Teoría asintótica

El método bootstrap tiene, en determinadas condiciones, propiedades asintóticas deseables . Las propiedades asintóticas descritas con más frecuencia son la convergencia débil/consistencia de las trayectorias de muestra del proceso empírico bootstrap y la validez de los intervalos de confianza derivados del método bootstrap. Esta sección describe la convergencia del método bootstrap empírico.

Convergencia estocástica

Este párrafo resume descripciones más completas de la convergencia estocástica en van der Vaart y Wellner [50] y Kosorok. [51] El bootstrap define un proceso estocástico , una colección de variables aleatorias indexadas por algún conjunto , donde es típicamente la línea real ( ) o una familia de funciones. Los procesos de interés son aquellos con caminos de muestra acotados, es decir, caminos de muestra en L-infinito ( ), el conjunto de todas las funciones uniformemente acotadas de a . Cuando está equipado con la distancia uniforme, es un espacio métrico , y cuando , dos subespacios de son de particular interés, , el espacio de todas las funciones continuas de al intervalo unitario [0,1], y , el espacio de todas las funciones cadlag de a [0,1]. Esto se debe a que contiene las funciones de distribución para todas las variables aleatorias continuas, y contiene las funciones de distribución para todas las variables aleatorias. Las afirmaciones sobre la consistencia del bootstrap son afirmaciones sobre la convergencia de las trayectorias de muestra del proceso bootstrap como elementos aleatorios del espacio métrico o algún subespacio del mismo, especialmente o .

Consistencia

Horowitz en una revisión reciente [1] define la consistencia como: el estimador bootstrap es consistente [para una estadística ] si, para cada , converge en probabilidad a 0 como , donde es la distribución de la estadística de interés en la muestra original, es la distribución verdadera pero desconocida de la estadística, es la función de distribución asintótica de , y es la variable de indexación en la función de distribución, es decir, . Esto a veces se llama más específicamente consistencia relativa a la distancia de Kolmogorov-Smirnov . [52]

Horowitz continúa recomendando utilizar un teorema de Mammen [53] que proporciona condiciones necesarias y suficientes para la consistencia de las estadísticas de una determinada forma común de manera más fácil de comprobar. En particular, sea la muestra aleatoria. Si para una secuencia de números y , entonces la estimación bootstrap de la función de distribución acumulativa estima la función de distribución acumulativa empírica si y solo si converge en la distribución a la distribución normal estándar .

Fuerte consistencia

La convergencia en probabilidad (externa) como se describió anteriormente también se llama consistencia débil . También se puede demostrar con suposiciones ligeramente más fuertes, que el bootstrap es fuertemente consistente , donde la convergencia en probabilidad (externa) se reemplaza por convergencia (externa) casi con seguridad. Cuando solo se describe un tipo de consistencia, normalmente es consistencia débil. Esto es adecuado para la mayoría de las aplicaciones estadísticas ya que implica que las bandas de confianza derivadas del bootstrap son asintóticamente válidas. [51]

Demostrando consistencia utilizando el teorema del límite central

En casos más simples, es posible utilizar directamente el teorema del límite central para demostrar la consistencia del procedimiento bootstrap para estimar la distribución de la media de la muestra.

En concreto, consideremos variables aleatorias independientes distribuidas de forma idéntica con y para cada . Sea . Además, para cada , condicional a , sean variables aleatorias independientes con distribución igual a la distribución empírica de . Esta es la secuencia de muestras bootstrap.

Luego se puede demostrar que donde representa la probabilidad condicional a , , , y .

Para ver esto, note que satisface la condición de Lindeberg , por lo que se cumple el TCL. [54]

El teorema de Glivenko-Cantelli proporciona una base teórica para el método bootstrap.

Véase también

- Precisión y exactitud

- Agregación de Bootstrap

- Arranque

- Probabilidad empírica

- Imputación (estadísticas)

- Confiabilidad (estadísticas)

- Reproducibilidad

- Remuestreo

Referencias

- ^ abc Horowitz JL (2019). "Métodos bootstrap en econometría". Revista Anual de Economía . 11 : 193–224. arXiv : 1809.04016 . doi : 10.1146/annurev-economics-080218-025651 .

- ^ abcde Efron B , Tibshirani R (1993). Una introducción a Bootstrap . Boca Ratón, FL: Chapman & Hall/CRC. ISBN 0-412-04231-2.software Archivado el 12 de julio de 2012 en archive.today

- ^ Efron B (2003). "Segundas reflexiones sobre el bootstrap" (PDF) . Statistical Science . 18 (2): 135–140.

- ^ abc Efron, B. (1979). "Métodos bootstrap: otra mirada al método jackknife". Anales de estadística . 7 (1): 1–26. doi : 10.1214/aos/1176344552 .

- ^ Lehmann EL (1992) "Introducción a Neyman y Pearson (1933) Sobre el problema de las pruebas más eficientes de hipótesis estadísticas". En: Breakthroughs in Statistics, Volumen 1, (Eds Kotz, S., Johnson, NL), Springer-Verlag. ISBN 0-387-94037-5 (seguido de reimpresión del artículo).

- ^ Quenouille MH . "Pruebas aproximadas de correlación en series temporales". Journal of the Royal Statistical Society, Serie B . 11 (1): 68–84. doi :10.1111/j.2517-6161.1949.tb00023.x.

- ^ Tukey JW . "Sesgo y confianza en muestras no muy grandes". Anales de estadística matemática . 29 : 614.

- ^ Jaeckel L (1972) La navaja infinitesimal. Memorándum MM72-1215-11, Bell Lab

- ^ Bickel PJ , Freedman DA (1981). "Alguna teoría asintótica para el bootstrap". Anales de Estadística . 9 (6): 1196–1217. doi : 10.1214/aos/1176345637 .

- ^ Singh K (1981). "Sobre la precisión asintótica del bootstrap de Efron" . Anales de Estadística . 9 : 1187–1195.

- ^ Rubin DB (1981). "El bootstrap bayesiano". Anales de Estadística . 9 : 130–134. doi : 10.1214/aos/1176345338 .

- ^ abc Efron, B. (1987). "Mejores intervalos de confianza bootstrap". Revista de la Asociación Estadounidense de Estadística . 82 (397). Revista de la Asociación Estadounidense de Estadística, vol. 82, núm. 397: 171–185. doi :10.2307/2289144. JSTOR 2289144.

- ^ DiCiccio T, Efron B (1992). "Intervalos de confianza más precisos en familias exponenciales". Biometrika . 79 (2): 231–245. doi :10.2307/2336835. ISSN 0006-3444. JSTOR 2336835. OCLC 5545447518 . Consultado el 31 de enero de 2024 .

- ^ Good, P. (2006) Métodos de remuestreo. 3.ª ed. Birkhauser.

- ^ abc "21 modelos de regresión bootstrap" (PDF) . Archivado (PDF) del original el 24 de julio de 2015.

- ^ DiCiccio TJ, Efron B (1996). "Intervalos de confianza bootstrap (con discusión)". Ciencia estadística . 11 (3): 189–228. doi : 10.1214/ss/1032280214 .

- ^ Hinkley D (1994). "[Bootstrap: ¿Más que una puñalada en la oscuridad?]: Comentario". Ciencia estadística . 9 (3): 400–403. doi : 10.1214/ss/1177010387 . ISSN 0883-4237.

- ^ Goodhue DL, Lewis W, Thompson W (2012). "¿Tiene PLS ventajas para muestras de tamaño pequeño o datos no normales?". MIS Quarterly . 36 (3): 981–1001. doi :10.2307/41703490. JSTOR 41703490. Apéndice.

- ^ Efron, B., Rogosa, D. y Tibshirani, R. (2004). Métodos de estimación por remuestreo. En NJ Smelser y PB Baltes (Eds.). Enciclopedia internacional de las ciencias sociales y del comportamiento (pp. 13216–13220). Nueva York, NY: Elsevier.

- ^ Adèr, HJ , Mellenbergh GJ y Hand, DJ (2008). Asesoramiento sobre métodos de investigación: el compañero de un consultor . Huizen, Países Bajos: Johannes van Kessel Publishing. ISBN 978-90-79418-01-5 .

- ^ Athreya KB (1987). "Bootstrap de la media en el caso de varianza infinita". Anales de Estadística . 15 (2): 724–731. doi : 10.1214/aos/1176350371 .

- ^ "¿Cuántas muestras de bootstrap diferentes hay? Statweb.stanford.edu". Archivado desde el original el 14 de septiembre de 2019. Consultado el 9 de diciembre de 2019 .

- ^ Rubin, DB (1981). "El bootstrap bayesiano". Anales de Estadística , 9, 130.

- ^ ab WANG, SUOJIN (1995). "Optimización del bootstrap suavizado". Ann. Inst. Statist. Math . 47 : 65–80. doi :10.1007/BF00773412. S2CID 122041565.

- ^ Dekking, Frederik Michel; Kraaikamp, Cornelis; Lopuhaä, Hendrik Paul; Meester, Ludolf Erwin (2005). Una introducción moderna a la probabilidad y la estadística: comprender por qué y cómo . Londres: Springer. ISBN 978-1-85233-896-1.OCLC 262680588 .

- ^ abc Kirk, Paul (2009). "Bootstrapping de regresión de proceso gaussiano: exploración de los efectos de la incertidumbre en datos de evolución temporal". Bioinformática . 25 (10): 1300–1306. doi :10.1093/bioinformatics/btp139. PMC 2677737 . PMID 19289448.

- ^ Wu, CFJ (1986). "Jackknife, bootstrap y otros métodos de remuestreo en el análisis de regresión (con discusiones)" (PDF) . Anales de Estadística . 14 : 1261–1350. doi : 10.1214/aos/1176350142 .

- ^ Mammen, E. (marzo de 1993). "Bootstrap y bootstrap salvaje para modelos lineales de alta dimensión". Anales de Estadística . 21 (1): 255–285. doi : 10.1214/aos/1176349025 .

- ^ Künsch, HR (1989). "El Jackknife y el Bootstrap para observaciones estacionarias generales". Anales de Estadística . 17 (3): 1217–1241. doi : 10.1214/aos/1176347265 .

- ^ Politis, DN; Romano, JP (1994). "El bootstrap estacionario". Revista de la Asociación Estadounidense de Estadística . 89 (428): 1303–1313. doi :10.1080/01621459.1994.10476870. hdl : 10983/25607 .

- ^ Vinod, HD (2006). "Conjuntos de máxima entropía para la inferencia de series temporales en economía". Journal of Asian Economics . 17 (6): 955–978. doi :10.1016/j.asieco.2006.09.001.

- ^ Vinod, Hrishikesh; López-de-Lacalle, Javier (2009). "Bootstrap de máxima entropía para series temporales: el paquete meboot R". Journal of Statistical Software . 29 (5): 1–19. doi : 10.18637/jss.v029.i05 .

- ^ Cameron, AC; Gelbach, JB; Miller, DL (2008). "Mejoras basadas en bootstrap para inferencia con errores agrupados" (PDF) . Review of Economics and Statistics . 90 (3): 414–427. doi :10.1162/rest.90.3.414.

- ^ Hanley JA, MacGibbon B (2006). "Creación de muestras bootstrap no paramétricas utilizando frecuencias de Poisson". Métodos y programas informáticos en biomedicina . 83 (1): 57–62. doi : 10.1016/j.cmpb.2006.04.006 .

- ^ Chamandy N, Muralidharan O, Najmi A, Naidu S (2012). "Estimación de la incertidumbre para flujos de datos masivos" . Consultado el 14 de agosto de 2024 .

- ^ Babu, G. Jogesh; Pathak, P. K; Rao, CR (1999). "Corrección de segundo orden del bootstrap de Poisson". Anales de Estadística . 27 (5): 1666–1683. doi : 10.1214/aos/1017939146 .

- ^ Shoemaker, Owen J.; Pathak, PK (2001). "El bootstrap secuencial: una comparación con el bootstrap regular". Comunicaciones en Estadística - Teoría y Métodos . 30 (8–9): 1661–1674. doi :10.1081/STA-100105691.

- ^ Jiménez-Gamero, María Dolores; Muñoz-García, Joaquín; Pino-Mejías, Rafael (2004). "Bootstrap reducido para la mediana". Estadística Sínica . 14 (4): 1179-1198. JSTOR 24307226.

- ^ Kleiner, A; Talwalkar, A; Sarkar, P; Jordania, MI (2014). "Un arranque escalable para datos masivos". Revista de la Royal Statistical Society, Serie B (Metodología estadística) . 76 (4): 795–816. arXiv : 1112.5016 . doi :10.1111/rssb.12050. ISSN 1369-7412. S2CID 3064206.

- ^ ab Davison, AC ; Hinkley, DV (1997). Métodos bootstrap y su aplicación . Cambridge Series in Statistical and Probabilistic Mathematics. Cambridge University Press. ISBN 0-521-57391-2. software.

- ^ Hall P (1988). "Comparación teórica de intervalos de confianza bootstrap". Anales de Estadística . 16 (3): 927–953. doi : 10.1214/aos/1176350933 . JSTOR 2241604.

- ^ abc Hesterberg, Tim C (2014). "Lo que los profesores deberían saber sobre Bootstrap: remuestreo en el currículo de estadística de pregrado". arXiv : 1411.5279 [stat.OT].

- ^ Efron, B. (1982). El método jackknife, el bootstrap y otros planes de remuestreo . Vol. 38. Monografías CBMS-NSF de la Sociedad de Matemáticas Industriales y Aplicadas. ISBN 0-89871-179-7.

- ^ Scheiner, S. (1998). Diseño y análisis de experimentos ecológicos . CRC Press. ISBN 0412035618.Capítulo 13, pág. 300

- ^ Rice, John. Estadística matemática y análisis de datos (2.ª ed.). pág. 272."Aunque esta ecuación directa de cuantiles de la distribución de muestreo bootstrap con límites de confianza puede parecer inicialmente atractiva, su fundamento es un tanto oscuro".

- ^ Datos de ejemplos en Análisis de datos bayesianos

- ^ Chihara, Laura; Hesterberg, Tim (3 de agosto de 2018). Estadística matemática con remuestreo y R (2.ª ed.). John Wiley & Sons, Inc. doi :10.1002/9781119505969. ISBN 9781119416548.S2CID60138121 .

- ^ Voinov, Vassily [G.]; Nikulin, Mikhail [S.] (1993). Estimadores insesgados y sus aplicaciones. Vol. 1: Caso univariado. Dordrect: Kluwer Academic Publishers. ISBN 0-7923-2382-3.

- ^ Young, GA (julio de 1990). "Bootstraps suavizados alternativos". Revista de la Royal Statistical Society, Serie B (Metodológica) . 52 (3): 477–484. doi :10.1111/j.2517-6161.1990.tb01801.x. ISSN 0035-9246.

- ^ van der Vaart AW , Wellner JA (1996). Convergencia débil y procesos empíricos con aplicaciones a la estadística . Nueva York: Springer Science+Business Media . ISBN 978-1-4757-2547-6.

- ^ ab Kosorok MR (2008). Introducción a los procesos empíricos y la inferencia semiparamétrica . Nueva York: Springer Science+Business Media . ISBN 978-0-387-74977-8.

- ^ van der Vaart AW (1998). Estadística asintótica . Cambridge Series in Statistical and Probabilistic Mathematics. Nueva York: Cambridge University Press . pág. 329. ISBN. 978-0-521-78450-4.

- ^ Mammen E (1992). ¿Cuándo funciona Bootstrap?: resultados y simulaciones asintóticas . Apuntes de clase sobre estadística. Vol. 57. Nueva York: Springer-Verlag . ISBN. 978-0-387-97867-3.

- ^ Gregory, Karl (29 de diciembre de 2023). "Algunos resultados basados en el teorema del límite central de Lindeberg" (PDF) . Consultado el 29 de diciembre de 2023 .

Lectura adicional

- Diaconis P , Efron B (mayo de 1983). «Métodos informáticos intensivos en estadística» (PDF) . Scientific American . 248 (5): 116–130. Bibcode :1983SciAm.248e.116D. doi :10.1038/scientificamerican0583-116. Archivado desde el original (PDF) el 2016-03-13 . Consultado el 2016-01-19 .ciencia popular

- Efron B (1981). "Estimaciones no paramétricas del error estándar: el método jackknife, el método bootstrap y otros métodos". Biometrika . 68 (3): 589–599. doi :10.1093/biomet/68.3.589. JSTOR 2335441.

- Hesterberg T, Moore DS, Monaghan S, Clipson A, Epstein R (2005). "Métodos bootstrap y pruebas de permutación" (PDF) . En David S. Moore , George McCabe (eds.). Introducción a la práctica de la estadística . software. Archivado desde el original (PDF) el 2006-02-15 . Consultado el 2007-03-23 .

- Efron B (1979). "Métodos bootstrap: otra mirada al método jackknife". Anales de estadística . 7 : 1–26. doi : 10.1214/aos/1176344552 .

- Efron B (1982). El Jackknife, el Bootstrap y otros planes de remuestreo . Sociedad de Matemática Industrial y Aplicada, Monografías CBMS-NSF. Vol. 38. Filadelfia, EE. UU.: Sociedad de Matemática Industrial y Aplicada .

- Efron B , Tibshirani RJ (1993). Introducción al software Bootstrap . Monografías sobre estadística y probabilidad aplicada. Vol. 57. Boca Raton, EE. UU.: Chapman & Hall .

- Davison AC, Hinley DV (1997). Métodos bootstrap y su aplicación . Cambridge Series in Statistical and Probabilistic Mathematics. Cambridge: Cambridge University Press . ISBN 9780511802843. software.

- Mooney CZ, Duval RD (1993). Bootstrapping: un enfoque no paramétrico para la inferencia estadística . Serie de artículos de la Universidad Sage sobre aplicaciones cuantitativas en las ciencias sociales. Vol. 07–095. Newbury Park, EE. UU.: Sage .

- Wright D, London K, Field AP (2011). "Uso de la estimación bootstrap y el principio de plug-in para datos de psicología clínica". Revista de psicopatología experimental . 2 (2): 252–270.

- Gong G (1986). "Validación cruzada, el método jackknife y el método bootstrap: estimación del exceso de error en la regresión logística hacia delante". Journal of the American Statistical Association . 81 (393): 108–113. doi :10.1080/01621459.1986.10478245.

- ^ Otros nombres que los colegas de Efron sugirieron para el método "bootstrap" fueron: Navaja Suiza , Hacha de Carne , Swan-Dive , Jack-Rabbit y Escopeta . [4]

![{\estilo de visualización [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\displaystyle m=[m(x_{1}),\ldots ,m(x_{n})]^{\intercal }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1ac3abe6a55b4d0a9df7db10e0c36a58453121a5)

![{\displaystyle [y(x_{1}),\ldots ,y(x_{r})]\sim {\mathcal {N}}(m_{0},K_{0})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a44b791e07518721a4bf8b6b0c3df9a90e24e47e)

![{\displaystyle m_{0}=[m(x_{1}),\ldots ,m(x_{r})]^{\intercal }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a7d40a77e82bd278ecea9d13421f38a71ff88bbf)

![{\displaystyle [y(x_{1}),\ldots ,y(x_{r}),f(x_{1}^{*}),\ldots ,f(x_{s}^{*})]^{\intercal }\sim {\mathcal {N}}({\binom {m_{0}}{m_{*}}}{\begin{pmatrix}K_{0}&K_{*}\\K_{*}^{\intercal }&K_{**}\end{pmatrix}})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0664dc735f8ff5cc3b0f33671b1d0a2bdbb163db)

![{\displaystyle m_{*}=[m(x_{1}^{*}),\ldots ,m(x_{s}^{*})]^{\intercal }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f24edcf8081b605823994e85e6c746c87d75a911)

![{\displaystyle [f(x_{1}^{*}),\ldots ,f(x_{s}^{*})]^{\intercal }\mid ([y(x)]^{\intercal }=y)\sim {\mathcal {N}}(m_{\text{post}},K_{\text{post}}),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8f2dac075f685480962738fefb076bdf3fee90a4)

![{\displaystyle y=[y_{1},...,y_{r}]^{\intercal }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc7e5927b40b3dc44746d2f644d0534278b268da)

![{\displaystyle \gamma \en [0.5,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb6affd7567b75316994441dd287a68607d2c844)

![{\estilo de visualización C[0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e160d783783c799aae07cf78d250747461af0ff9)

![{\estilo de visualización D[0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4d18229131d1ad9cd7cff586ad63243aa6acaae)

![{\displaystyle \mathbb {E}[X_{n1}]=\mu }](https://wikimedia.org/api/rest_v1/media/math/render/svg/16616fa7aae5c68ea292668e1be4b09912511b2b)

![{\displaystyle {\text{Var}}[X_{n1}]=\sigma ^{2}<\infty }](https://wikimedia.org/api/rest_v1/media/math/render/svg/608b3ef8f9245a4ee21895f709c8366fba074e17)