Estabilización de imagen

- inestable

- estabilización óptica basada en lentes

- Estabilización óptica por desplazamiento del sensor

- estabilización digital o electrónica

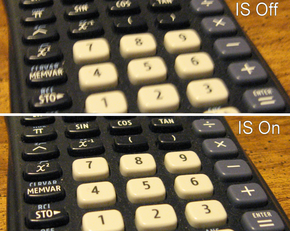

La estabilización de imagen ( IS ) es una familia de técnicas que reducen el desenfoque asociado con el movimiento de una cámara u otro dispositivo de imágenes durante la exposición .

Generalmente, compensa el movimiento horizontal y vertical (movimiento angular, equivalente a guiñada y cabeceo ) del dispositivo de imágenes, aunque la estabilización electrónica de imagen también puede compensar la rotación sobre el eje óptico ( balanceo ). [1] Se utiliza principalmente en binoculares estabilizados de imagen de alta gama , cámaras fijas y de video , telescopios astronómicos y también teléfonos inteligentes . Con cámaras fijas , el movimiento de la cámara es un problema particular a velocidades de obturación lentas o con lentes de distancia focal larga ( telefoto o zoom ). Con cámaras de video , el movimiento de la cámara causa un temblor visible de cuadro a cuadro en el video grabado. En astronomía, el problema del movimiento de la lente se suma a la variación en la atmósfera , que cambia las posiciones aparentes de los objetos con el tiempo.

Aplicación en fotografía fija

En fotografía, la estabilización de imagen puede facilitar velocidades de obturación de 2 a 5,5 pasos más lentas (exposiciones de 4 a 22 pasos) .+Se han reportado velocidades efectivas ( 1 ⁄ 2 veces más largas) e incluso más lentas.

Una regla general para determinar la velocidad de obturación más lenta posible para sostener la cámara con la mano sin que se note un desenfoque debido al movimiento de la cámara es tomar el recíproco de la distancia focal equivalente de 35 mm del objetivo, también conocida como la "regla de 1/mm" [a] . Por ejemplo, con una distancia focal de 125 mm en una cámara de 35 mm, la vibración o el movimiento de la cámara podrían afectar la nitidez si la velocidad de obturación es inferior a 1 ⁄ 125 segundos. Como resultado de las velocidades de obturación de 2 a 4,5 pasos más lentas permitidas por el IS, una imagen tomada a una velocidad de 1 ⁄ 125 segundos con un objetivo normal podría tomarse a 1 ⁄ 15 o 1 ⁄ 8 segundos con un objetivo equipado con IS y producir casi la misma calidad. La nitidez que se puede obtener a una velocidad determinada puede aumentar drásticamente. [3] Al calcular la distancia focal efectiva, es importante tener en cuenta el formato de imagen que utiliza una cámara. Por ejemplo, muchas cámaras SLR digitales utilizan un sensor de imagen que tiene 2 ⁄ 3 , 5 ⁄ 8 o 1 ⁄ 2 del tamaño de un fotograma de película de 35 mm. Esto significa que el fotograma de 35 mm es 1,5, 1,6 o 2 veces el tamaño del sensor digital. Los últimos valores se conocen como factor de recorte , factor de recorte del campo de visión, multiplicador de longitud focal o factor de formato. En una cámara con factor de recorte 2×, por ejemplo, una lente de 50 mm produce el mismo campo de visión que una lente de 100 mm utilizada en una cámara de película de 35 mm y, por lo general, se puede sostener con la mano a 1 ⁄ 100 de segundo.

Sin embargo, la estabilización de imagen no evita el desenfoque causado por el movimiento del sujeto o por movimientos extremos de la cámara. La estabilización de imagen está diseñada únicamente para reducir el desenfoque que resulta de un movimiento normal y mínimo de un objetivo debido a la toma de fotografías con la cámara en la mano. Algunos objetivos y cuerpos de cámara incluyen un modo de panorámica secundario o un "modo activo" más agresivo, ambos descritos con mayor detalle a continuación en la sección sobre estabilización óptica de imagen.

La astrofotografía hace un gran uso de la fotografía de larga exposición , que requiere que la cámara esté fija en un lugar. Sin embargo, sujetarla a la Tierra no es suficiente, ya que la Tierra gira . Las Pentax K-5 y Kr, cuando están equipadas con el accesorio GPS O-GPS1 para datos de posición, pueden usar su capacidad de desplazamiento del sensor para reducir los rastros de estrellas resultantes . [4]

La estabilización se puede aplicar en el objetivo o en el cuerpo de la cámara. Cada método tiene sus propias ventajas y desventajas. [5]

Técnicas

Estabilización óptica de imagen

Un estabilizador óptico de imagen ( OIS , IS u OS ) es un mecanismo utilizado en cámaras fotográficas o de vídeo que estabiliza la imagen grabada variando la trayectoria óptica hacia el sensor. Esta tecnología se implementa en el propio objetivo, a diferencia de la estabilización de imagen en el cuerpo ( IBIS ), que funciona moviendo el sensor como elemento final en la trayectoria óptica. El elemento clave de todos los sistemas de estabilización óptica es que estabilizan la imagen proyectada en el sensor antes de que el sensor convierta la imagen en información digital . IBIS puede tener hasta 5 ejes de movimiento: X, Y, Roll, Yaw y Pitch. IBIS tiene la ventaja añadida de funcionar con todos los objetivos.

Beneficios del OIS

La estabilización óptica de imagen prolonga la velocidad de obturación posible para la fotografía manual al reducir la probabilidad de que la imagen se vea borrosa debido al movimiento durante el mismo tiempo de exposición.

Para la grabación de vídeo con la cámara en la mano , independientemente de las condiciones de iluminación, la estabilización óptica de la imagen compensa las pequeñas vibraciones cuya apariencia se magnifica cuando se ven en una pantalla grande, como un televisor o un monitor de computadora . [6] [7] [8]

Nombres por vendedores

Distintas empresas tienen distintos nombres para la tecnología OIS, por ejemplo:

- Reducción de la vibración (VR) – Nikon (produjo la primera lente estabilizada óptica de dos ejes, un zoom de 38–105 mm f /4–7.8 integrado en la cámara Nikon Zoom 700VR (EE. UU.: Zoom-Touch 105 VR) en 1994) [9] [10]

- Estabilizador de imagen (IS): Canon presentó el EF 75–300 mm f /4–5.6 IS USM) en 1995. En 2009, presentó su primer objetivo (el EF 100 mm F2.8 Macro L) que utiliza un IS híbrido de cuatro ejes .

- Anti-Shake (AS) – Minolta y Konica Minolta (Minolta introdujo el primer estabilizador de imagen de dos ejes basado en sensor con la DiMAGE A1 en 2003)

- IBIS - Estabilización de imagen corporal – Olympus y Fujifilm

- SteadyShot óptico (OSS) – Sony (para Cyber-shot y varios objetivos con montura E α )

- Estabilización óptica de imagen (OIS) – Fujifilm

- MegaOIS, PowerOIS – Panasonic y Leica

- SteadyShot (SS), Super SteadyShot (SSS), SteadyShot INSIDE (SSI) – Sony (basado originalmente en el Anti-Shake de Konica Minolta , Sony introdujo una variante de fotograma completo de 2 ejes para la DSLR-A900 en 2008 y un estabilizador de 5 ejes para el ILCE-7M2 de fotograma completo en 2014)

- Estabilización óptica (OS) – Sigma

- Compensación de vibraciones (VC) – Tamron

- Reducción de vibración (SR) – Pentax

- PureView – Nokia (produjo el primer sensor estabilizado óptico para teléfonos celulares, integrado en el Lumia 920 )

- UltraPixel – HTC (La estabilización de imagen solo está disponible para el HTC One 2013 y el HTC 10 2016 con UltraPixel. No está disponible para el HTC One (M8) ni el HTC Butterfly S, que también tienen UltraPixel)

A finales de 2014, la mayoría de los teléfonos inteligentes de alta gama utilizan estabilización óptica de imagen para fotografías y vídeos. [11]

Basado en lentes

En la implementación de Nikon y Canon , funciona utilizando un elemento de lente flotante que se mueve ortogonalmente al eje óptico de la lente mediante electroimanes. [12] La vibración se detecta utilizando dos sensores de velocidad angular piezoeléctricos (a menudo llamados sensores giroscópicos ), uno para detectar el movimiento horizontal y el otro para detectar el movimiento vertical. [13] Como resultado, este tipo de estabilizador de imagen corrige solo las rotaciones de los ejes de cabeceo y guiñada, [14] [15] y no puede corregir la rotación alrededor del eje óptico. Algunas lentes tienen un modo secundario que contrarresta el movimiento vertical de la cámara. Este modo es útil cuando se utiliza una técnica de panorámica . Algunas de estas lentes lo activan automáticamente; otras usan un interruptor en la lente.

Para compensar el movimiento de la cámara al grabar videos mientras se camina, Panasonic introdujo Power Hybrid OIS+ con corrección de cinco ejes: rotación de ejes, rotación horizontal, rotación vertical y movimiento horizontal y vertical. [16]

Algunas lentes Nikon compatibles con VR ofrecen un modo "activo" para disparar desde un vehículo en movimiento, como un automóvil o un barco, que se supone que corrige los movimientos más grandes que el modo "normal". [17] Sin embargo, el modo activo utilizado para disparos normales puede producir peores resultados que el modo normal. [18] Esto se debe a que el modo activo está optimizado para reducir los movimientos de mayor velocidad angular (normalmente cuando se dispara desde una plataforma en gran movimiento utilizando velocidades de obturación más rápidas), mientras que el modo normal intenta reducir los movimientos de menor velocidad angular en una amplitud y un período de tiempo mayores (normalmente el movimiento del cuerpo y la mano cuando se está de pie en una plataforma estacionaria o que se mueve lentamente mientras se utilizan velocidades de obturación más lentas).

La mayoría de los fabricantes recomiendan desactivar la función IS de un objetivo cuando éste se monta en un trípode, ya que puede provocar resultados erráticos y, por lo general, no es necesario. Muchos objetivos de estabilización de imagen modernos (en particular, los objetivos IS más recientes de Canon) pueden detectar automáticamente que están montados en un trípode (como resultado de lecturas de vibración extremadamente bajas) y desactivan la función IS automáticamente para evitar esto y cualquier reducción consiguiente de la calidad de la imagen. [19] El sistema también consume energía de la batería, por lo que desactivarlo cuando no se necesita extiende la carga de la batería.

Una desventaja de la estabilización de imagen basada en lentes es el costo. Cada lente requiere su propio sistema de estabilización de imagen. Además, no todos los lentes están disponibles en una versión estabilizada de imagen. Este suele ser el caso de los lentes de focal fija rápidos y los lentes gran angular. Sin embargo, el lente más rápido con estabilización de imagen es el Nocticron con una velocidad de f /1.2 . Si bien la ventaja más obvia de la estabilización de imagen radica en las distancias focales más largas, incluso los lentes normales y gran angular se benefician de ella en aplicaciones con poca luz.

La estabilización basada en lentes también tiene ventajas sobre la estabilización en el cuerpo. En situaciones de poca luz o bajo contraste, el sistema de enfoque automático (que no tiene sensores estabilizados) puede funcionar con mayor precisión cuando la imagen que proviene del lente ya está estabilizada. [ cita requerida ] En las cámaras con visores ópticos, la imagen que ve el fotógrafo a través del lente estabilizado (a diferencia de la estabilización en el cuerpo) revela más detalles debido a su estabilidad, y también facilita el encuadre correcto. Esto es especialmente el caso con los teleobjetivos más largos. Esto no es un problema para los sistemas de cámaras sin espejo con lentes intercambiables , porque la salida del sensor a la pantalla o al visor electrónico está estabilizada.

Cambio de sensor

El sensor que captura la imagen se puede mover de tal manera que contrarreste el movimiento de la cámara, una tecnología a la que a menudo se hace referencia como estabilización mecánica de la imagen. Cuando la cámara gira, lo que provoca un error angular, los giroscopios codifican información para el actuador que mueve el sensor. [20] El sensor se mueve para mantener la proyección de la imagen sobre el plano de la imagen, que es una función de la longitud focal del objetivo que se utiliza. Las cámaras modernas pueden adquirir automáticamente información de la longitud focal de los objetivos modernos fabricados para esa cámara. Minolta y Konica Minolta utilizaron una técnica llamada Anti-Shake (AS) que ahora se comercializa como SteadyShot (SS) en la línea Sony α y Shake Reduction (SR) en las cámaras de las series K y Q de Pentax , que se basa en un sensor de velocidad angular muy preciso para detectar el movimiento de la cámara. [21] Olympus introdujo la estabilización de imagen con su cuerpo D-SLR E-510 , empleando un sistema construido alrededor de su Supersonic Wave Drive. [22] Otros fabricantes utilizan procesadores de señales digitales (DSP) para analizar la imagen sobre la marcha y luego mover el sensor en consecuencia. El desplazamiento del sensor también se utiliza en algunas cámaras de Fujifilm, Samsung, Casio Exilim y Ricoh Caplio. [23]

La ventaja de mover el sensor de imagen , en lugar de la lente, es que la imagen se puede estabilizar incluso en lentes fabricadas sin estabilización. Esto puede permitir que la estabilización funcione con muchas lentes que de otro modo no estarían estabilizadas, y reduce el peso y la complejidad de las lentes. Además, cuando la tecnología de estabilización de imagen basada en sensores mejora, solo se requiere reemplazar la cámara para aprovechar las mejoras, lo que generalmente es mucho menos costoso que reemplazar todas las lentes existentes si se depende de la estabilización de imagen basada en lentes. Algunas implementaciones de estabilización de imagen basadas en sensores son capaces de corregir la rotación del balanceo de la cámara , un movimiento que se excita fácilmente al presionar el botón del obturador. Ningún sistema basado en lentes puede abordar esta fuente potencial de borrosidad de la imagen. Un subproducto de la compensación de "balanceo" disponible es que la cámara puede corregir automáticamente los horizontes inclinados en el dominio óptico, siempre que esté equipada con un nivel de burbuja electrónico, como las cámaras Pentax K-7/K-5.

Una de las principales desventajas de mover el propio sensor de imagen es que la imagen proyectada en el visor no está estabilizada. De manera similar, la imagen proyectada en un sistema de enfoque automático por detección de fases que no forma parte del sensor de imagen, si se utiliza, no está estabilizada. Esto no es un problema en las cámaras que utilizan un visor electrónico (EVF), ya que la imagen proyectada en ese visor se toma del propio sensor de imagen.

Algunas cámaras, aunque no todas, que cuentan con estabilizadores integrados pueden preajustarse manualmente a una determinada distancia focal. Su sistema de estabilización corrige la situación como si la lente de esa distancia focal estuviera acoplada, por lo que la cámara puede estabilizar lentes más antiguas y lentes de otros fabricantes. Esto no es viable con lentes con zoom, porque su distancia focal es variable. Algunos adaptadores comunican la información de la distancia focal del fabricante de una lente al cuerpo de otro fabricante. Algunas lentes que no informan su distancia focal pueden ser equipadas con un chip que informa una distancia focal preprogramada al cuerpo de la cámara. A veces, ninguna de estas técnicas funciona y la estabilización de imagen no se puede utilizar con dichas lentes.

La estabilización de imagen en el cuerpo requiere que el objetivo tenga un círculo de imagen de salida más grande porque el sensor se mueve durante la exposición y, por lo tanto, utiliza una parte más grande de la imagen. En comparación con los movimientos del objetivo en los sistemas de estabilización de imagen óptica, los movimientos del sensor son bastante grandes, por lo que la efectividad está limitada por el rango máximo de movimiento del sensor, donde un objetivo moderno típico con estabilización óptica tiene mayor libertad. Tanto la velocidad como el rango del movimiento del sensor requerido aumentan con la longitud focal del objetivo que se utiliza, lo que hace que la tecnología de desplazamiento del sensor sea menos adecuada para teleobjetivos muy largos, especialmente cuando se utilizan velocidades de obturación más lentas, porque el rango de movimiento disponible del sensor rápidamente se vuelve insuficiente para hacer frente al desplazamiento creciente de la imagen.

En septiembre de 2023, Nikon anunció el lanzamiento de la Nikon Z f , que cuenta con la primera tecnología Focus-Point VR del mundo que centra el eje de estabilización de imagen por desplazamiento del sensor en el punto de enfoque automático, en lugar de en el centro del sensor como el sistema de estabilización de imagen por desplazamiento del sensor convencional. Esto permite la reducción de la vibración en el punto enfocado en lugar de solo en el centro de la imagen. [24]

Dual

A partir de la Panasonic Lumix DMC-GX8 , anunciada en julio de 2015, y posteriormente con la Panasonic Lumix DC-GH5 , Panasonic, que anteriormente solo equipaba la estabilización basada en lentes en su sistema de cámara con lentes intercambiables (del estándar Micro Cuatro Tercios ), introdujo la estabilización por desplazamiento del sensor que funciona en conjunto con el sistema basado en lentes existente ("Dual IS").

Mientras tanto (2016), Olympus también ofreció dos lentes con estabilización de imagen que se pueden sincronizar con el sistema de estabilización de imagen incorporado de los sensores de imagen de las cámaras Micro Four Thirds de Olympus ("Sync IS"). Con esta tecnología se puede lograr una ganancia de 6,5 f -stops sin imágenes borrosas. [25] Esto está limitado por el movimiento rotacional de la superficie de la Tierra, que engaña a los acelerómetros de la cámara. Por lo tanto, dependiendo del ángulo de visión, el tiempo máximo de exposición no debe exceder 1 ⁄ 3 de segundo para tomas largas con teleobjetivo (con una distancia focal equivalente a 35 mm de 800 milímetros) y un poco más de diez segundos para tomas de gran angular (con una distancia focal equivalente a 35 mm de 24 milímetros), si el movimiento de la Tierra no se tiene en cuenta en el proceso de estabilización de imagen. [26]

En 2015, el sistema de cámaras Sony E también permitió combinar sistemas de estabilización de imagen de lentes y cuerpos de cámara, pero sin sincronizar los mismos grados de libertad . En este caso, solo se activan los grados de compensación independientes de la estabilización del sensor de imagen incorporado para apoyar la estabilización de la lente. [27]

Canon y Nikon ahora tienen cuerpos sin espejo de fotograma completo que tienen IBIS y también admiten la estabilización basada en lentes de cada compañía. Los dos primeros cuerpos de este tipo de Canon, la EOS R y RP , no tienen IBIS, pero la función se agregó para los modelos más recientes de gama alta R3 , R5 , R6 (y su versión MkII) y la APS-C R7 . Sin embargo, la R8 de fotograma completo y la APS-C R10 no tienen IBIS. Todos los cuerpos de montura Z de fotograma completo de Nikon (la Z 6 , Z 7 , las versiones Mark II de ambas, la , Z 8 y la , Z 9 tienen IBIS. Sin embargo, su APS-C Z 50 carece de IBIS.

Estabilización de imagen digital

La estabilización de imagen digital en tiempo real , también llamada estabilización electrónica de imagen (EIS), se utiliza en algunas cámaras de vídeo. Esta técnica desplaza el área recortada que se lee del sensor de imagen para cada fotograma para contrarrestar el movimiento. Esto requiere que la resolución del sensor de imagen supere la resolución del vídeo grabado y reduce ligeramente el campo de visión porque el área del sensor de imagen fuera del fotograma visible actúa como un amortiguador contra los movimientos de la mano. [28] Esta técnica reduce las vibraciones que distraen de los vídeos al suavizar la transición de un fotograma a otro.

Esta técnica no puede hacer nada con el desenfoque de movimiento existente, que puede provocar que una imagen parezca perder el foco a medida que el movimiento se compensa debido al movimiento durante los tiempos de exposición de los fotogramas individuales. Este efecto es más visible en paisajes más oscuros debido a los tiempos de exposición prolongados por fotograma.

Algunos fabricantes de cámaras fijas promocionaron sus cámaras como si tuvieran estabilización de imagen digital cuando en realidad solo tenían un modo de alta sensibilidad que utiliza un tiempo de exposición corto, lo que produce imágenes con menos desenfoque de movimiento, pero más ruido. [29] Reduce el desenfoque al fotografiar algo que se está moviendo, así como el movimiento de la cámara.

Otros ahora también utilizan el procesamiento de señal digital (DSP) para reducir el desenfoque en las imágenes fijas, por ejemplo, subdividiendo la exposición en varias exposiciones más cortas en rápida sucesión, descartando las borrosas, realineando las subexposiciones más nítidas y sumándolas, y utilizando el giroscopio para detectar el mejor momento para tomar cada fotograma. [30] [31] [32]

Filtros de estabilización

Muchos sistemas de edición no lineal de vídeo utilizan filtros de estabilización que pueden corregir una imagen no estabilizada rastreando el movimiento de los píxeles en la imagen y corrigiendo la imagen moviendo el marco. [33] [34] El proceso es similar a la estabilización de imagen digital, pero como no hay una imagen más grande con la que trabajar, el filtro recorta la imagen para ocultar el movimiento del marco o intenta recrear la imagen perdida en el borde a través de una extrapolación espacial o temporal . [35]

Los servicios en línea, incluido YouTube , también están comenzando a proporcionar estabilización de video como un paso de posprocesamiento después de que se carga el contenido. Esto tiene la desventaja de no tener acceso a los datos giroscópicos en tiempo real, pero la ventaja de una mayor potencia de procesamiento y la capacidad de analizar imágenes tanto antes como después de un cuadro en particular. [36]

CCD de transferencia ortogonal

En astronomía, un CCD de transferencia ortogonal (OTCCD) desplaza la imagen dentro del propio CCD mientras se captura la imagen, basándose en el análisis del movimiento aparente de las estrellas brillantes. Se trata de un ejemplo poco común de estabilización digital para fotografías fijas. Un ejemplo de ello es el futuro telescopio de gigapíxeles Pan-STARRS que se está construyendo en Hawái. [37]

Estabilización del cuerpo de la cámara

Una técnica que no requiere capacidades adicionales de ninguna combinación de cuerpo de cámara y lente consiste en estabilizar todo el cuerpo de la cámara externamente en lugar de usar un método interno. Esto se logra colocando un giroscopio en el cuerpo de la cámara, generalmente usando el soporte de trípode incorporado de la cámara. Esto permite que el giroscopio externo (cardán) estabilice la cámara y se usa típicamente en fotografías desde un vehículo en movimiento, cuando no se dispone de un lente o una cámara que ofrezca otro tipo de estabilización de imagen. [38]

Una forma habitual de estabilizar cámaras en movimiento a partir del año 2015 aproximadamente es mediante el uso de un estabilizador de cámara, como un cabezal de cámara remoto estabilizado. La cámara y el objetivo se montan en un soporte de cámara controlado a distancia que luego se monta en cualquier cosa que se mueva, como sistemas ferroviarios, cables, automóviles o helicópteros. Un ejemplo de un cabezal estabilizado a distancia que se utiliza para estabilizar cámaras de televisión en movimiento que transmiten en vivo es el cabezal estabilizado Newton. [39]

Otra técnica para estabilizar el cuerpo de una cámara de vídeo o de cine es el sistema Steadicam , que aísla la cámara del cuerpo del operador mediante un arnés y un brazo de cámara con un contrapeso. [40]

Estabilizador de cámara

Un estabilizador de cámara es cualquier dispositivo u objeto que estabiliza externamente la cámara. Puede referirse a una Steadicam , un trípode , la mano del operador de la cámara o una combinación de estos.

En la fotografía de cerca, el uso de sensores de rotación para compensar los cambios en la dirección de apuntado resulta insuficiente. Si se intenta resolver detalles milimétricos del objeto, se nota que se mueve la cámara hacia arriba o hacia abajo o hacia la izquierda o hacia la derecha en lugar de inclinarla una fracción de milímetro. Los acelerómetros lineales de la cámara, junto con información como la distancia focal y la distancia enfocada del objetivo, pueden aplicar una corrección secundaria al mecanismo que mueve el sensor o la óptica para compensar tanto el movimiento lineal como el rotacional. [41]

En ojos biológicos

En muchos animales, incluidos los seres humanos, el oído interno funciona como el análogo biológico de un acelerómetro en los sistemas de estabilización de imagen de las cámaras, para estabilizar la imagen moviendo los ojos . Cuando se detecta una rotación de la cabeza, se envía una señal inhibidora a los músculos extraoculares de un lado y una señal excitatoria a los músculos del otro lado. El resultado es un movimiento compensatorio de los ojos. Normalmente, los movimientos oculares se retrasan menos de 10 ms respecto de los movimientos de la cabeza. [42]

Véase también

Notas

- ^ Esta regla fue inventada en la era del cine; con los sensores digitales modernos de alta resolución, una velocidad de obturación mínima del recíproco del doble de la longitud focal puede ser más apropiada, es decir, 1/(2*mm). [2]

Referencias

- ^ "Corregir el temblor excesivo en Final Cut Pro". Apple, Inc.

- ^ "Una regla sencilla para garantizar fotografías nítidas". 27 de julio de 2015. Consultado el 29 de enero de 2021 .

- ^ "Estabilización de imagen (IS) y reducción de vibración (VR)". www.kenrockwell.com .

- ^ PENTAX O-GPS1 - Comunicado de prensa, Pentax.jp (archivado)

- ^ "Estabilización de imagen: lente frente a cuerpo". Bobatkins.com . Consultado el 11 de diciembre de 2009 .

- ^ "Cámara Sony α7R IV de fotograma completo de 35 mm con 61,0 MP". Sony .

- ^ "Revisión del sensor de la Sony A7R IV". 14 de noviembre de 2019.

- ^ "Estabilización de lente vs. estabilización en la cámara". photographylife.com . 20 de febrero de 2012.

- ^ Modelos de cámaras Nikon 1992-1994 MIR

- ^ Chismes sobre la cámara Nikon Zoom 700VR

- ^ "15 cámaras de smartphones con estabilización óptica de imagen". 14 de diciembre de 2014.

- ^ ¿ Qué es el estabilizador óptico de imagen? Archivado el 16 de mayo de 2006 en Wayback Machine , Preguntas frecuentes sobre tecnología, Equipos de transmisión de Canon

- ^ Glosario: Óptica: Estabilización de imagen, Vincent Bockaert, Digital Photography Review

- ^ "Explicación del sistema Panasonic MegaOIS". Archivado desde el original el 12 de enero de 2009. Consultado el 16 de marzo de 2007 .

{{cite web}}: CS1 maint: URL no apta ( enlace ) - ^ "Mega OIS". Archivado desde el original el 7 de enero de 2011. Consultado el 5 de noviembre de 2011 .

- ^ "¿Por qué tu cámara compacta necesita el OIS?". Archivado desde el original el 3 de julio de 2013. Consultado el 31 de diciembre de 2013 .

- ^ "Tecnología de reducción de vibraciones (VR)". Archivado desde el original el 4 de noviembre de 2007. Consultado el 19 de mayo de 2007 .

- ^ "CameraHobby: Nikon AF-S VR 70–200mm f2.8 Review". Archivado desde el original el 23 de mayo de 2007. Consultado el 19 de mayo de 2007 .

- ^ "Informe técnico". Canon.com. Archivado desde el original el 25 de diciembre de 2009. Consultado el 11 de diciembre de 2009 .

- ^ "Desarrollo de un método de prueba para sistemas de estabilización de imágenes" (PDF) . Archivado desde el original (PDF) el 2009-01-17 . Consultado el 2008-04-04 .

- ^ Tecnología antivibración Dynax 7D Archivado el 19 de junio de 2006 en Wayback Machine , Konica Minolta

- ^ "Tecnología de estabilización de imagen de Olympus". Archivado desde el original el 2007-07-02 . Consultado el 2007-06-30 .

- ^ "Estabilización de imagen".

- ^ Nikon Z f | Focus Point VR , consultado el 11 de octubre de 2023

- ^ DL Cade: Olympus dice que la rotación de la Tierra limita la estabilización de imagen a un máximo de 6,5 pasos, petapixel.com, 26 de septiembre de 2016, consultado el 26 de octubre de 2017

- ^ Markus Bautsch: Optomechanische Bildstabilisierung, alemán, Estabilización de imagen optomecánica , en: Wikibook Técnicas de imagen digital , consultado el 30 de octubre de 2017

- ^ Una comparación de cómo funciona la estabilización de 5 ejes de Olympus y Sony, thephoblographer.com, 17 de diciembre de 2014, consultado el 26 de octubre de 2017

- ^ Chereau, R., Breckon, TP (septiembre de 2013). "Filtrado de movimiento robusto como facilitador de la estabilización de vídeo para un robot móvil teleoperado" (PDF) . En Kamerman, Gary W; Steinvall, Ove K; Bishop, Gary J; Gonglewski, John D (eds.). Proc. SPIE Teledetección electroóptica, tecnologías fotónicas y aplicaciones VII . Teledetección electroóptica, tecnologías fotónicas y aplicaciones VII; y Aplicaciones militares en imágenes hiperespectrales y detección de alta resolución espacial. Vol. 8897. SPIE. págs. 88970I. doi :10.1117/12.2028360. S2CID 11556469 . Consultado el 5 de noviembre de 2013 .

{{cite book}}: CS1 maint: varios nombres: lista de autores ( enlace )[ enlace muerto permanente ] - ^ "Detengan las etiquetas engañosas de 'Estabilización de imagen': Digital Photography Review". Dpreview.com. 2007-01-05 . Consultado el 2009-12-11 .

- ^ "Características de la Sony DSC-HX5V". sony.co.uk. 2010-04-01 . Consultado el 2012-06-24 .

- ^ "Características de la Fujifilm FinePix HS20EXR: triple estabilización de imagen". fujifilm.ca. 2011-01-05. Archivado desde el original el 2012-01-12 . Consultado el 2012-06-26 .

- ^ Zimmerman, Steven (12 de octubre de 2016). «Sony IMX378: análisis completo del sensor del Google Pixel y sus características». XDA Developers . Consultado el 17 de octubre de 2016 .

- ^ "El recurso del videógrafo de eventos". EventDV.net . Consultado el 11 de diciembre de 2009 .

- ^ "Estabilización por software". studiodaily.com. 28 de febrero de 2011. Consultado el 17 de marzo de 2014 .

- ^ "Capacidades | Estabilización". 2d3 . Archivado desde el original el 25 de noviembre de 2009 . Consultado el 11 de diciembre de 2009 .

- ^ "Secretos de estabilización de vídeo en YouTube". 15 de mayo de 2013. Consultado el 17 de octubre de 2014 .

- ^ Diseño de cámara CCD de transferencia ortogonal Pan-STARRS Archivado el 7 de agosto de 2004 en Wayback Machine , Gareth Wynn-Williams, Instituto de Astronomía

- ^ Multimedia: Cómo utilizar la estabilización de imagen, Andy King, Optimización de sitios web, 2004

- ^ "Cabezas de cámara remotas estabilizadas NEWTON". newtonnordic.com. 2020-01-09 . Consultado el 2020-06-26 .

- ^ Harris, Tom (22 de noviembre de 2001). "Cómo funcionan las steadicams". HowStuffWorks.com . Discovery Communications LLC . Consultado el 26 de julio de 2008 .

- ^ "Estabilizador de imagen híbrido". Comunicados de prensa globales de Canon . canon.com. 22 de julio de 2009. Archivado desde el original el 17 de junio de 2012. Consultado el 26 de junio de 2012 .

- ^ Barnes, GR (1979). "Función vestíbulo-ocular durante movimientos coordinados de cabeza y ojos para adquirir objetivos visuales". The Journal of Physiology . 287 : 127–147. doi :10.1113/jphysiol.1979.sp012650. PMC 1281486 . PMID 311828.