Análisis discriminante lineal

El análisis discriminante lineal ( LDA ), análisis discriminante normal ( NDA ) o análisis de función discriminante es una generalización del discriminante lineal de Fisher , un método utilizado en estadística y otros campos para encontrar una combinación lineal de características que caracteriza o separa dos o más clases de objetos o eventos. La combinación resultante puede utilizarse como clasificador lineal o, más comúnmente, para la reducción de dimensionalidad antes de una clasificación posterior .

El LDA está estrechamente relacionado con el análisis de varianza (ANOVA) y el análisis de regresión , que también intentan expresar una variable dependiente como una combinación lineal de otras características o mediciones. [2] [3] Sin embargo, el ANOVA utiliza variables independientes categóricas y una variable dependiente continua , mientras que el análisis discriminante tiene variables independientes continuas y una variable dependiente categórica ( es decir , la etiqueta de clase). [4] La regresión logística y la regresión probit son más similares al LDA que el ANOVA, ya que también explican una variable categórica por los valores de las variables independientes continuas. Estos otros métodos son preferibles en aplicaciones donde no es razonable asumir que las variables independientes se distribuyen normalmente, lo cual es un supuesto fundamental del método LDA.

El LDA también está estrechamente relacionado con el análisis de componentes principales (PCA) y el análisis factorial en el sentido de que ambos buscan combinaciones lineales de variables que expliquen mejor los datos. [5] El LDA intenta explícitamente modelar la diferencia entre las clases de datos. El PCA, por el contrario, no tiene en cuenta ninguna diferencia en la clase, y el análisis factorial construye las combinaciones de características basándose en las diferencias en lugar de las similitudes. El análisis discriminante también se diferencia del análisis factorial en el sentido de que no es una técnica de interdependencia: se debe hacer una distinción entre variables independientes y variables dependientes (también llamadas variables de criterio).

El análisis de correspondencias discriminante funciona cuando las mediciones realizadas sobre las variables independientes para cada observación son cantidades continuas. Cuando se trabaja con variables independientes categóricas, la técnica equivalente es el análisis de correspondencias discriminante. [6] [7]

El análisis discriminante se utiliza cuando los grupos se conocen a priori (a diferencia del análisis de conglomerados ). Cada caso debe tener una puntuación en una o más medidas predictivas cuantitativas y una puntuación en una medida de grupo. [8] En términos simples, el análisis de la función discriminante es una clasificación: el acto de distribuir cosas en grupos, clases o categorías del mismo tipo.

Historia

El análisis discriminante dicotómico original fue desarrollado por Sir Ronald Fisher en 1936. [9] Es diferente de un ANOVA o MANOVA , que se utiliza para predecir una (ANOVA) o múltiples (MANOVA) variables dependientes continuas a partir de una o más variables categóricas independientes. El análisis de la función discriminante es útil para determinar si un conjunto de variables es eficaz para predecir la pertenencia a una categoría. [10]

LDA para dos clases

Consideremos un conjunto de observaciones (también llamadas características, atributos, variables o mediciones) para cada muestra de un objeto o evento con una clase conocida . Este conjunto de muestras se denomina conjunto de entrenamiento en un contexto de aprendizaje supervisado . El problema de clasificación es entonces encontrar un buen predictor para la clase de cualquier muestra de la misma distribución (no necesariamente del conjunto de entrenamiento) dada solo una observación . [11] : 338

LDA aborda el problema suponiendo que las funciones de densidad de probabilidad condicional y son ambas de distribución normal con parámetros de media y covarianza y , respectivamente. Bajo este supuesto, la solución bayesiana óptima es predecir que los puntos pertenecen a la segunda clase si el logaritmo de los cocientes de verosimilitud es mayor que un umbral T, de modo que:

Sin más suposiciones, el clasificador resultante se denomina análisis discriminante cuadrático (ADQ).

En cambio, LDA hace el supuesto adicional de homocedasticidad simplificadora ( es decir , que las covarianzas de clase son idénticas, por lo que ) y que las covarianzas tienen rango completo. En este caso, varios términos se cancelan:

- Porque es hermitiano

y el criterio de decisión anterior se convierte en un umbral en el producto escalar

para una constante umbral c , donde

Esto significa que el criterio de que una entrada esté en una clase es puramente una función de esta combinación lineal de las observaciones conocidas.

A menudo resulta útil ver esta conclusión en términos geométricos: el criterio de que una entrada esté en una clase es puramente una función de la proyección de un punto del espacio multidimensional sobre un vector (por lo tanto, solo consideramos su dirección). En otras palabras, la observación pertenece a si correspondiente está ubicada en un lado determinado de un hiperplano perpendicular a . La ubicación del plano está definida por el umbral .

Suposiciones

Los supuestos del análisis discriminante son los mismos que los del análisis MANOVA. El análisis es bastante sensible a los valores atípicos y el tamaño del grupo más pequeño debe ser mayor que el número de variables predictoras. [8]

- Normalidad multivariante : Las variables independientes son normales para cada nivel de la variable de agrupación. [10] [8]

- Homogeneidad de varianza/covarianza ( homocedasticidad ): las varianzas entre las variables de grupo son las mismas en todos los niveles de predictores. Se puede probar con la estadística M de Box . [10] Sin embargo, se ha sugerido que se utilice el análisis discriminante lineal cuando las covarianzas sean iguales, y que se pueda utilizar el análisis discriminante cuadrático cuando las covarianzas no sean iguales. [8]

- Independencia : Se supone que los participantes son seleccionados aleatoriamente y que la puntuación de un participante en una variable es independiente de las puntuaciones en esa variable de todos los demás participantes. [10] [8]

Se ha sugerido que el análisis discriminante es relativamente robusto ante pequeñas violaciones de estos supuestos [12] , y también se ha demostrado que el análisis discriminante puede seguir siendo confiable cuando se utilizan variables dicotómicas (donde a menudo se viola la normalidad multivariada). [13]

Funciones discriminantes

El análisis discriminante funciona creando una o más combinaciones lineales de predictores, creando una nueva variable latente para cada función. Estas funciones se denominan funciones discriminantes. El número de funciones posibles es donde = número de grupos o (el número de predictores), lo que sea menor. La primera función creada maximiza las diferencias entre los grupos en esa función. La segunda función maximiza las diferencias en esa función, pero tampoco debe estar correlacionada con la función anterior. Esto continúa con las funciones posteriores con el requisito de que la nueva función no esté correlacionada con ninguna de las funciones anteriores.

Dado un grupo , con conjuntos de espacio muestral, existe una regla discriminante tal que si , entonces . El análisis discriminante encuentra entonces regiones “buenas” de para minimizar el error de clasificación, lo que conduce a un alto porcentaje de clasificación correcta en la tabla de clasificación. [14]

A cada función se le asigna una puntuación discriminante [ aclaración necesaria ] para determinar qué tan bien predice la ubicación del grupo.

- Coeficientes de correlación de estructura: la correlación entre cada predictor y la puntuación discriminante de cada función. Se trata de una correlación de orden cero (es decir, no corregida para los demás predictores). [15]

- Coeficientes estandarizados: peso de cada predictor en la combinación lineal que constituye la función discriminante. Al igual que en una ecuación de regresión, estos coeficientes son parciales (es decir, están corregidos para los demás predictores). Indican la contribución única de cada predictor en la predicción de la asignación de grupo.

- Funciones en los centroides de grupo: se proporcionan las puntuaciones discriminantes medias para cada variable de agrupamiento para cada función. Cuanto más separadas estén las medias, menor será el error en la clasificación.

Normas de discriminación

- Máxima verosimilitud : se asigna al grupo que maximiza la densidad de población (grupo). [16]

- Regla discriminante de Bayes: asigna al grupo que maximiza , donde π i representa la probabilidad previa de esa clasificación y representa la densidad de población. [16]

- Regla discriminante lineal de Fisher: maximiza la relación entre SS entre y SS dentro de , y encuentra una combinación lineal de los predictores para predecir el grupo. [16]

Valores propios

Un valor propio en el análisis discriminante es la raíz característica de cada función. [ aclaración necesaria ] Es una indicación de qué tan bien esa función diferencia los grupos, donde cuanto mayor sea el valor propio, mejor diferencia la función. [8] Sin embargo, esto debe interpretarse con precaución, ya que los valores propios no tienen límite superior. [10] [8] El valor propio puede verse como una relación de SS entre y SS dentro como en ANOVA cuando la variable dependiente es la función discriminante y los grupos son los niveles del IV [ aclaración necesaria ] . [10] Esto significa que el valor propio más grande está asociado con la primera función, el segundo más grande con la segunda, etc.

Tamaño del efecto

Algunos sugieren el uso de valores propios como medidas del tamaño del efecto , sin embargo, esto generalmente no es apoyado. [10] En cambio, la correlación canónica es la medida preferida del tamaño del efecto. Es similar al valor propio, pero es la raíz cuadrada de la relación de SS entre y SS total . Es la correlación entre los grupos y la función. [10] Otra medida popular del tamaño del efecto es el porcentaje de varianza [ aclaración necesaria ] para cada función. Esto se calcula por: ( λ x /Σλ i ) X 100 donde λ x es el valor propio para la función y Σ λ i es la suma de todos los valores propios. Esto nos dice qué tan fuerte es la predicción para esa función particular en comparación con las otras. [10] El porcentaje clasificado correctamente también se puede analizar como un tamaño del efecto. El valor kappa puede describir esto mientras se corrige el acuerdo aleatorio. [10] Kappa normaliza en todas las categorías en lugar de estar sesgado por clases con un rendimiento significativamente bueno o malo. [ aclaración necesaria ] [17]

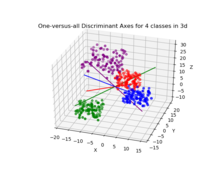

Análisis discriminante canónico paraaclases

El análisis discriminante canónico (ADC) encuentra los ejes ( k − 1 coordenadas canónicas , donde k es el número de clases) que separan mejor las categorías. Estas funciones lineales no están correlacionadas y definen, en efecto, un espacio k − 1 óptimo a través de la nube de datos n -dimensional que separa mejor (las proyecciones en ese espacio de) los k grupos. Consulte “ADC multiclase” para obtener más detalles a continuación.

Discriminante lineal de Fisher

Los términos discriminante lineal de Fisher y LDA a menudo se usan indistintamente, aunque el artículo original de Fisher [2] en realidad describe un discriminante ligeramente diferente, que no realiza algunas de las suposiciones de LDA, como clases distribuidas normalmente o covarianzas de clases iguales .

Supongamos que dos clases de observaciones tienen medias y covarianzas . Entonces, la combinación lineal de características tendrá medias y varianzas para . Fisher definió la separación entre estas dos distribuciones como la relación entre la varianza entre las clases y la varianza dentro de las clases:

Esta medida es, en cierto sentido, una medida de la relación señal-ruido para el etiquetado de clase. Se puede demostrar que la separación máxima se produce cuando

Cuando se cumplen los supuestos de LDA, la ecuación anterior es equivalente a LDA.

Asegúrese de tener en cuenta que el vector es la normal al hiperplano discriminante . Como ejemplo, en un problema bidimensional, la línea que mejor divide los dos grupos es perpendicular a .

Generalmente, los puntos de datos que se van a discriminar se proyectan sobre ; luego, se elige el umbral que mejor separa los datos a partir del análisis de la distribución unidimensional. No existe una regla general para el umbral. Sin embargo, si las proyecciones de puntos de ambas clases exhiben aproximadamente las mismas distribuciones, una buena opción sería el hiperplano entre las proyecciones de las dos medias, y . En este caso, el parámetro c en la condición de umbral se puede encontrar explícitamente:

- .

El método de Otsu está relacionado con el discriminante lineal de Fisher y fue creado para binarizar el histograma de píxeles en una imagen en escala de grises eligiendo de manera óptima el umbral blanco/negro que minimiza la variación intraclase y maximiza la variación entre clases dentro/entre las escalas de grises asignadas a las clases de píxeles en blanco y negro.

LDA multiclase

En el caso en que haya más de dos clases, el análisis utilizado en la derivación del discriminante de Fisher se puede extender para encontrar un subespacio que parezca contener toda la variabilidad de la clase. [18] Esta generalización se debe a CR Rao . [19] Supongamos que cada una de las C clases tiene una media y la misma covarianza . Entonces la dispersión entre la variabilidad de la clase puede definirse por la covarianza muestral de las medias de la clase.

donde es la media de las medias de las clases. La separación de clases en una dirección en este caso estará dada por

Esto significa que cuando es un vector propio de la separación será igual al valor propio correspondiente .

Si es diagonalizable, la variabilidad entre características estará contenida en el subespacio abarcado por los vectores propios correspondientes a los C − 1 valores propios más grandes (ya que es de rango C − 1 como máximo). Estos vectores propios se utilizan principalmente en la reducción de características, como en PCA. Los vectores propios correspondientes a los valores propios más pequeños tenderán a ser muy sensibles a la elección exacta de los datos de entrenamiento y, a menudo, es necesario utilizar la regularización como se describe en la siguiente sección.

Si se requiere una clasificación, en lugar de una reducción de dimensión , hay varias técnicas alternativas disponibles. Por ejemplo, las clases pueden dividirse y se puede utilizar un discriminante de Fisher o LDA estándar para clasificar cada partición. Un ejemplo común de esto es "uno contra el resto", donde los puntos de una clase se colocan en un grupo y todo lo demás en el otro, y luego se aplica LDA. Esto dará como resultado clasificadores C, cuyos resultados se combinan. Otro método común es la clasificación por pares, donde se crea un nuevo clasificador para cada par de clases (lo que da C ( C − 1)/2 clasificadores en total), y los clasificadores individuales se combinan para producir una clasificación final.

LDA incremental

La implementación típica de la técnica LDA requiere que todas las muestras estén disponibles de antemano. Sin embargo, hay situaciones en las que el conjunto de datos completo no está disponible y los datos de entrada se observan como un flujo. En este caso, es deseable que la extracción de características LDA tenga la capacidad de actualizar las características LDA calculadas observando las nuevas muestras sin ejecutar el algoritmo en todo el conjunto de datos. Por ejemplo, en muchas aplicaciones en tiempo real, como la robótica móvil o el reconocimiento facial en línea, es importante actualizar las características LDA extraídas tan pronto como estén disponibles nuevas observaciones. Una técnica de extracción de características LDA que puede actualizar las características LDA simplemente observando nuevas muestras es un algoritmo LDA incremental , y esta idea ha sido ampliamente estudiada durante las últimas dos décadas. [20] Chatterjee y Roychowdhury propusieron un algoritmo LDA autoorganizado incremental para actualizar las características LDA. [21] En otro trabajo, Demir y Ozmehmet propusieron algoritmos de aprendizaje local en línea para actualizar las características LDA de forma incremental utilizando la corrección de errores y las reglas de aprendizaje de Hebb. [22] Posteriormente, Aliyari et al . derivaron algoritmos incrementales rápidos para actualizar las características LDA observando las nuevas muestras. [20]

Uso práctico

En la práctica, no se conocen las medias y covarianzas de las clases. Sin embargo, se pueden estimar a partir del conjunto de entrenamiento. Se puede utilizar la estimación de máxima verosimilitud o la estimación máxima a posteriori en lugar del valor exacto en las ecuaciones anteriores. Aunque las estimaciones de la covarianza se pueden considerar óptimas en algún sentido, esto no significa que el discriminante resultante obtenido al sustituir estos valores sea óptimo en ningún sentido, incluso si el supuesto de clases distribuidas normalmente es correcto.

Otra complicación en la aplicación de LDA y el discriminante de Fisher a datos reales ocurre cuando el número de mediciones de cada muestra (es decir, la dimensionalidad de cada vector de datos) excede el número de muestras en cada clase. [5] En este caso, las estimaciones de covarianza no tienen rango completo, y por lo tanto no se pueden invertir. Hay varias formas de lidiar con esto. Una es usar una pseudo inversa en lugar de la matriz inversa habitual en las fórmulas anteriores. Sin embargo, se puede lograr una mejor estabilidad numérica proyectando primero el problema en el subespacio abarcado por . [23] Otra estrategia para lidiar con un tamaño de muestra pequeño es usar un estimador de contracción de la matriz de covarianza, que se puede expresar matemáticamente como

donde es la matriz identidad, y es la intensidad de contracción o parámetro de regularización . Esto conduce al marco del análisis discriminante regularizado [24] o análisis discriminante de contracción. [25]

Además, en muchos casos prácticos los discriminantes lineales no son adecuados. El discriminante de Fisher y el LDA se pueden ampliar para su uso en la clasificación no lineal a través del truco del kernel . Aquí, las observaciones originales se asignan efectivamente a un espacio no lineal de dimensión superior. La clasificación lineal en este espacio no lineal es entonces equivalente a la clasificación no lineal en el espacio original. El ejemplo más comúnmente utilizado de esto es el discriminante de Fisher de kernel .

El LDA se puede generalizar a un análisis discriminante múltiple , donde c se convierte en una variable categórica con N estados posibles, en lugar de solo dos. De manera análoga, si las densidades condicionales de clase son normales con covarianzas compartidas, la estadística suficiente para son los valores de N proyecciones, que son el subespacio abarcado por las N medias, proyectadas afines por la matriz de covarianza inversa. Estas proyecciones se pueden encontrar resolviendo un problema de valor propio generalizado , donde el numerador es la matriz de covarianza formada al tratar las medias como muestras, y el denominador es la matriz de covarianza compartida. Consulte “LDA multiclase” más arriba para obtener más detalles.

Aplicaciones

Además de los ejemplos que se dan a continuación, LDA se aplica en el posicionamiento y la gestión de productos .

Predicción de quiebra

En la predicción de quiebras basada en ratios contables y otras variables financieras, el análisis discriminante lineal fue el primer método estadístico aplicado para explicar sistemáticamente qué empresas se declararon en quiebra y cuáles sobrevivieron. A pesar de las limitaciones, incluida la no conformidad conocida de los ratios contables con los supuestos de distribución normal del LDA, el modelo de Edward Altman de 1968 [26] sigue siendo un modelo líder en aplicaciones prácticas. [27] [28] [29]

Reconocimiento facial

En el reconocimiento facial computarizado , cada rostro está representado por una gran cantidad de valores de píxeles. El análisis discriminante lineal se utiliza principalmente aquí para reducir el número de características a un número más manejable antes de la clasificación. Cada una de las nuevas dimensiones es una combinación lineal de valores de píxeles, que forman una plantilla. Las combinaciones lineales obtenidas mediante el discriminante lineal de Fisher se denominan rostros de Fisher , mientras que las obtenidas mediante el análisis de componentes principales relacionado se denominan rostros propios .

Marketing

En marketing , el análisis discriminante solía utilizarse para determinar los factores que diferencian a los distintos tipos de clientes o productos a partir de encuestas u otras formas de recopilación de datos. Ahora se utilizan con más frecuencia la regresión logística u otros métodos. El uso del análisis discriminante en marketing se puede describir mediante los siguientes pasos:

- Formular el problema y recopilar datos: identificar los atributos más destacados que utilizan los consumidores para evaluar los productos de esta categoría. Utilizar técnicas de investigación de marketing cuantitativa (como encuestas ) para recopilar datos de una muestra de clientes potenciales sobre sus calificaciones de todos los atributos del producto. La etapa de recopilación de datos suele estar a cargo de profesionales de la investigación de marketing. Las preguntas de la encuesta piden al encuestado que califique un producto de uno a cinco (o de 1 a 7, o de 1 a 10) en una serie de atributos elegidos por el investigador. Se eligen entre cinco y veinte atributos. Pueden incluir cosas como: facilidad de uso, peso, precisión, durabilidad, colorido, precio o tamaño. Los atributos elegidos variarán según el producto que se esté estudiando. Se hace la misma pregunta sobre todos los productos del estudio. Los datos de varios productos se codifican y se ingresan en un programa estadístico como R , SPSS o SAS . (Este paso es el mismo que en el análisis factorial).

- Calcule los coeficientes de la función discriminante y determine la significancia y validez estadística: elija el método de análisis discriminante adecuado. El método directo implica estimar la función discriminante de modo que todos los predictores se evalúen simultáneamente. El método por pasos introduce los predictores de manera secuencial. El método de dos grupos se debe utilizar cuando la variable dependiente tiene dos categorías o estados. El método discriminante múltiple se utiliza cuando la variable dependiente tiene tres o más estados categóricos. Utilice la Lambda de Wilks para probar la significancia en SPSS o la estadística F en SAS. El método más común utilizado para probar la validez es dividir la muestra en una muestra de estimación o análisis y una muestra de validación o de retención. La muestra de estimación se utiliza para construir la función discriminante. La muestra de validación se utiliza para construir una matriz de clasificación que contiene el número de casos clasificados correctamente e incorrectamente. El porcentaje de casos clasificados correctamente se denomina índice de aciertos .

- Dibuje los resultados en un mapa bidimensional, defina las dimensiones e interprete los resultados. El programa estadístico (o un módulo relacionado) representará los resultados en un mapa. El mapa representará cada producto (normalmente en un espacio bidimensional). La distancia entre los productos indica en qué medida son diferentes. El investigador debe etiquetar las dimensiones, lo que requiere un juicio subjetivo y suele ser un gran desafío. Véase mapeo perceptual .

Estudios biomédicos

La principal aplicación del análisis discriminante en medicina es la evaluación del estado de gravedad de un paciente y el pronóstico de la evolución de la enfermedad. Por ejemplo, durante el análisis retrospectivo, los pacientes se dividen en grupos según la gravedad de la enfermedad (leve, moderada y grave). A continuación, se estudian los resultados de los análisis clínicos y de laboratorio para revelar variables estadísticamente diferentes en estos grupos. Con estas variables, se construyen funciones discriminantes para clasificar la gravedad de la enfermedad en futuros pacientes. Además, el análisis discriminante lineal (LDA) puede ayudar a seleccionar muestras más discriminantes para aumentar los datos, lo que mejora el rendimiento de la clasificación. [30]

En biología, se utilizan principios similares para clasificar y definir grupos de diferentes objetos biológicos, por ejemplo, para definir tipos de fagos de Salmonella enteritidis basándose en espectros infrarrojos de transformada de Fourier, [31] para detectar la fuente animal de Escherichia coli estudiando sus factores de virulencia [32], etc.

Ciencias de la tierra

Este método se puede utilizar para separar las zonas de alteración [ aclaración necesaria ] . Por ejemplo, cuando se dispone de diferentes datos de varias zonas, el análisis discriminante puede encontrar el patrón dentro de los datos y clasificarlo de manera eficaz. [33]

Comparación con la regresión logística

El análisis de funciones discriminantes es muy similar a la regresión logística , y ambos pueden utilizarse para responder las mismas preguntas de investigación. [10] La regresión logística no tiene tantas suposiciones y restricciones como el análisis discriminante. Sin embargo, cuando se cumplen las suposiciones del análisis discriminante, es más potente que la regresión logística. [34] A diferencia de la regresión logística, el análisis discriminante puede utilizarse con tamaños de muestra pequeños. Se ha demostrado que cuando los tamaños de muestra son iguales y se mantiene la homogeneidad de varianza/covarianza, el análisis discriminante es más preciso. [8] A pesar de todas estas ventajas, la regresión logística se ha convertido, no obstante, en la opción común, ya que las suposiciones del análisis discriminante rara vez se cumplen. [9] [8]

Discriminante lineal en altas dimensiones

Las anomalías geométricas en dimensiones superiores conducen a la conocida maldición de la dimensionalidad . Sin embargo, la utilización adecuada de los fenómenos de concentración de medidas puede facilitar el cálculo. [35] Donoho y Tanner destacaron un caso importante de estos fenómenos de bendición de la dimensionalidad : si una muestra es esencialmente de alta dimensión, cada punto puede separarse del resto de la muestra mediante una desigualdad lineal, con alta probabilidad, incluso para muestras exponencialmente grandes. [36] Estas desigualdades lineales pueden seleccionarse en la forma estándar (de Fisher) del discriminante lineal para una rica familia de distribuciones de probabilidad. [37] En particular, dichos teoremas se prueban para distribuciones logarítmicas cóncavas , incluida la distribución normal multidimensional (la prueba se basa en las desigualdades de concentración para medidas logarítmicas cóncavas [38] ) y para medidas de producto en un cubo multidimensional (esto se prueba utilizando la desigualdad de concentración de Talagrand para espacios de probabilidad de producto). La separabilidad de los datos mediante discriminantes lineales clásicos simplifica el problema de la corrección de errores para los sistemas de inteligencia artificial en alta dimensión. [39]

Véase también

- Minería de datos

- Aprendizaje mediante árboles de decisión

- Análisis factorial

- Análisis discriminante de Kernel Fisher

- Logit (para regresión logística )

- Regresión lineal

- Análisis discriminante múltiple

- Escalamiento multidimensional

- Reconocimiento de patrones

- Regresión de preferencias

- Clasificador cuadrático

- Clasificación estadística

Referencias

- ^ Holtel, Frederik (20 de febrero de 2023). "El análisis discriminante lineal (LDA) puede ser muy fácil". Medium . Consultado el 18 de mayo de 2024 .

- ^ ab Fisher, RA (1936). "El uso de mediciones múltiples en problemas taxonómicos" (PDF) . Anales de eugenesia . 7 (2): 179–188. doi :10.1111/j.1469-1809.1936.tb02137.x. hdl : 2440/15227 .

- ^ McLachlan, GJ (2004). Análisis discriminante y reconocimiento estadístico de patrones . Wiley Interscience. ISBN 978-0-471-69115-0.Sr. 1190469 .

- ^ Análisis de datos cuantitativos: una introducción para investigadores sociales, Debra Wetcher-Hendricks, p.288

- ^ ab Martinez, AM; Kak, AC (2001). "PCA versus LDA" (PDF) . IEEE Transactions on Pattern Analysis and Machine Intelligence . 23 (2): 228–233. doi :10.1109/34.908974. Archivado desde el original (PDF) el 2008-10-11 . Consultado el 2010-06-30 .

- ^ Abdi, H. (2007) "Análisis de correspondencia discriminante". En: NJ Salkind (Ed.): Enciclopedia de medición y estadística . Thousand Oaks (CA): Sage. págs. 270–275.

- ^ Perriere, G.; Thioulouse, J. (2003). "Uso del análisis discriminante de correspondencia para predecir la ubicación subcelular de las proteínas bacterianas". Métodos y programas informáticos en biomedicina . 70 (2): 99–105. doi :10.1016/s0169-2607(02)00011-1. PMID 12507786.

- ^ abcdefghi Büyüköztürk, Ş. & Çokluk-Bökeoğlu, Ö. (2008). Análisis de funciones discriminantes: Concepto y aplicación. Egitim Arastirmalari - Revista euroasiática de investigación educativa, 33, 73-92.

- ^ ab Cohen et al. Análisis de correlación/regresión múltiple aplicado para las ciencias del comportamiento, 3.ª ed. (2003). Grupo Taylor & Francis.

- ^ abcdefghijk Hansen, John (2005). "Uso de SPSS para Windows y Macintosh: análisis y comprensión de datos". The American Statistician . 59 : 113. doi :10.1198/tas.2005.s139.

- ^ Venables, WN; Ripley, BD (2002). Estadística aplicada moderna con S (4.ª ed.). Springer Verlag. ISBN 978-0-387-95457-8.

- ^ Lachenbruch, PA (1975). Análisis discriminante . Nueva York: Hafner

- ^ Klecka, William R. (1980). Análisis discriminante . Serie Aplicaciones cuantitativas en las ciencias sociales, n.º 19. Thousand Oaks, CA: Sage Publications.

- ^ Hardle, W., Simar, L. (2007). Análisis estadístico multivariante aplicado . Springer Berlin Heidelberg. págs. 289–303.

- ^ Garson, GD (2008). Análisis de funciones discriminantes. https://web.archive.org/web/20080312065328/http://www2.chass.ncsu.edu/garson/pA765/discrim.htm.

- ^ abc Hardle, W., Simar, L. (2007). Análisis estadístico multivariante aplicado . Springer Berlin Heidelberg. págs. 289-303.

- ^ Israel, Steven A. (junio de 2006). "Métricas de rendimiento: cómo y cuándo". Geocarto International . 21 (2): 23–32. Bibcode :2006GeoIn..21...23I. doi :10.1080/10106040608542380. ISSN 1010-6049. S2CID 122376081.

- ^ Garson, GD (2008). Análisis de la función discriminante. "PA 765: Análisis de la función discriminante". Archivado desde el original el 2008-03-12 . Consultado el 2008-03-04 ..

- ^ Rao, RC (1948). "La utilización de mediciones múltiples en problemas de clasificación biológica". Revista de la Royal Statistical Society, Serie B . 10 (2): 159–203. doi :10.1111/j.2517-6161.1948.tb00008.x. JSTOR 2983775.

- ^ ab Aliyari Ghassabeh, Youness; Rudzicz, Frank; Moghaddam, Hamid Abrishami (1 de junio de 2015). "Extracción rápida e incremental de funciones LDA". Reconocimiento de patrones . 48 (6): 1999-2012. Código Bib : 2015PatRe..48.1999A. doi :10.1016/j.patcog.2014.12.012.

- ^ Chatterjee, C.; Roychowdhury, VP (1997-05-01). "Sobre algoritmos y redes autoorganizadas para características de separabilidad de clases". IEEE Transactions on Neural Networks . 8 (3): 663–678. doi :10.1109/72.572105. ISSN 1045-9227. PMID 18255669.

- ^ Demir, GK; Ozmehmet, K. (1 de marzo de 2005). "Algoritmos de aprendizaje local en línea para análisis discriminante lineal". Pattern Recognit. Lett . 26 (4): 421–431. Código Bibliográfico : 2005PaReL..26..421D. doi : 10.1016/j.patrec.2004.08.005. ISSN 0167-8655.

- ^ Yu, H.; Yang, J. (2001). "Un algoritmo LDA directo para datos de alta dimensión — con aplicación al reconocimiento facial". Reconocimiento de patrones . 34 (10): 2067–2069. Bibcode :2001PatRe..34.2067Y. CiteSeerX 10.1.1.70.3507 . doi :10.1016/s0031-3203(00)00162-x.

- ^ Friedman, JH (1989). "Análisis discriminante regularizado" (PDF) . Revista de la Asociación Estadounidense de Estadística . 84 (405): 165–175. CiteSeerX 10.1.1.382.2682 . doi :10.2307/2289860. JSTOR 2289860. MR 0999675.

- ^ Ahdesmäki, M.; Strimmer, K. (2010). "Selección de características en problemas de predicción ómica utilizando puntuaciones cat y control de tasa de falsos no descubrimientos". Anales de estadística aplicada . 4 (1): 503–519. arXiv : 0903.2003 . doi :10.1214/09-aoas277. S2CID 2508935.

- ^ Altman, Edward I. (1968). "Razones financieras, análisis discriminante y predicción de la quiebra corporativa". Revista de finanzas . 23 (4): 589–609. doi :10.2307/2978933. JSTOR 2978933.

- ^ Agarwal, Vineet; Taffler, Richard (2005). "Veinticinco años de puntuaciones z en el Reino Unido: ¿realmente funcionan?" (PDF) .

- ^ Agarwal, Vineet; Taffler, Richard (2007). "Veinticinco años del modelo de puntuación Z de Taffler: ¿realmente tiene capacidad predictiva?". Investigación contable y empresarial . 37 (4): 285–300. doi :10.1080/00014788.2007.9663313.

- ^ Bimpong, Patrick; et al. (2020). "Evaluación del poder predictivo y la manipulación de las ganancias. Estudio aplicado a empresas de bienes y servicios de consumo que cotizan en bolsa en Ghana utilizando tres modelos de puntuación Z". Revista de expertos en finanzas . 8 (1): 1–26.

- ^ Moradi, M; Demirel, H (2024). "Clasificación de la enfermedad de Alzheimer mediante selección de datos basada en GAN y LDA progresivos condicionales 3D". Procesamiento de señales, imágenes y vídeo . 18 (2): 1847–1861.

- ^ Preisner, O; Guiomar, R; Machado, J; Menezes, JC; Lopes, JA (2010). "Aplicación de la espectroscopia infrarroja por transformada de Fourier y la quimiometría para la diferenciación de fagotipos de Salmonella enterica serovar Enteritidis". Appl Environ Microbiol . 76 (11): 3538–3544. Bibcode :2010ApEnM..76.3538P. doi :10.1128/aem.01589-09. PMC 2876429 . PMID 20363777.

- ^ David, DE; Lynne, AM; Han, J; Foley, SL (2010). "Evaluación del perfil de factores de virulencia en la caracterización de aislamientos veterinarios de Escherichia coli". Appl Environ Microbiol . 76 (22): 7509–7513. Bibcode :2010ApEnM..76.7509D. doi :10.1128/aem.00726-10. PMC 2976202 . PMID 20889790.

- ^ Tahmasebi, P.; Hezarkhani, A.; Mortazavi, M. (2010). "Aplicación del análisis discriminante para la separación por alteración; depósito de cobre de Sungun, Azerbaiyán Oriental, Irán. Australia" (PDF) . Revista de Ciencias Básicas y Aplicadas . 6 (4): 564–576.

- ^ Trevor Hastie; Robert Tibshirani; Jerome Friedman. Los elementos del aprendizaje estadístico. Minería de datos, inferencia y predicción (segunda edición). Springer. pág. 128.

- ^ Kainen PC (1997) Utilización de anomalías geométricas de alta dimensión: cuando la complejidad facilita el cálculo. En: Kárný M., Warwick K. (eds) Métodos informáticos intensivos en control y procesamiento de señales: la maldición de la dimensionalidad, Springer, 1997, págs. 282-294.

- ^ Donoho, D., Tanner, J. (2009) Universalidad observada de transiciones de fase en geometría de alta dimensión, con implicaciones para el análisis de datos y procesamiento de señales modernos, Phil. Trans. R. Soc. A 367, 4273–4293.

- ^ Gorban, Alexander N.; Golubkov, Alexander; Grechuck, Bogdan; Mirkes, Evgeny M.; Tyukin, Ivan Y. (2018). "Corrección de sistemas de IA mediante discriminantes lineales: fundamentos probabilísticos". Ciencias de la información . 466 : 303–322. arXiv : 1811.05321 . doi :10.1016/j.ins.2018.07.040. S2CID 52876539.

- ^ Guédon, O., Milman, E. (2011) Interpolación de estimaciones de capa delgada y de gran desviación nítida para medidas logarítmicas cóncavas, Geom. Funct. Anal. 21 (5), 1043–1068.

- ^ Gorban, Alexander N.; Makarov, Valeri A.; Tyukin, Ivan Y. (julio de 2019). "La efectividad irrazonable de los pequeños conjuntos neuronales en el cerebro de alta dimensión". Physics of Life Reviews . 29 : 55–88. arXiv : 1809.07656 . Bibcode :2019PhLRv..29...55G. doi : 10.1016/j.plrev.2018.09.005 . PMID 30366739.

Lectura adicional

- Duda, RO; Hart, PE; Stork, DH (2000). Clasificación de patrones (2.ª ed.). Wiley Interscience. ISBN 978-0-471-05669-0.Señor 1802993 .

- Hilbe, JM (2009). Modelos de regresión logística . Chapman & Hall/CRC Press. ISBN 978-1-4200-7575-5.

- Mika, S.; et al. (1999). "Análisis discriminante de Fisher con núcleos". Redes neuronales para procesamiento de señales IX: Actas del taller de la IEEE Signal Processing Society de 1999 (Cat. N.° 98TH8468) . pp. 41–48. CiteSeerX 10.1.1.35.9904 . doi :10.1109/NNSP.1999.788121. ISBN . 978-0-7803-5673-3. Número de identificación del sujeto 8473401.

{{cite book}}: CS1 maint: date and year (link) - McFarland, H. Richard; Donald, St. P. Richards (2001). "Probabilidades exactas de clasificación errónea para funciones discriminantes cuadráticas normales enchufables. I. El caso de medias iguales". Journal of Multivariate Analysis . 77 (1): 21–53. doi : 10.1006/jmva.2000.1924 .

- McFarland, H. Richard; Donald, St. P. Richards (2002). "Probabilidades exactas de clasificación errónea para funciones discriminantes cuadráticas normales enchufables. II. El caso heterogéneo". Journal of Multivariate Analysis . 82 (2): 299–330. doi : 10.1006/jmva.2001.2034 .

- Haghighat, M.; Abdel-Mottaleb, M.; Alhalabi, W. (2016). "Análisis de correlación discriminante: fusión de niveles de características en tiempo real para reconocimiento biométrico multimodal". IEEE Transactions on Information Forensics and Security . 11 (9): 1984–1996. doi :10.1109/TIFS.2016.2569061. S2CID 15624506.

Enlaces externos

- Análisis de correlación discriminante (DCA) del artículo de Haghighat (ver arriba)

- ALGLIB contiene implementación de LDA de código abierto en C# / C++ / Pascal / VBA.

- LDA en Python: implementación de LDA en Python

- Tutorial de LDA con MS Excel

- Estadística biomédica. Análisis discriminante

- StatQuest: Análisis discriminante lineal (LDA) explicado claramente en YouTube

- Notas del curso, Análisis de la función discriminante por G. David Garson, Universidad Estatal de Carolina del Norte

- Tutorial de análisis discriminante en Microsoft Excel de Kardi Teknomo

- Notas del curso, Análisis de funciones discriminantes por David W. Stockburger, Universidad Estatal de Missouri Archivado el 3 de marzo de 2016 en Wayback Machine

- Análisis de la función discriminante (AD) por John Poulsen y Aaron French, Universidad Estatal de San Francisco