Modelo autorregresivo

Este artículo incluye una lista de referencias generales , pero carece de suficientes citas en línea correspondientes . ( Marzo de 2011 ) |

En estadística, econometría y procesamiento de señales, un modelo autorregresivo ( AR ) es una representación de un tipo de proceso aleatorio; como tal, se puede utilizar para describir ciertos procesos que varían en el tiempo en la naturaleza, la economía, el comportamiento, etc. El modelo autorregresivo especifica que la variable de salida depende linealmente de sus propios valores previos y de un término estocástico (un término imperfectamente predecible); por lo tanto, el modelo tiene la forma de una ecuación de diferencia estocástica (o relación de recurrencia) que no debe confundirse con una ecuación diferencial . Junto con el modelo de promedio móvil (MA) , es un caso especial y un componente clave de los modelos más generales de promedio móvil autorregresivo (ARMA) y de promedio móvil integrado autorregresivo (ARIMA) de series de tiempo, que tienen una estructura estocástica más complicada; también es un caso especial del modelo vectorial autorregresivo (VAR), que consiste en un sistema de más de una ecuación de diferencia estocástica entrelazada en más de una variable aleatoria en evolución.

A diferencia del modelo de promedio móvil (MA), el modelo autorregresivo no siempre es estacionario, porque puede contener una raíz unitaria.

Los modelos de lenguaje grandes se denominan autorregresivos, pero no son un modelo autorregresivo clásico en este sentido porque no son lineales.

Definición

La notación indica un modelo autorregresivo de orden p . El modelo AR( p ) se define como

donde son los parámetros del modelo, y es ruido blanco . [1] [2] Esto se puede escribir de manera equivalente usando el operador de retroceso B como

de modo que, moviendo el término de suma hacia el lado izquierdo y usando la notación polinomial , tenemos

Un modelo autorregresivo puede entonces verse como la salida de un filtro de respuesta de impulso infinito de todos los polos cuya entrada es ruido blanco.

Algunas restricciones de parámetros son necesarias para que el modelo permanezca estacionario en sentido débil . Por ejemplo, los procesos en el modelo AR(1) con no son estacionarios. En términos más generales, para que un modelo AR( p ) sea estacionario en sentido débil, las raíces del polinomio deben estar fuera del círculo unitario , es decir, cada raíz (compleja) debe satisfacer (ver páginas 89,92 [3] ).

Efecto intertemporal de los shocks

En un proceso AR, un shock único afecta los valores de la variable en evolución infinitamente lejos en el futuro. Por ejemplo, considere el modelo AR(1) . Un valor distinto de cero para en, digamos, el tiempo t = 1 afecta por la cantidad . Luego, por la ecuación AR para en términos de , esto afecta por la cantidad . Luego, por la ecuación AR para en términos de , esto afecta por la cantidad . Continuar este proceso muestra que el efecto de nunca termina, aunque si el proceso es estacionario , entonces el efecto disminuye hacia cero en el límite.

Como cada shock afecta a valores X infinitamente lejanos en el futuro desde el momento en que ocurren, cualquier valor dado X t se ve afectado por shocks que ocurren infinitamente lejanos en el pasado. Esto también se puede ver reescribiendo la autorregresión

(donde se ha suprimido el término constante asumiendo que la variable se ha medido como desviaciones de su media) como

Cuando se realiza la división polinomial en el lado derecho, el polinomio en el operador de retroceso aplicado tiene un orden infinito, es decir, una cantidad infinita de valores rezagados de aparecen en el lado derecho de la ecuación.

Polinomio característico

La función de autocorrelación de un proceso AR( p ) se puede expresar como [ cita requerida ]

¿Dónde están las raíces del polinomio?

donde B es el operador de retroceso , donde es la función que define la autorregresión y donde son los coeficientes de la autorregresión. La fórmula es válida solo si todas las raíces tienen multiplicidad 1. [ cita requerida ]

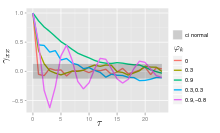

La función de autocorrelación de un proceso AR( p ) es una suma de exponenciales decrecientes.

- Cada raíz real aporta un componente a la función de autocorrelación que decae exponencialmente.

- De manera similar, cada par de raíces conjugadas complejas contribuye con una oscilación amortiguada exponencialmente.

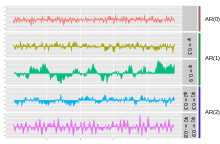

Gráficas de AR(pag) procesos

El proceso AR más simple es AR(0), que no tiene dependencia entre los términos. Solo el término error/innovación/ruido contribuye al resultado del proceso, por lo que en la figura, AR(0) corresponde a ruido blanco.

En el caso de un proceso AR(1) con un valor positivo , solo el término anterior del proceso y el término de ruido contribuyen a la salida. Si es cercano a 0, el proceso aún se ve como ruido blanco, pero a medida que se acerca a 1, la salida obtiene una contribución mayor del término anterior en relación con el ruido. Esto da como resultado una "suavizada" o integración de la salida, similar a un filtro de paso bajo .

En un proceso AR(2), los dos términos anteriores y el término de ruido contribuyen a la salida. Si ambos y son positivos, la salida se parecerá a un filtro de paso bajo, con la parte de alta frecuencia del ruido reducida. Si es positivo mientras que es negativo, entonces el proceso favorece los cambios de signo entre los términos del proceso. La salida oscila. Esto se puede comparar con la detección de bordes o la detección de cambios de dirección.

Ejemplo: Un proceso AR(1)

Un proceso AR(1) viene dado por: donde es un proceso de ruido blanco con media cero y varianza constante . (Nota: se ha eliminado el subíndice on). El proceso es estacionario en sentido débil si ya que se obtiene como salida de un filtro estable cuya entrada es ruido blanco. (Si entonces la varianza de depende del retardo temporal t, de modo que la varianza de la serie diverge al infinito cuando t tiende al infinito y, por lo tanto, no es estacionario en sentido débil). Suponiendo , la media es idéntica para todos los valores de t por la propia definición de estacionariedad en sentido débil. Si la media se denota por , se deduce de eso y por lo tanto

La varianza es

donde es la desviación estándar de . Esto se puede demostrar observando que

y luego notando que la cantidad anterior es un punto fijo estable de esta relación.

La autocovarianza viene dada por

Se puede observar que la función de autocovarianza decae con un tiempo de decaimiento (también llamado constante de tiempo ) de . [4]

La función de densidad espectral es la transformada de Fourier de la función de autocovarianza. En términos discretos, será la transformada de Fourier de tiempo discreto:

Esta expresión es periódica debido a la naturaleza discreta de , que se manifiesta como el término coseno en el denominador. Si suponemos que el tiempo de muestreo ( ) es mucho menor que el tiempo de decaimiento ( ), entonces podemos utilizar una aproximación continua para :

lo que produce un perfil lorentziano para la densidad espectral:

donde es la frecuencia angular asociada con el tiempo de decaimiento .

Se puede derivar una expresión alternativa para sustituyendo primero en la ecuación definitoria. Continuando este proceso N veces se obtiene

Para N que se acerca al infinito, se acercará a cero y:

Se observa que es ruido blanco convolucionado con el núcleo más la media constante. Si el ruido blanco es un proceso gaussiano , entonces también es un proceso gaussiano. En otros casos, el teorema del límite central indica que se distribuirá aproximadamente de manera normal cuando esté cerca de uno.

Para , el proceso será una progresión geométrica ( crecimiento o decrecimiento exponencial ). En este caso, la solución se puede encontrar analíticamente: donde es una constante desconocida ( condición inicial ).

Forma explícita de media/diferencia del proceso AR(1)

El modelo AR(1) es la analogía de tiempo discreto del proceso continuo de Ornstein-Uhlenbeck . Por lo tanto, a veces resulta útil comprender las propiedades del modelo AR(1) expresado en una forma equivalente. En esta forma, el modelo AR(1), con parámetro de proceso , viene dado por

- , donde , es la media del modelo, y es un proceso de ruido blanco con media cero y varianza constante .

Al reescribir esto como y luego derivar (por inducción) , se puede demostrar que

- y

- .

Elegir el retraso máximo

La autocorrelación parcial de un proceso AR(p) es igual a cero en rezagos mayores que p, por lo que el rezago máximo apropiado p es aquel después del cual las autocorrelaciones parciales son todas cero.

Cálculo de los parámetros AR

Hay muchas maneras de estimar los coeficientes, como el procedimiento de mínimos cuadrados ordinarios o el método de momentos (a través de las ecuaciones de Yule-Walker).

El modelo AR( p ) viene dado por la ecuación

Se basa en parámetros donde i = 1, ..., p . Existe una correspondencia directa entre estos parámetros y la función de covarianza del proceso, y esta correspondencia se puede invertir para determinar los parámetros a partir de la función de autocorrelación (que a su vez se obtiene a partir de las covarianzas). Esto se hace utilizando las ecuaciones de Yule-Walker.

Ecuaciones de Yule-Walker

Las ecuaciones de Yule-Walker, llamadas así por Udny Yule y Gilbert Walker , [5] [6] son el siguiente conjunto de ecuaciones. [7]

donde m = 0, …, p , dando como resultado p + 1 ecuaciones. Aquí está la función de autocovarianza de X t , es la desviación estándar del proceso de ruido de entrada y es la función delta de Kronecker .

Debido a que la última parte de una ecuación individual es distinta de cero solo si m = 0 , el conjunto de ecuaciones se puede resolver representando las ecuaciones para m > 0 en forma de matriz, obteniendo así la ecuación

que se puede resolver para todos La ecuación restante para m = 0 es

que, una vez conocidos, se pueden resolver para

Una formulación alternativa es en términos de la función de autocorrelación . Los parámetros AR están determinados por los primeros p +1 elementos de la función de autocorrelación. La función de autocorrelación completa puede entonces derivarse calculando recursivamente [8]

Ejemplos de algunos procesos AR( p ) de orden bajo

- p = 1

- Por eso

- p = 2

- Las ecuaciones de Yule-Walker para un proceso AR(2) son

- Recuerda que

- Usando la primera ecuación obtenemos

- Usando la fórmula de recursión obtenemos

- Las ecuaciones de Yule-Walker para un proceso AR(2) son

Estimación de parámetros AR

Las ecuaciones anteriores (ecuaciones de Yule-Walker) proporcionan varias rutas para estimar los parámetros de un modelo AR( p ), reemplazando las covarianzas teóricas con valores estimados. [9] Algunas de estas variantes se pueden describir de la siguiente manera:

- Estimación de autocovarianzas o autocorrelaciones. En este caso, cada uno de estos términos se estima por separado, utilizando estimaciones convencionales. Existen diferentes formas de hacerlo y la elección entre ellas afecta las propiedades del esquema de estimación. Por ejemplo, algunas elecciones pueden producir estimaciones negativas de la varianza.

- Formulación como un problema de regresión de mínimos cuadrados en el que se construye un problema de predicción de mínimos cuadrados ordinario, basando la predicción de valores de X t en los p valores anteriores de la misma serie. Esto puede considerarse como un esquema de predicción hacia adelante. Se puede observar que las ecuaciones normales para este problema corresponden a una aproximación de la forma matricial de las ecuaciones de Yule-Walker en la que cada aparición de una autocovarianza del mismo rezago se reemplaza por una estimación ligeramente diferente.

- Formulación como una forma extendida del problema de predicción de mínimos cuadrados ordinarios. Aquí se combinan dos conjuntos de ecuaciones de predicción en un único esquema de estimación y un único conjunto de ecuaciones normales. Un conjunto es el conjunto de ecuaciones de predicción hacia delante y el otro es un conjunto correspondiente de ecuaciones de predicción hacia atrás, relacionadas con la representación hacia atrás del modelo AR:

- Aquí los valores predichos de X t se basarían en los p valores futuros de la misma serie. [ aclaración necesaria ] Esta forma de estimar los parámetros AR se debe a John Parker Burg, [10] y se llama el método de Burg: [11] Burg y autores posteriores llamaron a estas estimaciones particulares "estimaciones de entropía máxima", [12] pero el razonamiento detrás de esto se aplica al uso de cualquier conjunto de parámetros AR estimados. En comparación con el esquema de estimación que utiliza solo las ecuaciones de predicción hacia adelante, se producen diferentes estimaciones de las autocovarianzas y las estimaciones tienen diferentes propiedades de estabilidad. Las estimaciones de Burg están particularmente asociadas con la estimación espectral de entropía máxima . [13]

Otros enfoques posibles para la estimación incluyen la estimación de máxima verosimilitud . Hay dos variantes distintas de máxima verosimilitud: en una (que en líneas generales equivale al esquema de mínimos cuadrados de predicción hacia adelante) la función de verosimilitud considerada es la correspondiente a la distribución condicional de los valores posteriores en la serie dados los valores p iniciales en la serie; en la segunda, la función de verosimilitud considerada es la correspondiente a la distribución conjunta incondicional de todos los valores en la serie observada. Pueden ocurrir diferencias sustanciales en los resultados de estos enfoques si la serie observada es corta o si el proceso está cerca de la no estacionariedad.

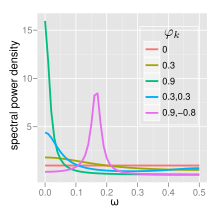

Espectro

La densidad espectral de potencia (PSD) de un proceso AR( p ) con variación de ruido es [8]

AR(0)

Para ruido blanco (AR(0))

AR(1)

Para AR(1)

- Si hay un único pico espectral en , a menudo denominado ruido rojo . A medida que se acerca a 1, hay una mayor potencia en las frecuencias bajas, es decir, mayores retrasos temporales. Este es entonces un filtro de paso bajo; cuando se aplica a la luz de espectro completo, se filtrará todo excepto la luz roja.

- Si hay un mínimo en , a menudo denominado ruido azul , actúa de manera similar a un filtro de paso alto: se filtrará todo excepto la luz azul.

AR(2)

El comportamiento de un proceso AR(2) está determinado enteramente por las raíces de su ecuación característica , que se expresa en términos del operador de rezago como:

o equivalentemente por los polos de su función de transferencia , que se define en el dominio Z por:

De ello se deduce que los polos son valores de z que satisfacen:

- ,

Lo cual produce:

- .

y son los recíprocos de las raíces características, así como los valores propios de la matriz de actualización temporal:

Los procesos AR(2) se pueden dividir en tres grupos dependiendo de las características de sus raíces/polos:

- Cuando , el proceso tiene un par de polos complejos conjugados, creando un pico de frecuencia media en:

con ancho de banda alrededor del pico inversamente proporcional a los módulos de los polos:

Los términos que involucran raíces cuadradas son todos reales en el caso de polos complejos ya que existen sólo cuando .

De lo contrario, el proceso tiene raíces reales y:

- Cuando actúa como un filtro de paso bajo en el ruido blanco con un pico espectral en

- Cuando actúa como un filtro de paso alto en el ruido blanco con un pico espectral en .

El proceso no es estacionario cuando los polos están en el círculo unitario o fuera de él, o equivalentemente cuando las raíces características están en el círculo unitario o dentro de él. El proceso es estable cuando los polos están estrictamente dentro del círculo unitario (las raíces están estrictamente fuera del círculo unitario), o equivalentemente cuando los coeficientes están en el triángulo .

La función PSD completa se puede expresar en forma real como:

Implementaciones en paquetes de estadísticas

- R – el paquete stats incluye la función ar ; [14] el paquete astsa incluye la función sarima para ajustarse a varios modelos, incluido AR. [15]

- MATLAB – Econometrics Toolbox [16] y System Identification Toolbox [17] incluyen modelos AR. [18]

- MATLAB y Octave : la caja de herramientas TSA contiene varias funciones de estimación para modelos AR univariables, multivariables y adaptativos. [19]

- PyMC 3, el marco de programación probabilística y estadística bayesiana, admite modos AR con rezagos p .

- Bayesloop : admite la inferencia de parámetros y la selección de modelos para el proceso AR-1 con parámetros que varían en el tiempo. [20]

- Python – statsmodels.org aloja un modelo AR. [21]

Respuesta al impulso

La respuesta al impulso de un sistema es el cambio en una variable en evolución en respuesta a un cambio en el valor de un término de choque k períodos antes, como una función de k . Dado que el modelo AR es un caso especial del modelo autorregresivo vectorial, el cálculo de la respuesta al impulso en autorregresión vectorial#respuesta al impulso se aplica aquí.

norte-previsión con anticipación

Una vez que los parámetros de la autorregresión

Una vez que se han estimado, la autorregresión se puede utilizar para pronosticar un número arbitrario de períodos en el futuro. Primero, se utiliza t para referirse al primer período para el cual aún no hay datos disponibles; se sustituyen los valores conocidos anteriores X t-i por i = 1, ..., p en la ecuación autorregresiva mientras se establece el término de error igual a cero (porque pronosticamos que X t será igual a su valor esperado, y el valor esperado del término de error no observado es cero). El resultado de la ecuación autorregresiva es el pronóstico para el primer período no observado. A continuación, se utiliza t para referirse al siguiente período para el cual aún no hay datos disponibles; nuevamente, se utiliza la ecuación autorregresiva para hacer el pronóstico, con una diferencia: no se conoce el valor de X de un período anterior al que se está pronosticando ahora, por lo que se utiliza su valor esperado (el valor predicho que surge del paso de pronóstico anterior). Luego, para períodos futuros se utiliza el mismo procedimiento, utilizando cada vez un valor de pronóstico más en el lado derecho de la ecuación predictiva hasta que, después de p predicciones, todos los p valores del lado derecho sean valores predichos de los pasos anteriores.

Existen cuatro fuentes de incertidumbre en relación con las predicciones obtenidas de esta manera: (1) incertidumbre sobre si el modelo autorregresivo es el modelo correcto; (2) incertidumbre sobre la precisión de los valores pronosticados que se utilizan como valores rezagados en el lado derecho de la ecuación autorregresiva; (3) incertidumbre sobre los valores verdaderos de los coeficientes autorregresivos; y (4) incertidumbre sobre el valor del término de error para el período que se está prediciendo. Cada una de las últimas tres puede cuantificarse y combinarse para dar un intervalo de confianza para las predicciones con n pasos de anticipación; el intervalo de confianza se hará más amplio a medida que n aumenta debido al uso de un número creciente de valores estimados para las variables del lado derecho.

Véase también

- Modelo de media móvil

- Ecuación diferencial lineal

- Análisis predictivo

- Codificación predictiva lineal

- Resonancia

- Recursión de Levinson

- Proceso de Ornstein-Uhlenbeck

- Respuesta al impulso infinito

Notas

- ^ Box, George EP (1994). Análisis de series temporales: pronóstico y control. Gwilym M. Jenkins, Gregory C. Reinsel (3.ª ed.). Englewood Cliffs, NJ: Prentice Hall. pág. 54. ISBN 0-13-060774-6.OCLC 28888762 .

- ^ Shumway, Robert H. (2000). Análisis de series temporales y sus aplicaciones. David S. Stoffer. Nueva York: Springer. pp. 90–91. ISBN 0-387-98950-1. OCLC 42392178. Archivado desde el original el 16 de abril de 2023. Consultado el 3 de septiembre de 2022 .

- ^ Shumway, Robert H.; Stoffer, David (2010). Análisis de series temporales y sus aplicaciones: con ejemplos de R (3.ª ed.). Springer. ISBN 978-1441978646.

- ^ Lai, Dihui; y Lu, Bingfeng; "Comprensión del modelo autorregresivo para series temporales como un sistema dinámico determinista" Archivado el 24 de marzo de 2023 en Wayback Machine , en Predictive Analytics and Futurism , junio de 2017, número 15, junio de 2017, páginas 7-9

- ^ Yule, G. Udny (1927) "Sobre un método de investigación de periodicidades en series perturbadas, con especial referencia a los números de manchas solares de Wolfer" Archivado el 14 de mayo de 2011 en Wayback Machine , Philosophical Transactions of the Royal Society of London , Ser. A, Vol. 226, 267–298.]

- ^ Walker, Gilbert (1931) "Sobre la periodicidad en series de términos relacionados" Archivado el 7 de junio de 2011 en Wayback Machine , Actas de la Royal Society de Londres , Ser. A, Vol. 131, 518–532.

- ^ Theodoridis, Sergios (10 de abril de 2015). "Capítulo 1. Probabilidad y procesos estocásticos". Aprendizaje automático: una perspectiva bayesiana y de optimización . Academic Press, 2015. pp. 9–51. ISBN 978-0-12-801522-3.

- ^ ab Von Storch, Hans; Zwiers, Francis W. (2001). Análisis estadístico en la investigación climática . Cambridge University Press. doi :10.1017/CBO9780511612336. ISBN 0-521-01230-9.[ página necesaria ]

- ^ Eshel, Gidon. "Las ecuaciones de Yule Walker para los coeficientes AR" (PDF) . stat.wharton.upenn.edu . Archivado (PDF) desde el original el 13 de julio de 2018 . Consultado el 27 de enero de 2019 .

- ^ Burg, John Parker (1968); "Una nueva técnica de análisis para datos de series temporales", en Modern Spectrum Analysis (Editado por DG Childers), Instituto de Estudios Avanzados de Procesamiento de Señales de la OTAN con énfasis en Acústica Subacuática. IEEE Press, Nueva York.

- ^ Brockwell, Peter J.; Dahlhaus, Rainer; Trindade, A. Alexandre (2005). "Algoritmos de Burg modificados para la autorregresión de subconjuntos multivariados" (PDF) . Statistica Sinica . 15 : 197–213. Archivado desde el original (PDF) el 21 de octubre de 2012.

- ^ Burg, John Parker (1967) "Análisis espectral de máxima entropía", Actas de la 37ª Reunión de la Sociedad de Geofísicos de Exploración , Oklahoma City, Oklahoma.

- ^ Bos, Robert; De Waele, Stijn; Broersen, Piet MT (2002). "Estimación espectral autorregresiva mediante la aplicación del algoritmo Burg a datos muestreados irregularmente". IEEE Transactions on Instrumentation and Measurement . 51 (6): 1289. Bibcode :2002ITIM...51.1289B. doi :10.1109/TIM.2002.808031. Archivado desde el original el 2023-04-16 . Consultado el 2019-12-11 .

- ^ "Ajuste de modelos autorregresivos a series temporales" Archivado el 28 de enero de 2016 en Wayback Machine (en R)

- ^ Stoffer, David; Poison, Nicky (9 de enero de 2023). «astsa: Análisis estadístico aplicado de series temporales» . Consultado el 20 de agosto de 2023 .

- ^ "Econometrics Toolbox" (Caja de herramientas de econometría). www.mathworks.com . Archivado desde el original el 16 de abril de 2023. Consultado el 16 de febrero de 2022 .

- ^ "Caja de herramientas de identificación de sistemas". www.mathworks.com . Archivado desde el original el 2022-02-16 . Consultado el 2022-02-16 .

- ^ "Modelo autorregresivo - MATLAB y Simulink". www.mathworks.com . Archivado desde el original el 2022-02-16 . Consultado el 2022-02-16 .

- ^ "La caja de herramientas de análisis de series temporales (TSA) para Octave y MATLAB". pub.ist.ac.at . Archivado desde el original el 2012-05-11 . Consultado el 2012-04-03 .

- ^ "christophmark/bayesloop". 7 de diciembre de 2021. Archivado desde el original el 28 de septiembre de 2020. Consultado el 4 de septiembre de 2018 – vía GitHub.

- ^ "statsmodels.tsa.ar_model.AutoReg — documentación de statsmodels 0.12.2". www.statsmodels.org . Archivado desde el original el 28 de febrero de 2021 . Consultado el 29 de abril de 2021 .

Referencias

- Mills, Terence C. (1990). Técnicas de series temporales para economistas . Cambridge University Press. ISBN 9780521343398.

- Percival, Donald B.; Walden, Andrew T. (1993). Análisis espectral para aplicaciones físicas . Cambridge University Press. Bibcode :1993sapa.book.....P.

- Pandit, Sudhakar M.; Wu, Shien-Ming (1983). Análisis de sistemas y series temporales con aplicaciones . John Wiley & Sons.

Enlaces externos

- Análisis de autorregresión (AR) por Paul Bourke

- Conferencia sobre econometría (tema: modelos autorregresivos) en YouTube por Mark Thoma

![{\displaystyle \phi [B]X_{t}=\varepsilon _{t}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/427fcdc777a1ef12ec7498f413bfbcb6d0932af5)

![{\displaystyle \operatorname {E} (X_{t+n}|X_{t})=\mu \left[1-\theta ^{n}\right]+X_{t}\theta ^{n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/57e7ce545d36dfb0de17a55881ba8322e99955a5)